Wprowadzenie

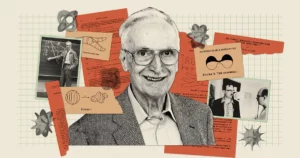

Sztuczna inteligencja wydaje się potężniejsza niż kiedykolwiek wcześniej, a chatboty takie jak Bard i ChatGPT potrafią generować tekst niesamowicie przypominający ludzki. Jednak pomimo wszystkich swoich talentów, boty te wciąż zastanawiają badaczy: zrobić takie modele właściwie rozumiem co oni mówią? „Najwyraźniej niektórzy ludzie w to wierzą” – stwierdził pionier sztucznej inteligencji Geoff podpowiedź w ostatnia rozmowa z Andrew Ng „a niektórzy ludzie uważają, że są to po prostu stochastyczne papugi”.

To sugestywne zdanie pochodzi z roku 2021 papier współautorem o Emilia Bender, lingwista komputerowy na Uniwersytecie Waszyngtońskim. Sugeruje to, że duże modele językowe (LLM) – które stanowią podstawę współczesnych chatbotów – generują tekst jedynie poprzez łączenie informacji, które już widziały, „bez żadnego odniesienia do znaczenia” – napisali autorzy, co czyni LLM „papugą stochastyczną”.

Modele te obsługują wiele największych i najlepszych współczesnych chatbotów, dlatego Hinton argumentował, że nadszedł czas, aby określić zakres tego, co rozumieją. Dla niego pytanie jest bardziej niż akademickie. „Dopóki będziemy mieli te różnice zdań”, powiedział do Ng, „nie będziemy w stanie dojść do konsensusu w sprawie zagrożeń”.

Nowe badania mogą sugerować odpowiedź. Teoria opracowana przez Sanjeev Arora Uniwersytetu Princeton i Anirudh Goyalbadacz z Google DeepMind sugeruje, że największe współczesne LLM nie są papugami stochastycznymi. Autorzy argumentują, że w miarę jak modele te stają się coraz większe i szkolone na większej liczbie danych, poprawiają się indywidualne zdolności językowe, a także rozwijają nowe, łącząc umiejętności w sposób wskazujący na zrozumienie – kombinacje, które prawdopodobnie nie istniały w danych uczących .

To teoretyczne podejście, które dostarcza matematycznie udowodnionego argumentu na temat tego, jak i dlaczego LLM może rozwinąć tak wiele umiejętności, przekonało ekspertów takich jak Hinton i innych. Kiedy Arora i jego zespół przetestowali niektóre przewidywania, odkryli, że modele te zachowywały się prawie dokładnie zgodnie z oczekiwaniami. Ze wszystkich relacji wynika, że największe firmy LLM nie tylko powtarzają to, co widziały wcześniej.

„[Oni] nie mogą po prostu naśladować tego, co widać w danych szkoleniowych” – stwierdził Sebastien Bubeck, matematyk i informatyk z Microsoft Research, który nie brał udziału w tej pracy. „To podstawowe spostrzeżenie.”

Więcej danych, więcej mocy

W razie nieoczekiwane i różnorodne zdolności w LLM, można śmiało powiedzieć, było zaskoczeniem. Zdolności te nie są oczywistą konsekwencją sposobu, w jaki systemy są budowane i szkolone. LLM to masywna sztuczna sieć neuronowa, która łączy poszczególne sztuczne neurony. Połączenia te nazywane są parametrami modelu, a ich liczba oznacza rozmiar LLM. Szkolenie polega na wydaniu LLM zdania z zasłoniętym ostatnim słowem, na przykład „Paliwo kosztuje rękę i ___”. LLM przewiduje rozkład prawdopodobieństwa w całym swoim słownictwie, więc jeśli zna, powiedzmy, tysiąc słów, przewiduje tysiąc prawdopodobieństw. Następnie wybiera najbardziej prawdopodobne słowo do uzupełnienia zdania – prawdopodobnie „noga”.

Początkowo LLM może źle wybierać słowa. Następnie algorytm uczący oblicza stratę — odległość w jakiejś wielowymiarowej przestrzeni matematycznej między odpowiedzią LLM a rzeczywistym słowem w oryginalnym zdaniu — i wykorzystuje tę stratę do dostosowania parametrów. Teraz, biorąc pod uwagę to samo zdanie, LLM obliczy lepszy rozkład prawdopodobieństwa, a jego strata będzie nieco mniejsza. Algorytm robi to dla każdego zdania w danych szkoleniowych (prawdopodobnie miliardów zdań), dopóki ogólna strata LLM nie spadnie do akceptowalnego poziomu. Podobny proces stosuje się do testowania LLM na zdaniach, które nie były częścią danych szkoleniowych.

Wyszkolony i przetestowany LLM, gdy zostanie mu przedstawiony nowy znak tekstowy, wygeneruje najbardziej prawdopodobne następne słowo, dołączy je do podpowiedzi, wygeneruje kolejne następne słowo i kontynuuje w ten sposób, uzyskując pozornie spójną odpowiedź. Nic w procesie szkoleniowym nie sugeruje, że większe LLM, zbudowane przy użyciu większej liczby parametrów i danych szkoleniowych, powinny również poprawiać się w przypadku zadań wymagających rozumowania.

Ale tak jest. Wystarczająco duże LLM wykazują umiejętności – od rozwiązywania podstawowych problemów matematycznych po odpowiadanie na pytania dotyczące tego, co dzieje się w umysłach innych – których nie mają mniejsze modele, mimo że wszyscy są szkoleni w podobny sposób.

„Skąd się wzięła ta [zdolność]?” Arora zastanawiała się. „I czy może to wynikać jedynie z przewidywania następnego słowa?”

Łączenie umiejętności z tekstem

Arora nawiązała współpracę z Goyalem, aby analitycznie odpowiedzieć na takie pytania. „Próbowaliśmy stworzyć ramy teoretyczne, aby zrozumieć, w jaki sposób dochodzi do wyłaniania się” – powiedziała Arora.

Duet zwrócił się ku obiektom matematycznym zwanym losowymi wykresami. Wykres to zbiór punktów (lub węzłów) połączonych liniami (lub krawędziami), a na losowym wykresie obecność krawędzi pomiędzy dowolnymi dwoma węzłami jest podyktowana losowo – powiedzmy przez rzut monetą. Moneta może być stronnicza, tak że z pewnym prawdopodobieństwem wypadnie reszka p. Jeśli moneta wypadnie reszką dla danej pary węzłów, pomiędzy tymi dwoma węzłami tworzy się krawędź; w przeciwnym razie pozostaną niepołączone. Jako wartość p zmian, wykresy mogą pokazywać nagłe zmiany ich właściwości. Na przykład, kiedy p przekracza pewien próg, izolowane węzły — te, które nie są połączone z żadnym innym węzłem — nagle znikają.

Arora i Goyal zdali sobie sprawę, że losowe wykresy, które powodują nieoczekiwane zachowania po osiągnięciu określonych progów, mogą być sposobem na modelowanie zachowania LLM. Sieci neuronowe stały się niemal zbyt złożone, aby je analizować, ale matematycy od dawna badają losowe wykresy i opracowali różne narzędzia do ich analizy. Być może teoria grafów losowych umożliwi badaczom zrozumienie i przewidywanie pozornie nieoczekiwanych zachowań dużych LLM.

Badacze postanowili skupić się na grafach „dwudzielnych”, które zawierają dwa typy węzłów. W ich modelu jeden typ węzła reprezentuje fragmenty tekstu — nie pojedyncze słowa, ale fragmenty, które mogą mieć długość akapitu lub kilku stron. Węzły te ułożone są w linii prostej. Poniżej nich, w innej linii, znajduje się drugi zestaw węzłów. Reprezentują one umiejętności potrzebne do zrozumienia danego fragmentu tekstu. Każda umiejętność może oznaczać prawie wszystko. Być może jeden węzeł reprezentuje zdolność LLM do zrozumienia słowa „ponieważ”, które zawiera pewne pojęcie przyczynowości; inny może reprezentować możliwość podzielenia dwóch liczb; jeszcze inny może reprezentować zdolność wykrywania ironii. „Jeśli zrozumiesz, że fragment tekstu jest ironiczny, wiele rzeczy się odwróci” – stwierdziła Arora. „To ma znaczenie przy przewidywaniu słów”.

Żeby było jasne, osoby LLM nie są szkolone ani testowane pod kątem umiejętności; są zbudowane wyłącznie w celu poprawy przewidywania następnego słowa. Jednak Arora i Goyal chcieli zrozumieć LLM z perspektywy umiejętności, które mogą być wymagane do zrozumienia pojedynczego tekstu. Połączenie między węzłem umiejętności a węzłem tekstowym lub między wieloma węzłami umiejętności a węzłem tekstowym oznacza, że LLM potrzebuje tych umiejętności, aby zrozumieć tekst w tym węźle. Ponadto wiele fragmentów tekstu może czerpać z tej samej umiejętności lub zestawu umiejętności; na przykład zestaw węzłów umiejętności reprezentujących zdolność rozumienia ironii będzie połączony z licznymi węzłami tekstowymi, w których występuje ironia.

Wyzwaniem było teraz połączenie tych dwuczęściowych wykresów z rzeczywistymi LLM i sprawdzenie, czy wykresy mogą ujawnić coś na temat pojawienia się potężnych zdolności. Badacze nie mogli jednak polegać na żadnych informacjach na temat szkolenia lub testowania rzeczywistych LLM – firmy takie jak OpenAI czy DeepMind nie upubliczniają swoich danych szkoleniowych ani testowych. Arora i Goyal chcieli także przewidzieć, jak będą się zachowywać LLM, gdy staną się jeszcze większe, ale nie ma takich informacji na temat przyszłych chatbotów. Naukowcy mieli jednak dostęp do jednej kluczowej informacji.

Od 2021 r. badacze badający wydajność LLM i innych sieci neuronowych zaobserwowali wyłonienie się cechy uniwersalnej. Zauważyli, że w miarę powiększania się modelu, czy to pod względem rozmiaru, czy ilości danych uczących, jego utrata danych testowych (różnica między przewidywanymi a poprawnymi odpowiedziami w nowych tekstach po treningu) zmniejsza się w bardzo specyficzny sposób. Obserwacje te zostały skodyfikowane w postaci równań zwanych prawami skalowania neuronowego. Dlatego Arora i Goyal zaprojektowali swoją teorię tak, aby nie opierała się na danych z pojedynczego LLM, chatbota czy zestawu danych szkoleniowych i testowych, ale na uniwersalnym prawie, którego oczekuje się, że wszystkie te systemy będą przestrzegać: stracie przewidywanej przez prawa skalowania.

Być może, rozumowali, lepsza wydajność – mierzona prawami skalowania neuronowego – była powiązana z poprawą umiejętności. Te ulepszone umiejętności można zdefiniować na ich dwustronnych wykresach poprzez połączenie węzłów umiejętności z węzłami tekstowymi. Ustalenie tego powiązania – między prawami skalowania neuronowego a wykresami dwudzielnymi – było kluczem umożliwiającym kontynuację prac.

Skalowanie umiejętności

Badacze rozpoczęli od założenia, że istnieje hipotetyczny dwudzielny wykres odpowiadający zachowaniu LLM na danych testowych. Aby wyjaśnić zmianę w stratach LLM na danych testowych, wymyślili sposób wykorzystania wykresu do opisania, w jaki sposób LLM zdobywa umiejętności.

Weźmy na przykład umiejętność „rozumienia ironii”. Pomysł ten jest reprezentowany przez węzeł umiejętności, więc badacze sprawdzają, z jakimi węzłami tekstowymi łączy się ten węzeł umiejętności. Jeśli prawie wszystkie połączone węzły tekstowe odniosą sukces – co oznacza, że przewidywania LLM dotyczące tekstu reprezentowanego przez te węzły są bardzo dokładne – wówczas LLM jest kompetentny w tej konkretnej umiejętności. Jeśli jednak więcej niż pewna część połączeń węzła umiejętności trafi do uszkodzonych węzłów tekstowych, wówczas LLM nie poradzi sobie z tą umiejętnością.

To połączenie między tymi dwudzielnymi wykresami a LLM umożliwiło Arorze i Goyalowi wykorzystanie narzędzi teorii grafów losowych do analizy zachowania LLM przez proxy. Badanie tych wykresów ujawniło pewne zależności pomiędzy węzłami. Zależności te z kolei przełożyły się na logiczny i możliwy do przetestowania sposób wyjaśnienia, w jaki sposób duże modele zyskały umiejętności niezbędne do osiągnięcia ich nieoczekiwanych zdolności.

Arora i Goyal najpierw wyjaśnili jedno kluczowe zachowanie: dlaczego więksi LLM stają się bardziej wykwalifikowani w zakresie indywidualnych umiejętności niż ich mniejsi odpowiednicy. Zaczęli od niższych strat testowych przewidywanych przez prawa skalowania neuronowego. Na wykresie tę niższą stratę testową reprezentuje spadek odsetka węzłów testowych, które uległy awarii. Zatem ogólnie jest mniej węzłów testowych, które zakończyły się niepowodzeniem. A jeśli jest mniej węzłów testowych, które zakończyły się niepowodzeniem, wówczas jest mniej połączeń między węzłami testowymi, które zakończyły się niepowodzeniem, a węzłami umiejętności. Dlatego większa liczba węzłów umiejętności jest połączona z pomyślnymi węzłami testowymi, co sugeruje rosnące kompetencje w zakresie umiejętności dla modelu. „Bardzo niewielka redukcja strat powoduje, że maszyna nabywa kompetencje w zakresie tych umiejętności” – powiedział Goyal.

Następnie para znalazła sposób na wyjaśnienie nieoczekiwanych zdolności większego modelu. W miarę wzrostu rozmiaru LLM i zmniejszania się strat w testach, losowe kombinacje węzłów umiejętności tworzą połączenia z indywidualnymi węzłami tekstowymi. Sugeruje to, że LLM staje się również lepszy w używaniu więcej niż jednej umiejętności na raz i zaczyna generować tekst przy użyciu wielu umiejętności – łącząc, powiedzmy, umiejętność używania ironii ze zrozumieniem słowa „ponieważ” – nawet jeśli te dokładne kombinacje umiejętności nie były obecne w żadnym fragmencie tekstu danych szkoleniowych.

Wyobraź sobie na przykład LLM, który mógłby już wykorzystać jedną umiejętność do generowania tekstu. Jeśli zwiększysz liczbę parametrów lub danych szkoleniowych LLM o rząd wielkości, stanie się on podobnie kompetentny w generowaniu tekstu wymagającego dwóch umiejętności. Przejdź o kolejny rząd wielkości, a LLM może teraz wykonywać zadania wymagające czterech umiejętności jednocześnie, ponownie na tym samym poziomie kompetencji. Większe LLM mają więcej sposobów łączenia umiejętności, co prowadzi do kombinatorycznej eksplozji umiejętności.

W miarę zwiększania skali LLM możliwość napotkania wszystkich tych kombinacji umiejętności w danych szkoleniowych staje się coraz bardziej nieprawdopodobna. Zgodnie z zasadami teorii grafów losowych każda kombinacja powstaje w wyniku losowego próbkowania możliwych umiejętności. Jeśli więc na wykresie znajduje się około 1,000 podstawowych poszczególnych węzłów umiejętności, a chcesz połączyć cztery umiejętności, istnieje około 1,000 do potęgi czwartej, czyli 1 bilion, możliwych sposobów ich połączenia.

Arora i Goyal postrzegają to jako dowód na to, że najwięksi LLM nie polegają wyłącznie na kombinacjach umiejętności, które widzieli w swoich danych szkoleniowych. Bubeck zgadza się. „Jeśli organizacja LLM naprawdę jest w stanie wykonać te zadania, łącząc cztery z tysiąca umiejętności, to musi dokonywać generalizacji” – stwierdził. Oznacza to, że najprawdopodobniej nie jest to papuga stochastyczna.

Prawdziwa kreatywność?

Jednak Arora i Goyal chcieli wyjść poza teorię i sprawdzić swoje twierdzenie, że LLM stają się lepsze w łączeniu większej liczby umiejętności, a tym samym w uogólnianiu, w miarę wzrostu ich rozmiaru i danych szkoleniowych. Razem z innymi kolegami zaprojektował metodę zwane „mieszanką umiejętności” w celu oceny zdolności LLM do wykorzystania wielu umiejętności do generowania tekstu.

Aby przetestować LLM, zespół poprosił go o wygenerowanie trzech zdań na losowo wybrany temat, które ilustrowały niektóre losowo wybrane umiejętności. Na przykład poprosili GPT-4 (LLM, który obsługuje najpotężniejszą wersję ChatGPT) o napisanie o pojedynkach – w zasadzie walkach na miecze. Ponadto poprosili go o pokazanie umiejętności w czterech obszarach: egocentrycznego nastawienia, metafory, sylogizmu statystycznego i fizyki wiedzy powszechnej. GPT-4 odpowiedział: „Moje zwycięstwo w tym tańcu ze stalą [metafora] jest tak pewne, jak upadek przedmiotu na ziemię [fizyka]. Jako znany pojedynek jestem z natury zwinny, podobnie jak większość innych [sylogizm statystyczny] mojej reputacji. Pokonać? Było to możliwe tylko ze względu na nierówne pole bitwy, a nie moją nieadekwatność [egoistyczne nastawienie]”. Poproszony o sprawdzenie wyników, GPT-4 zredukował je do trzech zdań.

Wprowadzenie

„To nie Hemingway ani Szekspir” – stwierdziła Arora, ale zespół jest pewien, że to potwierdza ich rację: model może wygenerować tekst, którego nie mógłby zobaczyć w danych szkoleniowych, wykazując umiejętności, które sumują się z tym, co niektórzy twierdzą jest zrozumienie. GPT-4 przechodzi nawet testy łączące umiejętności, które wymagają sześciu umiejętności w około 10% do 15% przypadków, powiedział, tworząc fragmenty tekstu, których statystycznie niemożliwe jest, aby istniały w danych szkoleniowych.

Zespół zautomatyzował także proces, prosząc GPT-4 o ocenę własnych wyników oraz wyników innych LLM. Arora stwierdziła, że sprawiedliwe jest, aby model sam się ocenił, ponieważ nie ma pamięci, więc nie pamięta, że został poproszony o wygenerowanie tego samego tekstu, który ma ocenić. Yasaman Bahri, badacz w Google DeepMind, który pracuje nad podstawami sztucznej inteligencji, uważa, że zautomatyzowane podejście jest „bardzo proste i eleganckie”.

Jeśli chodzi o teorię, to prawda, że opiera się ona na kilku założeniach, powiedział Bubeck, ale „te założenia nie są w żadnym wypadku szalone”. Eksperymenty zrobiły na nim także wrażenie. „To, co [zespół] udowadnia teoretycznie, a także potwierdza empirycznie, polega na tym, że istnieje uogólnienie składu, co oznacza, że [LLM] są w stanie złożyć elementy, które nigdy nie zostały złożone” – powiedział. „To dla mnie jest esencja kreatywności”.

Arora dodaje, że praca nie mówi nic o dokładności tego, co piszą LLM. „Właściwie to argument za oryginalnością” – stwierdził. „Te rzeczy nigdy nie istniały w światowym korpusie szkoleniowym. Nikt nigdy tego nie napisał. To musi mieć halucynacje.

Niemniej jednak Hinton uważa, że praca ta pozostawia pytanie, czy LLM są papugami stochastycznymi. „To najbardziej rygorystyczna metoda, jaką widziałem, pozwalająca wykazać, że GPT-4 to znacznie więcej niż zwykła papuga stochastyczna” – powiedział. „Pokazują w przekonujący sposób, że GPT-4 może generować tekst łączący umiejętności i tematy w sposób, który prawie na pewno nie wystąpił w danych szkoleniowych”. (Skontaktowaliśmy się z Bender, aby poznać jej punkt widzenia na temat nowego dzieła, ale odmówiła komentarza, powołując się na brak czasu).

I rzeczywiście, jak przewiduje matematyka, wydajność GPT-4 znacznie przewyższa wydajność jego mniejszego poprzednika, GPT-3.5 – w stopniu, który wystraszył Aorę. „Prawdopodobnie nie tylko ja” – powiedział. „Wiele osób uznało za nieco niesamowite, o ile GPT-4 był lepszy od GPT-3.5, a stało się to w ciągu roku. Czy to oznacza, że za rok czeka nas podobna zmiana tej wielkości? Nie wiem. Tylko OpenAI wie.”

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://www.quantamagazine.org/new-theory-suggests-chatbots-can-understand-text-20240122/

- :ma

- :Jest

- :nie

- :Gdzie

- ][P

- $W GÓRĘ

- 000

- 1

- 15%

- 2021

- a

- zdolności

- zdolność

- Zdolny

- O nas

- nagle

- akademicki

- do przyjęcia

- dostęp

- Stosownie

- Konta

- precyzja

- dokładny

- Osiągać

- ACM

- nabywanie

- rzeczywisty

- Dodaj

- Dodaje

- Po

- ponownie

- Zgadza się

- AI

- algorytm

- Wszystkie kategorie

- dopuszczać

- dozwolony

- prawie

- wzdłuż

- już

- również

- ilość

- an

- w czasie rzeczywistym sprawiają,

- i

- Andrew

- Inne

- odpowiedź

- sekretarka

- odpowiedzi

- każdy

- wszystko

- podejście

- w przybliżeniu

- SĄ

- obszary

- argumentować

- argumentował

- argument

- ARM

- ułożone

- sztuczny

- AS

- Założenia

- At

- Autorzy

- zautomatyzowane

- dostępny

- podstawowy

- Gruntownie

- podstawa

- Battlefield

- BE

- bo

- stają się

- staje się

- być

- zanim

- zachowanie

- zachowania

- jest

- uwierzyć

- poniżej

- BEST

- Ulepsz Swój

- pomiędzy

- Poza

- stronniczość

- stronniczy

- Duży

- większe

- Najwyższa

- miliardy

- Bit

- Bloki

- boty

- Budowanie

- wybudowany

- ale

- by

- obliczać

- oblicza

- nazywa

- oprawa ołowiana witrażu

- CAN

- nie może

- zdolny

- walizka

- pewien

- na pewno

- wyzwanie

- zmiana

- Zmiany

- chatbot

- nasze chatboty

- ChatGPT

- ZOBACZ

- Dodaj

- wybrany

- roszczenie

- jasny

- skodyfikowane

- ZGODNY

- Moneta

- koledzy

- kolekcja

- połączenie

- kombinacje

- połączyć

- kombajny

- łączenie

- jak

- byliśmy spójni, od początku

- komentarz

- Firmy

- kompetentny

- kompletny

- kompleks

- zrozumieć

- obliczeniowy

- komputer

- pewność

- Skontaktuj się

- połączony

- połączenie

- połączenia

- łączy

- Zgoda

- konsekwencja

- zawierać

- kontynuować

- przekonany

- skorygowania

- odpowiada

- Koszty:

- mógłby

- odpowiednikami

- zwariowany

- kreatywność

- istotny

- taniec

- Niebezpieczeństwa

- dane

- postanowiła

- zmniejsza

- DeepMind

- zdefiniowane

- wykazać

- oznacza

- zależeć

- opisać

- zaprojektowany

- wykryć

- Ustalać

- rozwijać

- rozwinięty

- podyktowane

- ZROBIŁ

- różnica

- znikać

- Wyświetlacz

- wyświetlanie

- dystans

- 分配

- inny

- podzielić

- do

- robi

- Nie

- robi

- nie

- na dół

- rysować

- Krople

- z powodu

- duet

- każdy

- krawędź

- wyłaniać się

- powstanie

- dość

- Cały

- równania

- istota

- ustanowienie

- oceniać

- Parzyste

- EVER

- Każdy

- dokładnie

- przykład

- przekracza

- istnieć

- istnieje

- spodziewany

- eksperymenty

- eksperci

- Wyjaśniać

- wyjaśnione

- eksplozja

- stopień

- fakt

- Failed

- nie

- sprawiedliwy

- Spadać

- daleko

- kilka

- mniej

- Walki

- znajduje

- i terminów, a

- Trzepnięcie

- Skupiać

- W razie zamówieenia projektu

- Nasz formularz

- formularze

- nadchodzący

- znaleziono

- Fundamenty

- cztery

- Czwarty

- frakcja

- Framework

- od

- zdobyte

- Zyski

- Generować

- generujący

- otrzymać

- miejsce

- Dać

- dany

- daje

- Dający

- Go

- będzie

- wykres

- wykresy

- większy

- Ziemia

- Rozwój

- się

- dzieje

- Have

- he

- głowice

- jej

- wysoko

- go

- wskazówki

- jego

- W jaki sposób

- Jednak

- HTTPS

- podobny do człowieka

- i

- pomysł

- if

- wyobrażam sobie

- niemożliwy

- Pod wrażeniem

- podnieść

- ulepszony

- in

- zawiera

- Zwiększać

- Zwiększenia

- coraz bardziej

- rzeczywiście

- indywidualny

- Informacja

- właściwie

- wgląd

- przykład

- Inteligencja

- najnowszych

- ironia

- odosobniony

- IT

- JEGO

- samo

- właśnie

- Klawisz

- Wiedzieć

- znany

- wie

- Brak

- język

- duży

- większe

- największym

- Nazwisko

- Prawo

- Laws

- Leży

- Wyprowadzenia

- Pozostawiać

- poziom

- poziomy

- lubić

- Prawdopodobnie

- Linia

- linie

- LINK

- mało

- LLM

- logiczny

- długo

- długi czas

- Popatrz

- od

- Partia

- niższy

- maszyna

- zrobiony

- magazyn

- robić

- WYKONUJE

- sposób

- wiele

- masywny

- matematyka

- matematyczny

- matematycznie

- Może..

- może

- me

- oznaczać

- znaczenie

- znaczy

- Poznaj nasz

- Pamięć

- sam

- metoda

- Microsoft

- może

- nic

- umysły

- model

- modele

- Nowoczesne technologie

- jeszcze

- Ponadto

- większość

- dużo

- wielokrotność

- musi

- my

- niezbędny

- potrzebne

- wymagania

- sieć

- sieci

- nerwowy

- sieci neuronowe

- sieci neuronowe

- Neurony

- nigdy

- Nowości

- Następny

- Nie

- węzeł

- węzły

- nic

- Pojęcie

- już dziś

- numer

- z naszej

- liczny

- obiekty

- zaciemnione

- oczywista

- of

- on

- pewnego razu

- ONE

- te

- tylko

- OpenAI

- Opinia

- or

- zamówienie

- oryginalny

- oryginalność

- Inne

- Pozostałe

- Inaczej

- na zewnątrz

- wydajność

- koniec

- ogólny

- własny

- stron

- đôi

- parametry

- część

- szczególny

- Przechodzący

- Ludzie

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- może

- perspektywa

- Fizyka

- Wybiera

- kawałek

- sztuk

- pionier

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- zwrotnica

- możliwość

- możliwy

- możliwie

- power

- mocny

- uprawnienia

- poprzednik

- przewidzieć

- Przewiduje

- przewidywanie

- przepowiednia

- Przewidywania

- Prognozy

- obecność

- teraźniejszość

- przedstawione

- Princeton

- prawdopodobnie

- problemy

- kontynuować

- wygląda tak

- produkcji

- dowód

- dający się udowodnić

- dowodzi

- zapewnia

- pełnomocnik

- publiczny

- położyć

- Putting

- Magazyn ilościowy

- pytanie

- pytania

- przypadkowy

- osiągnięty

- realizowany

- naprawdę

- Zredukowany

- redukcja

- odniesienie

- związane z

- Relacje

- polegać

- pozostawać

- pamiętać

- Słynny

- odpowiadać

- reprezentować

- reprezentowane

- reprezentowanie

- reprezentuje

- reputacja

- wymagać

- wymagany

- Wymaga

- Badania naukowe

- badacz

- Badacze

- REST

- ujawniać

- Ujawnił

- rygorystyczny

- Rosnąć

- reguły

- Powiedział

- taki sam

- zobaczył

- powiedzieć

- powiedzenie

- Skala

- skalowaniem

- Naukowiec

- widzieć

- pozornie

- wydaje

- widziany

- rozsądek

- wyrok

- zestaw

- ona

- powinien

- pokazać

- podobny

- Podobnie

- Prosty

- pojedynczy

- SIX

- Rozmiar

- umiejętność

- wykwalifikowany

- umiejętności

- mniejszy

- So

- Rozwiązywanie

- kilka

- coś

- Typ przestrzeni

- specyficzny

- rozpoczęty

- statystyczny

- Nadal

- proste

- silny

- Studiowanie

- udany

- taki

- nagły

- Wskazuje

- niespodzianka

- miecz

- systemy

- talenty

- zadania

- zespół

- w zespole

- test

- przetestowany

- Testowanie

- Testy

- XNUMX

- niż

- że

- Połączenia

- Wykres

- ich

- Im

- następnie

- teoretyczny

- teoria

- Tam.

- w związku z tym

- Te

- one

- rzeczy

- Myśli

- to

- tych

- chociaż?

- tysiąc

- trzy

- próg

- A zatem

- czas

- do

- dzisiaj

- razem

- także

- narzędzia

- aktualny

- tematy

- Toronto

- przeszkolony

- Trening

- przejścia

- Trylion

- prawdziwy

- stara

- SKRĘCAĆ

- Obrócony

- uszczypnąć

- drugiej

- rodzaj

- typy

- zasadniczy

- zrozumieć

- zrozumienie

- Nieoczekiwany

- uniwersalny

- uniwersytet

- mało prawdopodobne,

- aż do

- posługiwać się

- używany

- zastosowania

- za pomocą

- wartość

- różnorodny

- wersja

- początku.

- zwycięstwo

- chcieć

- poszukiwany

- była

- Waszyngton

- Droga..

- sposoby

- we

- webp

- były

- Co

- jeśli chodzi o komunikację i motywację

- czy

- który

- KIM

- dlaczego

- będzie

- w

- w ciągu

- pełen zdumienia

- słowo

- słowa

- Praca

- działa

- świat

- by

- napisać

- napisany

- napisał

- rok

- jeszcze

- You

- zefirnet