Wprowadzenie

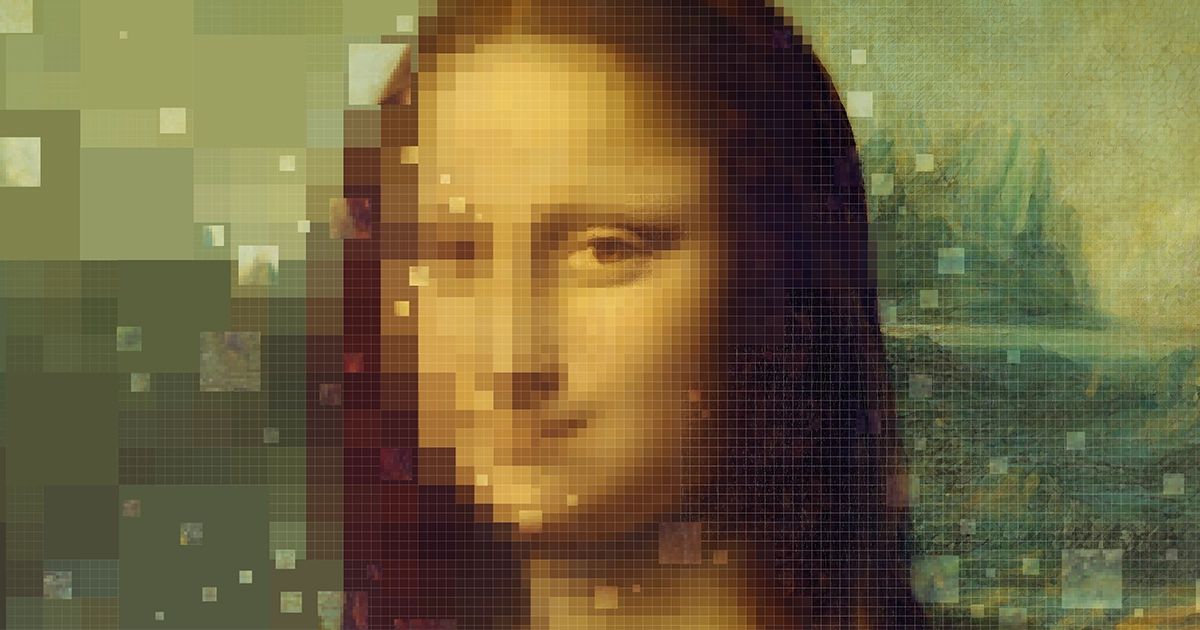

To jeden z największych stereotypów kryminałów i science fiction: śledczy wyświetla na ekranie komputera niewyraźne zdjęcie i prosi o jego poprawienie, i bum, obraz staje się ostry, odsłaniając istotną wskazówkę. To wspaniała wygoda w opowiadaniu historii, ale przez dziesięciolecia była to frustrująca fikcja – zbyt duże powiększenie obrazu powoduje widoczne piksele. Nie ma wystarczającej ilości danych, aby zrobić więcej.

„Jeśli po prostu naiwnie przeskalujesz obraz, będzie on rozmyty. Będzie dużo szczegółów, ale wszystko będzie nie tak” – powiedział Bryana Catanzaro, wiceprezes ds. badań stosowanych głębokiego uczenia się w firmie Nvidia.

Niedawno badacze i profesjonaliści zaczęli włączać algorytmy sztucznej inteligencji do swoich narzędzi do ulepszania obrazów, dzięki czemu proces ten jest łatwiejszy i wydajniejszy, ale nadal istnieją ograniczenia dotyczące ilości danych, które można pobrać z dowolnego obrazu. Na szczęście w miarę jak badacze coraz bardziej rozwijają algorytmy ulepszania, znajdują nowe sposoby radzenia sobie z tymi ograniczeniami, a czasami nawet znajdują sposoby na ich pokonanie.

W ostatniej dekadzie badacze zaczęli ulepszać obrazy za pomocą nowego rodzaju modelu sztucznej inteligencji zwanego generatywną siecią kontradyktoryjną (GAN), który może generować szczegółowe, imponująco wyglądające obrazy. „Obrazy nagle zaczęły wyglądać znacznie lepiej” – powiedział Tomer Michaeli, inżynier elektryk w Technion w Izraelu. Był jednak zaskoczony, że obrazy wykonane przez sieci GAN wykazywały wysoki poziom zniekształceń, który mierzy, jak blisko ulepszonego obrazu jest rzeczywista rzeczywistość tego, co pokazuje. GAN generowały obrazy, które wyglądały ładnie i naturalnie, ale w rzeczywistości zmyślały lub „halucynowały” szczegóły, które nie były dokładne, co rejestrowano jako wysoki poziom zniekształceń.

Michaeli obserwował, jak dziedzina renowacji zdjęć dzieli się na dwie odrębne społeczności. „Na jednym z nich pokazane były ładne zdjęcia, wiele z nich zostało wykonanych przez GAN. Drugi pokazywał dane, ale nie pokazywał wielu obrazów, ponieważ nie wyglądały ładnie” – powiedział.

W 2017 roku Michaeli i jego student Yochai Blau przyjrzeli się tej dychotomii bardziej formalnie. Nakreślili działanie różnych algorytmów ulepszania obrazu na wykresie zniekształcenia w funkcji jakości percepcyjnej, korzystając ze znanej miary jakości percepcyjnej, która dobrze koreluje z subiektywną oceną człowieka. Zgodnie z oczekiwaniami Michaeli, część algorytmów zapewniła bardzo wysoką jakość obrazu, inne natomiast były bardzo dokładne i charakteryzowały się niskimi zniekształceniami. Ale żaden nie miał obu zalet; trzeba było wybrać jedno albo drugie. Naukowcy nazwali to kompromis między zniekształceniem percepcji.

Michaeli także rzucał wyzwanie innym badaczom opracować algorytmy, które mogłyby zapewnić najlepszą jakość obrazu przy danym poziomie zniekształceń, aby umożliwić uczciwe porównania między algorytmami ładnych obrazów i algorytmami ładnych statystyk. Od tego czasu setki badaczy sztucznej inteligencji zgłosiło zniekształcenia i właściwości percepcyjne swoich algorytmów, cytując artykuł Michaeli i Blau który opisał kompromis.

Czasami konsekwencje kompromisu pomiędzy zniekształceniem percepcji nie są tragiczne. Nvidia na przykład odkryła, że ekrany o wysokiej rozdzielczości nie renderują dobrze treści wizualnych o niższej rozdzielczości, dlatego w lutym wypuściła narzędzie wykorzystujące głębokie uczenie się do ulepszania strumieniowego przesyłania wideo. W tym przypadku inżynierowie Nvidii przedłożyli jakość percepcyjną nad dokładność, akceptując fakt, że gdy algorytm przeskaluje wideo, dopracuje pewne szczegóły wizualne, których nie ma w oryginalnym filmie. „Modelka ma halucynacje. To wszystko domysły” – powiedział Catanzaro. „W większości przypadków model o super rozdzielczości może zgadnąć źle, pod warunkiem, że jest to spójne”.

Wprowadzenie

Zastosowania w badaniach i medycynie wymagają oczywiście znacznie większej dokładności. Technologia sztucznej inteligencji doprowadziła do znacznych postępów w obrazowaniu, ale „czasami wiąże się z niepożądanymi skutkami ubocznymi, takimi jak nadmierne dopasowanie lub [dodawanie] fałszywych funkcji, dlatego należy ją traktować ze szczególną ostrożnością” – stwierdziła. Junjie Yao, inżynier biomedyczny na Duke University. W zeszłym roku był współautorem m.in papier opisując, w jaki sposób narzędzia AI mogą ulepszyć istniejące metody pomiaru przepływu krwi i metabolizmu w mózgu, zachowując jednocześnie bezpieczeństwo po właściwej stronie kompromisu pomiędzy zniekształceniem percepcji.

Jednym ze sposobów obejścia ograniczeń dotyczących ilości danych, które można wyodrębnić z obrazu, jest po prostu włączenie danych z większej liczby obrazów — chociaż często nie jest to takie proste. Naukowcy badający środowisko za pomocą zdjęć satelitarnych poczynili postępy w łączeniu różnych źródeł danych wizualnych. W 2021 r. grupa badaczy z Chin i Wielkiej Brytanii połączone dane z dwóch różnych typów satelitów, aby uzyskać lepszy obraz wylesiania w Basenie Kongo, drugim co do wielkości tropikalnym lesie deszczowym na świecie i jednym z największych magazynów różnorodności biologicznej. Naukowcy zebrali dane z dwóch satelitów Landsat, które od dziesięcioleci mierzą wylesianie, i wykorzystali techniki głębokiego uczenia się, aby udoskonalić rozdzielczość zdjęć z 30 metrów do 10 metrów. Następnie połączyli ten zestaw obrazów z danymi z dwóch satelitów Sentinel-2, które mają nieco inny zestaw detektorów. Połączone zdjęcia „umożliwiły wykrycie od 11% do 21% więcej obszarów zaburzonych, niż było to możliwe przy użyciu samych obrazów Sentinel-2 lub Landsat-7/8” – napisali.

Michaeli sugeruje inny sposób obejścia, jeśli nie obejścia, twardych ograniczeń dostępności informacji. Zamiast skupiać się na jednej jednoznacznej odpowiedzi na pytanie, jak poprawić obraz o niskiej jakości, modele mogą przedstawiać wiele różnych interpretacji oryginalnego obrazu. W artykule zatytułowanym „Odkrywalna superrozdzielczość”, pomógł zademonstrować, w jaki sposób narzędzia do ulepszania obrazu mogą przedstawiać użytkownikowi wiele sugestii. Jeden niewyraźny obraz osoby ubranej w coś, co przypomina szarawą koszulę, o niskiej rozdzielczości, można zrekonstruować w obraz o wyższej rozdzielczości, na którym koszula ma czarno-białe pionowe, poziome paski lub kratkę, z których wszystkie są równie prawdopodobne .

W innym przykładzie Michaeli zrobił niskiej jakości zdjęcie tablicy rejestracyjnej i poddał je wiodącemu wzmacniaczowi obrazu AI, który pokazał, że cyfra 1 na tablicy rejestracyjnej najbardziej przypomina zero. Kiedy jednak obraz został przetworzony przy użyciu innego, bardziej otwartego algorytmu zaprojektowanego przez Michaeli, cyfra wydawała się równie prawdopodobna jako zero, 1 lub 8. Takie podejście mogłoby pomóc wykluczyć inne cyfry bez błędnego wniosku, że cyfra wynosi zero.

Ponieważ różne dyscypliny na swój własny sposób radzą sobie z kompromisem między zniekształceniem percepcji, kwestia tego, ile możemy wydobyć z obrazów AI i na ile możemy ufać tym obrazom, pozostaje kluczowa. „Powinniśmy pamiętać, że aby uzyskać takie ładne obrazy, algorytmy po prostu tworzą szczegóły” – powiedział Michaeli. Możemy złagodzić te halucynacje, ale wszechpotężny, rozwiązujący przestępstwa przycisk „wzmocnij” pozostanie marzeniem.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- ChartPrime. Podnieś poziom swojej gry handlowej dzięki ChartPrime. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://www.quantamagazine.org/the-ai-tools-making-images-look-better-20230823/

- :ma

- :Jest

- :nie

- ][P

- $W GÓRĘ

- 1

- 10

- 2017

- 2021

- 30

- 8

- a

- AC

- akceptując

- dostępność

- precyzja

- dokładny

- faktycznie

- dodanie

- zaliczki

- Zalety

- przeciwny

- AI

- algorytm

- Algorytmy

- Wszystkie kategorie

- dopuszczać

- sam

- również

- an

- i

- Inne

- odpowiedź

- każdy

- pojawia się

- stosowany

- podejście

- SĄ

- obszary

- na około

- Szyk

- sztuczny

- sztuczna inteligencja

- AS

- At

- BE

- bo

- staje się

- być

- zaczął

- BEST

- Ulepsz Swój

- pomiędzy

- Najwyższa

- biomedyczny

- Czarny

- krew

- wiać

- wysięgnik

- obie

- Mózg

- ale

- przycisk

- by

- nazywa

- CAN

- który

- walizka

- centralny

- Wykrywanie urządzeń szpiegujących

- Chiny

- wybrał

- Zamknij

- połączony

- łączenie

- jak

- byliśmy spójni, od początku

- komputer

- ekran komputera

- Kongo

- zgodny

- zawartość

- wygoda

- mógłby

- Kurs

- Przestępstwo

- dane

- dekada

- lat

- głęboko

- głęboka nauka

- wylesianie

- Kreowanie

- wykazać

- opisane

- zaprojektowany

- detal

- szczegółowe

- detale

- wykryte

- różne

- straszny

- dyscypliny

- odrębny

- do

- marzenie

- dubbingowane

- Książę

- uniwersytet książęcy

- łatwiej

- ruchomości

- inżynier

- Inżynierowie

- wzmacniać

- wzmocnione

- wzmocnienie

- dość

- Środowisko

- Równie

- niezbędny

- Parzyste

- EVER

- przykład

- Przede wszystkim system został opracowany

- spodziewany

- wyciąg

- skrajny

- fakt

- sprawiedliwy

- imitacja

- daleko

- Korzyści

- luty

- Fikcja

- pole

- znalezieniu

- w porządku

- Firma

- pływ

- Skupiać

- W razie zamówieenia projektu

- Formalnie

- znaleziono

- od

- frustrujące

- dalej

- generatywny

- otrzymać

- dany

- będzie

- absolwent

- wykres

- Zarządzanie

- miał

- Ciężko

- Have

- he

- pomoc

- pomógł

- Wysoki

- wysoka rozdzielczość

- jego

- Poziomy

- W jaki sposób

- How To

- HTTPS

- Setki

- IEEE

- if

- obraz

- zdjęcia

- Obrazowanie

- implikacje

- podnieść

- in

- włączać

- włączenie

- Informacja

- przykład

- zamiast

- Inteligencja

- najnowszych

- Izrael

- IT

- właśnie

- Trzymać

- Uprzejmy

- znany

- Nazwisko

- Ostatni rok

- prowadzący

- nauka

- Doprowadziło

- poziom

- poziomy

- Licencja

- lubić

- Prawdopodobnie

- Limity

- długo

- Popatrz

- wyglądał

- poszukuje

- Partia

- niski

- zrobiony

- magazyn

- poważny

- robić

- Dokonywanie

- wiele

- zmierzyć

- środków

- zmierzenie

- lekarstwo

- Metabolizm

- metody

- nic

- Złagodzić

- model

- modele

- jeszcze

- większość

- dużo

- wielokrotność

- Naturalny

- Natura

- wymagania

- netto

- sieć

- Nowości

- miło

- żaden

- Nvidia

- of

- często

- on

- ONE

- te

- or

- oryginalny

- Inne

- Pozostałe

- na zewnątrz

- wydajność

- koniec

- Przezwyciężać

- własny

- Papier

- Przeszłość

- postrzeganie

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- osoba

- wybierać

- Zdjęcia

- plato

- Analiza danych Platona

- PlatoDane

- do przyjęcia

- możliwy

- mocny

- teraźniejszość

- prezydent

- bardzo

- wygląda tak

- Obrobiony

- produkować

- Wytworzony

- specjalistów

- Postęp

- Ściąga

- Naciskać

- cechy

- jakość

- pytanie

- Rzeczywistość

- oczyścić

- zarejestrowany

- wydany

- pozostawać

- szczątki

- wykonanie

- Zgłoszone

- Badania naukowe

- Badacze

- Rozkład

- przywrócenie

- odkrywczy

- Zasada

- bezpiecznie

- Powiedział

- satelita

- Satelity

- nauka

- Fantastyka naukowa

- Ekran

- Ekrany

- drugi największy

- zestaw

- utknięcie

- powinien

- pokazać

- pokazał

- Targi

- bok

- Prosty

- po prostu

- ponieważ

- trochę inny

- So

- kilka

- Źródła

- dzielić

- rozpoczęty

- Nadal

- sklep

- opowiadanie

- Streaming

- Paski

- student

- Badanie

- taki

- Wskazuje

- Wspaniały

- zdziwiony

- Techniki

- Technologia

- niż

- że

- Połączenia

- świat

- ich

- Im

- następnie

- Tam.

- Te

- one

- to

- tych

- chociaż?

- Przez

- A zatem

- czas

- czasy

- pod tytulem

- do

- także

- wziął

- narzędzie

- narzędzia

- Zaufaj

- drugiej

- typy

- UK

- zasadniczy

- uniwersytet

- niepożądany

- używany

- Użytkownik

- zastosowania

- za pomocą

- różnorodny

- Przeciw

- pionowy

- początku.

- wice

- Wiceprezes

- Wideo

- Zobacz i wysłuchaj

- była

- Obserwowane

- Droga..

- sposoby

- we

- webp

- DOBRZE

- były

- Co

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- biały

- KIM

- będzie

- w

- bez

- wspaniale

- świat

- Źle

- napisał

- rok

- You

- zefirnet

- zero