Proces tworzenia modelu uczenia maszynowego (ML) jest iteracyjny, dopóki nie znajdziesz modelu kandydata, który działa dobrze i jest gotowy do wdrożenia. Gdy analitycy danych przechodzą przez ten proces, potrzebują niezawodnej metody łatwego śledzenia eksperymentów, aby zrozumieć, w jaki sposób została zbudowana każda wersja modelu i jak działała.

Amazon Sage Maker umożliwia zespołom korzystanie z szerokiej gamy funkcji do szybkiego przygotowywania, budowania, trenowania, wdrażania i monitorowania modeli ML. Rurociągi Amazon SageMaker zapewnia powtarzalny proces iteracji przez czynności budowania modelu i jest zintegrowany z Eksperymenty Amazon SageMaker. Domyślnie każdy potok programu SageMaker jest powiązany z eksperymentem, a każdy przebieg tego potoku jest śledzony jako próba w tym eksperymencie. Następnie Twoje iteracje są automatycznie śledzone bez żadnych dodatkowych kroków.

W tym poście przyjrzymy się bliżej motywacji stosowania zautomatyzowanego procesu śledzenia eksperymentów z eksperymentami i natywnych możliwości wbudowanych w Pipelines.

Dlaczego ważne jest organizowanie eksperymentów?

Cofnijmy się na chwilę i spróbujmy zrozumieć, dlaczego organizowanie eksperymentów pod kątem uczenia maszynowego jest ważne. Gdy analitycy danych podchodzą do nowego problemu z ML, muszą odpowiedzieć na wiele różnych pytań, od dostępności danych po sposób pomiaru wydajności modelu.

Na początku proces jest pełen niepewności i jest wysoce iteracyjny. W rezultacie ta faza eksperymentowania może generować wiele modeli, z których każdy jest tworzony na podstawie własnych danych wejściowych (zestawów danych, skryptów szkoleniowych i hiperparametrów) i wytwarzać własne dane wyjściowe (artefakty modeli i metryki oceny). Wyzwaniem jest zatem śledzenie wszystkich tych danych wejściowych i wyjściowych każdej iteracji.

Analitycy danych zazwyczaj szkolą wiele różnych wersji modelu, dopóki nie znajdą kombinacji transformacji danych, algorytmu i hiperparametrów, która skutkuje najlepszą wydajną wersją modelu. Każda z tych unikalnych kombinacji to pojedynczy eksperyment. Dzięki możliwemu do prześledzenia zapisowi danych wejściowych, algorytmów i hiperparametrów użytych w tej próbie zespół analityków danych może z łatwością odtworzyć swoje kroki.

Posiadanie zautomatyzowanego procesu śledzenia eksperymentów poprawia możliwość odtwarzania, a także wdrażania określonych, dobrze działających wersji modeli. Natywna integracja Pipelines z Experiments ułatwia automatyczne śledzenie eksperymentów i zarządzanie nimi w przebiegu potoku.

Korzyści z eksperymentów SageMaker

SageMaker Experiments pozwala analitykom danych organizować, śledzić, porównywać i oceniać ich iteracje szkoleniowe.

Zacznijmy najpierw od przeglądu tego, co możesz zrobić za pomocą eksperymentów:

- Organizuj eksperymenty – Eksperymenty strukturyzują eksperymentowanie z encją najwyższego poziomu o nazwie an eksperyment który zawiera zestaw Próby. Każda próba zawiera zestaw kroków zwanych komponenty próbne. Każdy komponent próbny jest kombinacją zbiorów danych, algorytmów i parametrów. Eksperymenty można zobrazować jako folder najwyższego poziomu do organizowania hipotez, próby jako podfoldery dla każdego przebiegu testu grupowego, a składniki próbne jako pliki dla każdego wystąpienia przebiegu testowego.

- Śledź eksperymenty – Eksperymenty umożliwiają analitykom danych śledzenie eksperymentów. Oferuje możliwość automatycznego przypisywania zadań SageMaker do wersji próbnej za pomocą prostych konfiguracji i śledzenia SDK.

- Porównaj i oceń eksperymenty – Integracja Eksperymentów z Studio Amazon SageMaker ułatwia tworzenie wizualizacji danych i porównywanie różnych prób. Możesz również uzyskać dostęp do danych próbnych za pośrednictwem pakietu Python SDK, aby wygenerować własną wizualizację przy użyciu preferowanych bibliotek kreślenia.

Aby dowiedzieć się więcej o interfejsach Experiments API i SDK, zalecamy zapoznanie się z następującą dokumentacją: Utwórz eksperyment i Amazon SageMaker Eksperymenty Python SDK.

Jeśli chcesz zanurkować głębiej, zalecamy zapoznanie się z amazon-sagemaker-examples/sagemaker-experiments repozytorium GitHub dla dalszych przykładów.

Integracja między rurociągami a eksperymentami

Potoki budowania modeli, które są częścią Pipelines, są specjalnie zbudowane dla ML i umożliwiają organizowanie zadań budowania modelu za pomocą narzędzia potoku, które obejmuje natywne integracje z innymi funkcjami SageMaker, a także elastyczność w rozszerzaniu potoku o kroki uruchamiane poza SageMaker . Każdy krok definiuje akcję podejmowaną przez potok. Zależności między krokami są definiowane przez bezpośredni wykres acykliczny (DAG) zbudowany przy użyciu pakietu Pipelines Python SDK. Możesz zbudować potok SageMaker programowo za pomocą tego samego zestawu SDK. Po wdrożeniu potoku możesz opcjonalnie zwizualizować jego przepływ pracy w Studio.

Pipelines automatycznie integruje się z eksperymentami, automatycznie tworząc eksperyment i próbę dla każdego uruchomienia. Potoki automatycznie tworzą eksperyment i próbę dla każdego uruchomienia potoku przed uruchomieniem kroków, chyba że określono jeden lub oba z tych danych wejściowych. Podczas uruchamiania zadania SageMaker potoku potok kojarzy wersję próbną z eksperymentem i kojarzy z wersją próbną każdy składnik próbny utworzony przez zadanie. Programowe określenie własnego eksperymentu lub wersji próbnej umożliwia precyzyjne dostosowanie sposobu organizacji eksperymentów.

Przepływ pracy, który przedstawiamy w tym przykładzie, składa się z szeregu kroków: kroku wstępnego przetwarzania, który dzieli nasz wejściowy zestaw danych na zestawy danych do trenowania, testowania i walidacji; krok dostrajania, aby dostroić nasze hiperparametry i rozpocząć zadania szkoleniowe, aby trenować model za pomocą Wbudowany algorytm XGBoost; i wreszcie krok modelu, aby utworzyć model SageMaker z najlepiej wytrenowanego artefaktu modelu. Pipelines oferuje również kilka obsługiwanych natywnie typy kroków poza tym, co omówiono w tym poście. Przedstawiamy również, w jaki sposób można śledzić przepływ pracy w potoku i generować metryki oraz wykresy porównawcze. Ponadto pokazujemy, jak powiązać nową wygenerowaną wersję próbną z istniejącym eksperymentem, który mógł zostać utworzony przed zdefiniowaniem potoku.

Kod potoków SageMaker

Notatnik możesz przejrzeć i pobrać z Repozytorium GitHub powiązane z tym postem. Przyglądamy się kodowi specyficznemu dla Pipelines, aby lepiej go zrozumieć.

Pipelines umożliwia przekazywanie parametrów w czasie wykonywania. Tutaj definiujemy typy instancji przetwarzania i trenowania oraz ich liczbę w czasie wykonywania z wstępnie ustawionymi wartościami domyślnymi:

Następnie konfigurujemy skrypt przetwarzania, który pobiera i dzieli wejściowy zestaw danych na części do trenowania, testowania i walidacji. Używamy SKLearnProcessor do uruchomienia tego etapu wstępnego przetwarzania. W tym celu definiujemy obiekt procesora z typem instancji i liczbą potrzebną do uruchomienia zadania przetwarzania.

Pipelines pozwala nam uzyskać wersjonowanie danych w sposób programistyczny przy użyciu zmiennych specyficznych dla wykonania, takich jak ExecutionVariables.PIPELINE_EXECUTION_ID, który jest unikalnym identyfikatorem uruchomienia potoku. Możemy na przykład stworzyć unikalny klucz do przechowywania wyjściowych zbiorów danych w Usługa Amazon Simple Storage (Amazon S3), który wiąże je z określonym przebiegiem rurociągu. Pełna lista zmiennych znajduje się w Zmienne wykonania.

Następnie przechodzimy do utworzenia obiektu estymatora, aby wytrenować model XGBoost. Ustawiamy kilka statycznych hiperparametrów, które są powszechnie używane w XGBoost:

Wykonujemy strojenie hiperparametrów tworzonych przez nas modeli za pomocą a ContinuousParameter zakres dla lambda. Wybranie jednej metryki jako metryki obiektywnej informuje tuner (instancję, która uruchamia zadania dostrajania hiperparametrów), że ocenisz zadanie uczenia na podstawie tej konkretnej metryki. Tuner zwraca najlepszą kombinację w oparciu o najlepszą wartość dla tej obiektywnej metryki, co oznacza najlepszą kombinację, która minimalizuje najlepszy błąd średniokwadratowy (RMSE).

Na etapie strojenia przeprowadza się wiele prób w celu określenia najlepszego modelu spośród testowanych zakresów parametrów. Metodą get_top_model_s3_uri, klasyfikujemy 50 najskuteczniejszych wersji artefaktu modelu S3 URI i wyodrębniamy tylko wersję o największej skuteczności (określamy k=0 najlepiej), aby stworzyć model SageMaker.

Po uruchomieniu potoku tworzy komponenty próbne dla każdego zadania dostrajania hiperparametrów i każdego zadania programu SageMaker utworzonego przez kroki potoku.

Możesz dalej skonfigurować integrację potoków z eksperymentami, tworząc PipelineExperimentConfig obiektu i przekaż go do obiektu potoku. Te dwa parametry definiują nazwę eksperymentu, który zostanie utworzony, oraz próbę, która będzie odnosić się do całego przebiegu potoku.

Jeśli chcesz skojarzyć przebieg potoku z istniejącym eksperymentem, możesz przekazać jego nazwę, a Pipelines skojarzy z nim nową wersję próbną. Możesz zapobiec tworzeniu eksperymentu i wersji próbnej dla potoku uruchamianego przez ustawienie pipeline_experiment_config do None.

Przekazujemy typy wystąpień i liczniki jako parametry i łączymy poprzednie kroki w następującej kolejności. Przepływ pracy potoku jest niejawnie definiowany przez dane wyjściowe kroku będące danymi wejściowymi innego kroku.

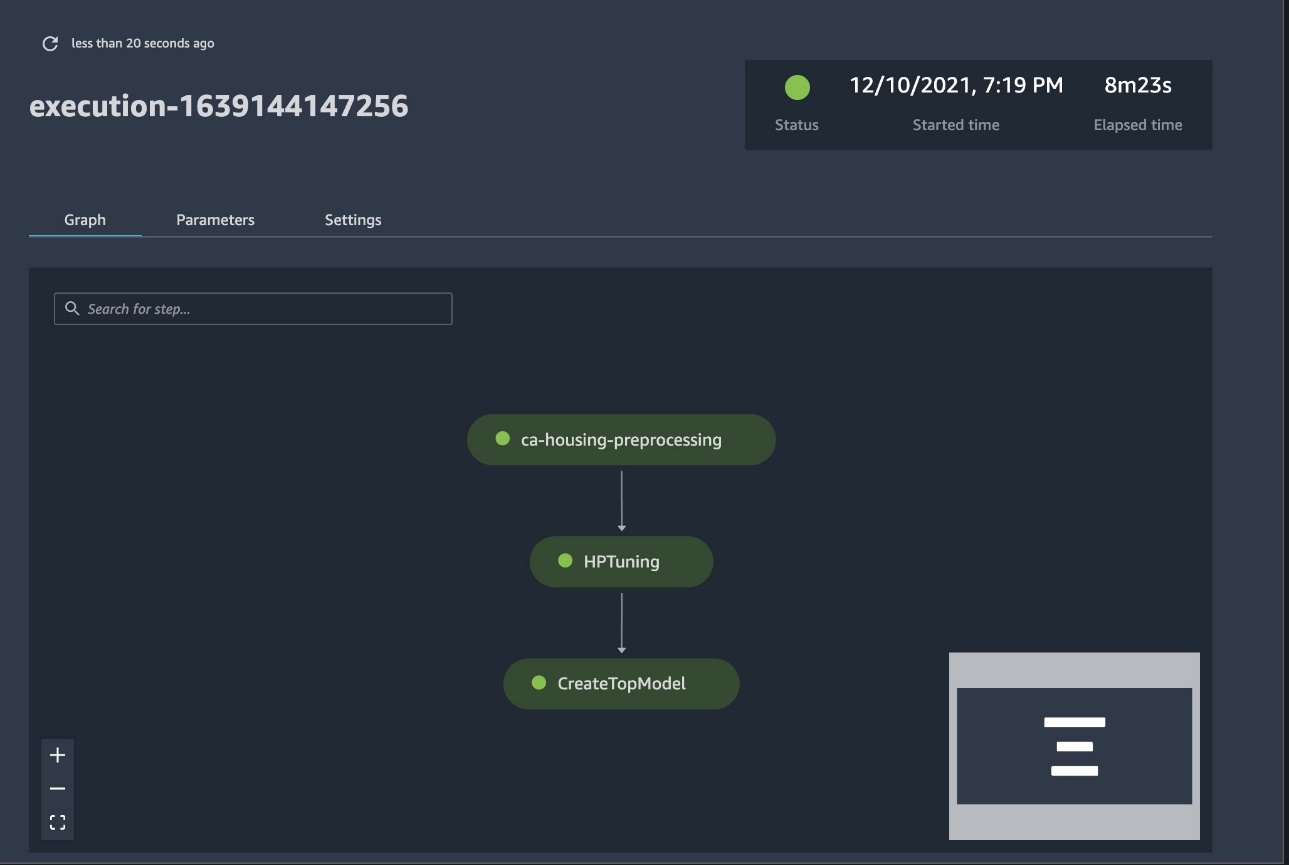

Pełnoprawny potok jest teraz utworzony i gotowy do pracy. Dodajemy rolę wykonania do potoku i uruchamiamy go. Stąd możemy przejść do konsoli SageMaker Studio Pipelines i wizualnie śledzić każdy krok. Możesz również uzyskać dostęp do połączonych dzienników z konsoli, aby debugować potok.

Powyższy zrzut ekranu pokazuje na zielono pomyślnie uruchomiony potok. Metryki jednej próby uzyskujemy z przebiegu potoku z następującym kodem:

Porównaj metryki dla każdego komponentu próbnego

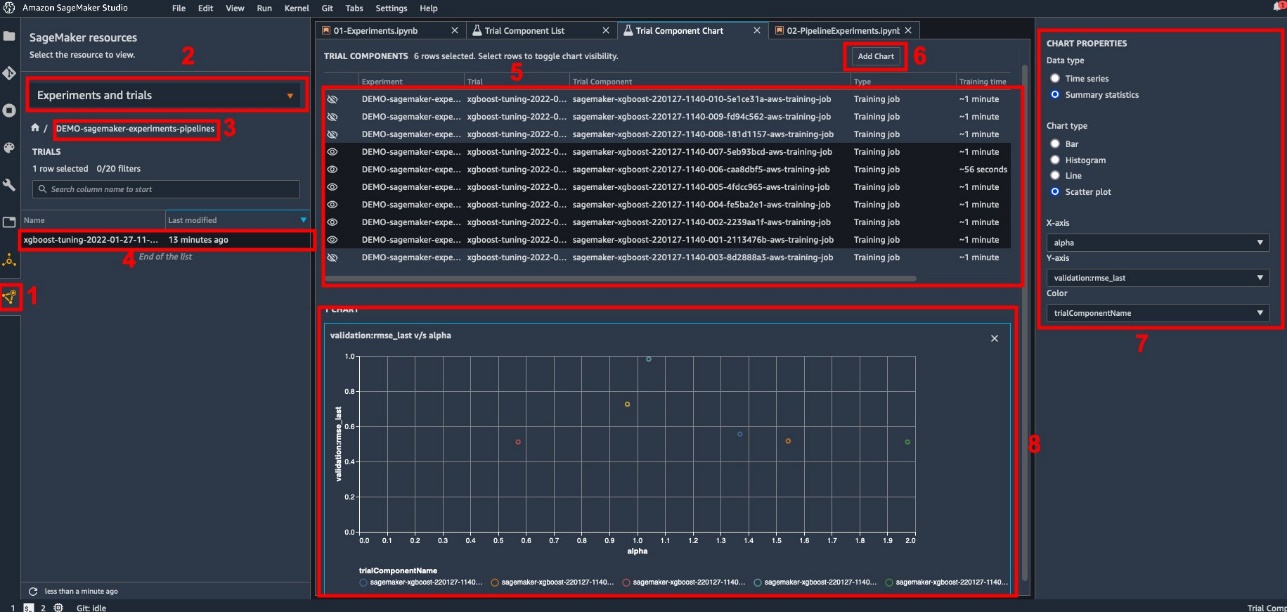

Wyniki dostrajania hiperparametrów można wykreślić w programie Studio lub za pośrednictwem innych bibliotek kreślenia języka Python. Pokazujemy oba sposoby robienia tego.

Poznaj dane treningowe i ewaluacyjne w Studio

Studio udostępnia interaktywny interfejs użytkownika, w którym można generować interaktywne wykresy. Kroki są następujące:

- Dodaj Eksperymenty i próby z Zasoby SageMaker ikona na lewym pasku bocznym.

- Wybierz eksperyment, aby go otworzyć.

- Wybierz (kliknij prawym przyciskiem myszy) interesującą Cię wersję próbną.

- Dodaj Otwórz na liście komponentów próbnych.

- Naciśnij przycisk Shift aby wybrać komponenty próbne reprezentujące zadania szkoleniowe.

- Dodaj Dodaj wykres.

- Dodaj Nowy wykres i dostosuj go, aby wykreślić zebrane metryki, które chcesz przeanalizować. W naszym przypadku zastosowania wybierz:

- W razie zamówieenia projektu Typ danychWybierz Statystyki podsumowujące.

- W razie zamówieenia projektu typ wykresuWybierz Wykres punktowy.

- W razie zamówieenia projektu Oś Xwybierz

lambda. - W razie zamówieenia projektu Oś Ywybierz

validation:rmse_last.

Nowy wykres pojawi się na dole okna, oznaczony jako „8”.

Możesz dodać więcej lub mniej zadań szkoleniowych, naciskając Shift i wybierając ikonę oka, aby uzyskać bardziej interaktywne wrażenia.

Analityka z eksperymentami SageMaker

Po zakończeniu przebiegu potoku możemy szybko zwizualizować porównanie różnych odmian modelu pod względem metryk zebranych podczas uczenia. Wcześniej wyeksportowaliśmy wszystkie metryki próbne do Pandy DataFrame za pomocą ExperimentAnalytics. Wykres uzyskany w Studio możemy odtworzyć za pomocą biblioteki Matplotlib.

Wnioski

Natywna integracja między SageMaker Pipelines i SageMaker Experiments umożliwia analitykom danych automatyczne organizowanie, śledzenie i wizualizację eksperymentów podczas działań związanych z opracowywaniem modeli. Możesz tworzyć eksperymenty, aby uporządkować wszystkie prace związane z rozwojem modelu, takie jak:

- Biznesowy przypadek użycia, którym się zajmujesz, np. tworzenie eksperymentu w celu przewidzenia rezygnacji klientów

- Na przykład eksperyment należący do zespołu data science dotyczący analityki marketingowej

- Konkretny projekt data science i ML

W tym poście zagłębiliśmy się w Pipelines, aby pokazać, jak można go używać w połączeniu z eksperymentami w celu zorganizowania w pełni zautomatyzowanego, kompleksowego przepływu pracy.

W następnym kroku możesz użyć tych trzech funkcji SageMaker – Studio, Eksperymenty i Potoki – w swoim następnym projekcie ML.

Sugerowane odczyty

O autorach

Paolo di Francesco jest architektem rozwiązań w AWS. Posiada doświadczenie w telekomunikacji i inżynierii oprogramowania. Pasjonuje się uczeniem maszynowym i obecnie koncentruje się na wykorzystaniu swojego doświadczenia, aby pomóc klientom osiągnąć ich cele w AWS, w szczególności w dyskusjach na temat MLOps. Poza pracą lubi grać w piłkę i czytać.

Paolo di Francesco jest architektem rozwiązań w AWS. Posiada doświadczenie w telekomunikacji i inżynierii oprogramowania. Pasjonuje się uczeniem maszynowym i obecnie koncentruje się na wykorzystaniu swojego doświadczenia, aby pomóc klientom osiągnąć ich cele w AWS, w szczególności w dyskusjach na temat MLOps. Poza pracą lubi grać w piłkę i czytać.

Mario Bourgoina jest Senior Partner Solutions Architect dla AWS, specjalistą AI/ML i globalnym liderem technologicznym dla MLOps. Współpracuje z klientami korporacyjnymi i partnerami wdrażającymi rozwiązania AI w chmurze. Ma ponad 30-letnie doświadczenie w uczeniu maszynowym i sztucznej inteligencji w startupach i przedsiębiorstwach, zaczynając od stworzenia jednego z pierwszych komercyjnych systemów uczenia maszynowego dla big data. Mario spędza wolny czas bawiąc się ze swoimi trzema belgijskimi tervurenami, gotując obiad dla swojej rodziny oraz ucząc się matematyki i kosmologii.

Mario Bourgoina jest Senior Partner Solutions Architect dla AWS, specjalistą AI/ML i globalnym liderem technologicznym dla MLOps. Współpracuje z klientami korporacyjnymi i partnerami wdrażającymi rozwiązania AI w chmurze. Ma ponad 30-letnie doświadczenie w uczeniu maszynowym i sztucznej inteligencji w startupach i przedsiębiorstwach, zaczynając od stworzenia jednego z pierwszych komercyjnych systemów uczenia maszynowego dla big data. Mario spędza wolny czas bawiąc się ze swoimi trzema belgijskimi tervurenami, gotując obiad dla swojej rodziny oraz ucząc się matematyki i kosmologii.

Ganapathi Krishnamoorthi jest starszym architektem rozwiązań ML w AWS. Ganapathi zapewnia nakazowe wskazówki klientom rozpoczynającym działalność i klientom korporacyjnym, pomagając im projektować i wdrażać aplikacje w chmurze na dużą skalę. Specjalizuje się w uczeniu maszynowym i koncentruje się na pomaganiu klientom w wykorzystywaniu AI/ML do osiągania wyników biznesowych. Kiedy nie jest w pracy, lubi zwiedzać plener i słuchać muzyki.

Ganapathi Krishnamoorthi jest starszym architektem rozwiązań ML w AWS. Ganapathi zapewnia nakazowe wskazówki klientom rozpoczynającym działalność i klientom korporacyjnym, pomagając im projektować i wdrażać aplikacje w chmurze na dużą skalę. Specjalizuje się w uczeniu maszynowym i koncentruje się na pomaganiu klientom w wykorzystywaniu AI/ML do osiągania wyników biznesowych. Kiedy nie jest w pracy, lubi zwiedzać plener i słuchać muzyki.

Valerie Sounthakith jest architektem rozwiązań dla AWS, pracującym w branży gier oraz z partnerami wdrażającymi rozwiązania AI. Swoją karierę zamierza budować wokół Computer Vision. W wolnym czasie Valerie spędza go na podróżach, odkrywaniu nowych miejsc do jedzenia i zmienianiu wnętrz swojego domu.

Valerie Sounthakith jest architektem rozwiązań dla AWS, pracującym w branży gier oraz z partnerami wdrażającymi rozwiązania AI. Swoją karierę zamierza budować wokół Computer Vision. W wolnym czasie Valerie spędza go na podróżach, odkrywaniu nowych miejsc do jedzenia i zmienianiu wnętrz swojego domu.

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- Amazon Sage Maker

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- Uczenie maszynowe AWS

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- zefirnet