Badacze odkryli ponad 100 złośliwych modeli uczenia maszynowego (ML) na platformie Hugging Face AI, które umożliwiają atakującym wstrzykiwanie złośliwego kodu na komputery użytkowników.

Chociaż Hugging Face wdraża środki bezpieczeństwa, ustalenia podkreślają rosnące ryzyko „uzbrojenia” publicznie dostępnych modeli, ponieważ mogą one stworzyć tylne drzwi dla atakujących.

Ustalenia JFrog Security Research stanowią część trwającego badania mającego na celu analizę, w jaki sposób hakerzy mogą wykorzystywać ML do atakowania użytkowników.

Szkodliwe treści

Zgodnie z artykułem autorstwa Computingbadacze opracowali zaawansowany system skanowania do analizy modeli hostowanych na platformie Hugging Face AI, takich jak PyTorch i Tensorflow Keras.

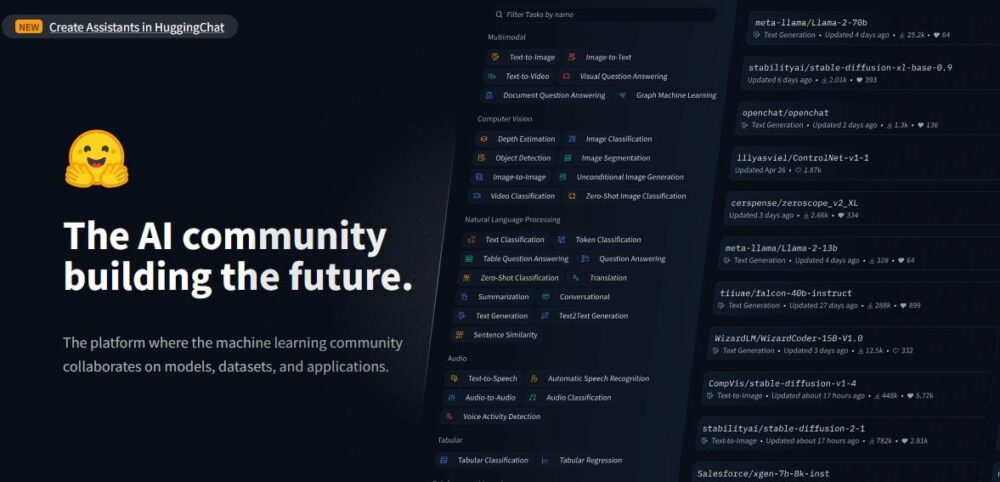

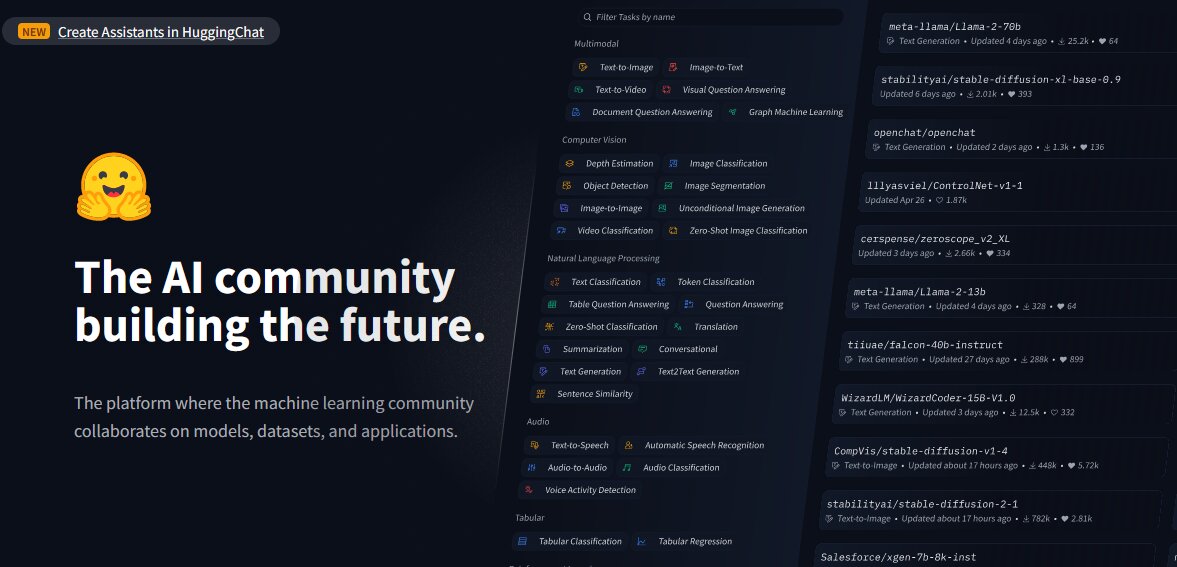

Hugging Face to platforma stworzona do udostępniania modeli AI, zbiorów danych i aplikacji. Analizując modele, naukowcy odkryli szkodliwe ładunki „w pozornie nieszkodliwych modelach”.

Dzieje się tak pomimo faktu, że Hugging Face stosuje środki bezpieczeństwa, takie jak skanowanie złośliwego oprogramowania i pikle. Platforma nie ogranicza jednak pobierania modeli, które mogą być potencjalnie szkodliwe, a także umożliwia ich publiczne udostępnienie Modele AI być nadużywane i wykorzystywane przez użytkowników.

Badając platformę i istniejące modele, badacze bezpieczeństwa firmy JFrog odkryli, zgodnie z ich danymi, około 100 modeli sztucznej inteligencji ze złośliwą funkcjonalnością. raport.

Z raportu wynika, że niektóre z tych modeli potrafią wykonywać kod na komputerach użytkowników, „tworząc w ten sposób trwałe backdoory dla atakujących”.

Naukowcy wskazali również, że takie odkrycia wykluczają wyniki fałszywie dodatnie. Ich zdaniem dokładnie odzwierciedlają one częstość występowania złośliwych modeli na platformie.

Przeczytaj także: Apple przekierowuje zespół samochodowy na spowolnienie rynku pojazdów elektrycznych po wprowadzeniu sztucznej inteligencji

Przykłady

Według raportu JFroga, jeden z „niepokojących” przypadków dotyczy: PyTorch Model. Według doniesień model został przesłany przez użytkownika zidentyfikowanego jako „baller423”, który następnie został usunięty z platformy Hugging Face.

Po dalszej analizie modelu badacze zauważyli, że zawierał on szkodliwy ładunek umożliwiający ustanowienie powłoki odwrotnej na określonym hoście (210.117.212.93).

Starszy badacz bezpieczeństwa JFrog, David Cohen, powiedział: „(To) jest znacznie bardziej inwazyjne i potencjalnie złośliwy, ponieważ ustanawia bezpośrednie połączenie z serwerem zewnętrznym, wskazując na potencjalne zagrożenie bezpieczeństwa, a nie zwykłą demonstrację podatności” – napisał.

Wykorzystuje to „metodę „_reduce_” modułu pickle Pythona do wykonania dowolnego kodu po załadowaniu pliku modelu, skutecznie omijając konwencjonalne metody wykrywania”.

Badacze zauważyli również, że ten sam ładunek tworzy połączenia z różnymi adresami IP, „co sugeruje, że operatorzy mogą być badaczami, a nie złośliwymi hakerami”.

Pobudka

Zespół JFrog zauważył, że odkrycia pobudziły Hugging Face i pokazały, że jego platforma jest podatna na manipulacje i potencjalne zagrożenia.

„Te incydenty w przejmujący sposób przypominają o ciągłych zagrożeniach, przed którymi stoją repozytoria Hugging Face i inne popularne repozytoria, takie jak Kaggle, które mogą potencjalnie zagrozić prywatności i bezpieczeństwu organizacji korzystających z tych zasobów, a także stwarzać wyzwania dla inżynierów AI/ML” – powiedział badacze.

To przychodzi jako zagrożenia cyberbezpieczeństwa na całym świecie rośnie, napędzany przez rozprzestrzenianie się narzędzi sztucznej inteligencji, a złe podmioty wykorzystują je w złych zamiarach. Hakerzy wykorzystują sztuczną inteligencję również do przeprowadzania ataków phishingowych i oszukiwania ludzi.

Jednak zespół JFrog dokonał innych odkryć.

Plac zabaw dla badaczy

Naukowcy również to zauważyli Przytulanie Twarzy przekształciło się w plac zabaw dla badaczy, „którzy chcą zwalczać pojawiające się zagrożenia, o czym świadczy różnorodny wachlarz taktyk pozwalających ominąć środki bezpieczeństwa”.

Na przykład ładunek przesłany przez „baller423” zainicjował połączenie odwrotnej powłoki z zakresem adresów IP należącym do Kreonet (Korea Research Environment Open Network).

Zgodnie z Mroczne czytanieKreonet to szybka sieć w Korei Południowej wspierająca zaawansowane badania i działania edukacyjne; „Dlatego możliwe jest, że za modelem stali badacze lub praktycy sztucznej inteligencji”.

„Widzimy, że większość „złośliwych” ładunków to w rzeczywistości próby badaczy i/lub nagrody za błędy mające na celu uzyskanie wykonania kodu w pozornie uzasadnionych celach” – powiedział Cohen.

Pomimo uzasadnionych celów zespół JFrog ostrzegł jednak, że strategie stosowane przez badaczy wyraźnie pokazują, że platformy takie jak Hugging Face są otwarte na ataki na łańcuch dostaw. Zdaniem zespołu można je dostosować tak, aby skupiały się na określonych grupach demograficznych, np. na inżynierach AI lub ML.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://metanews.com/over-100-malicious-code-execution-models-on-hugging-face-backdoors-users-devices/

- :ma

- :Jest

- :nie

- 100

- 210

- 212

- 7

- 9

- a

- O nas

- Stosownie

- dokładny

- zajęcia

- aktorzy

- faktycznie

- dodatek

- adres

- Adresy

- awansować

- zaawansowany

- AI

- Modele AI

- Platforma AI

- AI / ML

- również

- an

- w czasie rzeczywistym sprawiają,

- Analizując

- i

- aplikacje

- arbitralny

- SĄ

- Szyk

- artykuł

- AS

- atakować

- Ataki

- Próby

- dostępny

- tylne drzwi

- Łazienka

- BE

- być

- za

- należy

- hojność

- Bug

- nagroda za błąd

- by

- bypass

- wezwanie

- CAN

- zdolny

- wózek

- Etui

- wyzwania

- wyraźnie

- CO

- kod

- Cohen

- zwalczania

- byliśmy spójni, od początku

- kompromis

- computing

- połączenie

- połączenia

- zawarte

- Konwencjonalny

- mógłby

- Stwórz

- Tworzenie

- dostosowane

- zbiory danych

- David

- Demografia

- wykazać

- wykazać

- Mimo

- Wykrywanie

- rozwinięty

- różne

- kierować

- odkryty

- inny

- robi

- pobieranie

- edukacyjny

- faktycznie

- wschodzących

- zatrudniony

- umożliwiać

- Umożliwia

- umożliwiając

- Inżynierowie

- Środowisko

- zapewniają

- ustanawia

- ewoluowały

- Badanie

- wykonać

- wykonywania

- egzekucja

- Przede wszystkim system został opracowany

- zewnętrzny

- Twarz

- okładzina

- fakt

- fałszywy

- filet

- Ustalenia

- Skupiać

- W razie zamówieenia projektu

- Nasz formularz

- od

- podsycane

- Funkcjonalność

- dalej

- otrzymać

- Rozwój

- hakerzy

- szkodliwy

- Have

- he

- Wysoki

- Atrakcja

- gospodarz

- hostowane

- W jaki sposób

- Jednak

- HTTPS

- zidentyfikowane

- narzędzia

- in

- Zwiększać

- wskazany

- wskazuje

- wskazując,

- zapoczątkowany

- wstrzykiwać

- przykład

- intencje

- najnowszych

- intrusively

- dotyczy

- IP

- Adres IP

- Adresy IP

- IT

- JEGO

- jpg

- keras

- Korea

- nauka

- prawowity

- wykorzystuje

- lubić

- załadunek

- maszyna

- uczenie maszynowe

- maszyny

- zrobiony

- złośliwy

- malware

- Manipulacja

- rynek

- Maksymalna szerokość

- Może..

- środków

- sam

- metoda

- metody

- ML

- model

- modele

- jeszcze

- większość

- sieć

- szczególnie

- zauważyć

- of

- on

- ONE

- trwający

- na

- koncepcja

- otwarta sieć

- operatorzy

- or

- organizacji

- Inne

- na zewnątrz

- koniec

- część

- Ludzie

- phishing

- ataki phishingowe

- Platforma

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- plac zabaw dla dzieci

- Popularny

- możliwy

- potencjał

- potencjalnie

- rozpowszechnienie

- prywatność

- Prywatność i bezpieczeństwo

- publicznie

- cele

- płomień

- zasięg

- raczej

- Czytaj

- uznane

- raport

- podobno

- reprezentacja

- Badania naukowe

- badacz

- Badacze

- Zasoby

- ograniczać

- rewers

- Ryzyko

- Powiedział

- taki sam

- skanowanie

- bezpieczeństwo

- Środki bezpieczeństwa

- widzieć

- pozornie

- senior

- służyć

- serwer

- dzielenie

- Powłoka

- seans

- Południe

- Korea Południowa

- specyficzny

- określony

- strategie

- Badanie

- Następnie

- taki

- Wspierający

- system

- taktyka

- zespół

- tensorflow

- niż

- że

- Połączenia

- ich

- Im

- Te

- one

- groźba

- zagrożenia

- do

- narzędzia

- sztuczka

- przesłanych

- na

- posługiwać się

- Użytkownik

- Użytkownicy

- za pomocą

- Wykorzystując

- wrażliwość

- ostrzeżony

- była

- który

- chcieć

- w

- świat

- napisał

- zefirnet