Zespoły zajmujące się analizą danych i inżynierią danych spędzają znaczną część swojego czasu na etapie przygotowywania danych w cyklu życia uczenia maszynowego (ML), wykonując etapy selekcji, czyszczenia i transformacji danych. Jest to niezbędny i ważny etap każdego przepływu pracy ML w celu wygenerowania znaczących spostrzeżeń i prognoz, ponieważ złe lub niskiej jakości dane znacznie zmniejszają znaczenie uzyskanych spostrzeżeń.

Zespoły inżynierii danych są tradycyjnie odpowiedzialne za pozyskiwanie, konsolidację i przekształcanie surowych danych do wykorzystania w dalszej części procesu. Analitycy danych często muszą wykonać dodatkowe przetwarzanie danych na potrzeby przypadków użycia ML specyficznych dla domeny, takich jak język naturalny i szeregi czasowe. Na przykład niektóre algorytmy ML mogą być wrażliwe na brakujące wartości, rzadkie cechy lub wartości odstające i wymagają szczególnej uwagi. Nawet w przypadkach, gdy zbiór danych jest w dobrym stanie, badacze danych mogą chcieć przekształcić rozkłady cech lub utworzyć nowe funkcje, aby zmaksymalizować wnioski uzyskane z modeli. Aby osiągnąć te cele, badacze danych muszą polegać na zespołach zajmujących się inżynierią danych, aby uwzględnić żądane zmiany, co skutkuje zależnością i opóźnieniami w procesie opracowywania modelu. Alternatywnie zespoły zajmujące się analizą danych mogą zdecydować się na wewnętrzne przygotowanie danych i inżynierię funkcji, korzystając z różnych paradygmatów programowania. Wymaga to jednak inwestycji czasu i wysiłku w instalację i konfigurację bibliotek i frameworków, co nie jest rozwiązaniem idealnym, ponieważ ten czas można lepiej wykorzystać na optymalizację wydajności modelu.

Pogromca danych Amazon SageMaker upraszcza proces przygotowywania danych i inżynierii funkcji, skracając czas potrzebny na agregację i przygotowanie danych do ML z tygodni do minut, zapewniając pojedynczy interfejs wizualny dla analityków danych w celu wybierania, czyszczenia i eksplorowania zbiorów danych. Data Wrangler oferuje ponad 300 wbudowanych transformacji danych, które pomagają normalizować, przekształcać i łączyć funkcje bez pisania kodu. Możesz importować dane z wielu źródeł danych, np Usługa Amazon Simple Storage (Amazon S3), Amazonka Atena, Amazonka Przesunięcie ku czerwieni, Snowflake. Teraz możesz także skorzystać Pamięci danych jako źródło danych w Data Wrangler, aby łatwo przygotować dane dla ML.

Platforma Databricks Lakehouse łączy najlepsze elementy jezior danych i hurtowni danych, aby zapewnić niezawodność, dobre zarządzanie i wydajność hurtowni danych z otwartością, elastycznością i obsługą uczenia maszynowego jezior danych. Dzięki Databricks jako źródłu danych dla Data Wrangler możesz teraz szybko i łatwo łączyć się z Databricks, interaktywnie wysyłać zapytania do danych przechowywanych w Databricks przy użyciu SQL i przeglądać dane przed importem. Ponadto możesz łączyć swoje dane w Databricks z danymi przechowywanymi w Amazon S3 oraz danymi przesyłanymi do zapytań za pośrednictwem Amazon Athena, Amazon Redshift i Snowflake, aby utworzyć odpowiedni zestaw danych dla Twojego przypadku użycia ML.

W tym poście przekształcamy zbiór danych Lending Club Loan za pomocą Amazon SageMaker Data Wrangler do wykorzystania w szkoleniu modelu ML.

Omówienie rozwiązania

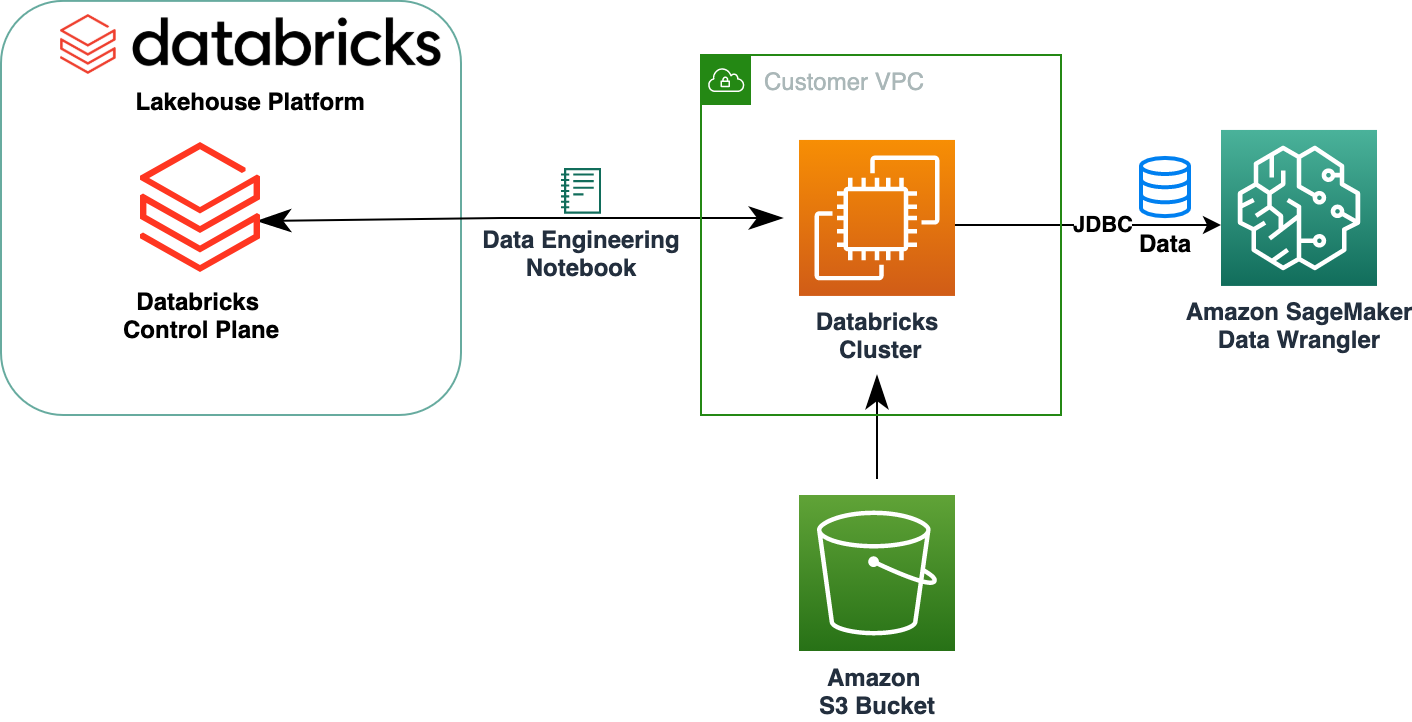

Poniższy diagram ilustruje naszą architekturę rozwiązania.

Zbiór danych Lending Club Loan zawiera pełne dane dotyczące wszystkich pożyczek udzielonych w latach 2007–2011, w tym bieżący status pożyczki i najnowsze informacje o płatnościach. Zawiera 39,717 22 wierszy, 3 kolumny funkcji i XNUMX etykiety celów.

Aby przekształcić nasze dane za pomocą Data Wrangler, wykonujemy następujące kroki wysokiego poziomu:

- Pobierz i podziel zestaw danych.

- Utwórz przepływ Data Wrangler.

- Importuj dane z Databricks do Data Wrangler.

- Importuj dane z Amazon S3 do Data Wrangler.

- Dołącz do danych.

- Zastosuj przekształcenia.

- Eksportuj zbiór danych.

Wymagania wstępne

W poście założono, że masz działający klaster Databricks. Jeśli Twój klaster działa na platformie AWS, sprawdź, czy masz skonfigurowane następujące elementy:

Konfiguracja kostek danych

- An profil instancji z wymaganymi uprawnieniami dostępu do segmentu S3

- A zasady dotyczące zasobników z wymaganymi uprawnieniami dla docelowego segmentu S3

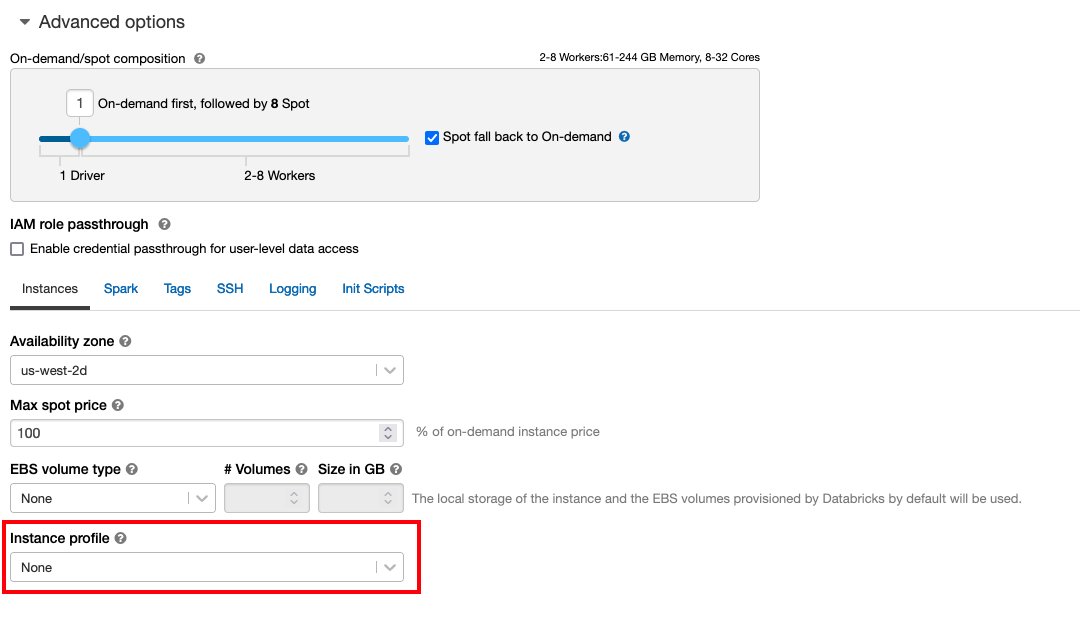

Obserwuj Bezpieczny dostęp do zasobników S3 przy użyciu profili instancji dla wymaganych AWS Zarządzanie tożsamością i dostępem (IAM), zasady zasobnika S3 i konfiguracja klastra Databricks. Upewnij się, że klaster Databricks jest skonfigurowany przy użyciu odpowiedniego pliku Instance Profile, wybrane w opcjach zaawansowanych, aby uzyskać dostęp do żądanego segmentu S3.

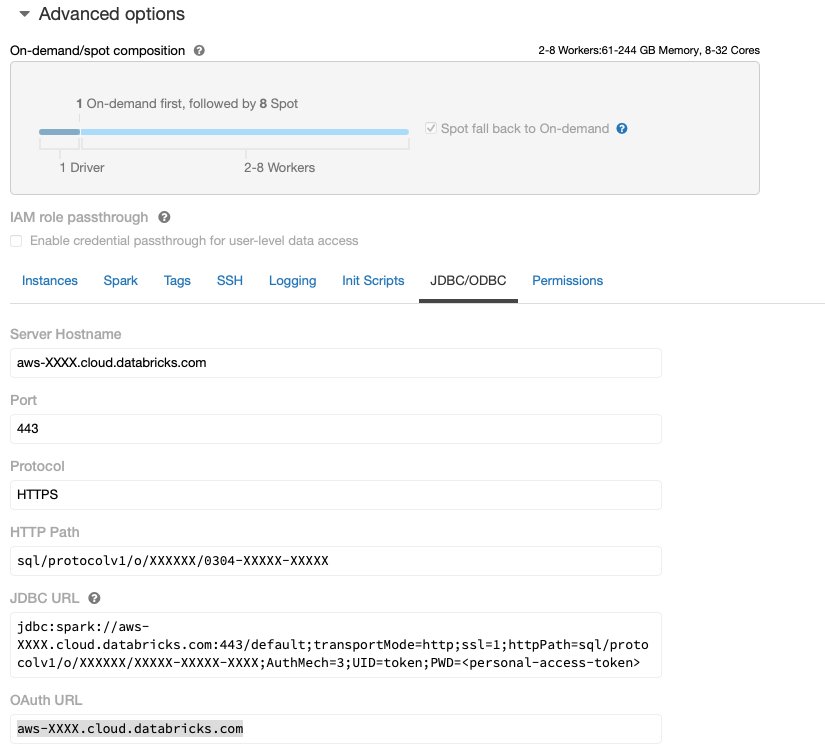

Po uruchomieniu klastra Databricks z wymaganym dostępem do Amazon S3 możesz pobrać plik JDBC URL z klastra Databricks, aby Data Wrangler mógł się z nim połączyć.

Pobierz adres URL JDBC

Aby pobrać adres URL JDBC, wykonaj następujące kroki:

- W Databricks przejdź do interfejsu użytkownika klastrów.

- Wybierz swój klaster.

- Na systemu kartę, wybierz Opcje zaawansowane.

- Pod Opcje zaawansowane, Wybierz JDBC/ODBC patka.

- Skopiuj adres URL JDBC.

Pamiętaj o zastąpieniu dostępu osobistego żeton w adresie URL.

Konfiguracja Data Wranglera

W tym kroku założono, że masz dostęp do przykładu Amazon SageMaker Studio Amazon SageMakeri użytkownikiem Studio.

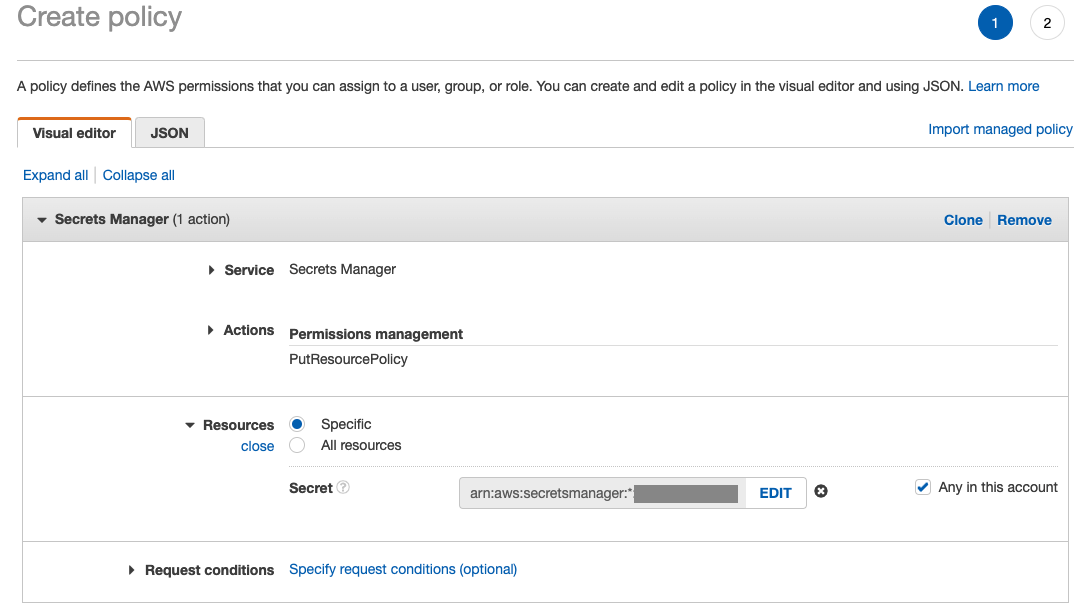

Aby zezwolić na dostęp do połączenia Databricks JDBC z Data Wrangler, użytkownik Studio wymaga następujących uprawnień:

secretsmanager:PutResourcePolicy

Wykonaj poniższe kroki, aby zaktualizować rolę wykonywania uprawnień przypisaną do użytkownika Studio z powyższymi uprawnieniami, jako użytkownik administracyjny uprawnień.

- W konsoli IAM wybierz role w okienku nawigacji.

- Wybierz rolę przypisaną do użytkownika Studio.

- Dodaj Dodaj uprawnienia.

- Dodaj Utwórz politykę inline.

- W obszarze Usługa wybierz Menedżer tajemnic.

- On Akcjewybierz Poziom dostępu.

- Dodaj Zarządzanie uprawnieniami.

- Dodaj PutResourcePolicy.

- W razie zamówieenia projektu Zasobywybierz Konkretny nastepnie: Dowolny na tym koncie.

Pobierz i podziel zestaw danych

Możesz zacząć od pobranie zbioru danych. W celach demonstracyjnych podzieliliśmy zbiór danych, kopiując kolumny funkcji id, emp_title, emp_length, home_owner, annual_inc stworzyć drugi pożyczki_2.csv plik. Usuwamy wyżej wymienione kolumny z oryginalnego pliku pożyczek, z wyjątkiem id kolumnę i zmień nazwę oryginalnego pliku na pożyczki_1.csv. Prześlij plik pożyczki_1.csv złożyć do Pamięci danych aby utworzyć tabelę loans_1 i pożyczki_2.csv w wiadrze S3.

Utwórz przepływ Data Wrangler

Aby uzyskać informacje na temat wymagań wstępnych Data Wrangler, zobacz Zacznij korzystać z Data Wranglera.

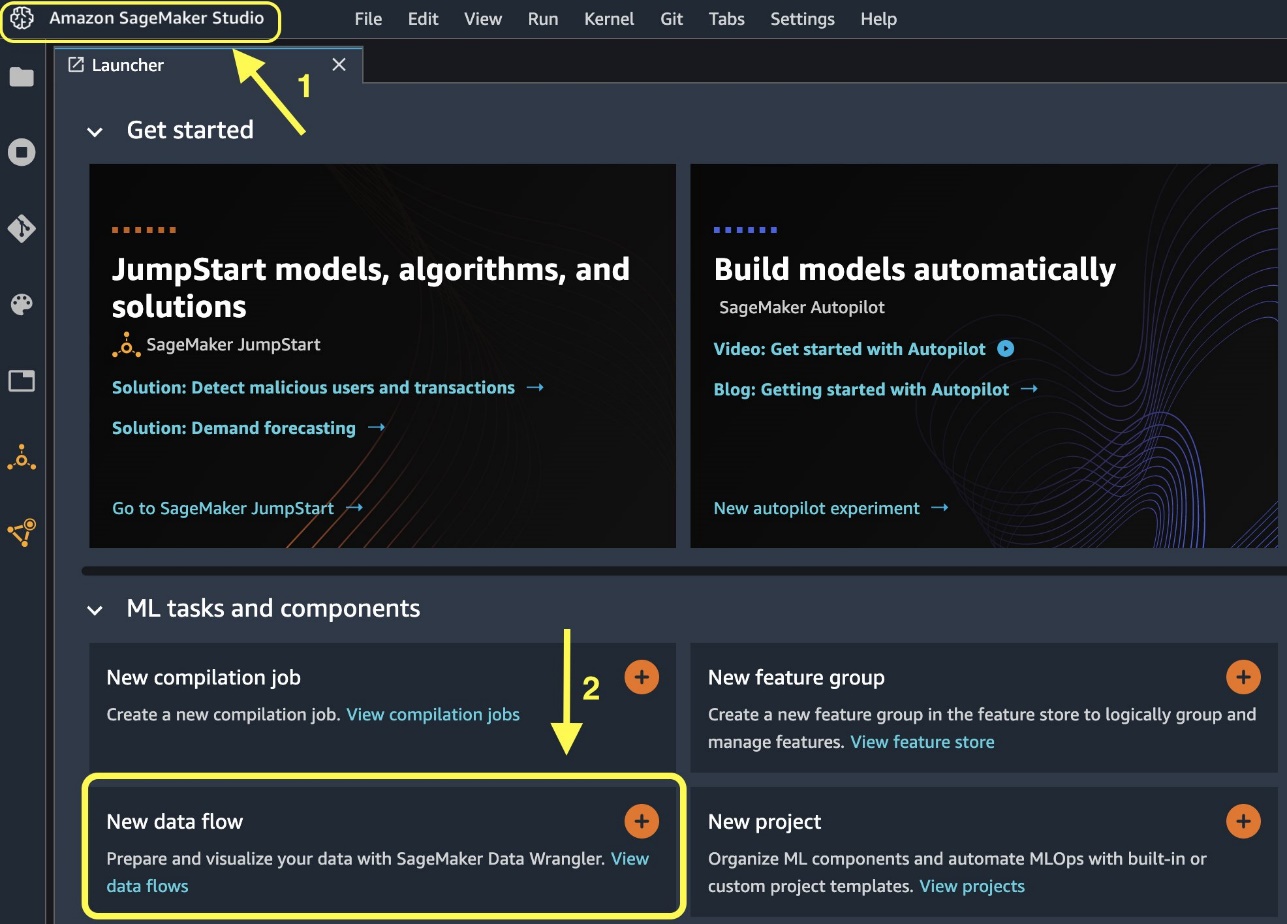

Zacznijmy od utworzenia nowego przepływu danych.

- Na konsoli Studio w filet menu, wybierz Nowości.

- Dodaj Przepływ danych Wranglera.

- Zmień nazwę przepływu według potrzeb.

Alternatywnie możesz utworzyć nowy przepływ danych z poziomu Launchera.

Utworzenie nowego przepływu może zająć kilka minut. Po utworzeniu przepływu zostanie wyświetlony komunikat Importuj daty strona.

Importuj dane z Databricks do Data Wrangler

Następnie konfigurujemy Databricks (JDBC) jako źródło danych w Data Wrangler. Aby zaimportować dane z Databricks, musimy najpierw dodać Databricks jako źródło danych.

- Na Importuj daty kartę przepływu Data Wrangler, wybierz Dodaj źródło danych.

- Z menu rozwijanego wybierz Kostki danych (JDBC).

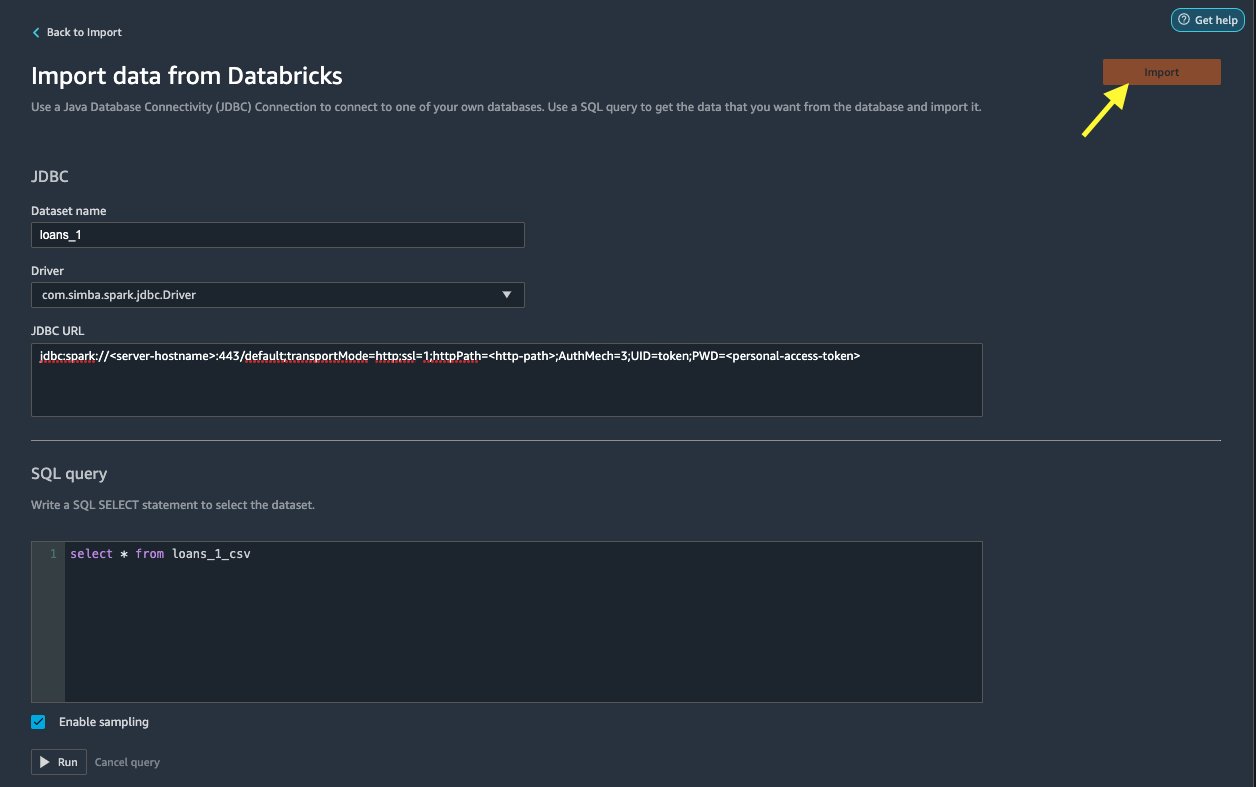

Na Importuj dane z Databricks stronie, wpisz szczegóły swojego klastra.

- W razie zamówieenia projektu Nazwa zestawu danych, wprowadź nazwę, której chcesz używać w pliku przepływu.

- W razie zamówieenia projektu Kierowca, wybierz sterownik

com.simba.spark.jdbc.Driver. - W razie zamówieenia projektu URL JDBCwprowadź uzyskany wcześniej adres URL klastra Databricks.

Adres URL powinien przypominać następujący format jdbc:spark://<serve- hostname>:443/default;transportMode=http;ssl=1;httpPath=<http- path>;AuthMech=3;UID=token;PWD=<personal-access-token>.

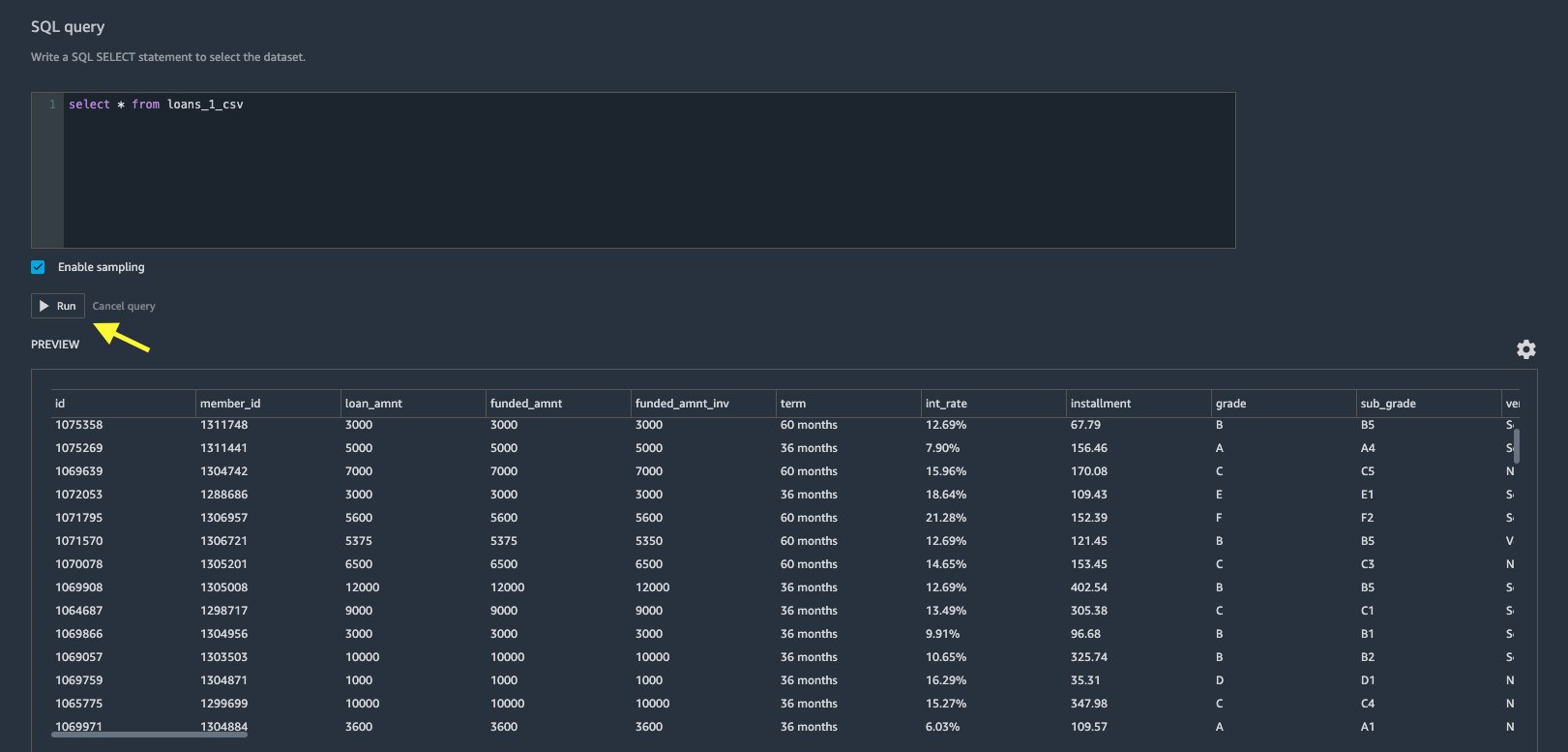

- W edytorze zapytań SQL określ następującą instrukcję SQL SELECT:

Jeśli podczas przesyłania danych do Databricks wybrałeś inną nazwę tabeli, zastąp odpowiednio pożyczki_1 w powyższym zapytaniu SQL.

W Zapytanie SQL sekcji w Data Wrangler, możesz wysyłać zapytania do dowolnej tabeli połączonej z bazą danych JDBC Databricks. Wstępnie wybrane Włącz próbkowanie ustawienie domyślnie pobiera pierwsze 50,000 XNUMX wierszy zestawu danych. W zależności od rozmiaru zbioru danych odznaczenie Włącz próbkowanie może skutkować dłuższym czasem importu.

- Dodaj run.

Uruchomienie zapytania daje podgląd zbioru danych Databricks bezpośrednio w Data Wrangler.

Data Wrangler zapewnia elastyczność konfiguracji wielu jednoczesnych połączeń z jednym klastrem Databricks lub z wieloma klastrami, jeśli jest to wymagane, umożliwiając analizę i przygotowanie połączonych zestawów danych.

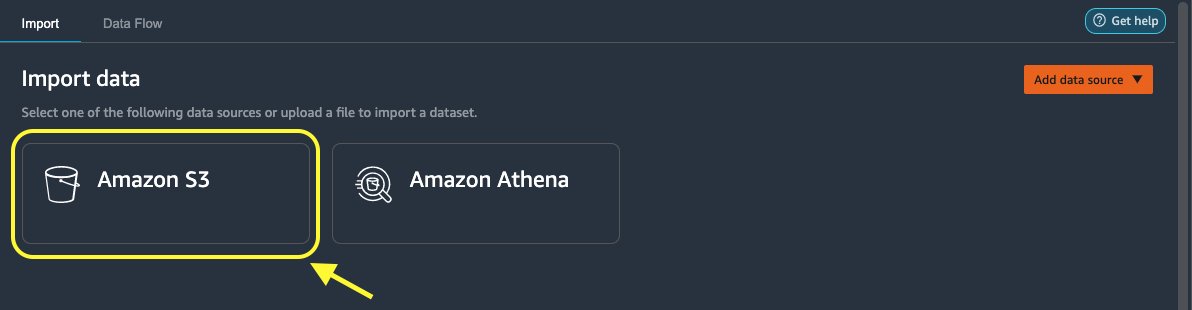

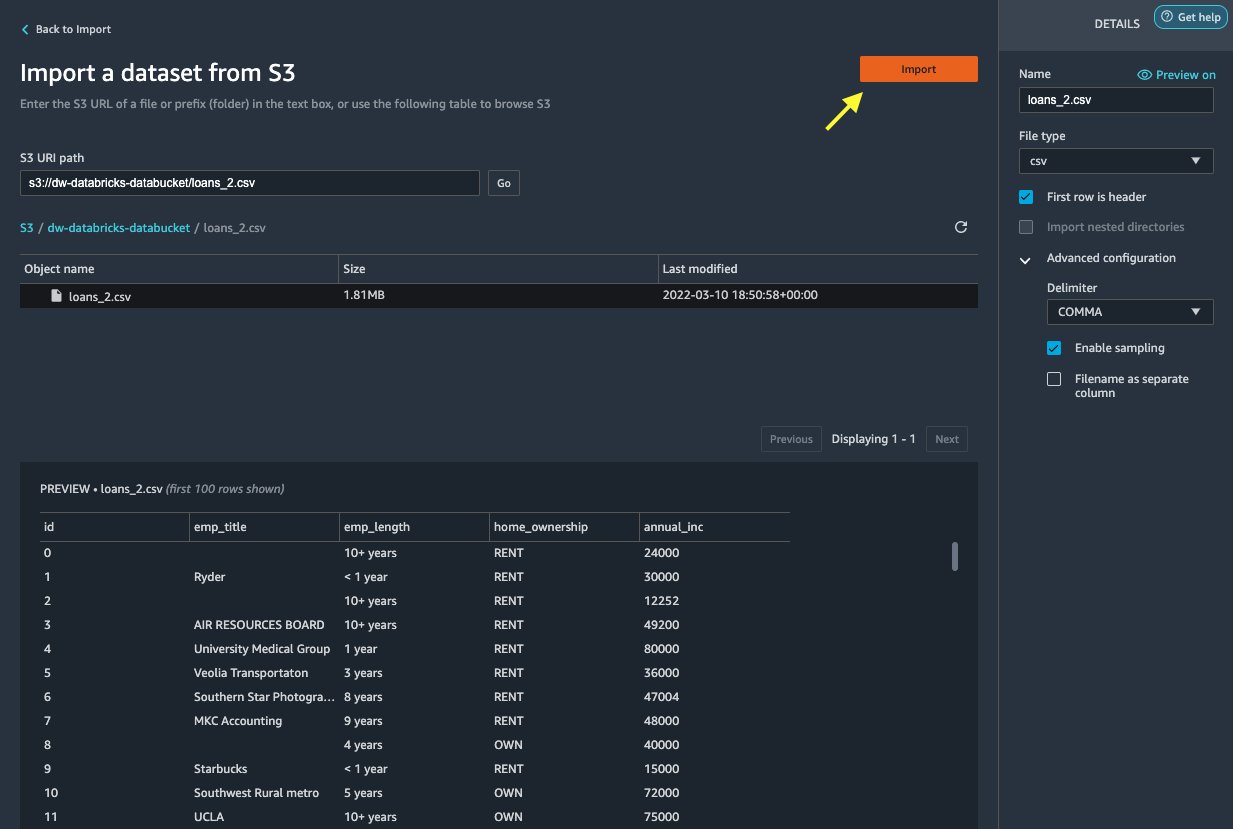

Zaimportuj dane z Amazon S3 do Data Wrangler

Następnie zaimportujmy plik loan_2.csv plik z Amazon S3.

- Na karcie Import wybierz Amazon S3 jako źródło danych.

- Przejdź do zasobnika S3 dla pliku

loan_2.csvplik.

Po wybraniu pliku CSV można wyświetlić podgląd danych.

- W Szczegóły okienko, wybierz Zaawansowana konfiguracja upewnić się Włącz próbkowanie jest wybrany i USTĘP jest wybrany do Ogranicznik.

- Dodaj import.

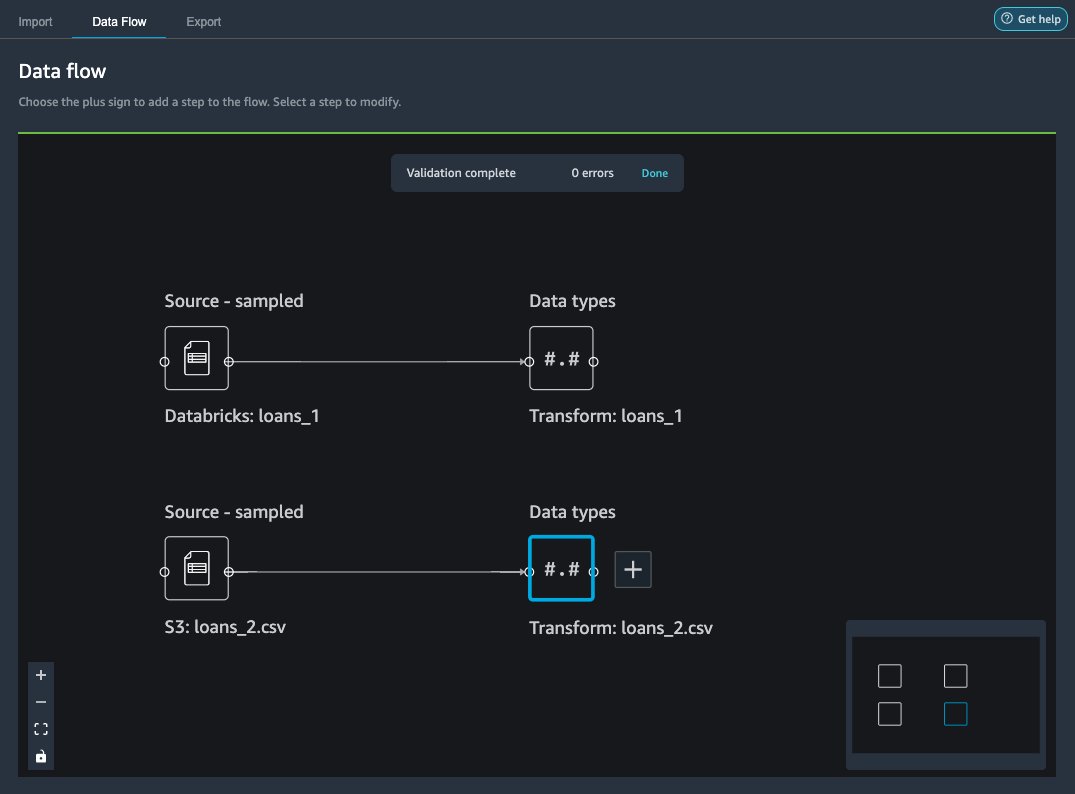

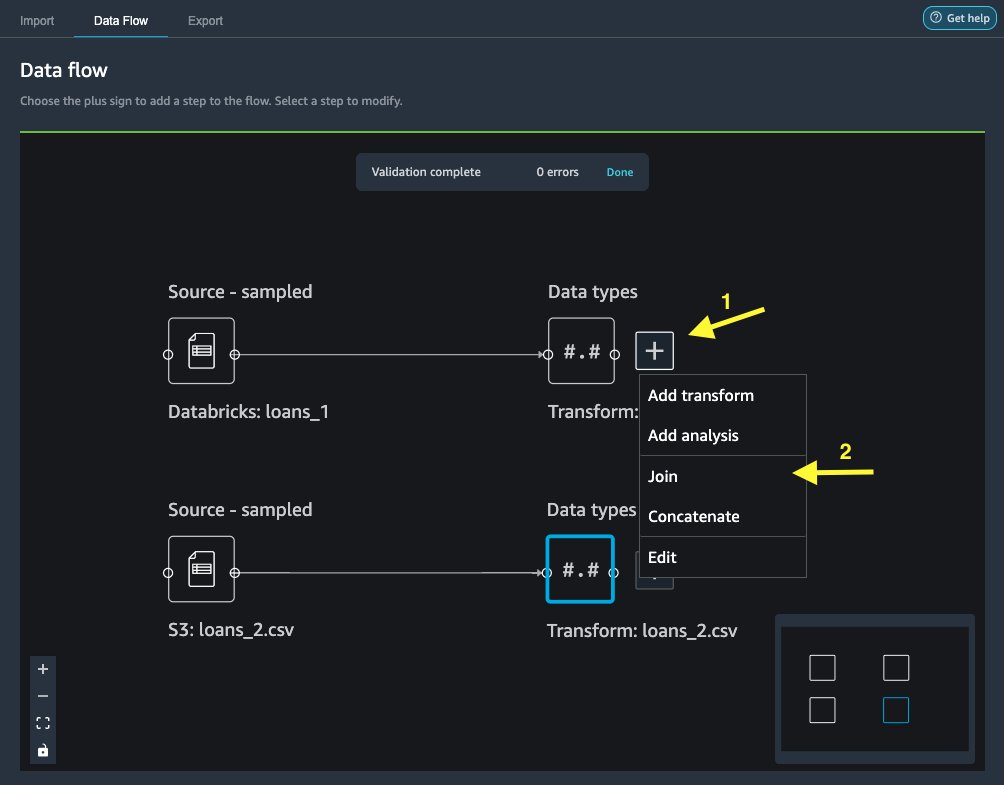

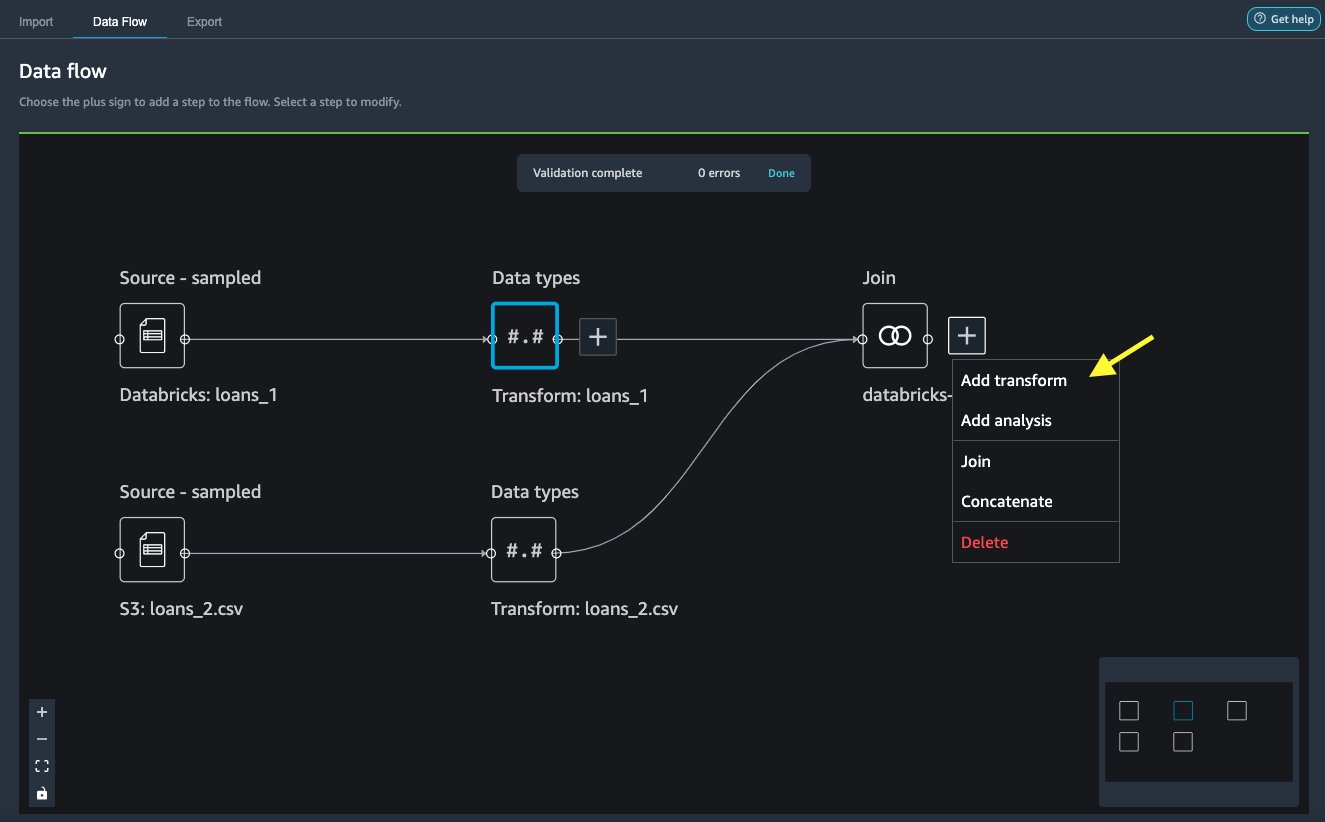

Po loans_2.csv zestaw danych został pomyślnie zaimportowany, interfejs przepływu danych wyświetla źródła danych Databricks JDBC i Amazon S3.

Dołącz do danych

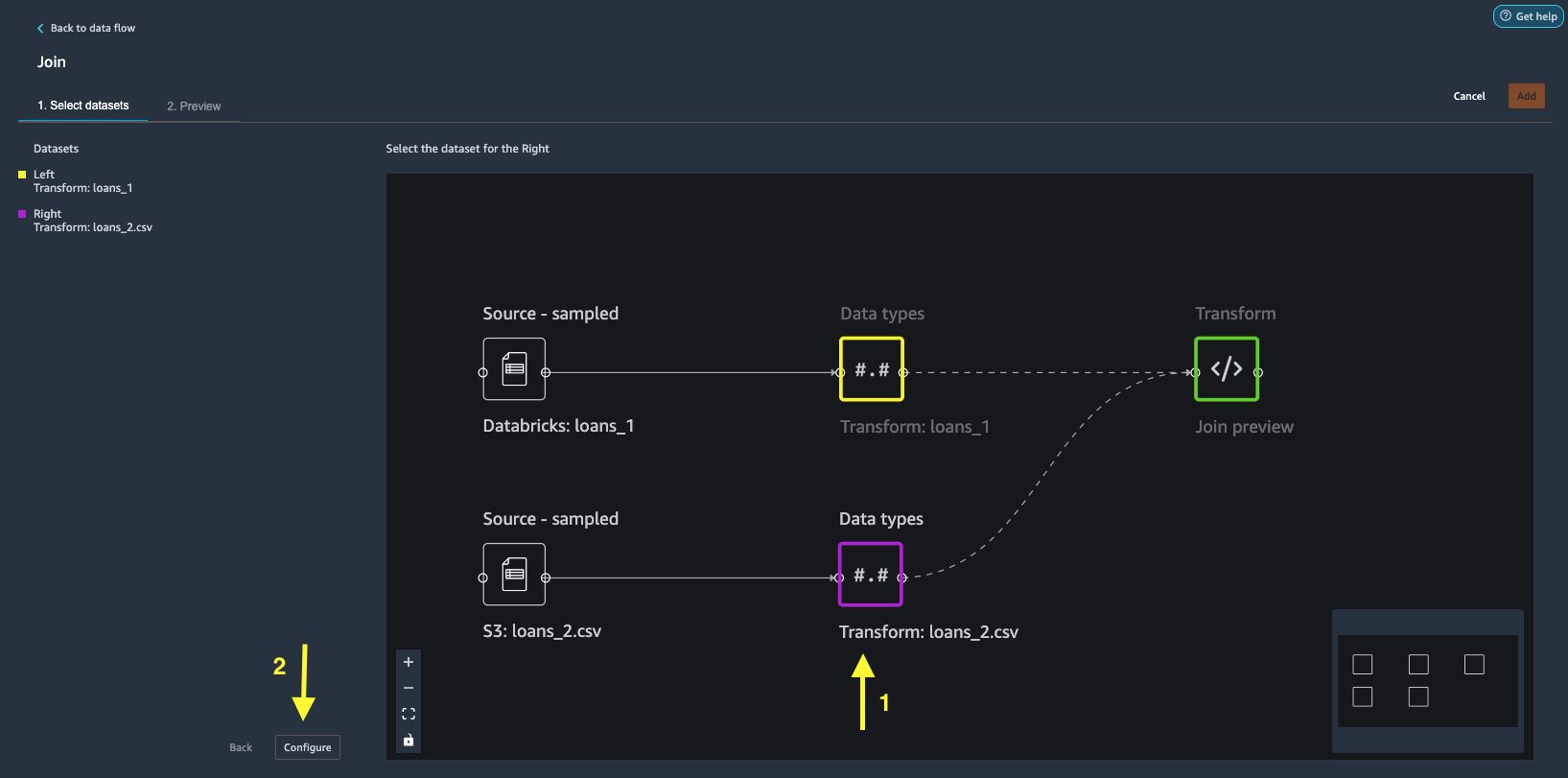

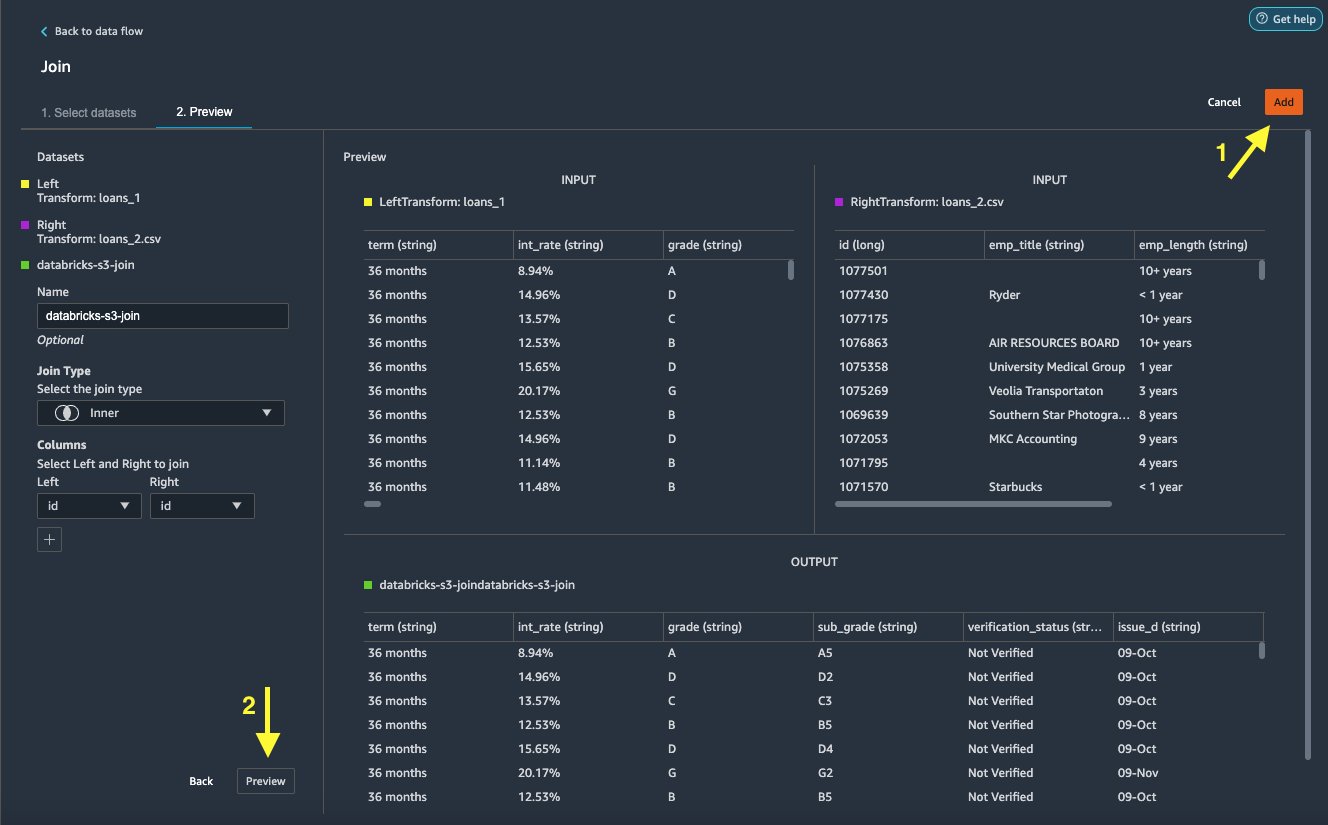

Teraz, gdy zaimportowaliśmy dane z Databricks i Amazon S3, połączmy zbiory danych przy użyciu wspólnej kolumny unikalnego identyfikatora.

- Na Przepływ danych tab, dla Typy danych, wybierz znak plus dla

loans_1. - Dodaj Dołącz do rejestru.

- Wybierz

loans_2.csvplik jako Prawa zestaw danych. - Dodaj Konfigurowanie aby ustawić kryteria łączenia.

- W razie zamówieenia projektu Imięwprowadź nazwę połączenia.

- W razie zamówieenia projektu Typ połączeniawybierz Wewnętrzny dla tego posta.

- Wybierz

idkolumna, do której chcesz dołączyć. - Dodaj Aplikuj aby wyświetlić podgląd połączonego zbioru danych.

- Dodaj Dodaj aby dodać go do przepływu danych.

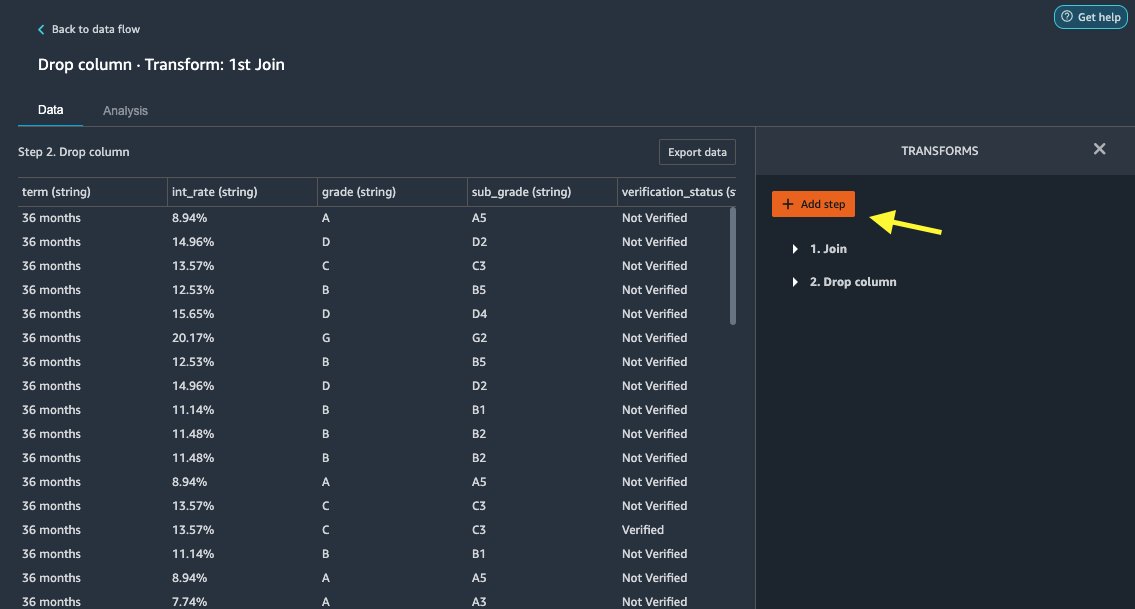

Zastosuj przekształcenia

Data Wrangler zawiera ponad 300 wbudowanych transformacji, które nie wymagają kodowania. Użyjmy wbudowanych transformacji, aby przygotować zestaw danych.

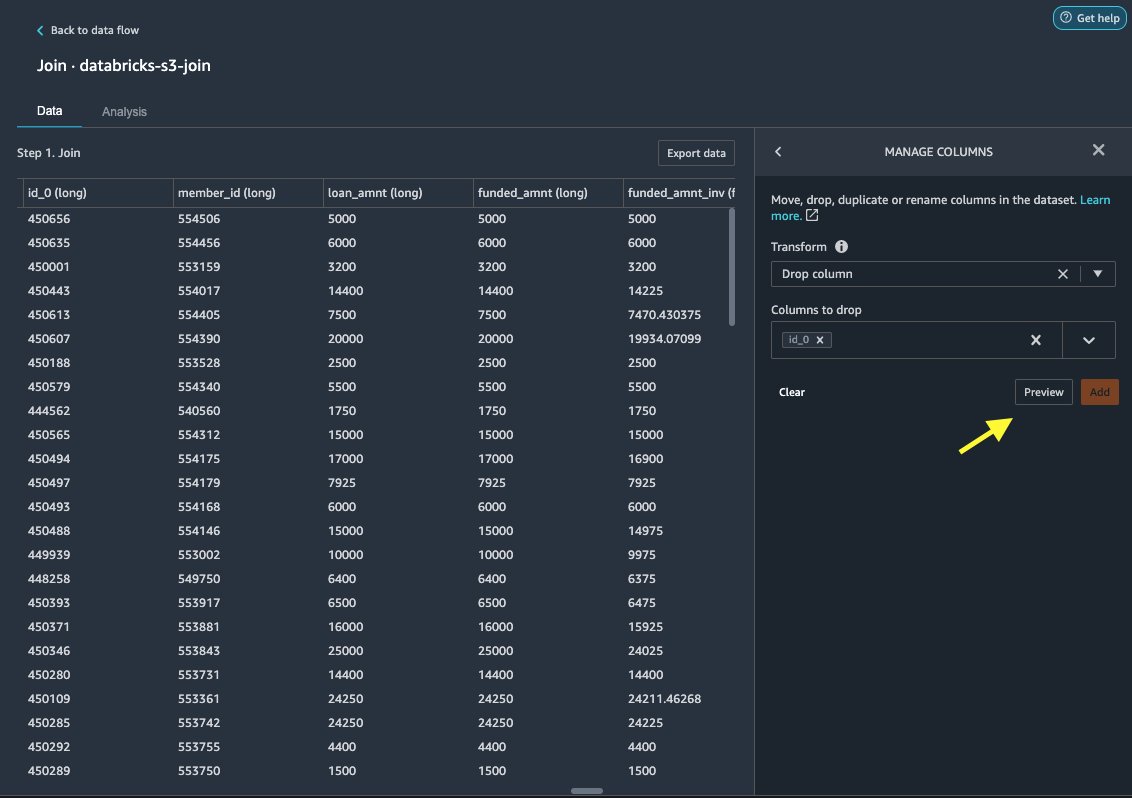

Upuść kolumnę

Najpierw usuwamy nadmiarową kolumnę ID.

- W połączonym węźle wybierz znak plus.

- Dodaj Dodaj transformację.

- Pod Transformuje, wybierać + Dodaj krok.

- Dodaj Zarządzaj kolumnami.

- W razie zamówieenia projektu Przekształcaćwybierz Upuść kolumnę.

- W razie zamówieenia projektu Kolumny do upuszczenia, wybierz kolumnę

id_0. - Dodaj Podgląd.

- Dodaj Dodaj.

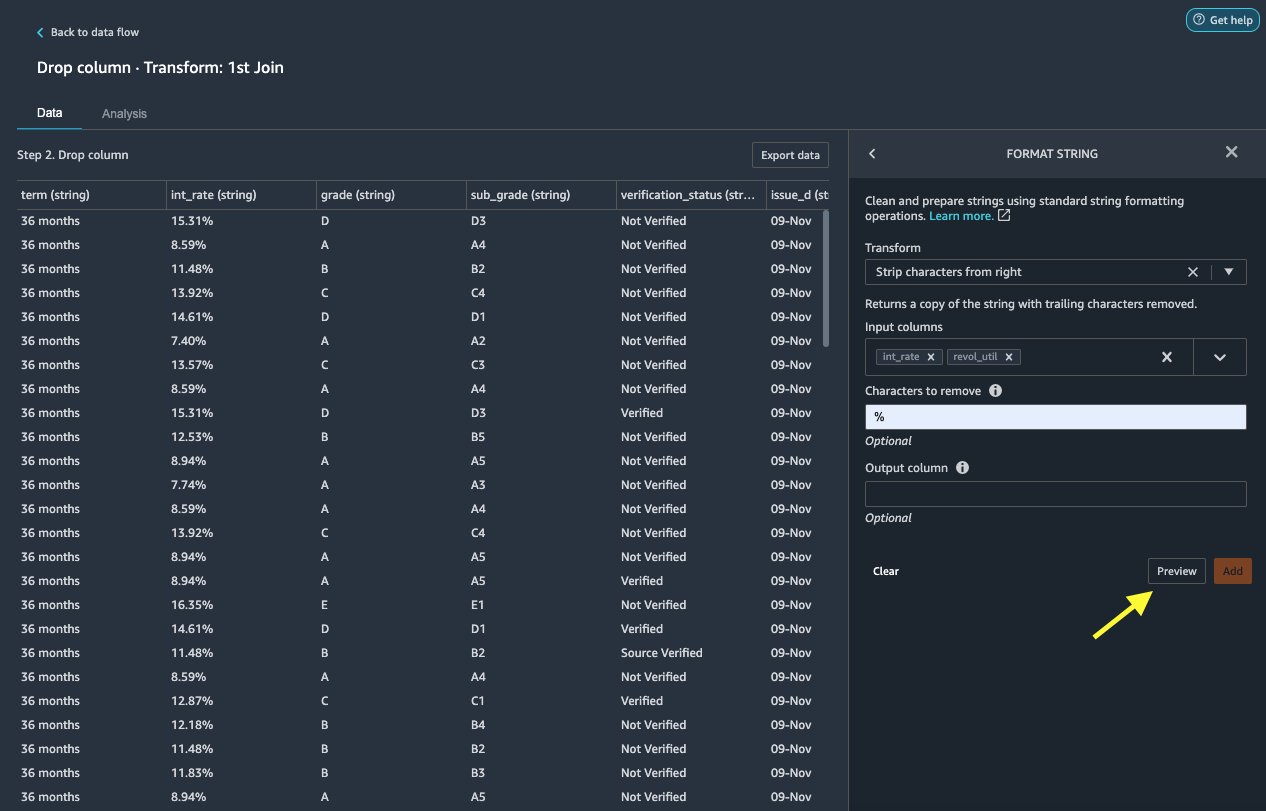

Formatuj ciąg

Zastosujmy formatowanie ciągu, aby usunąć symbol procentu z pliku int_rate i revol_util kolumny.

- Na Dane karta, pod Przekształca sięwybierz + Dodaj krok.

- Dodaj Formatuj ciąg.

- W razie zamówieenia projektu Przekształcaćwybierz Usuń znaki z prawej strony.

Data Wrangler umożliwia zastosowanie wybranej transformacji w wielu kolumnach jednocześnie.

- W razie zamówieenia projektu Kolumny wejściowewybierz

int_rateirevol_util. - W razie zamówieenia projektu Znaki do usunięcia, wchodzić

%. - Dodaj Podgląd.

- Dodaj Dodaj.

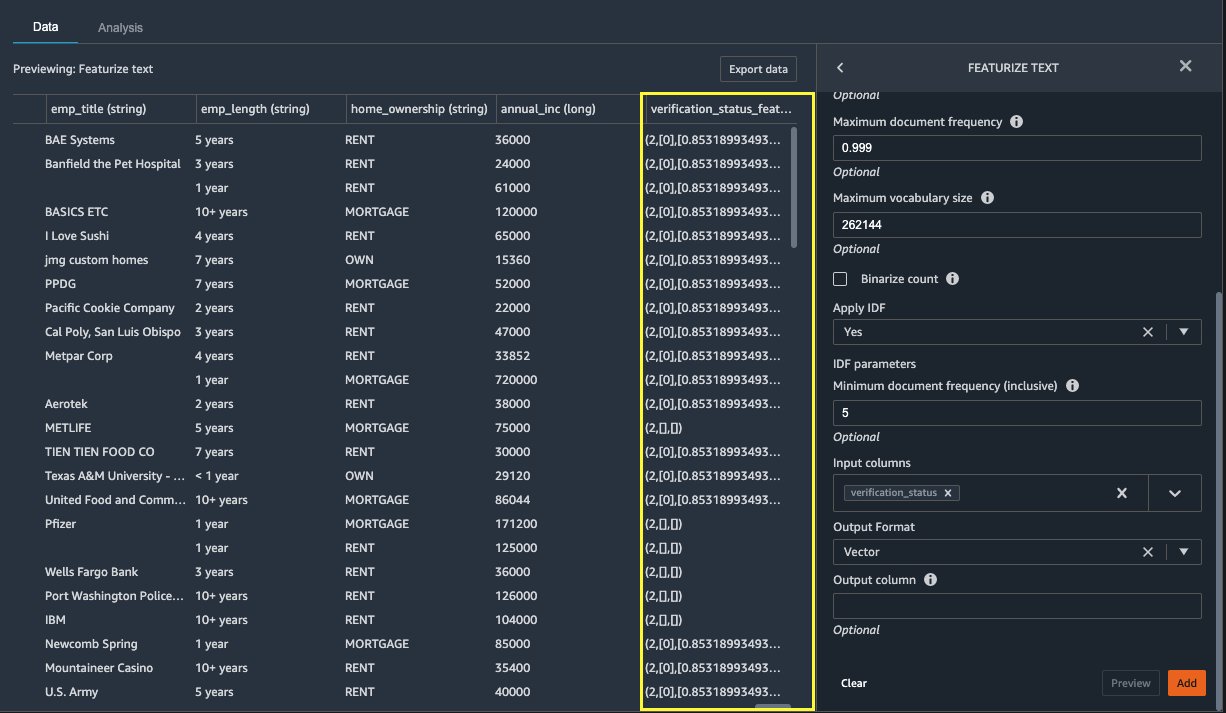

Wyróżniaj tekst

Przejdźmy teraz do wektoryzacji verification_status, kolumna z funkcjami tekstowymi. Konwertujemy kolumnę tekstową na wektory częstotliwości odwrotnej częstotliwości dokumentu (TF-IDF), stosując wektoryzator zliczania i standardowy tokenizator, jak opisano poniżej. W razie potrzeby Data Wrangler zapewnia również opcję zabrania własnego tokenizera.

- Pod Transformatorywybierz + Dodaj krok.

- Dodaj Wyróżniaj tekst.

- W razie zamówieenia projektu Przekształcaćwybierz Wektoryzuj.

- W razie zamówieenia projektu Kolumny wejściowewybierz

verification_status. - Dodaj Podgląd.

- Dodaj Dodaj.

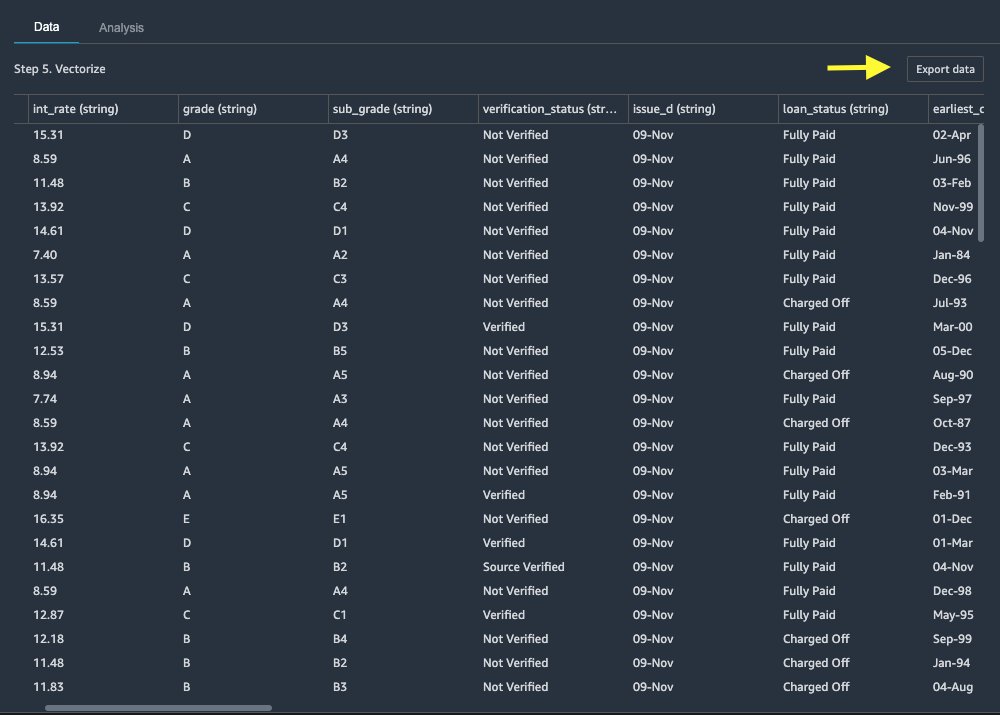

Eksportuj zbiór danych

Po zastosowaniu wielu transformacji do różnych typów kolumn, w tym tekstowych, kategorialnych i liczbowych, jesteśmy gotowi do użycia przekształconego zestawu danych na potrzeby szkolenia modelu ML. Ostatnim krokiem jest wyeksportowanie przekształconego zbioru danych do Amazon S3. W Data Wranglerze masz do wyboru wiele opcji dalszego wykorzystania transformacji:

- Dodaj Eksportuj krok do automatycznego generowania notatnika Jupyter z kodem SageMaker Processing w celu przetwarzania i eksportowania przekształconego zestawu danych do segmentu S3. Aby uzyskać więcej informacji, zobacz Uruchom przetwarzanie zadań kilkoma kliknięciami za pomocą Amazon SageMaker Data Wrangler.

- Wyeksportuj notatnik programu Studio, który tworzy plik Potok SageMaker z przepływem danych lub notatnikiem, który tworzy plik Sklep funkcji Amazon SageMaker grupę funkcji i dodaje funkcje do magazynu funkcji offline lub online.

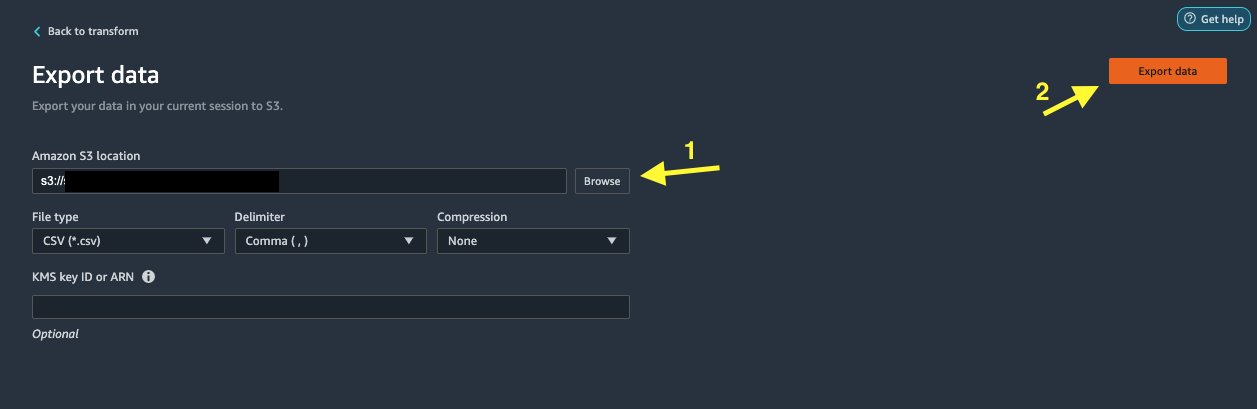

- Dodaj Eksportuj dane eksportować bezpośrednio do Amazon S3.

W tym poście korzystamy z Eksportuj dane opcja w Przekształcać view, aby wyeksportować przekształcony zbiór danych bezpośrednio do Amazon S3.

- Dodaj Eksportuj dane.

- W razie zamówieenia projektu Lokalizacja S3wybierz Przeglądaj i wybierz wiadro S3.

- Dodaj Eksportuj dane.

Sprzątać

Jeśli Twoja praca z Data Wranglerem dobiegła końca, wyłącz instancję Data Wranglera aby uniknąć ponoszenia dodatkowych opłat.

Wnioski

W tym poście omówiliśmy, jak szybko i łatwo skonfigurować i połączyć Databricks jako źródło danych w Data Wrangler, interaktywnie wysyłać zapytania do danych przechowywanych w Databricks przy użyciu języka SQL oraz wyświetlać podgląd danych przed importem. Dodatkowo sprawdziliśmy, jak możesz połączyć swoje dane w Databricks z danymi przechowywanymi w Amazon S3. Następnie zastosowaliśmy transformacje danych w połączonym zestawie danych, aby utworzyć potok przygotowania danych. Aby poznać więcej możliwości analizy Data Wrangler, w tym generowanie raportów dotyczących wycieków docelowych i błędów stronniczości, zapoznaj się z następującym postem na blogu Przyspiesz przygotowywanie danych za pomocą Amazon SageMaker Data Wrangler do przewidywania ponownej hospitalizacji pacjentów z cukrzycą.

Aby rozpocząć korzystanie z Data Wranglera, zobacz Przygotuj dane ML za pomocą Amazon SageMaker Data Wrangleri zobacz najnowsze informacje na temat Data Wranglera Strona produktu.

O autorach

Bainsy jest architektem rozwiązań w AWS skupiającym się na AI/ML. Jego pasją jest pomaganie klientom we wprowadzaniu innowacji i osiąganiu celów biznesowych z wykorzystaniem sztucznej inteligencji i uczenia maszynowego. W wolnym czasie Roop lubi czytać i wędrować.

Bainsy jest architektem rozwiązań w AWS skupiającym się na AI/ML. Jego pasją jest pomaganie klientom we wprowadzaniu innowacji i osiąganiu celów biznesowych z wykorzystaniem sztucznej inteligencji i uczenia maszynowego. W wolnym czasie Roop lubi czytać i wędrować.

Igor Alekseev jest architektem rozwiązań dla partnerów w AWS w zakresie danych i analiz. Igor współpracuje ze strategicznymi partnerami, pomagając im budować złożone architektury zoptymalizowane pod kątem AWS. Przed dołączeniem do AWS, jako Architekt Danych/Rozwiązań, zrealizował wiele projektów w Big Data, w tym kilka jezior danych w ekosystemie Hadoop. Jako Data Engineer był zaangażowany w zastosowanie AI/ML do wykrywania nadużyć i automatyzacji biura. Projekty Igora dotyczyły różnych branż, w tym komunikacji, finansów, bezpieczeństwa publicznego, produkcji i opieki zdrowotnej. Wcześniej Igor pracował jako full stack inżynier/tech lead.

Igor Alekseev jest architektem rozwiązań dla partnerów w AWS w zakresie danych i analiz. Igor współpracuje ze strategicznymi partnerami, pomagając im budować złożone architektury zoptymalizowane pod kątem AWS. Przed dołączeniem do AWS, jako Architekt Danych/Rozwiązań, zrealizował wiele projektów w Big Data, w tym kilka jezior danych w ekosystemie Hadoop. Jako Data Engineer był zaangażowany w zastosowanie AI/ML do wykrywania nadużyć i automatyzacji biura. Projekty Igora dotyczyły różnych branż, w tym komunikacji, finansów, bezpieczeństwa publicznego, produkcji i opieki zdrowotnej. Wcześniej Igor pracował jako full stack inżynier/tech lead.

Huong Nguyen jest starszym menedżerem produktu w AWS. Kieruje doświadczeniem użytkownika w SageMaker Studio. Ma 13-letnie doświadczenie w tworzeniu produktów z obsesją na punkcie klientów i opartych na danych, zarówno dla przedsiębiorstw, jak i konsumentów. W wolnym czasie lubi czytać, przebywać na łonie natury i spędzać czas z rodziną.

Huong Nguyen jest starszym menedżerem produktu w AWS. Kieruje doświadczeniem użytkownika w SageMaker Studio. Ma 13-letnie doświadczenie w tworzeniu produktów z obsesją na punkcie klientów i opartych na danych, zarówno dla przedsiębiorstw, jak i konsumentów. W wolnym czasie lubi czytać, przebywać na łonie natury i spędzać czas z rodziną.

Henryk Wang jest inżynierem rozwoju oprogramowania w AWS. Niedawno dołączył do zespołu Data Wrangler po ukończeniu studiów na Uniwersytecie Kalifornijskim w Davis. Interesuje się nauką o danych i uczeniem maszynowym, a drukowanie 3D jest jego hobby.

Henryk Wang jest inżynierem rozwoju oprogramowania w AWS. Niedawno dołączył do zespołu Data Wrangler po ukończeniu studiów na Uniwersytecie Kalifornijskim w Davis. Interesuje się nauką o danych i uczeniem maszynowym, a drukowanie 3D jest jego hobby.

- Coinsmart. Najlepsza w Europie giełda bitcoinów i kryptowalut.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. DARMOWY DOSTĘP.

- CryptoJastrząb. Radar Altcoin. Bezpłatna wersja próbna.

- Źródło: https://aws.amazon.com/blogs/machine-learning/prepare-data-from-databricks-for-machine-learning-using-amazon-sagemaker-data-wrangler/

- "

- 000

- 100

- 39

- 3d

- O nas

- dostęp

- pomieścić

- Dodatkowy

- zaawansowany

- Korzyść

- Algorytmy

- Wszystkie kategorie

- Amazonka

- analiza

- analityka

- Stosowanie

- architektura

- sztuczny

- sztuczna inteligencja

- Sztuczna inteligencja i uczenie maszynowe

- przydzielony

- Automatyzacja

- AWS

- jest

- BEST

- Big Data

- Blog

- granica

- budować

- wbudowany

- biznes

- możliwości

- Etui

- Dodaj

- Sprzątanie

- klub

- kod

- Kodowanie

- Kolumna

- połączony

- wspólny

- Komunikacja

- kompleks

- systemu

- połączony

- połączenie

- połączenia

- wynagrodzenie

- Konsola

- konsolidacja

- konsument

- konsumpcja

- zawiera

- stworzony

- tworzy

- Tworzenie

- Aktualny

- Klientów

- dane

- nauka danych

- Baza danych

- opóźnienie

- W zależności

- Wykrywanie

- oprogramowania

- różne

- bezpośrednio

- wyświetlacze

- na dół

- kierowca

- Spadek

- z łatwością

- Ekosystem

- redaktor

- umożliwiać

- umożliwiając

- inżynier

- Inżynieria

- Wchodzę

- Enterprise

- przykład

- Z wyjątkiem

- egzekucja

- doświadczenie

- odkryj

- członków Twojej rodziny

- Cecha

- Korzyści

- Opłaty

- finansować

- i terminów, a

- Elastyczność

- pływ

- następujący

- format

- oszustwo

- pełny

- Generować

- generacja

- dobry

- zarządzanie

- Zarządzanie

- opieki zdrowotnej

- pomoc

- W jaki sposób

- HTTPS

- tożsamość

- realizowane

- ważny

- importowanie

- Włącznie z

- przemysłowa

- Informacja

- spostrzeżenia

- Inteligencja

- odsetki

- Interfejs

- inwestycja

- zaangażowany

- IT

- Oferty pracy

- przystąpić

- Dołączył

- Etykiety

- język

- firmy

- prowadzić

- prowadzący

- nauka

- pożyczanie

- Kredyty

- wyglądał

- maszyna

- uczenie maszynowe

- kierownik

- produkcja

- ML

- model

- modele

- jeszcze

- wielokrotność

- Naturalny

- Natura

- Nawigacja

- Nowe funkcje

- notatnik

- Oferty

- nieaktywny

- Online

- Option

- Opcje

- zamówienie

- własny

- partnerem

- wzmacniacz

- namiętny

- płatność

- procent

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- osobisty

- faza

- Platforma

- polityka

- Przewidywania

- Podgląd

- wygląda tak

- Produkt

- Produkty

- Programowanie

- projektowanie

- zapewnia

- że

- publiczny

- cele

- szybko

- Surowy

- Czytający

- redukcja

- raport

- wymagać

- wymagany

- odpowiedzialny

- bieganie

- Bezpieczeństwo

- nauka

- Naukowcy

- wybrany

- Serie

- usługa

- zestaw

- ustawienie

- znaczący

- Prosty

- Rozmiar

- Tworzenie

- rozwoju oprogramowania

- rozwiązanie

- Rozwiązania

- obowiązuje

- wydać

- Spędzanie

- dzielić

- stos

- standard

- początek

- rozpoczęty

- Zestawienie sprzedaży

- Rynek

- przechowywanie

- sklep

- Strategiczny

- silny

- studio

- Z powodzeniem

- wsparcie

- cel

- zespół

- Przez

- czas

- Trening

- Przekształcać

- Transformacja

- ui

- wyjątkowy

- Aktualizacja

- posługiwać się

- różnorodność

- różnorodny

- Podczas

- bez

- Praca

- pracował

- działa

- pisanie