Wiele aplikacji przeznaczonych do konserwacji sprzętu przemysłowego, monitorowania handlu, zarządzania flotą i optymalizacji tras jest zbudowanych przy użyciu interfejsów API Cassandra i sterowników typu open source do przetwarzania danych z dużymi prędkościami i niskimi opóźnieniami. Samodzielne zarządzanie stołami Cassandra może być czasochłonne i kosztowne. Przestrzenie klawiszy Amazon (dla Apache Cassandra) umożliwia konfigurowanie, zabezpieczanie i skalowanie tabel Cassandra w chmurze AWS bez zarządzania dodatkową infrastrukturą.

W tym poście przeprowadzimy Cię przez usługi AWS związane z trenowaniem modeli uczenia maszynowego (ML) przy użyciu Amazon Keyspaces na wysokim poziomie i dostarczymy instrukcje krok po kroku dotyczące pozyskiwania danych z Amazon Keyspaces do Amazon Sage Maker oraz wytrenowanie modelu, który można wykorzystać w przypadku konkretnego przypadku użycia segmentacji klientów.

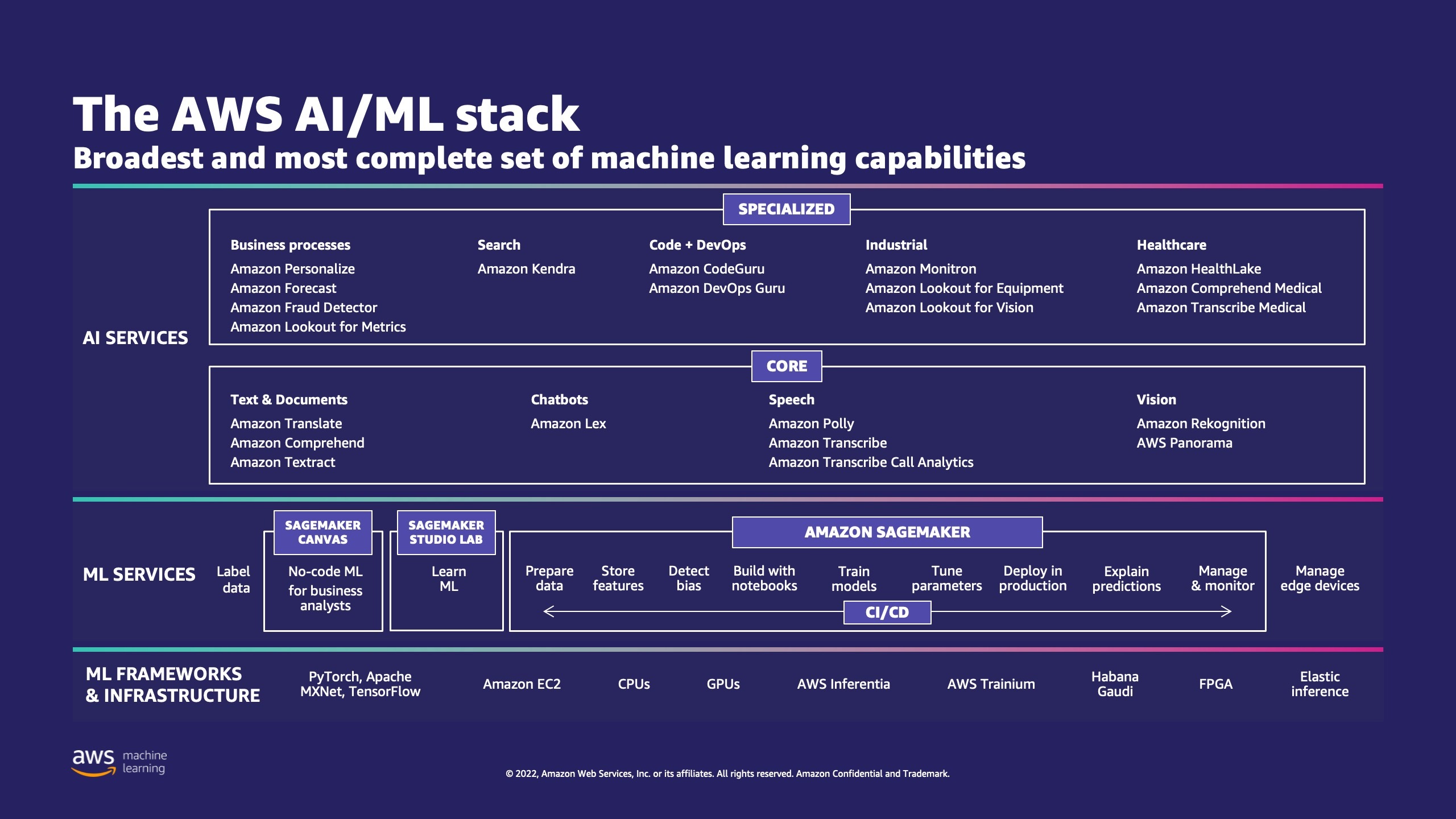

AWS oferuje wiele usług, które pomagają firmom wdrażać procesy ML w chmurze.

AWS ML Stack ma trzy warstwy. W środkowej warstwie znajduje się SageMaker, który zapewnia programistom, analitykom danych i inżynierom ML możliwość tworzenia, trenowania i wdrażania modeli ML na dużą skalę. Usuwa złożoność każdego etapu przepływu pracy ML, dzięki czemu można łatwiej wdrażać przypadki użycia ML. Obejmuje to wszystko, od konserwacji predykcyjnej po wizję komputerową po przewidywanie zachowań klientów. Dzięki SageMaker klienci osiągają nawet 10-krotną poprawę produktywności analityków danych.

Apache Cassandra jest popularnym wyborem do zastosowań wymagających dużego odczytu z danymi nieustrukturyzowanymi lub częściowo ustrukturyzowanymi. Na przykład popularna firma dostarczająca żywność szacuje czas dostawy, a klient detaliczny może często korzystać z informacji katalogowych produktów w bazie danych Apache Cassandra. Obszary klawiszy Amazon to skalowalna, wysoce dostępna i zarządzana bezserwerowa usługa bazy danych zgodna z Apache Cassandra. Nie musisz aprowizować, aktualizować ani zarządzać serwerami, ani instalować, konserwować ani obsługiwać oprogramowania. Tabele mogą automatycznie skalować się w górę i w dół, a płacisz tylko za zasoby, z których korzystasz. Amazon Keyspaces umożliwia uruchamianie obciążeń Cassandra w AWS przy użyciu tego samego kodu aplikacji Cassandra i narzędzi programistycznych, których używasz dzisiaj.

SageMaker zapewnia pakiet wbudowane algorytmy aby pomóc analitykom danych i praktykom ML w szybkim rozpoczęciu szkolenia i wdrażania modeli ML. W tym poście pokażemy, jak klient detaliczny może wykorzystać historię zakupów klientów w bazie danych Keyspaces i kierować kampanie marketingowe na różne segmenty klientów.

K-oznacza to nienadzorowany algorytm uczenia się. Próbuje znaleźć dyskretne grupy w danych, w których członkowie grupy są do siebie jak najbardziej podobni i jak najbardziej różni od członków innych grup. Definiujesz atrybuty, których algorytm ma używać do określania podobieństwa. SageMaker używa zmodyfikowanej wersji algorytm grupowania k-średnich w skali internetowej. W porównaniu z oryginalną wersją algorytmu, wersja używana przez SageMaker jest dokładniejsza. Jednak, podobnie jak oryginalny algorytm, skaluje się do ogromnych zbiorów danych i zapewnia skrócenie czasu szkolenia.

Omówienie rozwiązania

Instrukcje zakładają, że do uruchomienia kodu używasz SageMaker Studio. Powiązany kod został udostępniony dnia Przykładowy serwis GitHub AWS. Postępując zgodnie z instrukcjami w laboratorium, możesz wykonać następujące czynności:

- Zainstaluj niezbędne zależności.

- Połącz się z Amazon Keyspaces, utwórz tabelę i pozyskuj przykładowe dane.

- Zbuduj model klasyfikacji ML, korzystając z danych w Amazon Keyspaces.

- Przeglądaj wyniki modelu.

- Oczyść nowo utworzone zasoby.

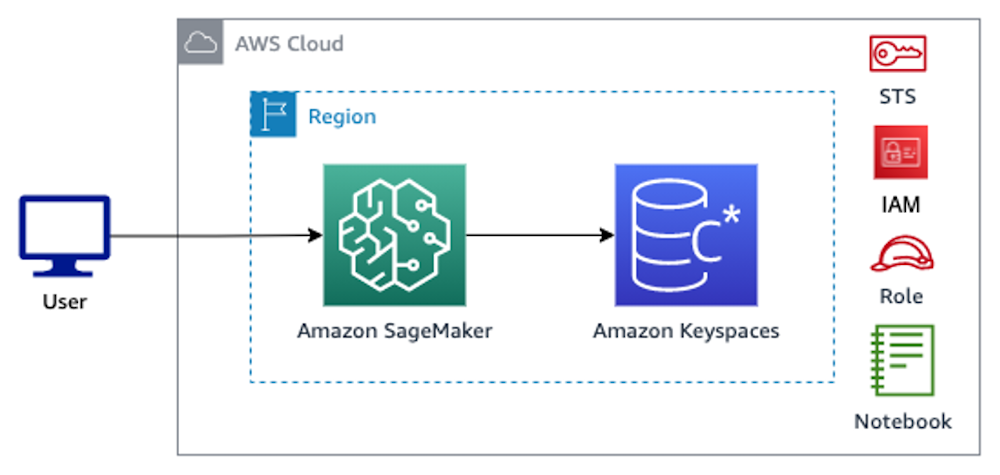

Po zakończeniu będziesz zintegrować SageMaker z Amazon Keyspaces, aby trenować modele ML, jak pokazano na poniższym obrazku.

Teraz możesz śledzić instrukcje krok po kroku w tym poście, aby przyswoić surowe dane przechowywane w Amazon Keyspaces za pomocą SageMaker i dane w ten sposób pobrane do przetwarzania ML.

Wymagania wstępne

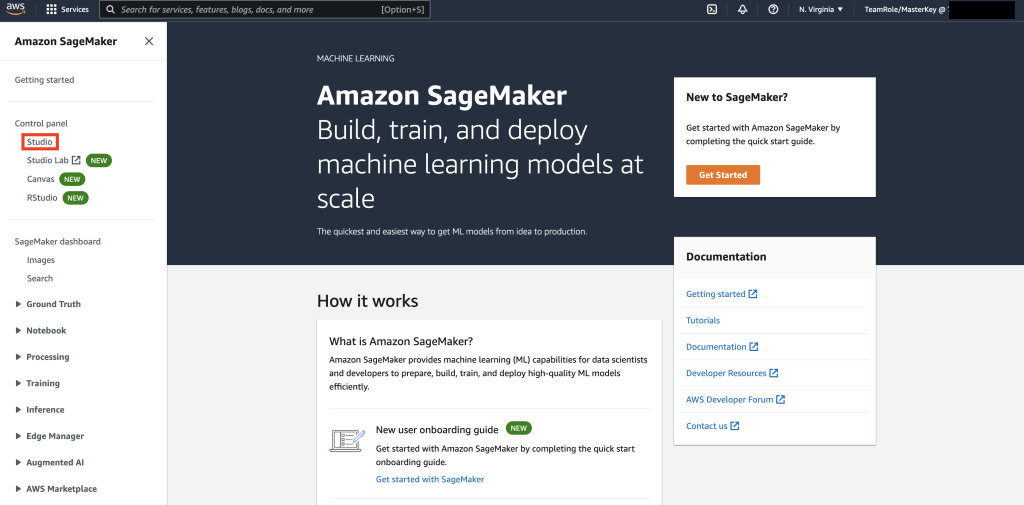

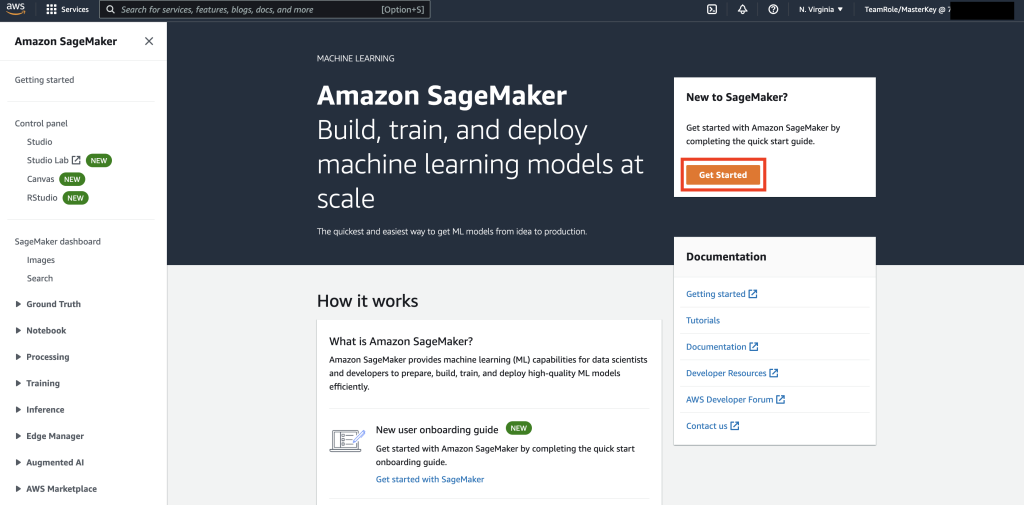

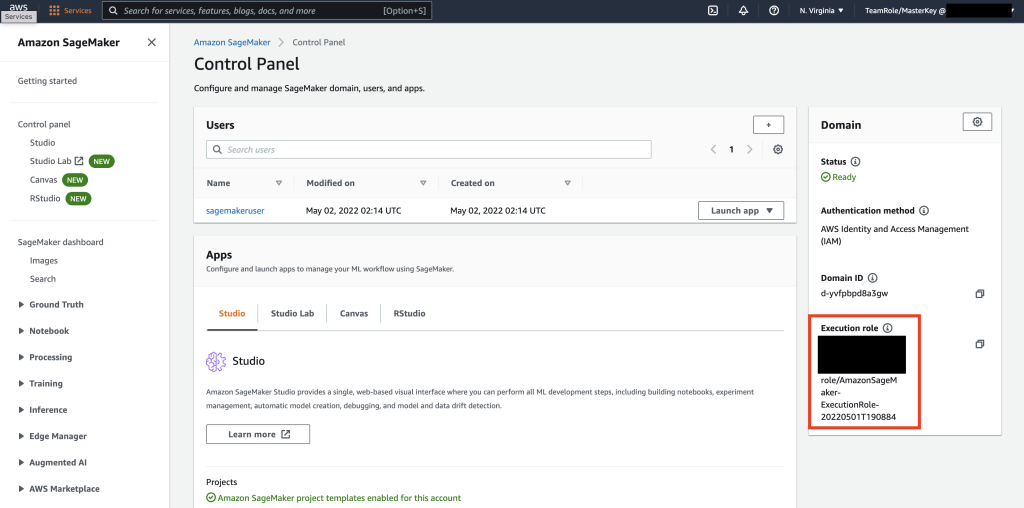

Najpierw przejdź do SageMaker.

Następnie, jeśli używasz SageMaker po raz pierwszy, wybierz Rozpocznij.

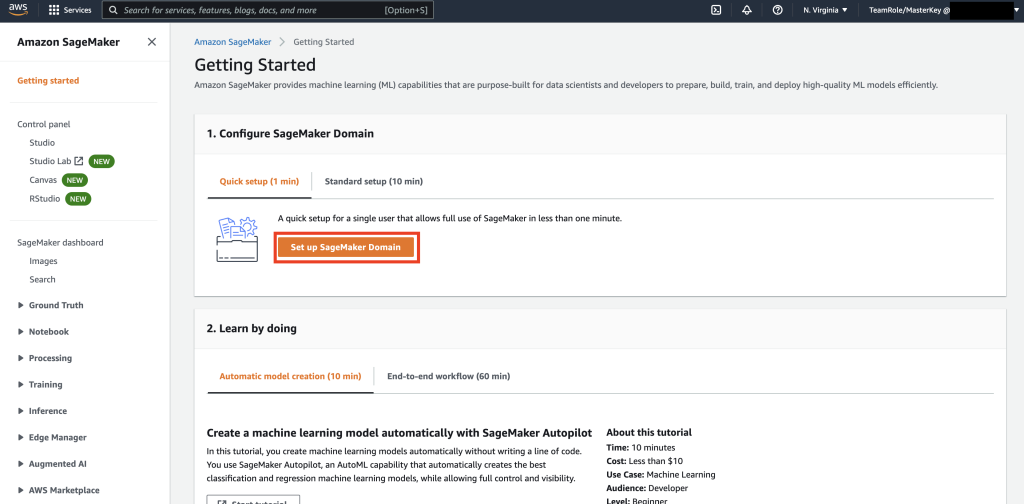

Następnie wybierz Skonfiguruj domenę SageMaker.

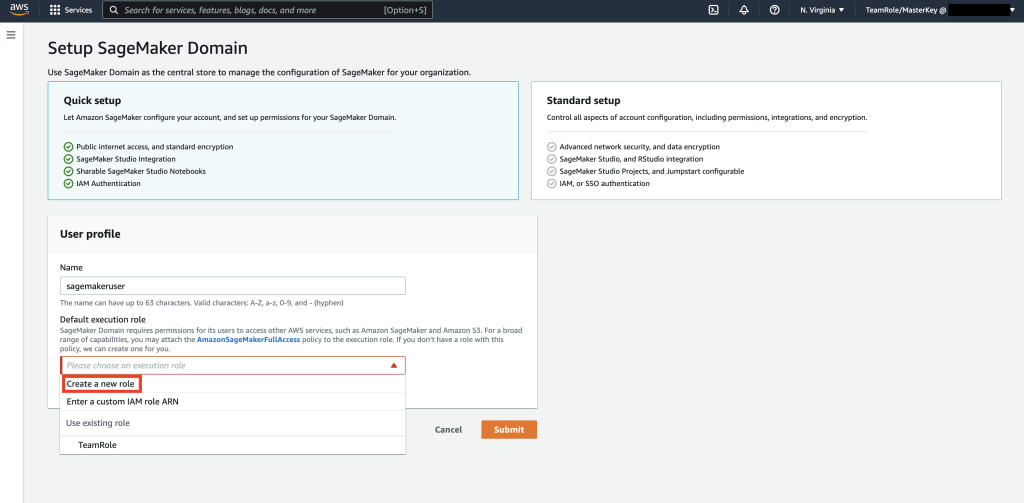

Następnie utwórz nowy profil użytkownika z nazwą – mędrzecużytkowniki wybierz Utwórz nową rolę Domyślna rola wykonania podpunkt.

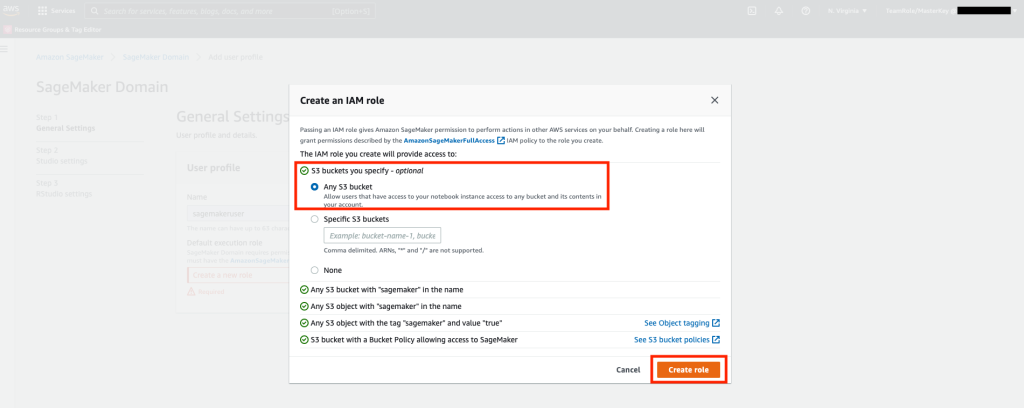

Następnie na wyświetlonym ekranie wybierz dowolny Usługa Amazon Simple Storage (Amazon S3) zasobnik i wybierz Utwórz rolę.

Ta rola zostanie użyta w poniższych krokach, aby umożliwić SageMakerowi dostęp do tabeli obszarów kluczy przy użyciu tymczasowych poświadczeń z roli. Eliminuje to konieczność przechowywania nazwy użytkownika i hasła w notebooku.

Następnie pobierz rolę powiązaną z mędrzecużytkownik który został utworzony w poprzednim kroku z sekcji podsumowania.

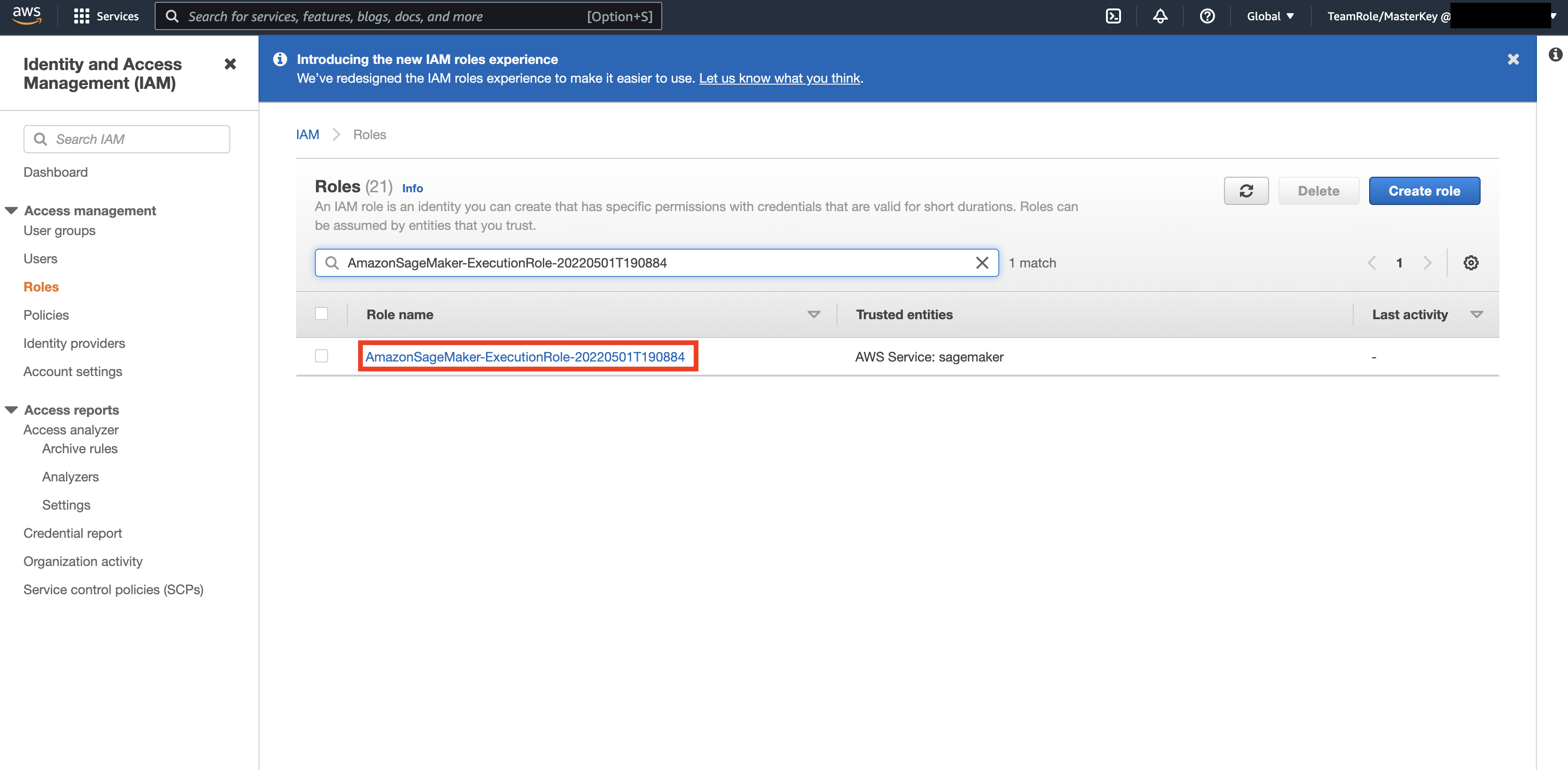

Następnie przejdź do Konsola AWS i spójrz w górę Zarządzanie tożsamością i dostępem AWS (IAM). W ramach uprawnień przejdź do ról. W ramach ról wyszukaj rolę wykonawczą zidentyfikowaną w poprzednim kroku.

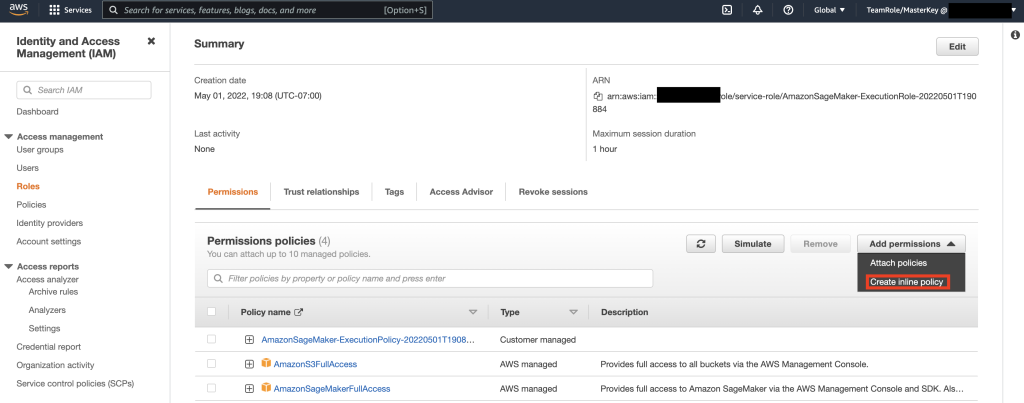

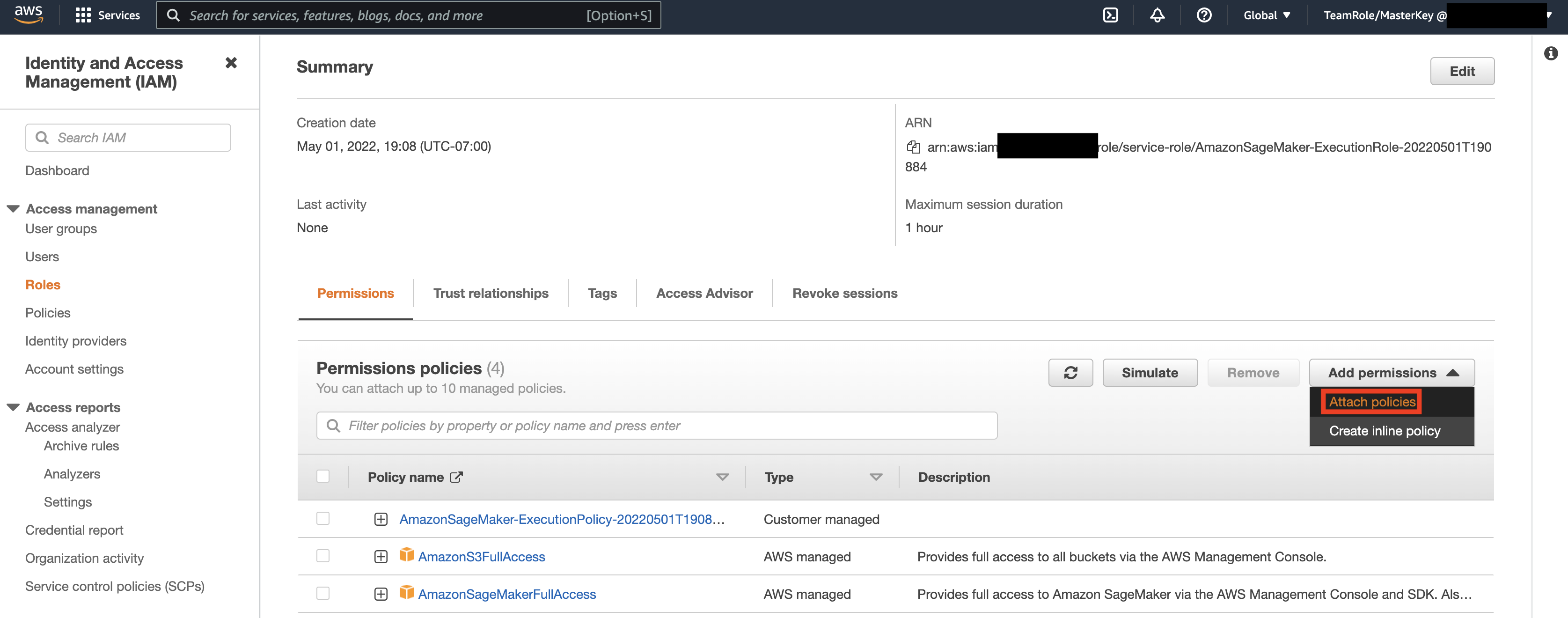

Następnie wybierz rolę zidentyfikowaną w poprzednim kroku i wybierz Dodaj uprawnienia. Z menu, które się pojawi, wybierz Utwórz zasady wbudowane. SageMaker pozwala zapewnić szczegółowy poziom dostępu, który ogranicza czynności, które użytkownik/aplikacja może wykonywać w oparciu o wymagania biznesowe.

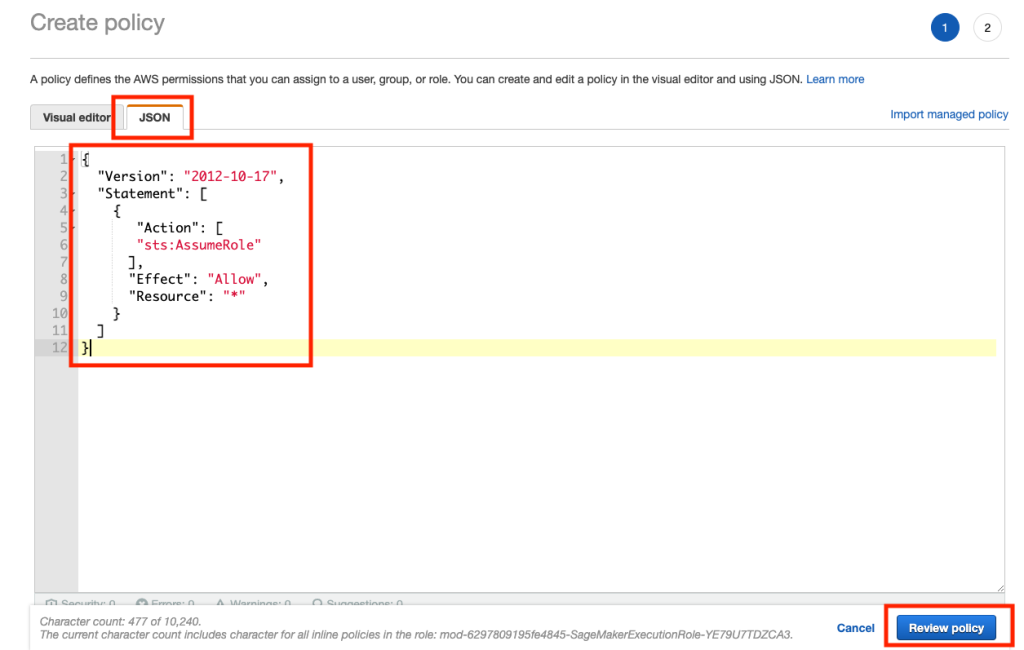

Następnie wybierz zakładkę JSON i skopiuj politykę z sekcji Notatka Github strona. Ta zasada umożliwia notebookowi SageMaker łączenie się z obszarami kluczy i pobieranie danych do dalszego przetwarzania.

Następnie ponownie wybierz Dodaj uprawnienia iz listy rozwijanej, a następnie wybierz Dołącz politykę.

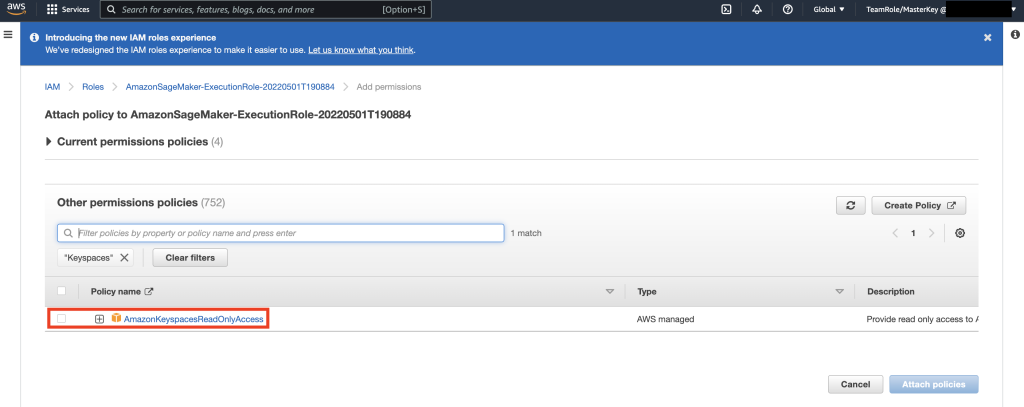

Wyszukaj zasady AmazonKeyspacesFullAccess i zaznacz pole wyboru obok pasującego wyniku, a następnie wybierz Dołącz zasady.

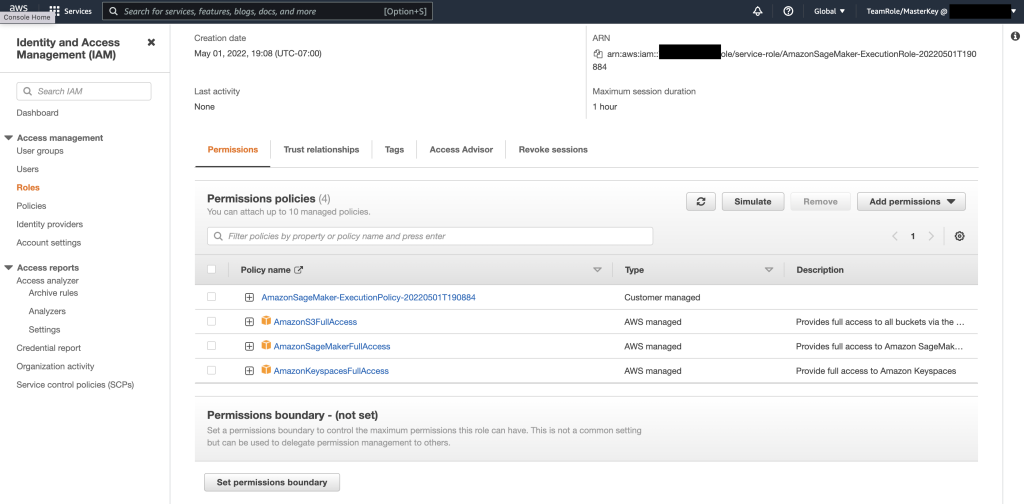

Sprawdź, czy sekcja polityki uprawnień zawiera AmazonS3FullAccess, AmazonSageMakerFullAccess, AmazonKeyspacesFullAccess, a także nowo dodane zasady wbudowane.

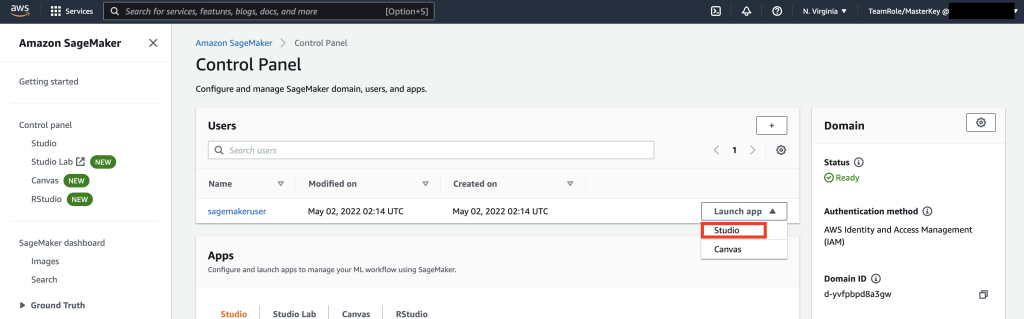

Następnie przejdź do SageMaker Studio za pomocą AWS Console i wybierz SageMaker Studio. Tam wybierz Uruchom aplikację i wybierz Studio.

Przewodnik po notebooku

Preferowanym sposobem łączenia się z Keyspaces z Notatnika SageMaker jest użycie Proces AWS Signature w wersji 4 (SigV4) na podstawie Poświadczenia tymczasowe do uwierzytelniania. W tym scenariuszu NIE musimy generować ani przechowywać poświadczeń Keyspaces i możemy użyć poświadczeń do uwierzytelniania za pomocą wtyczki SigV4. Tymczasowe dane uwierzytelniające składają się z identyfikatora klucza dostępu i tajnego klucza dostępu. Zawierają jednak również token zabezpieczający, który wskazuje, kiedy poświadczenia wygasają. W tym poście utworzymy rolę uprawnień i wygenerujemy tymczasowe dane uwierzytelniające.

Najpierw instalujemy sterownik (cassandra-sigv4). Ten sterownik umożliwia dodawanie informacji uwierzytelniających do żądań API przy użyciu procesu AWS Signature Version 4 (SigV4). Korzystając z wtyczki, możesz zapewnić użytkownikom i aplikacjom krótkoterminowe poświadczenia dostępu do Amazon Keyspaces (dla Apache Cassandra) przy użyciu użytkowników i ról uprawnień. Następnie zaimportujesz wymagany certyfikat wraz z dodatkowymi zależnościami pakietów. W końcu pozwolisz notebookowi przejąć rolę, aby rozmawiać z Keyspaces.

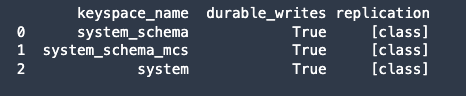

Następnie połącz się z Amazon Keyspaces i wczytaj dane systemowe z Keyspaces do Pandas DataFrame, aby zweryfikować połączenie.

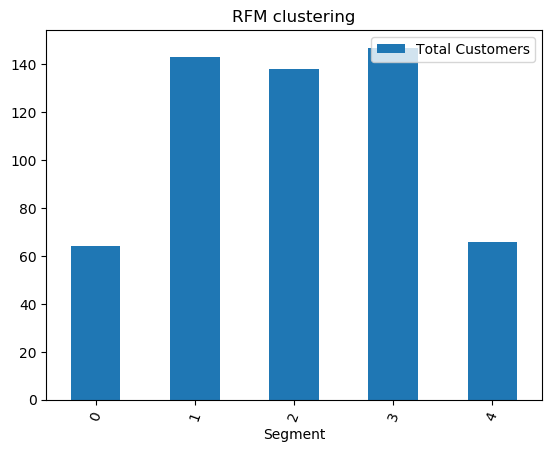

Następnie przygotuj dane do treningu na surowym zestawie danych. W notatniku Pythona powiązanym z tym postem użyj zestawu danych detalicznych pobranego z tutaji przetworzyć. Naszym celem biznesowym, biorąc pod uwagę zestaw danych, jest klastrowanie klientów przy użyciu określonej metryki wywołania RFM. Model RFM opiera się na trzech czynnikach ilościowych:

- Ostatnio: jak niedawno klient dokonał zakupu.

- Częstotliwość: jak często klient dokonuje zakupu.

- Wartość pieniężna: ile pieniędzy klient wydaje na zakupy.

Analiza RFM numerycznie klasyfikuje klienta w każdej z tych trzech kategorii, generalnie w skali od 1 do 5 (im wyższa liczba, tym lepszy wynik). „Najlepszy” klient otrzymałby najwyższą ocenę w każdej kategorii. Użyjemy funkcji dyskretyzacji pand opartej na kwantylu (qcut). Pomoże to zdyskretyzować wartości do wiader o równej wielkości na podstawie lub na podstawie kwantyli próbki.

W tym przykładzie używamy CQL do odczytywania rekordów z tabeli Keyspace. W niektórych przypadkach użycia ML może być konieczne wielokrotne odczytywanie tych samych danych z tej samej tabeli Keyspaces. W takim przypadku zalecamy zapisanie danych w zasobniku Amazon S3, aby uniknąć ponoszenia dodatkowych koszts czytanie z Amazon Keyspaces. W zależności od scenariusza możesz również użyć Amazon EMR do łykać bardzo duży plik Amazon S3 do SageMaker.

Następnie trenujemy model ML za pomocą algorytmu KMeans i upewniamy się, że klastry są tworzone. W tym konkretnym scenariuszu widać, że utworzone klastry są drukowane, pokazując, że klienci w surowym zestawie danych zostali zgrupowani razem na podstawie różnych atrybutów w zestawie danych. Te informacje o klastrach można wykorzystać w ukierunkowanych kampaniach marketingowych.

(Opcjonalnie) Następnie zapisujemy segmenty klientów, które zostały zidentyfikowane przez model ML, z powrotem w tabeli Amazon Keyspaces w celu marketingu ukierunkowanego. Zadanie wsadowe może odczytywać te dane i prowadzić kampanie kierowane do klientów w określonych segmentach.

Wreszcie my posprzątaj zasoby utworzone podczas tego samouczka, aby uniknąć ponoszenia dodatkowych opłat.

Usunięcie przestrzeni kluczy i tabel może potrwać od kilku sekund do minuty. Gdy usuniesz obszar kluczy, obszar kluczy i wszystkie jego tabele są usuwane i przestajesz naliczać od nich opłaty.

Wnioski

W tym poście pokazano, jak pozyskiwać dane klientów z Amazon Keyspaces do SageMaker i wytrenować model klastrowania, który umożliwił segmentację klientów. Możesz wykorzystać te informacje do ukierunkowanego marketingu, dzięki czemu znacznie poprawisz swój biznesowy wskaźnik KPI. Aby dowiedzieć się więcej o Amazon Keyspaces, przejrzyj następujące zasoby:

- Trenuj modele uczenia maszynowego przy użyciu przestrzeni kluczy Amazon jako źródła danych (notatnik SageMaker)

- Połącz się z Amazon Keyspaces ze swojego komputera za pomocą IntelliJ, PyCharm lub DataGrip IDE

- Dokumentacja języka CQL dla przestrzeni kluczy Amazon (dla Apache Cassandra)

- Jak skonfigurować dostęp z wiersza poleceń do Amazon Keyspaces (dla Apache Cassandra) przy użyciu nowego obrazu Docker dla programistów

- Zarządzanie tożsamością i dostępem dla przestrzeni kluczy Amazon (dla Apache Cassandra)

- Łączenie się z Amazon Keyspaces z SageMaker za pomocą poświadczenia specyficzne dla usługi

- Aktualność, częstotliwość, wartość pieniężna (RFM)

- Odniesienie do kodu Kaggle

O autorach

Wadim Lachowicz jest starszym architektem rozwiązań w AWS w rejonie zatoki San Francisco, pomagając klientom w migracji do AWS. Współpracuje z organizacjami od dużych przedsiębiorstw po małe startupy, aby wspierać ich innowacje. Pomaga również klientom w projektowaniu skalowalnych, bezpiecznych i opłacalnych rozwiązań w AWS.

Wadim Lachowicz jest starszym architektem rozwiązań w AWS w rejonie zatoki San Francisco, pomagając klientom w migracji do AWS. Współpracuje z organizacjami od dużych przedsiębiorstw po małe startupy, aby wspierać ich innowacje. Pomaga również klientom w projektowaniu skalowalnych, bezpiecznych i opłacalnych rozwiązań w AWS.

Część Patel jest architektem rozwiązań w AWS w rejonie zatoki San Francisco. Parth prowadzi klientów, aby przyspieszyć ich podróż do chmury i pomóc im pomyślnie wdrożyć chmurę AWS. Koncentruje się na ML i modernizacji aplikacji.

Część Patel jest architektem rozwiązań w AWS w rejonie zatoki San Francisco. Parth prowadzi klientów, aby przyspieszyć ich podróż do chmury i pomóc im pomyślnie wdrożyć chmurę AWS. Koncentruje się na ML i modernizacji aplikacji.

Ram Pathangi jest architektem rozwiązań w AWS w rejonie zatoki San Francisco. Pomógł klientom z branży rolniczej, ubezpieczeniowej, bankowej, handlu detalicznego, opieki zdrowotnej i nauk przyrodniczych, hotelarstwa i Hi-Tech pomyślnie prowadzić działalność w chmurze AWS. Specjalizuje się w bazach danych, analityce i ML.

Ram Pathangi jest architektem rozwiązań w AWS w rejonie zatoki San Francisco. Pomógł klientom z branży rolniczej, ubezpieczeniowej, bankowej, handlu detalicznego, opieki zdrowotnej i nauk przyrodniczych, hotelarstwa i Hi-Tech pomyślnie prowadzić działalność w chmurze AWS. Specjalizuje się w bazach danych, analityce i ML.

- Coinsmart. Najlepsza w Europie giełda bitcoinów i kryptowalut.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. DARMOWY DOSTĘP.

- CryptoJastrząb. Radar Altcoin. Bezpłatna wersja próbna.

- Źródło: https://aws.amazon.com/blogs/machine-learning/train-machine-learning-models-using-amazon-keyspaces-as-a-data-source/

- '

- "

- &

- 10

- 100

- 9

- zdolność

- O nas

- przyśpieszyć

- dostęp

- dokładny

- Osiągać

- działania

- Dodatkowy

- rolnictwo

- przed

- algorytm

- Wszystkie kategorie

- Amazonka

- analiza

- analityka

- Inne

- api

- Pszczoła

- Aplikacja

- Zastosowanie

- aplikacje

- POWIERZCHNIA

- Uwaga

- atrybuty

- Uwierzytelnianie

- automatycznie

- dostępny

- AWS

- Bankowość

- Zatoka

- Blog

- granica

- budować

- biznes

- biznes

- wezwanie

- Kampanie

- który

- Etui

- Kategoria

- świadectwo

- Opłaty

- wybór

- klasyfikacja

- Chmura

- kod

- w porównaniu

- komputer

- Skontaktuj się

- połączenie

- Konsola

- opłacalne

- mógłby

- kraj

- Stwórz

- stworzony

- Listy uwierzytelniające

- klient

- Klientów

- dane

- zbiór danych

- Baza danych

- Bazy danych

- dostarcza

- dostawa

- W zależności

- rozwijać

- wdrażanie

- stacjonarny

- Ustalać

- Deweloper

- deweloperzy

- różne

- Doker

- na dół

- kierowca

- Spadek

- podczas

- z łatwością

- Inżynierowie

- przedsiębiorstwa

- sprzęt

- Szacunki

- przykład

- egzekucja

- Czynniki

- i terminów, a

- pierwszy raz

- FLOTA

- koncentruje

- obserwuj

- następujący

- jedzenie

- Francisco

- funkcjonować

- dalej

- ogólnie

- Generować

- miejsce

- GitHub

- bardzo

- Zarządzanie

- Grupy

- Przewodniki

- Zdrowie

- Opieka zdrowotna

- pomoc

- pomoc

- Wysoki

- wyższy

- wysoko

- historia

- W jaki sposób

- How To

- Jednak

- HTTPS

- tożsamość

- obraz

- wdrożenia

- poprawa

- poprawy

- zawierać

- obejmuje

- wskaźnik

- przemysłowy

- Informacja

- Infrastruktura

- innowacje

- zainstalować

- ubezpieczenie

- zintegrowany

- IT

- Praca

- podróż

- Klawisz

- laboratorium

- język

- duży

- uruchomić

- warstwa

- UCZYĆ SIĘ

- nauka

- poziom

- Life Sciences

- Popatrz

- wierny

- maszyna

- uczenie maszynowe

- zrobiony

- utrzymać

- WYKONUJE

- zarządzanie

- zarządzane

- i konserwacjami

- zarządzający

- Marketing

- masywny

- dopasowywanie

- Użytkownicy

- ML

- model

- modele

- Monetarny

- pieniądze

- monitorowanie

- jeszcze

- większość

- wielokrotność

- niezbędny

- notatnik

- numer

- działać

- optymalizacja

- organizacji

- Inne

- pakiet

- szczególny

- Hasło

- Łata

- Zapłacić

- wtyczka

- polityka

- polityka

- Popularny

- możliwy

- potencjał

- przewidzieć

- Przygotować

- poprzedni

- Cena

- pierwotny

- wygląda tak

- procesów

- przetwarzanie

- Produkt

- wydajność

- Profil

- obiecujący

- zapewniać

- zapewnia

- zakup

- zakupy

- ilościowy

- szybko

- nośny

- Surowy

- Czytający

- otrzymać

- niedawno

- polecić

- dokumentacja

- wywołań

- wymagany

- wymagania

- Zasoby

- Efekt

- detaliczny

- przeglądu

- Ryzyko

- Rola

- Trasa

- run

- San

- San Francisco

- SC

- skalowalny

- Skala

- NAUKI

- Naukowcy

- Ekran

- Szukaj

- sekund

- bezpieczne

- bezpieczeństwo

- token bezpieczeństwa

- segment

- segmentacja

- Segmenty

- Bezserwerowe

- usługa

- Usługi

- zestaw

- shared

- krótkoterminowy

- pokazane

- podobny

- Prosty

- spać

- mały

- So

- Tworzenie

- solidny

- Rozwiązania

- kilka

- specjalizuje się

- stos

- rozpoczęty

- Startups

- przechowywanie

- sklep

- studio

- Z powodzeniem

- wsparcie

- system

- systemy

- Mówić

- cel

- ukierunkowane

- tymczasowy

- Połączenia

- Przez

- czas

- czasy

- już dziś

- razem

- żeton

- Zestaw narzędzi

- narzędzia

- Top

- handel

- Trening

- posługiwać się

- przypadków użycia

- Użytkownicy

- wartość

- różnorodny

- wersja

- pionowe

- wizja

- Co

- w ciągu

- bez

- pracujący

- by

- Twój