Kiedy kilka tygodni temu Stable Diffusion, aplikacja AI renderująca fotorealistyczne obrazy, zyskała na znaczeniu, pojawiło się nowe modne hasło; hipersieci.

Teraz stabilna dyfuzja i hipersieci są tak połączone, że nie można wymienić jednego bez drugiego w tym samym akapicie.

„Wytrenowałem hipersieci o stabilnej dyfuzji na małych zbiorach danych (nie, naprawdę nie współcześni artyści poza twoimi), aby nauczyć je niejasnych „stylów”, których tak naprawdę nie rozumie po wyjęciu z pudełka. Działa dokładnie tak, jak opisano, a właściwie lepiej, niż sam myślałem” — mówi użytkownik na Twitterze.

Wyszkoliłem hipersieci ze stabilną dyfuzją na małych zbiorach danych (nie, naprawdę nie współcześni artyści poza twoimi), aby nauczyć je niejasnych „stylów”, których tak naprawdę nie rozumie po wyjęciu z pudełka. działa dokładnie tak, jak opisał, właściwie lepiej, niż sam myślałem.

— maksymalizator żalu (@regretmaximizer) 20 grudnia 2022 r.

To uosobienie szumu związanego z hipersieciami, który ostatnio ogarnął internautów.

W informatyce hipersieć jest technicznie siecią, która generuje wagi dla sieci głównej. Innymi słowy, uważa się, że zachowanie sieci głównej jest takie samo jak innych sieci neuronowych, ponieważ uczy się ona mapować niektóre surowe dane wejściowe na pożądane cele, podczas gdy hipersieć pobiera zestaw danych wejściowych zawierających informacje o strukturze wag i generuje waga dla tej warstwy.

Przeczytaj również: Technologia sztucznej inteligencji, która tworzy niszczące życie głębokie fałszywe obrazy

W jaki sposób wykorzystywane są hipersieci?

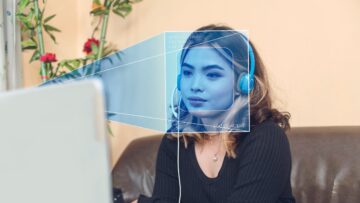

Aby zrozumieć, czym jest hipersieć, cofnijmy się trochę. Jeśli tworzyłeś obrazy w Stable Diffusion – narzędziu AI do tworzenia grafiki cyfrowej i obrazów – natknąłeś się na to.

Szkolenie ogólnie odnosi się do procesu, w którym model uczy się (określa) dobre wartości dla wszystkich wag i obciążenia z oznaczonych przykładów

Tworzenie obrazów na Stabilna dyfuzja nie jest procesem automatycznym, jak już omówiliśmy gdzie indziej. Aby się tam dostać, istnieją procesy.

Najpierw model AI musi nauczyć się, jak renderować lub syntetyzować obraz kogoś na zdjęciu z modelu 2D lub 3D za pomocą oprogramowania. Chociaż model stabilnej dyfuzji został dokładnie przetestowany, ma on pewne ograniczenia szkoleniowe, które można skorygować za pomocą osadzania i metod uczenia hipersieci.

Aby uzyskać najlepsze wyniki, użytkownicy końcowi mogą zdecydować się na dodatkowe szkolenie w celu dostrojenia wyników generowania, aby pasowały do bardziej konkretnych przypadków użycia. Szkolenie „osadzania” obejmuje kolekcję obrazów dostarczonych przez użytkownika i umożliwia modelowi tworzenie wizualnie podobnych obrazów za każdym razem, gdy nazwa osadzania jest używana w monicie generowania.

Osadzenia opierają się na koncepcji „inwersji tekstu” opracowanej przez naukowców z Uniwersytetu w Tel Awiwie, w której wektorowe reprezentacje określonych tokenów używane przez koder tekstu modelu są łączone z nowymi pseudosłowami. Osadzanie może zmniejszyć odchylenia w oryginalnym modelu lub naśladować style wizualne.

Z drugiej strony „hipersieć” to wstępnie wyszkolona sieć neuronowa, która jest stosowana w różnych punktach w większej sieci neuronowej i odnosi się do techniki stworzonej przez programistę NovelAI, Kurumuza, w 2021 r., pierwotnie przeznaczonej do modeli transformatorów do generowania tekstu .

Pociągi na konkretnych artystów

Uwzględniono hipersieci, aby kierować wyniki w określonym kierunku, umożliwiając modelom opartym na stabilnej dyfuzji replikację stylów artystycznych określonych artystów. Sieć ma tę zaletę, że może pracować nawet wtedy, gdy artysta nie jest rozpoznawany przez oryginalny model i nadal będzie przetwarzać obraz, znajdując kluczowe obszary, takie jak włosy i oczy, a następnie łatać te obszary w drugorzędnej ukrytej przestrzeni.

„Warstwa Embedding w Stable Diffusion jest odpowiedzialna za kodowanie danych wejściowych (na przykład podpowiedzi tekstowych i etykiet klas) w niskowymiarowych wektorach. Wektory te pomagają kierować modelem dyfuzji, aby tworzyć obrazy pasujące do danych wprowadzonych przez użytkownika” — wyjaśnia Benny Cheung na swoim blogu.

„Warstwa Hypernetwork pozwala systemowi uczyć się i reprezentować własną wiedzę. Pozwala Stable Diffusion na tworzenie obrazów w oparciu o wcześniejsze doświadczenia.”

Podczas gdy warstwa osadzania koduje dane wejściowe, takie jak monity tekstowe i etykiety klas, w niskowymiarowych wektorach, aby pomóc modelowi dyfuzji w tworzeniu obrazów pasujących do danych wejściowych użytkownika, warstwa hipersieci jest w pewnym sensie sposobem uczenia się systemu i przedstawiania własnych wiedza, umiejętności.

Innymi słowy, pozwala Stable Diffusion na tworzenie obrazów w oparciu o wcześniejsze doświadczenia. W przypadku stabilnej dyfuzji hipersieć to dodatkowa warstwa, która jest przetwarzana po wyrenderowaniu obrazu przez model. Hypernetwork ma tendencję do pochylania wszystkich wyników z modelu w kierunku danych treningowych w sposób zasadniczo „zmieniający” model.

Zachowanie pamięci

Zasadniczo oznacza to, że hipersieć jest odpowiedzialna za przechowywanie w pamięci obrazów wygenerowanych wcześniej przez system. Gdy użytkownik wprowadzi nowe dane, system może wykorzystać swoją wcześniejszą wiedzę do stworzenia dokładniejszego obrazu. W związku z tym hipersieci umożliwiają systemowi szybsze uczenie się i ulepszanie w miarę postępów.

Ma to tę zaletę, że każdy obraz zawierający coś, co opisuje twoje dane treningowe, będzie wyglądał jak twoje dane treningowe.

„Odkryliśmy, że szkolenie z osadzaniem jest łatwiejsze niż szkolenie z hipersiecią do generowania autoportretów. Nasz trening dał dobre wyniki, z których jesteśmy zadowoleni” – napisał Cheung.

Jakiej techniki dostrajania używasz? Coś w stylu Hypernetworks lub Textual Inversion?

— Mathias Michel (@m91michel) 21 grudnia 2022 r.

Ale jest to technologia, z którą wielu wciąż się targuje. Hipersieci i generatory sztucznej inteligencji właśnie zaczęły zaspokajać potrzeby i pragnienia użytkowników. Interfejsy użytkownika i techniki podpowiedzi będą bez wątpienia szybko się rozwijały, a może nawet będą chwytliwe Google zaskoczony, jak MetaNews niedawno pokryte.

- AI

- ai sztuka

- Bitcoin

- blockchain

- zgodność z technologią blockchain

- coinbase

- pomysłowość

- Zgoda

- konferencja kryptograficzna

- wydobycie kryptograficzne

- kryptowaluta

- Zdecentralizowane

- głębokie podróbki

- DeFi

- Zasoby cyfrowe

- ethereum

- polecane

- hipersieci

- uczenie maszynowe

- MetaWiadomości

- niezamienny żeton

- plato

- Platon Ai

- Analiza danych Platona

- PlatoDane

- platogaming

- Wielokąt

- dowód stawki

- stabilna dyfuzja

- Technologia

- W3

- zefirnet