Hoje, temos o prazer de anunciar que os modelos de base Meta Llama 3 estão disponíveis através JumpStart do Amazon SageMaker para implantar e executar inferência. Os modelos Llama 3 são uma coleção de modelos de texto generativos pré-treinados e ajustados.

Nesta postagem, explicamos como descobrir e implantar modelos Llama 3 por meio do SageMaker JumpStart.

O que é Meta Lhama 3

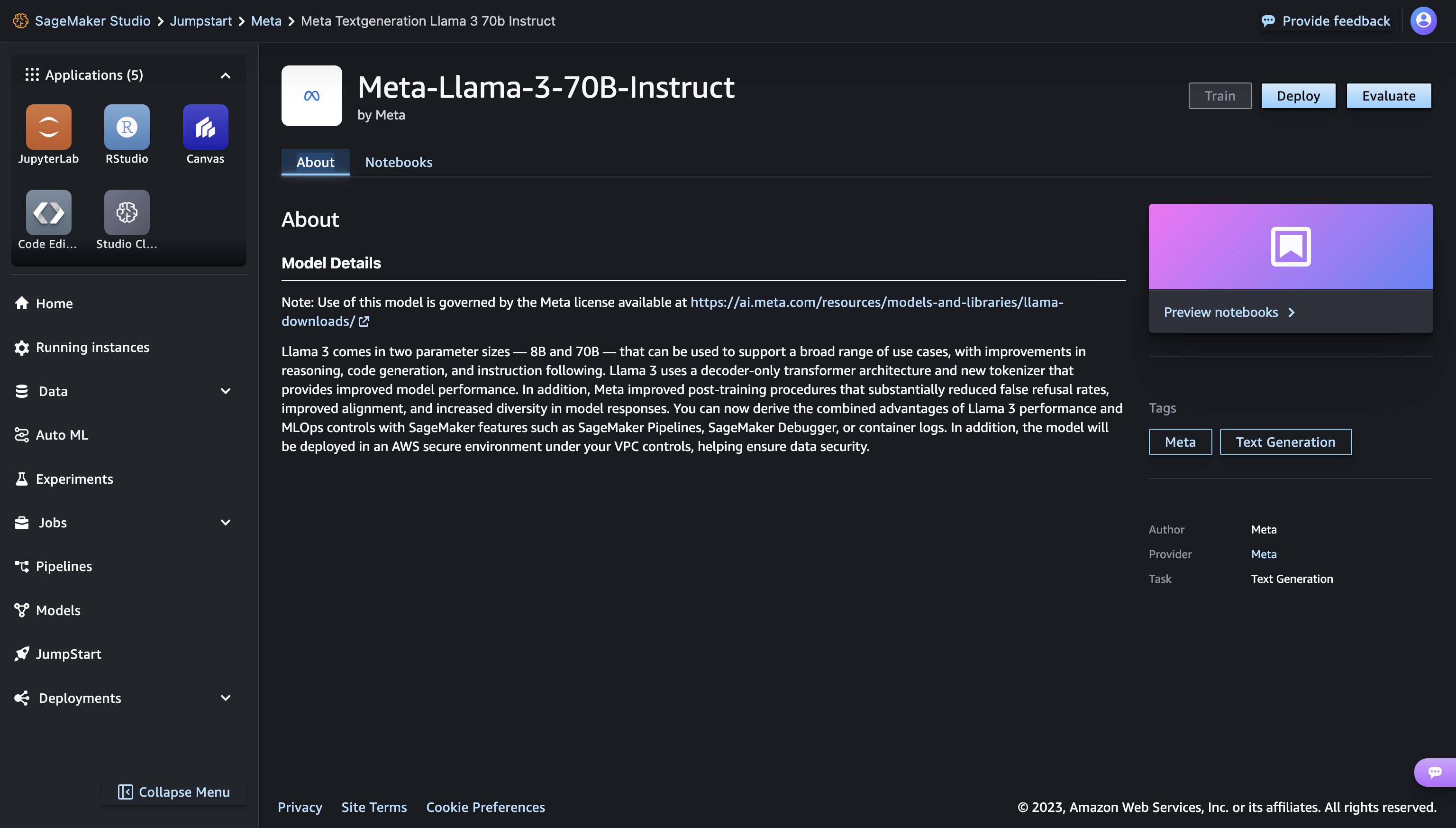

O Llama 3 vem em dois tamanhos de parâmetros – 8B e 70B com comprimento de contexto de 8k – que podem suportar uma ampla gama de casos de uso com melhorias no raciocínio, geração de código e acompanhamento de instruções. O Llama 3 usa uma arquitetura de transformador somente decodificador e um novo tokenizer que fornece melhor desempenho do modelo com tamanho de 128k. Além disso, o Meta melhorou os procedimentos pós-treinamento que reduziram substancialmente as taxas de falsas recusas, melhoraram o alinhamento e aumentaram a diversidade nas respostas do modelo. Agora você pode obter as vantagens combinadas do desempenho do Llama 3 e dos controles MLOps com recursos do Amazon SageMaker, como SageMaker Pipelines, SageMaker Debugger ou logs de contêiner. Além disso, o modelo será implantado em um ambiente seguro da AWS sob seus controles de VPC, ajudando a fornecer segurança de dados.

O que é o SageMaker JumpStart

Com o SageMaker JumpStart, você pode escolher entre uma ampla seleção de modelos de base disponíveis publicamente. Os profissionais de ML podem implantar modelos básicos em instâncias dedicadas do SageMaker a partir de um ambiente isolado de rede e personalizar modelos usando o SageMaker para treinamento e implantação de modelos. Agora você pode descobrir e implantar modelos do Llama 3 com apenas alguns cliques Estúdio Amazon SageMaker ou programaticamente por meio do SageMaker Python SDK, permitindo derivar o desempenho do modelo e controles MLOps com recursos do SageMaker, como Pipelines SageMaker, Depurador SageMakerou registros de contêiner. O modelo é implantado em um ambiente seguro da AWS e sob seus controles de VPC, ajudando a fornecer segurança de dados. Os modelos Llama 3 estão disponíveis hoje para implantação e inferência no Amazon SageMaker Studio em us-east-1 (Norte da Virgínia), us-east-2 (Ohio), us-west-2 (Oregon), eu-west-1 (Irlanda) e ap-northeast-1 (Tóquio) Regiões da AWS.

Descubra modelos

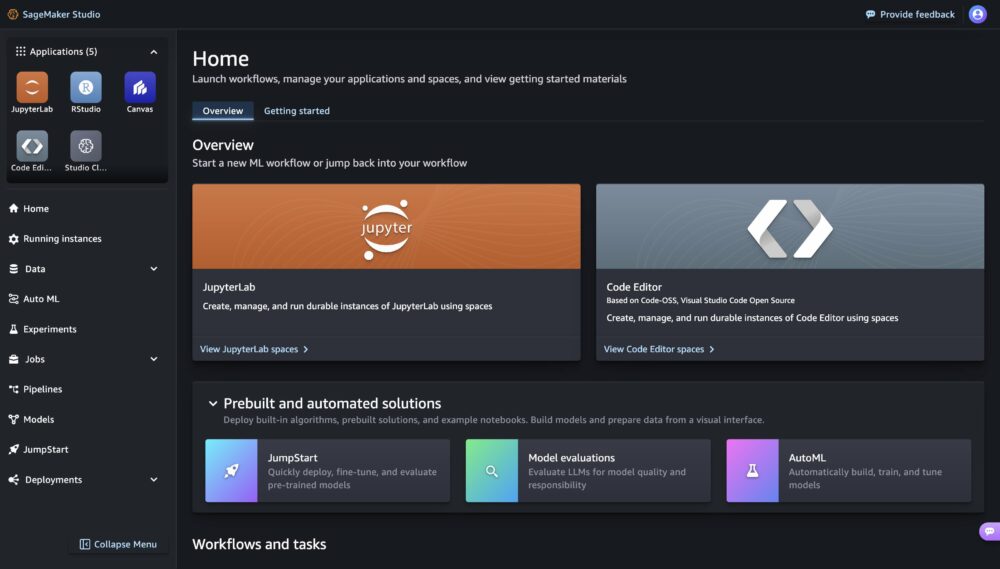

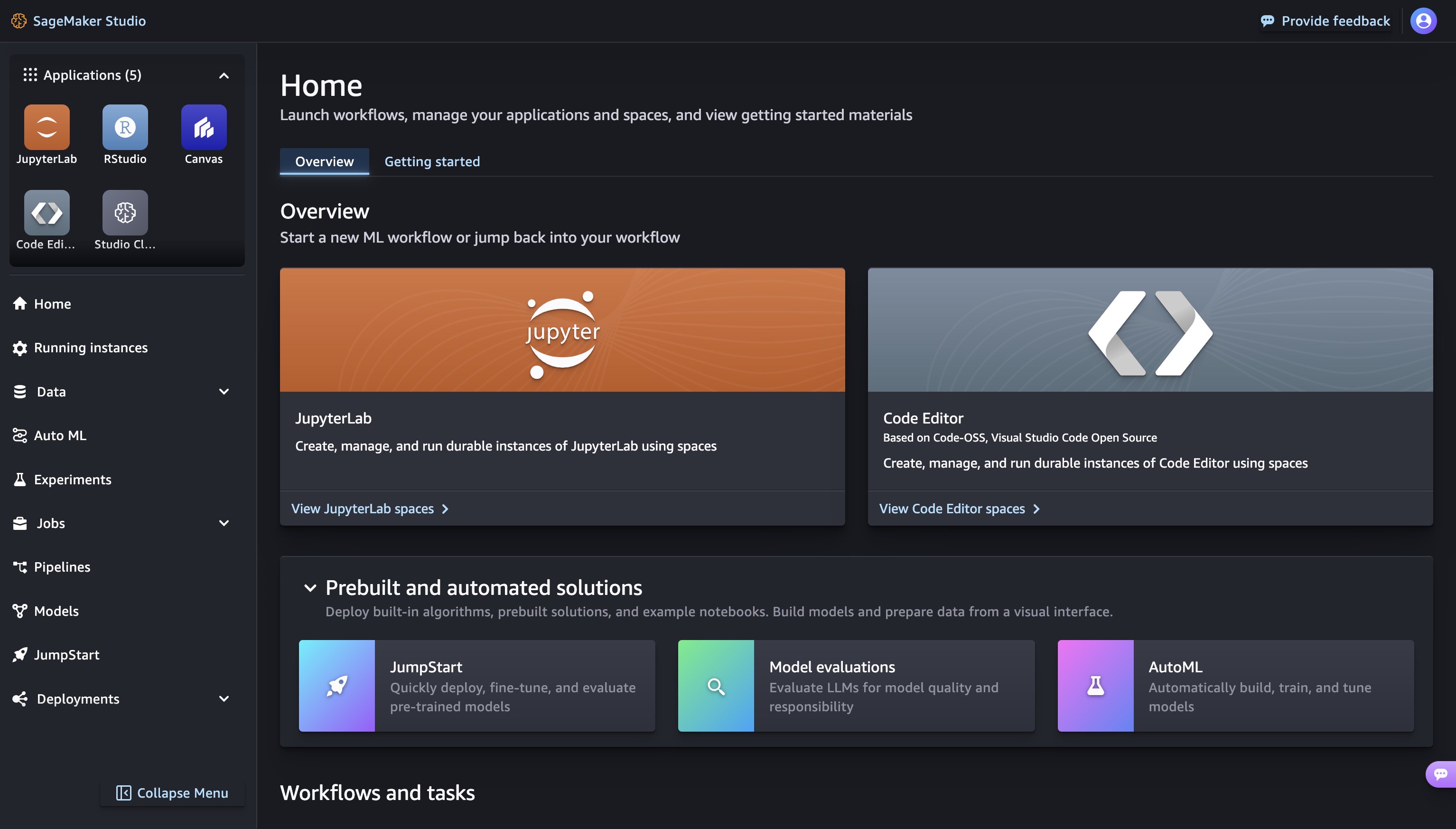

Você pode acessar os modelos básicos por meio do SageMaker JumpStart na interface do SageMaker Studio e do SageMaker Python SDK. Nesta seção, veremos como descobrir os modelos no SageMaker Studio.

SageMaker Studio é um ambiente de desenvolvimento integrado (IDE) que fornece uma única interface visual baseada na web onde você pode acessar ferramentas específicas para executar todas as etapas de desenvolvimento de ML, desde a preparação de dados até a construção, treinamento e implantação de seus modelos de ML. Para obter mais detalhes sobre como começar e configurar o SageMaker Studio, consulte Estúdio Amazon SageMaker.

No SageMaker Studio, você pode acessar o SageMaker JumpStart, que contém modelos pré-treinados, notebooks e soluções pré-construídas, em Soluções pré-construídas e automatizadas.

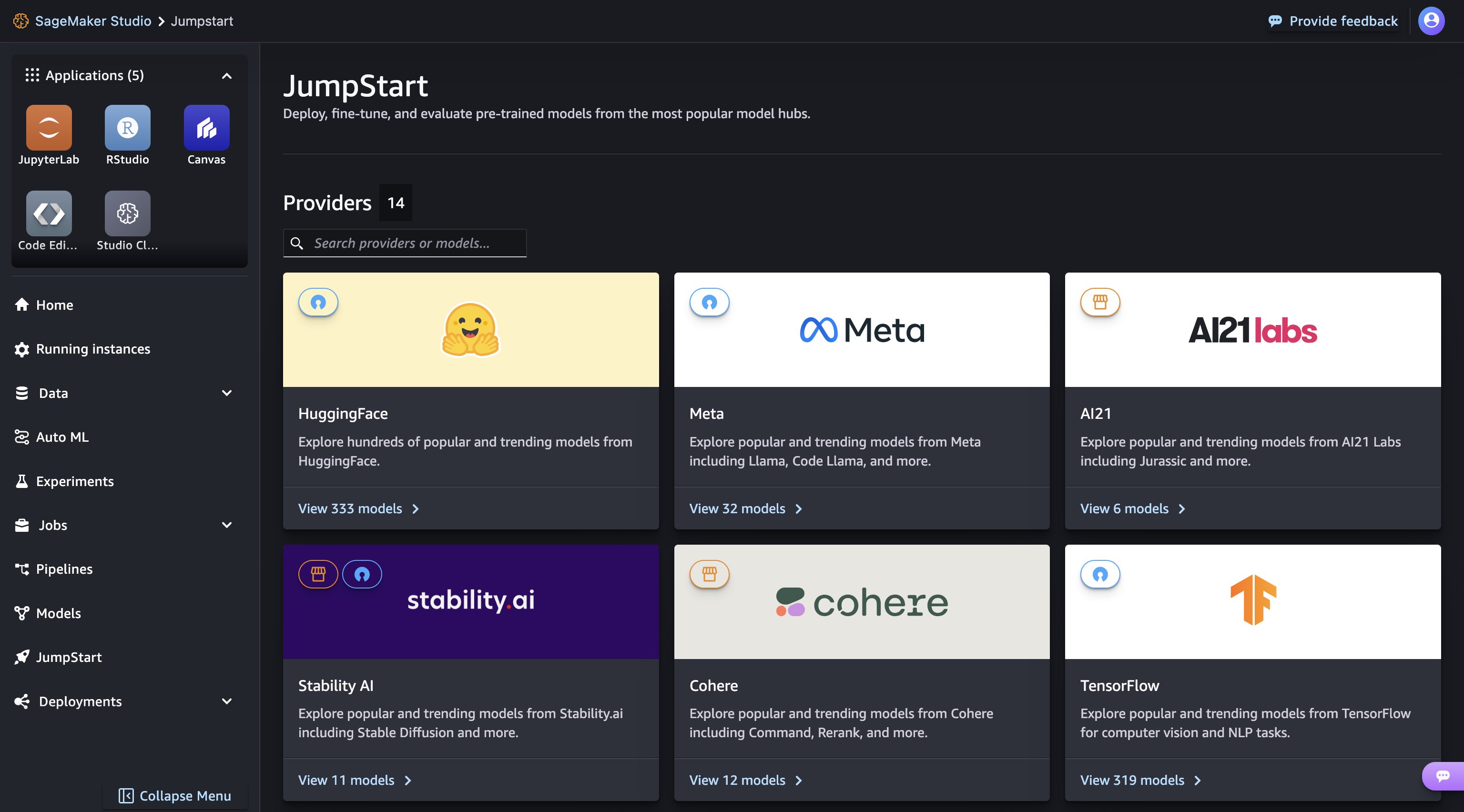

Na página inicial do SageMaker JumpStart, você pode descobrir facilmente vários modelos navegando por diferentes hubs com nomes de fornecedores de modelos. Você pode encontrar modelos Llama 3 no Meta hub. Se você não vir os modelos Llama 3, atualize sua versão do SageMaker Studio desligando e reiniciando. Para obter mais informações, consulte Encerre e atualize os aplicativos do Studio Classic.

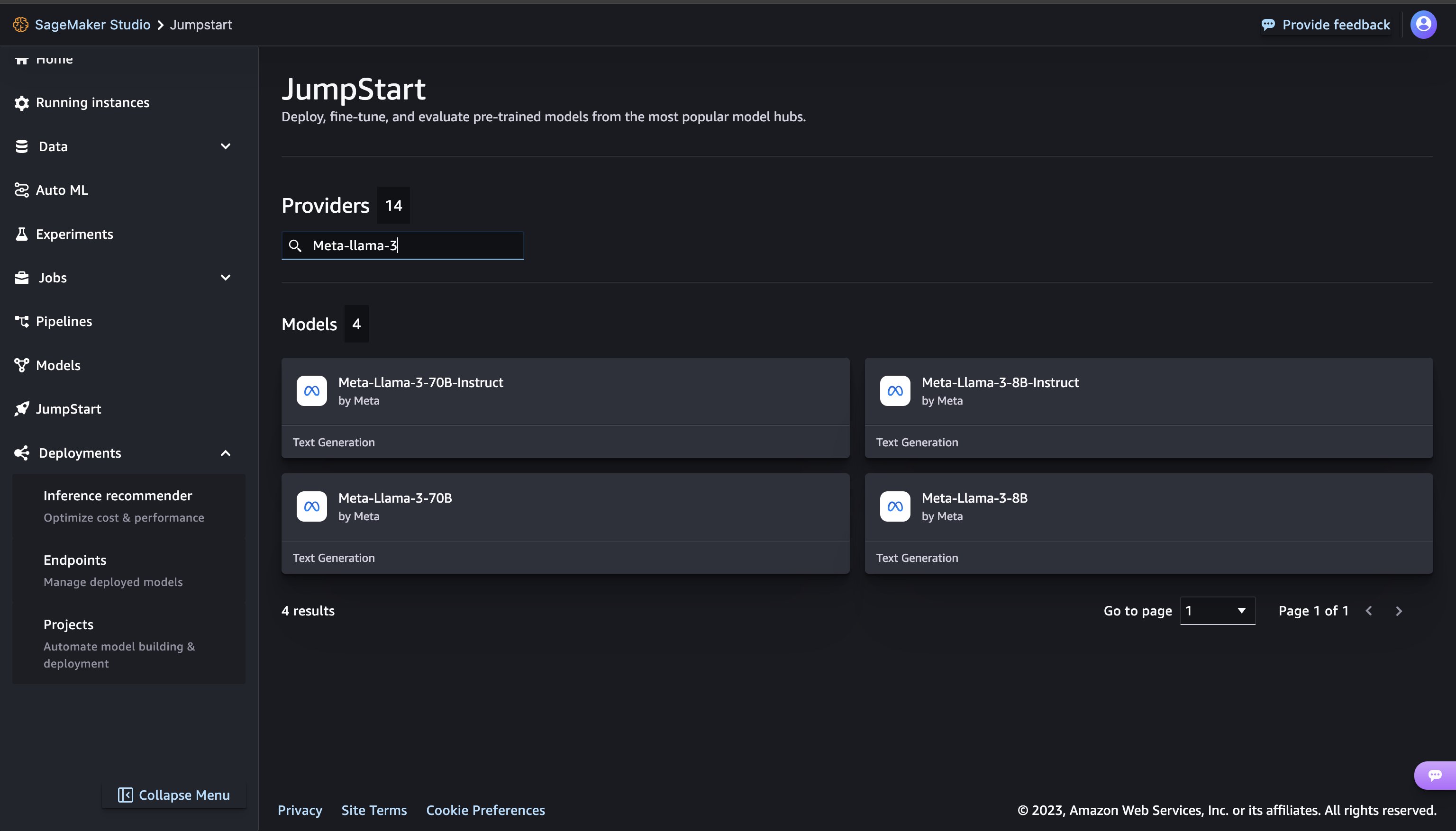

Você pode encontrar modelos Llama 3 pesquisando “Meta-llama-3“ na caixa de pesquisa localizada no canto superior esquerdo.

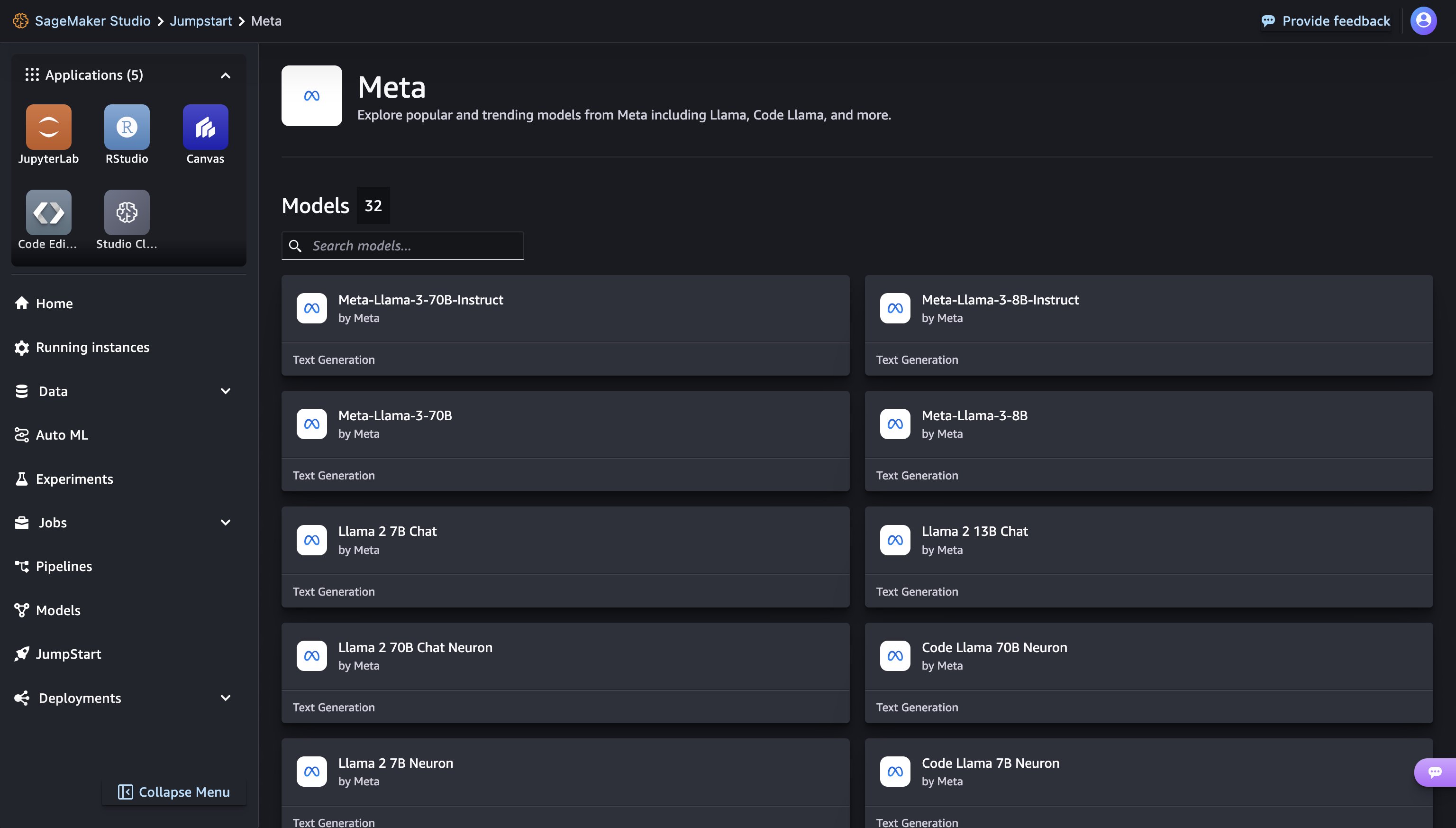

Você pode descobrir todos os modelos Meta disponíveis no SageMaker JumpStart clicando em Meta hub.

Clicar em um cartão de modelo abre a página de detalhes do modelo correspondente, na qual você pode facilmente implantar o modelo.

Implantar um modelo

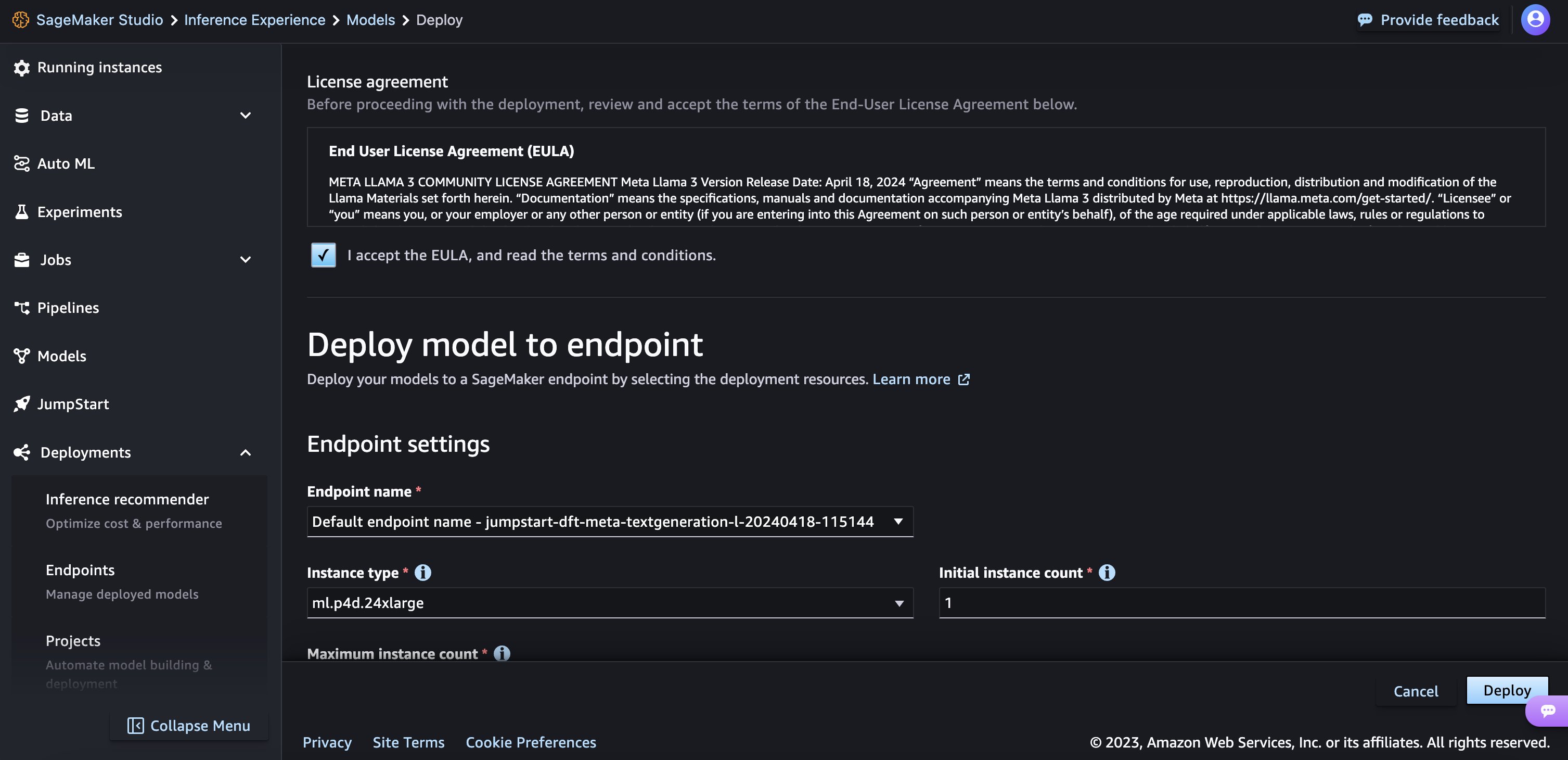

Quando você escolhe Implantação e reconhecer os termos do EULA, a implantação será iniciada.

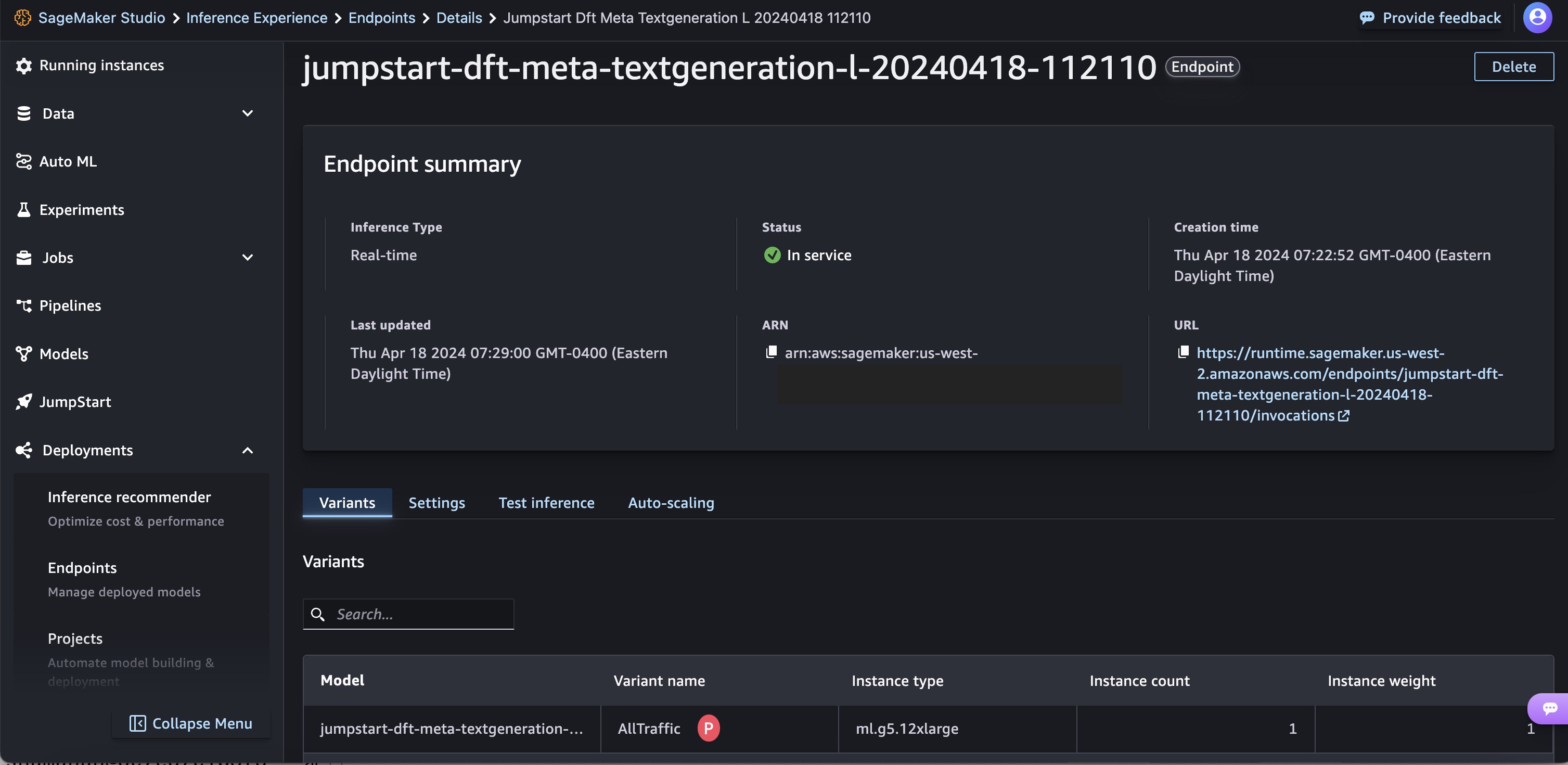

Você pode monitorar o progresso da implantação na página que aparece após clicar no botão Implantar.

Como alternativa, você pode escolher Caderno aberto para implantar por meio do notebook de exemplo. O caderno de exemplo fornece orientação completa sobre como implantar o modelo para inferência e limpeza de recursos.

Para implantar usando o notebook, você começa selecionando um modelo apropriado, especificado pelo model_id. Você pode implantar qualquer um dos modelos selecionados no SageMaker com o código a seguir.

Por padrão accept_eula está definido para False. Você precisa aceitar manualmente o EULA para implantar o endpoint com êxito. Ao fazer isso, você aceita o contrato de licença do usuário e a política de uso aceitável. Você também pode encontrar o contrato de licença Site da lhama. Isso implanta o modelo no SageMaker com configurações padrão, incluindo o tipo de instância padrão e as configurações de VPC padrão. Você pode alterar essas configurações especificando valores não padrão em JumpStartModel. Para saber mais, consulte o seguinte documentação.

A tabela a seguir lista todos os modelos Llama 3 disponíveis no SageMaker JumpStart junto com o model_ids, tipos de instância padrão e número máximo de tokens totais (soma do número de tokens de entrada e número de tokens gerados) suportados para cada um desses modelos.

| Nome do modelo | ID do modelo | Total máximo de tokens | Tipo de instância padrão |

| Meta-Lhama-3-8B | geração de metatexto-llama-3-8B | 8192 | ml.g5.12xgrande |

| Meta-Llama-3-8B-Instrução | meta-textGeneration-llama-3-8B-instruct | 8192 | ml.g5.12xgrande |

| Meta-Lhama-3-70B | geração de metatexto-llama-3-70b | 8192 | ml.p4d.24xgrande |

| Meta-Llama-3-70B-Instrução | meta-textGeneration-llama-3-70b-instruct | 8192 | ml.p4d.24xgrande |

Executar inferência

Depois de implantar o modelo, você pode executar inferência no endpoint implantado por meio do preditor SageMaker. Modelos de instrução ajustados (Llama 3: 8B Instruct e 70B Instruct) aceitam um histórico de bate-papos entre o usuário e o assistente de bate-papo e geram o bate-papo subsequente. Os modelos pré-treinados (Llama 3: 8B e 70B) requerem um prompt de string e executam o preenchimento do texto no prompt fornecido.

Os parâmetros de inferência controlam o processo de geração de texto no terminal. Os novos tokens Max controlam o tamanho da saída gerada pelo modelo. Isso não é igual ao número de palavras porque o vocabulário do modelo não é igual ao vocabulário do idioma inglês e cada token pode não ser uma palavra do idioma inglês. O parâmetro temperatura controla a aleatoriedade na saída. Temperaturas mais altas resultam em resultados mais criativos e alucinados. Todos os parâmetros de inferência são opcionais.

Solicitações de exemplo para o modelo 70B

Você pode usar os modelos Llama 3 para completar o texto de qualquer trecho de texto. Por meio da geração de texto, você pode realizar uma variedade de tarefas, como resposta a perguntas, tradução de idiomas, análise de sentimentos e muito mais. A carga útil de entrada para o endpoint se parece com o código a seguir:

A seguir estão alguns exemplos de prompts e o texto gerado pelo modelo. Todas as saídas são geradas com parâmetros de inferência {"max_new_tokens":64, "top_p":0.9, "temperature":0.6}.

No próximo exemplo, mostramos como usar modelos Llama 3 com aprendizado no contexto de poucos disparos, onde fornecemos amostras de treinamento disponíveis para o modelo. Executamos inferência apenas no modelo implantado e durante esse processo, e os pesos do modelo não mudam.

Solicitações de exemplo para o modelo 70B-Instruct

Com os modelos de instrução do Llama 3 que são otimizados para casos de uso de diálogo, a entrada para os endpoints do modelo de instrução é o histórico anterior entre o assistente de chat e o usuário. Você pode fazer perguntas contextuais à conversa que aconteceu até agora. Você também pode fornecer a configuração do sistema, como personas, que definem o comportamento do assistente de chat. Embora o formato da carga útil de entrada seja o mesmo do modelo base pré-treinado, o texto de entrada deve ser formatado da seguinte maneira:

Neste modelo de instrução, você pode opcionalmente começar com um system função e incluir quantas funções alternadas desejar na história baseada em turnos. O papel final deve ser sempre assistant e termine com dois novos feeds de linha.

A seguir, considere alguns exemplos de solicitações e respostas do modelo. No exemplo a seguir, o usuário está fazendo uma pergunta simples ao assistente.

No exemplo a seguir, o usuário conversa com o assistente sobre pontos turísticos de Paris. Em seguida, o usuário questiona sobre a primeira opção recomendada pelo assistente de chat.

Nos exemplos a seguir, definimos a configuração do sistema.

limpar

Depois de terminar de executar o notebook, exclua todos os recursos que você criou no processo para que seu faturamento seja interrompido. Use o seguinte código:

Conclusão

Neste post, mostramos como começar a usar os modelos Llama 3 no SageMaker Studio. Agora você tem acesso a quatro modelos de base do Llama 3 que contêm bilhões de parâmetros. Como os modelos básicos são pré-treinados, eles também podem ajudar a reduzir os custos de treinamento e infraestrutura e permitir a personalização para seu caso de uso. Confira SageMaker JumpStart no SageMaker Studio agora para começar.

Sobre Autores

Kyle Ulrich é Cientista Aplicado II na AWS

Xin Huang é cientista aplicado sênior na AWS

Qinglan é engenheiro desenvolvedor de software sênior na AWS

Haotiano An é engenheiro desenvolvedor de software II na AWS

Christopher Whitten é engenheiro de desenvolvimento de software II na AWS

Tyler Osterberg é engenheiro de desenvolvimento de software I na AWS

Manan Xá é gerente de desenvolvimento de software na AWS

Jonathan Guinegagne é engenheiro desenvolvedor de software sênior na AWS

Adriana Simões é gerente sênior de marketing de produto na AWS

junho ganhou é gerente de produto sênior na AWS

Ashish Khetan é cientista aplicado sênior na AWS

Rachna Chadha é arquiteto de soluções principal – AI/ML na AWS

Deepak Rupakula é especialista principal em GTM na AWS

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/meta-llama-3-models-are-now-available-in-amazon-sagemaker-jumpstart/

- :tem

- :é

- :não

- :onde

- $UP

- 1

- 10

- 11

- 120

- 19

- 360-degree

- 43

- 7

- 8

- 8k

- 9

- a

- Sobre

- ACEITAR

- aceitável

- Acesso

- acessível

- reconhecer

- adicionar

- adicionado

- Adição

- vantagens

- Depois de

- novamente

- contra

- Acordo

- AI / ML

- alinhamento

- Todos os Produtos

- juntamente

- tb

- sempre

- am

- Amazon

- Amazon Sage Maker

- JumpStart do Amazon SageMaker

- Estúdio Amazon SageMaker

- Amazon Web Services

- ambiance

- an

- análise

- e

- e infra-estrutura

- Anunciar

- responder

- responder

- qualquer

- Apple

- aplicado

- apropriado

- arquitetura

- SOMOS

- Arte

- AS

- perguntar

- pergunta

- Assistente

- associado

- At

- Atmosfera

- atração

- atrações

- Automatizado

- disponível

- evitar

- AWS

- base

- BE

- Tenha

- bonita

- Porque

- sido

- comportamento

- Beijing

- Acreditar

- entre

- morada

- bilhões

- Caixa

- quebra

- de tirar o fôlego

- amplo

- Quebrado

- Navegando

- Prédio

- construído

- mas a

- botão

- by

- chamadas

- CAN

- capital

- cartão

- casas

- casos

- alterar

- bate-papo

- chats

- verificar

- Escolha

- Cidades

- clássico

- limpar

- código

- coleção

- combinação

- combinado

- vem

- Comunicação

- realização

- Configuração

- Considerar

- constante

- não contenho

- Recipiente

- contém

- contexto

- contextual

- continuamente

- ao controle

- controles

- Conveniente

- Conversa

- Correspondente

- custos

- crio

- criado

- Criatividade

- crucial

- Cultura

- copo

- Clientes

- personalização

- personalizar

- dados,

- segurança dos dados

- de

- dedicado

- Padrão

- definir

- implantar

- implantado

- Implantação

- desenvolvimento

- implanta

- derivar

- desejado

- destinos

- detalhe

- detalhes

- Developer

- Desenvolvimento

- Diálogo

- diferença

- diferente

- jantares

- descobrir

- Diversidade

- do

- não

- fazer

- don

- feito

- duplicou

- down

- durante

- Crepúsculo

- e

- cada

- facilmente

- esforços

- permitir

- permitindo

- final

- end-to-end

- Ponto final

- engenheiro

- Engenharia

- Inglês

- suficiente

- assegurando

- Meio Ambiente

- Mesmo

- Cada

- todos

- exemplo

- exemplos

- animado

- vasta experiência

- feira

- falso

- famoso

- longe

- façanha

- destaque

- Funcionalidades

- pés

- poucos

- filmes

- final

- Encontre

- Primeiro nome

- sabor

- Flutuador

- fluxo

- seguinte

- Pé

- Escolha

- formato

- Foundation

- quatro

- França

- Francês

- recentes

- da

- Geral

- Teoria Geral da Relatividade

- gerar

- gerado

- geração

- generativo

- suave

- Alemão

- ter

- vidro

- Go

- vai

- gradualmente

- ótimo

- inovador

- orientações

- dirigido

- acontecer

- aconteceu

- Queijos duros

- trabalho duro

- Ter

- saudável

- ajudar

- ajuda

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- superior

- histórico

- história

- segurar

- Início

- hora

- habitação

- Como funciona o dobrador de carta de canal

- Como Negociar

- HTML

- HTTPS

- Hub

- cubos

- i

- icônico

- if

- ii

- importar

- impressionante

- melhorado

- melhorias

- in

- incluir

- Incluindo

- Crescimento

- aumentou

- aumentando

- INFORMAÇÕES

- Infraestrutura

- entrada

- instância

- imediatamente

- integrado

- Interface

- para dentro

- Irlanda

- isolado

- IT

- ESTÁ

- jpg

- apenas por

- Guarda

- Saber

- conhecido

- aterrissagem

- marcos

- língua

- maior

- lançamento

- Leis

- APRENDER

- aprendizagem

- esquerda

- Comprimento

- Licença

- vida

- Levantado

- leve

- isqueiro

- como

- Line

- listas

- literatura

- pequeno

- viver

- Vidas

- lhama

- localizado

- OLHARES

- lote

- diminuir

- moldadas

- fazer

- Fazendo

- Gerente

- maneira

- manualmente

- muitos

- Marketing

- max

- máximo

- Posso..

- significado

- mensagem

- Meta

- meia-noite

- Minutos

- conjugar

- mistura

- ML

- MLOps

- modelo

- modelos

- Monitore

- mais

- a maioria

- Mais populares

- muito

- museu

- Museus

- Nomeado

- você merece...

- necessário

- rede

- Novo

- Próximo

- noite

- não

- caderno

- agora

- número

- NY

- observação

- observadores

- ocorrer

- of

- oferecer

- oferecendo treinamento para distância

- Oferece

- frequentemente

- Ohio

- AZEITE E AZEITE EVO

- on

- ONE

- só

- abre

- ideal

- otimizado

- Opção

- or

- ordem

- Oregon

- Outros

- A Nossa

- nosso

- Fora

- saída

- outputs

- Acima de

- página

- parâmetro

- parâmetros

- Paris

- parte

- Realizar

- atuação

- Física

- peça

- Lugar

- platão

- Inteligência de Dados Platão

- PlatãoData

- desempenhado

- por favor

- Privacidade

- Popular

- Publique

- Predictor

- preparação

- anterior

- Diretor

- procedimentos

- processo

- Produto

- gerente de produto

- Perfis

- Progresso

- solicita

- Propostas

- fornecer

- fornecido

- fornecedores

- fornece

- público

- transporte público

- publicamente

- propósito

- colocar

- Python

- questão

- Frequentes

- aleatoriedade

- alcance

- Preços

- RE

- alcançado

- razões

- receita

- Recomenda

- Reduzido

- referir

- recusa

- Saudações

- regiões

- relatividade

- requerer

- recurso

- Recursos

- respostas

- Resultados

- Rio

- Tipo

- papéis

- romance

- Quarto

- Execute

- corrida

- s

- sábio

- Pipelines SageMaker

- sal

- mesmo

- amostra

- dizer

- Cientista

- Sdk

- Pesquisar

- pesquisar

- Segundo

- Seção

- seguro

- segurança

- Vejo

- selecionado

- selecionando

- doadores,

- senior

- sentimento

- Serviços

- de servir

- conjunto

- vários

- Shape

- tiro

- rede de apoio social

- mostrar

- mostrou

- Shows

- desligando

- periodo

- simples

- simplesmente

- solteiro

- Locais

- Tamanho

- tamanhos

- lento

- Lentamente

- Liso

- So

- até aqui

- Software

- desenvolvimento de software

- solução

- Soluções

- alguns

- Faísca

- especial

- especialista

- especificada

- especificando

- velocidade

- Spot

- suporte

- de pé

- começo

- começado

- Unidos

- estável

- Passos

- Dê um basta

- parou

- transmitir canais

- Tanga

- estrutura

- estudo

- Assombroso

- subseqüente

- substancialmente

- entraram com sucesso

- tal

- ajuda

- Suportado

- certo

- símbolo

- .

- mesa

- Alfaiate

- Tire

- toma

- tomar

- tarefas

- gosto

- Profissionais

- modelo

- condições

- texto

- obrigado

- que

- A

- O capital

- o mundo

- então

- teoria

- Lá.

- Este

- deles

- fino

- isto

- milhares

- Através da

- tempo

- para

- hoje

- juntos

- token

- Tokens

- Tóquio

- também

- ferramentas

- topo

- Total

- excursão

- Torre

- Training

- transformador

- traduzir

- Tradução

- transporte

- dois

- tipo

- tipos

- ui

- para

- único

- até

- Atualizar

- usar

- caso de uso

- Utilizador

- usos

- utilização

- Valioso

- Valores

- variações

- variedade

- vário

- versão

- muito

- via

- visualizações

- Virgínia

- visual

- volume

- vs

- andar

- querido

- guerra

- foi

- Água

- maneiras

- we

- web

- serviços web

- Web-Based

- casamentos

- BEM

- fui

- O Quê

- quando

- qual

- enquanto

- branco

- porque

- precisarão

- Windows

- VINHO

- de

- maravilha

- Word

- palavras

- Atividades:

- mundo

- Vocês

- investimentos

- zefirnet