A inteligência artificial (IA) é um campo em rápida evolução com potencial para melhorar e transformar muitos aspectos da sociedade. Em 2023, o ritmo de adoção de tecnologias de IA acelerou ainda mais com o desenvolvimento de modelos básicos (FMs) poderosos e um avanço resultante nas capacidades de IA generativa.

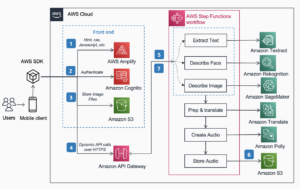

Na Amazon, lançamos vários serviços generativos de IA, como Rocha Amazônica e Sussurrador de Código da Amazone disponibilizaram uma série de modelos generativos altamente capazes por meio de JumpStart do Amazon SageMaker. Esses serviços são projetados para apoiar nossos clientes no desbloqueio dos recursos emergentes da IA generativa, incluindo criatividade aprimorada, criação de conteúdo personalizado e dinâmico e design inovador. Eles também podem permitir que os profissionais de IA compreendam o mundo como nunca antes — abordando barreiras linguísticas, mudanças climáticas, acelerando descobertas científicas e muito mais.

No entanto, para aproveitar todo o potencial da IA generativa, é importante refletir cuidadosamente sobre quaisquer riscos potenciais. Em primeiro lugar, isto beneficia as partes interessadas do sistema de IA, promovendo o desenvolvimento e a implantação responsáveis e seguros e incentivando a adoção de medidas proativas para fazer face ao potencial impacto. Consequentemente, o estabelecimento de mecanismos para avaliar e gerir riscos é um processo importante a ser considerado pelos profissionais de IA e tornou-se um componente central de muitos padrões emergentes da indústria de IA (por exemplo, ISO 42001, ISO 23894 e RMF do NIST) e legislação (como Lei de IA da UE).

Nesta postagem, discutimos como avaliar o risco potencial do seu sistema de IA.

Quais são os diferentes níveis de risco?

Embora possa ser mais fácil começar a olhar para um modelo individual de aprendizado de máquina (ML) e os riscos associados isoladamente, é importante considerar os detalhes da aplicação específica de tal modelo e o caso de uso correspondente como parte de um sistema de IA completo . Na verdade, é provável que um sistema de IA típico se baseie em vários modelos de ML diferentes trabalhando juntos, e uma organização pode estar procurando construir vários sistemas de IA diferentes. Consequentemente, os riscos podem ser avaliados para cada caso de uso e em diferentes níveis, nomeadamente risco de modelo, risco de sistema de IA e risco empresarial.

O risco empresarial abrange o amplo espectro de riscos que uma organização pode enfrentar, incluindo riscos financeiros, operacionais e estratégicos. O risco do sistema de IA centra-se no impacto associado à implementação e operação de sistemas de IA, enquanto o risco do modelo de ML refere-se especificamente às vulnerabilidades e incertezas inerentes aos modelos de ML.

Nesta postagem, nos concentramos principalmente no risco do sistema de IA. No entanto, é importante notar que todos os diferentes níveis de gestão de riscos dentro de uma organização devem ser considerados e alinhados.

Como é definido o risco do sistema de IA?

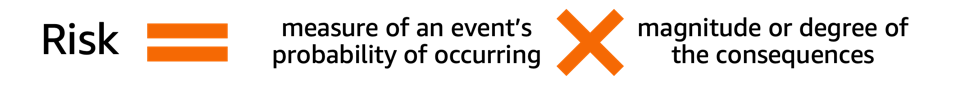

A gestão de riscos no contexto de um sistema de IA pode ser um caminho para minimizar o efeito da incerteza ou de potenciais impactos negativos, ao mesmo tempo que proporciona oportunidades para maximizar os impactos positivos. O risco em si não é um dano potencial, mas o efeito da incerteza nos objetivos. De acordo com Estrutura de gerenciamento de risco do NIST (NIST RMF), o risco pode ser estimado como uma medida multiplicativa da probabilidade de ocorrência de um evento cronometrada pelas magnitudes das consequências do evento correspondente.

Existem dois aspectos do risco: risco inerente e risco residual. O risco inerente representa a quantidade de risco que o sistema de IA apresenta na ausência de mitigações ou controles. O risco residual captura os riscos restantes após considerar estratégias de mitigação.

Tenha sempre em mente que a avaliação de riscos é uma atividade centrada no ser humano que requer esforços de toda a organização; esses esforços vão desde garantir que todas as partes interessadas relevantes sejam incluídas no processo de avaliação (como equipes de produto, engenharia, ciência, vendas e segurança) até avaliar como as perspectivas e normas sociais influenciam a probabilidade percebida e as consequências de determinados eventos.

Por que sua organização deveria se preocupar com a avaliação de riscos?

O estabelecimento de quadros de gestão de riscos para sistemas de IA pode beneficiar a sociedade em geral, ao promover a conceção, o desenvolvimento e a operação seguros e responsáveis de sistemas de IA. As estruturas de gestão de riscos também podem beneficiar as organizações através do seguinte:

- Melhor tomada de decisão – Ao compreender os riscos associados aos sistemas de IA, as organizações podem tomar melhores decisões sobre como mitigar esses riscos e utilizar os sistemas de IA de forma segura e responsável.

- Maior planejamento de conformidade – Uma estrutura de avaliação de risco pode ajudar as organizações a se prepararem para os requisitos de avaliação de risco em leis e regulamentos relevantes

- Construindo confiança – Ao demonstrar que estão a tomar medidas para mitigar os riscos dos sistemas de IA, as organizações podem mostrar aos seus clientes e partes interessadas que estão empenhadas em utilizar a IA de uma forma segura e responsável.

Como avaliar o risco?

Como primeiro passo, uma organização deve considerar a descrição do caso de utilização de IA que precisa de ser avaliado e identificar todas as partes interessadas relevantes. Um caso de uso é um cenário ou situação específica que descreve como os usuários interagem com um sistema de IA para atingir um objetivo específico. Ao criar uma descrição de caso de uso, pode ser útil especificar o problema de negócios que está sendo resolvido, listar as partes interessadas envolvidas, caracterizar o fluxo de trabalho e fornecer detalhes sobre as principais entradas e saídas do sistema.

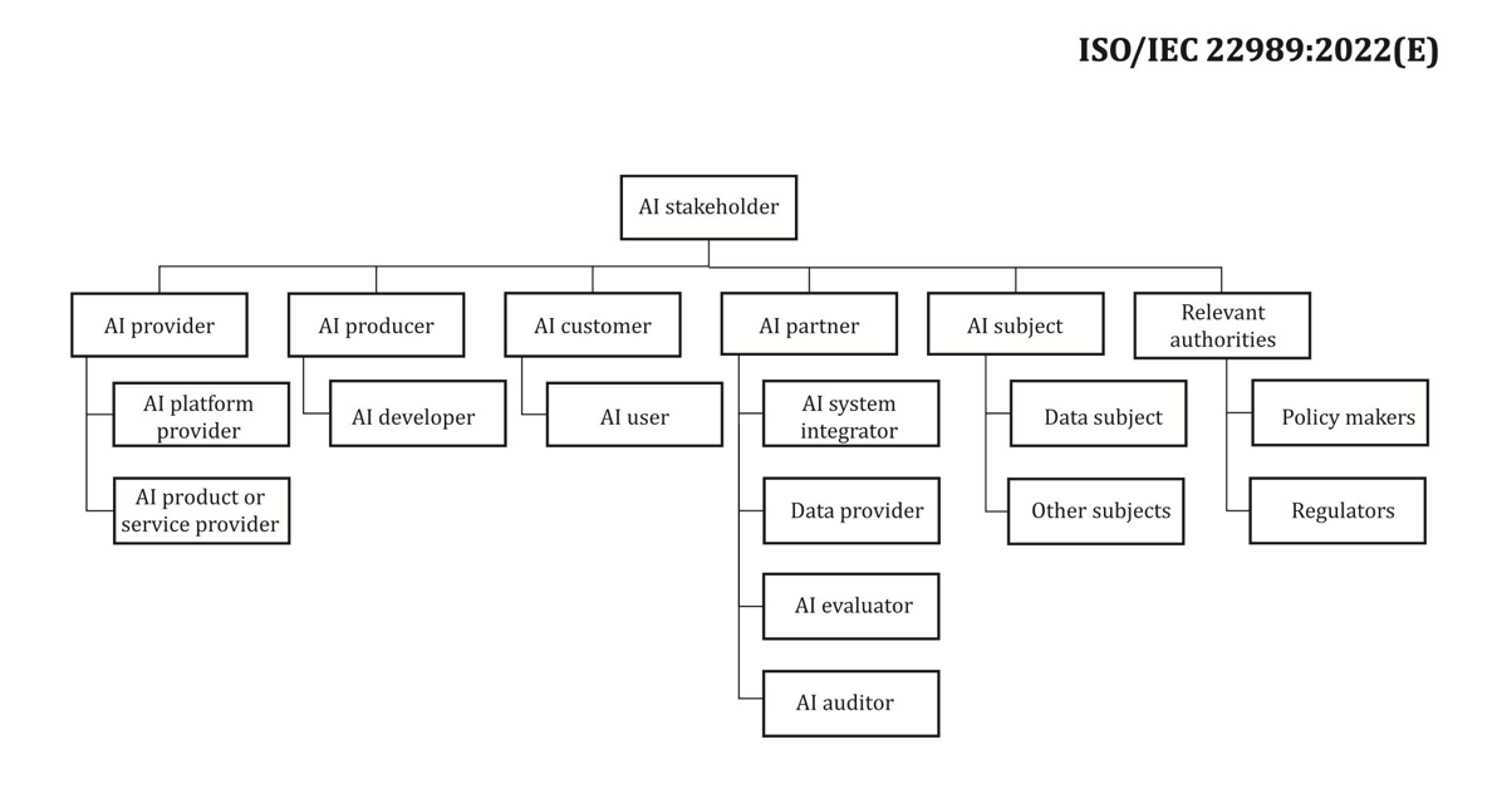

Quando se trata de partes interessadas, é fácil ignorar algumas. A figura a seguir é um bom ponto de partida para mapear as funções das partes interessadas na IA.

Fonte: “Tecnologia da informação – Inteligência artificial – Conceitos e terminologia de inteligência artificial”.

Um próximo passo importante da avaliação de risco do sistema de IA é identificar eventos potencialmente prejudiciais associados ao caso de uso. Ao considerar estes eventos, pode ser útil refletir sobre as diferentes dimensões da IA responsável, como a justiça e a robustez, por exemplo. Diferentes partes interessadas podem ser afetadas em diferentes graus e em diferentes dimensões. Por exemplo, um baixo risco de robustez para um utilizador final pode ser o resultado de um sistema de IA apresentar pequenas perturbações, enquanto um baixo risco de equidade pode ser causado por um sistema de IA que produz resultados negligenciavelmente diferentes para diferentes grupos demográficos.

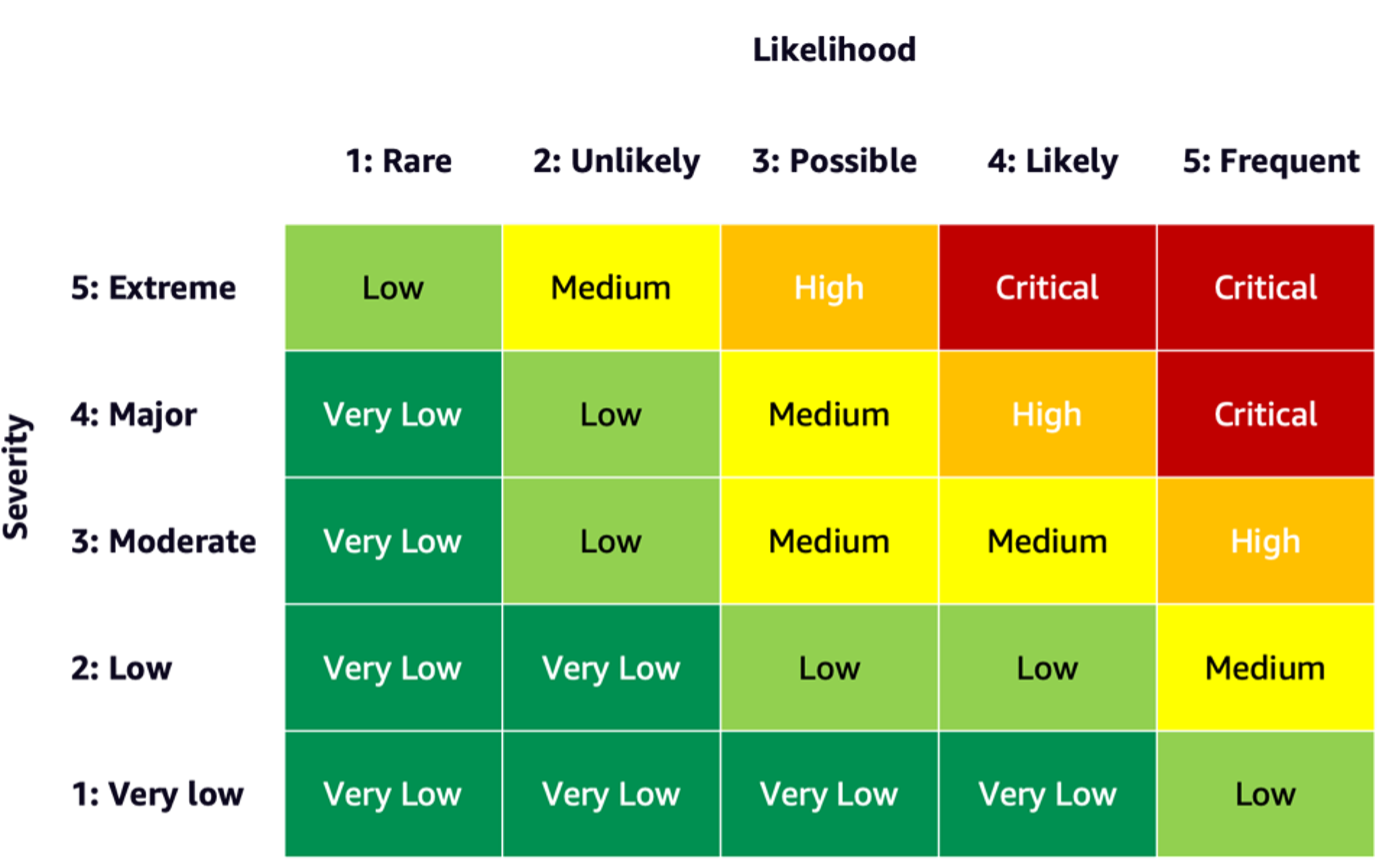

Para estimar o risco de um evento, você pode usar uma escala de probabilidade em combinação com uma escala de gravidade para medir a probabilidade de ocorrência, bem como o grau de consequências. Um ponto de partida útil ao desenvolver essas escalas pode ser o NIST RMF, que sugere o uso de categorias qualitativas não numéricas que variam de risco muito baixo a muito alto ou princípios de avaliação semiquantitativos, como escalas (como 1–10), caixas ou outros números representativos. Depois de definir as escalas de probabilidade e gravidade para todas as dimensões relevantes, você poderá usar um esquema de matriz de risco para quantificar o risco geral por partes interessadas ao longo de cada dimensão relevante. A figura a seguir mostra um exemplo de matriz de risco.

Usando esta matriz de risco, podemos considerar um evento com baixa gravidade e rara probabilidade de ocorrência como risco muito baixo. Tenha em mente que a avaliação inicial será uma estimativa do risco inerente e que as estratégias de mitigação de riscos podem ajudar a reduzir ainda mais os níveis de risco. O processo pode então ser repetido para gerar uma classificação para qualquer risco residual restante por evento. Se existirem vários eventos identificados na mesma dimensão, pode ser útil escolher o nível de risco mais elevado entre todos para criar um resumo da avaliação final.

Utilizando o resumo da avaliação final, as organizações terão de definir quais os níveis de risco aceitáveis para os seus sistemas de IA, bem como considerar regulamentos e políticas relevantes.

Compromisso da AWS

Através de compromissos com o a Casa Branca e UN, entre outros, estamos empenhados em partilhar o nosso conhecimento e experiência para promover a utilização responsável e segura da IA. Nessa linha, Adam Selipsky da Amazon representou recentemente a AWS no Cúpula de Segurança de IA com a presença de chefes de estado e líderes da indústria, demonstrando ainda mais nossa dedicação em colaborar no avanço responsável da inteligência artificial.

Conclusão

À medida que a IA continua a avançar, a avaliação de riscos torna-se cada vez mais importante e útil para as organizações que procuram construir e implementar IA de forma responsável. Ao estabelecer uma estrutura de avaliação de riscos e um plano de mitigação de riscos, as organizações podem reduzir o risco de possíveis incidentes relacionados à IA e ganhar a confiança de seus clientes, bem como colher benefícios como maior confiabilidade, maior justiça para diferentes grupos demográficos e muito mais.

Vá em frente e comece sua jornada de desenvolvimento de uma estrutura de avaliação de risco em sua organização e compartilhe suas ideias nos comentários.

Confira também uma visão geral dos riscos de IA generativa publicada na Amazon Science: IA responsável na era generativae explore a variedade de serviços da AWS que podem oferecer suporte em sua jornada de avaliação e mitigação de riscos: Esclarecimento do Amazon SageMaker, Monitor de modelo do Amazon SageMaker, AWS CloudTrail, Bem como o quadro de governança modelo.

Sobre os autores

Mia C. Mayer é cientista aplicado e educador de ML na AWS Machine Learning University; onde ela pesquisa e ensina segurança, explicabilidade e justiça de sistemas de aprendizado de máquina e IA. Ao longo de sua carreira, Mia estabeleceu vários programas de extensão universitária, atuou como palestrante convidada e palestrante principal e apresentou-se em inúmeras conferências de aprendizagem de grande porte. Ela também ajuda equipes internas e clientes da AWS a iniciar sua jornada de IA responsável.

Mia C. Mayer é cientista aplicado e educador de ML na AWS Machine Learning University; onde ela pesquisa e ensina segurança, explicabilidade e justiça de sistemas de aprendizado de máquina e IA. Ao longo de sua carreira, Mia estabeleceu vários programas de extensão universitária, atuou como palestrante convidada e palestrante principal e apresentou-se em inúmeras conferências de aprendizagem de grande porte. Ela também ajuda equipes internas e clientes da AWS a iniciar sua jornada de IA responsável.

Denis V. Batalov é um veterano de 17 anos da Amazon e PhD em Machine Learning, Denis trabalhou em projetos interessantes como Search Inside the Book, Amazon Mobile apps e Kindle Direct Publishing. Desde 2013, ele ajuda os clientes da AWS a adotar a tecnologia AI/ML como Arquiteto de Soluções. Atualmente, Denis é um líder de tecnologia mundial para IA/ML responsável pelo funcionamento dos arquitetos de soluções especialistas em AWS ML globalmente. Denis é um orador público frequente, você pode segui-lo no Twitter @dbatalov.

Denis V. Batalov é um veterano de 17 anos da Amazon e PhD em Machine Learning, Denis trabalhou em projetos interessantes como Search Inside the Book, Amazon Mobile apps e Kindle Direct Publishing. Desde 2013, ele ajuda os clientes da AWS a adotar a tecnologia AI/ML como Arquiteto de Soluções. Atualmente, Denis é um líder de tecnologia mundial para IA/ML responsável pelo funcionamento dos arquitetos de soluções especialistas em AWS ML globalmente. Denis é um orador público frequente, você pode segui-lo no Twitter @dbatalov.

Dra. Sara Liu é gerente sênior de programa técnico da equipe de IA responsável da AWS. Ela trabalha com uma equipe de cientistas, líderes de conjuntos de dados, engenheiros de ML, pesquisadores, bem como outras equipes multifuncionais para elevar o nível de IA responsável nos serviços de IA da AWS. Seus projetos atuais envolvem o desenvolvimento de cartões de serviço de IA, a realização de avaliações de risco para IA responsável, a criação de conjuntos de dados de avaliação de alta qualidade e a implementação de programas de qualidade. Ela também ajuda equipes internas e clientes a atender aos padrões em evolução da indústria de IA.

Dra. Sara Liu é gerente sênior de programa técnico da equipe de IA responsável da AWS. Ela trabalha com uma equipe de cientistas, líderes de conjuntos de dados, engenheiros de ML, pesquisadores, bem como outras equipes multifuncionais para elevar o nível de IA responsável nos serviços de IA da AWS. Seus projetos atuais envolvem o desenvolvimento de cartões de serviço de IA, a realização de avaliações de risco para IA responsável, a criação de conjuntos de dados de avaliação de alta qualidade e a implementação de programas de qualidade. Ela também ajuda equipes internas e clientes a atender aos padrões em evolução da indústria de IA.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/learn-how-to-assess-risk-of-ai-systems/

- :tem

- :é

- :não

- :onde

- 100

- 118

- 150

- 2013

- 2023

- 33

- 7

- a

- Sobre

- acelerado

- acelerando

- aceitável

- Segundo

- Alcançar

- em

- atividade

- Adam

- endereço

- adotar

- Adoção

- avançar

- avanço

- afetado

- Depois de

- à frente

- AI

- riscos de IA

- Serviços de IA

- Sistemas de IA

- AI / ML

- alinhado

- Todos os Produtos

- juntamente

- tb

- Amazon

- Amazon Web Services

- entre

- quantidade

- an

- e

- qualquer

- Aplicação

- aplicado

- Aplicativos

- arquitetos

- SOMOS

- artificial

- inteligência artificial

- AS

- aspectos

- avaliar

- avaliado

- Avaliando

- avaliação

- avaliações

- associado

- At

- comparecimento

- disponível

- AWS

- Aprendizado de máquina da AWS

- Barra

- barreiras

- baseado

- BE

- tornam-se

- tornando-se

- ser

- beneficiar

- Benefícios

- Melhor

- caixas

- livro

- amplo

- construir

- negócio

- mas a

- by

- CAN

- capacidades

- capaz

- capturas

- Cartões

- Cuidado

- Oportunidades

- cuidadosamente

- casas

- Categorias

- causado

- certo

- alterar

- caracterizar

- verificar

- Clima

- Das Alterações Climáticas

- colaborando

- combinação

- vem

- comentários

- comprometido

- completar

- compliance

- componente

- conceitos

- condutor

- conferências

- Consequências

- Consequentemente

- Considerar

- considerado

- considerando

- conteúdo

- Criação de conteúdo

- contexto

- continua

- controles

- núcleo

- Correspondente

- poderia

- crio

- Criar

- criação

- criatividade

- equipes multifuncionais

- Atual

- Atualmente

- Clientes

- conjuntos de dados

- decisões

- dedicação

- definir

- definido

- Grau

- demográfico

- Demografia

- demonstrando

- implantar

- desenvolvimento

- descrevendo

- descrição

- Design

- projetado

- detalhes

- em desenvolvimento

- Desenvolvimento

- diferente

- Dimensão

- dimensões

- diretamente

- discutir

- interrupções

- dinâmico

- cada

- ganhar

- mais fácil

- fácil

- efeito

- esforços

- emergente

- permitir

- engloba

- animador

- compromissos

- Engenharia

- Engenheiros

- aprimorada

- assegurando

- Empreendimento

- estabelecido

- estabelecendo

- estimativa

- estimado

- avaliadas

- avaliação

- Evento

- eventos

- evolução

- exemplo

- emocionante

- Exposição

- exposições

- experiência

- explorar

- Rosto

- fato

- factoring

- justiça

- campo

- Figura

- final

- financeiro

- Primeiro nome

- Foco

- concentra-se

- seguir

- seguinte

- Escolha

- principal

- Foundation

- Quadro

- enquadramentos

- freqüente

- da

- cheio

- funcionamento

- mais distante

- gerar

- generativo

- IA generativa

- ter

- Globalmente

- meta

- Bom estado, com sinais de uso

- governo

- Do grupo

- Locatário

- prejudicar

- prejudicial

- Ter

- he

- cabeças

- ajudar

- ajudou

- útil

- ajuda

- sua experiência

- Alta

- alta qualidade

- mais

- altamente

- ele

- Como funciona o dobrador de carta de canal

- Como Negociar

- Contudo

- HTML

- HTTPS

- identificado

- identificar

- if

- Impacto

- Impacto

- implementação

- implementação

- importante

- melhorar

- melhorado

- in

- incluído

- Incluindo

- cada vez mais

- Individual

- indústria

- padrões da indústria

- influência

- inerente

- do estado inicial,

- inovadores

- inputs

- dentro

- Inteligência

- interagir

- interno

- envolver

- envolvido

- ISO

- isolamento

- IT

- se

- viagem

- jpg

- Guarda

- Chave

- Principal

- Orador principal

- Conhecimento

- língua

- grande

- lançado

- Leis

- líder

- líderes

- Leads

- APRENDER

- aprendizagem

- Legislação

- Nível

- níveis

- probabilidade

- Provável

- linhas

- Lista

- procurando

- Baixo

- diminuir

- máquina

- aprendizado de máquina

- moldadas

- fazer

- gerencia

- de grupos

- Gerente

- muitos

- mapa,

- Matriz

- Maximizar

- Posso..

- a medida

- medidas

- mecanismos

- Conheça

- poder

- mente

- menor

- Mitigar

- mitigação

- ML

- Móvel Esteira

- aplicativos móveis

- modelo

- modelos

- mais

- múltiplo

- nomeadamente

- Cria

- negativo

- nunca

- Próximo

- nist

- normas

- nota

- números

- numeroso

- objetivos

- ocorrência

- ocorrendo

- of

- on

- operação

- operacional

- oportunidades

- or

- organização

- organizações

- Outros

- Outros

- de outra forma

- A Nossa

- Fora

- outputs

- alcance

- global

- Visão geral

- Paz

- parte

- particular

- caminho

- para

- percebido

- Personalizado

- perspectivas

- phd

- escolher

- plano

- platão

- Inteligência de Dados Platão

- PlatãoData

- ponto

- políticas

- positivo

- Publique

- potencial

- potencialmente

- poderoso

- Preparar

- apresentado

- principalmente

- princípios

- Proactive

- Problema

- processo

- produtor

- Produto

- Agenda

- Programas

- projetos

- Promoção

- fornecer

- fornecendo

- público

- publicado

- Publishing

- qualitativo

- qualidade

- aumentar

- alcance

- variando

- rapidamente

- RARO

- classificação

- perceber

- colher

- recentemente

- reduzir

- refletir

- em relação a

- regulamentos

- relevante

- confiabilidade

- remanescente

- repetido

- representante

- representado

- representa

- Requisitos

- exige

- pesquisadores

- pesquisas

- responsável

- com responsabilidade

- resultar

- resultando

- Risco

- avaliação de risco

- gestão de risco

- riscos

- robustez

- papéis

- seguro

- Segurança

- sábio

- vendas

- mesmo

- Escala

- Escalas

- cenário

- esquema

- Ciência

- científico

- Cientista

- cientistas

- Pesquisar

- seguro

- segurança

- senior

- sentido

- serviço

- Serviços

- vários

- Partilhar

- compartilhando

- ela

- rede de apoio social

- mostrar

- Shows

- desde

- situação

- Redes Sociais

- Sociedade

- Soluções

- alguns

- Palestrantes

- especialista

- específico

- especificamente

- Espectro

- partes interessadas

- partes interessadas

- padrões

- começo

- começado

- Comece

- Estado

- Passo

- Passos

- Estratégico

- estratégias

- tal

- Sugere

- RESUMO

- ajuda

- .

- sistemas

- tomar

- Profissionais

- equipes

- tecnologia

- Dados Técnicos:

- Tecnologias

- Tecnologia

- que

- A

- o mundo

- deles

- então

- Lá.

- Este

- deles

- isto

- aqueles

- Através da

- todo

- Cronometrado

- para

- juntos

- Transformar

- Confiança

- dois

- típico

- incertezas

- Incerteza

- compreensão

- universidade

- Desbloqueio

- usar

- caso de uso

- usuários

- utilização

- muito

- veterano

- vulnerabilidades

- we

- web

- serviços web

- BEM

- O Quê

- quando

- enquanto que

- qual

- enquanto

- precisarão

- de

- dentro

- trabalhou

- de gestão de documentos

- trabalhar

- trabalho

- mundo

- no mundo todo

- Vocês

- investimentos

- zefirnet