À medida que mais organizações adotam tecnologias generativas de IA – para elaborar propostas, preencher solicitações de subsídios e redigir código clichê — as equipes de segurança estão percebendo a necessidade de abordar uma nova questão: como proteger as ferramentas de IA?

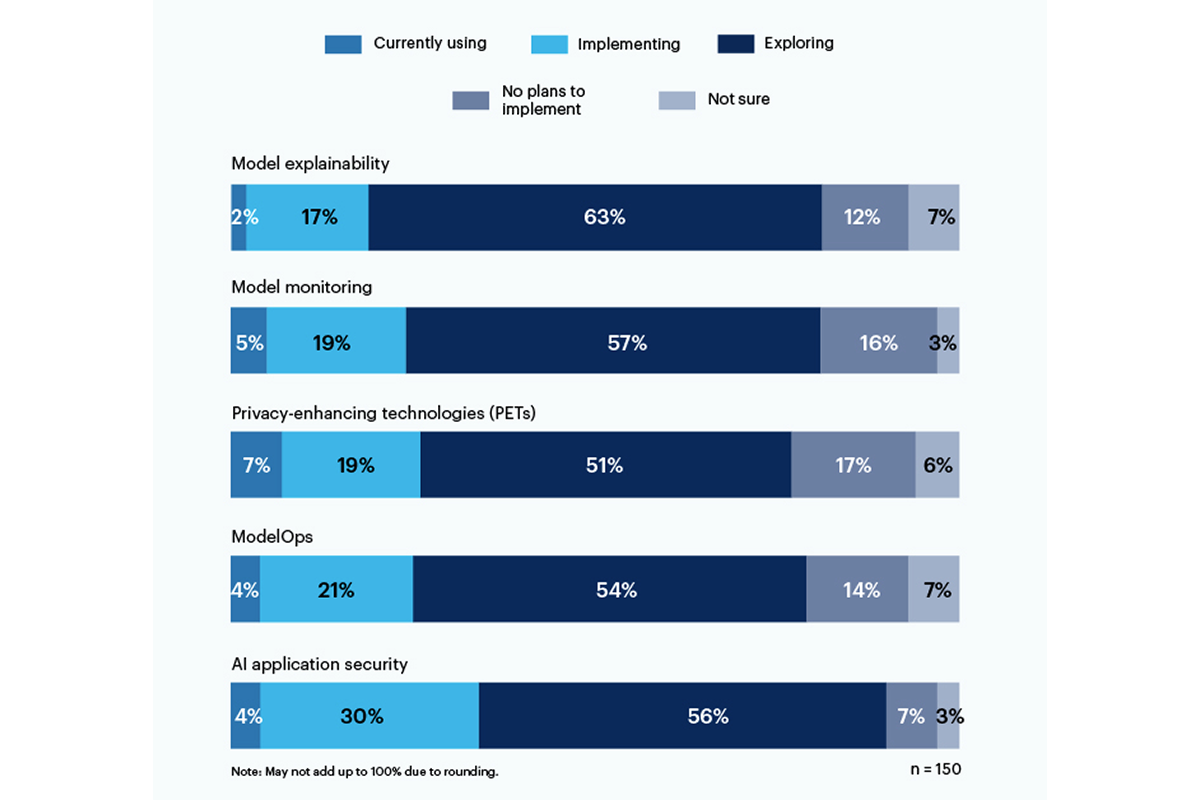

Um terço dos entrevistados em uma pesquisa recente do Gartner relatou usando ou implementando ferramentas de segurança de aplicativos baseadas em IA para enfrentar os riscos decorrentes do uso de IA generativa em sua organização.

As tecnologias de melhoria da privacidade (PETs) apresentaram a maior utilização atual, com 7% dos entrevistados, com sólidos 19% das empresas a implementá-las; esta categoria inclui formas de proteger dados pessoais, como criptografia homomórfica, Dados sintéticos gerados por IA, computação multipartidária segura, aprendizagem federada e privacidade diferencial. No entanto, 17% não têm planos para introduzir PET no seu ambiente.

Apenas 19% estão a utilizar ou a implementar ferramentas para a explicabilidade do modelo, mas há um interesse significativo (56%) entre os inquiridos em explorar e compreender estas ferramentas para abordar o risco generativo da IA. Explicabilidade, monitoramento de modelos e ferramentas de segurança de aplicativos de IA podem ser usadas em modelos de código aberto ou proprietários para alcançar a confiabilidade e a confiabilidade que os usuários corporativos precisam, de acordo com o Gartner.

Os riscos que mais preocupam os entrevistados incluem resultados incorretos ou tendenciosos (58%) e vulnerabilidades ou segredos vazados em códigos gerados por IA (57%). Significativamente, 43% citaram possíveis problemas de direitos autorais ou licenciamento decorrentes de conteúdo gerado por IA como os principais riscos para suas organizações.

“Ainda não há transparência sobre os modelos de dados em que estão sendo treinados, então o risco associado ao preconceito e à privacidade é muito difícil de entender e estimar”, escreveu um executivo de alto escalão em resposta à pesquisa do Gartner.

Em junho, o Instituto Nacional de Padrões e Tecnologia (NIST) lançou um grupo de trabalho público para ajudar a resolver essa questão, com base na sua Estrutura de Gestão de Riscos de IA de janeiro. Como mostram os dados do Gartner, as empresas não estão esperando para as diretivas do NIST.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.darkreading.com/tech-talks/companies-rely-multiple-methods-secure-generative-ai

- :é

- :não

- 7

- a

- Sobre

- Segundo

- Alcançar

- endereço

- adotar

- AI

- Todos os Produtos

- entre

- e

- Aplicação

- segurança da aplicação

- aplicações

- SOMOS

- AS

- associado

- At

- baseado

- BE

- viés

- tendencioso

- mas a

- by

- C-suite

- CAN

- Categoria

- citado

- código

- Empresas

- completar

- preocupado

- conteúdo

- direitos autorais

- artesanato

- Atual

- dados,

- difícil

- directivas

- do

- ou

- Empreendimento

- Meio Ambiente

- estimativa

- executivo

- Explorando

- Escolha

- Quadro

- da

- Gartner

- generativo

- IA generativa

- conceder

- maior

- Ter

- ajudar

- Como funciona o dobrador de carta de canal

- Contudo

- HTTPS

- implementação

- in

- incluir

- inclui

- Instituto

- interesse

- questões

- IT

- ESTÁ

- janeiro

- Junho

- lançado

- Licenciamento

- de grupos

- métodos

- modelo

- modelos

- monitoração

- mais

- a maioria

- múltiplo

- Nacional

- você merece...

- Novo

- nist

- não

- of

- on

- aberto

- open source

- or

- organização

- organizações

- pessoal

- dados pessoais

- Animais

- arremessos

- planos

- platão

- Inteligência de Dados Platão

- PlatãoData

- colocada

- potencial

- política de privacidade

- proprietário

- proteger

- público

- questão

- percebendo

- recentemente

- confiabilidade

- depender

- Informou

- respondentes

- resposta

- Risco

- gestão de risco

- riscos

- segredos!

- seguro

- segurança

- mostrou

- Shows

- periodo

- de forma considerável

- So

- sólido

- fonte

- padrões

- Ainda

- tal

- Vistorias

- sintético

- equipes

- Tecnologias

- Tecnologia

- que

- A

- deles

- Lá.

- Este

- isto

- para

- ferramentas

- topo

- Training

- Transparência

- fidedignidade

- compreender

- compreensão

- usar

- usava

- usuários

- utilização

- muito

- vulnerabilidades

- maneiras

- de

- trabalhar

- escrever

- escreveu

- Vocês

- zefirnet