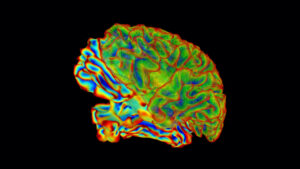

A linguagem e a fala são como expressamos nossos pensamentos internos. Mas os neurocientistas simplesmente ignoraram a necessidade de fala audível, pelo menos no laboratório. Em vez disso, eles acessaram diretamente a máquina biológica que gera linguagem e ideias: o cérebro.

Usando varreduras cerebrais e uma grande dose de aprendizado de máquina, uma equipe da Universidade do Texas em Austin desenvolveu um “decodificador de linguagem” que captura a essência do que uma pessoa ouve com base apenas em seus padrões de ativação cerebral. Longe de ser um pônei de um truque, o decodificador também pode traduzir a fala imaginada e até mesmo gerar legendas descritivas para filmes mudos usando atividade neural.

Aqui está o kicker: o método não requer cirurgia. Em vez de contar com eletrodos implantados, que escutam rajadas elétricas diretamente dos neurônios, a neurotecnologia usa ressonância magnética funcional (fMRI), um procedimento totalmente não invasivo, para gerar mapas cerebrais que correspondem à linguagem.

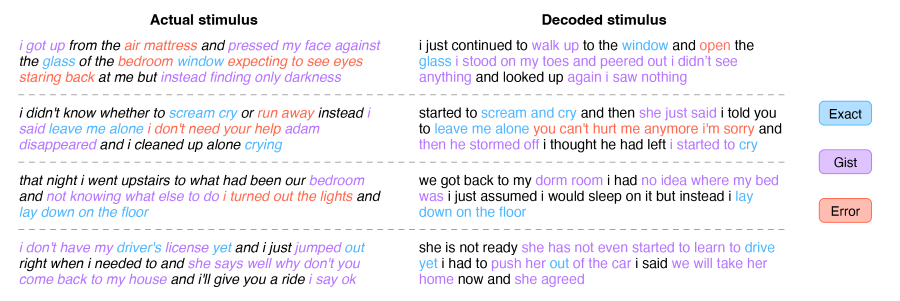

Para ser claro, a tecnologia não é leitura de mentes. Em cada caso, o decodificador produz paráfrases que captam a ideia geral de uma frase ou parágrafo. Não reproduz todas as palavras. No entanto, esse também é o poder do decodificador.

“Achamos que o decodificador representa algo mais profundo do que idiomas”, disse o principal autor do estudo, Dr. Alexander Huth, em uma coletiva de imprensa. “Podemos recuperar a ideia geral… e ver como a ideia evolui, mesmo que as palavras exatas se percam.”

O estudo, publicado esta semana em Nature Neuroscience, representa um poderoso primeiro impulso para métodos não invasivos interfaces cérebro-máquina para decodificar a linguagem - um problema notoriamente difícil. Com mais desenvolvimento, a tecnologia pode ajudar aqueles que perderam a capacidade de falar a recuperar a capacidade de se comunicar com o mundo exterior.

O trabalho também abre novos caminhos para aprender sobre como a linguagem é codificada no cérebro e para os cientistas de IA cavarem a “caixa preta” dos modelos de aprendizado de máquina que processam a fala e a linguagem.

“Demorou muito para chegar… ficamos meio chocados com o fato de ter funcionado tão bem”, disse Huth.

Linguagem de Decodificação

Traduzir a atividade cerebral para a fala não é novidade. Um estudo anterior usaram eletrodos colocados diretamente no cérebro de pacientes com paralisia. Ao ouvir a vibração elétrica dos neurônios, a equipe foi capaz de reconstruir palavras completas do paciente.

Huth decidiu seguir uma rota alternativa, embora ousada. Em vez de confiar na neurocirurgia, ele optou por uma abordagem não invasiva: fMRI.

“A expectativa entre os neurocientistas em geral de que você pode fazer esse tipo de coisa com fMRI é muito baixa”, disse Huth.

Há muitas razões. Ao contrário dos implantes que acessam diretamente a atividade neural, o fMRI mede como os níveis de oxigênio no sangue mudam. Isso é chamado de sinal BOLD. Como as regiões cerebrais mais ativas requerem mais oxigênio, as respostas BOLD atuam como um proxy confiável para a atividade neural. Mas vem com problemas. Os sinais são lentos em comparação com a medição de rajadas elétricas e os sinais podem ser ruidosos.

No entanto, o fMRI tem uma vantagem enorme em comparação com os implantes cerebrais: ele pode monitorar todo o cérebro em alta resolução. Comparado à coleta de dados de uma pepita em uma região, ele fornece uma visão panorâmica das funções cognitivas de nível superior – incluindo a linguagem.

Com a decodificação da linguagem, a maioria dos estudos anteriores abordou o córtex motor, uma área que controla como a boca e a laringe se movem para gerar a fala, ou mais “nível de superfície” no processamento da linguagem para articulação. A equipe de Huth decidiu subir uma abstração: no reino dos pensamentos e ideias.

No desconhecido

A equipe percebeu que precisava de duas coisas desde o início. Um, um conjunto de dados de varreduras cerebrais de alta qualidade para treinar o decodificador. Dois, uma estrutura de aprendizado de máquina para processar os dados.

Para gerar o banco de dados do mapa cerebral, sete voluntários tiveram seus cérebros escaneados repetidamente enquanto ouviam histórias de podcast enquanto tinham sua atividade neural medida dentro de uma máquina de ressonância magnética. Deitar dentro de um ímã gigante e barulhento não é divertido para ninguém, e a equipe teve o cuidado de manter os voluntários interessados e alertas, já que a atenção influencia na decodificação.

Para cada pessoa, o enorme conjunto de dados subsequente foi inserido em uma estrutura alimentada por aprendizado de máquina. Graças à recente explosão de modelos de aprendizado de máquina que ajudam a processar a linguagem natural, a equipe conseguiu aproveitar esses recursos e construir prontamente o decodificador.

Tem vários componentes. O primeiro é um modelo de codificação usando o GPT original, o antecessor do popular ChatGPT. O modelo pega cada palavra e prevê como o cérebro responderá. Aqui, a equipe ajustou o GPT usando mais de 200 milhões de palavras no total de comentários e podcasts do Reddit.

Esta segunda parte usa uma técnica popular em aprendizado de máquina chamada decodificação bayesiana. O algoritmo adivinha a próxima palavra com base em uma sequência anterior e usa a palavra adivinhada para verificar a resposta real do cérebro.

Por exemplo, um episódio de podcast tinha “meu pai não precisa disso…” como enredo. Quando alimentado no decodificador como um prompt, ele vinha com respostas em potencial: “muito”, “certo”, “desde” e assim por diante. A comparação da atividade cerebral prevista com cada palavra com a gerada a partir da palavra real ajudou o decodificador a aprimorar os padrões de atividade cerebral de cada pessoa e corrigir os erros.

Depois de repetir o processo com as melhores palavras previstas, o aspecto de decodificação do programa finalmente aprendeu a “impressão digital neural” única de cada pessoa para como ela processa a linguagem.

Um tradutor neuro

Como prova de conceito, a equipe comparou as respostas decodificadas com o texto real da história.

Chegou surpreendentemente perto, mas apenas para a essência geral. Por exemplo, um enredo, “começamos a trocar histórias sobre nossas vidas, nós dois somos do norte”, foi decodificado como “começamos a conversar sobre nossas experiências na área em que ele nasceu, eu era do norte”.

Essa paráfrase é esperada, explicou Huth. Como o fMRI é bastante barulhento e lento, é quase impossível capturar e decodificar cada palavra. O decodificador é alimentado com uma mistura de palavras e precisa desemaranhar seus significados usando recursos como voltas de frase.

Em contraste, as ideias são mais permanentes e mudam de forma relativamente lenta. Como a fMRI tem um atraso ao medir a atividade neural, ela captura conceitos e pensamentos abstratos melhor do que palavras específicas.

Essa abordagem de alto nível tem vantagens. Embora falte fidelidade, o decodificador captura um nível mais alto de representação de linguagem do que as tentativas anteriores, inclusive para tarefas não limitadas apenas à fala. Em um teste, os voluntários assistiram a um clipe animado de uma garota sendo atacada por dragões sem nenhum som. Usando apenas a atividade cerebral, o decodificador descreveu a cena da perspectiva do protagonista como uma história baseada em texto. Em outras palavras, o decodificador foi capaz de traduzir informações visuais diretamente em uma narrativa baseada em uma representação da linguagem codificada na atividade cerebral.

Da mesma forma, o decodificador também reconstruiu histórias imaginadas de um minuto dos voluntários.

Depois de mais de uma década trabalhando na tecnologia, “foi chocante e emocionante quando finalmente funcionou”, disse Huth.

Embora o decodificador não leia exatamente mentes, a equipe teve o cuidado de avaliar a privacidade mental. Em uma série de testes, eles descobriram que o decodificador só funcionava com a participação mental ativa dos voluntários. Pedir aos participantes para contar até sete, nomear animais diferentes ou construir mentalmente suas próprias histórias rapidamente degradou o decodificador, disse o primeiro autor Jerry Tang. Em outras palavras, o decodificador pode ser "resistido conscientemente".

Por enquanto, a tecnologia só funciona depois de meses de exames cuidadosos do cérebro em uma máquina com um zumbido alto, enquanto você está completamente imóvel – dificilmente viável para uso clínico. A equipe está trabalhando na tradução da tecnologia para fNIRS (espectroscopia funcional no infravermelho próximo), que mede os níveis de oxigênio no sangue no cérebro. Embora tenha uma resolução mais baixa que a fMRI, o fNIRS é muito mais portátil, pois o hardware principal é um dispositivo semelhante a uma touca de natação que cabe facilmente sob um moletom com capuz.

“Com ajustes, deveremos ser capazes de traduzir a configuração atual para o fNIRS no atacado”, disse Huth.

A equipe também planeja usar modelos de linguagem mais recentes para aumentar a precisão do decodificador e, potencialmente, unir diferentes idiomas. Como as línguas têm uma representação neural compartilhada no cérebro, o decodificador poderia, em teoria, codificar uma língua e usar os sinais neurais para decodificá-la em outra.

É uma “emocionante direção futura”, disse Huth.

Crédito de imagem: Jerry Tang/Martha Morales/Universidade do Texas em Austin

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoAiStream. Inteligência de Dados Web3. Conhecimento Amplificado. Acesse aqui.

- Cunhando o Futuro com Adryenn Ashley. Acesse aqui.

- Fonte: https://singularityhub.com/2023/05/02/this-brain-activity-decoder-translates-ideas-into-text-using-only-scans/

- :tem

- :é

- :não

- $UP

- 200

- a

- habilidade

- Capaz

- Sobre

- RESUMO

- abstração

- precisão

- Aja

- ativação

- ativo

- atividade

- Depois de

- contra

- AI

- Alertar

- Alexander

- algoritmo

- sozinho

- tb

- alternativa

- Apesar

- entre

- an

- e

- animais

- Outro

- qualquer

- qualquer um

- abordagem

- SOMOS

- ÁREA

- AS

- aspecto

- At

- Tentativas

- por WhatsApp.

- austin

- autor

- baseado

- Bayesiano

- BE

- Porque

- ser

- MELHOR

- Melhor

- sangue

- pino

- impulsionar

- nascido

- ambos

- Cérebro

- Atividade cerebral

- PONTE

- Briefing

- construir

- mas a

- by

- chamado

- veio

- CAN

- capturar

- capturas

- Cuidado

- cuidadoso

- casas

- alterar

- ChatGPT

- verificar

- remover filtragem

- Clínico

- Fechar

- cognitivo

- vem

- comentários

- comunicar

- comparado

- comparando

- completamente

- componentes

- conceito

- conceitos

- construir

- contraste

- controles

- correta

- poderia

- crédito

- Atual

- Pai

- dados,

- banco de dados

- década

- decidido

- decodificação

- mais profunda

- descrito

- desenvolvido

- Desenvolvimento

- dispositivo

- DID

- diferente

- difícil

- DIG

- direção

- diretamente

- do

- parece

- Não faz

- cada

- facilmente

- Todo

- episódio

- Mesmo

- eventualmente

- Cada

- evolui

- exatamente

- exemplo

- emocionante

- expectativa

- esperado

- Experiências

- explicado

- explosão

- expresso

- fatores

- longe

- factível

- Funcionalidades

- Alimentado

- fidelidade

- Finalmente

- Primeiro nome

- Escolha

- encontrado

- Quadro

- da

- cheio

- Diversão

- funcional

- mais distante

- desenvolvimento adicional

- futuro

- coleta

- Geral

- gerar

- gerado

- gera

- ter

- gigante

- Menina

- Go

- adivinhou

- tinha

- Hardware

- arreios

- Ter

- ter

- he

- ajudar

- ajudou

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- Alta

- de alto nível

- alta qualidade

- superior

- Como funciona o dobrador de carta de canal

- HTTPS

- i

- idéia

- idéias

- if

- Imagiologia

- impossível

- in

- Em outra

- Incluindo

- INFORMAÇÕES

- em vez disso

- interessado

- para dentro

- IT

- apenas por

- Guarda

- Tipo

- laboratório

- língua

- Idiomas

- conduzir

- aprendido

- aprendizagem

- mínimo

- Nível

- níveis

- como

- Limitado

- Line

- Escuta

- Vidas

- longo

- muito tempo

- perdido

- Baixo

- diminuir

- máquina

- aprendizado de máquina

- a Principal

- mapa,

- mapas

- maciço

- massivamente

- max-width

- significados

- medidas

- medição

- mental

- método

- milhão

- mente

- mentes

- erros

- modelo

- modelos

- Monitore

- mês

- mais

- a maioria

- Motor

- boca

- mover

- Filmes

- MRI

- múltiplo

- nome

- NARRATIVA

- natural

- Natureza

- quase

- você merece...

- necessário

- Cria

- Neurônios

- neurocirurgia

- Novo

- Próximo

- Norte

- agora

- of

- on

- ONE

- só

- começo

- abre

- or

- ordem

- original

- Outros

- A Nossa

- lado de fora

- Acima de

- global

- próprio

- Oxygen

- parte

- participantes

- participação

- paciente

- pacientes

- padrões

- regalias

- permanente

- pessoa

- perspectiva

- sem caroço

- planejamento

- platão

- Inteligência de Dados Platão

- PlatãoData

- Abundância

- Podcast

- Podcasts

- Popular

- potencial

- potencialmente

- poder

- alimentado

- poderoso

- antecessor

- previsto

- Previsões

- imprensa

- bastante

- anterior

- política de privacidade

- Problema

- problemas

- processo

- em processamento

- Agenda

- prova

- prova de conceito

- fornece

- procuração

- publicado

- Empurrar

- rapidamente

- em vez

- Leia

- Leitura

- realizado

- reino

- razões

- recentemente

- Recuperar

- recuperar

- região

- regiões

- relativamente

- confiável

- REPETIDAMENTE

- representação

- representa

- requerer

- Resolução

- ressonância

- Recursos

- Responder

- resposta

- respostas

- Rota

- Dito

- cena

- cientistas

- Segundo

- Vejo

- sentença

- Seqüência

- Série

- instalação

- Sete

- compartilhado

- chocado

- rede de apoio social

- Signal

- sinais

- desde

- solteiro

- Lentamente

- lento

- So

- algo

- Parecer

- falar

- específico

- Espectroscopia

- discurso

- começo

- começado

- estímulo

- Histórias

- História

- caso

- Estudo

- legendas

- Cirurgia

- Tire

- toma

- falando

- Torneira

- Batido

- tarefas

- Profissionais

- Tecnologia

- teste

- testes

- texas

- do que

- obrigado

- que

- A

- A área

- deles

- deles

- coisa

- coisas

- think

- isto

- esta semana

- aqueles

- tempo

- para

- levou

- Total

- comércio

- Trem

- traduzir

- dois

- para

- único

- universidade

- ao contrário

- usar

- usava

- utilização

- Ver

- voluntários

- vs

- foi

- Assistidos

- we

- semana

- BEM

- foram

- O Quê

- quando

- qual

- enquanto

- QUEM

- atacado

- precisarão

- de

- sem

- Word

- palavras

- Atividades:

- trabalhou

- trabalhar

- trabalho

- mundo

- ainda

- Vocês

- zefirnet