A inteligência artificial está em uma lágrima. As máquinas podem falar, escrever, jogar e gerar imagens, vídeos e músicas originais. Mas, à medida que as capacidades da IA cresceram, seus algoritmos também cresceram.

Há uma década, os algoritmos de aprendizado de máquina dependia de dezenas de milhões de conexões internas, ou parâmetros. Os algoritmos de hoje atingem regularmente centenas de bilhões e mesmo trilhões de parâmetros. Os pesquisadores dizem que a ampliação ainda gera ganhos de desempenho, e modelos com dezenas de trilhões de parâmetros podem chegar em pouco tempo.

Para treinar modelos tão grandes, você precisa de computadores poderosos. Considerando que a IA no início de 2010 era executada em um punhado de unidades de processamento gráfico - chips de computador que se destacam no processamento paralelo crucial para a IA - as necessidades de computação cresceram exponencialmente, e os principais modelos agora exigem centenas ou milhares. OpenAI, Microsoft, Meta, e outros estão construindo supercomputadores dedicados para lidar com a tarefa, e eles dizem que essas máquinas de IA estão entre as mais rápidas do planeta.

Mas mesmo que as GPUs tenham sido cruciais para o dimensionamento da IA - o A100 da Nvidia, por exemplo, ainda é um dos chips mais rápidos e mais usados em clusters de IA - alternativas mais estranhas projetadas especificamente para IA surgiram nos últimos anos.

A Cerebras oferece uma dessas alternativas.

Fazendo uma refeição de IA

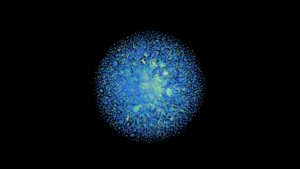

Do tamanho de um prato - cerca de 8.5 polegadas de lado - o Wafer Scale Engine da empresa é o maior chip de silício do mundo, com 2.6 trilhões de transistores e 850,000 núcleos gravados em um único wafer de silício. Cada Wafer Scale Engine serve como o coração do computador CS-2 da empresa.

Sozinho, o CS-2 é fera, mas ano passado Cerebras revelou um plano para conectar CS-2s junto com um sistema de memória externa chamado MemoryX e um sistema para conectar CS-2s chamado SwarmX. A empresa disse que a nova tecnologia pode conectar até 192 chips e treinar modelos duas ordens de grandeza maiores do que os maiores e mais avançados AIs de hoje.

“A indústria está ultrapassando os modelos de 1 trilhão de parâmetros e estamos estendendo esse limite em duas ordens de grandeza, permitindo redes neurais em escala cerebral com 120 trilhões de parâmetros”, disse o CEO e cofundador da Cerebras, Andrew Feldman.

Na época, tudo isso era teórico. Mas na semana passada, o empresa anunciou eles conectaram 16 CS-2s em um supercomputador de IA de classe mundial.

Conheça Andrômeda

A nova máquina, chamada Andromeda, tem 13.5 milhões de núcleos capazes de atingir velocidades superiores a um exaflop (um quintilhão de operações por segundo) com meia precisão de 16 bits. Devido ao chip único em seu núcleo, o Andromeda não é facilmente comparado a supercomputadores rodando em CPUs e GPUs mais tradicionais, mas Feldman disse fio HPC Andromeda é aproximadamente equivalente ao supercomputador Polaris do Argonne National Laboratory, que classifica 17º mais rápido do mundo, de acordo com a lista Top500 mais recente.

Além do desempenho, o rápido tempo de construção, o custo e a pegada do Andromeda são notáveis. Argonne começou a instalar o Polaris no verão de 2021, e o supercomputador foi ao ar cerca de um ano depois. Ele ocupa 40 racks, os compartimentos semelhantes a gabinetes de arquivamento que abrigam componentes de supercomputadores. Em comparação, Andromeda custou US$ 35 milhões - um preço modesto para uma máquina de seu poder - levou apenas três dias para montar, e usa apenas 16 racks.

A Cerebras testou o sistema treinando cinco versões do modelo de linguagem grande GPT-3 da OpenAI, bem como GPT-J e GPT-NeoX de código aberto da Eleuther AI. E, de acordo com o Cerebras, talvez a descoberta mais importante seja que o Andromeda demonstrou o que eles chamam de “escalonamento linear quase perfeito” de cargas de trabalho de IA para grandes modelos de linguagem. Resumindo, isso significa que, à medida que CS-2 adicionais são adicionados, os tempos de treinamento diminuem proporcionalmente.

Normalmente, disse a empresa, à medida que você adiciona mais chips, os ganhos de desempenho diminuem. O chip WSE da Cerebras, por outro lado, pode se mostrar mais eficiente porque seus 850,000 núcleos estão conectados entre si no mesmo pedaço de silício. Além do mais, cada núcleo tem um módulo de memória ao lado. Em conjunto, o chip reduz a quantidade de tempo gasto transferindo dados entre os núcleos e a memória.

“O dimensionamento linear significa que, quando você passa de um para dois sistemas, leva metade do tempo para que seu trabalho seja concluído. Essa é uma propriedade muito incomum na computação”, disse Feldman fio HPC. E, disse ele, pode escalar além de 16 sistemas conectados.

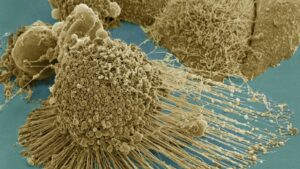

Além dos testes do próprio Cerebras, os resultados do escalonamento linear também foram demonstrados durante o trabalho no Argonne National Laboratory, onde os pesquisadores usaram o Andromeda para treinar o algoritmo de linguagem grande GPT-3-XL em longas sequências do genoma do Covid-19.

É claro que, embora o sistema possa escalar além de 16 CS-2s, até que ponto a escala linear persiste ainda precisa ser vista. Além disso, ainda não sabemos como o Cerebras se sai frente a frente com outros chips de IA. Fabricantes de chips de IA como Nvidia e Intel começaram participando de benchmarking regular de terceiros por nomes como MLperf. A Cerebras ainda não participou.

Espaço para poupar

Ainda assim, a abordagem parece estar criando seu próprio nicho no mundo da supercomputação, e o escalonamento contínuo em IA de linguagem grande é um caso de uso principal. De fato, Feldman disse Wired ano passado que a empresa já estava conversando com engenheiros da OpenAI, líder em modelos de linguagem grande. (O fundador da OpenAI, Sam Altman, também é investidor da Cerebras.)

Em seu lançamento em 2020, o modelo de linguagem grande GPT-3 da OpenAI mudou o jogo em termos de desempenho e tamanho. Pesando 175 bilhões de parâmetros, era o maior modelo de IA da época e surpreendeu os pesquisadores com suas habilidades. Desde então, os modelos de linguagem chegaram a trilhões de parâmetros, e modelos maiores podem surgir. Existem rumores- apenas isso, até agora - que o OpenAI lançará o GPT-4 em um futuro não muito distante e será outro salto do GPT-3. (Teremos que esperar para ver essa contagem.)

Dito isso, apesar de suas capacidades, grandes modelos de linguagem não são perfeitos nem universalmente adorados. Suas falhas incluem resultados que podem ser falsos, tendenciosos e ofensivos. A Meta Galactica, treinada em textos científicos, é um exemplo recente. Apesar de um conjunto de dados que se pode supor ser menos propenso a toxicidade do que o treinamento na Internet aberta, o modelo foi facilmente provocado a gerar texto prejudicial e impreciso e foi desativado em apenas três dias. Se os pesquisadores podem resolver as deficiências da linguagem AI, permanece incerto.

Mas parece provável que a expansão continue até que os retornos decrescentes apareçam. O próximo salto pode estar chegando - e talvez já tenhamos o hardware para fazer isso acontecer.

Crédito de imagem: Cerebras