As GPUs são uma ferramenta poderosa para cargas de trabalho de aprendizado de máquina, embora não sejam necessariamente a ferramenta certa para todos os trabalhos de IA, de acordo com Michael Bronstein, chefe de pesquisa de aprendizado de gráficos do Twitter.

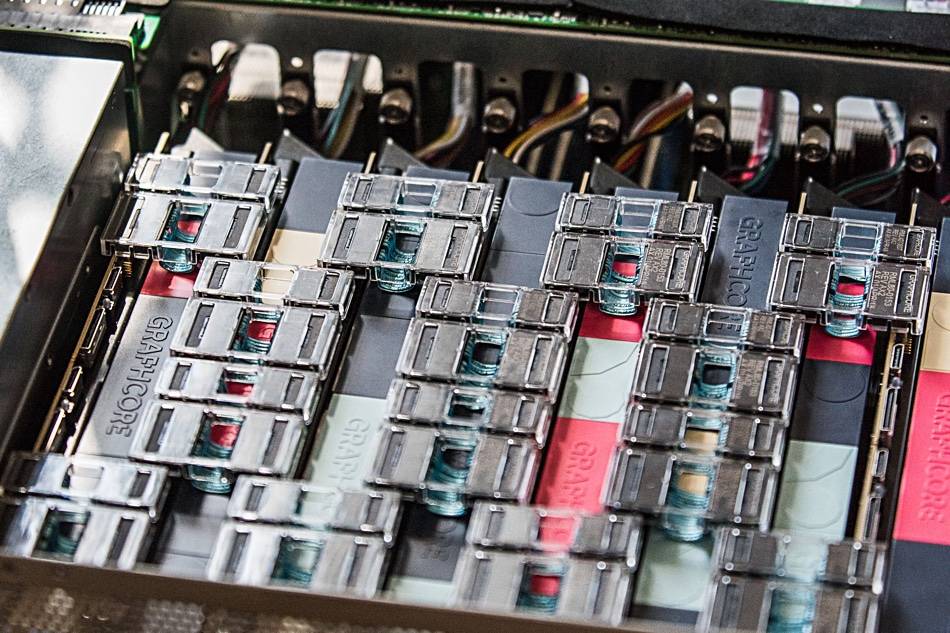

Sua equipe mostrou recentemente que o hardware de IA da Graphcore oferecia uma “aceleração de ordem de magnitude ao comparar um único processador IPU a uma GPU Nvidia A100”, em modelos de rede de gráfico temporal (TGN).

“A escolha do hardware para implementar os modelos do Graph ML é um problema crucial, mas muitas vezes esquecido”, diz um artigo conjunto escrito por Bronstein com Emanuele Rossi, pesquisador de ML no Twitter, e Daniel Justus, pesquisador da Graphcore.

As redes neurais gráficas oferecem um meio de encontrar ordem em sistemas complexos e são comumente usadas em redes sociais e sistemas de recomendação. No entanto, a natureza dinâmica desses ambientes torna esses modelos particularmente desafiadores para treinar, explicou o trio.

O grupo investigou a viabilidade das IPUs da Graphcore em lidar com vários modelos de TGN. O teste inicial foi feito em um pequeno modelo TGN baseado no JODIE Conjunto de dados da Wikipedia que vincula os usuários às edições que eles fizeram nas páginas. O gráfico foi composto por 8,227 usuários e 1,000 artigos para um total de 9,227 nós. JODIE é um sistema de previsão de código aberto projetado para dar sentido às redes de interação temporal.

A experimentação do trio revelou que tamanhos de lote grandes resultaram em validação degradada e precisão de inferência, em comparação com tamanhos de lote menores.

“A memória do nó e a conectividade do gráfico são atualizadas apenas após o processamento de um lote completo”, escreveu o trio. “Portanto, os eventos posteriores em um lote podem depender de informações desatualizadas, pois não estão cientes de eventos anteriores.”

No entanto, usando um tamanho de lote de 10, o grupo conseguiu obter validação e precisão de inferência ideais, mas eles observam que o desempenho na IPU ainda era superior ao de uma GPU, mesmo ao usar tamanhos de lote grandes.

“Ao usar um lote de 10, o TGN pode ser treinado na IPU cerca de 11 vezes mais rápido e, mesmo com um tamanho de lote grande de 200, o treinamento ainda é três vezes mais rápido na IPU”, diz o post. “Em todas as operações, a IPU lida com tamanhos de lotes pequenos com mais eficiência.”

A equipe postula que o acesso rápido à memória e a alta taxa de transferência oferecidas pelo grande cache SRAM no processador da Graphcore deram uma vantagem à IPU.

Essa liderança de desempenho também se estendeu a modelos de gráficos que excederam a memória do processador da IPU - cada IPU possui um cache SRAM de 1 GB - exigindo o uso de memória DRAM mais lenta conectada aos chips.

Ao testar em um modelo gráfico que consiste em 261 milhões de seguidores entre 15.5 milhões de usuários do Twitter, o uso de DRAM para a memória do nó reduziu a taxa de transferência por um fator de dois, descobriu a equipe de Bronstein.

No entanto, ao induzir vários subgráficos com base em um conjunto de dados sintético 10 vezes maior que o tamanho do gráfico do Twitter, a equipe descobriu que a taxa de transferência era dimensionada independentemente do tamanho do gráfico. Em outras palavras, o impacto no desempenho foi resultado do uso de memória mais lenta e não do tamanho do modelo.

“Usando essa técnica na IPU, o TGN pode ser aplicado a tamanhos de gráfico quase arbitrários, limitados apenas pela quantidade de memória do host disponível, mantendo uma taxa de transferência muito alta durante o treinamento e a inferência”, diz o artigo.

A equipe concluiu que a arquitetura de IPU da Graphcore mostra uma vantagem significativa sobre as GPUs em cargas de trabalho onde o acesso à computação e à memória são heterogêneos.

No entanto, a conclusão mais ampla é que os pesquisadores de ML devem considerar cuidadosamente sua escolha de hardware e não devem usar GPUs por padrão.

“A disponibilidade de serviços de computação em nuvem abstraindo o hardware subjacente leva a certa preguiça a esse respeito”, escreveu o trio. “Esperamos que nosso estudo chame mais atenção para esse tópico importante e abra caminho para algoritmos e arquiteturas de hardware futuros e mais eficientes para aplicativos Graph ML.” ®

- AI

- arte ai

- gerador de arte ai

- ai robô

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- escala ai

- sintaxe

- O registro

- zefirnet