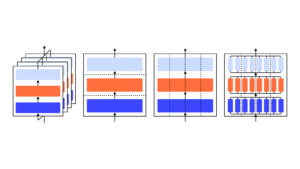

Mostramos que um modelo GPT-3 pode aprender a expressar incerteza sobre suas próprias respostas em linguagem natural – sem o uso de logits de modelo. Quando dada uma pergunta, o modelo gera uma resposta e um nível de confiança (por exemplo, “90% de confiança” ou “alta confiança”). Esses níveis são mapeados para probabilidades bem calibradas. O modelo também permanece moderadamente calibrado sob mudanças de distribuição e é sensível à incerteza nas suas próprias respostas, em vez de imitar exemplos humanos. Até onde sabemos, esta é a primeira vez que se demonstra que um modelo expressa incerteza calibrada sobre suas próprias respostas em linguagem natural. Para testar a calibração, apresentamos o conjunto de tarefas CalibratedMath. Comparamos a calibração da incerteza expressa em palavras (“probabilidade verbalizada”) com a incerteza extraída dos logits do modelo. Ambos os tipos de incerteza são capazes de generalizar a calibração sob mudança de distribuição. Também fornecemos evidências de que a capacidade do GPT-3 de generalizar a calibração depende de representações latentes pré-treinadas que se correlacionam com a incerteza epistêmica sobre suas respostas.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- Platoblockchain. Inteligência Metaverso Web3. Conhecimento Ampliado. Acesse aqui.

- Fonte: https://openai.com/research/teaching-models-to-express-their-uncertainty-in-words

- :é

- a

- habilidade

- Sobre

- e

- responder

- respostas

- SOMOS

- CAN

- capaz

- comparar

- confiança

- depende

- distribuição

- e

- evidência

- exemplos

- expresso

- expressa

- Primeiro nome

- primeira vez

- Escolha

- da

- gera

- dado

- Alta

- HTTPS

- humano

- in

- introduzir

- ESTÁ

- Conhecimento

- língua

- APRENDER

- Nível

- níveis

- mapa,

- modelo

- modelos

- natural

- of

- on

- próprio

- platão

- Inteligência de Dados Platão

- PlatãoData

- fornecer

- questão

- em vez

- permanece

- s

- sensível

- mudança

- mostrar

- mostrando

- suíte

- tarefas

- Ensino

- ensaio

- que

- A

- deles

- Este

- tempo

- para

- Incerteza

- para

- usar

- BEM

- de

- palavras

- zefirnet