Uma abordagem sistemática para retreinar algoritmos de inteligência artificial de aprendizado profundo para lidar com diferentes situações foi desenvolvida por pesquisadores do clima nos EUA. A equipe descobriu que, ao contrário da sabedoria convencional, retreinar níveis anteriores do algoritmo geralmente alcança melhores resultados do que retreinar níveis posteriores.

O aprendizado profundo é um tipo de aprendizado de máquina altamente avançado, às vezes controverso, no qual os algoritmos de computador ensinam a si mesmos os recursos importantes de um sistema e aprendem a fazer classificações sobre sua natureza e previsões sobre seu comportamento, geralmente com precisões que superam as capacidades dos humanos. Talvez a demonstração mais famosa de aprendizado profundo em ação tenha sido a vitória do programa AlphaGo do Google sobre o campeão go player Lee Sedol em 2017. No entanto, o aprendizado profundo tem aplicações mais práticas: pode prever o dobramento de proteínas, biópsias de tecido de tela para sinais precoces de câncer e prever padrões climáticos.

No entanto, como os algoritmos de aprendizado profundo não são programados por um operador externo, eles também não podem ser simplesmente reprogramados. Em vez disso, se o sistema mudar, o algoritmo deve ser treinado novamente usando dados do novo sistema. Isso é importante na climatologia se os algoritmos de aprendizado profundo treinados usando as condições climáticas atuais fizerem previsões úteis sobre as condições climáticas em um mundo afetado pelas mudanças climáticas. Esse processo – familiar aos humanos – de adaptação de experiências anteriores a situações desconhecidas é conhecido pelos cientistas da computação como aprendizagem por transferência.

Mistério profundo

Cientista do clima Pedram Hassanzadeh da Rice University, no Texas, explica que os algoritmos de aprendizado profundo processam informações em uma sequência de camadas. “A informação vai para uma camada, que extrai algumas informações, e depois envia essas informações para outra camada, que extrai mais informações.” Esse processo eventualmente produz a saída, mas, como explica Hassanzadeh, “ninguém sabe exatamente qual é o trabalho de cada camada porque não projetamos nenhuma delas – todas são aprendidas”. O aprendizado por transferência usa a pequena quantidade de dados disponíveis do novo conjunto de dados para treinar novamente um (ou alguns) desses níveis, e Hassanzadeh diz que é “importante qual nível você escolhe”.

A sabedoria convencional, diz ele, determina que as especificidades do problema sejam resolvidas nas camadas mais profundas da rede (aquelas camadas mais próximas da saída). Portanto, para realizar o aprendizado por transferência, esses são os melhores para retreinar. “O que foi feito no passado é que, digamos, o Google treina uma rede de mil camadas no Google Images e, então, alguém traz um pequeno número de raios-X, então eles retreinam as camadas 998 e 999”, explica Hassanzadeh. Agora ele e seus colegas adotaram uma abordagem sistemática.

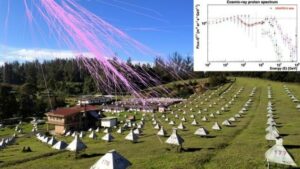

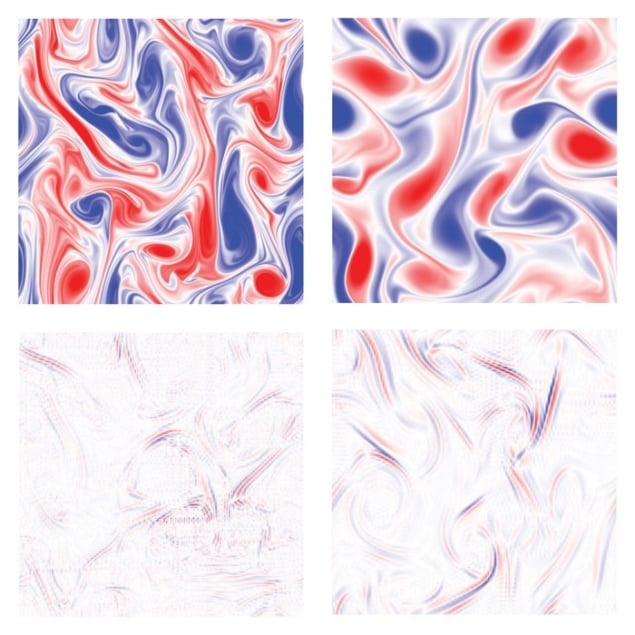

Os pesquisadores realizaram simulações de alta resolução do comportamento dos fluidos em três diferentes conjuntos de condições. Eles usaram esses dados para treinar três algoritmos de aprendizado profundo de 10 camadas para prever o comportamento dos fluidos sob cada um desses parâmetros específicos. Eles mudaram alguns parâmetros, como o número de Reynolds (a proporção de forças inerciais para forças viscosas) ou a vorticidade do fluido em cada caso e conduziram outro conjunto de simulações de alta resolução para prever o comportamento dos novos fluidos. Em cada um dos três casos, eles treinaram os mesmos algoritmos nos novos dados. Por fim, eles conduziram o aprendizado de transferência dos algoritmos antigos em um pequeno subconjunto dos novos dados, observando o efeito do retreinamento de cada nível e comparando o desempenho do algoritmo antigo retreinado com o algoritmo que havia sido treinado do zero nos novos dados.

Retreinando camadas rasas

Os resultados foram surpreendentes. “Neste artigo, descobrimos que as camadas mais rasas eram as melhores para retreinar”, diz Hassanzadeh. Ter acesso ao sinal previsto produzido pelo retreinamento de cada camada deu a eles uma janela para o efeito que cada camada teve neste sinal final. Portanto, eles simplesmente usaram a análise espectral de cada sinal para ver como cada camada estava modificando cada frequência presente. Alguns níveis controlavam as baixas frequências e era útil retreiná-los, pois eles capturavam as características macroscópicas de variação suave do algoritmo. Outros níveis, enquanto isso, previam os detalhes, e retreiná-los sozinho era quase inútil. Os pesquisadores forneceram um protocolo para determinar os níveis mais importantes em qualquer caso. “Não queríamos dizer que temos uma regra prática neste artigo”, diz Hassanzadeh. “Agora encontramos sistemas onde, por exemplo, as camadas intermediárias são as melhores [para retreinar].”

Inteligência artificial simplifica cálculos de propriedades eletrônicas

A equipe descreve o trabalho em um artigo publicado na Nexus do PNAS.

“Acho que é um artigo realmente interessante”, diz astrofísico e especialista em aprendizado de máquina Shirley Ho do Flatiron Institute em Nova York. Ela acrescenta: “Por outro lado, em muitas outras disciplinas científicas, usamos a análise espectral há muito tempo, então acho que a questão é se aplicá-la às múltiplas camadas é uma contribuição significativa ou não. Tenho a sensação de que provavelmente é uma daquelas coisas que estão na cabeça das pessoas, mas ninguém a escreveu. Pode ser um daqueles grandes artigos em que, uma vez que você diz, fica óbvio para todo mundo.”

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- Platoblockchain. Inteligência Metaverso Web3. Conhecimento Ampliado. Acesse aqui.

- Fonte: https://physicsworld.com/a/new-approach-retrains-deep-neural-networks-to-deal-with-changes-in-complex-systems/

- 2017

- a

- Sobre

- Acesso

- Alcança

- Açao Social

- Adiciona

- avançado

- algoritmo

- algoritmos

- Todos os Produtos

- sozinho

- quantidade

- análise

- e

- Outro

- aplicações

- Aplicando

- abordagem

- artificial

- inteligência artificial

- disponível

- Porque

- MELHOR

- Melhor

- Inferior

- Traz

- cálculos

- Câncer

- não podes

- capacidades

- casas

- casos

- campeão

- alterar

- Alterações

- Cidades

- Clima

- Das Alterações Climáticas

- colegas

- comparando

- integrações

- computador

- condições

- contrário

- contribuição

- controle

- controverso

- convencional

- dados,

- conjunto de dados

- acordo

- profundo

- deep learning

- mais profundo

- Design

- detalhes

- determinando

- desenvolvido

- dita

- diferenças

- diferente

- não

- durante

- cada

- Mais cedo

- Cedo

- efeito

- ou

- Eletrônico

- eventualmente

- exatamente

- exemplo

- vasta experiência

- especialista

- Explica

- externo

- Extractos

- familiar

- famoso

- Funcionalidades

- poucos

- Figura

- final

- Finalmente

- Forças

- encontrado

- Frequência

- da

- ter

- dado

- Go

- vai

- ótimo

- Grupo

- mão

- ter

- de alta resolução

- altamente

- Como funciona o dobrador de carta de canal

- Contudo

- HTTPS

- Humanos

- imagem

- imagens

- importante

- in

- INFORMAÇÕES

- em vez disso

- Instituto

- Inteligência

- interessante

- emitem

- IT

- Trabalho

- conhecido

- camada

- camadas

- APRENDER

- aprendido

- aprendizagem

- Lee

- Nível

- níveis

- Lista

- longo

- muito tempo

- procurando

- máquina

- aprendizado de máquina

- fazer

- muitos

- max-width

- Entretanto

- Coração

- mentes

- modelo

- mais

- a maioria

- múltiplo

- Natureza

- rede

- redes

- redes neurais

- Novo

- New York

- Cidade de Nova Iorque

- número

- óbvio

- Velho

- ONE

- aberto

- operador

- Outros

- Papel

- papéis

- parâmetros

- passado

- padrões

- pessoas

- Realizar

- atuação

- possivelmente

- platão

- Inteligência de Dados Platão

- PlatãoData

- jogador

- Prática

- predizer

- previsto

- Previsões

- presente

- Prévio

- provavelmente

- Problema

- processo

- Produzido

- Agenda

- programado

- Proteína

- protocolo

- fornecido

- publicado

- questão

- relação

- reconhecer

- pesquisadores

- Resultados

- arroz

- Regra

- mesmo

- diz

- Escala

- científico

- Cientista

- cientistas

- Peneira

- Seqüência

- conjunto

- Conjuntos

- raso

- mostrando

- Signal

- periodo

- Sinais

- simplesmente

- situações

- pequeno

- sem problemas

- So

- alguns

- específico

- Espectral

- substancial

- tal

- surpreendente

- .

- sistemas

- Profissionais

- texas

- A

- si mesmos

- assim sendo

- coisas

- três

- miniaturas

- tempo

- para

- hoje

- topo

- Trem

- treinado

- Training

- trens

- transferência

- verdadeiro

- VIRAR

- para

- desconhecido

- universidade

- us

- Clima

- O Quê

- se

- qual

- sabedoria

- Atividades:

- trabalhou

- mundo

- escrito

- Vocês

- zefirnet