Você pode acabar morando em uma cabana de espingarda. E você pode acabar trabalhando com GPT-4. E você pode se perguntar: “O GPT-4 rodará o Doom?” E você pode se perguntar: “Estou certo? Estou errado?"

Adrian de Wynter, principal cientista aplicado da Microsoft e pesquisador da Universidade de York, na Inglaterra, colocou essas questões em um artigo de pesquisa recente, “O GPT-4 executará o Doom?"

Infelizmente, GPT-4, um grande modelo de linguagem da OpenAI apoiada pela Microsoft, não tem capacidade para executar o código-fonte do Doom diretamente.

Mas sua variante multimodal, GPT-4V, que pode aceitar imagens como entrada e também texto, exibe a mesma cativante subcompetência de jogar doom como os modelos baseados em texto que lançaram inúmeras startups de IA.

“Na configuração do artigo, o GPT-4 (e o GPT-4 com visão, ou GPT-4V) não pode realmente rodar o Doom sozinho, porque é limitado pelo tamanho da entrada (e, obviamente, provavelmente apenas inventará coisas ; você realmente não quer que seu compilador tenha alucinações a cada cinco minutos)”, escreveu de Wynter em um comentário explicativo. nota sobre seu papel. “Dito isto, ele pode definitivamente atuar como um proxy para o motor, não muito diferente de outros 'ele rodará Doom?' implementações, como E. Coli or Bloco de notas. "

Ou seja, o GPT-4V não rodará Doom como um trator John Deere mas jogará Doom sem treinamento específico.

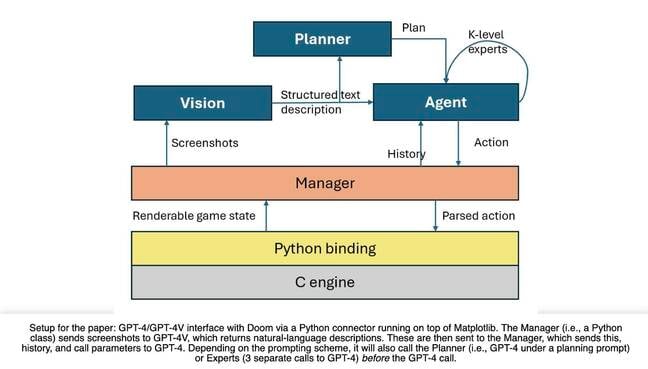

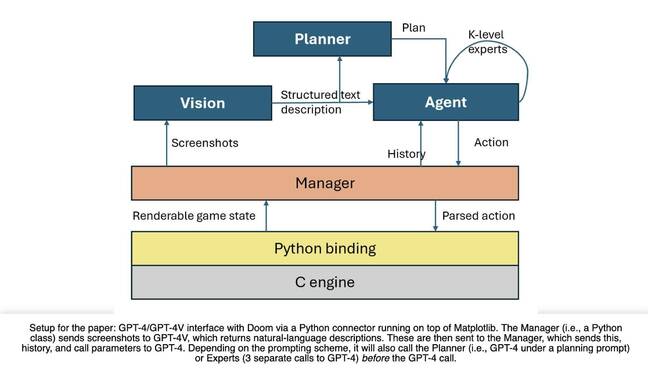

Para gerenciar isso, de Wynter projetou um componente Vision que chama GPT-4V, que captura capturas de tela do mecanismo de jogo e retorna descrições estruturais do estado do jogo. E ele combinou isso com um modelo de Agente que chama GPT-4 para tomar decisões com base na entrada visual e no histórico anterior. O modelo do Agente foi instruído a traduzir suas respostas em comandos de pressionamento de tecla que tenham significado para o mecanismo de jogo.

As interações são tratadas por meio de uma camada Manager que consiste em uma ligação Python de código aberto ao Motor C Doom rodando no Matplotlib.

Essa combinação de modelos e códigos de IA pode abrir portas, combater inimigos e disparar armas, de acordo com o jornal. E pode executar um conjunto mais amplo de instruções, como um passo a passo de nível, para melhorar seu próprio desempenho.

A principal deficiência deste sistema baseado em GPT-4V é a falta de permanência do objeto – ele se esquece dos zumbis do jogo quando eles saem da tela.

GPT-4 esquece o zumbi e segue em frente

“Por exemplo, seria muito comum o modelo ver um zumbi na tela e começar a atirar nele até acertá-lo (ou morrer)”, explica de Wynter. “Agora, esta é uma IA escrita para funcionar com hardware de 1993, então suponho que não tenha uma árvore de decisão super profunda. Então o zumbi atira em você e começa a correr pela sala.

“Qual é o problema aqui? Bem, primeiro o zumbi sai de vista. Pior, ainda está vivo e irá bater em você em algum momento. Então você tem que ir atrás, certo? Afinal, em Doom, é bater ou ser derrotado.

“Acontece que o GPT-4 se esquece do zumbi e segue em frente. Nota: o prompt diz explicitamente ao modelo o que fazer se estiver sofrendo danos e não puder ver um inimigo. Melhor ainda, ele simplesmente segue seu caminho alegre, fica preso em um canto e morre. Ele girou algumas vezes, mas em quase 50-60 corridas, eu observei… duas vezes, quero dizer.”

Além disso, o GPT-4 não consegue raciocinar muito bem. Quando solicitado a explicar as suas ações que eram geralmente corretas no contexto, as suas explicações eram pobres e muitas vezes incluíam alucinações (também conhecidas como informações incorretas).

De Wynter, no entanto, considera notável que o GPT-4 seja capaz de jogar Doom sem treinamento prévio.

Ao mesmo tempo, ele acha isso preocupante.

“No departamento de ética, é bastante preocupante como foi fácil para (a) eu construir código para fazer o modelo fotografar algo; e (b) para que o modelo fotografe algo com precisão, sem realmente questionar as instruções”, escreveu ele em sua postagem resumida.

“Portanto, embora esta seja uma exploração muito interessante em torno do planejamento e do raciocínio, e possa ter aplicações em testes automatizados de videogames, é bastante óbvio que este modelo não tem consciência do que está fazendo. Peço veementemente a todos que pensem sobre o que a implantação desses modelos [implica] para a sociedade e seu potencial uso indevido.”

E você pode dizer para si mesmo: “Meu Deus, o que eu fiz?” ®

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://go.theregister.com/feed/www.theregister.com/2024/03/11/gpt4_wont_run_doom/

- :tem

- :é

- :não

- $UP

- 369

- 7

- a

- Sobre

- ACEITAR

- Segundo

- exatamente

- Aja

- ações

- Depois de

- Agente

- AI

- Modelos de IA

- aka

- vivo

- Todos os Produtos

- am

- an

- e

- aplicações

- aplicado

- SOMOS

- por aí

- AS

- perguntar

- At

- Automatizado

- consciente

- baseado

- BE

- Porque

- sido

- Melhor

- obrigatório

- mais amplo

- construir

- mas a

- by

- chamadas

- CAN

- não podes

- capaz

- Capacidade

- capturas

- de cores

- clique

- CO

- código

- combinado

- comum

- componente

- considera

- Consistindo

- contexto

- Canto

- correta

- poderia

- Casal

- dano

- de

- decisão

- decisões

- profundo

- definitivamente

- Departamento

- desenvolvimento

- Design

- projetado

- diagrama

- DID

- morreu

- diretamente

- do

- não

- fazer

- don

- feito

- condenação

- portas

- fácil

- Motor

- Inglaterra

- ética

- Cada

- todos

- exemplo

- executar

- exposições

- Explicação

- Explica

- explicações

- explicitamente

- exploração

- lutar

- Encontre

- encontra

- Fogo

- acendimento

- Primeiro nome

- cinco

- Escolha

- carregado

- da

- jogo

- geralmente

- ter

- fica

- GitHub

- Go

- Deus

- vai

- vai

- adivinhar

- Hardware

- Ter

- he

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- sua

- história

- Acertar

- Como funciona o dobrador de carta de canal

- HTML

- HTTPS

- i

- if

- imagens

- implementações

- melhorar

- in

- in-game

- incluído

- incorreto

- INFORMAÇÕES

- entrada

- instruções

- interessante

- para dentro

- emitem

- IT

- ESTÁ

- se

- banheiro

- jpg

- apenas por

- mantém

- Falta

- língua

- grande

- lançado

- camada

- Nível

- como

- Limitado

- vida

- a Principal

- fazer

- gerencia

- Gerente

- matplotlib

- Posso..

- me

- significado

- Alegre

- Microsoft

- Minutos

- mau uso

- MIT

- misturar

- modelo

- modelos

- quase

- nota

- agora

- objeto

- óbvio

- of

- WOW!

- frequentemente

- on

- aberto

- open source

- OpenAI

- or

- Outros

- Fora

- próprio

- Papel

- atuação

- planejamento

- platão

- Inteligência de Dados Platão

- PlatãoData

- Jogar

- jogar

- ponto

- pobre

- colocada

- Publique

- potencial

- anterior

- Diretor

- Prévio

- provavelmente

- procuração

- Python

- Frequentes

- bastante

- clientes

- razão

- recentemente

- notável

- pesquisa

- investigador

- respostas

- Retorna

- certo

- Quarto

- Execute

- corrida

- é executado

- s

- Dito

- mesmo

- dizer

- Cientista

- Peneira

- screenshots

- Vejo

- conjunto

- instalação

- atirar

- mostrando

- Tamanho

- So

- Sociedade

- alguns

- algo

- fonte

- código fonte

- específico

- começo

- começa

- Startups

- Estado

- Ainda

- discordaram

- estrutura

- tal

- RESUMO

- super

- .

- tomar

- conta

- ensaio

- texto

- que

- A

- deles

- então

- Este

- deles

- think

- isto

- Através da

- tempo

- vezes

- para

- disse

- Training

- traduzir

- árvore

- perturbador

- VIRAR

- voltas

- Twice

- para

- universidade

- ao contrário

- até

- Variante

- muito

- Vídeo

- videogame

- Ver

- visão

- visual

- Passo a passo

- queremos

- foi

- Caminho..

- armas

- BEM

- foram

- O Quê

- quando

- qual

- enquanto

- precisarão

- de

- sem

- Ganhou

- Atividades:

- trabalhar

- pior

- seria

- escrito

- Errado

- escreveu

- ainda

- Iorque

- Vocês

- investimentos

- você mesmo

- zefirnet

- zumbi