Hoje, temos o prazer de anunciar que os modelos de base Llama 2 desenvolvidos pela Meta estão disponíveis para clientes através JumpStart do Amazon SageMaker. A família Llama 2 de grandes modelos de linguagem (LLMs) é uma coleção de modelos de texto generativos pré-treinados e ajustados que variam em escala de 7 bilhões a 70 bilhões de parâmetros. LLMs ajustados, chamados Llama-2-chat, são otimizados para casos de uso de diálogo. Você pode experimentar facilmente esses modelos e usá-los com o SageMaker JumpStart, que é um hub de aprendizado de máquina (ML) que fornece acesso a algoritmos, modelos e soluções de ML para que você possa começar a usar o ML rapidamente.

Nesta postagem, explicamos como usar os modelos Llama 2 via SageMaker JumpStart.

O que é Lhama 2

Llama 2 é um modelo de linguagem auto-regressivo que usa uma arquitetura de transformador otimizada. Llama 2 destina-se ao uso comercial e de pesquisa em inglês. Ele vem em uma variedade de tamanhos de parâmetros – 7 bilhões, 13 bilhões e 70 bilhões – bem como variações pré-treinadas e ajustadas. De acordo com Meta, as versões ajustadas usam ajuste fino supervisionado (SFT) e aprendizagem por reforço com feedback humano (RLHF) para se alinhar às preferências humanas de utilidade e segurança. O Llama 2 foi pré-treinado em 2 trilhões de tokens de dados de fontes disponíveis publicamente. Os modelos ajustados destinam-se a bate-papo semelhante a um assistente, enquanto os modelos pré-treinados podem ser adaptados para uma variedade de tarefas de geração de linguagem natural. Independentemente de qual versão do modelo um desenvolvedor usa, o guia de uso responsável da Meta pode ajudar a orientar ajustes adicionais que podem ser necessários para personalizar e otimizar os modelos com mitigações de segurança apropriadas.

O que é o SageMaker JumpStart

Com o SageMaker JumpStart, os profissionais de ML podem escolher entre uma ampla seleção de modelos básicos de código aberto. Os profissionais de ML podem implantar modelos básicos para dedicados Amazon Sage Maker instâncias de um ambiente isolado de rede e personalize modelos usando o SageMaker para treinamento e implantação de modelo.

Agora você pode descobrir e implantar o Llama 2 com apenas alguns cliques Estúdio Amazon SageMaker ou programaticamente por meio do SageMaker Python SDK, permitindo derivar o desempenho do modelo e controles MLOps com recursos do SageMaker, como Pipelines Amazon SageMaker, Depurador do Amazon SageMakerou registros de contêiner. O modelo é implantado em um ambiente seguro da AWS e sob seus controles de VPC, ajudando a garantir a segurança dos dados. Os modelos Llama 2 estão disponíveis hoje no Amazon SageMaker Studio, inicialmente em us-east 1 e us-west 2 regiões.

Descubra modelos

Você pode acessar os modelos básicos por meio do SageMaker JumpStart na interface do SageMaker Studio e do SageMaker Python SDK. Nesta seção, veremos como descobrir os modelos no SageMaker Studio.

SageMaker Studio é um ambiente de desenvolvimento integrado (IDE) que fornece uma única interface visual baseada na web onde você pode acessar ferramentas específicas para executar todas as etapas de desenvolvimento de ML, desde a preparação de dados até a construção, treinamento e implantação de seus modelos de ML. Para obter mais detalhes sobre como começar e configurar o SageMaker Studio, consulte Estúdio Amazon SageMaker.

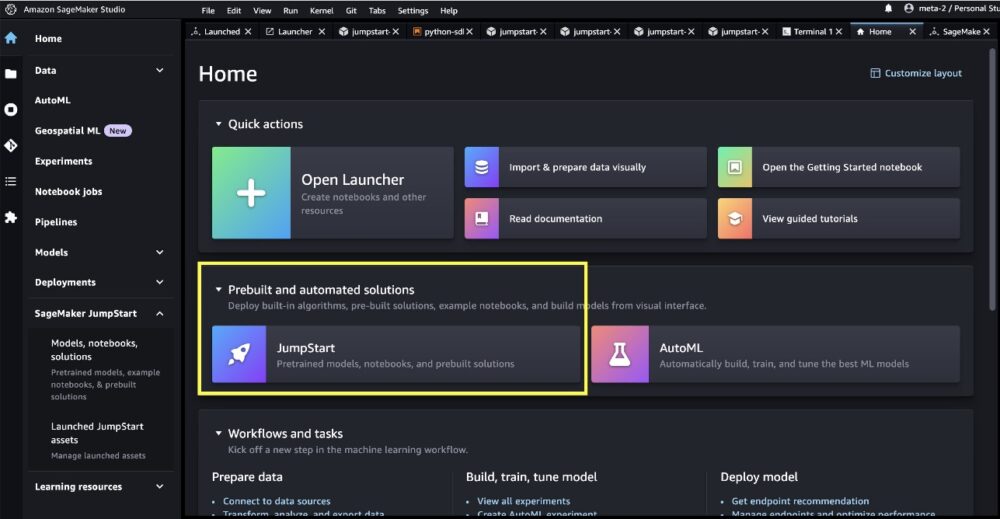

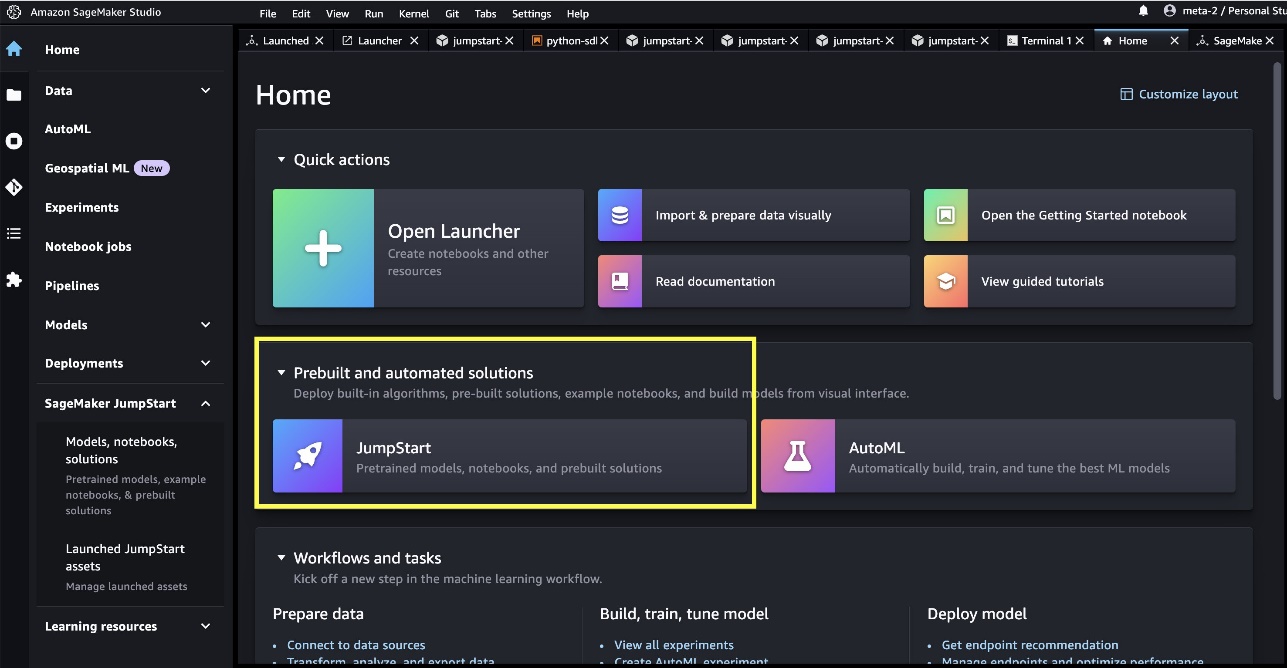

Quando estiver no SageMaker Studio, você poderá acessar o SageMaker JumpStart, que contém modelos pré-treinados, notebooks e soluções pré-construídas, em Soluções pré-construídas e automatizadas.

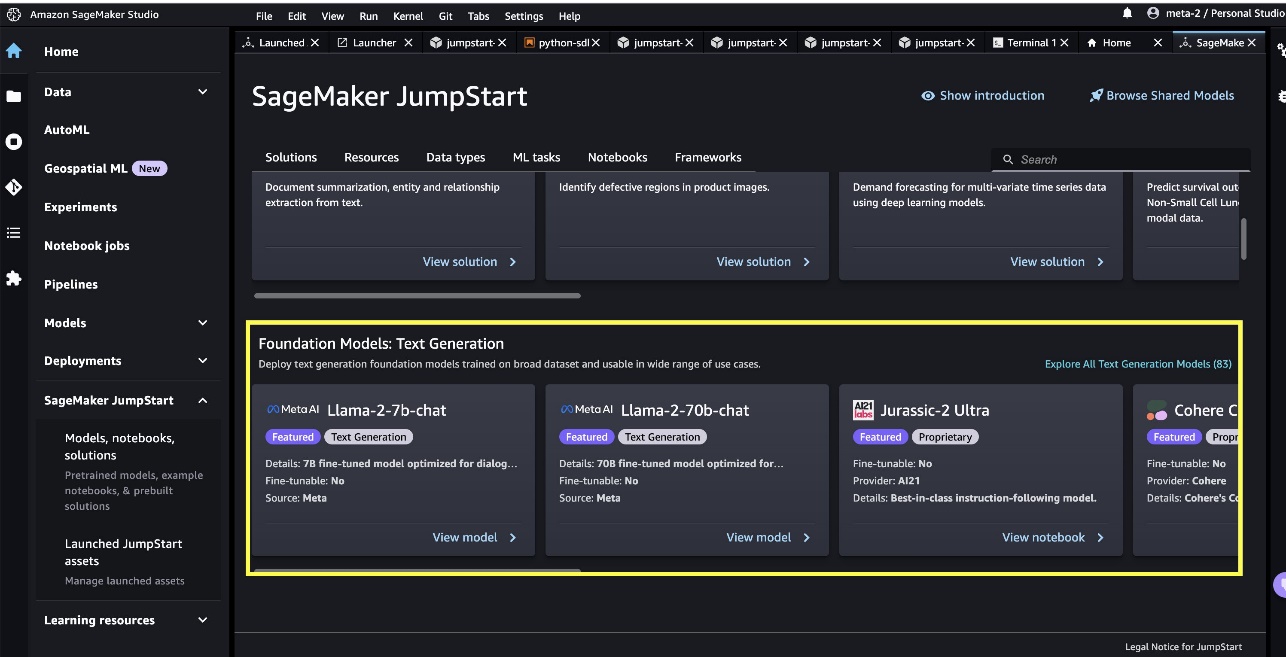

Na página inicial do SageMaker JumpStart, você pode procurar soluções, modelos, notebooks e outros recursos. Você pode encontrar dois modelos principais do Llama 2 no Modelos de Fundação: Geração de Texto carrossel. Se você não vir os modelos Llama 2, atualize sua versão do SageMaker Studio desligando e reiniciando. Para obter mais informações sobre atualizações de versão, consulte Desligue e atualize os aplicativos do Studio.

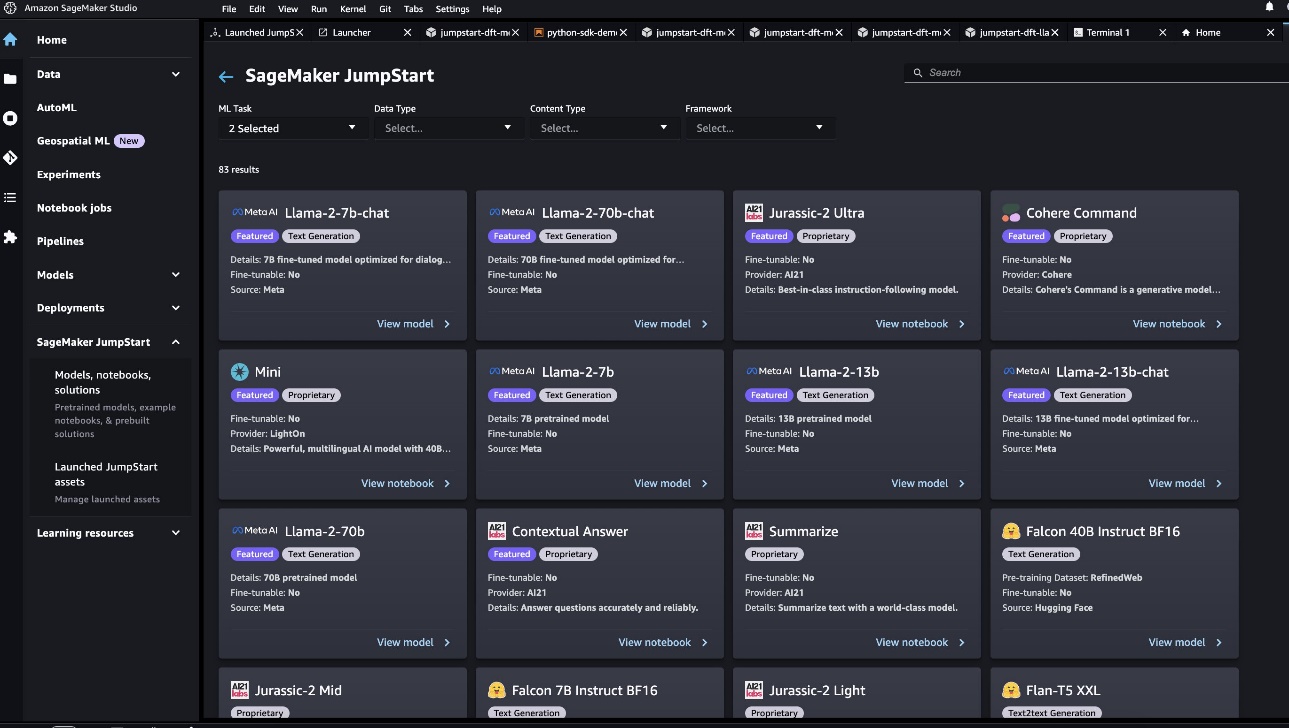

Você também pode encontrar outras quatro variantes de modelo escolhendo Explore todos os modelos de geração de texto ou procurando por llama na caixa de pesquisa.

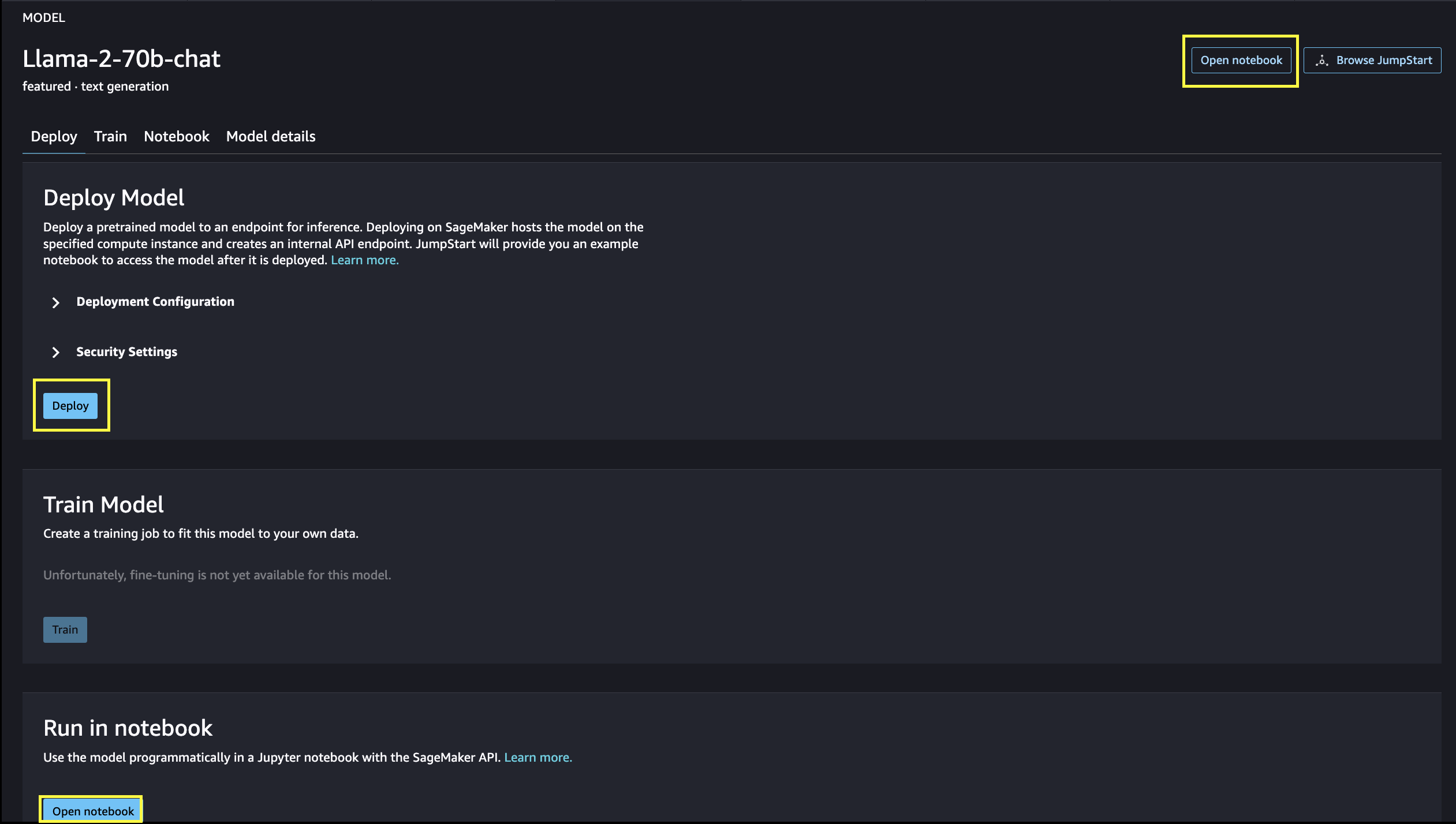

Você pode escolher o cartão do modelo para visualizar detalhes sobre o modelo, como licença, dados usados para treinar e como usar. Você também pode encontrar dois botões, Implantação e Abra o Notebook, que ajudam você a usar o modelo.

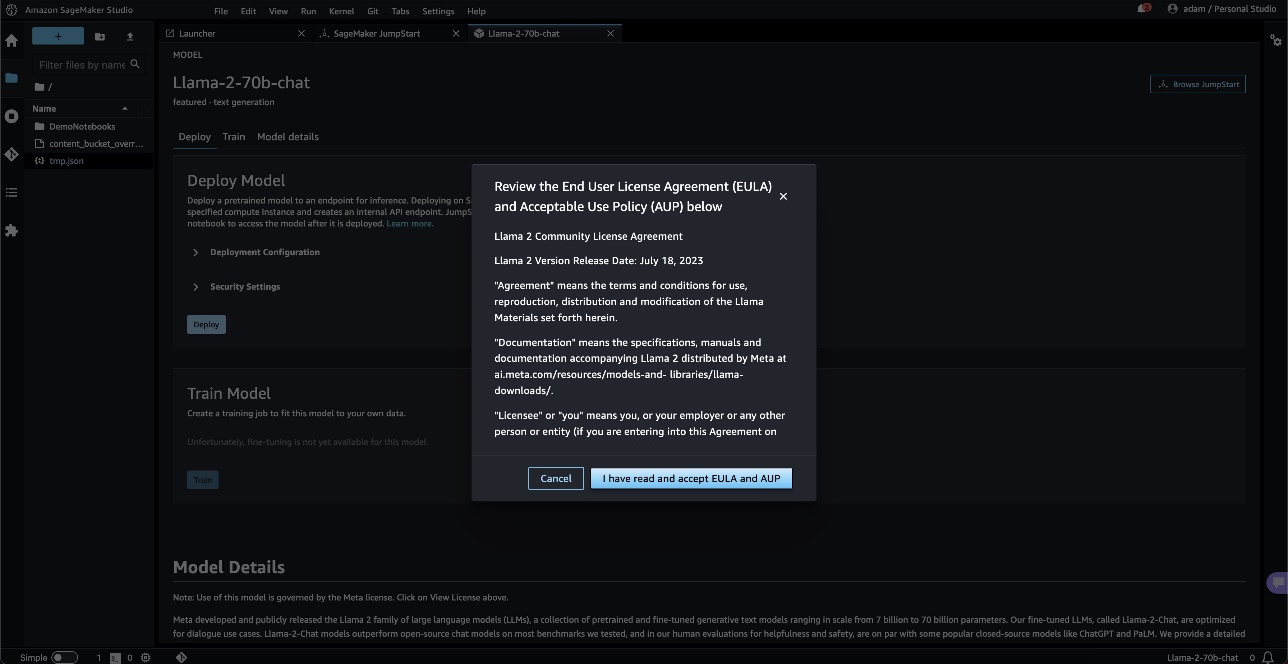

Ao escolher qualquer um dos botões, um pop-up mostrará o contrato de licença do usuário final e a política de uso aceitável para você confirmar.

Após confirmar, você prosseguirá para a próxima etapa para usar o modelo.

Implantar um modelo

Quando você escolhe Implantação e reconhecer os termos, a implantação do modelo será iniciada. Como alternativa, você pode implantar por meio do notebook de exemplo exibido escolhendo Abra o Notebook. O caderno de exemplo fornece orientação completa sobre como implantar o modelo para inferência e limpeza de recursos.

Para implantar usando um notebook, começamos selecionando um modelo apropriado, especificado pelo model_id. Você pode implantar qualquer um dos modelos selecionados no SageMaker com o seguinte código:

Isso implanta o modelo no SageMaker com configurações padrão, incluindo tipo de instância padrão e configurações de VPC padrão. Você pode alterar essas configurações especificando valores não padrão em Modelo JumpStart. Após a implantação, você pode executar inferência no endpoint implantado por meio do preditor SageMaker:

Modelos de bate-papo ajustados (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) aceitam um histórico de bate-papo entre o usuário e o assistente de bate-papo e geram o bate-papo subsequente. Os modelos pré-treinados (Llama-2-7b, Llama-2-13b, Llama-2-70b) requerem um prompt de string e executam o preenchimento de texto no prompt fornecido. Veja o seguinte código:

Observe que, por padrão, accept_eula está definido como falso. você precisa definir accept_eula=true para invocar o endpoint com sucesso. Ao fazer isso, você aceita o contrato de licença do usuário e a política de uso aceitável mencionados anteriormente. Você também pode download o contrato de licença.

Custom_attributes usados para passar o EULA são pares chave/valor. A chave e o valor são separados por = e os pares são separados por ;. Se o usuário passar a mesma chave mais de uma vez, o último valor será mantido e passado para o manipulador de script (ou seja, neste caso, usado para lógica condicional). Por exemplo, se accept_eula=false; accept_eula=true é passado para o servidor, então accept_eula=true é mantido e passado para o manipulador de script.

Os parâmetros de inferência controlam o processo de geração de texto no terminal. O controle máximo de novos tokens refere-se ao tamanho da saída gerada pelo modelo. Observe que isso não é igual ao número de palavras porque o vocabulário do modelo não é igual ao vocabulário do idioma inglês e cada token pode não ser uma palavra do idioma inglês. A temperatura controla a aleatoriedade na saída. Temperaturas mais altas resultam em resultados mais criativos e alucinados. Todos os parâmetros de inferência são opcionais.

A tabela a seguir lista todos os modelos de Llama disponíveis no SageMaker JumpStart junto com o model_ids, tipos de instância padrão e o número máximo de tokens totais (soma do número de tokens de entrada e número de tokens gerados) suportados para cada um desses modelos.

| Nome do modelo | ID do modelo | Total máximo de tokens | Tipo de instância padrão |

| Lhama-2-7b | geração de metatexto-llama-2-7b | 4096 | ml.g5.2xgrande |

| Lhama-2-7b-chat | meta-textogeração-llama-2-7b-f | 4096 | ml.g5.2xgrande |

| Lhama-2-13b | geração de metatexto-llama-2-13b | 4096 | ml.g5.12xgrande |

| Lhama-2-13b-chat | meta-textogeração-llama-2-13b-f | 4096 | ml.g5.12xgrande |

| Lhama-2-70b | geração de metatexto-llama-2-70b | 4096 | ml.g5.48xgrande |

| Lhama-2-70b-chat | meta-textogeração-llama-2-70b-f | 4096 | ml.g5.48xgrande |

Observe que os endpoints do SageMaker têm um limite de tempo limite de 60s. Assim, mesmo que o modelo seja capaz de gerar 4096 tokens, se a geração de texto demorar mais de 60 segundos, a solicitação falhará. Para os modelos 7B, 13B e 70B, recomendamos definir max_new_tokens não superior a 1500, 1000 e 500 respectivamente, mantendo o número total de tokens inferior a 4K.

Inferência e exemplos de prompts para Llama-2-70b

Você pode usar modelos Llama para completar texto em qualquer parte do texto. Por meio da geração de texto, você pode realizar diversas tarefas, como responder perguntas, traduzir idiomas, analisar sentimentos e muito mais. A carga útil de entrada para o endpoint se parece com o código a seguir:

A seguir estão alguns exemplos de prompts e o texto gerado pelo modelo. Todas as saídas são geradas com parâmetros de inferência {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

No próximo exemplo, mostramos como usar modelos Llama com aprendizado contextual de poucas tentativas, onde fornecemos amostras de treinamento disponíveis para o modelo. Observe que fazemos inferência apenas no modelo implantado e, durante esse processo, os pesos do modelo não mudam.

Inferência e exemplos de prompts para Llama-2-70b-chat

Com os modelos Llama-2-Chat, que são otimizados para casos de uso de diálogo, a entrada para os endpoints do modelo de chat é o histórico anterior entre o assistente de chat e o usuário. Você pode fazer perguntas contextuais à conversa que aconteceu até agora. Você também pode fornecer a configuração do sistema, como personas que definem o comportamento do assistente de chat. A carga útil de entrada para o endpoint se parece com o código a seguir:

A seguir estão alguns exemplos de prompts e o texto gerado pelo modelo. Todas as saídas são geradas com os parâmetros de inferência {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

No exemplo a seguir, o usuário conversou com o assistente sobre pontos turísticos de Paris. A seguir, o usuário pergunta sobre a primeira opção recomendada pelo assistente de chat.

Nos exemplos a seguir, definimos a configuração do sistema:

limpar

Depois de terminar de executar o notebook, exclua todos os recursos para que todos os recursos que você criou no processo sejam excluídos e seu faturamento seja interrompido:

Conclusão

Neste post, mostramos como começar a usar os modelos Llama 2 no SageMaker Studio. Com isso, você tem acesso a seis modelos de base do Llama 2 que contêm bilhões de parâmetros. Como os modelos básicos são pré-treinados, eles também podem ajudar a reduzir os custos de treinamento e infraestrutura e permitir a personalização para seu caso de uso. Para começar a usar o SageMaker JumpStart, visite os seguintes recursos:

Sobre os autores

junho ganhou é gerente de produto do SageMaker JumpStart. Ele se concentra em tornar os modelos básicos facilmente detectáveis e utilizáveis para ajudar os clientes a criar aplicativos generativos de IA. Sua experiência na Amazon também inclui aplicativos de compras móveis e entrega de última milha.

junho ganhou é gerente de produto do SageMaker JumpStart. Ele se concentra em tornar os modelos básicos facilmente detectáveis e utilizáveis para ajudar os clientes a criar aplicativos generativos de IA. Sua experiência na Amazon também inclui aplicativos de compras móveis e entrega de última milha.

Vivek Madan é um cientista aplicado da equipe Amazon SageMaker JumpStart. Ele obteve seu doutorado na Universidade de Illinois em Urbana-Champaign e foi pesquisador de pós-doutorado na Georgia Tech. Ele é um pesquisador ativo em aprendizado de máquina e design de algoritmos e publicou artigos em conferências EMNLP, ICLR, COLT, FOCS e SODA.

Vivek Madan é um cientista aplicado da equipe Amazon SageMaker JumpStart. Ele obteve seu doutorado na Universidade de Illinois em Urbana-Champaign e foi pesquisador de pós-doutorado na Georgia Tech. Ele é um pesquisador ativo em aprendizado de máquina e design de algoritmos e publicou artigos em conferências EMNLP, ICLR, COLT, FOCS e SODA.  Dr. é cientista aplicado da equipe Amazon SageMaker JumpStart. Seus interesses de pesquisa incluem algoritmos escaláveis de aprendizado de máquina, visão computacional, séries temporais, não paramétricos bayesianos e processos gaussianos. Seu doutorado é pela Duke University e publicou artigos em NeurIPS, Cell e Neuron.

Dr. é cientista aplicado da equipe Amazon SageMaker JumpStart. Seus interesses de pesquisa incluem algoritmos escaláveis de aprendizado de máquina, visão computacional, séries temporais, não paramétricos bayesianos e processos gaussianos. Seu doutorado é pela Duke University e publicou artigos em NeurIPS, Cell e Neuron.  Dr. é cientista aplicado sênior do Amazon SageMaker JumpStart e ajuda a desenvolver algoritmos de aprendizado de máquina. Ele obteve seu PhD pela Universidade de Illinois Urbana-Champaign. Ele é um pesquisador ativo em aprendizado de máquina e inferência estatística e publicou muitos artigos em conferências NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Dr. é cientista aplicado sênior do Amazon SageMaker JumpStart e ajuda a desenvolver algoritmos de aprendizado de máquina. Ele obteve seu PhD pela Universidade de Illinois Urbana-Champaign. Ele é um pesquisador ativo em aprendizado de máquina e inferência estatística e publicou muitos artigos em conferências NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.  Sundar Ranganathan é o chefe global de especialistas em GenAI/Frameworks GTM na AWS. Ele se concentra no desenvolvimento de estratégias GTM para grandes modelos de linguagem, GenAI e cargas de trabalho de ML em grande escala em serviços AWS como Amazon EC2, EKS, EFA, AWS Batch e Amazon SageMaker. Sua experiência inclui funções de liderança em gerenciamento e desenvolvimento de produtos na NetApp, Micron Technology, Qualcomm e Mentor Graphics.

Sundar Ranganathan é o chefe global de especialistas em GenAI/Frameworks GTM na AWS. Ele se concentra no desenvolvimento de estratégias GTM para grandes modelos de linguagem, GenAI e cargas de trabalho de ML em grande escala em serviços AWS como Amazon EC2, EKS, EFA, AWS Batch e Amazon SageMaker. Sua experiência inclui funções de liderança em gerenciamento e desenvolvimento de produtos na NetApp, Micron Technology, Qualcomm e Mentor Graphics.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Automotivo / EVs, Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- BlockOffsets. Modernizando a Propriedade de Compensação Ambiental. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :tem

- :é

- :não

- :onde

- $UP

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360-degree

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- Capaz

- Sobre

- ACEITAR

- aceitável

- Acesso

- acessibilidade

- acessível

- Segundo

- reconhecer

- em

- ativo

- adicionar

- acrescentando

- Adicional

- endereço

- Depois de

- novamente

- contra

- Acordo

- AI

- algoritmo

- algoritmos

- alinhar

- Todos os Produtos

- permitir

- juntamente

- tb

- sempre

- am

- Amazon

- Amazon EC2

- Amazon Sage Maker

- JumpStart do Amazon SageMaker

- Estúdio Amazon SageMaker

- Amazon Web Services

- americano

- an

- análise

- e

- e infra-estrutura

- Anunciar

- Outro

- responder

- qualquer

- qualquer um

- Aplicação

- aplicações

- aplicado

- apreciar

- apropriado

- Arco

- arquitetura

- SOMOS

- Arte

- AS

- auxiliar

- Assistente

- At

- Atmosfera

- atrações

- Automatizado

- disponível

- AWS

- Banana

- basic

- Batalha

- Bayesiano

- BE

- bonita

- Beleza

- passou a ser

- Porque

- tornam-se

- sido

- Cerveja

- antes

- comportamento

- Beijing

- Acreditar

- Acredita

- MELHOR

- entre

- morada

- bilhão

- bilhões

- Preto

- Caixa

- Break

- de tirar o fôlego

- amplo

- construir

- Prédio

- construído

- mas a

- botão

- by

- chamado

- CAN

- capital

- carro

- cartão

- carrossel

- casas

- casos

- CAT

- alterar

- chocolate

- Escolha

- escolha

- Cidades

- clássico

- código

- coleção

- combinado

- combina

- vem

- vinda

- comercial

- Empresa

- realização

- computador

- Visão de Computador

- conferências

- confiante

- Configuração

- considerado

- constante

- formação

- não contenho

- Recipiente

- contém

- conteúdo

- contextual

- continuar

- continuamente

- ao controle

- controles

- Conveniente

- Conversa

- custos

- país

- coragem

- cobrir

- crio

- criado

- Criatividade

- cultural

- Cultura

- copo

- Clientes

- personalização

- personalizar

- dados,

- segurança dos dados

- dedicado

- dedicação

- Padrão

- definir

- Entrega

- implantar

- implantado

- Implantação

- desenvolvimento

- implanta

- Design

- projetado

- desejado

- destino

- destinos

- detalhes

- desenvolver

- desenvolvido

- Developer

- em desenvolvimento

- Desenvolvimento

- Diálogo

- diferença

- diferente

- difícil

- descobrir

- distintivo

- do

- documentários

- fazer

- feito

- não

- duplicou

- down

- Duque

- Universidade Duke

- durante

- e

- cada

- Mais cedo

- facilmente

- fácil

- Edward

- einstein

- ou

- permitir

- permitindo

- final

- end-to-end

- Ponto final

- Engenharia

- Inglês

- desfrutar

- suficiente

- garantir

- Meio Ambiente

- equipamento

- Ether

- Mesmo

- eventos

- todos

- exemplo

- exemplos

- animado

- vasta experiência

- experimentar

- experimentos

- expresso

- FALHA

- fracassado

- feira

- falso

- família

- famoso

- longe

- façanha

- destaque

- Funcionalidades

- retornos

- pés

- poucos

- filmes

- final

- Finalmente

- Encontre

- Primeiro nome

- navio almirante

- Flutuador

- Fluxos

- concentra-se

- seguinte

- Escolha

- para a frente

- encontrado

- Foundation

- quatro

- França

- Francês

- da

- totalmente

- mais distante

- futuro

- Geral

- gerar

- gerado

- geração

- generativo

- IA generativa

- ter

- OFERTE

- vidro

- Global

- Go

- vai

- gráficos

- ótimo

- maior

- inovador

- Cresça:

- orientações

- guia

- tinha

- Alças

- aconteceu

- feliz

- Queijos duros

- trabalho duro

- Ter

- ter

- he

- cabeça

- ajudar

- ajuda

- ajuda

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- hi

- Alta

- superior

- sua

- histórico

- história

- habitação

- Como funciona o dobrador de carta de canal

- Como Negociar

- HTML

- HTTPS

- Hub

- humano

- i

- icônico

- idéia

- if

- ii

- Illinois

- Impacto

- importar

- importante

- impressionante

- in

- incluir

- inclui

- Incluindo

- Incorporado

- INFORMAÇÕES

- Infraestrutura

- inicialmente

- entrada

- inspirado

- inspiradora

- instância

- imediatamente

- instruções

- integrado

- Pretendido

- interesses

- Interface

- para dentro

- isolado

- IT

- ESTÁ

- viagem

- jpg

- apenas por

- manutenção

- manteve

- Chave

- Tipo

- Saber

- conhecido

- aterrissagem

- ponto de referência

- língua

- grande

- em grande escala

- maior

- Sobrenome

- Atrasado

- lançamento

- Leis

- Liderança

- APRENDER

- Aprenda e Cresça

- aprendizagem

- mínimo

- menos

- níveis

- Licença

- vida

- leve

- como

- LIMITE

- listas

- literatura

- ll

- lhama

- lógica

- longo

- muito tempo

- procurando

- OLHARES

- gosta,

- amado

- diminuir

- máquina

- aprendizado de máquina

- moldadas

- fazer

- FAZ

- Fazendo

- de grupos

- Gerente

- muitos

- maravilha

- Importância

- máximo

- Posso..

- significado

- a medida

- Mídia

- média

- mencionado

- mensagem

- Meta

- mícron

- minuto

- Minutos

- mistura

- ML

- MLOps

- Móvel Esteira

- modelo

- modelos

- momento

- mês

- mais

- a maioria

- Mais populares

- movimento

- filme

- muito

- museu

- Museus

- Música

- nome

- natural

- necessário

- você merece...

- necessário

- rede

- Novo

- New York

- Próximo

- não

- caderno

- agora

- número

- numeroso

- NY

- of

- oferecer

- oferecendo treinamento para distância

- Oferece

- AZEITE E AZEITE EVO

- on

- uma vez

- ONE

- só

- aberto

- open source

- Otimize

- otimizado

- Opção

- or

- Outros

- Outros

- de outra forma

- A Nossa

- Fora

- saída

- Acima de

- global

- página

- pares

- Papel

- papéis

- parâmetro

- parâmetros

- Paris

- parte

- passar

- passou

- passes

- passado

- paz

- Realizar

- atuação

- permanente

- telefone

- fotografias

- Física

- peça

- Pizza

- plástico

- platão

- Inteligência de Dados Platão

- PlatãoData

- desempenhado

- Privacidade

- pop-up

- Popular

- Publique

- postal

- Predictor

- preferências

- preparação

- presente

- anterior

- processo

- processos

- Produto

- desenvolvimento de produtos

- gestão de produtos

- gerente de produto

- Propostas

- orgulhoso

- fornecer

- fornecido

- fornece

- fornecendo

- público

- transporte público

- publicamente

- publicado

- propósito

- colocar

- Python

- Qualcomm

- Frequentes

- Links

- rapidamente

- Rampas

- aleatoriedade

- alcance

- variando

- pronto

- razões

- receber

- receita

- recomendar

- Recomenda

- refere-se

- Independentemente

- regiões

- relativo

- relatividade

- repetido

- representar

- solicitar

- exige

- pesquisa

- investigador

- Recursos

- respectivamente

- Responder

- DESCANSO

- resultar

- Resultados

- Rio

- Tipo

- papéis

- Execute

- corrida

- s

- Segurança

- sábio

- sal

- mesmo

- escalável

- Escala

- Cientista

- cientistas

- Sdk

- SEA

- Pesquisar

- pesquisar

- Seção

- seguro

- segurança

- Vejo

- visto

- parecia

- selecionado

- selecionando

- doadores,

- enviar

- senior

- sentimento

- Série

- Serviços

- de servir

- conjunto

- contexto

- Shape

- tubarão

- minha

- rede de apoio social

- mostrar

- mostrou

- Shows

- desligando

- significado

- periodo

- simples

- simplesmente

- solteiro

- local

- Locais

- SIX

- Tamanho

- Lentamente

- pequeno

- So

- até aqui

- Redes Sociais

- meios de comunicação social

- Soluções

- alguns

- fonte

- Fontes

- especial

- especialistas

- especificada

- velocidade

- fica

- começo

- começado

- Estado

- Unidos

- estatístico

- Passo

- Passos

- parou

- Estratégia

- Tanga

- estrutura

- estudo

- Assombroso

- sujeito

- subseqüente

- sucesso

- entraram com sucesso

- tal

- Suportado

- certo

- símbolo

- .

- mesa

- Tire

- toma

- tarefas

- gosto

- Profissionais

- tecnologia

- Tecnologia

- temporário

- condições

- do que

- obrigado

- que

- A

- O capital

- O Futuro

- A fonte

- o mundo

- deles

- Eles

- teoria

- Lá.

- Este

- deles

- coisas

- think

- isto

- Apesar?

- Através da

- tigre

- tempo

- Séries temporais

- vezes

- Título

- para

- hoje

- juntos

- token

- Tokens

- ferramentas

- topo

- Total

- Torre

- Trem

- Training

- transformador

- traduzir

- Tradução

- transporte

- Trilhão

- tentar

- dois

- tipo

- tipos

- ui

- para

- inesquecível

- único

- universidade

- até

- Atualizar

- Atualizações

- utilizável

- usar

- caso de uso

- usava

- Utilizador

- usuários

- usos

- utilização

- valor

- Valores

- variedade

- versão

- versões

- muito

- via

- Ver

- visualizações

- visão

- Visite a

- visitantes

- volume

- querido

- guerra

- foi

- we

- web

- serviços web

- Web-Based

- Site

- BEM

- Baleia

- O Quê

- O que é a

- quando

- enquanto que

- qual

- enquanto

- porque

- precisarão

- Windows

- de

- Word

- palavras

- Atividades:

- trabalho

- mundo

- reconhecido mundialmente

- embrulho

- anos

- Iorque

- Vocês

- investimentos

- você mesmo

- zefirnet

- Zip