Inteligência artificial (AI) criou furor recentemente com a possibilidade de revolucionar a forma como as pessoas abordam e resolvem diferentes tarefas e problemas complexos. Dos cuidados de saúde às finanças, a IA e os seus modelos de aprendizagem automática associados demonstraram o seu potencial para agilizar processos complexos, melhorar padrões de tomada de decisão e descobrir informações valiosas.

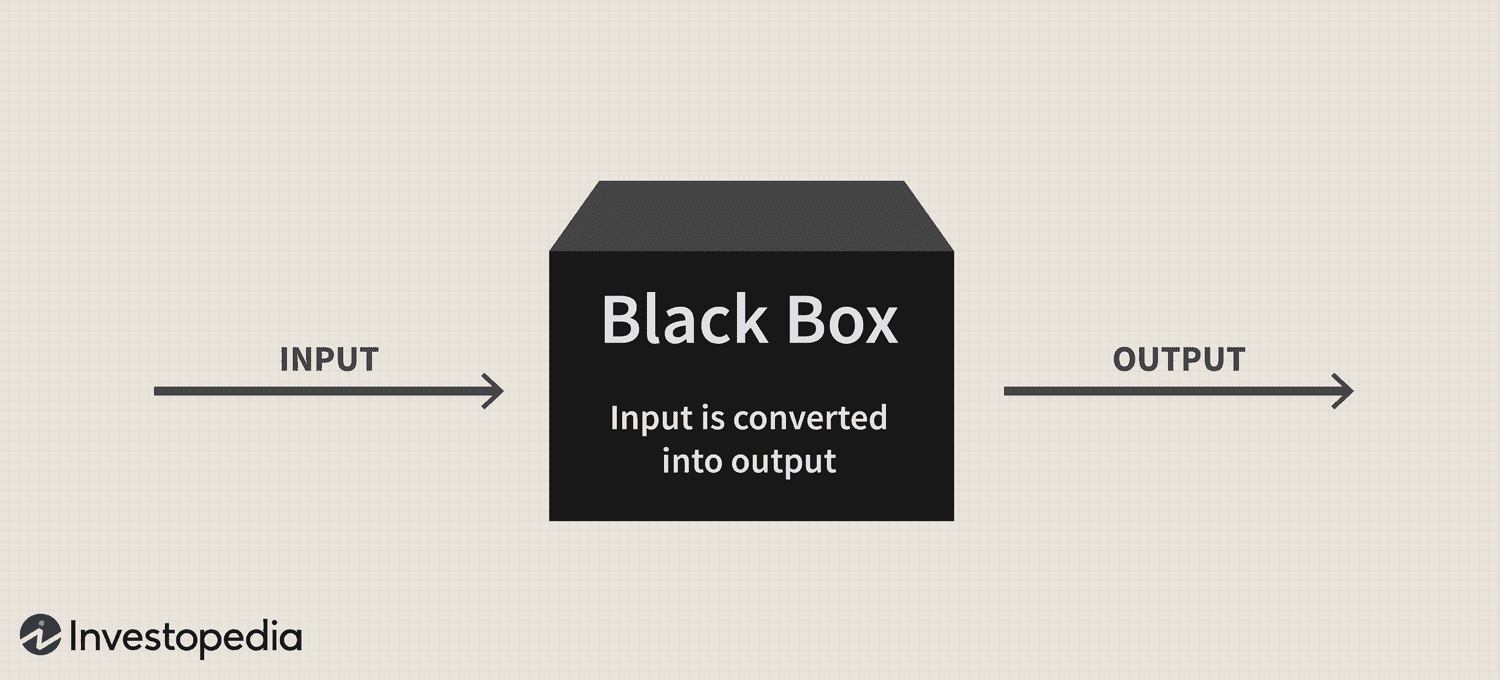

No entanto, apesar do imenso potencial da tecnologia, um persistente problema de “caixa preta” continua a representar um desafio significativo para sua adoção, levantando questões sobre a transparência e interpretabilidade desses sistemas sofisticados.

Em resumo, o problema da caixa preta decorre da dificuldade em entender como os sistemas de IA e os modelos de aprendizado de máquina processam dados e geram previsões ou decisões. Esses modelos geralmente dependem de algoritmos intrincados que não são facilmente compreensíveis para os humanos, levando a uma falta de responsabilidade e confiança.

Portanto, à medida que a IA se torna cada vez mais integrada a vários aspectos de nossas vidas, abordar esse problema é crucial para garantir o uso responsável e ético dessa poderosa tecnologia.

A caixa preta: uma visão geral

A metáfora da “caixa preta” decorre da noção de que os sistemas de IA e os modelos de aprendizado de máquina operam de maneira oculta à compreensão humana, muito parecido com o conteúdo de uma caixa opaca e lacrada. Esses sistemas são construídos sobre modelos matemáticos complexos e conjuntos de dados de alta dimensão, que criam relacionamentos e padrões intrincados que orientam seus processos de tomada de decisão. No entanto, esses trabalhos internos não são prontamente acessíveis ou compreensíveis para os humanos.

Em termos práticos, o problema da caixa preta da IA é a dificuldade de decifrar o raciocínio por trás das previsões ou decisões de um sistema de IA. Esse problema é particularmente prevalente em modelos de aprendizado profundo, como redes neurais, em que várias camadas de nós interconectados processam e transformam dados de maneira hierárquica. A complexidade desses modelos e as transformações não lineares que eles realizam tornam extremamente desafiador rastrear a lógica por trás de seus resultados.

Nikita Brudnov, CEO do BR Group - um painel de análise de marketing baseado em IA - disse ao Cointelegraph que a falta de transparência em como os modelos de IA chegam a certas decisões e previsões pode ser problemática em muitos contextos, como diagnóstico médico, tomada de decisões financeiras e processos legais, impactando significativamente a adoção contínua da IA.

Magazine: Joe Lubin: A verdade sobre a separação dos fundadores da ETH e o 'Crypto Google'

“Nos últimos anos, muita atenção tem sido dada ao desenvolvimento de técnicas para interpretar e explicar decisões tomadas por modelos de IA, como gerar pontuações de importância de recursos, visualizar limites de decisão e identificar explicações hipotéticas contrafactuais”, disse ele, acrescentando:

“No entanto, essas técnicas ainda estão engatinhando e não há garantia de que serão eficazes em todos os casos”.

Brudnov acredita ainda que, com mais descentralização, os reguladores podem exigir que as decisões tomadas pelos sistemas de IA sejam mais transparentes e responsáveis para garantir sua validade ética e justiça geral. Ele também sugeriu que os consumidores podem hesitar em usar produtos e serviços baseados em IA se não entenderem como eles funcionam e seu processo de tomada de decisão.

James Wo, fundador da DFG - uma empresa de investimentos que investe ativamente em tecnologias relacionadas à IA - acredita que a questão da caixa preta não afetará a adoção no futuro previsível. De acordo com Wo, a maioria dos usuários não se importa necessariamente com o funcionamento dos modelos de IA existentes e fica feliz em simplesmente obter utilidade deles, pelo menos por enquanto.

“No médio prazo, quando a novidade dessas plataformas passar, definitivamente haverá mais ceticismo sobre a metodologia da caixa preta. As perguntas também aumentarão à medida que o uso de IA entrar na cripto e na Web3, onde há riscos financeiros e consequências a serem consideradas”, admitiu.

Impacto na confiança e transparência

Um domínio em que a ausência de transparência pode afetar substancialmente a confiança é o diagnóstico médico orientado por IA. Por exemplo, os modelos de IA podem analisar dados médicos complexos na área da saúde para gerar diagnósticos ou recomendações de tratamento. No entanto, quando os médicos e pacientes não conseguem compreender a lógica por trás dessas sugestões, eles podem questionar a confiabilidade e a validade desses insights. Esse ceticismo pode levar ainda mais à hesitação na adoção de soluções de IA, potencialmente impedindo os avanços no atendimento ao paciente e na medicina personalizada.

No domínio financeiro, os sistemas de IA podem ser empregados para pontuação de crédito, detecção de fraude e avaliação de risco. No entanto, o problema da caixa preta pode criar incerteza em relação à justiça e precisão dessas pontuações de crédito ou ao raciocínio por trás dos alertas de fraude, limitando a capacidade da tecnologia de digitalizar o setor.

A indústria criptográfica também enfrenta as repercussões do problema da caixa preta. Por exemplo, ativos digitais e tecnologia blockchain estão enraizados na descentralização, abertura e verificabilidade. Os sistemas de IA que carecem de transparência e interpretabilidade representam uma desconexão entre as expectativas do usuário e a realidade das soluções orientadas por IA neste espaço.

Preocupações regulatórias

Do ponto de vista regulatório, o problema da caixa preta da IA apresenta desafios únicos. Para começar, a opacidade dos processos de IA pode tornar cada vez mais difícil para os reguladores avaliar a conformidade desses sistemas com as regras e diretrizes existentes. Além disso, a falta de transparência pode complicar a capacidade dos reguladores de desenvolver novas estruturas que possam abordar os riscos e desafios apresentados pelos aplicativos de IA.

Os legisladores podem ter dificuldades para avaliar a justiça, o viés e as práticas de privacidade de dados dos sistemas de IA e seu impacto potencial nos direitos do consumidor e na estabilidade do mercado. Além disso, sem uma compreensão clara dos processos de tomada de decisão dos sistemas orientados por IA, os reguladores podem enfrentar dificuldades para identificar possíveis vulnerabilidades e garantir que as salvaguardas apropriadas estejam em vigor para mitigar os riscos.

Um desenvolvimento regulatório notável em relação a esta tecnologia foi a Lei de Inteligência Artificial da União Europeia, que está se aproximando a tornar-se parte do estatuto do bloco depois de chegar a um acordo político provisório em 27 de abril.

Em sua essência, a AI Act visa criar um ambiente confiável e responsável para o desenvolvimento da IA na UE. Os legisladores adotaram um sistema de classificação que classifica diferentes tipos de IA por risco: inaceitável, alto, limitado e mínimo. Essa estrutura foi projetada para abordar várias preocupações relacionadas ao problema da caixa preta da IA, incluindo questões sobre transparência e responsabilidade.

A incapacidade de monitorar e regular com eficácia os sistemas de IA já prejudicou as relações entre diferentes setores e órgãos reguladores.

No início do mês passado, o popular chatbot AI ChatGPT foi banido na Itália por 29 dias, principalmente devido a preocupações com a privacidade levantadas pela agência de proteção de dados do país por suspeitas de violações do Regulamento Geral de Proteção de Dados (GDPR) da UE. No entanto, a plataforma foi autorizada a retomar os seus serviços em 29 de abril, depois que o CEO Sam Altman anunciou que ele e sua equipe haviam tomado medidas específicas para cumprir as exigências do regulador, incluindo a revelação de suas práticas de processamento de dados e a implementação de sua implementação de idade- medidas de bloqueio.

A regulamentação inadequada dos sistemas de IA pode minar a confiança do público nos aplicativos de IA, à medida que os usuários ficam cada vez mais preocupados com preconceitos inerentes, imprecisões e implicações éticas.

Resolvendo o problema da caixa preta

Para resolver o problema da caixa preta da IA de forma eficaz, é essencial empregar uma combinação de abordagens que promovam a transparência, a interpretabilidade e a responsabilidade. Duas dessas estratégias complementares são IA explicável (XAI) e modelos de código aberto.

XAI é uma área de pesquisa dedicada a preencher a lacuna entre a complexidade dos sistemas de IA e a necessidade de interpretabilidade humana. O XAI se concentra no desenvolvimento de técnicas e algoritmos que podem fornecer explicações compreensíveis para humanos para decisões baseadas em IA, oferecendo insights sobre o raciocínio por trás dessas escolhas.

Os métodos frequentemente empregados em XAI incluem modelos substitutos, análise de importância de recursos, análise de sensibilidade e explicações agnósticas de modelos interpretáveis localmente. A implementação do XAI em todos os setores pode ajudar as partes interessadas a entender melhor os processos orientados por IA, aumentando a confiança na tecnologia e facilitando a conformidade com os requisitos regulamentares.

Em conjunto com o XAI, promover a adoção de modelos de IA de código aberto pode ser uma estratégia eficaz para resolver o problema da caixa preta. Os modelos de código aberto concedem acesso total aos algoritmos e dados que impulsionam os sistemas de IA, permitindo que usuários e desenvolvedores examinem e entendam os processos subjacentes.

Essa maior transparência pode ajudar a criar confiança e promover a colaboração entre desenvolvedores, pesquisadores e usuários. Além disso, a abordagem de código aberto pode criar sistemas de IA mais robustos, responsáveis e eficazes.

O problema da caixa preta no espaço criptográfico

O problema da caixa preta tem ramificações significativas para vários aspectos do espaço criptográfico, incluindo estratégias de negociação, previsões de mercado, medidas de segurança, tokenização e contratos inteligentes.

No campo das estratégias de negociação e previsões de mercado, os modelos baseados em IA estão ganhando popularidade à medida que os investidores buscam capitalizar na negociação algorítmica. No entanto, o problema da caixa preta dificulta a compreensão dos usuários sobre como esses modelos funcionam, dificultando a avaliação de sua eficácia e riscos potenciais. Consequentemente, essa opacidade também pode resultar em confiança injustificada em decisões de investimento orientadas por IA ou tornar os investidores excessivamente dependentes de sistemas automatizados.

A IA desempenha um papel crucial no aprimoramento das medidas de segurança no ecossistema blockchain, detectando transações fraudulentas e atividades suspeitas. No entanto, o problema da caixa preta complica o processo de verificação dessas soluções de segurança orientadas por IA. A falta de transparência na tomada de decisões pode corroer a confiança nos sistemas de segurança, levantando preocupações sobre sua capacidade de proteger os ativos e as informações do usuário.

Recente: Consenso 2023: As empresas mostram interesse na Web3, apesar dos desafios regulatórios dos EUA

A tokenização e os contratos inteligentes – dois componentes vitais do ecossistema blockchain – também estão testemunhando uma maior integração da IA. No entanto, o problema da caixa preta pode obscurecer a lógica por trás dos tokens gerados por IA ou da execução de contratos inteligentes.

À medida que a IA revoluciona vários setores, abordar o problema da caixa preta está se tornando mais urgente. Ao promover a colaboração entre pesquisadores, desenvolvedores, formuladores de políticas e partes interessadas do setor, soluções podem ser desenvolvidas para promover transparência, responsabilidade e confiança nos sistemas de IA. Assim, será interessante ver como esse novo paradigma tecnológico continua a evoluir.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoAiStream. Inteligência de Dados Web3. Conhecimento Amplificado. Acesse aqui.

- Cunhando o Futuro com Adryenn Ashley. Acesse aqui.

- Compre e venda ações em empresas PRE-IPO com PREIPO®. Acesse aqui.

- Fonte: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- :tem

- :é

- :não

- :onde

- 2023

- 27

- a

- habilidade

- Sobre

- Acesso

- acessível

- responsabilidade

- responsável

- precisão

- em

- Aja

- ativamente

- atividades

- acrescentando

- Adicionalmente

- endereço

- endereçando

- adotado

- Adotando

- Adoção

- avanços

- afetar

- Depois de

- agência

- Acordo

- AI

- Lei de IA

- Chatbot AI

- Alimentado por AI

- visa

- Alertas

- algorítmico

- negociação algorítmica

- algoritmos

- Todos os Produtos

- já

- tb

- entre

- an

- análise

- analítica

- analisar

- e

- anunciou

- aplicações

- abordagem

- se aproxima

- apropriado

- Abril

- SOMOS

- ÁREA

- por aí

- artificial

- inteligência artificial

- AS

- aspectos

- avaliação

- Ativos

- associado

- At

- por WhatsApp.

- Automatizado

- BE

- tornam-se

- torna-se

- tornando-se

- sido

- atrás

- acredita

- Melhor

- entre

- viés

- vieses

- Preto

- blockchain

- ecossistema blockchain

- tecnologia blockchain

- corpos

- livro

- limites

- Caixa

- ponte

- construir

- ganhar confiança

- construído

- negócios

- by

- CAN

- não podes

- capitalizar

- Cuidado

- casos

- Chefe executivo

- certo

- desafiar

- desafios

- desafiante

- chatbot

- ChatGPT

- escolhas

- classificação

- sistema de classificação

- remover filtragem

- médicos

- Cointelegraph

- colaboração

- combinação

- complementar

- integrações

- complexidade

- compliance

- componentes

- compreender

- preocupado

- Preocupações

- Consequências

- Consequentemente

- Considerar

- consumidor

- Direitos do consumidor

- Consumidores

- conteúdo

- Contextos

- continuou

- continua

- contract

- contratos

- núcleo

- poderia

- país

- crio

- criado

- crédito

- crucial

- cripto

- Indústria de criptografia

- espaço criptográfico

- painel de instrumentos

- dados,

- privacidade de dados

- informática

- protecção de dados

- conjuntos de dados

- Descentralização

- decisão

- Tomada de Decisão

- decisões

- dedicado

- profundo

- deep learning

- definitivamente

- demandas

- demonstraram

- projetado

- Apesar de

- Detecção

- desenvolver

- desenvolvido

- desenvolvedores

- em desenvolvimento

- Desenvolvimento

- diferente

- difícil

- dificuldades

- Dificuldade

- digital

- Ativos Digitais

- digitalizar

- do

- domínio

- não

- distância

- dois

- facilmente

- ecossistema

- Eficaz

- efetivamente

- eficácia

- empregada

- permitindo

- aumentar

- aprimorando

- garantir

- assegurando

- Entra

- Meio Ambiente

- essencial

- ETH

- considerações éticas

- EU

- Europa

- avaliar

- evolui

- exemplo

- execução

- existente

- expectativas

- explicando

- Rosto

- rostos

- facilitando

- justiça

- Característica

- financiar

- financeiro

- Empresa

- concentra-se

- Escolha

- o previsível

- formulário

- Promover

- fomento

- fundador

- fundadores

- Quadro

- enquadramentos

- fraude

- detecção de fraude

- fraudulento

- da

- cheio

- função

- mais distante

- Além disso

- futuro

- ganhando

- lacuna

- RGPD

- Geral

- dados gerais

- gerar

- gerando

- conceder

- Grupo

- garanta

- guia

- orientações

- tinha

- feliz

- Ter

- he

- saúde

- ajudar

- Alta

- atrapalha

- sua

- Como funciona o dobrador de carta de canal

- Contudo

- HTTPS

- humano

- Humanos

- identificar

- if

- imenso

- Impacto

- impactando

- implementação

- implementação

- implicações

- importância

- in

- incapacidade

- incluir

- Incluindo

- Crescimento

- aumentou

- cada vez mais

- indústrias

- indústria

- INFORMAÇÕES

- inerente

- insights

- integrado

- integração

- Inteligência

- interconectado

- interesse

- interessante

- para dentro

- investimento

- Investidores

- Investe

- emitem

- questões

- IT

- Itália

- ESTÁ

- Falta

- Sobrenome

- legisladores

- camadas

- conduzir

- principal

- aprendizagem

- mínimo

- Legal

- procedimentos legais

- como

- Limitado

- Vidas

- local

- lógica

- máquina

- aprendizado de máquina

- moldadas

- fazer

- Fazendo

- maneira

- muitos

- mercado

- previsões de mercado

- Marketing

- matemático

- Posso..

- medidas

- médico

- dados médicos

- medicina

- Metodologia

- poder

- mínimo

- Mitigar

- modelos

- Monitore

- Mês

- mais

- Além disso

- a maioria

- em movimento

- muito

- múltiplo

- necessariamente

- você merece...

- redes

- redes neurais

- mesmo assim

- Novo

- não

- nós

- notável

- Noção

- romance

- novidade

- agora

- of

- WOW!

- oferecendo treinamento para distância

- frequentemente

- on

- uma vez

- opaco

- open source

- Abertura

- operar

- or

- A Nossa

- global

- pago

- paradigma

- parte

- particularmente

- paciente

- pacientes

- padrões

- Pessoas

- Realizar

- Personalizado

- Lugar

- plataforma

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- Jogar

- formuladores de políticas

- político

- Popular

- popularidade

- possibilidade

- potencial

- potencialmente

- poderoso

- Prática

- práticas

- Previsões

- presente

- presentes

- prevalecente

- principalmente

- política de privacidade

- Problema

- problemas

- Proceedings

- processo

- processos

- em processamento

- Produtos

- a promover

- Promoção

- proteção

- fornecer

- provisório

- público

- confiança publica

- questão

- Frequentes

- angariado

- elevando

- raciocínio

- chegando

- Realidade

- reino

- recentemente

- recentemente

- recomendações

- em relação a

- Regular

- Regulamento

- regulamentos

- Reguladores

- reguladores

- relacionado

- Relacionamentos

- confiabilidade

- depender

- repercussões

- requerer

- Requisitos

- pesquisa

- pesquisadores

- responsável

- resultar

- currículo

- revolucionar

- revoluciona

- direitos

- Risco

- avaliação de risco

- riscos

- uma conta de despesas robusta

- Tipo

- regras

- proteções

- Dito

- Sam

- Sam Altman

- marcar

- segurança

- Medidas de Segurança

- Vejo

- Buscar

- Sensibilidade

- Serviços

- Conjuntos

- mostrar

- periodo

- de forma considerável

- simplesmente

- Ceticismo

- smart

- smart contract

- Smart Contracts

- Soluções

- RESOLVER

- sofisticado

- fonte

- Espaço

- específico

- divisão

- Estabilidade

- partes interessadas

- suporte

- fica

- deriva

- Passos

- Ainda

- estratégias

- Estratégia

- simplificar

- Lutar

- tal

- suspeito

- .

- sistemas

- Tandem

- tarefas

- Profissionais

- tecnologia

- técnicas

- Tecnologias

- Tecnologia

- condições

- que

- A

- deles

- Eles

- Lá.

- Este

- deles

- isto

- para

- tokenization

- Tokens

- Traçar

- Trading

- Estratégias de negociação

- Transações

- Transformar

- transformações

- Transparência

- transparente

- tratamento

- Confiança

- digno de confiança

- Verdade

- dois

- tipos

- Incerteza

- descobrir

- subjacente

- compreender

- compreensível

- compreensão

- único

- sobre

- us

- usar

- Utilizador

- usuários

- utilidade

- Valioso

- vário

- Verificação

- Violações

- vital

- vulnerabilidades

- foi

- Web3

- quando

- qual

- precisarão

- de

- dentro

- sem

- testemunhando

- wo

- Atividades:

- funcionamento

- anos

- zefirnet