A detecção de viés em dados e resultados de modelos é um requisito fundamental para a construção de modelos responsáveis de inteligência artificial (IA) e aprendizado de máquina (ML). Infelizmente, detectar o viés não é uma tarefa fácil para a grande maioria dos profissionais devido ao grande número de maneiras pelas quais ele pode ser medido e os diferentes fatores que podem contribuir para um resultado tendencioso. Por exemplo, uma amostragem desequilibrada dos dados de treinamento pode resultar em um modelo menos preciso para determinados subconjuntos dos dados. O viés também pode ser introduzido pelo próprio algoritmo de ML - mesmo com um conjunto de dados de treinamento bem balanceado, os resultados podem favorecer determinados subconjuntos de dados em comparação com os outros.

Para detectar o viés, você deve ter uma compreensão completa dos diferentes tipos de viés e os correspondentes métricas de viés. Por exemplo, no momento da redação deste artigo, Esclarecimento do Amazon SageMaker oferece 21 métricas diferentes para escolher.

Nesta postagem, usamos um caso de uso de previsão de renda (prevendo a renda do usuário a partir de recursos de entrada como educação e número de horas trabalhadas por semana) para demonstrar diferentes tipos de vieses e as métricas correspondentes no SageMaker Clarify. Também desenvolvemos uma estrutura para ajudá-lo a decidir quais métricas são importantes para sua aplicação.

Introdução ao SageMaker Clarify

Os modelos de ML estão sendo cada vez mais usados para ajudar a tomar decisões em vários domínios, como serviços financeiros, saúde, educação e recursos humanos. Em muitas situações, é importante entender por que o modelo de ML fez uma previsão específica e também se as previsões foram afetadas por viés.

O SageMaker Clarify fornece ferramentas para essas duas necessidades, mas neste post nos concentramos apenas na funcionalidade de detecção de viés. Para saber mais sobre explicabilidade, confira Explicando os fatos da partida da Bundesliga xGoals usando o Amazon SageMaker Clarify.

O SageMaker Clarify faz parte do Amazon Sage Maker, que é um serviço totalmente gerenciado para criar, treinar e implantar modelos de ML.

Exemplos de perguntas sobre preconceito

Para fundamentar a discussão, a seguir estão alguns exemplos de perguntas que os construtores de ML e suas partes interessadas podem ter em relação ao viés. A lista consiste em algumas perguntas gerais que podem ser relevantes para vários aplicativos de ML, bem como perguntas sobre aplicativos específicos, como recuperação de documentos.

Você pode perguntar, considerando os grupos de interesse nos dados de treinamento (por exemplo, homens x mulheres), quais métricas devo usar para responder às seguintes perguntas:

- A representação do grupo nos dados de treinamento reflete o mundo real?

- Os rótulos de destino nos dados de treinamento favorecem um grupo sobre o outro, atribuindo-lhe rótulos mais positivos?

- O modelo tem precisão diferente para grupos diferentes?

- Em um modelo cujo objetivo é identificar candidatos qualificados para contratação, o modelo tem a mesma precisão para diferentes grupos?

- Em um modelo cujo objetivo é recuperar documentos relevantes para uma consulta de entrada, o modelo recupera documentos relevantes de diferentes grupos na mesma proporção?

No restante deste post, desenvolvemos uma estrutura sobre como considerar responder a essas e outras perguntas por meio das métricas disponíveis no SageMaker Clarify.

Caso de uso e contexto

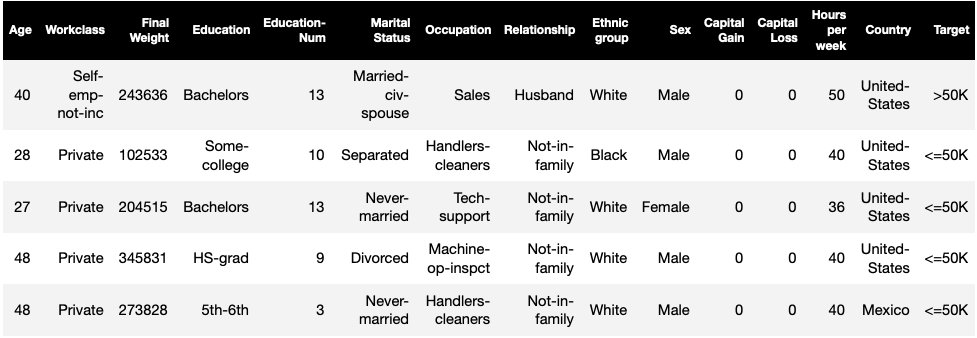

Esta postagem usa um exemplo existente de um trabalho do SageMaker Clarify do Imparcialidade e explicabilidade com o notebook SageMaker Clarify e explica os valores de métrica de viés gerados. O notebook treina um modelo XGBoost no Conjunto de dados UCI Adulto (Dua, D. e Graff, C. (2019). Repositório de aprendizado de máquina UCI. Irvine, CA: Universidade da Califórnia, Escola de Informação e Ciência da Computação).

A tarefa de ML neste conjunto de dados é prever se uma pessoa tem uma renda anual de mais ou menos de US$ 50,000. A tabela a seguir mostra algumas instâncias junto com seus recursos. Medir o viés na previsão de renda é importante porque podemos usar essas previsões para informar decisões como ofertas de desconto e marketing direcionado.

Terminologia de viés

Antes de mergulhar mais fundo, vamos rever algumas terminologias essenciais. Para obter uma lista completa de termos, consulte Amazon SageMaker esclarece termos de preconceito e justiça.

- O rótulo – O recurso de destino que o modelo de ML é treinado para prever. Um rótulo observado refere-se ao valor do rótulo observado nos dados usados para treinar ou testar o modelo. UMA rótulo previsto é o valor previsto pelo modelo de ML. Os rótulos podem ser binários e geralmente são codificados como 0 e 1. Assumimos que 1 representa um rótulo favorável ou positivo (por exemplo, renda maior ou igual a US$ 50,000) e 0 para representar um rótulo desfavorável ou negativo. Os rótulos também podem consistir em mais de dois valores. Mesmo nesses casos, um ou mais valores constituem rótulos favoráveis. Por uma questão de simplicidade, este post considera apenas rótulos binários. Para obter detalhes sobre como lidar com rótulos com mais de dois valores e rótulos com valores contínuos (por exemplo, em regressão), consulte Artigo de justiça e explicabilidade da Amazon AI.

- Faceta – Uma coluna ou recurso em relação ao qual o viés é medido. Em nosso exemplo, a faceta é

sexe assume dois valores:womaneman, codificado comofemaleemalenos dados (esses dados são extraídos do Censo de 1994 e impõem uma opção binária). Embora o post considere uma única faceta com apenas dois valores, para casos mais complexos envolvendo múltiplas facetas ou facetas com mais de dois valores, consulte Artigo de justiça e explicabilidade da Amazon AI. - Viés – Um desequilíbrio significativo nos dados de entrada ou previsões do modelo em diferentes valores de faceta. O que constitui “significativo” depende da sua aplicação. Para a maioria das métricas, um valor de 0 não implica em desequilíbrio. As métricas de viés no SageMaker Clarify são divididas em duas categorias:

- Pré treino – Quando presente, o viés pré-treinamento indica apenas desequilíbrios nos dados.

- Pós treino – O viés pós-treinamento considera adicionalmente as previsões dos modelos.

Vamos examinar cada categoria separadamente.

Viés de pré-treinamento

Métricas de viés de pré-treinamento no SageMaker Clarify respondem à seguinte pergunta: Todos os valores de faceta têm representação igual (ou semelhante) nos dados? É importante inspecionar os dados quanto ao viés pré-treinamento, pois isso pode se traduzir em viés pós-treinamento nas previsões do modelo. Por exemplo, um modelo treinado em dados desequilibrados em que um valor de faceta aparece muito raramente pode apresentar uma precisão substancialmente pior para esse valor de faceta. A representação igual pode ser calculada sobre o seguinte:

- Todos os dados de treinamento, independentemente dos rótulos

- O subconjunto dos dados de treinamento apenas com rótulos positivos

- Cada etiqueta separadamente

A figura a seguir fornece um resumo de como cada métrica se encaixa em cada uma das três categorias.

Algumas categorias consistem em mais de uma métrica. As métricas básicas (caixas cinzas) respondem à pergunta sobre viés nessa categoria da forma mais simples. Métricas em caixas brancas também cobrem casos especiais (por exemplo, o paradoxo de Simpson) e preferências do usuário (por exemplo, focando em certas partes da população ao calcular o desempenho preditivo).

Representação de valor de faceta, independentemente de rótulos

A única métrica nesta categoria é o Desequilíbrio de Classe (CI). O objetivo dessa métrica é medir se todos os valores de faceta têm representação igual nos dados.

IC é a diferença na fração dos dados constituídos pelos dois valores das facetas. Em nosso conjunto de dados de exemplo, para a faceta sex, a divisão (mostrada no gráfico de pizza) mostra que as mulheres constituem 32.4% dos dados de treinamento, enquanto os homens constituem 67.6%. Como resultado:

CI = 0.676 - 0.324 = 0.352

Um desequilíbrio de classe severamente alto pode levar a um desempenho preditivo pior para o valor da faceta com representação menor.

Representação de valor de faceta apenas no nível de rótulos positivos

Outra maneira de medir a representação igual é verificar se todos os valores de faceta contêm uma fração semelhante de amostras com rótulos observados positivos. Os rótulos positivos consistem em resultados favoráveis (por exemplo, empréstimo concedido, selecionado para o trabalho), portanto, analisar os rótulos positivos separadamente ajuda a avaliar se as decisões favoráveis são distribuídas uniformemente.

Em nosso conjunto de dados de exemplo, os rótulos observados são divididos em valores positivos e negativos, conforme mostrado na figura a seguir.

11.4% de todas as mulheres e 31.4% de todos os homens têm o rótulo positivo (região sombreada nas barras esquerda e direita). A Diferença em Proporções Positivas em Rótulos (DPL) mede essa diferença.

DPL = 0.314 - 0.114 = 0.20

A métrica avançada nesta categoria, Disparidade Demográfica Condicional em Rótulos (CDDL), mede as diferenças nos rótulos positivos, mas as estratifica em relação a outra variável. Essa métrica ajuda a controlar o Paradoxo de Simpson, um caso em que um cálculo sobre todos os dados mostra viés, mas o viés desaparece ao agrupar os dados em relação a algumas informações secundárias.

A Estudo de Admissão da UC Berkeley de 1973 fornece um exemplo. De acordo com os dados, os homens foram admitidos em uma taxa maior do que as mulheres. No entanto, quando examinadas no nível de departamentos universitários individuais, as mulheres foram admitidas em taxas semelhantes ou mais altas em cada departamento. Essa observação pode ser explicada pelo paradoxo de Simpson, que surgiu aqui porque as mulheres se candidataram a escolas mais competitivas. Como resultado, menos mulheres foram admitidas em geral em comparação com os homens, embora escola por escola tenham sido admitidas em uma taxa semelhante ou superior.

Para obter mais detalhes sobre como o CDDL é calculado, consulte Artigo de justiça e explicabilidade da Amazon AI.

Representação de valor de faceta no nível de cada rótulo separadamente

A igualdade na representação também pode ser medida para cada rótulo individual, não apenas para o rótulo positivo.

As métricas nesta categoria calculam a diferença na distribuição de rótulos de diferentes valores de faceta. A distribuição de rótulo para um valor de atributo contém todos os valores de rótulo observados, juntamente com a fração de amostras com o valor desse rótulo. Por exemplo, na figura que mostra as distribuições de rótulos, 88.6% das mulheres têm um rótulo observado negativo e 11.4% têm um rótulo observado positivo. Portanto, a distribuição de rótulos para mulheres é [0.886, 0.114] e para homens é [0.686, 0.314].

A métrica básica nesta categoria, divergência de Kullback-Leibler (KL), mede essa diferença como:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

As métricas avançadas nesta categoria, divergência de Jensen-Shannon (JS), Lp-norm (LP), Distância de Variação Total (TVD) e Kolmogorov-Smirnov (KS), também medem a diferença entre as distribuições, mas possuem propriedades matemáticas diferentes. Salvo casos especiais, eles fornecerão insights semelhantes ao KL. Por exemplo, embora o valor KL possa ser infinito quando um valor de faceta não contém amostras com determinados rótulos (por exemplo, nenhum homem com rótulo negativo), JS evita esses valores infinitos. Para obter mais detalhes sobre essas diferenças, consulte Artigo de justiça e explicabilidade da Amazon AI.

Relação entre DPL (Categoria 2) e métricas baseadas em distribuição de KL/JS/LP/TVD/KS (Categoria 3)

Métricas baseadas em distribuição são mais naturalmente aplicáveis a rótulos não binários. Para rótulos binários, devido ao fato de que o desequilíbrio no rótulo positivo pode ser usado para calcular o desequilíbrio no rótulo negativo, as métricas de distribuição fornecem os mesmos insights que o DPL. Portanto, você pode usar DPL nesses casos.

Viés pós-treinamento

As métricas de viés pós-treinamento no SageMaker Clarify nos ajudam a responder a duas perguntas principais:

- Todos os valores de faceta são representados em uma taxa semelhante em previsões de modelo positivas (favoráveis)?

- O modelo tem desempenho preditivo semelhante para todos os valores de faceta?

A figura a seguir mostra como as métricas são mapeadas para cada uma dessas perguntas. A segunda pergunta pode ser mais detalhada dependendo de qual rótulo o desempenho é medido em relação.

Representação igual em previsões de modelo positivo

As métricas nesta categoria verificam se todos os valores de faceta contêm uma fração semelhante de amostras com rótulo previsto positivo pelo modelo. Essa classe de métricas é muito semelhante às métricas de pré-treinamento de DPL e CDDL – a única diferença é que essa categoria considera rótulos previstos em vez de rótulos observados.

Em nosso conjunto de dados de exemplo, 4.5% de todas as mulheres recebem o rótulo positivo pelo modelo e 13.7% de todos os homens recebem o rótulo positivo.

A métrica básica nesta categoria, Diferença em proporções positivas em rótulos previstos (DPPL), mede a diferença nas atribuições de classe positivas.

DPPL = 0.137 - 0.045 = 0.092

Observe como nos dados de treinamento, uma fração maior de homens teve um rótulo observado positivo. De maneira semelhante, uma fração maior de homens recebe um rótulo positivo previsto.

Passando para as métricas avançadas nesta categoria, o Disparate Impact (DI) mede a mesma disparidade em atribuições de classe positivas, mas em vez da diferença, ele calcula a proporção:

DI = 0.045 / 0.137 = 0.328

Tanto o DI quanto o DPPL transmitem percepções qualitativamente semelhantes, mas diferem em alguns casos de canto. Por exemplo, as razões tendem a explodir em números muito grandes se o denominador for pequeno. Tomemos um exemplo dos números 0.1 e 0.0001. A razão é 0.1/0.0001 = 10,000, enquanto a diferença é 0.1 – 0.0001 ≈ 0.1. Ao contrário das outras métricas em que um valor de 0 não implica em nenhum viés, para DI, nenhum viés corresponde a um valor de 1.

Disparidade Demográfica Condicional em Rótulos Previstos (CDDPL) mede a disparidade na representação de valor de faceta no rótulo positivo, mas assim como a métrica de pré-treinamento de CDDL, ela também controla o paradoxo de Simpson.

Contrafactual Fliptest (FT) mede se amostras semelhantes dos dois valores de faceta recebem decisões semelhantes do modelo. Um modelo que atribui decisões diferentes a duas amostras que são semelhantes entre si, mas diferem nos valores de faceta, pode ser considerado tendencioso em relação ao valor de faceta que recebe o rótulo desfavorável (negativo). Dado o primeiro valor de faceta (mulheres), ele avalia se membros semelhantes com o outro valor de faceta (homens) têm uma previsão de modelo diferente. Membros semelhantes são escolhidos com base no algoritmo de k-vizinhos mais próximos.

Desempenho igual

As previsões do modelo podem ter uma representação semelhante em rótulos positivos de diferentes valores de faceta, mas o desempenho do modelo nesses grupos pode diferir significativamente. Em muitos aplicativos, pode ser desejável ter um desempenho preditivo semelhante em diferentes valores de faceta. As métricas nesta categoria medem a diferença no desempenho preditivo entre os valores de atributo.

Como os dados podem ser divididos de muitas maneiras diferentes com base nos rótulos observados ou previstos, há muitas maneiras diferentes de medir o desempenho preditivo.

Desempenho preditivo igual, independentemente dos rótulos

Você pode considerar o desempenho do modelo em todos os dados, independentemente dos rótulos observados ou previstos – ou seja, a precisão geral.

As figuras a seguir mostram como o modelo classifica as entradas dos dois valores de faceta em nosso conjunto de dados de exemplo. Os verdadeiros negativos (TN) são casos em que o rótulo observado e o previsto foram 0. Os falsos positivos (FP) são classificações incorretas em que o rótulo observado era 0, mas o rótulo previsto era 1. Os verdadeiros positivos (TP) e os falsos negativos (FN) são definidos similarmente.

|

|

Para cada valor de faceta, o desempenho geral do modelo, ou seja, a precisão para esse valor de faceta, é:

Precisão = (TN + TP) / (TN + FP + FN + TP)

Com esta fórmula, a precisão para mulheres é de 0.930 e para homens é de 0.815. Isso leva à única métrica nesta categoria, Diferença de precisão (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 significa que a precisão para ambos os grupos é a mesma. Valores maiores (positivos ou negativos) indicam maiores diferenças na precisão.

Desempenho igual apenas em rótulos positivos

Você pode restringir a análise de desempenho do modelo apenas a rótulos positivos. Por exemplo, se a aplicação é para detectar defeitos em uma linha de montagem, pode ser desejável verificar se as peças não defeituosas (rótulo positivo) de diferentes tipos (valores de faceta) são classificadas como não defeituosas na mesma proporção. Essa quantidade é chamada de recall, ou taxa de verdadeiro positivo:

Recordar = TP / (TP + FN)

Em nosso conjunto de dados de exemplo, o recall para mulheres é 0.389 e o recall para homens é 0.425. Isso leva à métrica básica nesta categoria, a Diferença de Recall (RD):

RD = 0.425 - 0.389 = 0.036

Agora vamos considerar as três métricas avançadas nesta categoria, ver quais preferências do usuário elas codificam e como elas diferem da métrica básica de RD.

Primeiro, em vez de medir o desempenho nos rótulos positivos observados, você pode medi-lo nos rótulos positivos previstos. Dado um valor de faceta, como mulheres, e todas as amostras com esse valor de faceta que são previstas como positivas pelo modelo, quantas são realmente classificadas corretamente como positivas? Essa quantidade é chamada de taxa de aceitação (AR), ou precisão:

AR = TP / (TP + FP)

Em nosso exemplo, o AR para mulheres é 0.977 e o AR para homens é 0.970. Isso leva à Diferença na Taxa de Aceitação (DAR):

DAR = 0.970 - 0.977 = -0.007

Outra maneira de medir o viés é combinar as duas métricas anteriores e medir quantas previsões mais positivas os modelos atribuem a um valor de faceta em comparação com os rótulos positivos observados. O SageMaker Clarify mede essa vantagem pelo modelo como a razão entre o número de rótulos positivos observados para esse valor de faceta e o número de rótulos positivos previstos, e se refere a isso como aceitação condicional (CA):

CA = (TP + FN) / (TP + FP)

Em nosso exemplo, a CA para mulheres é 2.510 e para homens é 2.283. A diferença na CA leva à métrica final nesta categoria, Diferença na Aceitação Condicional (DCA):

DCA = 2.283 - 2.510 = -0.227

Desempenho igual apenas em rótulos negativos

De maneira semelhante aos rótulos positivos, o viés também pode ser calculado como a diferença de desempenho nos rótulos negativos. Considerar rótulos negativos separadamente pode ser importante em certas aplicações. Por exemplo, em nosso exemplo de detecção de defeitos, podemos querer detectar peças defeituosas (rótulo negativo) de diferentes tipos (valor de faceta) na mesma taxa.

A métrica básica nesta categoria, especificidade, é análoga à métrica de recall (taxa de verdadeiro positivo). A especificidade calcula a precisão do modelo em amostras com este valor de faceta que têm um rótulo negativo observado:

Especificidade = TN / (TN + FP)

Em nosso exemplo (veja as tabelas de confusão), a especificidade para mulheres e homens é 0.999 e 0.994, respectivamente. Consequentemente, o Diferença de especificidade (SD) é:

SD = 0.994 - 0.999 = -0.005

Seguindo em frente, assim como a métrica da taxa de aceitação, a quantidade análoga para rótulos negativos - a taxa de rejeição (RR) - é:

RR = TN / (TN + FN)

O RR para mulheres é 0.927 e para homens é 0.791, levando à métrica Diferença na Taxa de Rejeição (DRR):

DRR = 0.927 - 0.791 = -0.136

Finalmente, o análogo de rótulo negativo de aceitação condicional, a rejeição condicional (CR), é a razão entre o número de rótulos negativos observados para esse valor de faceta e o número de rótulos negativos previstos:

CR = (TN + FP) / (TN + FN)

O CR para mulheres é 0.928 e para homens é 0.796. A métrica final nesta categoria é a Diferença na Rejeição Condicional (DCR):

DCR = 0.796 - 0.928 = 0.132

Desempenho igual em rótulos positivos e negativos

O SageMaker Clarify combina as duas categorias anteriores considerando a taxa de desempenho do modelo nos rótulos positivos e negativos. Especificamente, para cada valor de faceta, o SageMaker Clarify calcula a proporção entre falsos negativos (FN) e falsos positivos (FP). Em nosso exemplo, a razão FN/FP para mulheres é 679/10 = 67.9 e para homens é 3678/84 = 43.786. Isso leva à métrica de Igualdade de Tratamento (TE), que mede a diferença entre a razão FP/FN:

TE = 67.9 - 43.786 = 24.114

A captura de tela a seguir mostra como você pode usar o SageMaker Clarify com Estúdio Amazon SageMaker para mostrar os valores, bem como intervalos e descrições curtas de diferentes métricas de viés.

Perguntas sobre viés: com quais métricas começar?

Lembre-se dos exemplos de perguntas sobre viés no início deste post. Tendo passado pelas métricas de diferentes categorias, considere as perguntas novamente. Para responder à primeira pergunta, que diz respeito às representações de diferentes grupos nos dados de treinamento, você pode começar com a métrica Class Desbalance (CI). Da mesma forma, para as perguntas restantes, você pode começar examinando Diferença em proporções positivas em rótulos (DPL), Diferença de precisão (AD), Diferença na taxa de aceitação (DAR) e Diferença de recall (RD), respectivamente.

Viés sem valores de faceta

Para facilitar a exposição, esta descrição das métricas pós-treinamento excluiu a métrica Generalized Entropy Index (GE). Essa métrica mede o viés sem considerar o valor da faceta e pode ser útil para avaliar como os erros do modelo são distribuídos. Para detalhes, consulte Entropia Generalizada (GE).

Conclusão

Neste post, você viu como as 21 métricas diferentes no SageMaker Clarify medem o viés em diferentes estágios do pipeline de ML. Você aprendeu sobre várias métricas por meio de um caso de uso de previsão de receita, como escolher métricas para seu caso de uso e com quais você pode começar.

Comece sua jornada de IA responsável avaliando o viés em seus modelos de ML usando o notebook de demonstração Justiça e Explicabilidade com SageMaker Clarify. Você pode encontrar a documentação detalhada do SageMaker Clarify, incluindo a definição formal de métricas, em O que é imparcialidade e explicabilidade do modelo para previsões de aprendizado de máquina. Para a implementação de código aberto das métricas de viés, consulte o Repositório GitHub aws-sagemaker-clarify. Para uma discussão detalhada, incluindo limitações, consulte Artigo de justiça e explicabilidade da Amazon AI.

Sobre os autores

Bilal Zafar é um cientista aplicado na AWS, trabalhando em justiça, explicabilidade e segurança em aprendizado de máquina.

Bilal Zafar é um cientista aplicado na AWS, trabalhando em justiça, explicabilidade e segurança em aprendizado de máquina.

Denis V. Batalov é Arquiteto de Soluções para AWS, especializado em Machine Learning. Ele está na Amazon desde 2005. Denis é PhD na área de IA. Siga-o no Twitter: @dbatalov.

Michele Donini é um cientista aplicado sênior na AWS. Ele lidera uma equipe de cientistas que trabalham em IA responsável e seus interesses de pesquisa são Justiça Algorítmica e Aprendizado de Máquina Explicável.

Michele Donini é um cientista aplicado sênior na AWS. Ele lidera uma equipe de cientistas que trabalham em IA responsável e seus interesses de pesquisa são Justiça Algorítmica e Aprendizado de Máquina Explicável.

- AI

- arte ai

- gerador de arte ai

- ai robô

- Amazon Sage Maker

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- Aprendizado de máquina da AWS

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- escala ai

- sintaxe

- zefirnet