A sumarização é a técnica de condensar informações consideráveis em um formato compacto e significativo e permanece como a pedra angular da comunicação eficiente em nossa era rica em informações. Num mundo cheio de dados, resumir textos longos em breves resumos economiza tempo e ajuda a tomar decisões informadas. A sumarização condensa o conteúdo, economizando tempo e melhorando a clareza ao apresentar as informações de forma concisa e coerente. A sumarização é inestimável para a tomada de decisões e para o gerenciamento de grandes volumes de conteúdo.

Os métodos de sumarização têm uma ampla gama de aplicações atendendo a diversos propósitos, como:

- Agregação de notícias - Agregação de notícias envolve resumir artigos de notícias em um boletim informativo para a indústria de mídia

- Resumo de documento legal - Resumo de documento legal ajuda profissionais jurídicos a extrair informações jurídicas importantes de documentos extensos, como termos, condições e contratos

- Pesquisa acadêmica – A sumarização anota, indexa, condensa e simplifica informações importantes de artigos acadêmicos

- Curadoria de conteúdo para blogs e sites – Você pode criar resumos de conteúdo originais e envolventes para os leitores, especialmente em marketing

- Relatórios financeiros e análises de mercado – Você pode extrair insights financeiros a partir de relatórios e criar resumos executivos para apresentações a investidores no setor financeiro

Com os avanços no processamento de linguagem natural (PNL), modelos de linguagem e IA generativa, resumir textos de tamanhos variados tornou-se mais acessível. Ferramentas como LangChain, combinado com um modelo de linguagem grande (LLM) desenvolvido por Rocha Amazônica or JumpStart do Amazon SageMaker, simplificar o processo de implementação.

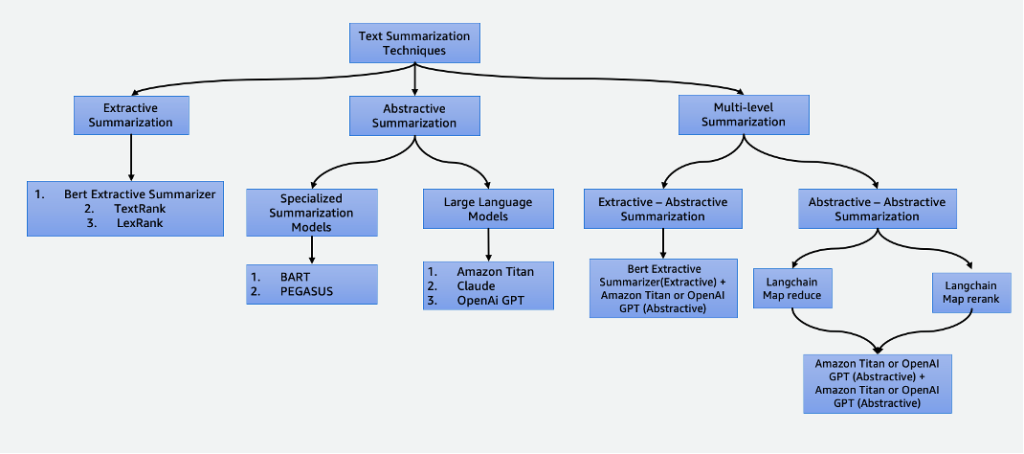

Esta postagem se aprofunda nas seguintes técnicas de resumo:

- Sumarização extrativa usando o resumidor extrativo BERT

- Sumarização abstrativa usando modelos de sumarização especializados e LLMs

- Duas técnicas de resumo multinível:

- Sumarização extrativo-abstrativa usando a estratégia de resumo de conteúdo extrativo-abstrativo (EACSS)

- Resumo abstrativo-abstrativo usando Map Reduce e Map ReRank

O exemplo de código completo é encontrado no GitHub repo. Você pode lançar esta solução in Estúdio Amazon SageMaker.

Clique aqui para abrir o console AWS e acompanhar.

Tipos de resumos

Existem várias técnicas para resumir texto, que são amplamente categorizadas em duas abordagens principais: extrativista e abstrativo resumo. Além disso, as metodologias de sumarização multinível incorporam uma série de etapas, combinando técnicas extrativas e abstrativas. Essas abordagens multiníveis são vantajosas ao lidar com textos com tokens maiores que o limite de um LLM, permitindo a compreensão de narrativas complexas.

Resumo extrativo

O resumo extrativo é uma técnica usada na PNL e na análise de texto para criar um resumo por meio da extração de frases-chave. Em vez de gerar novas frases ou conteúdos como na sumarização abstrativa, a sumarização extrativa depende da identificação e extração das partes mais relevantes e informativas do texto original para criar uma versão condensada.

A sumarização extrativa, embora vantajosa por preservar o conteúdo original e garantir alta legibilidade ao extrair diretamente frases importantes do texto fonte, tem limitações. Falta-lhe criatividade, é incapaz de gerar frases novas e pode ignorar detalhes sutis, potencialmente perdendo informações importantes. Além disso, pode produzir resumos extensos, às vezes sobrecarregando os leitores com informações excessivas e indesejadas. Existem muitas técnicas de sumarização extrativa, como Classificação de texto e LexRank. Neste post, nos concentramos no resumidor extrativo BERT.

Resumidor extrativo BERT

A Resumidor extrativo BERT é um tipo de modelo de sumarização extrativa que utiliza o modelo de linguagem BERT para extrair as frases mais importantes de um texto. BERT é um modelo de linguagem pré-treinado que pode ser ajustado para uma variedade de tarefas, incluindo resumo de texto. Funciona primeiro incorporando as frases no texto usando BERT. Isso produz uma representação vetorial para cada frase que captura seu significado e contexto. O modelo então usa um algoritmo de agrupamento para agrupar as sentenças em agrupamentos. As sentenças que estão mais próximas do centro de cada cluster são selecionadas para formar o resumo.

Comparado com LLMs, a vantagem do resumidor extrativo BERT é que ele é relativamente simples de treinar e implantar o modelo e é mais explicável. A desvantagem é que o resumo não é criativo e não gera frases. Ele seleciona apenas frases do texto original. Isso limita sua capacidade de resumir textos complexos ou matizados.

Resumo abstrativo

O resumo abstrativo é uma técnica usada na PNL e na análise de texto para criar um resumo que vai além da mera extração de sentenças ou frases do texto fonte. Em vez de selecionar e reorganizar o conteúdo existente, a sumarização abstrativa gera novas sentenças ou frases que capturam o significado central e as ideias principais do texto original de uma forma mais condensada e coerente. Esta abordagem exige que o modelo compreenda o conteúdo do texto e o expresse de uma forma que não está necessariamente presente no material de origem.

Modelos de resumo especializados

Esses modelos de linguagem natural pré-treinados, como BART e PEGASUS, são adaptados especificamente para tarefas de resumo de texto. Eles empregam arquiteturas codificador-decodificador e são menores em parâmetros em comparação com seus equivalentes. Esse tamanho reduzido permite facilidade de ajuste fino e implantação em instâncias menores. No entanto, é importante observar que esses modelos de resumo também vêm com tamanhos menores de tokens de entrada e saída. Ao contrário de seus equivalentes de uso mais geral, esses modelos são projetados exclusivamente para tarefas de resumo. Como resultado, a entrada necessária para estes modelos é apenas o texto que precisa ser resumido.

Modelos de grande linguagem

A modelo de linguagem grande refere-se a qualquer modelo que passa por treinamento em conjuntos de dados extensos e diversos, normalmente por meio de aprendizagem auto-supervisionada em grande escala, e é capaz de ser ajustado para se adequar a uma ampla gama de tarefas posteriores específicas. Esses modelos são maiores em tamanho de parâmetro e apresentam melhor desempenho nas tarefas. Notavelmente, eles apresentam tamanhos de token de entrada substancialmente maiores, alguns indo até 100,000, como o da Antrópico Claude. Para utilizar um desses modelos, a AWS oferece o serviço totalmente gerenciado Amazon Bedrock. Se precisar de mais controle do ciclo de vida de desenvolvimento do modelo, você pode implantar LLMs por meio do SageMaker.

Dada a sua natureza versátil, estes modelos requerem instruções de tarefas específicas fornecidas através de texto de entrada, uma prática referida como engenharia imediata. Este processo criativo produz resultados variados com base no tipo de modelo e no texto de entrada. A eficácia do desempenho do modelo e a qualidade do prompt influenciam significativamente a qualidade final dos resultados do modelo. A seguir estão algumas dicas quando a engenharia solicita um resumo:

- Inclua o texto para resumir – Insira o texto que precisa ser resumido. Isso serve como material de origem para o resumo.

- Defina a tarefa – Deixe claro que o objetivo é a sumarização do texto. Por exemplo, “Resuma o seguinte texto: [texto de entrada]”.

- Fornecer contexto – Ofereça uma breve introdução ou contexto para o texto fornecido que precisa ser resumido. Isso ajuda o modelo a compreender o conteúdo e o contexto. Por exemplo, “Você recebeu o seguinte artigo sobre Inteligência Artificial e seu papel na área da saúde: [texto de entrada].”

- Solicitar o resumo – Solicita ao modelo que gere um resumo do texto fornecido. Seja claro sobre o tamanho ou formato desejado do resumo. Por exemplo, “Por favor, gere um resumo conciso do artigo fornecido sobre Inteligência Artificial e seu papel na Saúde: [texto de entrada].”

- Definir restrições ou diretrizes de comprimento – Opcionalmente, oriente o comprimento do resumo especificando uma contagem de palavras, contagem de frases ou limite de caracteres desejado. Por exemplo, “Gere um resumo com no máximo 50 palavras: [texto de entrada].”

A engenharia imediata e eficaz é fundamental para garantir que os resumos gerados sejam precisos, relevantes e alinhados com a tarefa de resumo pretendida. Refine a solicitação para obter resultados de resumo ideais com experimentos e iterações. Depois de estabelecer a eficácia dos prompts, você poderá reutilizá-los com o uso de modelos de prompt.

Resumo multinível

Resumos extrativos e abstrativos são úteis para textos mais curtos. No entanto, quando o texto de entrada excede o limite máximo de tokens do modelo, a sumarização multinível torna-se necessária. A sumarização multinível envolve uma combinação de várias técnicas de sumarização, como métodos extrativos e abstrativos, para condensar efetivamente textos mais longos, aplicando múltiplas camadas de processos de sumarização. Nesta seção, discutimos duas técnicas de resumo multinível: resumo extrativo-abstrativo e resumo abstrativo-abstrativo.

Resumo extrativo-abstrativo

A sumarização extrativo-abstrativa funciona gerando primeiro um resumo extrativo do texto. Em seguida, utiliza um sistema de sumarização abstrativa para refinar o resumo extrativo, tornando-o mais conciso e informativo. Isto aumenta a precisão, fornecendo resumos mais informativos em comparação com os métodos extrativos isolados.

Estratégia de resumo de conteúdo extrativo-abstrativo

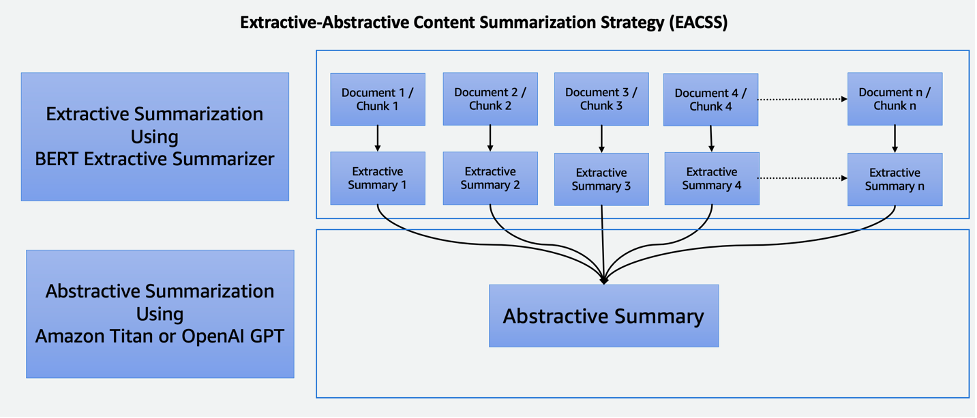

A técnica EACSS combina os pontos fortes de duas técnicas poderosas: o resumidor extrativo BERT para a fase extrativa e os LLMs para a fase abstrativa, conforme ilustrado no diagrama a seguir.

O EACSS oferece diversas vantagens, incluindo a preservação de informações cruciais, maior legibilidade e adaptabilidade. No entanto, a implementação do EACSS é computacionalmente dispendiosa e complexa. Existe o risco de perda potencial de informações, e a qualidade do resumo depende muito do desempenho dos modelos subjacentes, tornando a seleção e o ajuste cuidadosos do modelo essenciais para alcançar resultados ideais. A implementação inclui as seguintes etapas:

- O primeiro passo é dividir o documento grande, como um livro, em seções menores, ou pedaços. Esses pedaços são definidos como frases, parágrafos ou até capítulos, dependendo da granularidade desejada para o resumo.

- Para a fase extrativa, empregamos o resumidor extrativo BERT. Este componente funciona incorporando as sentenças em cada bloco e, em seguida, empregando um algoritmo de agrupamento para identificar as sentenças que estão mais próximas dos centróides do agrupamento. Esta etapa extrativa ajuda a preservar o conteúdo mais importante e relevante de cada bloco.

- Tendo gerado resumos extrativos para cada pedaço, passamos para a fase de resumo abstrativo. Aqui, utilizamos LLMs conhecidos por sua capacidade de gerar resumos coerentes e contextualmente relevantes. Esses modelos tomam os resumos extraídos como entrada e produzem resumos abstrativos que capturam a essência do documento original, garantindo ao mesmo tempo legibilidade e coerência.

Ao combinar técnicas de sumarização extrativas e abstrativas, esta abordagem oferece uma maneira eficiente e abrangente de resumir documentos extensos, como livros. Garante a extração de informações importantes, ao mesmo tempo que permite a geração de resumos concisos e legíveis, tornando-se uma ferramenta valiosa para diversas aplicações no domínio da sumarização de documentos.

Resumo abstrativo-abstrativo

O resumo abstrativo-abstrativo é uma abordagem onde métodos abstrativos são usados para extrair e gerar resumos. Ele oferece vantagens notáveis, incluindo maior legibilidade, coerência e flexibilidade para ajustar o comprimento e os detalhes do resumo. É excelente na geração de linguagem, permitindo parafrasear e evitar redundâncias. No entanto, existem desvantagens. Por exemplo, é computacionalmente dispendioso e intensivo em recursos, e a sua qualidade depende fortemente da eficácia dos modelos subjacentes, que, se não forem bem treinados ou versáteis, podem ter impacto na qualidade dos resumos gerados. A seleção de modelos é crucial para mitigar estes desafios e garantir resumos abstrativos de alta qualidade. Para sumarização abstrativo-abstrativa, discutimos duas estratégias: Map Reduce e Map ReRank.

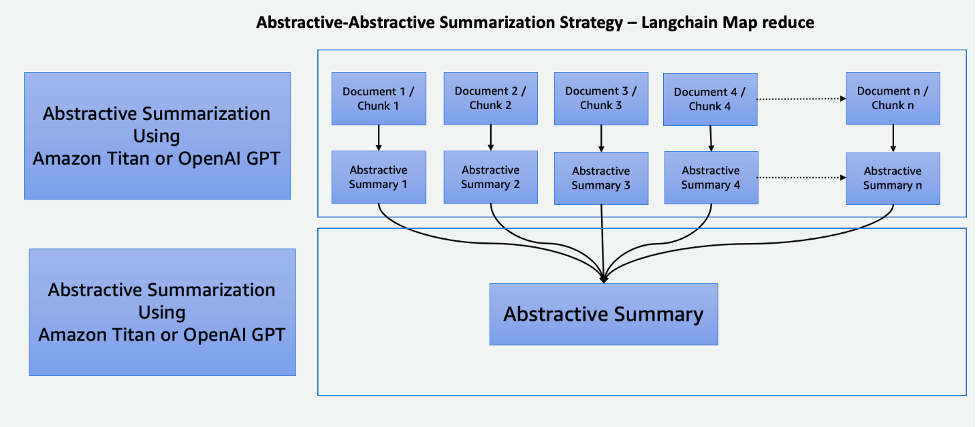

Redução de mapa usando LangChain

Este processo em duas etapas compreende um Etapa de mapa e etapa de redução, conforme ilustrado no diagrama a seguir. Essa técnica permite resumir uma entrada que é maior que o limite de token de entrada do modelo.

O processo consiste em três etapas principais:

- Os corpora são divididos em pedaços menores que se enquadram no limite de token do LLM.

- Usamos uma etapa de Mapa para aplicar individualmente uma cadeia LLM que extrai todas as informações importantes de cada passagem e sua saída é usada como uma nova passagem. Dependendo do tamanho e da estrutura dos corpora, isto pode assumir a forma de temas abrangentes ou de breves resumos.

- A etapa Reduzir combina as passagens de saída da etapa Mapear ou de uma etapa Reduzir de forma que se ajuste ao limite de token e o alimente no LLM. Este processo é repetido até que o resultado final seja uma passagem singular.

A vantagem de usar esta técnica é que ela é altamente escalável e paralelizável. Todo o processamento em cada etapa é independente um do outro, o que aproveita sistemas distribuídos ou serviços sem servidor e menor tempo de computação.

Mapear ReRank usando LangChain

Essa cadeia executa um prompt inicial em cada documento que não apenas tenta concluir uma tarefa, mas também dá uma pontuação de quão certo é sua resposta. A resposta com pontuação mais alta é retornada.

Esta técnica é muito semelhante ao Map Reduce, mas com a vantagem de exigir menos chamadas gerais, agilizando o processo de sumarização. No entanto, sua limitação reside na incapacidade de mesclar informações em vários documentos. Esta restrição torna-o mais eficaz em cenários onde se espera uma resposta única e direta de um documento único, tornando-o menos adequado para tarefas de recuperação de informação mais complexas ou multifacetadas que envolvem múltiplas fontes. A consideração cuidadosa do contexto e da natureza dos dados é essencial para determinar a adequação deste método para necessidades específicas de resumo.

Cohere ReRank usa um sistema de reclassificação baseado em semântica que contextualiza o significado da consulta de um usuário além da relevância da palavra-chave. É usado com sistemas de armazenamento de vetores, bem como em mecanismos de pesquisa baseados em palavras-chave, proporcionando flexibilidade.

Comparando técnicas de resumo

Cada técnica de resumo tem suas próprias vantagens e desvantagens:

- A sumarização extrativa preserva o conteúdo original e garante alta legibilidade, mas carece de criatividade e pode produzir resumos longos.

- O resumo abstrativo, embora ofereça criatividade e gere resumos concisos e fluentes, apresenta o risco de modificação não intencional do conteúdo, desafios na precisão da linguagem e desenvolvimento que consome muitos recursos.

- A sumarização extrativa-abstrativa em vários níveis resume efetivamente documentos grandes e fornece melhor flexibilidade no ajuste fino da parte extrativa dos modelos. No entanto, é caro, demorado e carece de paralelização, tornando o ajuste de parâmetros um desafio.

- O resumo abstrativo-abstrativo em vários níveis também resume efetivamente documentos grandes e se destaca pela legibilidade e coerência aprimoradas. No entanto, é computacionalmente caro e consome muitos recursos, dependendo fortemente da eficácia dos modelos subjacentes.

A seleção cuidadosa do modelo é crucial para mitigar os desafios e garantir resumos abstrativos de alta qualidade nesta abordagem. A tabela a seguir resume os recursos de cada tipo de resumo.

| Aspecto | Resumo Extrativo | Resumo abstrato | Resumo multinível |

| Gere resumos criativos e envolventes | Não | Sim | Sim |

| Preservar o conteúdo original | Sim | Não | Não |

| Equilibre a preservação da informação e a criatividade | Não | Sim | Sim |

| Adequado para texto curto e objetivo (comprimento do texto de entrada menor que o máximo de tokens do modelo) | Sim | Sim | Não |

| Eficaz para documentos mais longos e complexos, como livros (comprimento do texto de entrada maior que o máximo de tokens do modelo) | Não | Não | Sim |

| Combina extração e geração de conteúdo | Não | Não | Sim |

As técnicas de resumo multinível são adequadas para documentos longos e complexos onde o comprimento do texto de entrada excede o limite de token do modelo. A tabela a seguir compara essas técnicas.

| Técnica | Vantagens | Desvantagens |

| EACSS (extrativo-abstrativo) | Preserva informações cruciais, fornece a capacidade de ajustar a parte extrativa dos modelos. | Computacionalmente caro, potencial perda de informações e falta de paralelização. |

| Redução de mapa (abstrativo-abstrativo) | Escalável e paralelizável, com menos tempo de computação. A melhor técnica para gerar resumos criativos e concisos. | Processo intensivo de memória. |

| Map ReRank (abstrativo-abstrativo) | Resumo simplificado com classificação baseada em semântica. | Fusão limitada de informações. |

Dicas ao resumir texto

Considere as seguintes práticas recomendadas ao resumir o texto:

- Esteja ciente do tamanho total do token – Esteja preparado para dividir o texto se ele exceder os limites de token do modelo ou empregar vários níveis de resumo ao usar LLMs.

- Esteja ciente dos tipos e do número de fontes de dados – Combinar informações de múltiplas fontes pode exigir transformações, organização clara e estratégias de integração. Coisas LangChain tem integração em uma ampla variedade de fontes de dados e tipos de documentos. Simplifica o processo de combinação de texto de diferentes documentos e fontes de dados com o uso desta técnica.

- Esteja ciente da especialização do modelo – Alguns modelos podem se destacar em determinados tipos de conteúdo, mas ter dificuldades com outros. Pode haver modelos ajustados que sejam mais adequados ao seu domínio de texto.

- Use o resumo multinível para grandes corpos de texto – Para textos que excedem os limites de token, considere uma abordagem de resumo multinível. Comece com um resumo de alto nível para capturar as ideias principais e depois resumir progressivamente as subseções ou capítulos para obter insights mais detalhados.

- Resuma o texto por tópicos – Esta abordagem ajuda a manter um fluxo lógico e a reduzir a perda de informações, além de priorizar a retenção de informações cruciais. Se você estiver usando LLMs, crie instruções claras e específicas que orientem o modelo para resumir um tópico específico em vez de todo o corpo do texto.

Conclusão

A sumarização é uma ferramenta vital em nossa era rica em informações, permitindo a destilação eficiente de informações extensas em formas concisas e significativas. Desempenha um papel fundamental em vários domínios, oferecendo inúmeras vantagens. A sumarização economiza tempo ao transmitir rapidamente o conteúdo essencial de documentos extensos, auxilia na tomada de decisões ao extrair informações críticas e melhora a compreensão na educação e na curadoria de conteúdo.

Esta postagem forneceu uma visão geral abrangente de várias técnicas de resumo, incluindo abordagens extrativas, abstrativas e multiníveis. Com ferramentas como LangChain e modelos de linguagem, você pode aproveitar o poder da sumarização para agilizar a comunicação, melhorar a tomada de decisões e desbloquear todo o potencial de vastos repositórios de informações. A tabela comparativa deste post pode ajudá-lo a identificar as técnicas de resumo mais adequadas para seus projetos. Além disso, as dicas compartilhadas na postagem servem como orientações valiosas para evitar erros repetitivos ao experimentar LLMs para resumo de texto. Este conselho prático permite que você aplique os conhecimentos adquiridos, garantindo uma sumarização bem-sucedida e eficiente nos projetos.

Referências

Sobre os autores

Nick Biso é engenheiro de aprendizado de máquina na AWS Professional Services. Ele resolve desafios organizacionais e técnicos complexos usando ciência e engenharia de dados. Além disso, ele cria e implanta modelos de IA/ML na Nuvem AWS. Sua paixão se estende à sua propensão para viagens e diversas experiências culturais.

Nick Biso é engenheiro de aprendizado de máquina na AWS Professional Services. Ele resolve desafios organizacionais e técnicos complexos usando ciência e engenharia de dados. Além disso, ele cria e implanta modelos de IA/ML na Nuvem AWS. Sua paixão se estende à sua propensão para viagens e diversas experiências culturais.

Suhas chowdary Jonnalagadda é cientista de dados na AWS Global Services. Ele é apaixonado por ajudar clientes empresariais a resolver seus problemas mais complexos com o poder da IA/ML. Ele ajudou clientes a transformar suas soluções de negócios em diversos setores, incluindo finanças, saúde, bancos, comércio eletrônico, mídia, publicidade e marketing.

Suhas chowdary Jonnalagadda é cientista de dados na AWS Global Services. Ele é apaixonado por ajudar clientes empresariais a resolver seus problemas mais complexos com o poder da IA/ML. Ele ajudou clientes a transformar suas soluções de negócios em diversos setores, incluindo finanças, saúde, bancos, comércio eletrônico, mídia, publicidade e marketing.

Ala Tabby é arquiteto principal de nuvem/consultor técnico estratégico com ampla experiência na migração de clientes e na modernização de cargas de trabalho e serviços de aplicativos para AWS. Com mais de 25 anos de experiência no desenvolvimento e arquitetura de software, ela é reconhecida por sua capacidade de aprofundamento, bem como por conquistar habilmente a confiança de clientes e parceiros para projetar arquiteturas e soluções em diversas pilhas de tecnologia e provedores de nuvem.

Ala Tabby é arquiteto principal de nuvem/consultor técnico estratégico com ampla experiência na migração de clientes e na modernização de cargas de trabalho e serviços de aplicativos para AWS. Com mais de 25 anos de experiência no desenvolvimento e arquitetura de software, ela é reconhecida por sua capacidade de aprofundamento, bem como por conquistar habilmente a confiança de clientes e parceiros para projetar arquiteturas e soluções em diversas pilhas de tecnologia e provedores de nuvem.

Shyam Desai é engenheiro de nuvem para serviços de big data e aprendizado de máquina na AWS. Ele oferece suporte a clientes e aplicativos de big data de nível empresarial usando uma combinação de experiência em engenharia de software com ciência de dados. Ele possui amplo conhecimento em visão computacional e aplicações de imagem para inteligência artificial, bem como aplicações biomédicas e bioinformáticas.

Shyam Desai é engenheiro de nuvem para serviços de big data e aprendizado de máquina na AWS. Ele oferece suporte a clientes e aplicativos de big data de nível empresarial usando uma combinação de experiência em engenharia de software com ciência de dados. Ele possui amplo conhecimento em visão computacional e aplicações de imagem para inteligência artificial, bem como aplicações biomédicas e bioinformáticas.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/techniques-for-automatic-summarization-of-documents-using-language-models/

- :tem

- :é

- :não

- :onde

- 1

- 100

- 11

- 20

- 25

- 50

- 7

- 8

- 9

- a

- habilidade

- Sobre

- acadêmico

- acessível

- precisão

- preciso

- alcançar

- em

- Adição

- Adicionalmente

- avanços

- Vantagem

- vantajoso

- vantagens

- Publicidade

- conselho

- assessor

- Depois de

- idade

- agregação

- AI

- AI / ML

- SIDA

- algoritmo

- alinhado

- Todos os Produtos

- Permitindo

- permite

- sozinho

- juntamente

- tb

- Apesar

- Amazon

- Amazon Web Services

- an

- análise

- e

- responder

- Antrópico

- qualquer

- Aplicação

- aplicações

- Aplicar

- Aplicando

- abordagem

- se aproxima

- SOMOS

- Ordem

- artigo

- artigos

- artificial

- inteligência artificial

- AS

- At

- Automático

- evitar

- evitando

- consciente

- AWS

- Serviços Profissionais AWS

- Bancário

- baseado

- BE

- tornam-se

- torna-se

- ser

- MELHOR

- melhores práticas

- Melhor

- Pós

- Grande

- Big Data

- biomédica

- Blogs

- corpos

- corpo

- livro

- Livros

- ambos

- Break

- amplo

- amplamente

- Constrói

- negócio

- mas a

- botão

- by

- chamadas

- CAN

- capacidades

- capaz

- capturar

- capturas

- cuidadoso

- Centralização de

- certo

- cadeia

- desafios

- desafiante

- capítulos

- personagem

- clareza

- remover filtragem

- claramente

- clique

- Na nuvem

- Agrupar

- agrupamento

- código

- COERENTE

- combinação

- combinado

- combina

- combinando

- como

- vem

- Comunicação

- compacto

- comparado

- comparação

- completar

- integrações

- componente

- compreensivo

- compreende

- Computar

- computador

- Visão de Computador

- conciso

- condições

- Considerar

- consideração

- consiste

- cônsul

- restrições

- consumindo

- conteúdo

- Curadoria de conteúdo

- contexto

- ao controle

- núcleo

- pedra angular

- poderia

- homólogos

- artesanato

- crio

- Criatividade

- criatividade

- crítico

- crucial

- cultural

- curadoria

- Clientes

- dados,

- ciência de dados

- cientista de dados

- conjuntos de dados

- lidar

- Tomada de Decisão

- decisões

- definido

- Dependendo

- depende

- implantar

- desenvolvimento

- implanta

- Design

- projetado

- desejado

- detalhe

- detalhado

- detalhes

- Determinar

- em desenvolvimento

- Desenvolvimento

- diferente

- diretamente

- Desvantagem

- discutir

- distribuído

- Sistemas distribuídos

- diferente

- documento

- INSTITUCIONAIS

- Não faz

- domínio

- domínios

- down

- desvantagens

- cada

- Ganhando

- facilidade

- Loja virtual

- Educação

- Eficaz

- efetivamente

- eficácia

- eficiente

- embutindo

- empregando

- empodera

- permite

- permitindo

- noivando

- engenheiro

- Engenharia

- Motores

- aprimorada

- Melhora

- garantir

- garante

- assegurando

- Empreendimento

- no âmbito da empresa

- Era

- erros

- especialmente

- essência

- essencial

- estabelecido

- Mesmo

- exemplo

- excedem

- excede

- Excel

- excessivo

- exclusivamente

- executivo

- existente

- esperado

- caro

- vasta experiência

- Experiências

- experimentos

- experiência

- expresso

- se estende

- extenso

- Experiência Extensiva

- extrato

- Extração

- Extractos

- Característica

- menos

- final

- financiar

- Primeiro nome

- caber

- Flexibilidade

- fluxo

- Foco

- seguir

- seguinte

- Escolha

- formulário

- formato

- formas

- encontrado

- da

- cheio

- totalmente

- Além disso

- ganhou

- propósito geral

- gerar

- gerado

- gera

- gerando

- geração

- generativo

- IA generativa

- dado

- dá

- Dando

- Global

- vai

- vai

- maior

- Grupo

- guia

- orientações

- arreios

- Ter

- he

- saúde

- fortemente

- ajudar

- ajudou

- ajuda

- ajuda

- sua experiência

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- Alta

- de alto nível

- alta qualidade

- mais

- altamente

- sua

- Como funciona o dobrador de carta de canal

- Contudo

- HTML

- HTTPS

- legível para humanos

- idéias

- identificar

- identificar

- if

- Imagiologia

- Impacto

- implementação

- implementação

- importante

- melhorar

- melhorar

- in

- incapacidade

- inclui

- Incluindo

- incorporar

- de treinadores em Entrevista Motivacional

- índices

- Individualmente

- indústrias

- influência

- INFORMAÇÕES

- informativo

- informado

- do estado inicial,

- entrada

- insights

- em vez disso

- instruções

- integração

- Inteligência

- Pretendido

- para dentro

- Introdução

- inestimável

- investidor

- envolver

- IT

- iterações

- ESTÁ

- jpg

- Chave

- Conhecimento

- conhecido

- língua

- grande

- Maior

- camadas

- aprendizagem

- Legal

- Comprimento

- menos

- níveis

- encontra-se

- wifecycwe

- como

- LIMITE

- limitação

- limitações

- limites

- LLM

- lógico

- longo

- mais

- fora

- diminuir

- máquina

- aprendizado de máquina

- a Principal

- a manter

- fazer

- FAZ

- Fazendo

- gerenciados

- gestão

- muitos

- mapa,

- mercado

- Marketing

- material

- máximo

- Posso..

- significado

- significativo

- Mídia

- mers

- ir

- fusão

- método

- metodologias

- métodos

- migrando

- desaparecido

- Mitigar

- modelo

- modelos

- modernizando

- mais

- Além disso

- a maioria

- mover

- multifacetado

- múltiplo

- narrativas

- natural

- Processamento de linguagem natural

- Natureza

- necessariamente

- necessário

- você merece...

- Cria

- Novo

- notícias

- Newsletter

- PNL

- não

- notável

- notavelmente

- nota

- romance

- número

- numeroso

- objetivo

- of

- oferecer

- oferecendo treinamento para distância

- Oferece

- on

- ONE

- só

- aberto

- ideal

- or

- organização

- organizacional

- original

- Outros

- Outros

- A Nossa

- Fora

- resultados

- saída

- outputs

- Acima de

- global

- abrangente

- Visão geral

- esmagador

- próprio

- parâmetro

- parâmetros

- parte

- particular

- Parceiros

- passagem

- paixão

- apaixonado

- Realizar

- atuação

- fase

- Frases

- essencial

- platão

- Inteligência de Dados Platão

- PlatãoData

- desempenha

- Publique

- potencial

- potencialmente

- poder

- alimentado

- poderoso

- Prática

- prática

- práticas

- preparado

- presente

- Apresentações

- preservação

- preservando

- Diretor

- prioriza

- problemas

- processo

- processos

- em processamento

- produzir

- produz

- profissional

- progressivamente

- projetos

- solicita

- fornecido

- fornecedores

- fornece

- fornecendo

- puxando

- fins

- qualidade

- alcance

- Posição

- leitores

- reconhecido

- reduzir

- Reduzido

- a que se refere

- refere-se

- refinar

- relativamente

- relevância

- relevante

- contando

- reorganizando

- repetido

- repetitivo

- Relatórios

- representação

- requerer

- requeridos

- exige

- recurso

- uso intensivo de recursos

- resposta

- restrição

- resultar

- Resultados

- retenção

- reutilizar

- Risco

- Tipo

- é executado

- sábio

- poupança

- escalável

- Escala

- cenários

- Ciência

- Cientista

- Ponto

- marcar

- Pesquisar

- Mecanismos de busca

- Seção

- seções

- selecionado

- selecionando

- doadores,

- sentença

- Série

- servir

- Serverless

- serve

- serviço

- Serviços

- de servir

- vários

- compartilhado

- ela

- Baixo

- de forma considerável

- semelhante

- simplifica

- simplificar

- solteiro

- singular

- considerável

- Tamanho

- tamanhos

- menor

- Software

- Engenharia de software

- unicamente

- Soluções

- RESOLVER

- Resolve

- alguns

- às vezes

- fonte

- Fontes

- especializado

- específico

- especificamente

- divisão

- Pilhas

- fica

- começo

- Estado

- Passo

- Passos

- loja

- franco

- estratégias

- Estratégia

- simplificar

- racionalização

- pontos fortes

- estrutura

- Lutar

- substancialmente

- bem sucedido

- tal

- terno

- adequado

- resumir

- RESUMO

- suportes

- rapidamente

- .

- sistemas

- mesa

- adaptados

- Tire

- toma

- Tarefa

- tarefas

- tecnologia

- Dados Técnicos:

- técnica

- técnicas

- condições

- texto

- do que

- que

- A

- Os projetos

- A fonte

- deles

- Eles

- temas

- então

- Lá.

- Este

- deles

- isto

- três

- Através da

- tempo

- dicas

- para

- token

- Tokens

- ferramenta

- ferramentas

- tópico

- Temas

- Total

- Trem

- Training

- transformações

- transformando

- viagens

- Confiança

- sintonização

- dois

- tipo

- tipos

- tipicamente

- incapaz

- sofre

- subjacente

- compreender

- compreensão

- único

- ao contrário

- destravar

- até

- não desejado

- usar

- usava

- usos

- utilização

- utilizar

- Valioso

- variedade

- vário

- variando

- Grande

- versátil

- versão

- muito

- visão

- vital

- volumes

- Caminho..

- we

- web

- serviços web

- BEM

- quando

- qual

- enquanto

- inteiro

- Largo

- Wikipedia

- de

- dentro

- Word

- palavras

- trabalho

- mundo

- anos

- rendimentos

- Vocês

- investimentos

- zefirnet