DeepMind fez isso de novo.

Depois de resolver um desafio fundamental em biologia -prevendo a estrutura da proteína-e desembaraçando a matemática da teoria do nó, tem como objetivo um processo de computação fundamental incorporado em milhares de aplicativos do dia a dia. Da análise de imagens até modelando o clima ou mesmo investigando o funcionamento interno das redes neurais artificiais, a IA poderia, teoricamente, acelerar os cálculos em vários campos, aumentando a eficiência e reduzindo ao mesmo tempo o uso e os custos de energia.

Mas mais impressionante é como eles fizeram isso. O algoritmo recorde, apelidado de AlphaTensor, é um desdobramento do AlfaZero, que derrotou jogadores humanos no xadrez e no Go.

“Algoritmos têm sido usados em todas as civilizações do mundo para realizar operações fundamentais há milhares de anos”, escreveu co-autores Drs. Matej Balog e Alhussein Fawzi da DeepMind. “No entanto, descobrir algoritmos é altamente desafiador.”

AlphaTensor abre caminho para um novo mundo onde a IA projeta programas que superam qualquer coisa projetada por humanos, ao mesmo tempo que melhora seu próprio “cérebro” de máquina.

“Este trabalho avança para um território desconhecido ao usar IA para um problema de otimização no qual as pessoas trabalham há décadas… as soluções que ele encontra podem ser imediatamente desenvolvidas para melhorar os tempos de execução computacional”, disse o Dr. Federico Levi, editor sênior da Natureza, o qual publicado o estudo.

Insira a multiplicação da matriz

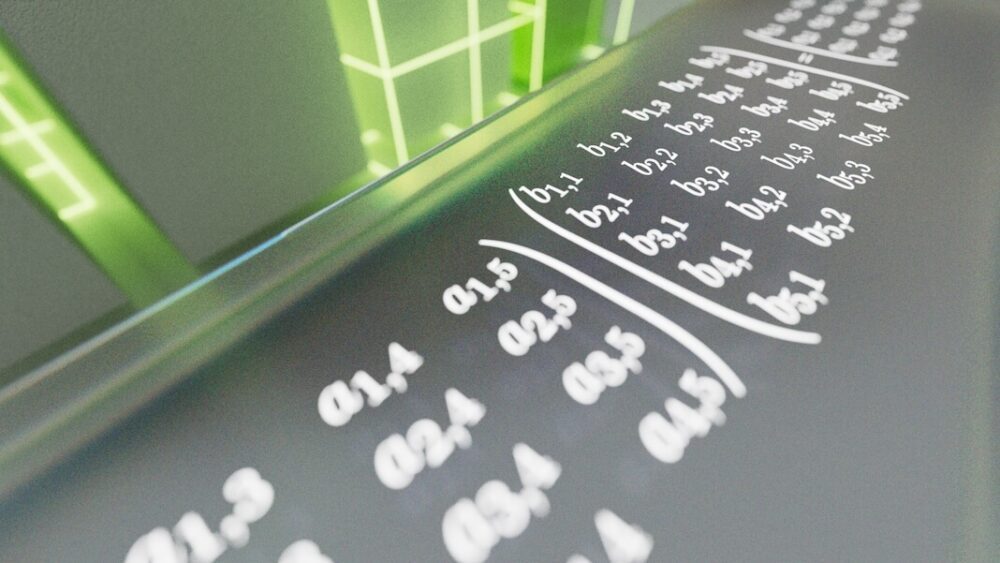

O problema que o AlphaTensor enfrenta é a multiplicação de matrizes. Se de repente você está visualizando linhas e colunas de números verdes rolando pela tela, você não está sozinho. Grosso modo, uma matriz é mais ou menos assim – uma grade de números que representa digitalmente os dados de sua escolha. Podem ser pixels em uma imagem, as frequências de um clipe de som ou a aparência e as ações dos personagens em videogames.

A multiplicação de matrizes pega duas grades de números e multiplica uma pela outra. É um cálculo frequentemente ensinado no ensino médio, mas também é fundamental para sistemas de computação. Aqui, linhas de números em uma matriz são multiplicadas por colunas em outra. Os resultados geram um resultado — por exemplo, um comando para ampliar ou inclinar a visualização de uma cena de videogame. Embora esses cálculos funcionem nos bastidores, qualquer pessoa que use um telefone ou computador depende de seus resultados todos os dias.

Você pode ver como o problema pode ficar extremamente difícil, extremamente rápido. Multiplicar matrizes grandes consome muita energia e tempo. Cada par de números deve ser multiplicado individualmente para construir uma nova matriz. À medida que as matrizes crescem, o problema rapidamente se torna insustentável – ainda mais do que prever os melhores movimentos de xadrez ou Go. Alguns especialistas estimam que há mais maneiras para resolver a multiplicação de matrizes do que o número de átomos no universo.

Em 1969, Volker Strassen, um matemático alemão, mostrou que há maneiras de economizar, eliminando uma rodada de multiplicação de matrizes dois por dois de um total de oito a sete. Pode não parecer impressionante, mas o método de Strassen mostrou que é possível superar padrões de operações de longa data – isto é, algoritmos – para multiplicação de matrizes. Sua abordagem, o algoritmo Strassen, reinou como a abordagem mais eficiente por mais de 50 anos.

Mas e se existirem métodos ainda mais eficientes? “Ninguém conhece o melhor algoritmo para resolvê-lo”, disse o Dr. François Le Gall, da Universidade de Nagoya, no Japão, que não esteve envolvido no trabalho. disse MIT Technology Review. “É um dos maiores problemas em aberto na ciência da computação.”

Algoritmos de perseguição de IA

Se a intuição humana está falhando, por que não recorrer a uma mente mecânica?

No novo estudo, a equipe da DeepMind transformou a multiplicação de matrizes em um jogo. Semelhante ao seu antecessor AlphaZero, o AlphaTensor usa aprendizagem por reforço profundo, um método de aprendizado de máquina inspirado na forma como os cérebros biológicos aprendem. Aqui, um agente de IA (geralmente uma rede neural artificial) interage com seu ambiente para resolver um problema de várias etapas. Se tiver sucesso, ganha uma “recompensa” – ou seja, os parâmetros de rede da IA são atualizados para que seja mais provável que tenha sucesso novamente no futuro.

É como aprender a virar uma panqueca. Inicialmente, muitos cairão no chão, mas eventualmente suas redes neurais aprenderão os movimentos dos braços e das mãos para um giro perfeito.

O campo de treinamento do AlphaTensor é uma espécie de jogo de tabuleiro 3D. É essencialmente um quebra-cabeça para um jogador, mais ou menos semelhante ao Sudoku. A IA deve multiplicar grelhas de números no menor número de passos possível, ao mesmo tempo que escolhe entre uma miríade de movimentos permitidos – mais de um bilião deles.

Esses movimentos permitidos foram meticulosamente projetados no AlphaTensor. Em uma coletiva de imprensa, o coautor Dr. Hussain Fawzi explicou: “Formular o espaço de descoberta algorítmica é muito complexo… ainda mais difícil é como podemos navegar neste espaço.”

Por outras palavras, quando confrontados com um conjunto incompreensível de opções, como podemos restringi-las para aumentar as nossas hipóteses de encontrar a agulha no palheiro? E qual a melhor estratégia para chegar à agulha sem cavar todo o palheiro?

Um truque que a equipe incorporou ao AlphaTensor é um método chamado pesquisa em árvore. Em vez de, metaforicamente falando, cavar aleatoriamente no palheiro, aqui a IA sonda “estradas” que poderiam levar a um resultado melhor. Os aprendizados intermediários ajudam a IA a planejar seu próximo passo para aumentar as chances de sucesso. A equipe também mostrou exemplos de algoritmos de jogos de sucesso, como ensinar a uma criança os movimentos iniciais do xadrez. Finalmente, assim que a IA descobriu movimentos valiosos, a equipe permitiu reordenar essas operações para um aprendizado mais personalizado em busca de um melhor resultado.

Abrindo novos caminhos

AlphaTensor jogou bem. Numa série de testes, a equipa desafiou a IA a encontrar as soluções mais eficazes para matrizes até cinco por cinco – ou seja, com cinco números cada numa linha ou coluna.

O algoritmo redescobriu rapidamente o hack original de Strassen, mas depois superou todas as soluções anteriormente concebidas pela mente humana. Testando a IA com diferentes tamanhos de matrizes, o AlphaTensor encontrou soluções mais eficientes para mais de 70. “Na verdade, o AlphaTensor normalmente descobre milhares de algoritmos para cada tamanho de matriz”, disse a equipe. “É incompreensível.”

Em um caso, ao multiplicar uma matriz cinco por cinco por uma matriz quatro por cinco, a IA reduziu o recorde anterior de 80 multiplicações individuais para apenas 76. Também brilhou em matrizes maiores, reduzindo o número de cálculos necessários para duas. matrizes onze por onze de 919 a 896.

Com a prova de conceito em mãos, a equipe voltou-se para o uso prático. Os chips de computador são frequentemente projetados para otimizar diferentes computações – GPUs para gráficos, por exemplo, ou Chips de IA para aprendizado de máquina—e combinar um algoritmo com o hardware mais adequado aumenta a eficiência.

Aqui, a equipe usou o AlphaTensor para encontrar algoritmos para dois chips populares em aprendizado de máquina: a GPU NVIDIA V100 e o Google TPU. Ao todo, os algoritmos desenvolvidos por IA aumentaram a velocidade computacional em até 20%.

É difícil dizer se a IA também pode acelerar smartphones, laptops ou outros dispositivos do dia a dia. No entanto, “este desenvolvimento seria muito interessante se pudesse ser usado na prática”, disse a Dra. Virginia Williams, do MIT. “Um aumento no desempenho melhoraria muitos aplicativos.”

A mente de uma IA

Apesar do AlphaTensor ter derrotado o mais recente recorde humano de multiplicação de matrizes, a equipe da DeepMind ainda não consegue explicar o porquê.

“Ele obteve uma intuição incrível ao jogar esses jogos”, disse o cientista e coautor da DeepMind, Dr. Pushmeet Kohli, em uma coletiva de imprensa.

A evolução dos algoritmos também não precisa ser homem versus máquina.

Embora o AlphaTensor seja um trampolim para algoritmos mais rápidos, podem existir algoritmos ainda mais rápidos. “Como precisa restringir sua pesquisa a algoritmos de um formato específico, pode perder outros tipos de algoritmos que possam ser mais eficientes”, escreveram Balog e Fawzi.

Talvez um caminho ainda mais intrigante combinaria a intuição humana e a da máquina. “Seria bom descobrir se este novo método realmente inclui todos os anteriores, ou se é possível combiná-los e obter algo ainda melhor.” dito Willians. Outros especialistas concordam. Com uma variedade de algoritmos à sua disposição, os cientistas podem começar a dissecá-los em busca de pistas sobre o que fez as soluções da AlphaTensor funcionarem, abrindo caminho para o próximo avanço.

Crédito da imagem: DeepMind