Introdução

Há dois anos, num projecto chamado Além do benchmark do Jogo de Imitação, ou BIG-bench, 450 pesquisadores compilaram uma lista de 204 tarefas projetadas para testar os recursos de grandes modelos de linguagem, que potencializam chatbots como o ChatGPT. Na maioria das tarefas, o desempenho melhorou de forma previsível e suave à medida que os modelos foram ampliados – quanto maior o modelo, melhor ele ficou. Mas com outras tarefas, o salto na capacidade não foi tranquilo. O desempenho permaneceu próximo de zero por um tempo, depois o desempenho aumentou. Outros estudos encontraram saltos semelhantes na capacidade.

Os autores descreveram isso como um comportamento “inovador”; outros pesquisadores compararam isso a uma transição de fase na física, como quando a água líquida congela e se transforma em gelo. Em um papel publicado em agosto de 2022, os pesquisadores observaram que esses comportamentos não são apenas surpreendentes, mas também imprevisíveis, e que devem informar a evolução das conversas sobre segurança, potencial e risco da IA. Eles chamaram as habilidades de “emergente”, uma palavra que descreve comportamentos coletivos que só aparecem quando um sistema atinge um alto nível de complexidade.

Mas as coisas podem não ser tão simples. Um novo papel por um trio de pesquisadores da Universidade de Stanford postula que o aparecimento repentino dessas habilidades é apenas uma consequência da forma como os pesquisadores medem o desempenho do LLM. As habilidades, argumentam eles, não são imprevisíveis nem repentinas. “A transição é muito mais previsível do que as pessoas imaginam”, disse Sanmi Koyejo, cientista da computação em Stanford e autor sênior do artigo. “Fortes alegações de emergência têm tanto a ver com a forma como escolhemos medir como com o que os modelos estão fazendo.”

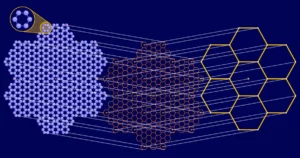

Só agora estamos vendo e estudando esse comportamento devido ao tamanho desses modelos. Grandes modelos de linguagem são treinados analisando enormes conjuntos de dados de texto — palavras de fontes on-line, incluindo livros, pesquisas na web e Wikipédia — e encontrar links entre palavras que geralmente aparecem juntas. O tamanho é medido em termos de parâmetros, aproximadamente análogo a todas as maneiras pelas quais as palavras podem ser conectadas. Quanto mais parâmetros, mais conexões um LLM pode encontrar. O GPT-2 tinha 1.5 bilhão de parâmetros, enquanto o GPT-3.5, o LLM que alimenta o ChatGPT, usa 350 bilhões. O GPT-4, que estreou em março de 2023 e agora é a base do Microsoft Copilot, supostamente usa 1.75 trilhão.

Esse rápido crescimento trouxe um aumento surpreendente no desempenho e na eficácia, e ninguém contesta que LLMs grandes o suficiente podem completar tarefas que modelos menores não conseguem, incluindo aquelas para as quais não foram treinados. O trio de Stanford que considera a emergência uma “miragem” reconhece que os LLMs se tornam mais eficazes à medida que crescem; na verdade, a complexidade adicional de modelos maiores deverá permitir melhorar a resolução de problemas mais difíceis e diversos. Mas eles argumentam que se esta melhoria parece suave e previsível ou irregular e nítida resulta da escolha da métrica - ou mesmo da escassez de exemplos de teste - e não do funcionamento interno do modelo.

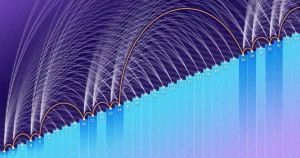

A adição de três dígitos oferece um exemplo. No estudo BIG-bench de 2022, os pesquisadores relataram que, com menos parâmetros, tanto o GPT-3 quanto outro LLM chamado LAMDA não conseguiram completar com precisão os problemas de adição. No entanto, quando o GPT-3 treinou usando 13 bilhões de parâmetros, sua capacidade mudou como se fosse o apertar de um botão. De repente, poderia acrescentar – e o LAMDA também poderia, com 68 bilhões de parâmetros. Isto sugere que a capacidade de adicionar surge num certo limiar.

Mas os pesquisadores de Stanford ressaltam que os LLMs foram julgados apenas pela precisão: ou eles conseguiam fazê-lo perfeitamente ou não. Portanto, mesmo que um LLM tenha previsto a maioria dos dígitos corretamente, ele falhou. Isso não parecia certo. Se você estiver calculando 100 mais 278, então 376 parece uma resposta muito mais precisa do que, digamos, -9.34.

Então, em vez disso, Koyejo e seus colaboradores testaram a mesma tarefa usando uma métrica que concede crédito parcial. “Podemos perguntar: quão bem ele prevê o primeiro dígito? Então o segundo? Então o terceiro? ele disse.

Koyejo credita a ideia do novo trabalho ao seu aluno de pós-graduação Rylan Schaeffer, que, segundo ele, percebeu que o desempenho de um LLM parece mudar com a forma como sua capacidade é medida. Juntamente com Brando Miranda, outro estudante de pós-graduação de Stanford, eles escolheram novas métricas mostrando que à medida que os parâmetros aumentavam, os LLMs previam uma sequência cada vez mais correta de dígitos em problemas de adição. Isto sugere que a capacidade de adicionar não é emergente – o que significa que sofre um salto repentino e imprevisível – mas gradual e previsível. Eles descobrem que, com uma medida diferente, a emergência desaparece.

Introdução

Mas outros cientistas salientam que o trabalho não dissipa totalmente a noção de emergência. Por exemplo, o artigo do trio não explica como prever quando as métricas, ou quais, apresentarão melhorias abruptas em um LLM, disse Tianshi Li, cientista da computação da Northeastern University. “Então, nesse sentido, essas habilidades ainda são imprevisíveis”, disse ela. Outros, como Jason Wei, um cientista da computação agora na OpenAI que compilou uma lista de habilidades emergentes e foi autor do artigo do BIG-bench, argumentaram que os primeiros relatos de emergência eram sólidos porque, para habilidades como a aritmética, a resposta certa é realmente tudo o que importa.

“Definitivamente há uma conversa interessante aqui”, disse Alex Tamkin, cientista pesquisador da startup de IA Antrópica. O novo artigo divide habilmente tarefas de várias etapas para reconhecer as contribuições de componentes individuais, disse ele. “Mas esta não é a história completa. Não podemos dizer que todos esses saltos sejam uma miragem. Ainda acho que a literatura mostra que mesmo quando você tem previsões de uma etapa ou usa métricas contínuas, você ainda tem descontinuidades e, à medida que aumenta o tamanho do seu modelo, ainda pode vê-lo melhorando rapidamente.”

E mesmo que o surgimento dos LLMs de hoje possa ser explicado por diferentes ferramentas de medição, é provável que esse não seja o caso dos LLMs maiores e mais complicados de amanhã. “Quando levamos os LLMs para o próximo nível, inevitavelmente eles irão emprestar conhecimento de outras tarefas e outros modelos”, disse Xia “Ben” Hu, cientista da computação da Rice University.

Esta consideração evolutiva da emergência não é apenas uma questão abstrata a ser considerada pelos pesquisadores. Para Tamkin, isso se refere diretamente aos esforços contínuos para prever como os LLMs se comportarão. “Essas tecnologias são tão amplas e aplicáveis”, disse ele. “Espero que a comunidade use isto como um ponto de partida, como uma ênfase contínua na importância de construir uma ciência de previsão para estas coisas. Como não ficar surpresos com a próxima geração de modelos?”

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.quantamagazine.org/how-quickly-do-large-language-models-learn-unexpected-skills-20240213/

- :tem

- :é

- :não

- ][p

- $UP

- 1

- 100

- 13

- 2022

- 2023

- 204

- 350

- 75

- a

- habilidades

- habilidade

- RESUMO

- precisão

- preciso

- exatamente

- adicionar

- adicionado

- Adição

- atrás

- AI

- Todos os Produtos

- an

- análise

- e

- Outro

- responder

- Antrópico

- aparecer

- relevante

- SOMOS

- argumentar

- por aí

- AS

- perguntar

- At

- AGOSTO

- autor

- autores

- prêmios

- longe

- BE

- Porque

- tornam-se

- comportamento

- comportamentos

- Melhor

- entre

- bilhão

- Livros

- pedir emprestado

- ambos

- quebra

- amplo

- Trazido

- construir

- mas a

- by

- cálculo

- chamado

- CAN

- capacidades

- casas

- certo

- alterar

- mudado

- chatbots

- ChatGPT

- escolha

- Escolha

- escolheu

- reivindicações

- colaboradores

- Collective

- comunidade

- compilado

- completar

- complexidade

- complicado

- componentes

- computador

- conectado

- Coneções

- conseqüência

- Considerar

- consideração

- continuou

- contínuo

- contribuições

- Conversa

- conversas

- correta

- corretamente

- poderia

- crédito

- Créditos

- estreou

- definitivamente

- descrito

- descreve

- projetado

- diferente

- difícil

- dígitos

- diretamente

- diferente

- do

- parece

- Não faz

- fazer

- down

- Mais cedo

- Eficaz

- eficácia

- esforços

- ou

- emergência

- emerge

- ênfase

- enorme

- suficiente

- Mesmo

- evolução

- exemplo

- exemplos

- Explicação

- explicado

- fato

- fracassado

- Moda

- menos

- Encontre

- descoberta

- Primeiro nome

- Giro

- Escolha

- encontrado

- da

- cheio

- totalmente

- jogo

- geração

- ter

- obtendo

- OFERTE

- tem

- gradual

- pós-graduação

- Cresça:

- Growth

- tinha

- Ter

- he

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- Alta

- sua

- esperança

- Como funciona o dobrador de carta de canal

- Como Negociar

- Contudo

- HTML

- HTTPS

- i

- ICE

- idéia

- if

- importante

- melhorado

- melhoria

- in

- Incluindo

- Crescimento

- aumentou

- cada vez mais

- Individual

- inevitavelmente

- informar

- interior

- em vez disso

- interessante

- para dentro

- IT

- ESTÁ

- julgado

- saltar

- Saltou

- saltos

- apenas por

- Conhecimento

- língua

- grande

- Maior

- saltos

- APRENDER

- Nível

- como

- Provável

- Links

- Líquido

- Lista

- literatura

- LLM

- OLHARES

- revista

- fazer

- Março

- Matéria

- Posso..

- significado

- a medida

- medição

- métrico

- Métrica

- Microsoft

- modelo

- modelos

- mais

- a maioria

- muito

- Nomeado

- Perto

- Nem

- Novo

- Próximo

- não

- Northeastern University

- notado

- Noção

- agora

- of

- Oferece

- frequentemente

- on

- uma vez

- ONE

- queridos

- contínuo

- online

- só

- OpenAI

- or

- Outros

- Outros

- Fora

- Papel

- parâmetros

- Pessoas

- perfeitamente

- atuação

- fase

- Física

- platão

- Inteligência de Dados Platão

- PlatãoData

- mais

- ponto

- possível

- potencial

- poder

- atribuições

- predizer

- Previsível

- previsto

- predição

- Previsões

- problemas

- projeto

- publicado

- Quantagazine

- questão

- rapidamente

- rápido

- em vez

- Chega

- clientes

- reconhecer

- permaneceu

- Informou

- alegadamente

- Relatórios

- pesquisa

- pesquisadores

- Resultados

- arroz

- certo

- Risco

- grosseiramente

- Segurança

- Dito

- mesmo

- dizer

- Escala

- dimensionado

- Ciência

- Cientista

- cientistas

- pesquisas

- Segundo

- Vejo

- visto

- parecem

- parece

- senior

- sentido

- Seqüência

- afiado

- ela

- rede de apoio social

- mostrar

- mostrando

- Shows

- semelhante

- simples

- Tamanho

- Habilidades

- menor

- Liso

- sem problemas

- So

- Parecer

- Fontes

- fala

- Stanford

- Universidade de Stanford

- inicialização

- Ainda

- História

- estudante

- caso

- Estudo

- Estudando

- tal

- súbito

- Sugere

- surge

- admirado

- surpreendente

- Interruptor

- .

- Tarefa

- tarefas

- Tecnologias

- condições

- teste

- testado

- do que

- que

- A

- então

- Este

- deles

- coisas

- think

- Terceiro

- isto

- limiar

- para

- hoje

- juntos

- também

- ferramentas

- Trem

- treinado

- transição

- Trilhão

- trio

- sofre

- Inesperado

- universidade

- imprevisível

- usar

- usos

- utilização

- foi

- Água

- Caminho..

- maneiras

- we

- web

- webp

- BEM

- foram

- O Quê

- quando

- se

- qual

- enquanto

- QUEM

- Wikipedia

- precisarão

- de

- Word

- palavras

- Atividades:

- funcionamento

- seria

- anos

- Vocês

- investimentos

- zefirnet

- zero