Introdução

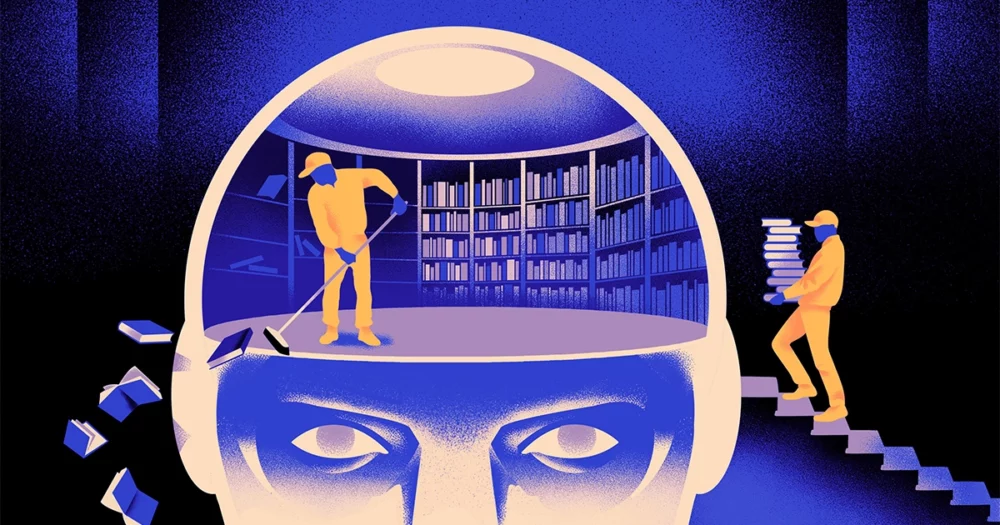

Uma equipe de cientistas da computação criou um tipo mais ágil e flexível do modelo de aprendizado de máquina. O truque: deve esquecer periodicamente o que sabe. E embora esta nova abordagem não substitua os enormes modelos que sustentam as maiores aplicações, poderá revelar mais sobre como estes programas compreendem a linguagem.

A nova pesquisa marca “um avanço significativo no campo”, disse Jea Kwon, engenheiro de IA do Instituto de Ciências Básicas da Coreia do Sul.

Os mecanismos de linguagem de IA em uso hoje são principalmente alimentados por redes neurais artificiais. Cada “neurônio” na rede é uma função matemática que recebe sinais de outros neurônios, executa alguns cálculos e envia sinais através de múltiplas camadas de neurônios. Inicialmente o fluxo de informações é mais ou menos aleatório, mas através do treinamento, o fluxo de informações entre os neurônios melhora à medida que a rede se adapta aos dados de treinamento. Se um pesquisador de IA quiser criar um modelo bilíngue, por exemplo, ele treinaria o modelo com uma grande pilha de texto de ambos os idiomas, o que ajustaria as conexões entre os neurônios de forma a relacionar o texto em um idioma com equivalentes. palavras no outro.

Mas esse processo de treinamento exige muito poder computacional. Se o modelo não funcionar muito bem, ou se as necessidades do usuário mudarem posteriormente, será difícil adaptá-lo. “Digamos que você tenha um modelo com 100 idiomas, mas imagine que um idioma que você deseja não seja coberto”, disse Mikel Artetxe, coautor da nova pesquisa e fundador da startup de IA Reka. “Você poderia começar do zero, mas não é o ideal.”

Artetxe e seus colegas tentaram contornar essas limitações. Alguns anos atrás, Artetxe e outros treinaram uma rede neural em um idioma e depois apagaram o que sabiam sobre os blocos de construção das palavras, chamados tokens. Eles são armazenados na primeira camada da rede neural, chamada camada de incorporação. Eles deixaram todas as outras camadas do modelo em paz. Depois de apagar os tokens do primeiro idioma, eles treinaram novamente o modelo no segundo idioma, que preencheu a camada de incorporação com novos tokens desse idioma.

Embora o modelo contivesse informações incompatíveis, o retreinamento funcionou: o modelo conseguiu aprender e processar a nova linguagem. Os pesquisadores presumiram que, enquanto a camada de incorporação armazenava informações específicas das palavras usadas na língua, os níveis mais profundos da rede armazenavam informações mais abstratas sobre os conceitos por trás das línguas humanas, o que ajudou o modelo a aprender a segunda língua.

“Vivemos no mesmo mundo. Conceitualizamos as mesmas coisas com palavras diferentes” em idiomas diferentes, disse Yihong Chen, o autor principal do artigo recente. “É por isso que você tem esse mesmo raciocínio de alto nível no modelo. Uma maçã é algo doce e suculento, em vez de apenas uma palavra.”

Introdução

Embora esta abordagem de esquecimento fosse uma forma eficaz de adicionar uma nova linguagem a um modelo já treinado, a reciclagem ainda era exigente – exigia muitos dados linguísticos e poder de processamento. Chen sugeriu um ajuste: em vez de treinar, apagar a camada de incorporação e depois treinar novamente, eles deveriam redefinir periodicamente a camada de incorporação durante a rodada inicial de treinamento. “Ao fazer isso, todo o modelo se acostuma a ser reiniciado”, disse Artetxe. “Isso significa que quando você deseja estender o modelo para outra linguagem é mais fácil, porque é isso que você está fazendo.”

Os pesquisadores pegaram um modelo de linguagem comumente usado chamado Roberta, treinaram-no usando sua técnica de esquecimento periódico e compararam-no com o desempenho do mesmo modelo quando foi treinado com a abordagem padrão de não esquecimento. O modelo de esquecimento teve um desempenho um pouco pior do que o convencional, recebendo uma pontuação de 85.1 em comparação com 86.1 em uma medida comum de precisão linguística. Depois, treinaram novamente os modelos em outras linguagens, usando conjuntos de dados muito menores, de apenas 5 milhões de tokens, em vez dos 70 bilhões que usaram durante o primeiro treinamento. A precisão do modelo padrão diminuiu para 53.3 em média, mas o modelo de esquecimento caiu apenas para 62.7.

O modelo de esquecimento também se saiu muito melhor se a equipe impusesse limites computacionais durante o retreinamento. Quando os pesquisadores reduziram a duração do treinamento de 125,000 mil passos para apenas 5,000 mil, a precisão do modelo de esquecimento diminuiu para 57.8, em média, enquanto o modelo padrão caiu para 37.2, o que não é melhor do que suposições aleatórias.

Introdução

A equipe concluiu que o esquecimento periódico parece tornar o modelo melhor no aprendizado de línguas em geral. “Como [eles] continuam esquecendo e reaprendendo durante o treinamento, ensinar algo novo à rede mais tarde se torna mais fácil”, disse Evgenia Nikishin, pesquisadora do Mila, um centro de pesquisa de aprendizagem profunda em Quebec. Sugere que quando os modelos linguísticos compreendem uma língua, fazem-no a um nível mais profundo do que apenas os significados de palavras individuais.

A abordagem é semelhante à forma como nossos próprios cérebros funcionam. “A memória humana em geral não é muito boa em armazenar com precisão grandes quantidades de informações detalhadas. Em vez disso, os humanos tendem a lembrar a essência das nossas experiências, abstraindo e extrapolando”, disse Benjamim Levy, neurocientista da Universidade de São Francisco. “Habilitar a IA com processos mais humanos, como o esquecimento adaptativo, é uma forma de levá-los a um desempenho mais flexível.”

Além do que pode dizer sobre como funciona a compreensão, Artetxe espera que modelos de linguagem de esquecimento mais flexíveis também possam ajudar a levar os avanços mais recentes da IA para mais idiomas. Embora os modelos de IA sejam bons no manejo do espanhol e do inglês, dois idiomas com amplos materiais de treinamento, os modelos não são tão bons com seu basco nativo, o idioma local específico do nordeste da Espanha. “A maioria dos modelos de grandes empresas de tecnologia não se sai bem”, disse ele. “Adaptar os modelos existentes ao basco é o caminho a seguir.”

Chen também espera um mundo onde mais flores de IA desabrochem. “Estou pensando em uma situação em que o mundo não precise de um grande modelo de linguagem. Temos tantos”, disse ela. “Se existe uma fábrica que produz modelos de linguagem, você precisa desse tipo de tecnologia. Possui um modelo básico que pode se adaptar rapidamente a novos domínios.”

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :tem

- :é

- :não

- :onde

- ][p

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- Sobre

- RESUMO

- precisão

- exatamente

- adaptar

- adaptativo

- adapta

- adicionar

- Adição

- avançar

- Depois de

- AI

- Modelos de IA

- Todos os Produtos

- sozinho

- já

- tb

- quantidades

- an

- e

- Outro

- Apple

- abordagem

- Aplicativos

- SOMOS

- AS

- At

- autor

- média

- base

- basic

- Porque

- torna-se

- sido

- atrás

- Melhor

- entre

- Grande

- grande tecnologia

- O maior

- bilhão

- Blocos

- Florescer

- ambos

- avanços

- trazer

- Prédio

- mas a

- by

- cálculos

- chamado

- CAN

- Centralização de

- alterar

- chen

- contornar

- Coautor

- colegas

- comum

- geralmente

- Empresas

- comparado

- computacional

- computador

- computação

- poder de computação

- conceitos

- Concluído

- Coneções

- contida

- convencional

- poderia

- coberto

- crio

- criado

- Cortar

- dados,

- conjuntos de dados

- diminuiu

- profundo

- deep learning

- mais profunda

- exigente

- detalhado

- DID

- diferente

- do

- Não faz

- fazer

- domínios

- não

- desistiu

- durante

- cada

- mais fácil

- Eficaz

- embutindo

- engenheiro

- Motores

- Inglês

- Todo

- Equivalente

- exemplo

- existente

- Experiências

- estender

- fábrica

- poucos

- campo

- preenchida

- Primeiro nome

- flexível

- fluxo

- Escolha

- para a frente

- fundador

- Francisco

- da

- função

- Geral

- geralmente

- ter

- GitHub

- Go

- Bom estado, com sinais de uso

- Manipulação

- Queijos duros

- Ter

- he

- ajudar

- ajudou

- de alto nível

- sua

- espera

- Como funciona o dobrador de carta de canal

- HTTPS

- enorme

- humano

- como humano

- Humanos

- ideal

- if

- fotografia

- Imposta

- melhora

- in

- Individual

- INFORMAÇÕES

- do estado inicial,

- inicialmente

- em vez disso

- Instituto

- IT

- apenas por

- Guarda

- Tipo

- sabe

- Coréia

- língua

- Idiomas

- grande

- mais tarde

- mais recente

- camada

- camadas

- conduzir

- APRENDER

- aprendizagem

- esquerda

- Comprimento

- menos

- Nível

- níveis

- como

- limitações

- limites

- viver

- local

- OLHARES

- lote

- máquina

- aprendizado de máquina

- revista

- fazer

- Fazendo

- muitos

- materiais

- matemático

- significados

- significa

- a medida

- Memória

- poder

- milhão

- modelo

- modelos

- mais

- na maioria das vezes

- muito

- múltiplo

- devo

- nativo

- você merece...

- Cria

- rede

- neural

- rede neural

- Neurônios

- Novo

- não

- of

- on

- ONE

- só

- or

- Outros

- Outros

- A Nossa

- Acima de

- próprio

- Papel

- atuação

- periodicamente

- platão

- Inteligência de Dados Platão

- PlatãoData

- mergulhou

- poder

- alimentado

- processo

- processos

- em processamento

- Poder de processamento

- Programas

- Quantagazine

- Quebeque

- rapidamente

- acaso

- em vez

- recebe

- receber

- recentemente

- lembrar

- requeridos

- pesquisa

- investigador

- pesquisadores

- revelar

- volta

- é executado

- Dito

- mesmo

- San

- San Francisco

- dizer

- Ciência

- cientistas

- Ponto

- arranhar

- Segundo

- parece

- seletivo

- envia

- Conjuntos

- ela

- rede de apoio social

- sinais

- periodo

- semelhante

- situação

- menor

- So

- alguns

- algo

- Sul

- Coreia do Sul

- Espanha

- Espanhol

- específico

- padrão

- começo

- inicialização

- Passos

- Ainda

- armazenadas

- armazenar

- tal

- Sugere

- doce

- toma

- Ensino

- Profissionais

- tecnologia

- empresas de tecnologia

- técnica

- Tecnologia

- Tender

- texto

- do que

- que

- A

- as informações

- o mundo

- deles

- Eles

- então

- Este

- deles

- coisas

- Pensando

- isto

- Apesar?

- Através da

- para

- hoje

- Tokens

- levou

- Trem

- treinado

- Training

- truque

- experimentado

- puxão

- dois

- compreender

- compreensão

- universidade

- usar

- usava

- utilização

- muito

- queremos

- quer

- foi

- Caminho..

- we

- webp

- BEM

- O Quê

- quando

- qual

- enquanto

- porque

- de

- Word

- palavras

- Atividades:

- trabalhou

- trabalho

- mundo

- pior

- seria

- anos

- Vocês

- zefirnet