Em um mundo cada vez mais centrado em dados, as empresas devem se concentrar na coleta de informações físicas valiosas e na geração das informações de que precisam, mas que não podem capturar facilmente. Acesso a dados, regulamentação e conformidade são uma fonte crescente de atrito para inovação em análise e inteligência artificial (IA).

Para setores altamente regulamentados, como serviços financeiros, saúde, ciências da vida, automotivo, robótica e manufatura, o problema é ainda maior. Isso causa barreiras ao design do sistema, compartilhamento de dados (interno e externo), monetização, análise e aprendizado de máquina (ML).

Os dados sintéticos são uma ferramenta que aborda muitos desafios de dados, principalmente questões de IA e análise, como proteção de privacidade, conformidade regulatória, acessibilidade, escassez de dados e viés. Isso também inclui compartilhamento de dados e tempo para dados (e, portanto, tempo para o mercado).

Dados sintéticos são gerados algoritmicamente. Ele espelha propriedades e padrões estatísticos dos dados de origem. Mas o mais importante é que não contém pontos de dados confidenciais, privados ou pessoais.

Você faz perguntas aos dados sintéticos e obtém as mesmas respostas que obteria com os dados reais.

No nosso post anterior, demonstramos como usar redes adversárias como Generative Adversarial Networks (GANS) para gerar conjuntos de dados tabulares para aprimorar o treinamento do modelo de fraude de crédito.

Para que as partes interessadas de negócios adotem dados sintéticos para seus projetos de ML e analíticos, é imperativo não apenas garantir que os dados sintéticos gerados atendam à finalidade e aos aplicativos downstream esperados, mas também que eles sejam capazes de medir e demonstrar a qualidade de os dados gerados.

Com o aumento das obrigações legais e éticas na preservação da privacidade, um dos pontos fortes dos dados sintéticos é a capacidade de remover informações confidenciais e originais durante sua síntese. Portanto, além da qualidade, precisamos de métricas para avaliar o risco de vazamento de informações privadas, se houver, e avaliar se o processo de geração não está “memorizando” ou copiando nenhum dos dados originais.

Para conseguir tudo isso, podemos mapear a qualidade dos dados sintéticos em dimensões, que ajudam os usuários, as partes interessadas e a nós a entender melhor os dados gerados.

As três dimensões da avaliação de qualidade de dados sintéticos

Os dados sintéticos gerados são medidos em relação a três dimensões principais:

- Fidelidade

- Utilidade

- Privacidade

Estas são algumas das perguntas sobre quaisquer dados sintéticos gerados que devem ser respondidas por um relatório de qualidade de dados sintéticos:

- Quão semelhantes são esses dados sintéticos em comparação com o conjunto de treinamento original?

- Quão úteis são esses dados sintéticos para nossos aplicativos downstream?

- Alguma informação vazou dos dados de treinamento originais para os dados sintéticos?

- Algum dado considerado sensível no mundo real (de outros conjuntos de dados não usados para treinar o modelo) foi inadvertidamente sintetizado por nosso modelo?

As métricas que traduzem cada uma dessas dimensões para os usuários finais são um tanto flexíveis. Afinal, os dados a serem gerados podem variar em termos de distribuições, tamanho e comportamentos. Eles também devem ser fáceis de entender e interpretar.

Por fim, as métricas devem ser totalmente orientadas por dados e não exigir nenhum conhecimento prévio ou informações específicas do domínio. No entanto, se o usuário deseja aplicar regras e restrições específicas aplicáveis a um domínio de negócios específico, ele deve ser capaz de defini-las durante o processo de síntese para garantir que a fidelidade específica do domínio seja atendida.

Analisamos cada uma dessas métricas com mais detalhes nas seções a seguir.

Métricas para entender a fidelidade

Em qualquer projeto de ciência de dados, devemos entender se uma determinada população de amostra é relevante para o problema que estamos resolvendo. Da mesma forma, para o processo de avaliação da relevância dos dados sintéticos gerados, devemos avaliá-los em termos de fidelidade em comparação com o original.

As representações visuais dessas métricas as tornam mais fáceis de compreender. Poderíamos ilustrar se a cardinalidade e a proporção das categorias foram respeitadas, se as correlações entre as diferentes variáveis foram mantidas e assim por diante.

A visualização dos dados não apenas ajuda a avaliar a qualidade dos dados sintéticos, mas também se enquadra como uma das etapas iniciais do ciclo de vida da ciência de dados para um melhor entendimento dos dados.

Vamos nos aprofundar em algumas métricas de fidelidade com mais detalhes.

Comparações estatísticas exploratórias

Nas comparações estatísticas exploratórias, os recursos dos conjuntos de dados originais e sintéticos são explorados usando medidas estatísticas importantes, como média, mediana, desvio padrão, valores distintos, valores ausentes, mínimos, máximos, intervalos de quartil para recursos contínuos e o número de registros por categoria, valores ausentes por categoria e caracteres mais recorrentes para atributos categóricos.

Essa comparação deve ser realizada entre o conjunto de dados original e os dados sintéticos. Essa avaliação revelaria se os conjuntos de dados comparados são estatisticamente semelhantes. Se não forem, teremos uma compreensão de quais recursos e medidas são diferentes. Você deve considerar treinar novamente e regenerar os dados sintéticos com parâmetros diferentes se uma diferença significativa for observada.

Este teste atua como uma triagem inicial para garantir que os dados sintéticos tenham fidelidade razoável ao conjunto de dados original e, portanto, possam ser submetidos a testes mais rigorosos.

Pontuação de similaridade do histograma

A pontuação de similaridade do histograma mede as distribuições marginais de cada recurso dos conjuntos de dados sintéticos e originais.

A pontuação de similaridade é limitada entre zero e um, com uma pontuação de um indicando que as distribuições de dados sintéticos se sobrepõem perfeitamente às distribuições dos dados originais.

Uma pontuação próxima a um daria aos usuários a confiança de que o conjunto de dados de validação e o conjunto de dados sintético são estatisticamente semelhantes.

Pontuação de informação mútua

A pontuação de informação mútua mede a dependência mútua de duas características, numéricas ou categóricas, indicando quanta informação pode ser obtida de uma característica observando outra.

A informação mútua pode medir relações não lineares, fornecendo uma compreensão mais abrangente da qualidade dos dados sintéticos, pois permite entender o grau de preservação das relações da variável.

Uma pontuação de um indica que a dependência mútua entre os recursos foi perfeitamente capturada nos dados sintéticos.

Pontuação de correlação

A pontuação de correlação mede o quão bem as correlações no conjunto de dados original foram capturadas nos dados sintéticos.

As correlações entre duas ou mais colunas são extremamente importantes para aplicativos de ML, que ajudam a descobrir relacionamentos entre recursos e a variável de destino e ajudam a criar um modelo bem treinado.

A pontuação de correlação é limitada entre zero e um, com uma pontuação de um indicando que as correlações foram perfeitamente combinadas.

Ao contrário dos dados tabulares estruturados, que comumente encontramos em problemas de dados, alguns tipos de dados estruturados têm um comportamento particular em que as observações anteriores têm a probabilidade de influenciar a observação seguinte. Estes são conhecidos como séries temporais ou dados sequenciais – por exemplo, um conjunto de dados com medições horárias da temperatura ambiente.

Esse comportamento significa que há um requisito para definir determinadas métricas que podem medir especificamente a qualidade desses conjuntos de dados de séries temporais

Pontuação de autocorrelação e autocorrelação parcial

Embora semelhante à correlação, a autocorrelação mostra a relação de uma série temporal em seu valor atual em relação a seus valores anteriores. A remoção dos efeitos dos intervalos de tempo anteriores gera autocorrelação parcial. Portanto, a pontuação de autocorrelação mede quão bem os dados sintéticos capturaram as autocorrelações significativas, ou correlações parciais, do conjunto de dados original.

Métricas para entender a utilidade

Agora podemos ter percebido estatisticamente que os dados sintéticos são semelhantes ao conjunto de dados original. Além disso, também devemos avaliar o desempenho do conjunto de dados sintetizado em problemas comuns de ciência de dados quando treinado em vários algoritmos de ML.

Usando o seguinte utilidade métricas, pretendemos criar confiança de que podemos realmente obter desempenho em aplicativos downstream em relação ao desempenho dos dados originais.

pontuação de previsão

Medir o desempenho de dados sintéticos em comparação com os dados reais originais pode ser feito por meio de modelos de ML. A pontuação do modelo downstream captura a qualidade dos dados sintéticos comparando o desempenho dos modelos de ML treinados nos conjuntos de dados sintéticos e originais e validados em dados de teste retidos do conjunto de dados original. Isso fornece um Pontuação do Teste Sintético de Trem Real (TSTR) e de um Treinar Real Testar Real (TRTR) pontuação respectivamente.

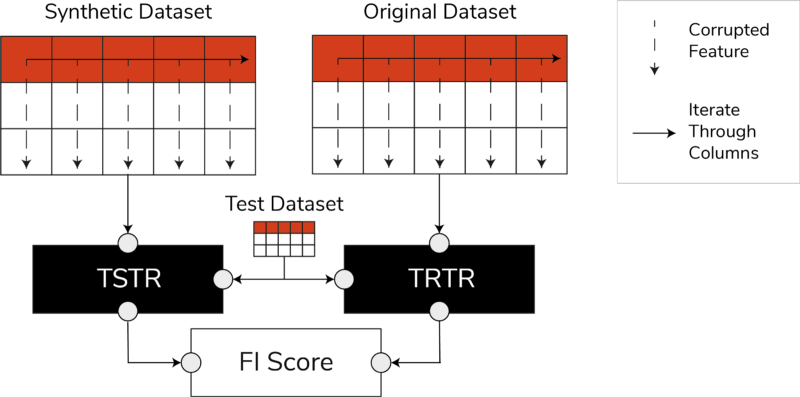

Pontuações TSTR, TRTR e a pontuação de importância do recurso (imagem do autor)

A pontuação incorpora uma ampla variedade dos algoritmos de ML mais confiáveis para tarefas de regressão ou classificação. O uso de vários classificadores e regressores garante que a pontuação seja mais generalizável na maioria dos algoritmos, para que os dados sintéticos possam ser considerados úteis no futuro.

No final, se a pontuação TSTR e a pontuação TRTR forem comparáveis, isso indica que os dados sintéticos têm qualidade para serem usados para treinar modelos de ML eficazes para aplicativos do mundo real.

Pontuação de importância do recurso

Altamente relacionada à pontuação de previsão, a pontuação de importância do recurso (FI) a estende adicionando interpretabilidade às pontuações TSTR e TRTR.

A pontuação F1 compara as mudanças e a estabilidade da ordem de importância do recurso obtida com a pontuação de previsão. Um conjunto sintético de dados é considerado de alta utilidade se produzir a mesma ordem de importância de recursos que os dados reais originais.

QScore

Para garantir que um modelo treinado com nossos dados recém-gerados produzirá as mesmas respostas para as mesmas perguntas que um modelo treinado com os dados originais, usamos o Qscore. Isso mede o desempenho downstream dos dados sintéticos executando muitas consultas baseadas em agregação aleatória nos conjuntos de dados sintéticos e originais (e de validação).

A ideia aqui é que ambas as consultas devem retornar resultados semelhantes.

Um QScore alto garante que os aplicativos downstream que utilizam operações de consulta e agregação possam fornecer um valor quase igual ao do conjunto de dados original.

Métricas para entender a privacidade

Com o política de privacidade regulamentos já em vigor, é uma obrigação ética e um requisito legal garantir que informações confidenciais sejam protegidas.

Antes que esses dados sintéticos possam ser compartilhados livremente e usados para aplicativos downstream, devemos considerar as métricas de privacidade que podem ajudar a parte interessada a entender onde estão os dados sintéticos gerados em comparação com os dados originais em termos da extensão das informações vazadas. Além disso, devemos tomar decisões críticas sobre como os dados sintéticos podem ser compartilhados e usados.

Pontuação exata da partida

Uma avaliação direta e intuitiva da privacidade é procurar cópias dos dados reais entre os registros sintéticos. A pontuação de correspondência exata conta o número de registros reais que podem ser encontrados entre o conjunto sintético.

A pontuação deve ser zero, afirmando que nenhuma informação real está presente como está nos dados sintéticos. Essa métrica atua como um mecanismo de triagem antes de avaliarmos outras métricas de privacidade.

Pontuação de privacidade dos vizinhos

Além disso, a pontuação de privacidade dos vizinhos mede a proporção de registros sintéticos que podem ser muito semelhantes aos reais. Isso significa que, embora não sejam cópias diretas, são pontos potenciais de vazamento de privacidade e uma fonte de informações úteis para ataques de inferência.

A pontuação é calculada conduzindo uma pesquisa de vizinhos mais próximos de alta dimensão nos dados sintéticos sobrepostos aos dados originais.

Pontuação de inferência de associação

No ciclo de vida da ciência de dados, depois que um modelo é treinado, ele não precisa mais acessar as amostras de treinamento e pode fazer previsões sobre dados não vistos. Da mesma forma, em nosso caso, uma vez treinado o modelo sintetizador, amostras de dados sintéticos podem ser geradas sem a necessidade dos dados originais.

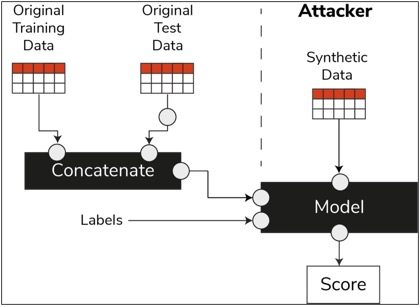

Através de um tipo de ataque chamado “ataque de inferência de membros”, os invasores podem tentar revelar os dados que foram usados para criar os dados sintéticos, sem ter acesso aos dados originais. Isso resulta em um comprometimento da privacidade.

A pontuação de inferência de associação mede a probabilidade de um ataque de inferência de associação ser bem-sucedido.

Uma pontuação baixa sugere a viabilidade de inferência de que um determinado registro era um membro do conjunto de dados de treinamento que levou à criação dos dados sintéticos. Em outras palavras, os ataques podem inferir detalhes de um registro individual, comprometendo assim a privacidade.

Uma alta pontuação de inferência de associação indica que é improvável que um invasor determine se um determinado registro fazia parte do conjunto de dados original usado para criar os dados sintéticos. Isso também significa que nenhuma informação individual foi comprometida por meio dos dados sintéticos.

O conceito de resistência

Uma prática recomendada importante que devemos seguir é garantir que os dados sintéticos sejam gerais o suficiente e não superajustem os dados originais nos quais foram treinados. No fluxo típico de ciência de dados, ao criar modelos de ML, como um classificador Random Forest, deixamos de lado os dados de teste, treinamos os modelos usando os dados de treinamento e avaliamos as métricas em dados de teste não vistos.

Da mesma forma, para dados sintéticos, mantemos de lado uma amostra dos dados originais – geralmente referidos como um conjunto de dados de retenção ou dados de teste retidos não vistos – e avaliamos os dados sintéticos gerados em relação ao conjunto de dados de retenção.

Espera-se que o conjunto de dados de validação seja uma representação dos dados originais, mas não visto quando os dados sintéticos foram gerados. Portanto, é vital ter pontuações semelhantes para todas as métricas ao comparar o original com o de validação e os conjuntos de dados sintéticos.

Quando pontuações semelhantes são obtidas, podemos estabelecer que os pontos de dados sintéticos não são resultado da memorização dos pontos de dados originais, preservando a mesma fidelidade e utilidade.

Considerações finais

O mundo está começando a entender a importância estratégica dos dados sintéticos. Como cientistas de dados e geradores de dados, é nosso dever construir confiança nos dados sintéticos que geramos e garantir que sejam para um propósito.

Os dados sintéticos estão evoluindo para um item obrigatório no kit de ferramentas de desenvolvimento de ciência de dados. A Revisão de Tecnologia do MIT tem notado dados sintéticos como uma das tecnologias revolucionárias de 2022. Não podemos imaginar a construção de modelos de IA de excelente valor sem dados sintéticos, afirma Gartner.

De acordo com o McKinsey, os dados sintéticos minimizam os custos e as barreiras que você teria ao desenvolver algoritmos ou obter acesso aos dados.

A geração de dados sintéticos é sobre conhecer os aplicativos downstream e entender as compensações entre as diferentes dimensões para a qualidade dos dados sintéticos.

Resumo

Como usuário dos dados sintéticos, é essencial definir o contexto do caso de uso para o qual cada amostra de sintético será usada no futuro. Assim como nos dados reais, a qualidade dos dados sintéticos depende do caso de uso pretendido, bem como dos parâmetros escolhidos para a sintetização.

Por exemplo, manter outliers nos dados sintéticos como nos dados originais é útil para um caso de uso de detecção de fraude. No entanto, não é útil em um caso de uso de assistência médica com preocupações de privacidade, pois valores discrepantes geralmente podem ser vazamento de informações.

Além disso, existe uma compensação entre fidelidade, utilidade e privacidade. Os dados não podem ser otimizados para os três simultaneamente. Essas métricas permitem que as partes interessadas priorizem o que é essencial para cada caso de uso e gerenciem as expectativas a partir dos dados sintéticos gerados.

Em última análise, quando vemos os valores de cada métrica e quando eles atendem às expectativas, as partes interessadas podem confiar nas soluções que criam usando os dados sintéticos.

Os casos de uso para dados sintéticos estruturados abrangem uma ampla gama de aplicações, desde dados de teste para desenvolvimento de software até a criação de braços de controle sintéticos em ensaios clínicos.

Entre em contato para explorar essas oportunidades ou crie uma PoC para demonstrar o valor.

Faris Haddad é o Líder de Data & Insights na equipe AABG Strategic Pursuits. Ele ajuda as empresas a se tornarem orientadas por dados com sucesso.

Faris Haddad é o Líder de Data & Insights na equipe AABG Strategic Pursuits. Ele ajuda as empresas a se tornarem orientadas por dados com sucesso.

- Avançado (300)

- AI

- arte ai

- gerador de arte ai

- ai robô

- Aprendizado de máquina da Amazon

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- Aprendizado de máquina da AWS

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- escala ai

- sintaxe

- Instruções Técnicas

- zefirnet