Introdução

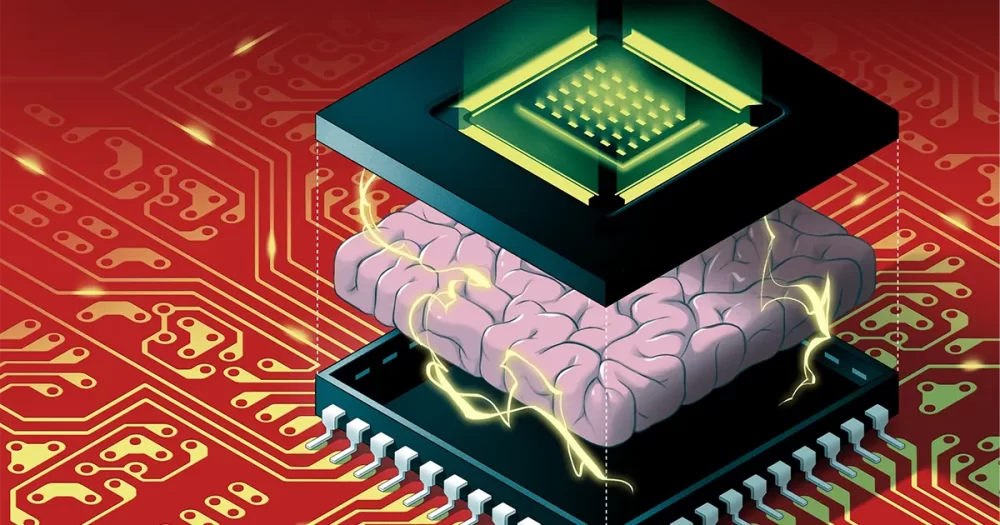

Os algoritmos de inteligência artificial não podem continuar crescendo no ritmo atual. Algoritmos como redes neurais profundas – que são vagamente inspirados pelo cérebro, com várias camadas de neurônios artificiais ligados uns aos outros por meio de valores numéricos chamados pesos – ficam maiores a cada ano. Mas hoje em dia, as melhorias de hardware não estão mais acompanhando a enorme quantidade de memória e capacidade de processamento necessária para executar esses algoritmos maciços. Em breve, o tamanho dos algoritmos de IA pode atingir um limite.

E mesmo que pudéssemos continuar ampliando o hardware para atender às demandas da IA, há outro problema: executá-los em computadores tradicionais desperdiça uma quantidade enorme de energia. As altas emissões de carbono geradas pela execução de grandes algoritmos de IA já são prejudiciais ao meio ambiente e só piorarão à medida que os algoritmos se tornarem cada vez mais gigantescos.

Uma solução, chamada de computação neuromórfica, se inspira em cérebros biológicos para criar designs com eficiência energética. Infelizmente, embora esses chips possam ultrapassar os computadores digitais na conservação de energia, eles carecem do poder computacional necessário para executar uma rede neural profunda considerável. Isso os tornou fáceis de serem ignorados pelos pesquisadores de IA.

Isso finalmente mudou em agosto, quando Weier Wan, H.-S. Filipe Wong, Gert Cauwenberghs e seus colegas revelou um novo chip neuromórfico chamado NeuRRAM que inclui 3 milhões de células de memória e milhares de neurônios embutidos em seu hardware para executar algoritmos. Ele usa um tipo relativamente novo de memória chamada RAM resistiva ou RRAM. Ao contrário dos chips RRAM anteriores, o NeuRRAM é programado para operar de maneira analógica para economizar mais energia e espaço. Embora a memória digital seja binária - armazenando 1 ou 0 - as células de memória analógica no chip NeuRRAM podem armazenar vários valores em uma faixa totalmente contínua. Isso permite que o chip armazene mais informações de algoritmos de IA massivos na mesma quantidade de espaço do chip.

Como resultado, o novo chip pode funcionar tão bem quanto computadores digitais em tarefas complexas de IA, como reconhecimento de imagem e fala, e os autores afirmam que é até 1,000 vezes mais eficiente em termos de energia, abrindo a possibilidade de pequenos chips executarem algoritmos cada vez mais complicados. dentro de pequenos dispositivos anteriormente inadequados para IA, como relógios e telefones inteligentes.

Pesquisadores não envolvidos no trabalho ficaram profundamente impressionados com os resultados. “Este papel é bastante original”, disse Zhong Rui Wang, um pesquisador RRAM de longa data da Universidade de Hong Kong. “Ele faz contribuições em diferentes níveis – no nível do dispositivo, no nível da arquitetura do circuito e no nível do algoritmo.”

Criando novas memórias

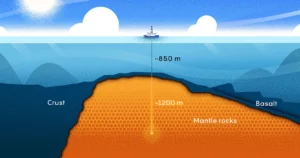

Em computadores digitais, as enormes quantidades de energia desperdiçadas enquanto executam algoritmos de IA são causadas por uma falha de design simples e onipresente que torna cada computação ineficiente. Normalmente, a memória de um computador – que contém os dados e valores numéricos que ele processa durante a computação – é colocada na placa-mãe longe do processador, onde a computação ocorre.

Para as informações que passam pelo processador, “é como se você passasse oito horas no trânsito, mas fizesse duas horas de trabalho”, disse Wan, um cientista da computação da Universidade de Stanford que recentemente se mudou para a startup de IA Aizip.

Introdução

Corrigir esse problema com novos chips tudo-em-um que colocam memória e computação no mesmo lugar parece simples. Também está mais próximo de como nossos cérebros provavelmente processam informações, já que muitos neurocientistas acreditam que a computação acontece dentro de populações de neurônios, enquanto as memórias são formadas quando as sinapses entre os neurônios fortalecem ou enfraquecem suas conexões. Mas criar tais dispositivos provou ser difícil, já que as formas atuais de memória são incompatíveis com a tecnologia dos processadores.

Cientistas da computação, décadas atrás, desenvolveram os materiais para criar novos chips que executam cálculos onde a memória é armazenada – uma tecnologia conhecida como computação na memória. Mas com os computadores digitais tradicionais funcionando tão bem, essas ideias foram negligenciadas por décadas.

“Esse trabalho, assim como a maioria dos trabalhos científicos, foi meio que esquecido”, disse Wong, professor de Stanford.

Com efeito, o primeiro tal dispositivo remonta pelo menos a 1964, quando engenheiros elétricos de Stanford descobriram que podiam manipular certos materiais, chamados óxidos metálicos, para ativar e desativar sua capacidade de conduzir eletricidade. Isso é significativo porque a capacidade de um material de alternar entre dois estados fornece a espinha dorsal para o armazenamento de memória tradicional. Normalmente, na memória digital, um estado de alta voltagem corresponde a 1 e baixa voltagem a 0.

Para fazer um dispositivo RRAM mudar de estado, você aplica uma voltagem através de eletrodos de metal conectados a duas extremidades do óxido de metal. Normalmente, os óxidos metálicos são isolantes, o que significa que não conduzem eletricidade. Mas com voltagem suficiente, a corrente se acumula, eventualmente passando pelos pontos fracos do material e abrindo um caminho para o eletrodo do outro lado. Depois que a corrente passa, ela pode fluir livremente ao longo desse caminho.

Wong compara esse processo a um raio: quando uma carga suficiente se acumula dentro de uma nuvem, ela rapidamente encontra um caminho de baixa resistência e cai um raio. Mas, ao contrário do raio, cujo caminho desaparece, o caminho através do óxido metálico permanece, o que significa que permanece condutor indefinidamente. E é possível apagar o caminho condutivo aplicando outra voltagem ao material. Assim, os pesquisadores podem alternar uma RRAM entre dois estados e usá-los para armazenar memória digital.

Os pesquisadores de meados do século não reconheceram o potencial da computação com eficiência energética, nem precisavam disso ainda com os algoritmos menores com os quais estavam trabalhando. Demorou até o início dos anos 2000, com a descoberta de novos óxidos metálicos, para os pesquisadores perceberem as possibilidades.

Wong, que trabalhava na IBM na época, lembra que um colega premiado que trabalhava na RRAM admitiu que não entendia completamente a física envolvida. “Se ele não entende”, Wong lembra de pensar, “talvez eu não devesse tentar entender”.

Mas em 2004, pesquisadores da Samsung Electronics anunciaram que haviam memória RRAM integrada com sucesso construído sobre um chip de computação tradicional, sugerindo que um chip de computação em memória pode finalmente ser possível. Wong resolveu pelo menos tentar.

Chips de computação na memória para IA

Por mais de uma década, pesquisadores como Wong trabalharam para desenvolver a tecnologia RRAM até o ponto em que pudesse lidar de forma confiável com tarefas de computação de alta potência. Por volta de 2015, os cientistas da computação começaram a reconhecer o enorme potencial desses dispositivos energeticamente eficientes para grandes algoritmos de IA, que estavam começando a decolar. Naquele ano, cientistas da Universidade da Califórnia, Santa Barbara mostrou que os dispositivos RRAM poderiam fazer mais do que apenas armazenar memória de uma nova maneira. Eles próprios poderiam executar tarefas básicas de computação – incluindo a grande maioria das computações que ocorrem dentro dos neurônios artificiais de uma rede neural, que são tarefas simples de multiplicação de matrizes.

No chip NeuRRAM, os neurônios de silício são incorporados ao hardware e as células de memória RRAM armazenam os pesos – os valores que representam a força das conexões entre os neurônios. E como as células de memória NeuRRAM são analógicas, os pesos que elas armazenam representam toda a gama de estados de resistência que ocorrem enquanto o dispositivo alterna entre um estado de baixa resistência e um estado de alta resistência. Isso permite uma eficiência de energia ainda maior do que a memória RRAM digital pode alcançar porque o chip pode executar muitos cálculos de matriz em paralelo - em vez de um após o outro, como nas versões de processamento digital.

Mas como o processamento analógico ainda está décadas atrás do processamento digital, ainda há muitos problemas a serem resolvidos. Uma delas é que os chips RRAM analógicos devem ser extraordinariamente precisos, pois as imperfeições no chip físico podem introduzir variabilidade e ruído. (Para chips tradicionais, com apenas dois estados, essas imperfeições não importam tanto.) Isso torna significativamente mais difícil para dispositivos RRAM analógicos executar algoritmos de IA, dado que a precisão de, digamos, reconhecer uma imagem será prejudicada se o o estado condutivo do dispositivo RRAM não é exatamente o mesmo todas as vezes.

“Quando olhamos para um caminho de iluminação, cada vez é diferente”, disse Wong. “Então, como resultado disso, o RRAM exibe um certo grau de estocasticidade – toda vez que você os programa é um pouco diferente.” Wong e seus colegas provaram que os dispositivos RRAM podem armazenar pesos contínuos de IA e ainda serem tão precisos quanto computadores digitais se os algoritmos forem treinados para se acostumar com o ruído que encontram no chip, um avanço que lhes permitiu produzir o chip NeuRRAM.

Introdução

Outra questão importante que eles tiveram que resolver envolvia a flexibilidade necessária para suportar diversas redes neurais. No passado, os projetistas de chips tinham que alinhar os minúsculos dispositivos RRAM em uma área ao lado de neurônios de silício maiores. Os dispositivos RRAM e os neurônios foram conectados sem programação, de modo que a computação só poderia ser realizada em uma única direção. Para suportar redes neurais com computação bidirecional, eram necessários fios e circuitos extras, aumentando as necessidades de energia e espaço.

Então, a equipe de Wong projetou uma nova arquitetura de chip onde os dispositivos de memória RRAM e os neurônios de silício foram misturados. Essa pequena mudança no projeto reduziu a área total e economizou energia.

“Achei [o arranjo] muito bonito”, disse Melika Payvand, pesquisador neuromórfico do Instituto Federal Suíço de Tecnologia de Zurique. “Definitivamente, considero um trabalho inovador.”

Por vários anos, a equipe de Wong trabalhou com colaboradores para projetar, fabricar, testar, calibrar e executar algoritmos de IA no chip NeuRRAM. Eles consideraram o uso de outros tipos emergentes de memória que também podem ser usados em um chip de computação na memória, mas a RRAM tinha uma vantagem por causa de suas vantagens na programação analógica e porque era relativamente fácil de integrar com materiais de computação tradicionais.

Seus resultados recentes representam o primeiro chip RRAM que pode executar algoritmos de IA tão grandes e complexos – um feito que antes só era possível em simulações teóricas. “Quando se trata de silício real, essa capacidade estava faltando”, disse Anup Das, um cientista da computação da Drexel University. “Este trabalho é a primeira demonstração.”

“Os sistemas de IA digital são flexíveis e precisos, mas muito menos eficientes”, disse Cauwenberghs. Agora, disse Cauwenberghs, seu chip RRAM analógico flexível, preciso e eficiente em termos de energia “preencheu a lacuna pela primeira vez”.

Escalando acima

O design da equipe mantém o chip NeuRRAM minúsculo - do tamanho de uma unha - enquanto comprime 3 milhões de dispositivos de memória RRAM que podem servir como processadores analógicos. E embora possa executar redes neurais tão bem quanto computadores digitais, o chip também (e pela primeira vez) pode executar algoritmos que realizam cálculos em diferentes direções. Seu chip pode inserir uma tensão nas linhas da matriz RRAM e ler as saídas das colunas como é padrão para chips RRAM, mas também pode fazer isso de trás para as colunas, para que possa ser usado em redes neurais que operam com dados fluindo em direções diferentes.

Tal como acontece com a própria tecnologia RRAM, isso é possível há muito tempo, mas ninguém pensou em fazê-lo. “Por que não pensamos nisso antes?” perguntou Payvand. “Em retrospectiva, não sei.”

“Na verdade, isso abre muitas outras oportunidades”, disse Das. Como exemplos, ele mencionou a capacidade de um sistema simples de executar os enormes algoritmos necessários para simulações físicas multidimensionais ou carros autônomos.

No entanto, o tamanho é um problema. As maiores redes neurais agora contêm bilhões de pesos, não os milhões contidos nos novos chips. Wong planeja escalar empilhando vários chips NeuRRAM uns sobre os outros.

Será igualmente importante manter os custos de energia baixos em dispositivos futuros ou reduzi-los ainda mais. Uma maneira de chegar lá é por copiando o cérebro ainda mais de perto para adotar o sinal de comunicação usado entre neurônios reais: o pico elétrico. É um sinal disparado de um neurônio para outro quando a diferença de voltagem entre o interior e o exterior da célula atinge um limite crítico.

“Existem grandes desafios aí”, disse Tony Kenyon, pesquisador de nanotecnologia da University College London. “Mas ainda podemos querer seguir nessa direção, porque … as chances são de que você terá maior eficiência energética se estiver usando picos muito esparsos.” Para executar algoritmos que atingem o chip NeuRRAM atual, provavelmente seria necessária uma arquitetura totalmente diferente, observou Kenyon.

Por enquanto, a eficiência energética que a equipe alcançou ao executar grandes algoritmos de IA no chip NeuRRAM criou uma nova esperança de que as tecnologias de memória possam representar o futuro da computação com IA. Talvez um dia consigamos igualar os 86 bilhões de neurônios do cérebro humano e os trilhões de sinapses que os conectam sem ficar sem energia.