Os pesquisadores descobriram mais de 100 modelos maliciosos de aprendizado de máquina (ML) na plataforma Hugging Face AI que podem permitir que invasores injetem código malicioso nas máquinas dos usuários.

Embora o Hugging Face implemente medidas de segurança, as descobertas destacam o risco crescente de “armamento” de modelos disponíveis publicamente, pois podem criar uma porta dos fundos para os invasores.

As descobertas da JFrog Security Research fazem parte de um estudo em andamento para analisar como os hackers podem usar o ML para atacar os usuários.

Conteúdo prejudicial

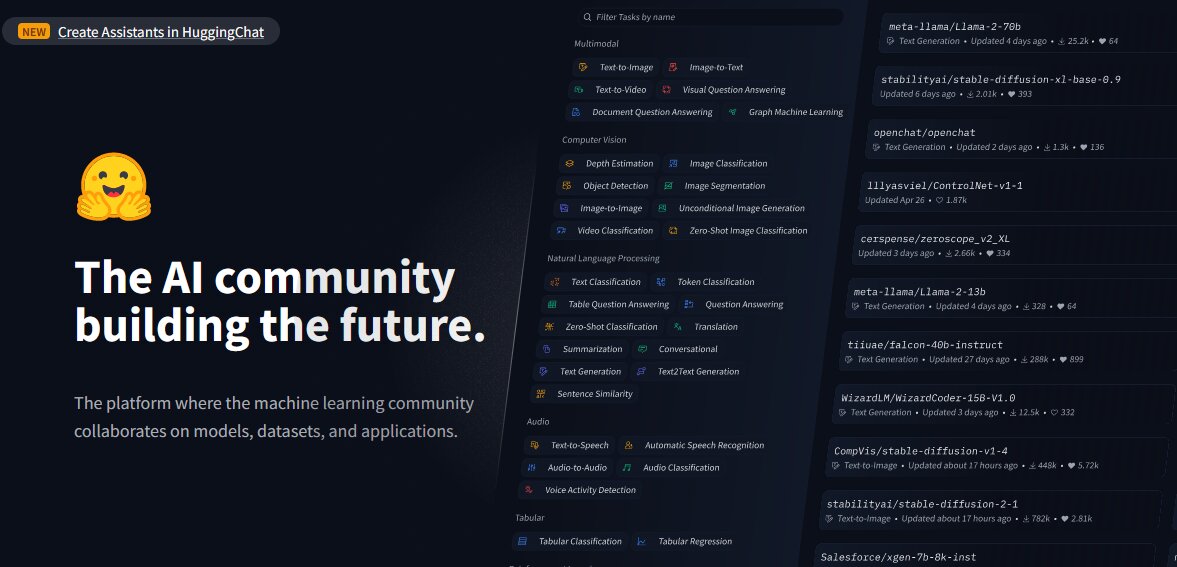

De acordo com um artigo de Computação, os pesquisadores desenvolveram um sistema de digitalização avançado para examinar modelos hospedados na plataforma Hugging Face AI, como PyTorch e Tensorflow Keras.

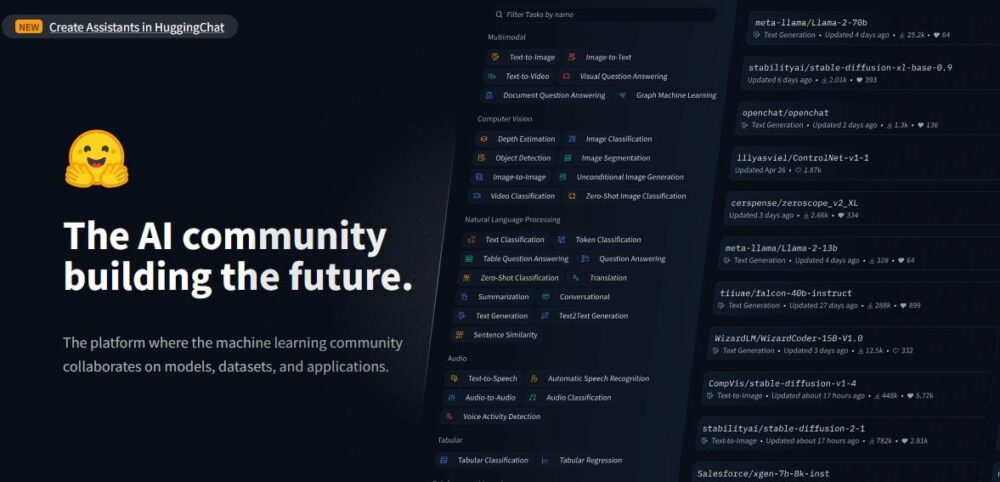

Hugging Face é uma plataforma desenvolvida para compartilhar modelos, conjuntos de dados e aplicativos de IA. Ao analisar os modelos, os pesquisadores descobriram cargas prejudiciais “dentro de modelos aparentemente inócuos”.

Isso ocorre apesar do fato de Hugging Face executar medidas de segurança como malware e verificação de picles. No entanto, a plataforma não restringe o download de modelos que possam ser potencialmente prejudiciais e também permite disponibilizar publicamente Modelos de IA para ser abusado e transformado em arma pelos usuários.

Ao examinar a plataforma e os modelos existentes, os pesquisadores de segurança da JFrog descobriram cerca de 100 modelos de IA com funcionalidades maliciosas, de acordo com seu relatório. Denunciar.

Alguns desses modelos, indica o relatório, são capazes de executar código nas máquinas dos usuários, “criando assim um backdoor persistente para os invasores”.

Os pesquisadores também indicaram que tais descobertas excluem falsos positivos. Estes, disseram eles, são uma representação precisa da prevalência de modelos maliciosos na plataforma.

Veja também: Apple redireciona equipe automotiva para desaceleração do mercado pós-EV de IA

Os exemplos

Segundo o relatório do JFrog, um dos casos “alarmantes” envolve um PyTorch modelo. O modelo teria sido carregado por um usuário identificado como “baller423”, que foi posteriormente excluído da plataforma Hugging Face.

Ao examinar mais detalhadamente o modelo, os pesquisadores notaram que ele continha uma carga maliciosa, permitindo estabelecer um shell reverso em um host especificado (210.117.212.93).

O pesquisador sênior de segurança da JFrog, David Cohen, disse: “(É) notavelmente mais intrusivo e potencialmente malicioso, pois estabelece uma conexão direta com um servidor externo, indicando uma potencial ameaça à segurança, em vez de uma mera demonstração de vulnerabilidade”, escreveu ele.

Isso aproveita “o método '_reduce_' do módulo pickle do Python para executar código arbitrário ao carregar o arquivo de modelo, ignorando efetivamente os métodos de detecção convencionais”.

Os pesquisadores também reconheceram que a mesma carga estava criando conexões para diferentes endereços IP, “sugerindo que os operadores podem ser pesquisadores, e não hackers mal-intencionados”.

Um alerta

A equipe JFrog observou que as descobertas são um alerta para o Hugging Face, mostrando que sua plataforma é propensa a manipulação e ameaças potenciais.

“Esses incidentes servem como lembretes comoventes das ameaças contínuas enfrentadas pelos repositórios Hugging Face e outros repositórios populares, como o Kaggle, que podem comprometer a privacidade e a segurança das organizações que utilizam esses recursos, além de representar desafios para os engenheiros de IA/ML”, disse Os pesquisadores.

Isto vem como ameaças à segurança cibernética em todo o mundo estão a aumentar, alimentados pela proliferação de ferramentas de IA, com maus atores a abusarem delas com intenções maliciosas. Os hackers também estão usando IA para promover ataques de phishing e enganar as pessoas.

Contudo, a equipe JFrog fez outras descobertas.

Um playground para pesquisadores

Os pesquisadores também notaram que Abraçando o rosto evoluiu para um playground para pesquisadores “que desejam combater ameaças emergentes, como demonstrado pela diversidade de táticas para contornar suas medidas de segurança”.

Por exemplo, a carga carregada por “baller423” iniciou uma conexão shell reversa para um intervalo de endereços IP que pertence à Kreonet (Korea Research Environment Open Network).

De acordo com o Leitura escura, Kreonet é uma rede de alta velocidade na Coreia do Sul que apoia pesquisas avançadas e atividades educacionais; “portanto, é possível que pesquisadores ou profissionais de IA estejam por trás do modelo.”

“Podemos ver que a maioria das cargas 'maliciosos' são, na verdade, tentativas de pesquisadores e/ou recompensas de bugs para obter a execução de código para fins aparentemente legítimos”, disse Cohen.

Apesar dos propósitos legítimos, a equipa JFrog alertou, no entanto, que as estratégias utilizadas pelos investigadores demonstram claramente que plataformas como o Hugging Face estão abertas a ataques à cadeia de abastecimento. Estes, de acordo com a equipe, podem ser personalizados para focar em dados demográficos específicos, como engenheiros de IA ou ML.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://metanews.com/over-100-malicious-code-execution-models-on-hugging-face-backdoors-users-devices/

- :tem

- :é

- :não

- 100

- 210

- 212

- 7

- 9

- a

- Sobre

- Segundo

- preciso

- atividades

- atores

- Adição

- endereço

- endereços

- avançar

- avançado

- AI

- Modelos de IA

- Plataforma de IA

- AI / ML

- tb

- an

- analisar

- análise

- e

- aplicações

- arbitrário

- SOMOS

- Ordem

- artigo

- AS

- ataque

- Ataques

- Tentativas

- disponível

- Porta dos fundos

- Mau

- BE

- sido

- atrás

- pertence

- recompensa

- Bug

- recompensa bug

- by

- ignorar

- chamada

- CAN

- capaz

- carro

- casos

- desafios

- claramente

- CO

- código

- cohen

- combater

- vem

- compromisso

- computação

- da conexão

- Coneções

- contida

- convencional

- poderia

- crio

- Criar

- personalizado

- conjuntos de dados

- David

- Demografia

- demonstrar

- demonstraram

- Apesar de

- Detecção

- desenvolvido

- diferente

- diretamente

- descoberto

- diferente

- parece

- download

- educacional

- efetivamente

- emergente

- empregada

- permitir

- permite

- permitindo

- Engenheiros

- Meio Ambiente

- estabelecer

- estabelece

- evoluiu

- Examinando

- executar

- executando

- execução

- existente

- externo

- Rosto

- enfrentando

- fato

- falso

- Envie o

- descobertas

- Foco

- Escolha

- formulário

- da

- alimentaram

- funcionalidade

- mais distante

- ter

- Crescente

- hackers

- prejudicial

- Ter

- he

- Alta

- Destaques

- hospedeiro

- hospedado

- Como funciona o dobrador de carta de canal

- Contudo

- HTTPS

- identificado

- implementa

- in

- Crescimento

- indicado

- indicam

- indicador

- iniciado

- injetável

- instância

- intenções

- para dentro

- intrusivo

- envolve

- IP

- Endereço IP

- Endereços IP

- IT

- ESTÁ

- jpg

- keras

- Coréia

- aprendizagem

- legítimo

- aproveita as

- como

- carregamento

- máquina

- aprendizado de máquina

- máquinas

- moldadas

- malicioso

- malwares

- Manipulação

- mercado

- max-width

- Posso..

- medidas

- mers

- método

- métodos

- ML

- modelo

- modelos

- mais

- a maioria

- rede

- notavelmente

- notado

- of

- on

- ONE

- contínuo

- para

- aberto

- rede aberta

- operadores

- or

- organizações

- Outros

- Fora

- Acima de

- parte

- Pessoas

- Phishing

- ataques de phishing

- plataforma

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- recreio

- Popular

- possível

- potencial

- potencialmente

- predomínio

- política de privacidade

- Privacidade e segurança

- publicamente

- fins

- pytorch

- alcance

- em vez

- Leia

- reconhecido

- Denunciar

- alegadamente

- representação

- pesquisa

- investigador

- pesquisadores

- Recursos

- restringir

- reverso

- Risco

- Dito

- mesmo

- exploração

- segurança

- Medidas de Segurança

- Vejo

- aparentemente

- senior

- servir

- servidor

- compartilhando

- concha

- mostrando

- Sul

- Coreia do Sul

- específico

- especificada

- estratégias

- Estudo

- Subseqüentemente

- tal

- Apoiar

- .

- tática

- Profissionais

- fluxo tensor

- do que

- que

- A

- deles

- Eles

- Este

- deles

- ameaça

- ameaças

- para

- ferramentas

- truque

- carregado

- sobre

- usar

- Utilizador

- usuários

- utilização

- Utilizando

- vulnerabilidade

- advertido

- foi

- qual

- desejo

- de

- mundo

- escreveu

- zefirnet