Amazon SageMaker Data Wrangler este un instrument de pregătire a datelor bazat pe UI, care ajută la efectuarea analizei, preprocesării și vizualizării datelor cu funcții de curățare, transformare și pregătire a datelor mai rapid. Șabloanele de flux predefinite Data Wrangler ajută la pregătirea datelor mai rapidă pentru oamenii de știință în date și pentru practicanții de învățare automată (ML), ajutându-vă să accelerați și să înțelegeți modelele de cele mai bune practici pentru fluxurile de date folosind seturi de date comune.

Puteți utiliza fluxurile Data Wrangler pentru a efectua următoarele sarcini:

- Vizualizarea datelor – Examinarea proprietăților statistice pentru fiecare coloană din setul de date, construirea de histograme, studierea valorii aberante

- Curățarea datelor - Eliminarea duplicatelor, eliminarea sau completarea intrărilor cu valori lipsă, eliminarea valorii aberante

- Îmbogățirea datelor și inginerie de caracteristici – Procesarea coloanelor pentru a construi caracteristici mai expresive, selectând un subset de caracteristici pentru antrenament

Această postare vă va ajuta să înțelegeți Data Wrangler folosind următorul exemplu de fluxuri pre-construite GitHub. Depozitul prezintă transformarea datelor tabelare, transformările de date în serie de timp și transformările setului de date unite. Fiecare necesită un tip diferit de transformări din cauza naturii lor de bază. Datele standard tabelare sau transversale sunt colectate la un anumit moment în timp. În schimb, datele din seria temporală sunt captate în mod repetat de-a lungul timpului, fiecare punct de date succesiv depinzând de valorile sale trecute.

Să ne uităm la un exemplu despre cum putem folosi fluxul de date eșantion pentru datele tabelare.

Cerințe preliminare

Data Wrangler este un Amazon SageMaker caracteristică disponibilă în cadrul Amazon SageMaker Studio, așa că trebuie să urmăm procesul de integrare Studio pentru a activa mediul Studio și notebook-urile. Deși puteți alege dintre câteva metode de autentificare, cel mai simplu mod de a crea un domeniu Studio este să urmați Pornire rapidă instrucțiuni. Pornirea rapidă folosește aceleași setări implicite ca și configurație standard Studio. De asemenea, puteți alege să vă îmbarcați folosind Centrul de identitate AWS IAM (succesorul AWS Single Sign-On) pentru autentificare (consultați Accesați domeniul Amazon SageMaker folosind IAM Identity Center).

Importați setul de date și fișierele flux în Data Wrangler folosind Studio

Următorii pași descriu cum să importați date în SageMaker pentru a fi consumate de Data Wrangler:

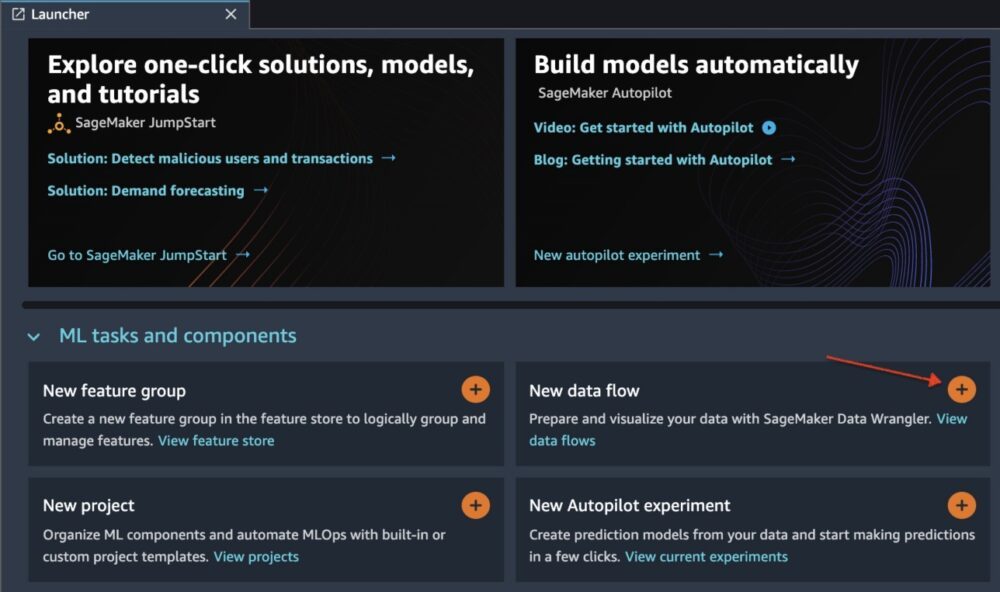

Inițializați Data Wrangler prin interfața de utilizare Studio, alegând Flux de date nou.

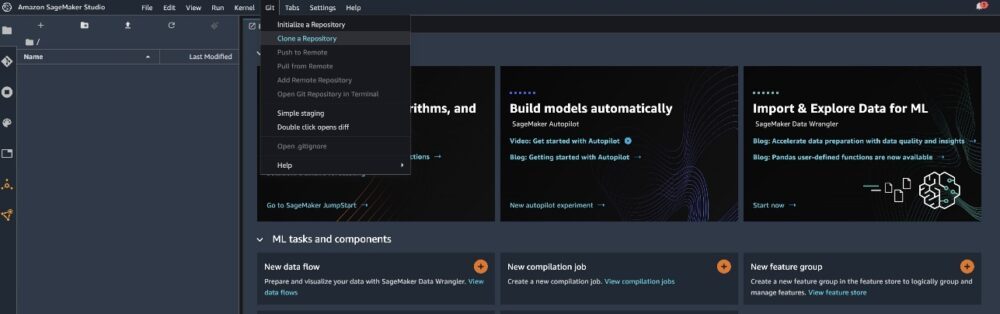

Clonați GitHub repo pentru a descărca fișierele flux în mediul dvs. Studio.

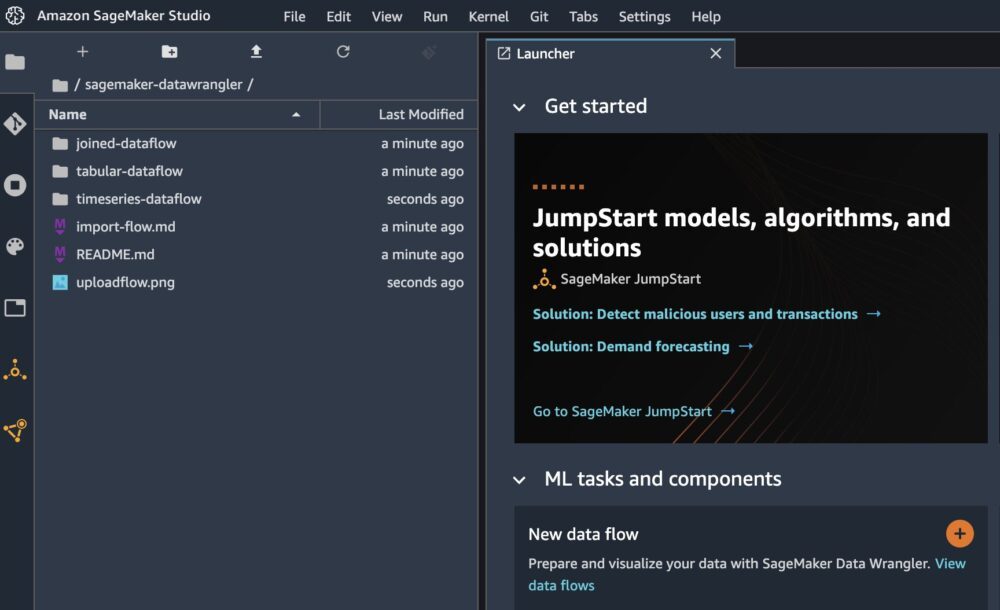

Când clona este completă, ar trebui să puteți vedea conținutul depozitului în panoul din stânga.

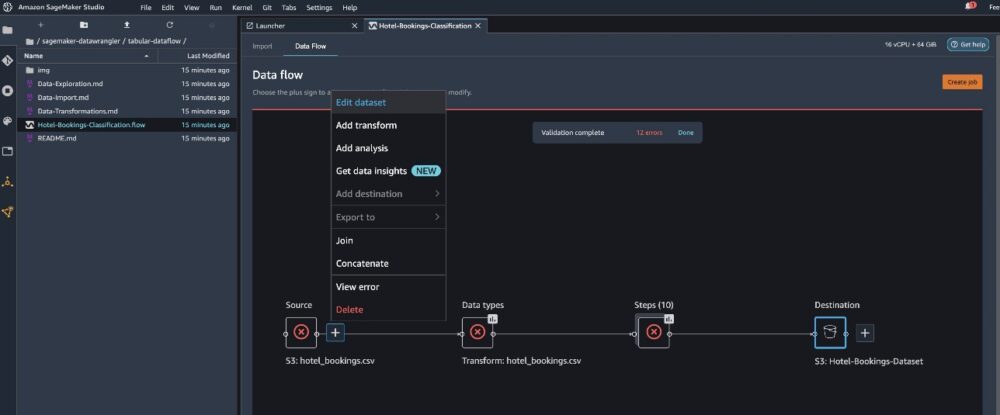

Alegeți fișierul Hotel-Rezervari-Clasificare.flow pentru a importa fișierul flux în Data Wrangler.

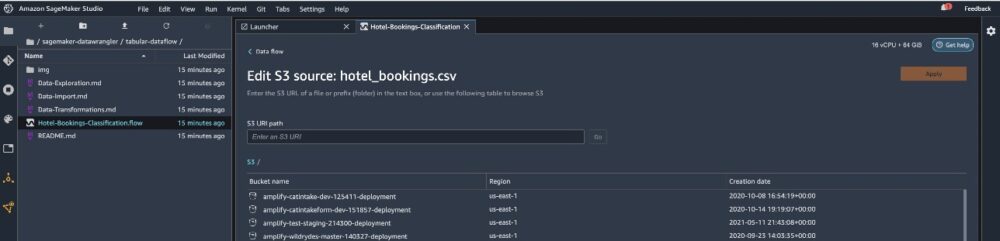

Dacă utilizați seria cronologică sau fluxul de date alăturat, fluxul va apărea ca un nume diferit. După ce fluxul a fost importat, ar trebui să vedeți următoarea captură de ecran. Acest lucru ne arată erori, deoarece trebuie să ne asigurăm că fișierul flux indică sursa corectă de date în Serviciul Amazon de stocare simplă (Amazon S3).

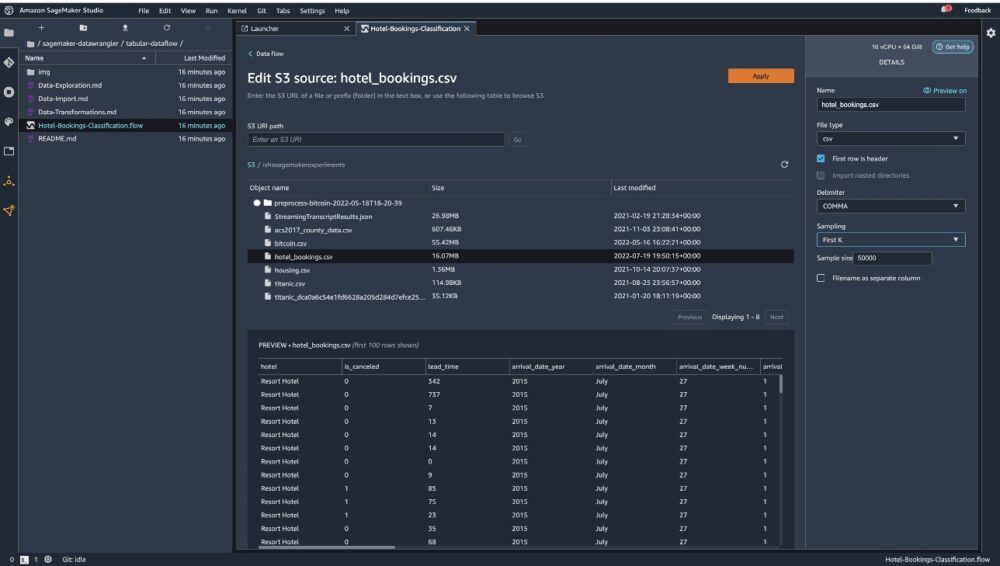

Alege Editați setul de date pentru a vă aduce toate gălețile S3. Apoi, alegeți setul de date hotel_bookings.csv din găleata S3 pentru a alerga prin flux de date tabelar.

Rețineți că, dacă utilizați flux de date asociat, poate fi necesar să importați mai multe seturi de date în Data Wrangler

În panoul din dreapta, asigurați-vă PARAGRAF este ales ca delimitator si Prelevarea de probe este setat la În primul rând K. Setul nostru de date este suficient de mic pentru a rula transformări Data Wrangler pe setul de date complet, dar am vrut să evidențiem cum puteți importa setul de date. Dacă aveți un set de date mare, luați în considerare utilizarea eșantionării. Alege Import pentru a importa acest set de date în Data Wrangler.

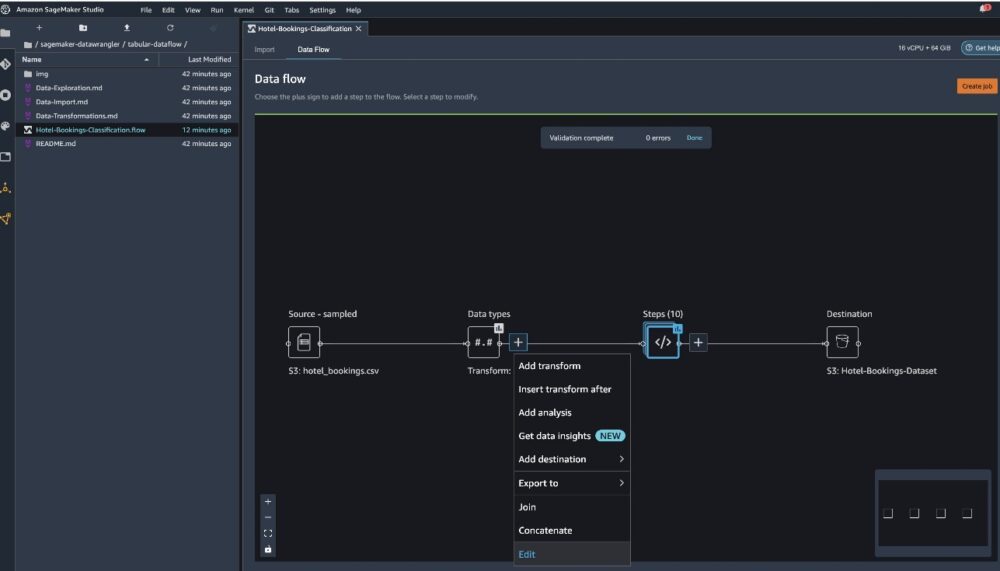

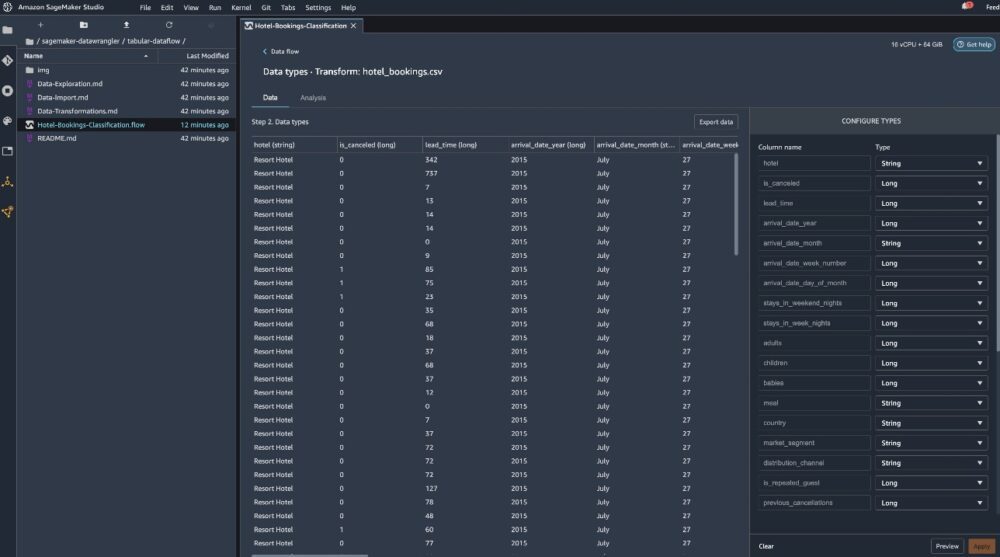

După ce setul de date este importat, Data Wrangler validează automat setul de date și detectează tipurile de date. Puteți vedea că erorile au dispărut deoarece indicăm setul de date corect. Editorul de flux arată acum două blocuri care arată că datele au fost importate dintr-o sursă și tipurile de date recunoscute. De asemenea, puteți edita tipurile de date dacă este necesar.

Următoarea captură de ecran arată tipurile noastre de date.

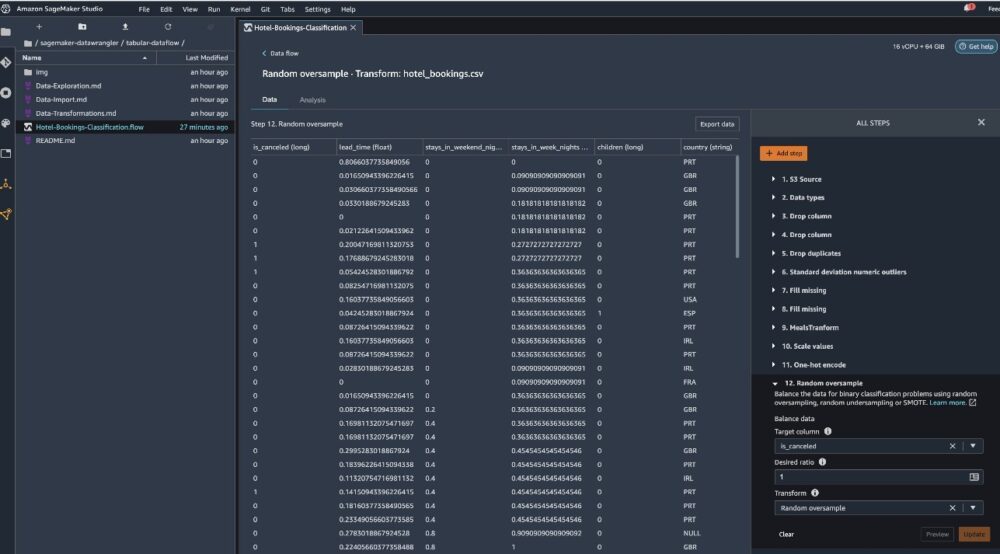

Să ne uităm la unele dintre transformările efectuate ca parte a acestui flux tabelar. Dacă utilizați serii de timp or alăturat fluxuri de date, consultați câteva transformări comune pe GitHub repo. Am efectuat câteva analize exploratorii de bază a datelor utilizând rapoarte de perspectivă a datelor care au studiat scurgerea țintă și coliniaritatea caracteristicilor din setul de date, analize rezumate de tabel și capacitatea de modelare rapidă. Explorați pașii de pe GitHub repo.

Acum aruncăm coloane pe baza recomandărilor oferite de Raportul privind datele și calitatea.

- Pentru scurgeri țintă, aruncați starea_rezervării.

- Pentru coloanele redundante, drop days_in_waiting_list, hotel, reserved_room_type, arrival_date_month, reservation_status_date, bebeluși, și sosire_data_ziua_lunii.

- Pe baza rezultatelor corelației liniare, eliminați coloanele sosire_data_număr_săptămână și sosire_data_an deoarece valorile de corelație pentru aceste perechi de caracteristici (coloane) sunt mai mari decât pragul recomandat de 0.90.

- Pe baza rezultatelor corelației neliniare, scădeți starea_rezervării. Această coloană a fost deja marcată pentru a fi abandonată pe baza analizei de scurgere țintă.

- Procesați valori numerice (scalare min-max) pentru lead_time, stays_in_weekend_nights, stays_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_canceled, booking_changes, adr, total_of_specical_requests, și locuri_de_parcare_necesare.

- One-hot codificare variabile categorice cum ar fi masă, is_repeated_guest, segment_market, assigned_room_type, deposit_type, și tip de client.

- Echilibrați variabila țintă Supraeșantionare aleatorie pentru dezechilibrul clasei. Utilizați capacitatea de modelare rapidă pentru a gestiona valorile aberante și valorile lipsă.

Exportați pe Amazon S3

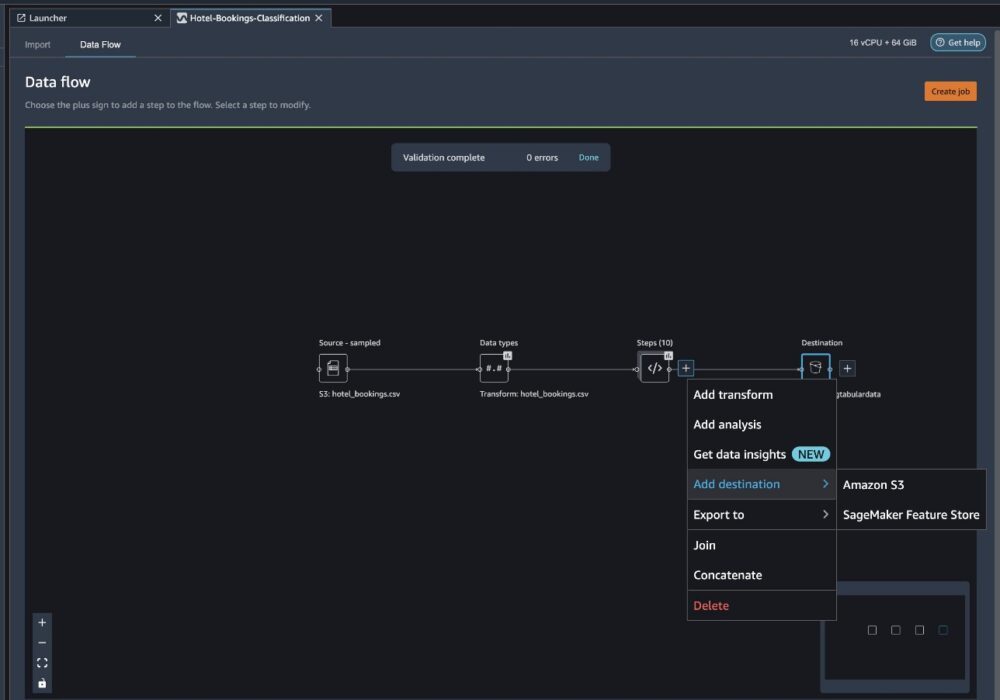

Acum am trecut prin diferitele transformări și suntem gata să exportăm datele pe Amazon S3. Această opțiune creează o sarcină de procesare SageMaker, care rulează fluxul de procesare Data Wrangler și salvează setul de date rezultat într-un compartiment S3 specificat. Urmați următorii pași pentru a configura exportul către Amazon S3:

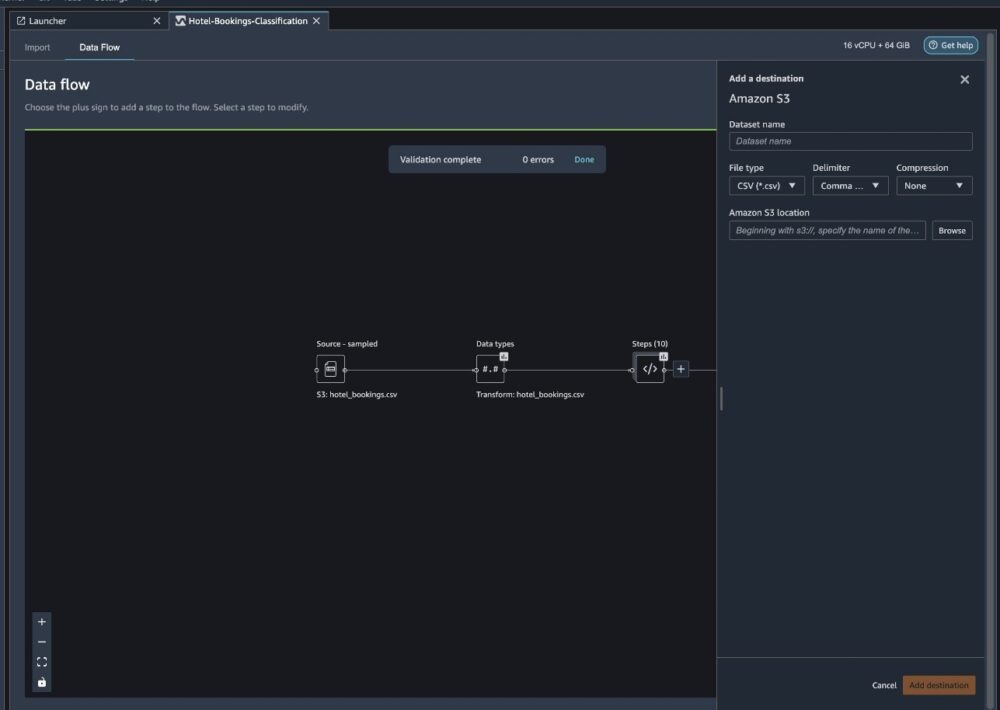

Alegeți semnul plus de lângă o colecție de elemente de transformare și alegeți Adăugați destinația, Apoi Amazon S3.

- Pentru Numele setului de date, introduceți un nume pentru noul set de date, de exemplu

NYC_export. - Pentru Tip de fișier, alege CSV.

- Pentru delimitator, alege virgulă.

- Pentru Comprimare, alege Nici unul.

- Pentru Locație Amazon S3, utilizați același nume de grup pe care l-am creat mai devreme.

- Alege Adăugați destinația.

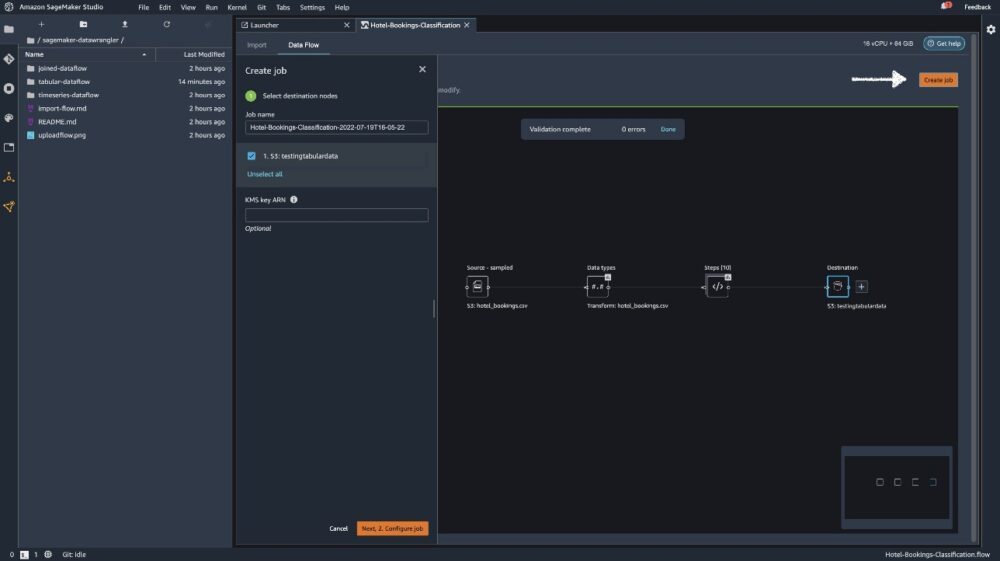

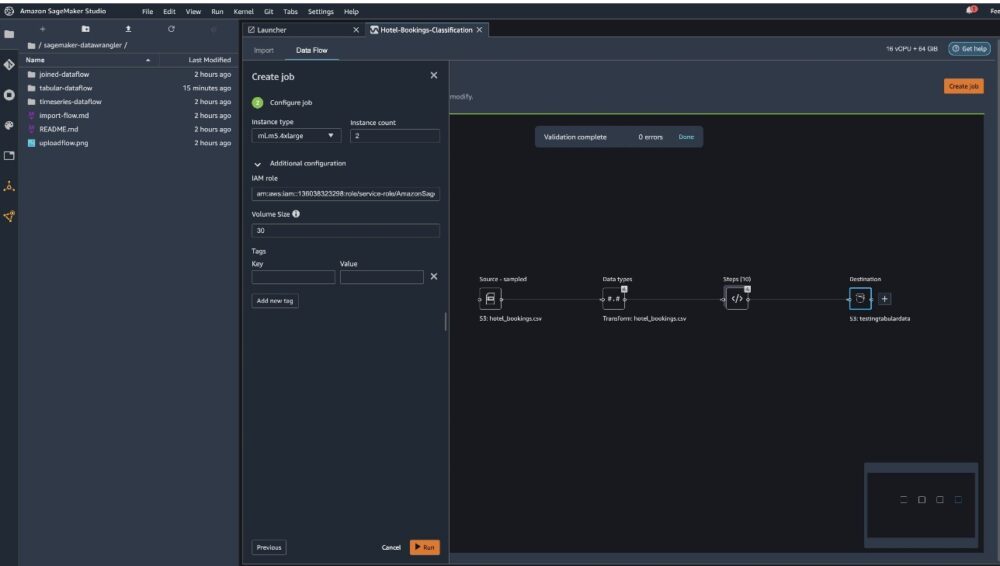

Alege Creați loc de muncă.

Pentru Numele locului de munca, introduceți un nume sau păstrați opțiunea generată automat și alegeți destinație. Avem o singură destinație, S3:testingtabulardata, dar este posibil să aveți mai multe destinații din diferiți pași ai fluxului de lucru. Paraseste ARN cheie KMS câmpul gol și alegeți Pagina Următoare →.

Acum trebuie să configurați capacitatea de calcul pentru un job. Puteți păstra toate valorile implicite pentru acest exemplu.

- Pentru Tipul instanței, utilizați ml.m5.4xlarge.

- Pentru Număr de instanțe, folosiți 2.

- Puteți explora Configurație suplimentară, dar păstrați setările implicite.

- Alege Alerga.

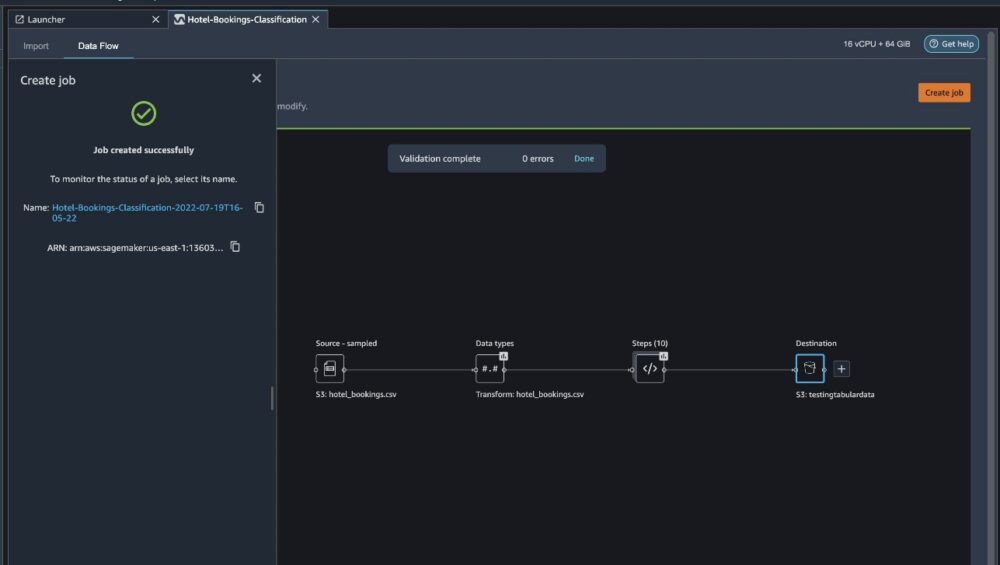

Acum munca ta a început și este nevoie de ceva timp pentru a procesa 6 GB de date conform fluxului nostru de procesare Data Wrangler. Costul pentru această lucrare va fi de aproximativ 2 USD, deoarece ml.m5.4xlarge costă 0.922 USD pe oră și folosim două dintre ele.

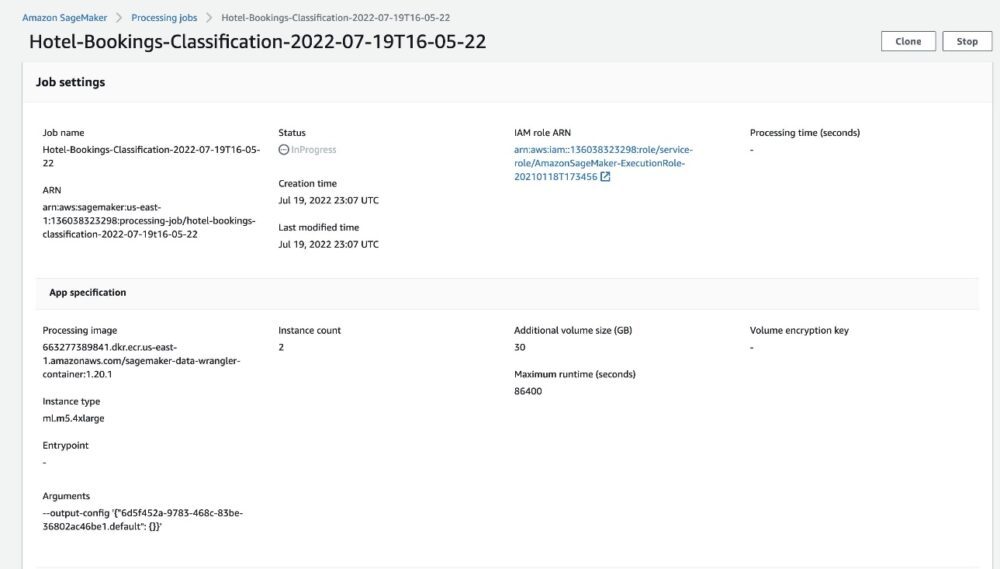

Dacă alegeți numele postului, sunteți redirecționat către o nouă fereastră cu detaliile postului.

Pe pagina cu detaliile jobului, puteți vedea toți parametrii de la pașii anteriori.

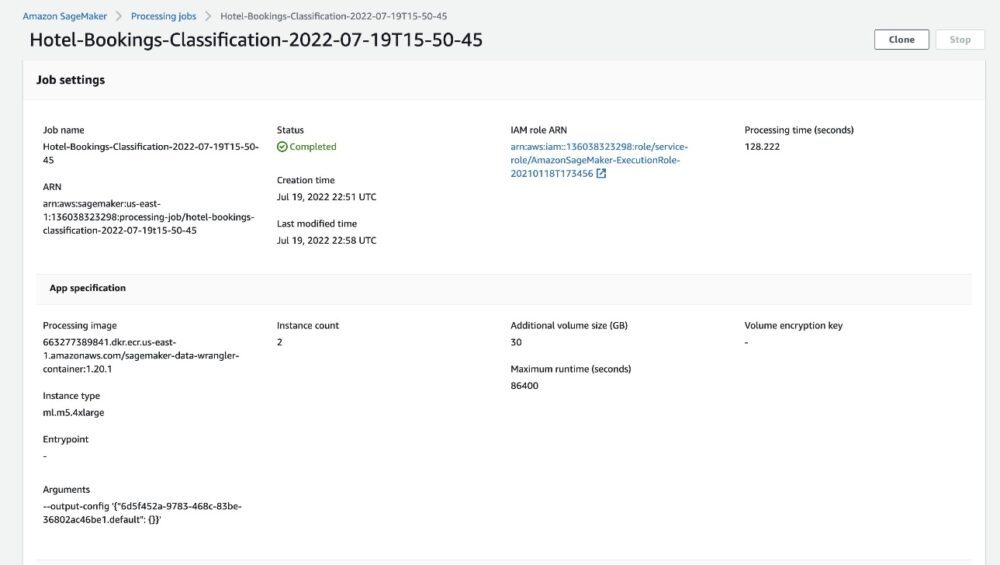

Când starea jobului se schimbă în Finalizat, puteți, de asemenea, să verificați Timp de procesare (secunde) valoare. Această lucrare de procesare durează aproximativ 5-10 minute.

Când lucrarea este finalizată, fișierele de ieșire de tren și de testare sunt disponibile în folderele de ieșire S3 corespunzătoare. Puteți găsi locația de ieșire din configurațiile jobului de procesare.

După ce sarcina de procesare Data Wrangler este finalizată, putem verifica rezultatele salvate în bucket-ul nostru S3. Nu uitați să actualizați job_name variabilă cu numele postului dvs.

Acum puteți utiliza aceste date exportate pentru rularea modelelor ML.

A curăța

Ștergeți-vă gălețile S3 şi de Fluxul de date Wrangler pentru a șterge resursele de bază și pentru a preveni costurile nedorite după ce terminați experimentul.

Concluzie

În această postare, am arătat cum puteți importa fluxul de date tabelar pre-construit în Data Wrangler, îl conectați la setul nostru de date și exportați rezultatele în Amazon S3. Dacă cazurile dvs. de utilizare necesită să manipulați datele seriei cronologice sau să vă alăturați mai multor seturi de date, puteți parcurge celelalte fluxuri de eșantion predefinite din GitHub repo.

După ce ați importat un flux de lucru de pregătire a datelor predefinit, îl puteți integra cu Amazon SageMaker Processing, Pipelines Amazon SageMaker, și Magazinul de caracteristici Amazon SageMaker pentru a simplifica sarcina de procesare, partajare și stocare a datelor de antrenament ML. De asemenea, puteți exporta acest eșantion de flux de date într-un script Python și puteți crea un canal personalizat de pregătire a datelor ML, accelerând astfel viteza de lansare.

Vă încurajăm să verificați GitHub depozit pentru a face practică practică și pentru a găsi noi modalități de a îmbunătăți acuratețea modelului! Pentru a afla mai multe despre SageMaker, vizitați Ghid pentru dezvoltatori Amazon SageMaker.

Despre Autori

Isha Dua este un arhitect senior de soluții cu sediul în San Francisco Bay Area. Ea îi ajută pe clienții AWS Enterprise să se dezvolte prin înțelegerea obiectivelor și provocărilor lor și îi îndrumă asupra modului în care își pot arhitectura aplicațiile într-o manieră nativă în cloud, asigurându-se în același timp că sunt rezistente și scalabile. Este pasionată de tehnologiile de învățare automată și de sustenabilitatea mediului.

Isha Dua este un arhitect senior de soluții cu sediul în San Francisco Bay Area. Ea îi ajută pe clienții AWS Enterprise să se dezvolte prin înțelegerea obiectivelor și provocărilor lor și îi îndrumă asupra modului în care își pot arhitectura aplicațiile într-o manieră nativă în cloud, asigurându-se în același timp că sunt rezistente și scalabile. Este pasionată de tehnologiile de învățare automată și de sustenabilitatea mediului.

- AI

- ai art

- ai art generator

- ai robot

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- inteligență artificială

- certificare de inteligență artificială

- inteligența artificială în domeniul bancar

- robot cu inteligență artificială

- roboți cu inteligență artificială

- software de inteligență artificială

- Învățare automată AWS

- blockchain

- conferință blockchain ai

- coingenius

- inteligența artificială conversațională

- criptoconferință ai

- dall-e

- învățare profundă

- google ai

- masina de învățare

- Plato

- platoul ai

- Informații despre date Platon

- Jocul lui Platon

- PlatoData

- platogaming

- scara ai

- sintaxă

- zephyrnet