Ingineria promptă a devenit o abilitate esențială pentru oricine lucrează cu modele de limbaj mari (LLM) pentru a genera texte relevante și de înaltă calitate. Deși ingineria promptului de text a fost discutată pe scară largă, ingineria promptului vizual este un domeniu în curs de dezvoltare care necesită atenție. Indicațiile vizuale pot include casete de delimitare sau măști care ghidează modelele de viziune în generarea de rezultate relevante și precise. În această postare, explorăm elementele de bază ale ingineriei vizuale prompte, beneficiile acesteia și modul în care poate fi utilizată pentru a rezolva un caz de utilizare specific: segmentarea imaginii pentru conducerea autonomă.

În ultimii ani, domeniul vederii computerizate a cunoscut progrese semnificative în domeniul segmentării imaginii. O astfel de descoperire este Segmentează orice model (SAM) de Meta AI, care are potențialul de a revoluționa segmentarea la nivel de obiect cu antrenament zero-shot sau câteva lovituri. În această postare, folosim modelul SAM ca exemplu de model de viziune a fundației și explorăm aplicarea acestuia la Setul de date BDD100K, un set de date divers de conducere autonomă pentru învățarea multitask eterogene. Combinând punctele forte ale SAM cu datele bogate furnizate de BDD100K, prezentăm potențialul ingineriei vizuale prompte cu diferite versiuni de SAM. Inspirat de LangChain cadru pentru modele de limbaj, propunem un lanț vizual pentru a realiza promptarea vizuală prin combinarea modelelor de detectare a obiectelor cu SAM.

Deși această postare se concentrează pe conducerea autonomă, conceptele discutate sunt aplicabile pe scară largă domeniilor care au aplicații bogate bazate pe viziune, cum ar fi asistența medicală și științele vieții, precum și mass-media și divertisment. Să începem prin a afla mai multe despre ceea ce se află sub capota unui model de viziune fundamentală precum SAM. Noi am folosit Amazon SageMaker Studio pe o instanță ml.g5.16xlarge pentru această postare.

Segmentează orice model (SAM)

Modelele de bază sunt modele mari de învățare automată (ML) instruite pe o cantitate mare de date și pot fi solicitate sau ajustate pentru cazuri de utilizare specifice sarcinii. Aici, explorăm modelul Segment Anything (SAM), care este un model de bază pentru viziune, în special segmentarea imaginii. Este pre-antrenat pe un set masiv de date de 11 milioane de imagini și 1.1 miliarde de măști, ceea ce îl face cel mai mare set de date de segmentare la momentul scrierii. Acest set extins de date acoperă o gamă largă de obiecte și categorii, oferind SAM o sursă de date de instruire diversă și la scară largă.

Modelul SAM este antrenat să înțeleagă obiectele și poate scoate măști de segmentare pentru orice obiect în imagini sau cadre video. Modelul permite inginerie vizuală promptă, permițându-vă să furnizați intrări precum text, puncte, casete de delimitare sau măști pentru a genera etichete fără a modifica imaginea originală. SAM este disponibil în trei dimensiuni: de bază (ViT-B, 91 de milioane de parametri), mare (ViT-L, 308 de milioane de parametri) și uriaș (ViT-H, 636 de milioane de parametri), care răspund diferitelor cerințe de calcul și cazuri de utilizare.

Motivația principală din spatele SAM este îmbunătățirea segmentării la nivel de obiect cu eșantioane și epoci de antrenament minime pentru orice obiect de interes. Puterea SAM constă în capacitatea sa de a se adapta la noile distribuții de imagini și sarcini fără cunoștințe prealabile, o caracteristică cunoscută sub numele de transfer zero-shot. Această adaptabilitate este obținută prin pregătirea sa pe setul de date expansiv SA-1B, care a demonstrat o performanță impresionantă zero-shot, depășind multe rezultate anterioare complet supravegheate.

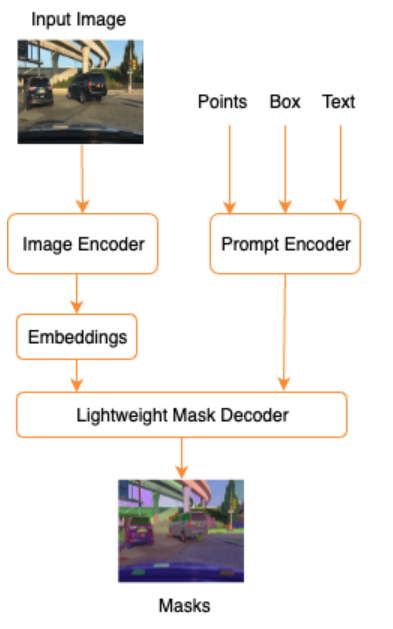

După cum se arată în următoarea arhitectură pentru SAM, procesul de generare a măștilor de segmentare implică trei pași:

- Un codificator de imagine produce o încorporare unică pentru imagine.

- Un codificator de prompt convertește orice prompt într-un vector de încorporare pentru prompt.

- Decodorul ușor combină informațiile din codificatorul de imagine și codificatorul prompt pentru a prezice măștile de segmentare.

De exemplu, putem oferi o intrare cu o imagine și o casetă de delimitare în jurul unui obiect de interes din imaginea respectivă (de exemplu, mașina argintie sau banda de rulare), iar modelul SAM ar produce măști de segmentare pentru acel obiect.

Inginerie vizuală promptă

Ingineria promptă se referă la structurarea intrărilor la un model care face modelul să înțeleagă intenția și produce rezultatul dorit. Cu ajutorul ingineriei prompte textuale, puteți structura textul introdus prin modificări precum alegerea cuvintelor, formatarea, ordonarea și multe altele pentru a obține rezultatul dorit. Ingineria promptă vizuală presupune că utilizatorul lucrează într-o modalitate vizuală (imagine sau video) și oferă intrări. Următoarea este o listă neexhaustivă de modalități potențiale de a furniza informații pentru modelul AI generativ în domeniul vizual:

- Punct – Un punct de coordonate singular (x, y) în planul imaginii

- Puncte – mai multe puncte de coordonate (x, y), care nu sunt neapărat legate între ele

- Caseta de delimitare – Un set de patru valori (x, y, w, h) care definesc o regiune dreptunghiulară în planul imaginii

- Contur – Un set de puncte de coordonate (x, y) din planul imaginii care formează o formă închisă

- Mască – O matrice de aceeași dimensiune ca imaginea cu o mască parțială a obiectului de interes

Având în vedere tehnicile de inginerie promptă vizuală, haideți să explorăm modul în care aceasta poate fi aplicată modelului pre-antrenat SAM. Am folosit versiunea de bază a modelului pre-antrenat.

Solicitare zero-shot cu modelul SAM pre-antrenat

Pentru început, să explorăm abordarea zero-shot. Următoarea este un exemplu de imagine din setul de date de antrenament luat de la camera frontală a unui vehicul.

Putem obține măști de segmentare pentru toate obiectele din imagine fără nicio solicitare vizuală explicită generând automat măști doar cu o imagine de intrare. În imaginea următoare, vedem părți ale mașinii, drum, semn de circulație, plăcuțe de înmatriculare, pasaj, stâlpi, indicatoare și multe altele sunt segmentate.

Cu toate acestea, această ieșire nu este imediat utilă din următoarele motive:

- Mașinile nu sunt segmentate în ansamblu, ci în părți. Pentru majoritatea modelelor de percepție, de exemplu, nu ne pasă cu adevărat că fiecare dintre anvelope are măști de ieșire separate. Acest lucru este valabil atunci când căutați și alte obiecte cunoscute de interes, cum ar fi drumul, vegetația, indicatoarele și așa mai departe.

- Părțile imaginii care sunt utile pentru sarcinile din aval, cum ar fi zona de rulare, sunt împărțite, fără nicio explicație. Pe de altă parte, instanțele similare sunt identificate separat și putem fi interesați să grupăm obiecte similare (segmentare panoptic vs. instanță).

Inginerie vizuală promptă cu modelul SAM pre-antrenat

Din fericire, SAM acceptă furnizarea de prompturi de intrare și putem folosi puncte, matrice de puncte și casete de delimitare ca intrări. Cu aceste instrucțiuni specifice, ne așteptăm ca SAM să se descurce mai bine cu segmentări care se concentrează pe anumite puncte sau zone. Acest lucru poate fi comparat cu șablonul de prompt de limbă"What is a good name for a company that makes {product}?"

unde intrarea împreună cu acest șablon de prompt de la utilizator este {product}. {product} este un slot de intrare. În solicitarea vizuală, casetele de delimitare, punctele sau măștile sunt sloturile de intrare.

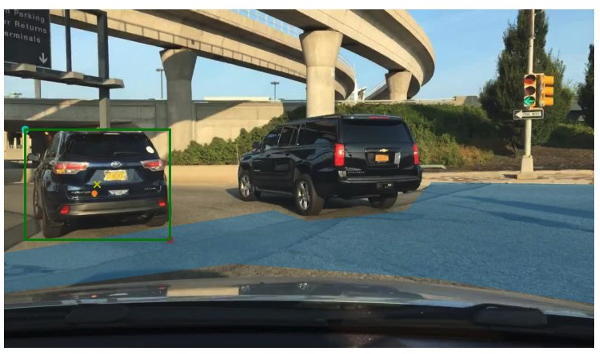

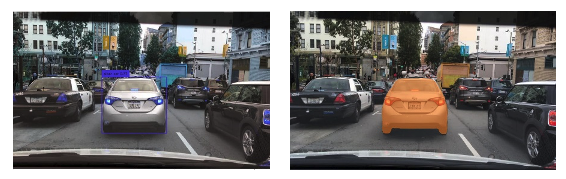

Următoarea imagine oferă caseta de delimitare a adevărului de la sol originală în jurul vehiculelor și patch-ul zonei de condus din datele de adevăr de la sol BDD100K. Imaginea arată, de asemenea, un punct de intrare (un X galben) în centrul casetei de delimitare verde la care ne vom referi în următoarele câteva secțiuni.

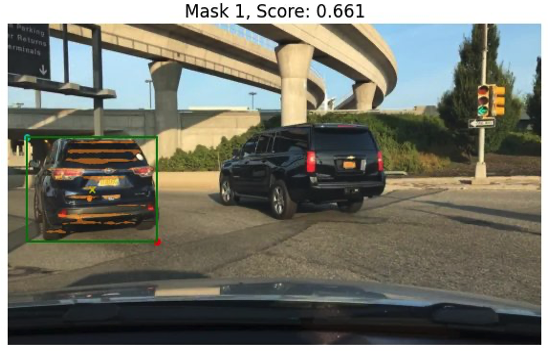

Să încercăm să generăm o mască pentru mașina din stânga cu caseta de delimitare verde ca intrare în SAM. După cum se arată în exemplul următor, modelul de bază al SAM nu găsește nimic. Acest lucru se vede și în scorul scăzut de segmentare. Când ne uităm la măștile de segmentare mai îndeaproape, vedem că există regiuni mici returnate ca măști (îndreptate spre utilizarea săgeților roșii) care nu sunt cu adevărat utilizabile pentru nicio aplicație din aval.

Să încercăm o combinație între o casetă de delimitare și un punct ca prompt vizual de intrare. Crucea galbenă din imaginea anterioară este centrul casetei de delimitare. Furnizarea coordonatelor acestui punct (x,y) ca prompt împreună cu constrângerea casetei de delimitare ne oferă următoarea mască și un scor puțin mai mare. Acest lucru nu este încă utilizabil prin niciun mijloc.

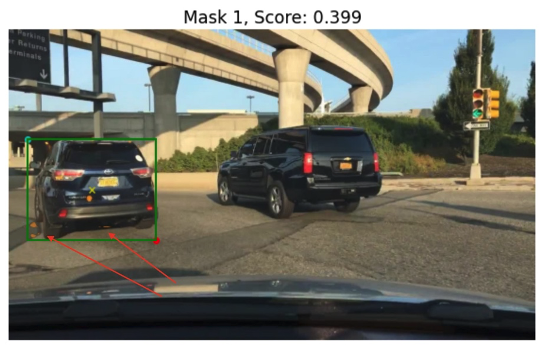

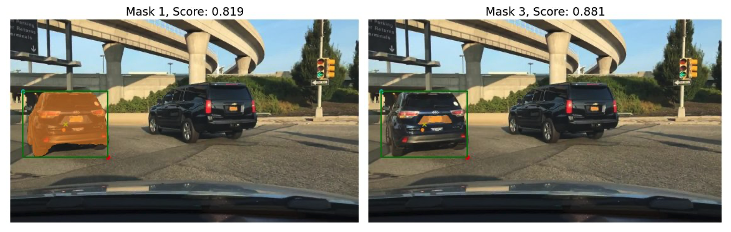

În cele din urmă, cu modelul de bază pre-antrenat, putem furniza doar punctul de intrare ca prompt (fără caseta de delimitare). Următoarele imagini arată două dintre primele trei măști pe care le-am considerat interesante.

Masca 1 segmentează mașina completă, în timp ce Masca 3 segmentează o zonă care ține plăcuța de înmatriculare a mașinii aproape de crucea galbenă (prompt de introducere). Masca 1 nu este încă o mască strânsă și curată în jurul mașinii; acest lucru indică calitatea modelului, despre care putem presupune că crește odată cu dimensiunea modelului.

Putem încerca modele mai mari pre-antrenate cu același prompt de introducere. Următoarele imagini arată rezultatele noastre. Când utilizați modelul uriaș SAM pre-antrenat, Masca 3 este întreaga mașină, în timp ce Masca 1 și 2 pot fi folosite pentru a extrage plăcuța de înmatriculare.

Versiunea mare a modelului SAM oferă, de asemenea, rezultate similare.

Procesul prin care am trecut aici este similar cu ingineria manuală a promptului pentru solicitările text cu care este posibil să fiți deja familiarizați. Rețineți că o îmbunătățire recentă a modelului SAM pentru a segmenta orice la calitate înaltă oferă rezultate mult mai bune specifice obiectului și contextului. În cazul nostru, constatăm că promptarea zero-shot cu solicitări text și vizuale (punct, casetă și puncte și casete) nu îmbunătățesc drastic rezultatele așa cum am văzut mai sus.

Șabloane prompte și lanțuri vizuale

După cum putem vedea din exemplele de zero-shot precedente, SAM se străduiește să identifice toate obiectele din scenă. Acesta este un exemplu bun de unde putem profita de șabloanele prompte și lanțurile vizuale. Lanțul vizual este inspirat de conceptul de lanț din cadrul popular LangChain pentru aplicații lingvistice. Ajută la înlănțuirea surselor de date și a unui LLM pentru a produce rezultatul. De exemplu, putem folosi un lanț API pentru a apela un API și a invoca un LLM pentru a răspunde la întrebare pe baza răspunsului API.

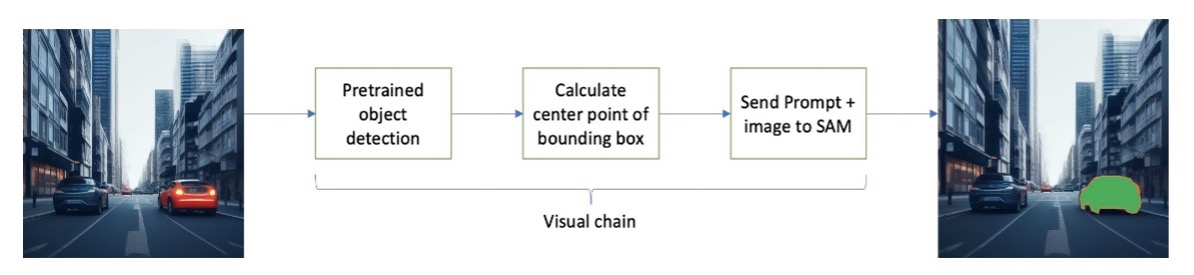

Inspirat de LangChain, propunem un lanț vizual secvențial care arată ca figura următoare. Folosim un instrument (cum ar fi un model de detectare a obiectelor pre-antrenat) pentru a obține casetele de delimitare inițiale, pentru a calcula punctul din centrul casetei de delimitare și pentru a folosi acest lucru pentru a solicita modelul SAM cu imaginea de intrare.

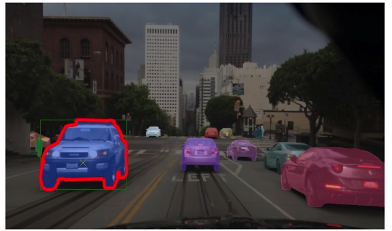

De exemplu, următoarea imagine arată măștile de segmentare ca rezultat al rulării acestui lanț.

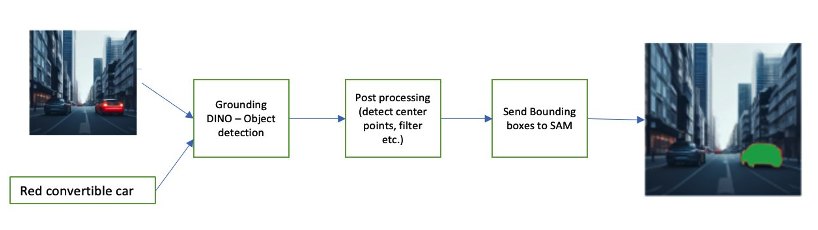

Un alt exemplu de lanț poate implica o introducere de text a obiectului pe care utilizatorul este interesat să îl identifice. Pentru a implementa acest lucru, am construit o conductă folosind Împământare DINO, un model de detectare a obiectelor pentru a solicita SAM pentru segmentare.

Grounding DINO este un model de detectare a obiectelor zero-shot care poate efectua detectarea obiectelor cu text care oferă nume de categorii (cum ar fi „semafoare” sau „camion”) și expresii (cum ar fi „camion galben”). Acceptă perechi de text și imagine pentru a efectua detectarea obiectelor. Se bazează pe o arhitectură transformatoare și permite modalități încrucișate cu date text și imagini. Pentru a afla mai multe despre Grounding DINO, consultați Grounding DINO: căsătoria DINO cu Grounded Pre-Training pentru detectarea obiectelor în set deschis. Acest lucru generează casete de delimitare și etichete și poate fi procesat în continuare pentru a genera puncte centrale, filtrare pe baza etichetelor, pragurilor și multe altele. Acesta este folosit (cutii sau puncte) ca un prompt către SAM pentru segmentare, care scoate măști.

Următoarele sunt câteva exemple care arată textul de intrare, ieșirea DINO (casete de delimitare) și ieșirea finală SAM (măști de segmentare).

Următoarele imagini arată rezultatul pentru „camion galben”.

Următoarele imagini arată rezultatul pentru „mașină de argint”.

Următoarea imagine arată rezultatul pentru „banda de rulare”.

Putem folosi această conductă pentru a construi un lanț vizual. Următorul fragment de cod explică acest concept:

pipeline = [object_predictor, segment_predictor]

image_chain = ImageChain.from_visual_pipeline(pipeline, image_store, verbose=True)

image_chain.run('All silver cars', image_id='5X3349')Deși acesta este un exemplu simplu, acest concept poate fi extins pentru a procesa fluxurile de la camerele de pe vehicule pentru a efectua urmărirea obiectelor, redarea datelor cu informații de identificare personală (PII) și multe altele. Putem obține, de asemenea, cutiile de delimitare de la modele mai mici sau, în unele cazuri, folosind instrumente standard de viziune computerizată. Este destul de simplu să utilizați un model pre-antrenat sau un serviciu precum Amazon Rekognition pentru a obține etichete inițiale (vizuale) pentru solicitarea dvs. La momentul scrierii acestui articol, există peste 70 de modele disponibile pe Amazon SageMaker Jumpstart pentru detectarea obiectelor și Amazon Rekognition identifică deja mai multe categorii utile de obiecte în imagini, inclusiv mașini, pietoni și alte vehicule.

În continuare, ne uităm la câteva rezultate cantitative legate de performanța modelelor SAM cu un subset de date BDD100K.

Rezultate cantitative

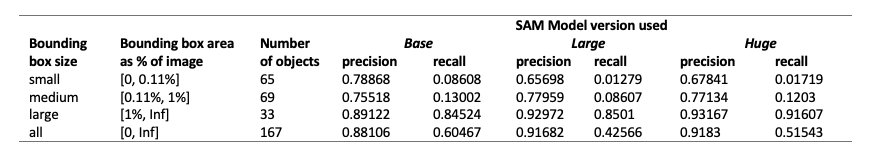

Obiectivul nostru este să comparăm performanța a trei modele pre-antrenate atunci când primesc aceleași sugestii vizuale. În acest caz, folosim punctul central al locației obiectului ca intrare vizuală. Comparăm performanța în ceea ce privește dimensiunile obiectului (proporțional cu dimensiunea imaginii) - mic (zonă <0.11%), medie (0.11% < zonă < 1%) și mare (zonă > 1%). Pragurile zonei cutiei de delimitare sunt definite de Common Objects in Context (COCO) valori de evaluare [Lin și colab., 2014].

Evaluarea este la nivel de pixel și folosim următoarele valori de evaluare:

- Precizie = (număr de instanțe relevante și recuperate) / (număr total de instanțe recuperate)

- Recall = (număr de instanțe relevante și de preluare) / (număr total de instanțe relevante)

- Instanțe aici sunt fiecare pixel din cadrul casetei de delimitare a obiectului de interes

Următorul tabel raportează performanța a trei versiuni diferite ale modelului SAM (de bază, mare și uriașă). Aceste versiuni au trei codificatoare diferite: ViT-B (de bază), ViT-L (mari), ViT-H (uriaș). Codificatoarele au un număr diferit de parametri, în care modelul de bază are mai puțini parametri decât mari, iar mare este mai puțin decât uriaș. Deși creșterea numărului de parametri arată o performanță îmbunătățită cu obiecte mai mari, acest lucru nu este așa pentru obiectele mai mici.

Reglați fin SAM pentru cazul dvs. de utilizare

În multe cazuri, utilizarea directă a unui model SAM pre-antrenat poate să nu fie foarte utilă. De exemplu, să ne uităm la o scenă tipică din trafic - imaginea următoare este rezultatul din modelul SAM cu puncte prompt eșantionate aleatoriu ca intrare în stânga și etichetele reale din sarcina de segmentare semantică de la BDD100K în dreapta. Acestea sunt evident foarte diferite.

Stivele de percepție în AV-uri pot folosi cu ușurință a doua imagine, dar nu și prima. Pe de altă parte, există câteva rezultate utile din prima imagine care pot fi utilizate și că modelul nu a fost instruit în mod explicit, de exemplu, marcajele benzilor, segmentarea trotuarului, măștile plăcuțelor de înmatriculare și așa mai departe. Putem ajusta modelul SAM pentru a îmbunătăți rezultatele segmentării. Pentru a efectua această reglare fină, am creat un set de date de antrenament folosind un subset de segmentare a instanțelor (500 de imagini) din setul de date BDD10K. Acesta este un subset foarte mic de imagini, dar scopul nostru este să dovedim că modelele de viziune de bază (la fel ca LLM) pot funcționa bine pentru cazul dvs. de utilizare cu un număr surprinzător de mic de imagini. Următoarea imagine arată imaginea de intrare, masca de ieșire (în albastru, cu un chenar roșu pentru mașină în stânga) și posibile solicitări (caseta de delimitare în verde și punctul central X în galben).

Am efectuat reglajul fin folosind biblioteca Hugging Face activată Amazon SageMaker Studio. Am folosit instanța ml.g4dn.xlarge pentru testele modelului de bază SAM și ml.g4dn.2xlarge pentru testele modelului uriaș SAM. În experimentele noastre inițiale, am observat că reglarea fină a modelului de bază cu doar casete de delimitare nu a avut succes. Modelele reglate fin și pre-antrenate nu au putut să învețe măștile de adevăr la sol specifice mașinii din seturile de date originale. Adăugarea de puncte de interogare la reglarea fină, de asemenea, nu a îmbunătățit antrenamentul.

În continuare, putem încerca să reglam fin modelul uriaș SAM pentru 30 de epoci, cu un set de date foarte mic (500 de imagini). Masca originală a adevărului la sol arată ca următoarea imagine pentru mașina tip etichetă.

După cum se arată în imaginile următoare, versiunea originală pre-antrenată a modelului uriaș cu un prompt de casetă de delimitare specifică (în verde) nu oferă nicio ieșire, în timp ce versiunea reglată fin oferă o ieșire (încă nu este exactă, dar reglarea fină a fost tăiată oprit după 40 de epoci și cu un set de date de antrenament foarte mic de 500 de imagini). Modelul uriaș original, pre-antrenat, nu a fost capabil să prezică măști pentru niciuna dintre imaginile pe care le-am testat. Ca exemplu de aplicație în aval, modelul ajustat poate fi utilizat în fluxurile de lucru de pre-etichetare, cum ar fi cel descris în Modul de etichetare automată pentru sisteme avansate de asistență pentru șoferi bazate pe învățare profundă pe AWS.

Concluzie

În această postare, am discutat despre modelul de viziune de bază cunoscut sub numele de Segment Anything Model (SAM) și arhitectura acestuia. Am folosit modelul SAM pentru a discuta despre sugestiile vizuale și diferitele intrări pentru ingineria promptării vizuale. Am explorat modul în care funcționează diferite indicații vizuale și limitările acestora. De asemenea, am descris modul în care lanțurile vizuale măresc performanța față de utilizarea unui singur prompt, similar cu API-ul LangChain. În continuare, am furnizat o evaluare cantitativă a trei modele pre-antrenate. În cele din urmă, am discutat despre modelul SAM ajustat și rezultatele acestuia în comparație cu modelul de bază original. Reglarea fină a modelelor de fundație ajută la îmbunătățirea performanței modelului pentru sarcini specifice, cum ar fi segmentarea. Trebuie remarcat faptul că modelul SAM, datorită cerințelor sale de resurse, limitează utilizarea pentru cazurile de utilizare în timp real și inferența la margine în starea sa actuală. Sperăm că, cu iterații viitoare și tehnici îmbunătățite, vor reduce cerințele de calcul și vor îmbunătăți latența.

Sperăm că această postare vă încurajează să explorați sugestiile vizuale pentru cazurile dvs. de utilizare. Deoarece aceasta este încă o formă emergentă de inginerie promptă, sunt multe de descoperit în ceea ce privește indicațiile vizuale, lanțurile vizuale și performanța acestor instrumente. Amazon SageMaker este o platformă ML gestionată complet, care permite constructorilor să exploreze modele mari de limbaj și vizuale și să creeze aplicații AI generative. Începeți să construiți viitorul cu AWS astăzi.

Despre autori

Gopi Krishnamurthy este arhitect senior de soluții AI/ML la Amazon Web Services cu sediul în New York City. Lucrează cu clienți mari din industria auto în calitate de consilier de încredere pentru a-și transforma sarcinile de lucru de învățare automată și pentru a migra în cloud. Interesele sale principale includ învățarea profundă și tehnologiile fără server. În afara serviciului, îi place să petreacă timpul cu familia sa și să exploreze o gamă largă de muzică.

Gopi Krishnamurthy este arhitect senior de soluții AI/ML la Amazon Web Services cu sediul în New York City. Lucrează cu clienți mari din industria auto în calitate de consilier de încredere pentru a-și transforma sarcinile de lucru de învățare automată și pentru a migra în cloud. Interesele sale principale includ învățarea profundă și tehnologiile fără server. În afara serviciului, îi place să petreacă timpul cu familia sa și să exploreze o gamă largă de muzică.

Shreyas Subramanian este un arhitect principal de soluții specializat în AI/ML și ajută clienții prin utilizarea Machine Learning pentru a-și rezolva provocările de afaceri folosind platforma AWS. Shreyas are experiență în optimizarea la scară largă și în învățarea automată, precum și în utilizarea învățării automate și a învățării prin consolidare pentru accelerarea sarcinilor de optimizare.

Shreyas Subramanian este un arhitect principal de soluții specializat în AI/ML și ajută clienții prin utilizarea Machine Learning pentru a-și rezolva provocările de afaceri folosind platforma AWS. Shreyas are experiență în optimizarea la scară largă și în învățarea automată, precum și în utilizarea învățării automate și a învățării prin consolidare pentru accelerarea sarcinilor de optimizare.

Sujitha Martin este un om de știință aplicat în Centrul de inovare generativ AI (GAIIC). Expertiza ei este în construirea de soluții de învățare automată care implică viziunea computerizată și procesarea limbajului natural pentru diverse verticale din industrie. În special, ea are o vastă experiență de lucru în conștientizarea situațională centrată pe om și în învățarea infuzată de cunoștințe pentru sisteme extrem de autonome.

Sujitha Martin este un om de știință aplicat în Centrul de inovare generativ AI (GAIIC). Expertiza ei este în construirea de soluții de învățare automată care implică viziunea computerizată și procesarea limbajului natural pentru diverse verticale din industrie. În special, ea are o vastă experiență de lucru în conștientizarea situațională centrată pe om și în învățarea infuzată de cunoștințe pentru sisteme extrem de autonome.

Francisco Calderon este Data Scientist în Centrul de Inovare Generative AI (GAIIC). În calitate de membru al GAIIC, el ajută la descoperirea artei posibilului cu clienții AWS care folosesc tehnologiile AI generative. În timpul liber, lui Francisco îi place să cânte muzică și chitară, să joace fotbal cu fiicele sale și să se bucure de timpul cu familia.

Francisco Calderon este Data Scientist în Centrul de Inovare Generative AI (GAIIC). În calitate de membru al GAIIC, el ajută la descoperirea artei posibilului cu clienții AWS care folosesc tehnologiile AI generative. În timpul liber, lui Francisco îi place să cânte muzică și chitară, să joace fotbal cu fiicele sale și să se bucure de timpul cu familia.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/foundational-vision-models-and-visual-prompt-engineering-for-autonomous-driving-applications/

- :are

- :este

- :nu

- :Unde

- $UP

- 1

- 100

- 11

- 179

- 2014

- 214

- 225

- 30

- 40

- 500

- 7

- 70

- 804

- 91

- 97

- a

- capacitate

- Capabil

- Despre Noi

- mai sus

- accelerarea

- acceptă

- precis

- realizat

- curent

- adapta

- adăugare

- avansat

- progresele

- Avantaj

- consilier

- După

- AI

- AI / ML

- AL

- TOATE

- permite

- de-a lungul

- deja

- de asemenea

- Cu toate ca

- Amazon

- Amazon Rekognition

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- și

- răspunde

- Orice

- oricine

- nimic

- api

- aplicabil

- aplicație

- aplicatii

- aplicat

- abordare

- arhitectură

- SUNT

- ZONĂ

- domenii

- în jurul

- Mulțime

- Artă

- AS

- Asistență

- asuma

- presupune

- At

- atenţie

- auto

- autonom

- disponibil

- gradului de conştientizare

- AWS

- fundal

- de bază

- bazat

- Noțiuni de bază

- BE

- deoarece

- deveni

- fost

- începe

- în spatele

- Beneficiile

- Mai bine

- Miliard

- Albastru

- frontieră

- Cutie

- Dulapuri

- descoperire

- in linii mari

- construi

- constructori

- Clădire

- construit

- afaceri

- dar

- by

- calcula

- apel

- aparat foto

- camere video

- CAN

- Poate obține

- mașină

- pasă

- masini

- caz

- cazuri

- categorii

- Categorii

- catering

- Centru

- lanţ

- lanţuri

- provocări

- alegere

- Oraș

- curat

- Închide

- închis

- îndeaproape

- Cloud

- nucă de cocos

- cod

- combinaţie

- combină

- combinând

- Comun

- companie

- comparaţie

- comparație

- de calcul

- Calcula

- calculator

- Computer Vision

- concept

- Concepte

- context

- coordona

- Nucleu

- Covers

- a creat

- Trece

- Curent

- Starea curenta

- clienţii care

- Tăiat

- de date

- om de știință de date

- seturi de date

- adânc

- învățare profundă

- defini

- definit

- demonstrat

- descris

- dorit

- Detectare

- diferit

- dino

- direct

- descoperi

- discuta

- discutat

- distribuții

- diferit

- do

- Nu

- domeniu

- domenii

- Dont

- drastic

- şofer

- conducere

- două

- e

- E&T

- fiecare

- cu ușurință

- Margine

- Încorporarea

- șmirghel

- permite

- permițând

- încurajează

- Inginerie

- Divertisment

- Întreg

- epoci

- esenţial

- evaluare

- exemplu

- exemple

- expansiv

- aștepta

- experienţă

- experimente

- expertiză

- explică

- explicație

- explicit

- explora

- explorat

- expresii

- extensiv

- Experiență vastă

- extrage

- Față

- destul de

- familiar

- familie

- Caracteristică

- puțini

- camp

- Figura

- filtru

- final

- Găsi

- First

- se concentrează

- concentrându-se

- următor

- Pentru

- formă

- Fundație

- fundamentale

- patru

- Cadru

- Francisco

- din

- faţă

- Complet

- complet

- mai mult

- viitor

- genera

- generează

- generator

- generativ

- AI generativă

- obține

- dat

- oferă

- bine

- Verde

- Teren

- ghida

- mână

- Avea

- având în

- he

- de asistență medicală

- ajută

- ei

- aici

- Înalt

- de înaltă calitate

- superior

- extrem de

- lui

- deține

- capotă

- speranţă

- Cum

- HTML

- HTTPS

- mare

- identificat

- identifică

- identifica

- identificarea

- imagine

- imagini

- imediat

- punerea în aplicare a

- impresionant

- îmbunătăţi

- îmbunătățit

- îmbunătățire

- in

- include

- Inclusiv

- Crește

- Creșteri

- crescând

- industrie

- informații

- perfuzată

- inițială

- Inovaţie

- intrare

- intrări

- inspirat

- instanță

- Segmentarea instanțelor

- instrucțiuni

- scop

- interes

- interesat

- interesant

- interese

- în

- implica

- implicând

- IT

- iterații

- ESTE

- jpg

- doar

- doar unul

- cunoştinţe

- cunoscut

- Etichetă

- etichete

- Bandă

- limbă

- mare

- pe scară largă

- mai mare

- cea mai mare

- în cele din urmă

- Latență

- AFLAȚI

- învăţare

- stânga

- mai puțin

- Nivel

- Bibliotecă

- Licență

- se află

- Viaţă

- Life Sciences

- categorie ușoară

- ca

- îi place

- limitări

- Limitele

- Lin

- Listă

- mic

- LLM

- locaţie

- Uite

- cautati

- Se pare

- Jos

- maşină

- masina de învățare

- FACE

- Efectuarea

- gestionate

- manual

- multe

- căsătorindu-se

- masca

- Măști

- masiv

- Mai..

- mijloace

- Mass-media

- mediu

- membru

- meta

- Metrici

- migra

- milion

- minte

- minim

- ML

- model

- Modele

- modificările aduse

- Module

- mai mult

- cele mai multe

- motivaţia

- mult

- multiplu

- Muzică

- nume

- nume

- Natural

- Procesarea limbajului natural

- în mod necesar

- Nou

- New York

- New York City

- următor

- Nu.

- notat

- număr

- obiect

- Detectarea obiectelor

- obiectiv

- obiecte

- of

- de pe

- on

- ONE

- optimizare

- or

- original

- Altele

- al nostru

- afară

- Rezultat

- producție

- iesiri

- exterior

- peste

- perechi

- parametru

- parametrii

- special

- piese

- Plasture

- percepţie

- Efectua

- performanță

- efectuată

- Personal

- imagine

- piloni

- conducte

- Pixel

- plan

- platformă

- Plato

- Informații despre date Platon

- PlatoData

- Joaca

- joc

- Punct

- puncte

- Popular

- posibil

- Post

- potenţial

- putere

- prezice

- primar

- Principal

- anterior

- proces

- Procesat

- prelucrare

- produce

- produce

- proporție

- propune

- Dovedi

- furniza

- prevăzut

- furnizează

- furnizarea

- scop

- calitate

- cantitativ

- cantitate

- întrebare

- gamă

- în timp real

- într-adevăr

- motive

- recent

- Roșu

- reduce

- trimite

- se referă

- regiune

- regiuni

- legate de

- Rapoarte

- Cerinţe

- Necesită

- resursă

- respect

- răspuns

- rezultat

- REZULTATE

- revoluţiona

- Bogat

- dreapta

- drum

- funcţionare

- sagemaker

- Sam

- acelaşi

- văzut

- Scară

- scenă

- ȘTIINȚE

- Om de stiinta

- scor

- Al doilea

- secțiuni

- vedea

- văzut

- segment

- segmentarea

- segmente

- senior

- distinct

- serverless

- serviciu

- Servicii

- set

- câteva

- ea

- să

- Arăta

- prezenta

- indicat

- Emisiuni

- semna

- semnificativ

- Semne

- Silver

- asemănător

- simplu

- singular

- Mărimea

- dimensiuni

- calificare

- slot

- sloturi

- mic

- mai mici

- fragment

- So

- Fotbal

- soluţii

- REZOLVAREA

- unele

- Sursă

- Surse

- specialist

- specific

- specific

- petrece

- împărţi

- Stive

- standard

- Începe

- Stat

- paşi

- Încă

- simplu

- puncte forte

- structura

- structurarea

- luptele

- de succes

- astfel de

- Sprijină

- depășind

- sisteme

- tabel

- Lua

- luate

- Sarcină

- sarcini

- tehnici de

- Tehnologii

- șablon

- şabloane

- termeni

- testat

- teste

- a) Sport and Nutrition Awareness Day in Manasia Around XNUMX people from the rural commune Manasia have participated in a sports and healthy nutrition oriented activity in one of the community’s sports ready yards. This activity was meant to gather, mainly, middle-aged people from a Romanian rural community and teach them about the benefits that sports have on both their mental and physical health and on how sporting activities can be used to bring people from a community closer together. Three trainers were made available for this event, so that the participants would get the best possible experience physically and so that they could have the best access possible to correct information and good sports/nutrition practices. b) Sports Awareness Day in Poiana Țapului A group of young participants have taken part in sporting activities meant to teach them about sporting conduct, fairplay, and safe physical activities. The day culminated with a football match.

- textual

- decât

- acea

- Zona

- Noțiuni de bază

- Viitorul

- informațiile

- lor

- Acolo.

- Acestea

- acest

- gândit

- trei

- Prin

- timp

- anvelope

- la

- astăzi

- instrument

- Unelte

- top

- Total

- Urmărire

- trafic

- dresat

- Pregătire

- Transforma

- transformator

- camion

- adevărat

- de încredere

- Adevăr

- încerca

- Două

- tip

- tipic

- în

- înţelege

- us

- utilizabil

- Folosire

- utilizare

- carcasa de utilizare

- utilizare-cazuri

- utilizat

- Utilizator

- folosind

- Valori

- diverse

- Fixă

- vegetație

- Vehicule

- versiune

- Versiunile

- verticalele

- foarte

- Video

- viziune

- vizual

- vs

- W

- a fost

- modalități de

- we

- web

- servicii web

- BINE

- a mers

- au fost

- Ce

- Ce este

- cand

- întrucât

- care

- întreg

- larg

- Gamă largă

- pe larg

- voi

- cu

- în

- fără

- asistat

- cuvinte

- Apartamente

- fluxuri de lucru

- de lucru

- fabrică

- ar

- scris

- X

- ani

- York

- Tu

- Ta

- zephyrnet