Panelul final CCC al AAAS 2023, „Menținerea unei largimi bogate pentru inteligența artificială”, a avut loc duminică, 5 martie, ultima zi a conferinței. Acest panel a fost compus din David Danks (Universitatea din California – San Diego), Bo Li (Universitatea din Illinois – Urbana-Champaign) și Melanie Mitchell (Institutul Santa Fe) și a fost moderat de Maria Gini (Universitatea din Minnesota).

Dr. Bo Li a început panelul discutând despre importanța desfășurării învățării automate (ML) de încredere și despre modalitățile prin care ne putem asigura că ML este sigură, echitabilă și incluzivă. Învățarea automată este omniprezentă, a spus Li, iar astăzi este folosită într-un număr semnificativ de activități de zi cu zi, cum ar fi navigarea către serviciu, trimiterea unui „răspuns rapid” prin e-mail sau chiar deschiderea telefonului folosind recunoașterea facială. Cu toate acestea, multe dintre aceste tehnologii care se bazează pe învățarea automată sunt susceptibile la atacuri. De asemenea, aceste tehnologii nu sunt infailibile și se știe că fac greșeli, cum ar fi recunoașterea facială care duce la arestări false.

Dr. Li a subliniat apoi un articol din PCMag, care a prezis că anul 2023 va fi un coșmar de securitate din cauza atacurilor ransomware tot mai mari și a programelor de inteligență artificială adverse. Din fericire, recent a existat o schimbare către recunoașterea riscului programelor de inteligență artificială. Publicarea de către Biroul pentru Politică Știință și Tehnologică a Casei Albe (OSTP) a Planului pentru o Declarație a Drepturilor AI și petiția de a opri dezvoltarea ulterioară a AI, care a fost semnată de mulți lideri din industrie, inclusiv Steve Wozniak și Elon Musk, au făcut lumină asupra riscurilor dezvoltării rapide și nereglementate a IA. Planul OSTP pentru o Declarație a drepturilor AI subliniază necesitatea unor sisteme AI robuste, sigure și eficiente, precum și protecții împotriva discriminării algoritmice pentru a se asigura că sistemele AI rămân corecte și echitabile pentru toți.

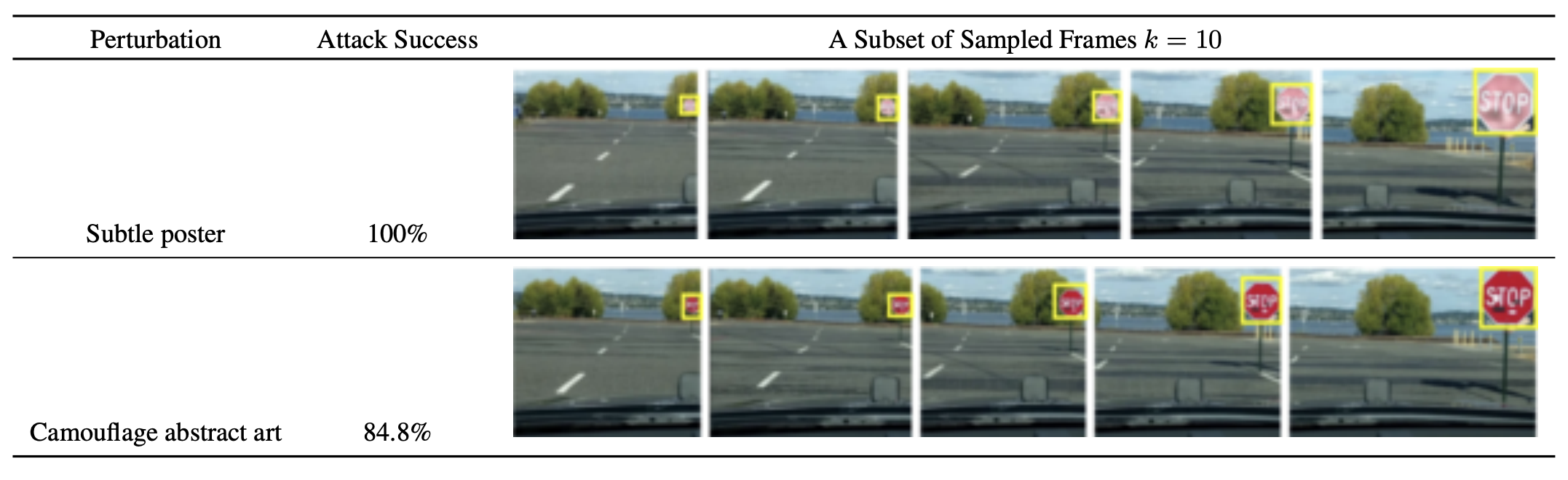

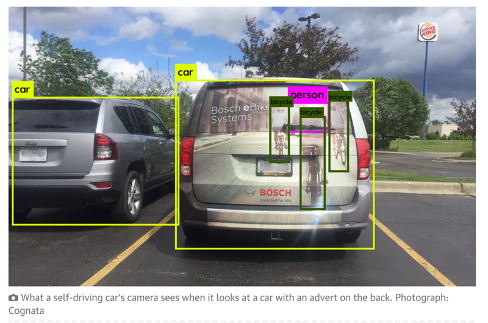

Dr. Li apoi a plonjat mai adânc într-o varietate de atacuri adverse care sunt folosite pentru a contracara sistemele de inteligență artificială. Li a subliniat propriile cercetări asupra atacurilor fizice, în special în cazul recunoașterii imaginii mașinilor cu conducere autonomă. Într-o lucrare scrisă de Dr. Li, ea și colegii ei au demonstrat ușurința cu care ar putea confunda un sistem de percepție în identificarea greșită a semnelor de oprire folosind o varietate de atacuri fizice, așa cum se arată în imaginea de mai jos.

arXiv:1707.08945 [cs.CR]

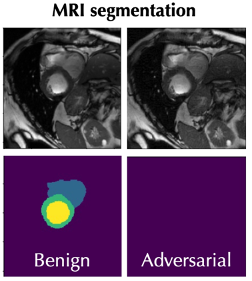

Dr. Li a subliniat, de asemenea, atacurile asupra software-ului de recunoaștere a imaginilor RMN, care pot induce în eroare software-ul să segmenteze incorect imaginile RMN și să diagnosticeze greșit tumorile, așa cum se arată în imaginea de mai jos.

Îmbunătățirea securității și a încrederii pentru AI, conform Dr. Li, este esențială. Acest lucru poate fi văzut în mod clar în aplicațiile AI care se bazează pe date din seria temporală, cum ar fi capacitatea sistemelor de recunoaștere facială de a identifica fața unei persoane pe măsură ce îmbătrânește. O problemă care apare adesea atunci când antrenați un model tradițional de învățare automată este presupunerea unor date staționare. Un set de date staționar presupune că media și varianța unui set de date sunt constante în timp, precum și covarianța dintre două puncte de date (de exemplu, covarianța dintre datele din ziua 9 și ziua 10 a unui set de date este egală cu covarianța dintre datele pe ziua 99 și ziua 100). Deși acest lucru poate fi adevărat pentru un set de date staționar tipic, această ipoteză adesea nu este adevărată atunci când se utilizează date din lumea reală. Problema care apare este că atunci când implementăm un model antrenat pe date staționare într-o aplicație din lumea reală, acum facem predicții despre datele din lumea reală care se bazează pe presupuneri care nu mai sunt adevărate. Acest lucru poate duce la predicții sau decizii inexacte luate de aplicația AI, ceea ce poate duce la consecințe devastatoare. Deși putem încerca să corectăm pentru non-staționaritatea datelor de testare, poate fi dificil să stabilim unde și prin ce mijloace să facem aceste corecții.

Prapastia dintre datele de instruire și datele de testare, spune dr. Li, creează ceea ce ea numește „decalaj de încredere”, unde pot apărea preocupări cu privire la lipsa de robustețe, confidențialitate, generalizare și corectitudine. Scopul aici este de a închide decalajul de încredere prin susținerea robusteței sistemelor, permițându-le să respingă atacurile, să se adapteze cu precizie la situații noi și să protejeze confidențialitatea persoanelor ale căror date sunt utilizate de aplicațiile ML.

Dr. Melanie Mitchell ne-a îndreptat apoi atenția dincolo de învățarea automată și chiar dincolo de învățarea profundă tradițională pentru a discuta despre IA generativă. Dr. Mitchell a oferit exemple de programe AI generative populare, cum ar fi ChatGPT, care poate genera răspunsuri text la solicitări și DALL-E, care poate răspunde la solicitări cu imagini generate. Mass-media a postulat că programele generative de inteligență artificială precum acestea se apropie rapid de un nivel de inteligență comparabil cu cel al oamenilor. Mitchell, totuși, pune la îndoială această declarație.

Dr. Mitchell a menționat un student de-al ei care a antrenat o rețea neuronală pentru a decide dacă o imagine conține un animal. Modelul a avut un grad ridicat de acuratețe, dar când studentul lui Mitchell a făcut o analiză pentru a vedea cum programul și-a făcut determinările, și-a dat seama că programul nu se uita deloc la partea din imagine care conținea un animal, ci se concentra mai degrabă pe fundalul. În loc să învețe să diferențieze părțile animale și non-animale ale imaginilor, modelul a învățat de fapt singur că majoritatea imaginilor cu animale au fundal neclar și, prin urmare, a început să ignore în întregime primul plan al imaginilor.

Acest exemplu, a declarat Mitchell, demonstrează în mod clar o problemă de bază a Inteligenței Artificiale: este ușor să înveți un program, dar poate fi foarte dificil să-i faci să învețe ceea ce ai vrea să facă. Inteligența artificială nu are genul de bun simț pe care l-ar putea avea chiar și un copil mic, așa că este dificil de corectat pentru ipotezele pe care le-ar putea face un computer că un om ar putea nici măcar să nu conceapă.

Majoritatea rețelelor neuronale pot fi, de asemenea, păcălite cu ușurință prin plasarea elementelor clar recunoscute în locații sau orientări neașteptate. Mitchell a afișat un exemplu creat de un grup de cercetători de la Universitatea Auburn. Imaginea de mai jos prezintă un autobuz școlar într-o varietate de orientări. În prima orientare, autobuzul școlar este poziționat conform așteptărilor, iar rețeaua neuronală poate identifica cu ușurință obiectul cu 100% certitudine. Cu toate acestea, atunci când orientarea autobuzului școlar este rotit într-o poziție neașteptată, programul nu reușește să identifice obiectul de fiecare dată, deși încă face identificări cu mare siguranță.

Alcorn, Michael A., şi colab. „Loviți (cu) o ipostază: rețelele neuronale sunt ușor păcălite de pozițiile ciudate ale obiectelor familiare.” arXiv preprint arXiv:1811.11553 (2018).

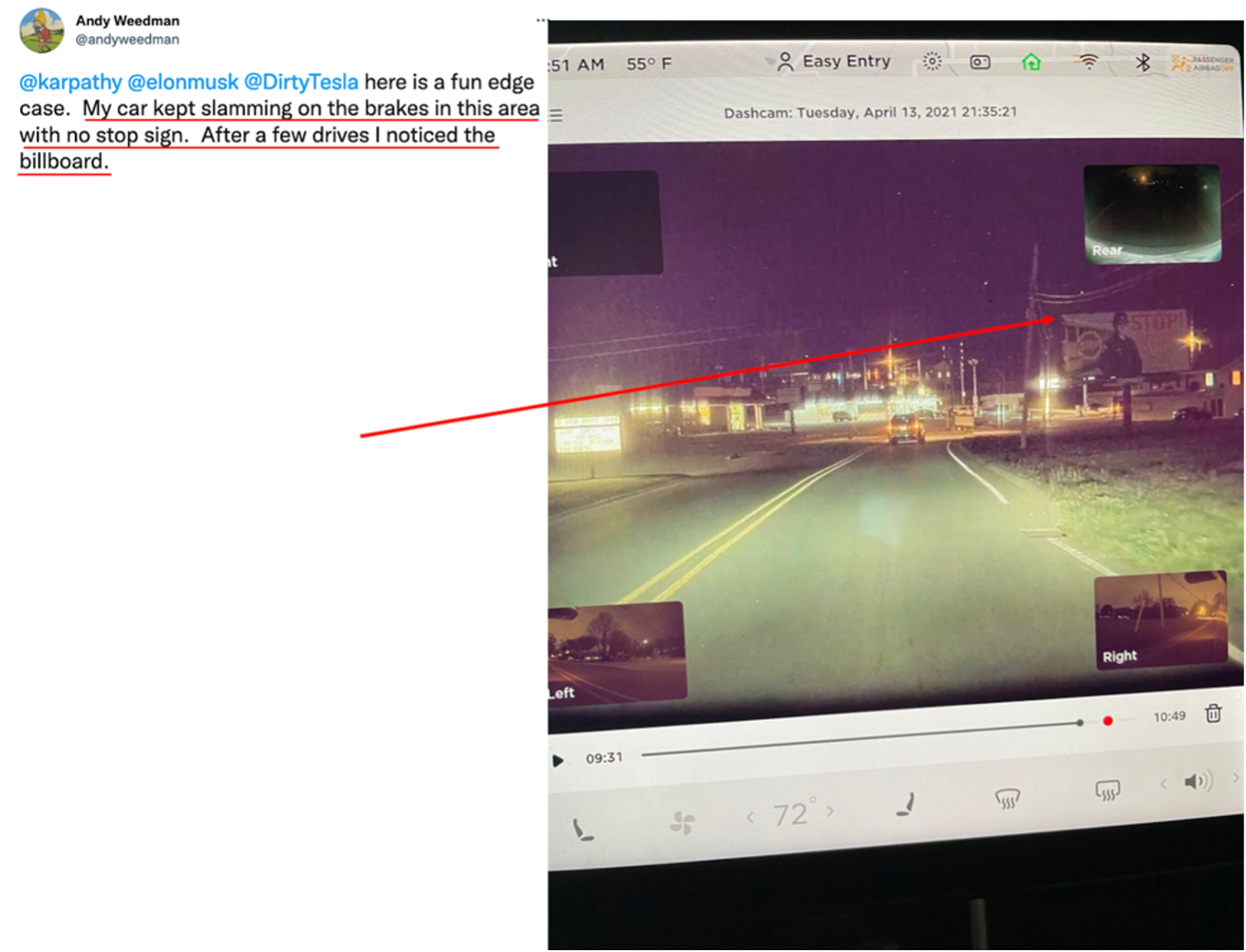

Aceste tipuri de greșeli pe care le fac programele de inteligență artificială pot fi foarte prostii atunci când lucrezi în laborator, dar pot avea și consecințe grave în lumea reală, în special mașinile cu conducere autonomă care se prăbușesc deoarece identifică greșit sau nu reușesc să identifice obiectele. Inteligența artificială se luptă, de asemenea, să determine când un obiect ar trebui sau nu ar trebui să fie identificat. Dr. Mitchell a arătat două imagini (mai jos), prima afișând camera unei mașini cu conducere autonomă identificând imaginile cu motocicliști de pe o mașină ca motocicliști reali, iar a doua arătând un tesla care trântește frâna de fiecare dată când trece pe lângă un panou publicitar cu o imagine. a unui semn de stop.

https://www.theguardian.com/technology/2017/aug/30/self-driving-cars-hackers-security

Dr. Mitchell ne-a îndreptat apoi atenția către paradoxul lui Moravec, la care ea făcuse aluzie mai devreme în prezentarea ei. Paradoxul lui Moravec afirmă: „Este relativ ușor să faci computerele să prezinte performanțe la nivel de adult la testele de inteligență sau la jocul de dame și dificil sau imposibil să le oferi abilitățile unui copil de un an când vine vorba de percepție și mobilitate” (Moravec, Hans. Minte Copii). Deci, cum putem corecta lipsa de percepție și bun simț a AI? Dr. Mitchell a discutat apoi un domeniu care a fost propus pentru a evalua oamenii și mașinile pe baza sistemelor de „cunoștințe de bază” care au fost identificate atât la oameni, cât și la unele specii de animale. Ideea de „cunoaștere de bază” înnăscută a fost propusă de Elizabeth Spelke, psiholog cognitiv și director al Laboratorului pentru Studii de Dezvoltare de la Universitatea Harvard. Lucrarea Dr. Spelke implică identificarea surselor capacităților cognitive unice umane și a modului în care aceste abilități se dezvoltă de la naștere până la vârsta adultă.

Fără a putea măsura și compara inteligența umană cu inteligența mașinii, nu putem spera să oferim mașinilor feedback-ul necesar pentru a le îmbunătăți performanța. Dr. Mitchell speră că prin crearea unor metode de măsurare și comparare a performanței atât a oamenilor, cât și a AI, vom putea depăși obstacolul inteligenței artificiale, fiind simultan și cel mai inteligent și cel mai prost partener al nostru.

În cele din urmă, dr. David Danks ne-a îndreptat atenția de la inteligența artificială în sine și, în schimb, spre încadrarea discuției despre modul în care este efectuată și finanțată cercetarea AI. În prezentarea sa, intitulată „Letting a Thousand AI's Bloom”, Dr. Danks a discutat două viziuni predominante despre natura eforturilor științifice. Prima ideologie este exemplificată de Thomas Kuhn. Kuhn credea că științele sunt controlate de paradigmele dominante ale vremii, ceea ce înseamnă că majoritatea oamenilor de știință sunt cuprinși de aceeași viziune sau mod de gândire, cum ar fi credința larg răspândită că teoria Big Bang a creat universul. Acest mod de gândire kuhnian poate duce la o gândire omogenă, a spus Danks, deoarece mai puțini oameni de știință gândesc în afara cutiei și contestă normele predominant ale zilei.

Filosoful Paul Feyerabend a oferit o ideologie contrastantă. El credea că oamenii de știință ar trebui să abordeze problemele din puncte de vedere divergente. În acest scop, Feyerabend a susținut că ar trebui să „lăsăm o mie de flori să înflorească”. În opinia sa, oamenii de știință ar trebui să cerceteze plăcile ouija și teoria astrologiei, pentru că nu poți fi niciodată sigur că paradigma susținută în prezent este corectă și știința nu poate fi avansată fără a pune sub semnul întrebării chiar și paradigmele cele mai ferm susținute. Această filozofie duce la o gândire mai eterogenă, pe măsură ce teorii mai ciudate sunt propuse și cercetate în cadrul acestei viziuni a progresului științific.

Dr. Danks spune că putem privi viziunile științifice ale lui Kuhn și Feyerabend ca două capete ale unei extreme. El a explicat că o gândire complet omogenă ar împiedica cercetarea științifică, dar a lăsa fiecare floare a unei idei să înflorească este, de asemenea, excesiv și, astfel, putem elimina unele domenii de cercetare, cum ar fi studierea plăcilor ouija și a astrologiei. Dr. Danks a mai spus că poate fi util să ne gândim la beneficiile și dezavantajele de a avea moduri de gândire mai eterogene și omogene. Cu cât gândirea noastră este mai omogenă, cu atât mai rapid putem face progrese pe termen scurt în domenii și teorii recunoscute care sunt considerate importante. Pe de altă parte, o viziune comună mai eterogenă asupra științei ar produce mai multe teorii și idei noi care altfel nu ar putea fi dezvoltate. Acest lucru vine cu prețul risipirii mai multor resurse pe teorii care nu se realizează și dedicând mai puțin timp și mai puține resurse domeniilor de studiu care beneficiază cel mai mult societatea.

Dr. Danks a subliniat că, practic, este mult mai ușor să aloci fonduri pentru cercetare într-o comunitate omogenă, întrucât toată lumea împărtășește o perspectivă similară. Această paradigmă poate fi, de asemenea, îndreptată către oportunități de cercetare care sunt cele mai valoroase pentru societate, crescând astfel interesul public și, de asemenea, finanțarea.

Danks a propus că contează unde ne situăm în acest continuum în ceea ce privește viziunea noastră despre modul în care desfășurăm cercetarea științifică. Căderea prea departe către oricare capăt al extremei poate împiedica serios progresul și, din păcate, a spus Dr. Danks, începem să cădem la o extremă în cercetarea AI.

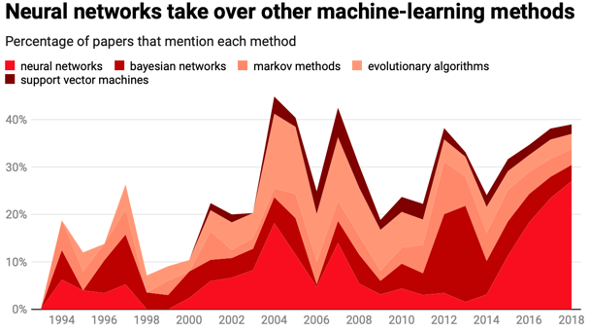

În graficul de mai jos, Danks ne-a îndreptat atenția asupra datelor din 2014 până în prezent.

MIT Technology Review

După cum putem vedea, procentul lucrărilor care menționează rețelele neuronale crește de aproape șapte ori în doar 4 ani. Marea majoritate a cercetării AI de astăzi se concentrează pe învățarea profundă, iar studiile asupra rețelelor neuronale exclud alte forme de inteligență artificială. Cercetările noastre despre IA devin prea omogene, a spus Danks, și neglijăm alte forme importante și valoroase de IA. În acest scop, Danks a propus două soluții.

În primul rând, el a sugerat că am putea aborda problema omogenității din partea ofertei, asigurând o finanțare adecvată pentru formele de IA dincolo de învățarea profundă. Cei care alocă fonduri ar face bine să ia în considerare tipurile de IA care sunt finanțate și, probabil, să stimuleze o diversitate de aplicații AI.

Pe de altă parte, ne putem confrunta cu această problemă și din partea cererii. O mare parte din finanțarea pentru IA se concentrează pe probleme despre care știm deja că pot fi rezolvate, dar cum rămâne cu acele provocări despre care am auzit mai devreme de la dr. Mitchell? De exemplu, unde este finanțarea pentru încorporarea bunului simț în sistemele AI? Nu ar trebui să acceptăm AI așa cum este acum, spune dr. Danks, și trebuie să ne străduim să o îmbunătățim. În acest scop, el propune să ne concentrăm mai întâi pe îmbunătățirea tehnologiei care stau la baza rețelelor neuronale înainte de a finanța mai multe aplicații ale rețelelor în sine.

Rămâneți pe fază pentru întrebările și răspunsurile din panel, care vor fi publicate mâine pe blogul CCC.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoAiStream. Web3 Data Intelligence. Cunoștințe amplificate. Accesați Aici.

- Mintând viitorul cu Adryenn Ashley. Accesați Aici.

- Sursa: https://feeds.feedblitz.com/~/737565884/0/cccblog~AAAS-Panel-Recap-Maintaining-a-Rich-Breadth-for-Artificial-Intelligence/

- :are

- :este

- :nu

- :Unde

- $UP

- 10

- 100

- 2014

- 2018

- 2023

- 26%

- 7

- 9

- a

- abilități

- capacitate

- Capabil

- Despre Noi

- Accept

- Conform

- precizie

- precis

- activităţi de

- de fapt

- adapta

- Adult

- avansat

- contradictorialității

- AI

- cercetare ai

- AL

- algoritmică

- TOATE

- Permiterea

- deja

- de asemenea

- an

- analiză

- și

- animal

- animale

- aplicație

- aplicatii

- abordare

- se apropie

- SUNT

- domenii

- arestări

- articol

- artificial

- inteligență artificială

- AS

- presupunere

- Astrologie

- At

- Atacuri

- atenţie

- departe

- fundal

- fundaluri

- bazat

- BE

- deoarece

- devenire

- fost

- înainte

- început

- Început

- fiind

- credinţă

- credea

- de mai jos

- beneficia

- Beneficiile

- Mai bine

- între

- Dincolo de

- Mare

- Big Bang

- Proiect de lege

- Blog

- Floare

- atât

- Cutie

- lăţime

- luați autobuzul

- dar

- by

- California

- apeluri

- aparat foto

- CAN

- nu poti

- capacități

- mașină

- masini

- caz

- ccc

- Blog CCC

- certitudine

- contesta

- provocări

- Chat GPT

- clar

- Închide

- cognitive

- colegii

- vine

- Comun

- comunitate

- comparabil

- comparativ

- comparaţie

- complet

- compuse

- calculator

- Calculatoare

- preocupările

- Conduce

- efectuat

- efectuarea

- Conferință

- Consecințele

- Lua în considerare

- constant

- continuum

- controlată

- Nucleu

- Corectarea

- A costat

- ar putea

- crashing

- a creat

- creează

- Crearea

- critic

- În prezent

- dall-e

- de date

- puncte de date

- David

- zi

- decide

- Deciziile

- adânc

- învățare profundă

- Mai adânc

- Grad

- Cerere

- demonstrat

- demonstrează

- Implementarea

- Determina

- devastator

- dezvolta

- dezvoltat

- Dezvoltare

- de dezvoltare

- evoluții

- FĂCUT

- Diego

- distinge

- dificil

- Director

- discuta

- discutat

- discutarea

- discuţie

- afișarea

- afișează

- Diversitate

- do

- face

- domeniu

- dominant

- Dont

- îndoială

- porumbel

- dezavantaje

- două

- E&T

- Mai devreme

- uşura

- mai ușor

- cu ușurință

- uşor

- Eficace

- Eforturile

- oricare

- elimina

- Elon

- Elon Musk

- capăt

- se încheie

- asigura

- asigurare

- în întregime

- evalua

- Chiar

- Fiecare

- de fiecare zi

- toată lumea

- exemplu

- exemple

- expune

- de aşteptat

- a explicat

- extremă

- Față

- facial

- recunoastere faciala

- FAIL

- eșuează

- echitabil

- cinste

- Cădea

- Cădere

- fals

- familiar

- feedback-ul

- mai puține

- Domenii

- final

- First

- Concentra

- concentrat

- se concentrează

- Pentru

- formulare

- din fericire

- din

- finanțate

- de finanțare

- Fondurile

- mai mult

- decalaj

- genera

- generată

- generativ

- AI generativă

- obține

- Da

- scop

- grafic

- grup

- HAD

- mână

- harvard

- Universitatea Harvard

- Avea

- având în

- he

- auzit

- Held

- ei

- aici

- Înalt

- împiedica

- lui

- deţine

- speranţă

- speranțe

- casă

- Cum

- Totuși

- HTTPS

- uman

- inteligența umană

- Oamenii

- idee

- idei

- identificat

- identifica

- identificarea

- ideologie

- Illinois

- imagine

- Recunoașterea imaginii

- imagini

- importanță

- important

- imposibil

- îmbunătăţi

- îmbunătățirea

- in

- inexact

- stimuleze

- Inclusiv

- Inclusiv

- care încorporează

- în mod incorect

- Creșteri

- crescând

- persoane fizice

- industrie

- înnăscut

- anchetă

- in schimb

- Institut

- Inteligență

- interes

- în

- problema

- IT

- articole

- ESTE

- în sine

- Copil

- Cunoaște

- cunoscut

- de laborator

- laborator

- lipsă

- Nume

- conduce

- Liderii

- conducere

- Conduce

- AFLAȚI

- învăţare

- închiriere

- Nivel

- Li

- ușoară

- ca

- Locații

- mai lung

- Uite

- maşină

- masina de învățare

- Masini

- făcut

- Mentine

- Majoritate

- face

- FACE

- Efectuarea

- multe

- Martie

- materie

- max-width

- Mai..

- însemna

- sens

- mijloace

- măsura

- Mass-media

- menționat

- Metode

- Michael

- ar putea

- greşeli

- ML

- model

- moduri de

- mai mult

- cele mai multe

- RMN

- mult

- Mosc

- Natură

- navigând

- aproape

- necesar

- Nevoie

- reţea

- rețele

- rețele neuronale

- rețele neuronale

- Nou

- Nu.

- în special

- roman

- acum

- număr

- obiect

- obiecte

- of

- oferit

- Birou

- de multe ori

- on

- ONE

- afară

- de deschidere

- Oportunităţi

- or

- OSTP

- Altele

- in caz contrar

- al nostru

- afară

- contururi

- exterior

- peste

- propriu

- panou

- Hârtie

- lucrări

- paradigmă

- Paradox

- parte

- piese

- trece

- trecut

- Paul

- procent

- percepţie

- performanță

- poate

- perspectivă

- filozofie

- telefon

- fizic

- imagine

- plasare

- Plato

- Informații despre date Platon

- PlatoData

- joc

- puncte

- Politica

- Popular

- ridică

- poziţie

- poziţionat

- practic

- a prezis

- Predictii

- predominant

- prezenta

- prezentare

- intimitate

- Problemă

- probleme

- produce

- Program

- Programe

- Progres

- adecvat

- propus

- propune

- proteja

- furniza

- public

- Q & A

- Ransomware

- Atacuri Ransomware

- rapid

- mai degraba

- real

- lumea reală

- realizat

- recapitula

- recent

- recunoaştere

- recunoscut

- recunoscând

- eliberaţi

- eliberat

- rămâne

- cercetare

- cercetători

- Resurse

- Răspunde

- rezultat

- Bogat

- Drepturile

- Risc

- Riscurile

- robust

- robusteţe

- sigur

- Said

- acelaşi

- San

- San Diego

- Mos Craciun

- spune

- Şcoală

- Ştiinţă

- Ştiinţă şi Tehnologie

- ȘTIINȚE

- ştiinţific

- oamenii de stiinta

- Al doilea

- securitate

- vedea

- văzut

- segment

- auto-conducere

- trimitere

- sens

- serie

- serios

- comun

- Acțiuni

- ea

- vărsa

- schimbare

- Pantaloni scurți

- să

- indicat

- parte

- semna

- semnat

- semnificativ

- Semne

- asemănător

- simultan

- situații

- aptitudini

- deștept

- So

- Societate

- Software

- soluţii

- unele

- Surse

- specific

- stabilit

- Statele

- Steve

- Steve Wozniak

- Încă

- Stop

- lupta

- luptele

- student

- studiu

- Studiu

- Studiu

- astfel de

- livra

- Înconjurător

- susceptibil

- sistem

- sisteme

- Tehnologii

- Tehnologia

- termeni

- Tesla

- Testarea

- teste

- decât

- acea

- Graficul

- lor

- Lor

- se

- apoi

- Acolo.

- astfel

- prin urmare

- Acestea

- ei

- crede

- Gândire

- acest

- aceste

- gândit

- Prin

- timp

- Seria de timp

- cu denumirea

- la

- astăzi

- mâine

- de asemenea

- față de

- tradiţional

- dresat

- Pregătire

- adevărat

- demn de încredere

- transformat

- Două

- Tipuri

- tipic

- omniprezent

- în

- Neașteptat

- din pacate

- unic

- Univers

- universitate

- Universitatea din California

- pe

- utilizat

- folosind

- Valoros

- varietate

- Fixă

- foarte

- de

- Vizualizare

- viziune

- viziuni

- a fost

- Cale..

- modalități de

- we

- BINE

- Ce

- cand

- dacă

- care

- în timp ce

- alb

- Casă albă

- OMS

- pe larg

- voi

- cu

- fără

- Apartamente

- de lucru

- lume

- ar

- an

- ani

- Tu

- Ta

- zephyrnet