Învățarea automată (ML) ajută organizațiile să mărească veniturile, să stimuleze creșterea afacerii și să reducă costurile prin optimizarea funcțiilor de bază ale afacerii pe mai multe verticale, cum ar fi prognoza cererii, scorul de credit, stabilirea prețurilor, estimarea ratei clienților, identificarea următoarelor cele mai bune oferte, anticiparea livrărilor întârziate și îmbunătățirea calității producției. Ciclurile tradiționale de dezvoltare ML durează luni și necesită abilități limitate de știință a datelor și abilități de inginerie ML. Ideile analiștilor pentru modelele ML stau adesea în întârzieri lungi care așteaptă lățimea de bandă a echipei de știință a datelor, în timp ce oamenii de știință ai datelor se concentrează pe proiecte ML mai complexe care necesită setul lor complet de abilități.

Pentru a ajuta la depășirea acestui impas, am făcut-o a introdus Amazon SageMaker Canvas, o soluție ML fără cod, care poate ajuta companiile să accelereze livrarea soluțiilor ML în câteva ore sau zile. SageMaker Canvas le permite analiștilor să utilizeze cu ușurință datele disponibile în lacurile de date, depozitele de date și depozitele de date operaționale; construiți modele ML; și folosiți-le pentru a face predicții în mod interactiv și pentru scorul în lot pe seturi de date în bloc, toate fără a scrie o singură linie de cod.

În această postare, arătăm cum SageMaker Canvas permite colaborarea între oamenii de știință de date și analiștii de afaceri, realizând un timp mai rapid de lansare pe piață și accelerând dezvoltarea soluțiilor ML. Analiștii își obțin propriul spațiu de lucru ML fără cod în SageMaker Canvas, fără a fi nevoie să devină un expert ML. Analiștii își pot partaja apoi modelele din Canvas cu câteva clicuri, cu care oamenii de știință de date vor putea lucra în Amazon SageMaker Studio, un mediu de dezvoltare integrat (IDE) ML end-to-end. Lucrând împreună, analiștii de afaceri își pot aduce cunoștințele de domeniu și rezultatele experimentării, în timp ce oamenii de știință de date pot crea în mod eficient conducte și eficientiza procesul.

Să analizăm în profunzime cum ar arăta fluxul de lucru.

Analiștii de afaceri construiesc un model, apoi îl distribuie

Pentru a înțelege modul în care SageMaker Canvas simplifică colaborarea dintre analiștii de afaceri și oamenii de știință de date (sau inginerii ML), mai întâi abordăm procesul ca analist de afaceri. Înainte de a începe, consultați Anunțăm Amazon SageMaker Canvas – o capacitate de învățare automată vizuală, fără cod pentru analiștii de afaceri pentru instrucțiuni despre construirea și testarea modelului cu SageMaker Canvas.

Pentru această postare, folosim o versiune modificată a Set de date de detectare a fraudei cu cardul de credit de la Kaggle, un set de date binecunoscut pentru o problemă de clasificare binară. Setul de date este inițial foarte dezechilibrat – are foarte puține intrări clasificate ca o clasă negativă (tranzacții anormale). Indiferent de distribuția caracteristicilor țintă, putem folosi în continuare acest set de date, deoarece SageMaker Canvas gestionează acest dezechilibru pe măsură ce antrenează și ajustează un model automat. Acest set de date este format din aproximativ 9 milioane de celule. De asemenea, puteți descărca un versiune redusă a acestui set de date. Dimensiunea setului de date este mult mai mică, în jur de 500,000 de celule, deoarece a fost subeșantionat aleatoriu și apoi supraeșantionat cu tehnica SMOTE pentru a se asigura că se pierde cât mai puțină informație în timpul acestui proces. Desfășurarea unui experiment întreg cu acest set de date redus vă costă 0 USD în cadrul nivelului gratuit SageMaker Canvas.

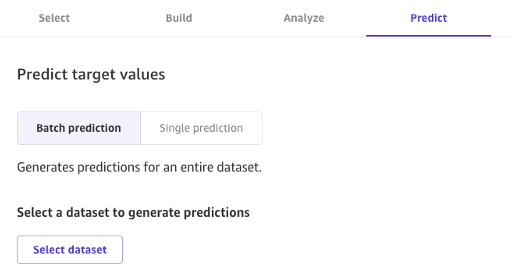

După ce modelul este construit, analiștii îl pot folosi pentru a face predicții direct în Canvas fie pentru solicitări individuale, fie pentru un întreg set de date de intrare în bloc.

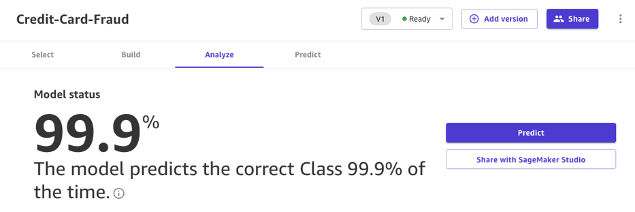

Modelele create cu Canvas Standard Build pot fi, de asemenea, partajate cu ușurință, printr-un clic pe un buton, cu oamenii de știință de date și inginerii ML care folosesc SageMaker Studio. Acest lucru permite unui cercetător de date să valideze performanța modelului pe care l-ați construit și să ofere feedback. Inginerii ML vă pot ridica modelul și îl pot integra cu fluxurile de lucru și produsele existente disponibile companiei și clienților dvs. Rețineți că, în momentul scrierii, nu este posibil să partajați un model construit cu Canvas Quick Build sau un model de prognoză în serie de timp.

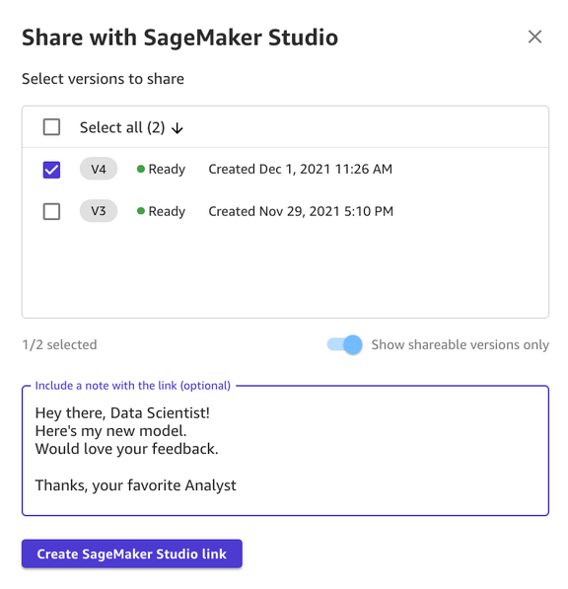

Partajarea unui model prin interfața de utilizare Canvas este simplă:

- Pe pagina care arată modelele pe care le-ați creat, alegeți un model.

- Alege Distribuie.

- Alegeți una sau mai multe versiuni ale modelului pe care doriți să-l partajați.

- Opțional, includeți o notă care să ofere mai mult context despre model sau ajutorul pe care îl căutați.

- Alege Creați legătura SageMaker Studio.

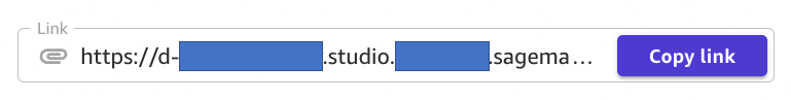

- Copiați linkul generat.

Si asta e! Acum puteți partaja linkul cu colegii dvs. prin Slack, e-mail sau orice altă metodă preferată. Specialistul de date trebuie să fie în același domeniu SageMaker Studio pentru a vă accesa modelul, așa că asigurați-vă că acesta este cazul administratorului organizației dvs.

Oamenii de știință de date accesează informațiile despre model din SageMaker Studio

Acum, să jucăm rolul unui cercetător de date sau al unui inginer ML și să vedem lucrurile din punctul lor de vedere folosind SageMaker Studio.

Linkul partajat de analist ne duce în SageMaker Studio, primul IDE bazat pe cloud pentru fluxul de lucru ML end-to-end.

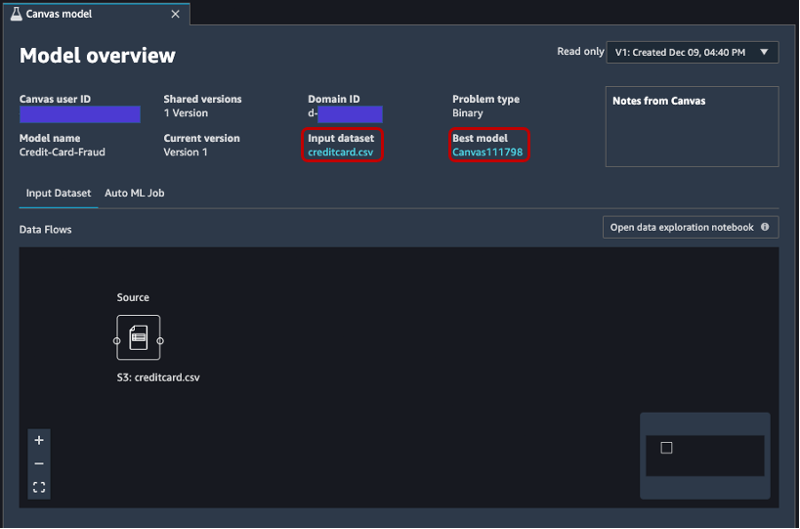

Fila se deschide automat și arată o prezentare generală a modelului creat de analist în SageMaker Canvas. Puteți vedea rapid numele modelului, tipul de problemă ML, versiunea modelului și care utilizator a creat modelul (în câmpul ID utilizator Canvas). De asemenea, aveți acces la detalii despre setul de date de intrare și cel mai bun model pe care SageMaker l-a putut produce. Vom aborda asta mai târziu în postare.

Pe Setul de date de intrare fila, puteți vedea și fluxul de date de la sursă la setul de date de intrare. În acest caz, este utilizată o singură sursă de date și nu au fost aplicate operații de îmbinare, deci este afișată o singură sursă. Puteți analiza statistici și detalii despre setul de date alegând Caietul de explorare a datelor deschise. Acest caiet vă permite să explorați datele care erau disponibile înainte de antrenamentul modelului și conține o analiză a variabilei țintă, un eșantion de date de intrare, statistici și descrieri ale coloanelor și rândurilor, precum și alte informații utile pentru ca cercetătorul de date. aflați mai multe despre setul de date. Pentru a afla mai multe despre acest raport, consultați Raport de explorare a datelor.

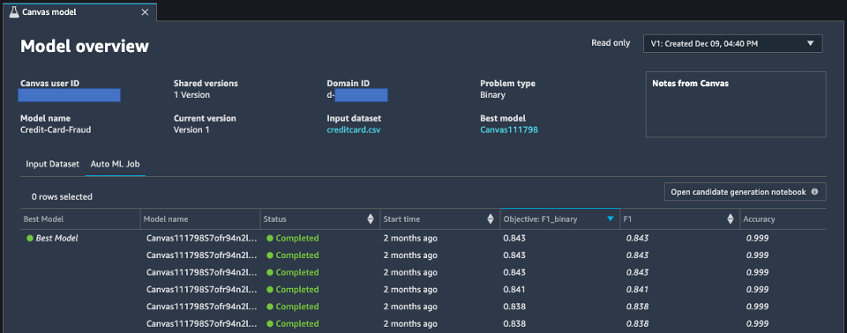

După analizarea setului de date de intrare, să trecem la a doua filă din prezentarea generală a modelului, Job AutoML. Această filă conține o descriere a jobului AutoML când ați selectat opțiunea Standard Build în SageMaker Canvas.

Tehnologia AutoML de sub SageMaker Canvas elimină greutățile legate de construirea modelelor ML. Construiește, antrenează și reglează automat cel mai bun model ML pe baza datelor dvs., folosind o abordare automată, permițându-vă în același timp să mențineți controlul și vizibilitatea deplină. Această vizibilitate asupra modelelor candidate generate, precum și a hiper-parametrilor utilizați în timpul procesului AutoML este conținută în caietul generației de candidati, care este disponibil în această filă.

Job AutoML fila conține, de asemenea, o listă a fiecărui model construit ca parte a procesului AutoML, sortată după metrica obiectivului F1. Pentru a evidenția cel mai bun model dintre joburile de formare lansate, este folosită o etichetă cu un cerc verde în Cel mai bun model coloană. De asemenea, puteți vizualiza cu ușurință alte valori utilizate în timpul fazei de antrenament și evaluare, cum ar fi scorul de precizie și zona sub curbă (AUC). Pentru a afla mai multe despre modelele pe care le puteți antrena în timpul unui job AutoML și despre valorile utilizate pentru evaluarea performanțelor modelului antrenat, consultați Suport de model, metrici și validare.

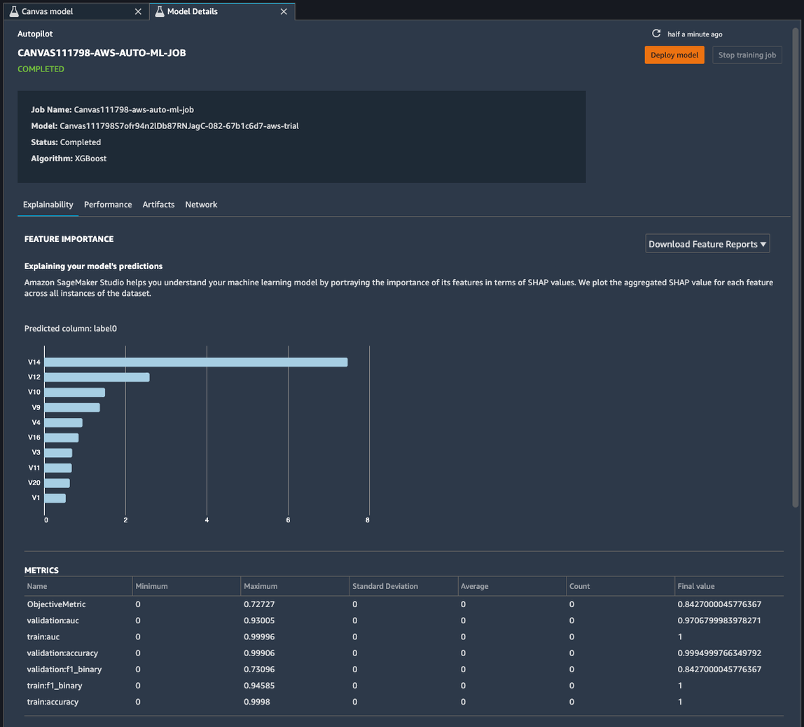

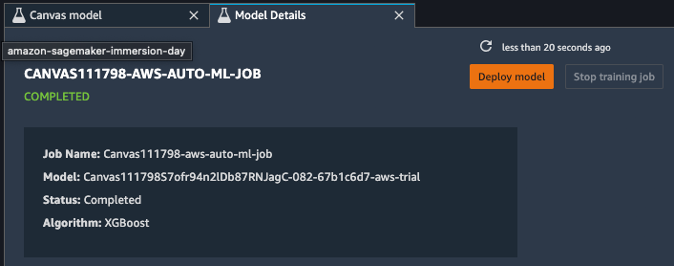

Pentru a afla mai multe despre model, puteți acum să faceți clic dreapta pe cel mai bun model și să alegeți Deschideți în detaliile modelului. Alternativ, puteți alege Cel mai bun model link din partea de sus a Prezentare generală a modelului secțiunea pe care ați vizitat-o prima dată.

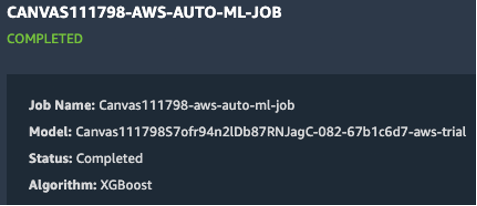

Pagina cu detaliile modelului conține o mulțime de informații utile cu privire la modelul care a funcționat cel mai bine cu aceste date de intrare. Să ne concentrăm mai întâi pe rezumatul din partea de sus a paginii. Exemplul precedent de captură de ecran arată că, din sute de rulări de antrenament de model, un model XGBoost a avut cele mai bune rezultate pe setul de date de intrare. La momentul scrierii acestui articol, SageMaker Canvas poate antrena trei tipuri de algoritmi ML: liniar care învață, XGBoost și un perceptron multistrat (MLP), fiecare cu o mare varietate de conducte de preprocesare și hiper-parametri. Pentru a afla mai multe despre fiecare algoritm, consultați pagina de algoritmi acceptați.

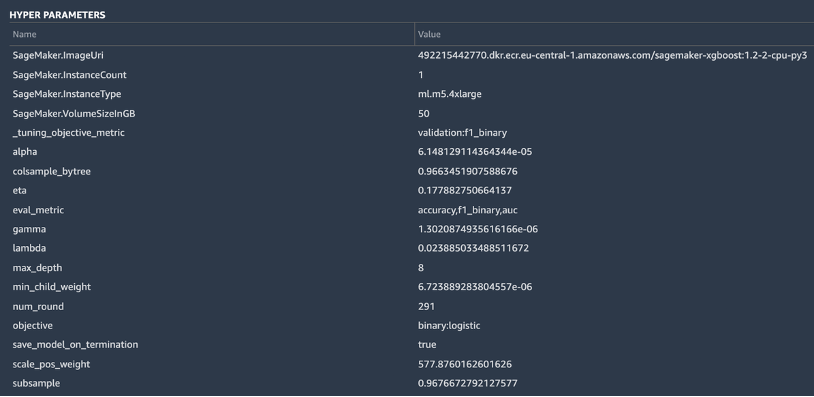

SageMaker include, de asemenea, o funcționalitate explicativă datorită unei implementări scalabile și eficiente a KernelSHAP, bazat pe conceptul unei valori Shapley din domeniul teoriei jocurilor cooperative care atribuie fiecărei caracteristici o valoare de importanță pentru o anumită predicție. Acest lucru permite transparență cu privire la modul în care modelul a ajuns la predicții și este foarte util să definiți importanța caracteristicilor. Un raport complet de explicabilitate, inclusiv importanța caracteristicilor, poate fi descărcat în format PDF, notebook sau date brute. În acel raport, este afișat un set mai larg de valori, precum și o listă completă de hiper-parametri utilizați în timpul lucrării AutoML. Pentru a afla mai multe despre modul în care SageMaker oferă instrumente de explicabilitate integrate pentru soluțiile AutoML și algoritmii ML standard, consultați Utilizați instrumente de explicabilitate integrate și îmbunătățiți calitatea modelului folosind Amazon SageMaker Autopilot.

În cele din urmă, celelalte file din această vizualizare arată informații despre detaliile de performanță (matricea de confuzie, curba de rechemare de precizie, curba ROC), artefactele utilizate pentru intrări și generate în timpul jobului AutoML și detaliile rețelei.

În acest moment, cercetătorul de date are două opțiuni: să implementeze direct modelul sau să creeze o conductă de instruire care poate fi programată sau declanșată manual sau automat. Următoarele secțiuni oferă câteva informații despre ambele opțiuni.

Implementați modelul direct

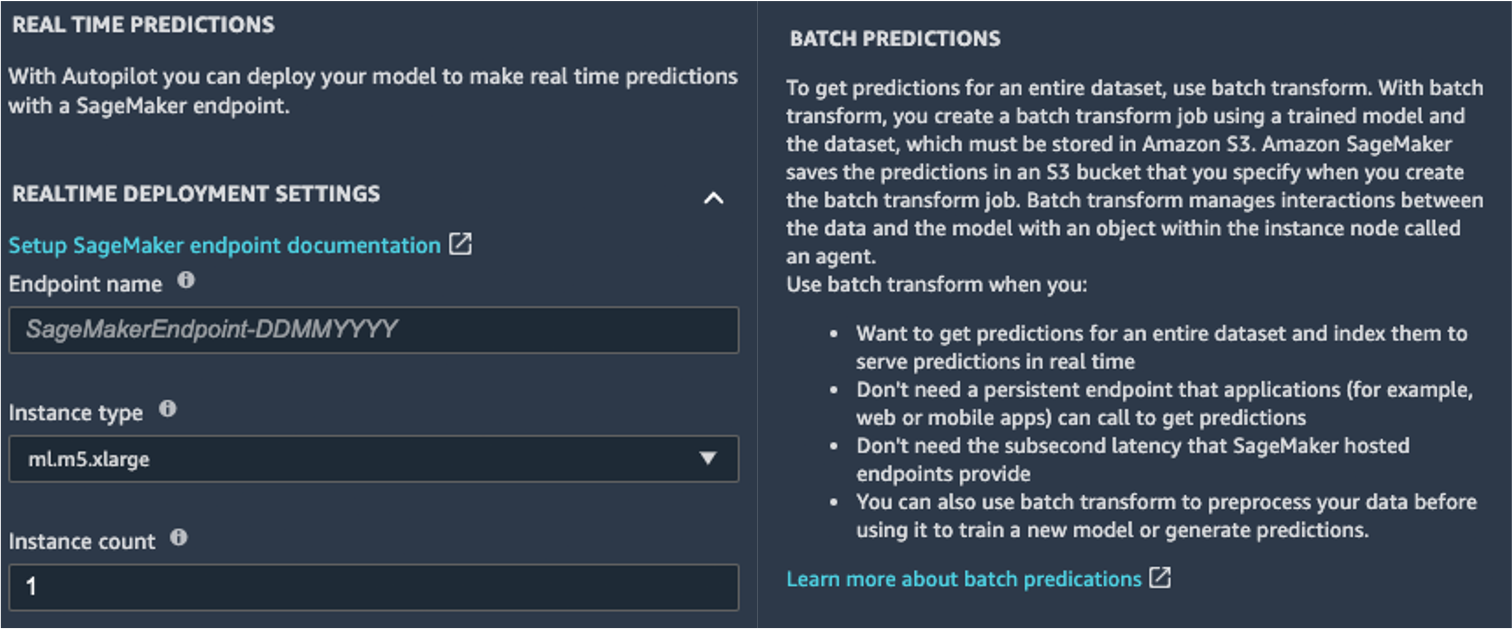

Dacă cercetătorul de date este mulțumit de rezultatele obținute de jobul AutoML, poate implementa direct modelul din Detalii model pagină. Este la fel de simplu ca și alegerea Implementează modelul lângă numele modelului.

SageMaker vă arată două opțiuni pentru implementare: un punct final în timp real, alimentat de Puncte finale Amazon SageMaker, și inferența în lot, alimentată de Transformarea lotului Amazon SageMaker.

SageMaker oferă și alte moduri de inferență. Pentru a afla mai multe, vezi Implementați modele pentru inferență.

Pentru a activa modul de predicții în timp real, dați pur și simplu punctului final un nume, un tip de instanță și un număr de instanțe. Deoarece acest model nu necesită resurse de calcul grele, puteți utiliza o instanță bazată pe CPU cu un număr inițial de 1. Puteți afla mai multe despre diferitele tipuri de instanțe disponibile și despre specificațiile acestora pe pagina Pagina de prețuri Amazon SageMaker (în Prețuri la cerere secțiunea, alegeți Inferență în timp real fila). Dacă nu știți ce instanță ar trebui să alegeți pentru implementare, puteți, de asemenea, să cereți SageMaker să găsească cea mai bună pentru dvs., în funcție de KPI-urile dvs., folosind Recomandator SageMaker Inference. De asemenea, puteți furniza parametri opționali suplimentari, în ceea ce privește dacă doriți sau nu să capturați date de solicitare și răspuns la sau de la punctul final. Acest lucru se poate dovedi util dacă plănuiți monitorizarea modelului dvs. De asemenea, puteți alege conținutul pe care doriți să îl furnizați ca parte a răspunsului dvs. - indiferent dacă este vorba doar de predicție sau probabilitatea de predicție, probabilitatea tuturor claselor și etichetele țintă.

Pentru a rula o sarcină de punctare în lot, obținând predicții pentru un set întreg de intrări simultan, puteți lansa lucrarea de transformare în lot din Consola de administrare AWS sau prin intermediul SDK-ului SageMaker Python. Pentru a afla mai multe despre transformarea lotului, consultați Utilizați Transformarea lotului și caietele de exemplu.

Definiți o conductă de antrenament

Modelele ML pot fi foarte rar, sau vreodată, considerate statice și neschimbate, deoarece se deplasează de la linia de bază pe care au fost antrenați. Datele din lumea reală evoluează de-a lungul timpului și din acestea ies mai multe modele și perspective, care pot fi sau nu capturate de modelul original antrenat pe date istorice. Pentru a rezolva această problemă, puteți configura o conductă de antrenament care să vă reantreneze automat modelele cu cele mai recente date disponibile.

În definirea acestei conducte, una dintre opțiunile cercetătorului de date este să folosească din nou AutoML pentru conducta de antrenament. Puteți lansa o lucrare AutoML în mod programatic, invocând API-ul create_auto_ml_job() din AWS Boto3 SDK. Puteți apela această operație de la un AWS Lambdas funcția în cadrul unui Funcții pas AWS flux de lucru sau dintr-un LambdaStep in Pipelines Amazon SageMaker.

În mod alternativ, cercetătorul de date poate folosi cunoștințele, artefactele și hiper-parametrii obținuți din jobul AutoML pentru a defini un canal complet de instruire. Aveți nevoie de următoarele resurse:

- Algoritmul care a funcționat cel mai bine pentru cazul de utilizare – Ați obținut deja aceste informații din rezumatul modelului generat de Canvas. Pentru acest caz de utilizare, este algoritmul încorporat XGBoost. Pentru instrucțiuni despre cum să utilizați SDK-ul SageMaker Python pentru a antrena algoritmul XGBoost cu SageMaker, consultați Utilizați XGBoost cu SageMaker Python SDK.

- Hiperparametrii derivați de jobul AutoML – Acestea sunt disponibile în Explicabilitate secțiune. Le puteți folosi ca intrări atunci când definiți jobul de antrenament cu SDK-ul SageMaker Python.

- Codul de inginerie a caracteristicilor furnizat în secțiunea Artefacte – Puteți utiliza acest cod atât pentru preprocesarea datelor înainte de antrenament (de exemplu, prin Amazon SageMaker Processing), cât și înainte de inferență (de exemplu, ca parte a unei conducte de inferență SageMaker).

Puteți combina aceste resurse ca parte a unei conducte SageMaker. Omitem detaliile de implementare în această postare – rămâneți pe fază pentru mai mult conținut care vine pe acest subiect.

Concluzie

SageMaker Canvas vă permite să utilizați ML pentru a genera predicții fără a fi nevoie să scrieți niciun cod. Un analist de afaceri poate începe în mod autonom să-l folosească cu seturi de date locale, precum și cu datele deja stocate Serviciul Amazon de stocare simplă (Amazon S3), Amazon RedShift, sau Fulg de nea. Cu doar câteva clicuri, aceștia își pot pregăti și alătura seturile de date, pot analiza acuratețea estimată, pot verifica ce coloane au impact, pot antrena cel mai performant model și pot genera noi predicții individuale sau pe lot, totul fără a fi nevoie să apeleze la un expert în știință de date. Apoi, după cum este necesar, pot partaja modelul cu o echipă de cercetători de date sau ingineri MLOps, care importă modelele în SageMaker Studio și lucrează alături de analist pentru a oferi o soluție de producție.

Analiștii de afaceri pot obține în mod independent informații din datele lor fără a avea o diplomă în ML și fără a fi nevoie să scrie o singură linie de cod. Oamenii de știință de date pot avea acum mai mult timp pentru a lucra la proiecte mai provocatoare, care pot folosi mai bine cunoștințele lor extinse despre AI și ML.

Credem că această nouă colaborare deschide ușa pentru construirea de soluții ML mai puternice pentru afacerea dvs. Acum aveți analiști care produc informații valoroase de afaceri, permițând în același timp cercetătorilor de date și inginerilor ML să vă ajute să perfecționeze, să ajusteze și să extindă după cum este necesar.

Resurse suplimentare

- Pentru a afla mai multe despre modul în care SageMaker poate ajuta în continuare analiștii de afaceri, consultați Amazon SageMaker pentru analiști de afaceri.

- Pentru a afla mai multe despre modul în care SageMaker le permite oamenilor de știință să dezvolte, antreneze și implementeze modelele lor ML, consultați Amazon SageMaker pentru cercetătorii de date.

- Pentru mai multe informații despre modul în care SageMaker poate ajuta inginerii MLOps în simplificarea ciclului de viață ML folosind MLOps, consultați Amazon SageMaker pentru inginerii MLOps.

Despre Autori

Davide Gallitelli este arhitect specializat în soluții pentru AI/ML în regiunea EMEA. Are sediul la Bruxelles și lucrează îndeaproape cu clienții din Benelux. Este dezvoltator încă de când era foarte mic, începând să codeze la vârsta de 7 ani. A început să învețe AI/ML la universitate și de atunci s-a îndrăgostit de el.

Davide Gallitelli este arhitect specializat în soluții pentru AI/ML în regiunea EMEA. Are sediul la Bruxelles și lucrează îndeaproape cu clienții din Benelux. Este dezvoltator încă de când era foarte mic, începând să codeze la vârsta de 7 ani. A început să învețe AI/ML la universitate și de atunci s-a îndrăgostit de el.

Mark Roy este un arhitect principal de învățare automată pentru AWS, ajutând clienții să proiecteze și să construiască soluții AI / ML. Munca lui Mark acoperă o gamă largă de cazuri de utilizare ML, cu un interes principal în viziunea pe computer, învățarea profundă și scalarea ML în întreaga întreprindere. A ajutat companii din multe industrii, inclusiv asigurări, servicii financiare, mass-media și divertisment, asistență medicală, utilități și producție. Mark deține șase certificări AWS, inclusiv certificarea ML Specialty. Înainte de a se alătura AWS, Mark a fost arhitect, dezvoltator și lider în tehnologie timp de peste 25 de ani, inclusiv 19 ani în servicii financiare.

Mark Roy este un arhitect principal de învățare automată pentru AWS, ajutând clienții să proiecteze și să construiască soluții AI / ML. Munca lui Mark acoperă o gamă largă de cazuri de utilizare ML, cu un interes principal în viziunea pe computer, învățarea profundă și scalarea ML în întreaga întreprindere. A ajutat companii din multe industrii, inclusiv asigurări, servicii financiare, mass-media și divertisment, asistență medicală, utilități și producție. Mark deține șase certificări AWS, inclusiv certificarea ML Specialty. Înainte de a se alătura AWS, Mark a fost arhitect, dezvoltator și lider în tehnologie timp de peste 25 de ani, inclusiv 19 ani în servicii financiare.

- Coinsmart. Cel mai bun schimb de Bitcoin și Crypto din Europa.

- Platoblockchain. Web3 Metaverse Intelligence. Cunoștințe amplificate. ACCES LIBER.

- CryptoHawk. Radar Altcoin. Încercare gratuită.

- Sursa: https://aws.amazon.com/blogs/machine-learning/build-share-deploy-how-business-analysts-and-data-scientists-achieve-faster-time-to-market-using-no- cod-ml-și-amazon-sagemaker-canvas/

- "

- 000

- 100

- 7

- 9

- Despre Noi

- accelera

- accelerarea

- acces

- Conform

- peste

- Suplimentar

- admin

- AI

- Algoritmul

- algoritmi

- TOATE

- Permiterea

- deja

- Amazon

- analiză

- analist

- api

- abordare

- ZONĂ

- în jurul

- Automata

- disponibil

- AWS

- De bază

- deveni

- CEL MAI BUN

- frontieră

- Bruxelles

- construi

- Clădire

- construiește

- construit-in

- afaceri

- apel

- cazuri

- Certificare

- alegeri

- Cerc

- clasificare

- cod

- colaborare

- Coloană

- venire

- Companii

- companie

- complex

- Calcula

- concept

- confuzie

- conține

- conţinut

- Control

- cooperativă

- Nucleu

- Cheltuieli

- credit

- curba

- clienţii care

- de date

- știința datelor

- om de știință de date

- livrare

- Cerere

- implementa

- desfășurarea

- Amenajări

- Detectare

- dezvolta

- Dezvoltator

- Dezvoltare

- diferit

- distribuire

- Nu

- domeniu

- jos

- cu ușurință

- eficient

- Punct final

- inginer

- Inginerie

- inginerii

- Afacere

- Divertisment

- Mediu inconjurator

- estimativ

- exemplu

- experiment

- explorare

- extinde

- mai repede

- Caracteristică

- feedback-ul

- financiar

- Servicii financiare

- First

- debit

- Concentra

- următor

- format

- fraudă

- Gratuit

- Complet

- funcţie

- funcționalitate

- joc

- genera

- obtinerea

- Oferirea

- Verde

- Creștere

- având în

- de asistență medicală

- ajutor

- ajută

- Evidențiați

- extrem de

- istoric

- deține

- Cum

- Cum Pentru a

- HTTPS

- sute

- importanță

- îmbunătăţi

- include

- Inclusiv

- Crește

- individ

- industrii

- informații

- perspective

- asigurare

- integra

- integrate

- interes

- IT

- Loc de munca

- Locuri de munca

- alătura

- cunoştinţe

- etichete

- Ultimele

- lansa

- AFLAȚI

- învăţare

- Linie

- LINK

- Listă

- mic

- local

- Lung

- cautati

- dragoste

- maşină

- masina de învățare

- administrare

- manual

- de fabricaţie

- marca

- Piață

- Matrice

- Mass-media

- Metrici

- milion

- ML

- model

- Modele

- luni

- muta

- reţea

- caiet

- promoții

- deschide

- Operațiuni

- Opțiune

- Opţiuni

- comandă

- organizație

- organizații

- Altele

- performanță

- spectacole

- fază

- planificare

- Joaca

- Punct de vedere

- posibil

- puternic

- prezicere

- Predictii

- de stabilire a prețurilor

- primar

- Principal

- Problemă

- proces

- produce

- producere

- Produse

- Proiecte

- furniza

- furnizează

- trăgând

- calitate

- repede

- gamă

- Crud

- în timp real

- reduce

- raportează

- necesita

- Resurse

- răspuns

- REZULTATE

- venituri

- Alerga

- funcţionare

- scalabil

- scalare

- Ştiinţă

- Om de stiinta

- oamenii de stiinta

- sdk

- selectate

- serie

- Servicii

- set

- Distribuie

- comun

- simplu

- SIX

- Mărimea

- aptitudini

- moale

- So

- soluţii

- REZOLVAREA

- Începe

- început

- statistică

- depozitare

- magazine

- studio

- a sustine

- Ţintă

- echipă

- Tehnologia

- Testarea

- Sursa

- de-a lungul

- timp

- împreună

- Unelte

- top

- tradiţional

- Pregătire

- trenuri

- Tranzacții

- Transforma

- Transparență

- ui

- înţelege

- universitate

- us

- utilizare

- valoare

- Vizualizare

- vizibilitate

- viziune

- Ce

- dacă

- OMS

- în

- fără

- Apartamente

- a lucrat

- de lucru

- fabrică

- scris

- ani