Sunt un mare fan al emisiunii de călătorii a lui Anthony Bourdain Piese necunoscute. În fiecare episod, bucătarul vizitează sate îndepărtate de pe tot globul, documentând viețile, mâncărurile și culturile triburilor regionale cu inima și mintea deschise.

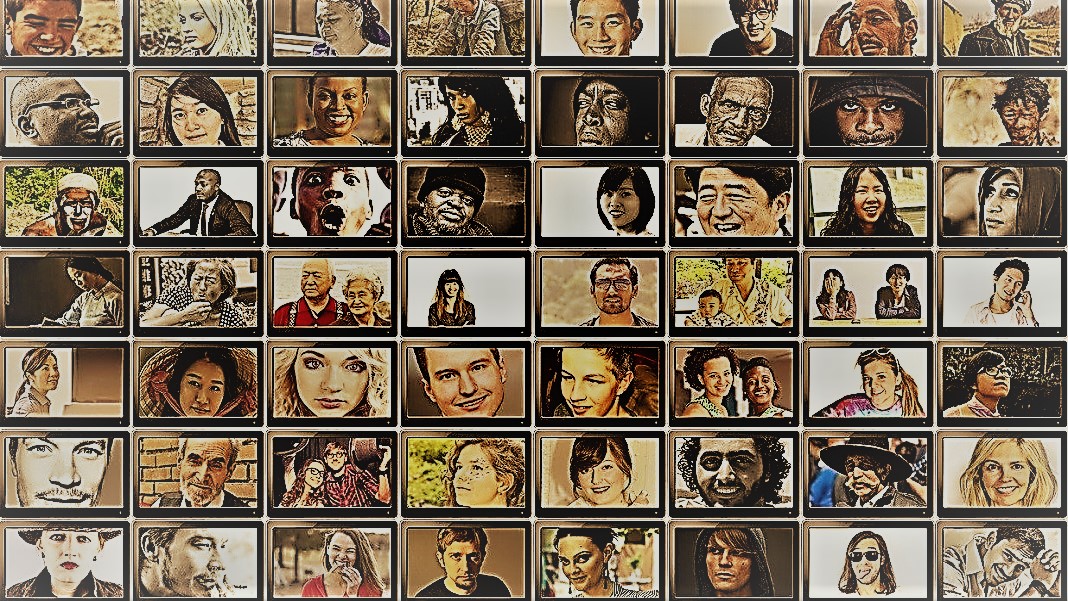

Spectacolul oferă o privire asupra diversității uimitoare a umanității. Oamenii de științe sociale au un obiectiv similar - înțelegerea comportamentului diferitor persoane, grupuri și culturi - dar folosesc o varietate de metode în situații controlate. Pentru amândoi, vedetele acestor urmăriri sunt subiecții: oamenii.

Dar ce se întâmplă dacă ai înlocui oamenii cu chatbot-uri AI?

Ideea sună absurd. Cu toate acestea, datorită apariției ChatGPT și a altor modele de limbaj mari (LLM), oamenii de știință socială cochetează cu ideea de a folosi aceste instrumente pentru a construi rapid diverse grupuri de „oameni simulați” și a efectua experimente pentru a le investiga comportamentul și valorile ca proxy pentru omologii lor biologici.

Dacă vă imaginați minți umane recreate digital, nu este asta. Ideea este de a profita de expertiza ChatGPT de a imita răspunsurile umane. Deoarece modelele colectează cantități enorme de date online — bloguri, comentarii pe Youtube, fan fiction, cărți — ele surprind cu ușurință relațiile dintre cuvinte în mai multe limbi. Acești algoritmi sofisticați pot decoda, de asemenea, aspecte nuanțate ale limbajului, cum ar fi ironia, sarcasmul, metaforele și tonurile emoționale, un aspect critic al comunicării umane în fiecare cultură. Aceste puncte forte fac ca LLM-urile să imite mai multe personalități sintetice cu o gamă largă de convingeri.

Un alt bonus? În comparație cu participanții umani, ChatGPT și alte LLM-uri nu obosesc, permițând oamenilor de știință să colecteze date și să testeze teorii despre comportamentul uman cu o viteză fără precedent.

Ideea, deși controversată, are deja sprijin. Un articol recent Analizând domeniul în curs de dezvoltare a constatat că, în anumite scenarii concepute cu atenție, răspunsurile ChatGPT s-au corelat cu cele ale a aproximativ 95% dintre participanții umani.

AI „ar putea schimba jocul pentru cercetarea în științe sociale” a spus Dr. Igor Grossman de la Universitatea din Waterloo, care, împreună cu colegii, a scris recent un articol despre viitor în Ştiinţă. Cheia de utilizare Homo siliciu în cercetare? Management atent al părtinirii și fidelitatea datelor, a spus echipa.

Sondarea minții societale umane

Ce este exact știința socială?

Mai simplu, este studierea modului în care oamenii, fie ca indivizi, fie ca grup, se comportă în diferite circumstanțe, cum interacționează între ei și se dezvoltă ca cultură. Este o umbrelă a cercetării academice cu mai multe ramuri: economie, științe politice, antropologie și psihologie.

Disciplina abordează o gamă largă de subiecte proeminente în zeitgeist-ul actual. Care este impactul rețelelor sociale asupra sănătății mintale? Care sunt atitudinile publice actuale față de schimbările climatice pe măsură ce episoadele meteorologice severe cresc? Cum valorifică diferitele culturi metodele de comunicare – și ce declanșează neînțelegeri?

Un studiu de științe sociale începe cu o întrebare și o ipoteză. Unul dintre preferatele mele: culturile tolerează diferit mirosul corporal? (Fara gluma, subiectul a fost studiată destul de puțin și da, este o diferenta!)

Oamenii de știință folosesc apoi o varietate de metode, cum ar fi chestionare, teste comportamentale, observație și modelare pentru a-și testa ideile. Sondajele sunt un instrument deosebit de popular, deoarece întrebările pot fi concepute și verificate cu strictețe și pot ajunge cu ușurință la o gamă largă de persoane atunci când sunt distribuite online. Oamenii de știință analizează apoi răspunsurile scrise și aduc perspective asupra comportamentului uman. Cu alte cuvinte, utilizarea limbajului de către un participant este esențială pentru aceste studii.

Deci, cum se potrivește ChatGPT?

„Homo Silicus”

Pentru Grossman, LLM-urile din spatele chatbot-urilor precum ChatGPT sau Google's Bard reprezintă o oportunitate fără precedent de a reproiecta experimentele din științe sociale.

Deoarece sunt instruiți pe seturi masive de date, LLM-urile „pot reprezenta o gamă largă de experiențe și perspective umane”, au spus autorii. Deoarece modelele „hoarbă” liber, fără granițe, pe internet – la fel ca oamenii care călătoresc adesea la nivel internațional – ele pot adopta și afișa o gamă mai largă de răspunsuri în comparație cu subiecții umani recrutați.

ChatGPT, de asemenea, nu se lasă influențat de alți membri ai unui studiu și nu se obosește, permițându-i potențial să genereze răspunsuri mai puțin părtinitoare. Aceste trăsături pot fi utile în special în „proiectele cu risc ridicat” – de exemplu, mimând răspunsurile oamenilor care trăiesc în țări aflate în război sau în regimuri dificile prin postări pe rețelele sociale. La rândul lor, răspunsurile ar putea informa intervențiile din lumea reală.

În mod similar, LLM-urile formate pe subiecte culturale fierbinți, cum ar fi identitatea de gen sau dezinformarea ar putea reproduce diferite școli de gândire teoretice sau ideologice pentru a informa politicile. În loc să chestioneze minuțios sute de mii de participanți umani, AI poate genera rapid răspunsuri bazate pe discursul online.

În afară de posibilele utilizări din viața reală, LLM-urile pot acționa și ca subiecți digitali care interacționează cu participanții umani la experimente de științe sociale, oarecum similar cu personajele nonplayer (NPC) din jocurile video. De exemplu, LLM ar putea adopta diferite „personalități” și interacționa cu voluntari umani de pe tot globul online, folosind text, punându-le aceeași întrebare. Deoarece algoritmii nu dorm, ar putea rula 24/7. Datele rezultate îi pot ajuta pe oamenii de știință să exploreze modul în care diverse culturi evaluează informații similare și cum se răspândesc opiniile și informațiile greșite.

Pași de bebeluș

Ideea de a folosi chatbot-uri în locul oamenilor în studii nu este încă curentă.

Dar există dovezi timpurii că ar putea funcționa. A studiu de preimprimare lansat luna aceasta de la Georgia Tech, Microsoft Research și Olin College au descoperit că un LLM a replicat răspunsurile umane în numeroase experimente de psihologie clasică, inclusiv infamul Experimente de șoc Milgram.

Cu toate acestea, rămâne o întrebare critică: cât de bine pot aceste modele să surprindă cu adevărat răspunsul unui om?

Există mai multe pietre de poticnire.

În primul rând este calitatea algoritmului și a datelor de antrenament. Majoritatea conținutului online este dominat de doar câteva limbi. Un LLM instruit pe aceste date ar putea imita cu ușurință sentimentul, perspectiva sau chiar judecata morală a persoanelor care folosesc acele limbi – moștenind, la rândul său, părtinire din datele de instruire.

„Această reproducere a prejudecăților este o preocupare majoră, deoarece ar putea amplifica diferențele pe care oamenii de știință socială se străduiesc să le descopere în cercetarea lor”, a spus Grossman.

Unii oameni de știință se îngrijorează, de asemenea, că LLM-urile sunt drepte regurgitant ce li se spune. Este antiteza unui studiu de științe sociale, în care scopul principal este de a surprinde umanitatea în toată frumusețea ei diversă și complexă. Pe de altă parte, ChatGPT și modele similare sunt cunoscute pentru „halucinați”, inventând informații care sună plauzibile, dar sunt false.

Deocamdată, „modelele de limbaj mari se bazează pe „umbre” experiențelor umane”, a spus Grossman. Deoarece aceste sisteme de inteligență artificială sunt în mare parte cutii negre, este dificil de înțeles cum sau de ce generează anumite răspunsuri - puțin tulburător atunci când le folosesc ca proxy umani în experimente comportamentale.

În ciuda limitărilor, „LLM-urile permit oamenilor de științe sociale să se despartă de metodele tradiționale de cercetare și să își abordeze munca în moduri inovatoare”, au spus autorii. Ca prim pas, Homo silicus ar putea ajuta la elaborarea de idei și la testarea rapidă a ipotezelor, cele promițătoare fiind validate în continuare la populațiile umane.

Dar pentru ca științele sociale să întâmpine cu adevărat AI, va trebui să existe transparență, corectitudine și acces egal la aceste sisteme puternice. LLM-urile sunt dificil și costisitor de antrenat, modelele recente fiind din ce în ce mai închise în spatele unor paywall-uri puternice.

„Trebuie să ne asigurăm că LLM-urile în științe sociale, la fel ca toate modelele științifice, sunt open-source, ceea ce înseamnă că algoritmii lor și, în mod ideal, datele sunt disponibile tuturor pentru a le analiza, testa și modifica.” a spus autorul studiului Dr. Dawn Parker de la Universitatea din Waterloo. „Numai menținând transparența și replicabilitatea ne putem asigura că cercetarea în științe sociale asistată de inteligență artificială contribuie cu adevărat la înțelegerea noastră a experienței umane.”

Credit imagine: Gerd Altmann / Pixabay

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. Automobile/VE-uri, carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- BlockOffsets. Modernizarea proprietății de compensare a mediului. Accesați Aici.

- Sursa: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :are

- :este

- :nu

- $UP

- 23

- a

- Despre Noi

- academic

- acces

- peste

- act

- adopta

- venire

- AI

- Algoritmul

- algoritmi

- TOATE

- permite

- Permiterea

- deja

- de asemenea

- Sume

- an

- analiza

- și

- Anthony

- abordare

- SUNT

- Arizona

- Mulțime

- articol

- AS

- aspect

- aspecte

- At

- autor

- Autorii

- disponibil

- bazat

- BE

- Frumuseţe

- deoarece

- fost

- comportament

- în spatele

- fiind

- convingerile

- între

- părtinire

- părtinitor

- Pic

- Negru

- Blocuri

- corp

- Primă

- frontierelor

- atât

- Dulapuri

- brainstorming

- ramuri

- Pauză

- dar

- by

- CAN

- captura

- atent

- sigur

- Schimbare

- caractere

- chatbots

- Chat GPT

- împrejurări

- Climat

- Schimbarea climei

- colegii

- colecta

- Colegiu

- comentarii

- Comunicare

- comparație

- complex

- Îngrijorare

- construi

- conţinut

- contribuie

- controlată

- controversat

- ar putea

- țări

- credit

- critic

- aspect critic

- cultural

- Cultură

- Curent

- de date

- seturi de date

- proiectat

- dezvolta

- diferit

- dificil

- digital

- digital

- Afişa

- distribuite

- diferit

- Diversitate

- do

- face

- Nu

- Dont

- dr

- a desena

- fiecare

- Devreme

- cu ușurință

- Economie

- enorm

- asigura

- episod

- egal

- mai ales

- evalua

- Chiar

- Fiecare

- exact

- exemplu

- scump

- experienţă

- Experiențe

- experimente

- expertiză

- explora

- cinste

- fals

- ventilator

- Ficţiune

- fidelitate

- camp

- First

- potrivi

- alimente

- Pentru

- găsit

- din

- mai mult

- joc

- Jocuri

- Gen

- genera

- Georgia

- obține

- licărire

- glob

- Grupului

- mână

- mână

- Avea

- Sănătate

- inimă

- ajutor

- FIERBINTE

- Cum

- HTML

- http

- HTTPS

- mare

- uman

- Experiența umană

- Umanitate

- Oamenii

- sute

- idee

- ideal

- idei

- Identitate

- if

- Impactul

- in

- În altele

- Inclusiv

- Crește

- tot mai mult

- persoane fizice

- infam

- influențat

- Informa

- informații

- inovatoare

- perspective

- interacţiona

- în

- ironie

- IT

- ESTE

- jpg

- doar

- Cheie

- cunoscut

- limbă

- Limbă

- mare

- în mare măsură

- mai puțin

- ca

- limitări

- Locuiește

- viaţă

- LLM

- Principal

- Mainstream

- Mentine

- major

- Efectuarea

- administrare

- masiv

- Mai..

- sens

- Mass-media

- Membri actuali

- mental

- De sănătate mintală

- Metode

- Microsoft

- minte

- mințile

- Dezinformare

- modelare

- Modele

- modifica

- Lună

- morală

- cele mai multe

- multiplu

- trebuie sa

- my

- născând

- Nevoie

- Nu.

- acum

- numeroși

- of

- de multe ori

- on

- ONE

- cele

- on-line

- deschide

- open-source

- Oportunitate

- or

- Altele

- al nostru

- participanţi

- oameni

- la sută

- Personalități

- perspectivă

- perspective

- Plato

- Informații despre date Platon

- PlatoData

- plauzibil

- Punct

- Politicile

- politic

- Popular

- populații

- postări

- potenţial

- puternic

- sondă

- proeminent

- promițător

- dovadă

- furnizează

- împuternicit

- Psihologie

- public

- urmărire

- calitate

- întrebare

- Întrebări

- gamă

- repede

- mai degraba

- ajunge

- lumea reală

- într-adevăr

- recent

- recent

- redesign

- regimuri

- regional

- Relaţii

- eliberat

- se bazează

- rămășițe

- la distanta

- înlocuiește

- replicabilitate

- replicat

- reprezenta

- reproducere

- cercetare

- răspuns

- răspunsuri

- rezultând

- aproximativ

- Alerga

- Said

- acelaşi

- scenarii

- Școli

- Ştiinţă

- ȘTIINȚE

- ştiinţific

- oamenii de stiinta

- sentiment

- set

- câteva

- sever

- Arăta

- asemănător

- pur şi simplu

- situații

- dormi

- Social

- social media

- Postări în rețelele sociale

- societate

- oarecum

- sofisticat

- viteză

- Stele

- începe

- Pas

- puncte forte

- lupta

- studiu

- Studiu

- Studiu

- poticnire

- astfel de

- a sustine

- sintetic

- sisteme

- Parime

- Robinet

- echipă

- tech

- test

- teste

- decât

- mulțumesc

- acea

- lor

- Lor

- apoi

- teoretic

- Acolo.

- Acestea

- ei

- acest

- aceste

- deşi?

- gândit

- mii

- Prin

- obosit

- la

- instrument

- Unelte

- subiecte

- față de

- tradiţional

- Tren

- dresat

- Pregătire

- Transparență

- călătorie

- frământă

- cu adevărat

- ÎNTORCĂ

- umbrelă

- descoperi

- în

- înţelege

- înţelegere

- universitate

- fără precedent

- utilizare

- utilizări

- folosind

- validate

- valoare

- Valori

- varietate

- Fixă

- foarte

- verificat

- Video

- jocuri video

- Vizite

- voluntari

- război

- modalități de

- we

- Vreme

- bun venit

- BINE

- Ce

- cand

- care

- OMS

- de ce

- larg

- Gamă largă

- mai larg

- Wikipedia

- voi

- cu

- fără

- cuvinte

- Apartamente

- fabrică

- face griji

- scris

- da

- încă

- Tu

- youtube

- zeitgeist

- zephyrnet