Video Cel mai mare model de limbaj AI de la Google îi ajută pe roboți să fie mai flexibili în înțelegerea și interpretarea comenzilor umane, potrivit celor mai recente cercetări ale gigantului web.

De obicei, mașinile răspund cel mai bine la cerințe foarte specifice – cererile deschise le pot arunca uneori și pot duce la rezultate pe care utilizatorii nu le-au avut în vedere. Oamenii învață să interacționeze cu roboții într-un mod rigid, cum ar fi să pună întrebări într-un anumit mod pentru a obține răspunsul dorit.

Cel mai recent sistem Google, numit PaLM-SayCan, promite totuși să fie mai inteligent. Dispozitivul fizic de la Everyday Robots – un startup derivat din Google X – are camere pentru ochi în cap și un braț cu un clește ascuns în spatele corpului său lung drept, care se află deasupra unui set de roți.

Puteți urmări robotul în acțiune în videoclipul de mai jos:

Întrebând robotul, ceva de genul „Tocmai m-am antrenat, poți să-mi aduci o gustare sănătoasă?” îl va împinge să aducă un măr. „PaLM-SayCan [este] o abordare interpretabilă și generală a valorificării cunoștințelor din modelele de limbaj, care permite unui robot să urmeze instrucțiuni textuale de nivel înalt pentru a îndeplini sarcini bazate fizic”, cercetătorii de la echipa Google Brain. a explicat.

Google a introdus cel mai mare model de limbă Palmier în aprilie anul acesta. PaLM a fost instruit pe datele răzuite de pe internet, dar în loc să răspundă text deschis, sistemul a fost adaptat pentru a genera o listă de instrucțiuni de urmat de robot.

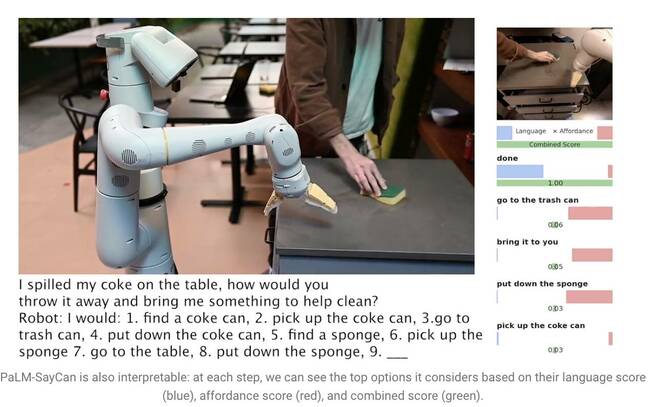

Spunând „Mi-am vărsat Cola pe masă, cum l-ai arunca și mi-ai aduce ceva care să ajute la curățat?”, îl determină pe PaLM să înțeleagă întrebarea și să genereze o listă de pași pe care robotul îi poate urma pentru a finaliza sarcina, cum ar fi să treacă peste. să ridic cutia, să o aruncăm într-un coș și să luăm un burete.

Modelele de limbaj mari (LLM) precum PaLM, totuși, nu înțeleg sensul a ceea ce spun. Din acest motiv, cercetătorii au antrenat un model separat folosind învățarea prin întărire pentru a fundamenta limbajul abstract în reprezentări și acțiuni vizuale. În acest fel, robotul învață să asocieze cuvântul „Coca-Cola” cu o imagine a unei cutii de băutură gazoasă.

PaLM-SayCan învață, de asemenea, așa-numitele „funcții de affordance” – o metodă care ierarhizează posibilitatea de a finaliza o anumită acțiune date obiecte din mediul său. Este mai probabil ca robotul să ridice un burete decât un aspirator, de exemplu, dacă detectează un burete, dar nu există un aspirator în apropierea lui.

„Metoda noastră, SayCan, extrage și valorifică cunoștințele din cadrul LLM-urilor în sarcini bazate fizic”, a explicat echipa într-un lucrare de cercetare. „LLM (Say) oferă o fundamentare a sarcinilor pentru a determina acțiuni utile pentru un obiectiv la nivel înalt, iar funcțiile de affordance învățate (Poate) oferă o bază mondială pentru a determina ce este posibil de executat pe plan. Folosim învățarea prin întărire (RL) ca o modalitate de a învăța funcții de valoare condiționată de limbaj care oferă avantaje a ceea ce este posibil în lume.”

Pentru a împiedica robotul să se îndepărteze de sarcină, acesta este instruit să selecteze acțiuni numai din 101 de instrucțiuni diferite. Google l-a antrenat să se adapteze la o bucătărie – PaLM-SayCan poate obține gustări, băuturi și poate efectua sarcini simple de curățare. Cercetătorii cred că LLM-urile sunt primul pas în a determina roboții să îndeplinească sarcini mai complexe în siguranță, având în vedere instrucțiuni abstracte.

„Experimentele noastre pe o serie de sarcini robotizate din lumea reală demonstrează capacitatea de a planifica și completa instrucțiuni abstracte, în limbaj natural, cu o rată de succes ridicată. Credem că interpretabilitatea lui PaLM-SayCan permite interacțiunea sigură a utilizatorilor din lumea reală cu roboții”, au concluzionat ei. ®

- AI

- ai art

- ai art generator

- ai robot

- inteligență artificială

- certificare de inteligență artificială

- inteligența artificială în domeniul bancar

- robot cu inteligență artificială

- roboți cu inteligență artificială

- software de inteligență artificială

- blockchain

- conferință blockchain ai

- coingenius

- inteligența artificială conversațională

- criptoconferință ai

- dall-e

- învățare profundă

- google ai

- masina de învățare

- Plato

- platoul ai

- Informații despre date Platon

- Jocul lui Platon

- PlatoData

- platogaming

- scara ai

- sintaxă

- Registrul

- zephyrnet