Introducere

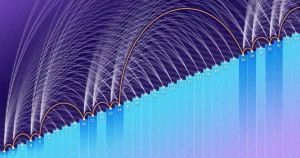

Acum doi ani, într-un proiect numit Dincolo de reperul jocului de imitație, sau BIG-bench, 450 de cercetători au întocmit o listă de 204 sarcini concepute pentru a testa capabilitățile modelelor mari de limbaj, care alimentează chatbot-uri precum ChatGPT. La majoritatea sarcinilor, performanța s-a îmbunătățit previzibil și fără probleme pe măsură ce modelele s-au extins - cu cât modelul era mai mare, cu atât s-a îmbunătățit. Dar cu alte sarcini, saltul în abilități nu a fost lină. Performanța a rămas aproape de zero pentru un timp, apoi performanța a crescut. Alte studii au găsit salturi similare în abilități.

Autorii au descris acest lucru ca fiind un comportament „revoluționar”; alți cercetători au comparat-o cu o tranziție de fază în fizică, cum ar fi atunci când apa lichidă îngheață în gheață. În o hartie publicate în august 2022, cercetătorii au remarcat că aceste comportamente nu sunt doar surprinzătoare, ci și imprevizibile și că ar trebui să informeze conversațiile în evoluție despre siguranța, potențialul și riscul AI. Ei au numit abilitățile „apărea”, un cuvânt care descrie comportamente colective care apar doar odată ce un sistem atinge un nivel ridicat de complexitate.

Dar lucrurile s-ar putea să nu fie atât de simple. O nouă lucrare de un trio de cercetători de la Universitatea Stanford postulează că apariția bruscă a acestor abilități este doar o consecință a modului în care cercetătorii măsoară performanța LLM. Abilitățile, susțin ei, nu sunt nici imprevizibile, nici bruște. „Tranziția este mult mai previzibilă decât oamenii îi acordă credit”, a spus Sanmi Koyejo, un informatician la Stanford și autor principal al lucrării. „Pretențiile puternice de apariție au atât de mult de-a face cu modul în care alegem să măsurăm, cât și cu ceea ce fac modelele.”

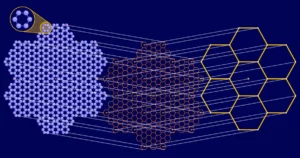

Abia acum vedem și studiem acest comportament din cauza cât de mari au devenit aceste modele. Modelele lingvistice mari se antrenează analizând enorm seturi de date de text — cuvinte din surse online, inclusiv cărți, căutări pe web și Wikipedia — și găsirea de legături între cuvinte care apar adesea împreună. Mărimea este măsurată în termeni de parametri, aproximativ analog cu toate modurile în care cuvintele pot fi conectate. Cu cât mai mulți parametri, cu atât mai multe conexiuni poate găsi un LLM. GPT-2 a avut 1.5 miliarde de parametri, în timp ce GPT-3.5, LLM care alimentează ChatGPT, folosește 350 de miliarde. GPT-4, care a debutat în martie 2023 și acum stă la baza Microsoft Copilot, se pare că folosește 1.75 trilioane.

Această creștere rapidă a adus o creștere uimitoare a performanței și eficacității și nimeni nu contestă faptul că LLM-urile suficient de mari pot îndeplini sarcini pe care modelele mai mici nu le pot realiza, inclusiv cele pentru care nu au fost instruiți. Trio-ul de la Stanford care a considerat apariția ca un „miraj” recunoaște că LLM-urile devin mai eficiente pe măsură ce se extind; de fapt, complexitatea adăugată de modele mai mari ar trebui să facă posibilă îmbunătățirea problemelor mai dificile și mai diverse. Dar ei susțin că, dacă această îmbunătățire pare netedă și previzibilă sau cremoasă și clară, rezultă din alegerea metricii - sau chiar din puține exemple de testare - mai degrabă decât din funcționarea interioară a modelului.

Adunarea de trei cifre oferă un exemplu. În studiul BIG-bench din 2022, cercetătorii au raportat că, cu mai puțini parametri, atât GPT-3, cât și un alt LLM numit LAMDA nu au reușit să completeze cu exactitate problemele de adăugare. Cu toate acestea, atunci când GPT-3 s-a antrenat folosind 13 miliarde de parametri, capacitatea sa s-a schimbat ca și cum ar fi apăsat un comutator. Dintr-o dată, ar putea adăuga - și LAMDA ar putea, de asemenea, la 68 de miliarde de parametri. Acest lucru sugerează că capacitatea de a adăuga apare la un anumit prag.

Dar cercetătorii de la Stanford subliniază că LLM-urile au fost judecate doar în funcție de acuratețe: fie o puteau face perfect, fie nu puteau. Deci, chiar dacă un LLM a prezis corect majoritatea cifrelor, a eșuat. Nu părea corect. Dacă calculezi 100 plus 278, atunci 376 pare un răspuns mult mai precis decât, să zicem, −9.34.

Deci, în schimb, Koyejo și colaboratorii săi au testat aceeași sarcină folosind o măsurătoare care acordă credit parțial. „Ne putem întreba: cât de bine prezice prima cifră? Apoi al doilea? Apoi al treilea?” el a spus.

Koyejo atribuie ideea noii lucrări studentului său absolvent Rylan Schaeffer, despre care a spus că a observat că performanța unui LLM pare să se schimbe odată cu modul în care este măsurată capacitatea acestuia. Împreună cu Brando Miranda, un alt student absolvent de la Stanford, au ales noi valori care arată că, pe măsură ce parametrii au crescut, LLM-urile au prezis o secvență din ce în ce mai corectă de cifre în probleme suplimentare. Acest lucru sugerează că capacitatea de a adăuga nu este emergentă - ceea ce înseamnă că suferă un salt brusc, imprevizibil - ci treptat și previzibil. Ei constată că, cu un alt băţ de măsurat, apariţia dispare.

Introducere

Dar alți oameni de știință subliniază că lucrarea nu risipește pe deplin noțiunea de apariție. De exemplu, lucrarea trio-ului nu explică cum să preziceți când valorile, sau care dintre ele, vor arăta o îmbunătățire bruscă într-un LLM, a spus Tianshi Li, un informatician la Universitatea Northeastern. „Deci, în acest sens, aceste abilități sunt încă imprevizibile”, a spus ea. Alții, cum ar fi Jason Wei, un informatician acum la OpenAI, care a întocmit o listă de abilități emergente și a fost autor al lucrării BIG-bench, au argumentat că rapoartele anterioare despre apariție erau solide, deoarece pentru abilități precum aritmetica, răspunsul corect este cu adevărat tot ceea ce contează.

„Cu siguranță este o conversație interesantă de purtat aici”, a spus Alex Tamkin, cercetător la startup-ul AI Anthropic. Noua lucrare descompune cu îndemânare sarcinile în mai multe etape pentru a recunoaște contribuțiile componentelor individuale, a spus el. „Dar aceasta nu este întreaga poveste. Nu putem spune că toate aceste sărituri sunt un miraj. Încă cred că literatura arată că, chiar și atunci când aveți predicții într-un singur pas sau folosiți metrici continue, aveți în continuare discontinuități și, pe măsură ce creșteți dimensiunea modelului, puteți vedea în continuare că se îmbunătățește într-un mod asemănător săriturii.”

Și chiar dacă apariția în LLM-urile de astăzi poate fi explicată prin diferite instrumente de măsurare, este probabil că nu va fi cazul LLM-urilor mai mari și mai complicate de mâine. „Când creștem LLM-urile la următorul nivel, inevitabil vor împrumuta cunoștințe de la alte sarcini și alte modele”, a spus Xia „Ben” Hu, un informatician la Universitatea Rice.

Această luare în considerare în evoluție a apariției nu este doar o întrebare abstractă pe care cercetătorii trebuie să o ia în considerare. Pentru Tamkin, se referă direct la eforturile în curs de a prezice modul în care se vor comporta LLM. „Aceste tehnologii sunt atât de largi și atât de aplicabile”, a spus el. „Sper că comunitatea folosește acest lucru ca un punct de plecare ca un accent continuu asupra cât de important este să construim o știință a predicției pentru aceste lucruri. Cum să nu fim surprinși de următoarea generație de modele?”

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://www.quantamagazine.org/how-quickly-do-large-language-models-learn-unexpected-skills-20240213/

- :are

- :este

- :nu

- ][p

- $UP

- 1

- 100

- 13

- 2022

- 2023

- 204

- 350

- 75

- a

- abilități

- capacitate

- REZUMAT

- precizie

- precis

- precis

- adăuga

- adăugat

- plus

- în urmă

- AI

- TOATE

- an

- analiza

- și

- O alta

- răspunde

- Antropică

- apărea

- aplicabil

- SUNT

- argumenta

- în jurul

- AS

- cere

- At

- August

- autor

- Autorii

- Premii

- departe

- BE

- deoarece

- deveni

- comportament

- comportamente

- Mai bine

- între

- Miliard

- Manuale

- împrumuta

- atât

- pauze

- larg

- adus

- construi

- dar

- by

- calcularea

- denumit

- CAN

- capacități

- caz

- sigur

- Schimbare

- si-a schimbat hainele;

- chatbots

- Chat GPT

- alegere

- Alege

- a ales

- creanțe

- colaboratori

- Colectiv

- comunitate

- compilat

- Completă

- complexitate

- complicat

- componente

- calculator

- legat

- Conexiuni

- consecință

- Lua în considerare

- considerare

- a continuat

- continuu

- contribuţii

- Conversație

- conversații

- corecta

- corect

- ar putea

- credit

- credite

- a debutat

- categoric

- descris

- descrie

- proiectat

- diferit

- dificil

- cifre

- direct

- diferit

- do

- face

- Nu

- face

- jos

- Mai devreme

- Eficace

- eficacitate

- Eforturile

- oricare

- apariție

- apare

- accent

- enorm

- suficient de

- Chiar

- evoluție

- exemplu

- exemple

- Explica

- a explicat

- fapt

- A eșuat

- Modă

- mai puține

- Găsi

- descoperire

- First

- Flip

- Pentru

- găsit

- din

- Complet

- complet

- joc

- generaţie

- obține

- obtinerea

- Da

- am

- treptat

- absolvent

- Crește

- Creștere

- HAD

- Avea

- he

- aici

- Înalt

- lui

- speranţă

- Cum

- Cum Pentru a

- Totuși

- HTML

- HTTPS

- i

- ICE

- idee

- if

- important

- îmbunătățit

- îmbunătățire

- in

- Inclusiv

- Crește

- a crescut

- tot mai mult

- individ

- inevitabil

- Informa

- interior

- in schimb

- interesant

- în

- IT

- ESTE

- judecat

- a sari

- sărit

- salturi

- doar

- cunoştinţe

- limbă

- mare

- mai mare

- salturi

- AFLAȚI

- Nivel

- ca

- Probabil

- Link-uri

- Lichid

- Listă

- literatură

- LLM

- Se pare

- revistă

- face

- Martie

- materie

- Mai..

- sens

- măsura

- măsurare

- metric

- Metrici

- Microsoft

- model

- Modele

- mai mult

- cele mai multe

- mult

- Numit

- În apropiere

- Nici

- Nou

- următor

- Nu.

- Universitatea Northeastern

- notat

- noțiune

- acum

- of

- promoții

- de multe ori

- on

- dată

- ONE

- cele

- în curs de desfășurare

- on-line

- afară

- OpenAI

- or

- Altele

- Altele

- afară

- Hârtie

- parametrii

- oameni

- perfect

- performanță

- fază

- Fizică

- Plato

- Informații despre date Platon

- PlatoData

- la care se adauga

- Punct

- posibil

- potenţial

- putere

- competenţelor

- prezice

- predictibil

- a prezis

- prezicere

- Predictii

- probleme

- proiect

- publicat

- Quantamagazina

- întrebare

- repede

- rapid

- mai degraba

- aTINGE

- într-adevăr

- recunoaște

- a ramas

- Raportat

- relatărilor

- Rapoarte

- cercetare

- cercetători

- REZULTATE

- Orez

- dreapta

- Risc

- aproximativ

- Siguranţă

- Said

- acelaşi

- Spune

- Scară

- scalate

- Ştiinţă

- Om de stiinta

- oamenii de stiinta

- Cautari

- Al doilea

- vedea

- vedere

- părea

- pare

- senior

- sens

- Secvenţă

- ascuţit

- ea

- să

- Arăta

- arătând

- Emisiuni

- asemănător

- simplu

- Mărimea

- aptitudini

- mai mici

- netezi

- lin

- So

- Suna

- Surse

- vorbeşte

- stanford

- Universitatea Stanford

- lansare

- Încă

- Poveste

- student

- studiu

- Studiu

- Studiu

- astfel de

- brusc

- sugerează

- apare

- uimit

- surprinzător

- Intrerupator

- sistem

- Sarcină

- sarcini

- Tehnologii

- termeni

- test

- testat

- decât

- acea

- apoi

- Acestea

- ei

- lucruri

- crede

- Al treilea

- acest

- prag

- la

- azi

- împreună

- de asemenea

- Unelte

- Tren

- dresat

- tranziţie

- Trilion

- trio

- este supus

- Neașteptat

- universitate

- imprevizibil

- utilizare

- utilizări

- folosind

- a fost

- Apă

- Cale..

- modalități de

- we

- web

- WebP

- BINE

- au fost

- Ce

- cand

- dacă

- care

- în timp ce

- OMS

- Wikipedia

- voi

- cu

- Cuvânt

- cuvinte

- Apartamente

- lucrări

- ar

- ani

- Tu

- Ta

- zephyrnet

- zero