Introducere

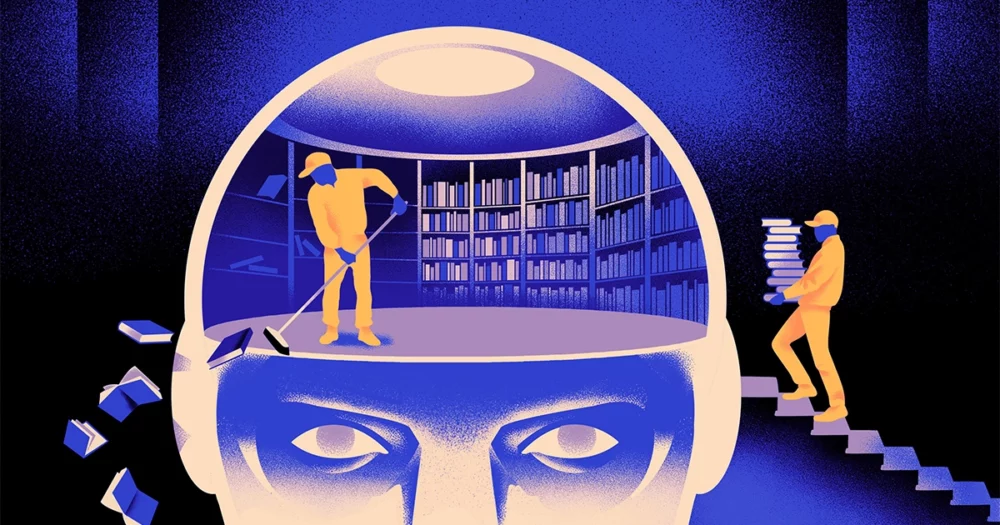

O echipă de informaticieni a creat un tip mai agil, mai flexibil a modelului de învățare automată. Trucul: trebuie să uite periodic ceea ce știe. Și deși această nouă abordare nu va înlocui modelele uriașe care stau la baza celor mai mari aplicații, ar putea dezvălui mai multe despre modul în care aceste programe înțeleg limbajul.

Noua cercetare marchează „un progres semnificativ în domeniu”, a spus Jea Kwon, un inginer AI la Institutul pentru Științe de bază din Coreea de Sud.

Motoarele de limbaj AI utilizate astăzi sunt alimentate în cea mai mare parte de rețele neuronale artificiale. Fiecare „neuron” din rețea este o funcție matematică care primește semnale de la alți astfel de neuroni, execută unele calcule și trimite semnale prin mai multe straturi de neuroni. Inițial, fluxul de informații este mai mult sau mai puțin aleatoriu, dar prin antrenament, fluxul de informații între neuroni se îmbunătățește pe măsură ce rețeaua se adaptează la datele de antrenament. Dacă un cercetător AI dorește să creeze un model bilingv, de exemplu, ea ar antrena modelul cu o grămadă mare de text din ambele limbi, care ar ajusta conexiunile dintre neuroni în așa fel încât să relaționeze textul într-o singură limbă cu echivalent. cuvinte în celălalt.

Dar acest proces de instruire necesită multă putere de calcul. Dacă modelul nu funcționează foarte bine sau dacă nevoile utilizatorului se schimbă ulterior, este greu să-l adaptezi. „Să presupunem că aveți un model care are 100 de limbi, dar imaginați-vă că o limbă pe care o doriți nu este acoperită”, a spus Mikel Artetxe, un coautor al noii cercetări și fondator al startup-ului AI Reka. „Ați putea începe de la zero, dar nu este ideal.”

Artetxe și colegii săi au încercat să ocolească aceste limitări. Acum cativa ani, Artetxe și alții au antrenat o rețea neuronală într-o singură limbă, apoi au șters ceea ce știa despre elementele de bază ale cuvintelor, numite jetoane. Acestea sunt stocate în primul strat al rețelei neuronale, numit stratul de încorporare. Au lăsat în pace toate celelalte straturi ale modelului. După ștergerea jetoanelor primei limbi, au reantrenat modelul pe a doua limbă, care a umplut stratul de încorporare cu noi jetoane din limba respectivă.

Chiar dacă modelul conținea informații nepotrivite, recalificarea a funcționat: modelul a putut învăța și procesa noua limbă. Cercetătorii au presupus că, în timp ce stratul de încorporare stoca informații specifice cuvintelor folosite în limbă, nivelurile mai profunde ale rețelei stocau informații mai abstracte despre conceptele din spatele limbajelor umane, ceea ce a ajutat apoi modelul să învețe a doua limbă.

„Trăim în aceeași lume. Conceptualizăm aceleași lucruri cu cuvinte diferite” în limbi diferite, a spus Yihong Chen, autorul principal al lucrării recente. „De aceea aveți același raționament la nivel înalt în model. Un măr este ceva dulce și suculent, în loc de doar un cuvânt.”

Introducere

În timp ce această abordare a uitarii a fost o modalitate eficientă de a adăuga o nouă limbă la un model deja instruit, recalificarea a fost încă solicitantă - a necesitat multe date lingvistice și putere de procesare. Chen a sugerat o modificare: în loc să se antreneze, să ștergă stratul de încorporare, apoi să se reantreneze, ar trebui să resetați periodic stratul de încorporare în timpul rundei inițiale de antrenament. „Făcând acest lucru, întregul model se obișnuiește cu resetarea”, a spus Artetxe. „Asta înseamnă că atunci când vrei să extinzi modelul într-o altă limbă, este mai ușor, pentru că asta ai făcut.”

Cercetătorii au luat un model de limbaj folosit în mod obișnuit, numit Roberta, l-au antrenat folosind tehnica lor de uitare periodică și l-au comparat cu performanța aceluiași model atunci când a fost antrenat cu abordarea standard, fără uitare. Modelul de uitare s-a descurcat puțin mai rău decât cel convențional, primind un scor de 85.1 comparativ cu 86.1 la o măsură comună a acurateței limbajului. Apoi au reantrenat modelele pe alte limbi, folosind seturi de date mult mai mici de doar 5 milioane de jetoane, mai degrabă decât cele 70 de miliarde pe care le-au folosit în timpul primului antrenament. Precizia modelului standard a scăzut la 53.3 în medie, dar modelul uitat a scăzut doar la 62.7.

Modelul uitarii s-a descurcat, de asemenea, mult mai bine dacă echipa a impus limite de calcul în timpul reinstruirii. Când cercetătorii au redus durata antrenamentului de la 125,000 de pași la doar 5,000, precizia modelului de uitare a scăzut la 57.8, în medie, în timp ce modelul standard a scăzut la 37.2, ceea ce nu este mai bun decât presupunerile aleatorii.

Introducere

Echipa a concluzionat că uitarea periodică pare să facă modelul mai bun la învățarea limbilor străine în general. „Pentru că [ei] continuă să uite și să reînvețe în timpul antrenamentului, a preda rețelei ceva nou mai târziu devine mai ușor”, a spus Evgenii Nikishin, cercetător la Mila, un centru de cercetare a învățării profunde din Quebec. Acesta sugerează că atunci când modelele de limbaj înțeleg o limbă, o fac la un nivel mai profund decât doar semnificațiile cuvintelor individuale.

Abordarea este similară cu modul în care funcționează propriul nostru creier. „Memoria umană, în general, nu este foarte bună la stocarea cu acuratețe a unor cantități mari de informații detaliate. În schimb, oamenii tind să-și amintească esența experiențelor noastre, făcând abstracție și extrapolând”, a spus Benjamin Levy, neurolog la Universitatea din San Francisco. „Activarea inteligenței artificiale cu procese mai asemănătoare oamenilor, cum ar fi uitarea adaptivă, este o modalitate de a le aduce la performanțe mai flexibile.”

Pe lângă ceea ce s-ar putea spune despre modul în care funcționează înțelegerea, Artetxe speră că modelele mai flexibile de uitare lingvistică ar putea contribui și la aducerea celor mai recente descoperiri AI în mai multe limbi. Deși modelele AI sunt bune la manipularea spaniolă și engleză, două limbi cu materiale de instruire ample, modelele nu sunt atât de bune cu basca sa nativă, limba locală specifică nord-estului Spaniei. „Majoritatea modelelor de la marile companii de tehnologie nu o fac bine”, a spus el. „Adaptarea modelelor existente la bască este calea de urmat.”

De asemenea, Chen așteaptă cu nerăbdare o lume în care mai multe flori AI înfloresc. „Mă gândesc la o situație în care lumea nu are nevoie de un model mare de limbă. Avem atât de multe”, a spus ea. „Dacă există o fabrică care produce modele lingvistice, ai nevoie de acest tip de tehnologie. Are un model de bază care se poate adapta rapid la noi domenii.”

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :are

- :este

- :nu

- :Unde

- ][p

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- Despre Noi

- REZUMAT

- precizie

- precis

- adapta

- adaptivă

- se adaptează

- adăuga

- plus

- avansa

- După

- AI

- Modele AI

- TOATE

- singur

- deja

- de asemenea

- Sume

- an

- și

- O alta

- Apple

- abordare

- Apps

- SUNT

- AS

- At

- autor

- in medie

- de bază

- de bază

- deoarece

- devine

- fost

- în spatele

- Mai bine

- între

- Mare

- tehnologie mare

- Cea mai mare

- Miliard

- Blocuri

- Floare

- atât

- descoperiri

- aduce

- Clădire

- dar

- by

- calcule

- denumit

- CAN

- Centru

- Schimbare

- chen

- ocoli

- Coautor

- colegii

- Comun

- în mod obișnuit

- Companii

- comparație

- de calcul

- calculator

- tehnica de calcul

- puterea de calcul

- Concepte

- încheiat

- Conexiuni

- conținute

- convențional

- ar putea

- acoperit

- crea

- a creat

- Tăiat

- de date

- seturi de date

- scăzut

- adânc

- învățare profundă

- Mai adânc

- cerând

- detaliat

- FĂCUT

- diferit

- do

- Nu

- face

- domenii

- Dont

- scăzut

- în timpul

- fiecare

- mai ușor

- Eficace

- Încorporarea

- inginer

- Motoare

- Engleză

- Întreg

- Echivalent

- exemplu

- existent

- Experiențe

- extinde

- fabrică

- puțini

- camp

- umplut

- First

- flexibil

- debit

- Pentru

- Înainte

- fondator

- Francisco

- din

- funcţie

- General

- în general

- obține

- GitHub

- Go

- bine

- Manipularea

- Greu

- Avea

- he

- ajutor

- a ajutat

- la nivel înalt

- lui

- speranțe

- Cum

- HTTPS

- mare

- uman

- asemănător omului

- Oamenii

- ideal

- if

- imagina

- impusă

- îmbunătăţeşte

- in

- individ

- informații

- inițială

- inițial

- in schimb

- Institut

- IT

- doar

- A pastra

- Copil

- știe

- Coreea

- limbă

- Limbă

- mare

- mai tarziu

- Ultimele

- strat

- straturi

- conduce

- AFLAȚI

- învăţare

- stânga

- Lungime

- mai puțin

- Nivel

- nivelurile de

- ca

- limitări

- Limitele

- trăi

- local

- Se pare

- Lot

- maşină

- masina de învățare

- revistă

- face

- Efectuarea

- multe

- Materiale

- matematic

- sensuri

- mijloace

- măsura

- Memorie

- ar putea

- milion

- model

- Modele

- mai mult

- Mai ales

- mult

- multiplu

- trebuie sa

- nativ

- Nevoie

- nevoilor

- reţea

- neural

- rețele neuronale

- neuronii

- Nou

- Nu.

- of

- on

- ONE

- afară

- or

- Altele

- Altele

- al nostru

- peste

- propriu

- Hârtie

- performanță

- periodic

- Plato

- Informații despre date Platon

- PlatoData

- plonjat

- putere

- alimentat

- proces

- procese

- prelucrare

- Putere de procesare

- Programe

- Quantamagazina

- Quebec

- repede

- aleator

- mai degraba

- primește

- primire

- recent

- minte

- necesar

- cercetare

- cercetător

- cercetători

- dezvălui

- rotund

- ruleaza

- Said

- acelaşi

- San

- San Francisco

- Spune

- Ştiinţă

- oamenii de stiinta

- scor

- zgâria

- Al doilea

- pare

- selectiv

- trimite

- Seturi

- ea

- să

- semnalele

- semnificativ

- asemănător

- situație

- mai mici

- So

- unele

- ceva

- Sud

- Coreea de Sud

- Spania

- Spaniolă

- specific

- standard

- Începe

- lansare

- paşi

- Încă

- stocate

- stocarea

- astfel de

- sugerează

- dulce

- ia

- Predarea

- echipă

- tech

- tech

- tehnică

- Tehnologia

- Tind

- a) Sport and Nutrition Awareness Day in Manasia Around XNUMX people from the rural commune Manasia have participated in a sports and healthy nutrition oriented activity in one of the community’s sports ready yards. This activity was meant to gather, mainly, middle-aged people from a Romanian rural community and teach them about the benefits that sports have on both their mental and physical health and on how sporting activities can be used to bring people from a community closer together. Three trainers were made available for this event, so that the participants would get the best possible experience physically and so that they could have the best access possible to correct information and good sports/nutrition practices. b) Sports Awareness Day in Poiana Țapului A group of young participants have taken part in sporting activities meant to teach them about sporting conduct, fairplay, and safe physical activities. The day culminated with a football match.

- decât

- acea

- informațiile

- lumea

- lor

- Lor

- apoi

- Acestea

- ei

- lucruri

- Gândire

- acest

- deşi?

- Prin

- la

- astăzi

- indicativele

- a luat

- Tren

- dresat

- Pregătire

- truc

- încercat

- ciupi

- Două

- înţelege

- înţelegere

- universitate

- utilizare

- utilizat

- folosind

- foarte

- vrea

- vrea

- a fost

- Cale..

- we

- WebP

- BINE

- Ce

- cand

- care

- în timp ce

- de ce

- cu

- Cuvânt

- cuvinte

- Apartamente

- a lucrat

- fabrică

- lume

- mai rău

- ar

- ani

- Tu

- zephyrnet