Interviu Abilitățile modelelor comerciale de limbaje mari de a rezolva problemele de programare competitive pot fi stimulate semnificativ prin ghidarea cu atenție a proceselor sale printr-o inginerie inteligentă promptă.

Pentru a demonstra acest lucru, Codium AI, cu sediul în Israel, a construit AlphaCodium și eliberat software-ul de pe GitHub luna aceasta. AlphaCodium nu este un model de limbaj mare în sine. În schimb, este o metodă care îmbunătățește abilitățile de rezolvare a problemelor ale instrumentelor AI generative precum GPT-4, folosind ceea ce CEO-ul Itamar Friedman numește „ingineria fluxului”.

În primul rând, o întrebare de programare este transmisă modelului de limbaj mare subiacent și i se cere să descrie și să rezume problema. Aceste informații ghidează apoi modul în care ar trebui să înceapă să rezolve problema. AlphaCodium definește lucruri, cum ar fi ceea ce ar trebui să fie intrările și ieșirile, atunci când vine cu o soluție. Toate acestea sunt specificate în limbaj natural.

Modelul începe apoi să genereze cod care se aliniază cu specificațiile pe care tocmai le-a descris. Competițiile de programare care le cer concurenților să codeze conform specificațiilor oferă de obicei teste care arată ce ar trebui să iasă un script pentru o anumită intrare. AlphaCodium generează mai multe dintre aceste cazuri de testare și apoi rulează soluții posibile pentru a verifica dacă codul funcționează conform așteptărilor.

Dacă nu reușește să se potrivească cu niciuna dintre ieșirile definite în niciunul dintre teste, modelul generează diferite soluții până când trec toate testele sau nu reușește. Pot apărea erori atunci când codul său nu se compila sau este pur și simplu greșit.

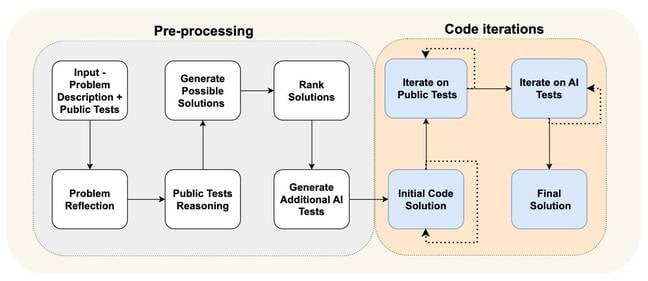

Puteți vedea diferiții pași ai procesului de inginerie a fluxului în diagrama de mai jos. Este împărțit în mare parte într-o fază de preprocesare, în care sistemul analizează problema în limbaj natural și o etapă de iterare a codului, în care rulează soluții posibile împotriva testelor publice și generate de AI.

„Nu luăm problema și mergem la model și îi spunem: „Hei, te rog să generăm soluția finală”, a spus Friedman. Registrul. „Solicităm modelului să redefinească această problemă în puncte.” Simplificarea acestuia și împărțirea lucrurilor în bucăți face ca modelul să genereze mai târziu cod mai ușor pentru diferite părți ale unui algoritm.

În esență, ingineria fluxului este o procedură care ghidează procesul de rezolvare a problemelor modelului, împărțindu-l în pași bine definiți. Îndemnarea acestuia să „împartă codul generat în sub-funcții mici, cu nume și funcționalități semnificative”, ni se spune, duce la mai puține erori și face codul mai ușor de testat și remediat.

„Practic, ne-am petrecut 95% din timp pe inginerie de flux și doar 5% pe inginerie promptă și nu am schimbat solicitările pentru fiecare [pas]”, a adăugat Friedman.

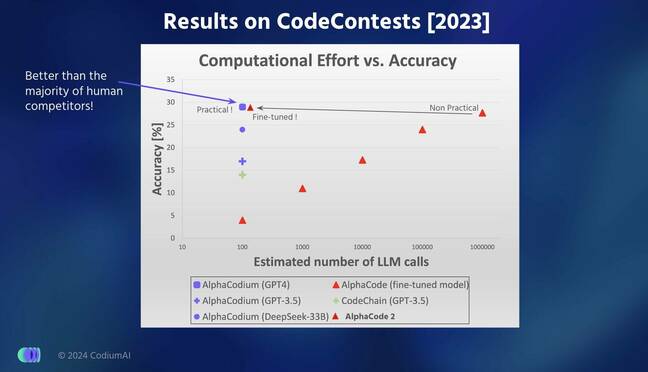

Inginerii de la Codium au testat performanța modelului lor pe sute de probleme utilizate în părțile de verificare și testare ale setului de date CodeForces compilat de Google DeepMind în urmă cu doi ani. Ei susțin că AlphaCodium a fost mai bun la rezolvarea problemelor de codare decât modelele AlphaCode și AlphaCode2 de la Google DeepMind.

În rezultatele raportate într-un arXiv hârtie [PDF], AlphaCodium a reușit să răspundă corect la 44% dintre întrebări, comparativ cu 24% ale AlphaCode, generând în același timp doar cinci soluții în comparație cu cele zece soluții alese de AlphaCode pentru 107 probleme de validare. Interesant este că decalajul s-a redus când a fost vorba de 165 de probleme de testare, AlphaCodium rezolvând 29%, comparativ cu AlphaCode de 28%.

AlphaCode selectează cele mai promițătoare zece soluții din zeci de mii sau sute de mii de scripturi posibile pe care le generează, ceea ce face ca rularea să fie intensivă din punct de vedere al calculului.

„Ne-am concentrat mult mai mult pe întregul flux de testare”, a spus Friedman. „Pentru [Google], au lucrat atât de mult asupra generației. Ei încearcă să genereze sute de alte opțiuni și noi generăm foarte puține soluții, dar le testează foarte bine pentru a ghida îmbunătățirea codului.”

AlphaCodium este puțin mai bun decât cel mai recent model AlphaCode2 al Google DeepMind, care este de 10,000 de ori mai eficient decât predecesorul său AlphaCode, a adăugat el.

Cum se compară AlphaCodium cu alte modele de ultimă generație în ceea ce privește acuratețea și eficiența

Friedman a spus că este încrezător că performanța AlphaCodium nu se datorează scurgerii de date, unde modelul de bază a fost antrenat și testat pe aceleași probleme. Versiunea GPT-4 care alimentează AlphaCodium a fost instruită pe text răzuit de pe internet până în septembrie 2021, în timp ce problemele pe care și-a testat sistemul au fost preluate din setul de date CodeForces menționat mai sus, care a fost lansat mult mai târziu.

O comparație mai bună de la mere la mere care evaluează procesul de inginerie a fluxului, totuși, se uită la capacitatea GPT-4 de a rezolva aceleași întrebări cu și fără aplicarea AlphaCodium. GPT-4 vechi simplu a putut răspunde corect doar la 19 și, respectiv, 12 la sută din problemele din seturile de validare și, respectiv, de testare, în comparație cu varianta alimentată cu AlphaCodium de 44 și 29 de procente.

Pe scurt, se pare că implementarea unui pipeline atent care generează date suplimentare pentru a ghida modul în care este generat codul și pentru a îmbunătăți procesul de testare poate fi mai eficientă decât încercarea de a antrena de la zero un model de limbaj mare.

Codium a lansat recent un nou instrument pentru a sprijini dezvoltatorii Python, care acum pot apela AlphaCodium pentru a rezolva direct o problemă de codare în IDE-ul lor. Te poți juca cu el Aici. ®

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://go.theregister.com/feed/www.theregister.com/2024/02/19/codium_ai_interview/

- :are

- :este

- :nu

- :Unde

- $UP

- 10

- 12

- 19

- 2021

- 24

- 28

- 29

- 7

- a

- abilități

- capacitate

- Capabil

- precizie

- adăugat

- Suplimentar

- împotriva

- în urmă

- AI

- Algoritmul

- Se aliniază

- TOATE

- an

- analize

- și

- răspunde

- Orice

- apare

- Aplicarea

- apărea

- AS

- cere

- solicitând

- evaluează

- At

- bazat

- Pe scurt

- BE

- fost

- începe

- începe

- de mai jos

- Mai bine

- Pic

- amplificat

- Breaking

- larg

- gandaci

- construit

- dar

- by

- apel

- apeluri

- a venit

- CAN

- atent

- cu grijă

- cazuri

- CEO

- Schimbare

- verifica

- ales

- pretinde

- CO

- cod

- Codificare

- venire

- comercial

- comparație

- comparație

- Competiţii

- competitiv

- compilat

- din punct de vedere computațional

- încrezător

- corect

- ar putea

- de date

- scurgeri de date

- set de date

- DeepMind

- definit

- defineste

- demonstra

- descrie

- descris

- Dezvoltatorii

- diagramă

- FĂCUT

- diferit

- direct

- împărţi

- nu

- don

- două

- fiecare

- mai ușor

- Eficace

- eficient

- Inginerie

- Întreg

- Erori

- de aşteptat

- eșuează

- fed-

- puțini

- mai puține

- final

- cinci

- Repara

- debit

- concentrat

- Pentru

- din

- funcționalitate

- decalaj

- genera

- generată

- generează

- generator

- generaţie

- generativ

- AI generativă

- GitHub

- dat

- Go

- ghida

- Ghiduri

- călăuzitor

- he

- Cum

- Totuși

- HTTPS

- sute

- if

- Punere în aplicare a

- îmbunătăţi

- îmbunătățire

- îmbunătăţeşte

- in

- informații

- intrare

- intrări

- in schimb

- Internet

- în

- ISN

- Israel

- IT

- repetare

- ESTE

- jpg

- doar

- Etichetă

- limbă

- mare

- în mare măsură

- mai tarziu

- Ultimele

- Conduce

- scurgere

- ca

- cautati

- FACE

- Efectuarea

- administra

- Meci

- semnificativ

- metodă

- model

- Modele

- Lună

- mai mult

- mai eficient

- cele mai multe

- mult

- nume

- Natural

- Nou

- acum

- of

- Vechi

- on

- afară

- Opţiuni

- or

- Altele

- al nostru

- afară

- producție

- iesiri

- piese

- trece

- pentru

- la sută

- performanță

- fază

- conducte

- Simplu

- Plato

- Informații despre date Platon

- PlatoData

- Joaca

- "vă rog"

- puncte

- posibil

- Alimentarea

- predecesor

- Problemă

- de rezolvare a problemelor

- probleme

- procedură

- proces

- procese

- Programare

- promițător

- solicitări

- furniza

- public

- Piton

- întrebare

- Întrebări

- RE

- într-adevăr

- recent

- Redefinire

- eliberat

- Raportat

- respectiv

- REZULTATE

- Alerga

- ruleaza

- s

- Said

- acelaşi

- zgâria

- scenariu

- script-uri

- vedea

- Septembrie

- set

- Seturi

- Pantaloni scurți

- să

- arătând

- semnificativ

- simplificarea

- mic

- So

- Software

- soluţie

- soluţii

- REZOLVAREA

- Rezolvarea

- Specificaţii

- specificată

- uzat

- împărţi

- Etapă

- de ultimă oră

- Pas

- paşi

- rezuma

- a sustine

- sistem

- Lua

- luate

- spune

- zece

- zeci

- termeni

- test

- testat

- Testarea

- teste

- a) Sport and Nutrition Awareness Day in Manasia Around XNUMX people from the rural commune Manasia have participated in a sports and healthy nutrition oriented activity in one of the community’s sports ready yards. This activity was meant to gather, mainly, middle-aged people from a Romanian rural community and teach them about the benefits that sports have on both their mental and physical health and on how sporting activities can be used to bring people from a community closer together. Three trainers were made available for this event, so that the participants would get the best possible experience physically and so that they could have the best access possible to correct information and good sports/nutrition practices. b) Sports Awareness Day in Poiana Țapului A group of young participants have taken part in sporting activities meant to teach them about sporting conduct, fairplay, and safe physical activities. The day culminated with a football match.

- decât

- acea

- lor

- Lor

- apoi

- Acestea

- ei

- lucruri

- acest

- aceste

- deşi?

- mii

- Prin

- timp

- la

- a spus

- instrument

- Unelte

- Tren

- dresat

- încerca

- încercat

- Două

- tipic

- care stau la baza

- până la

- utilizat

- folosind

- validare

- Variantă

- Verificare

- versiune

- foarte

- a fost

- we

- BINE

- bine definit

- au fost

- Ce

- cand

- întrucât

- în timp ce

- OMS

- cu

- fără

- Apartamente

- de lucru

- Greșit

- ani

- Tu

- zephyrnet