Moderarea conținutului este procesul de screening și monitorizare online a conținutului generat de utilizatori. Pentru a oferi un mediu sigur atât pentru utilizatori, cât și pentru mărci, platformele trebuie să modereze conținutul pentru a se asigura că acesta se încadrează în liniile directoare prestabilite de comportament acceptabil, care sunt specifice platformei și audienței sale.

Când o platformă moderează conținutul, conținutul acceptabil generat de utilizatori (UGC) poate fi creat și partajat cu alți utilizatori. Comportamentele inadecvate, toxice sau interzise pot fi prevenite, blocate în timp real sau eliminate ulterior, în funcție de instrumentele și procedurile de moderare a conținutului pe care le are platforma.

Poți să folosești Moderare de conținut Amazon Rekognition pentru a detecta conținut inadecvat, nedorit sau ofensator, pentru a crea o experiență de utilizator mai sigură, pentru a oferi agenților de publicitate garanții de siguranță a mărcii și pentru a respecta reglementările locale și globale.

În această postare, discutăm elementele cheie necesare pentru a evalua aspectul de performanță al unui serviciu de moderare a conținutului în ceea ce privește diferitele metrici de acuratețe și oferim un exemplu de utilizare a Amazon Rekognition API-uri de moderare a conținutului.

Ce să evaluezi

Când evaluați un serviciu de moderare a conținutului, vă recomandăm următorii pași.

Înainte de a putea evalua performanța API-ului în cazurile dvs. de utilizare, trebuie să pregătiți un set de date de testare reprezentativ. Următoarele sunt câteva recomandări de nivel înalt:

- Colectie – Luați o mostră aleatorie suficient de mare (imagini sau videoclipuri) din datele pe care doriți să le rulați în cele din urmă prin Amazon Rekognition. De exemplu, dacă intenționați să moderați imaginile încărcate de utilizatori, puteți lua imagini de utilizator pentru o săptămână pentru test. Vă recomandăm să alegeți un set care are suficiente imagini fără a deveni prea mare pentru a fi procesat (cum ar fi 1,000–10,000 de imagini), deși seturile mai mari sunt mai bune.

- Definiție – Utilizați regulile de conținut ale aplicației dvs. pentru a decide ce tipuri de conținut nesigur sunteți interesat să detectați din Amazon Rekognition taxonomia conceptelor de moderare. De exemplu, s-ar putea să fiți interesat să detectați toate tipurile de nuditate explicită și violență grafică sau sânge.

- adnotare – Acum aveți nevoie de un adevăr de teren generat de oameni pentru setul dvs. de testare, folosind etichetele alese, astfel încât să puteți compara predicțiile mașinii cu acestea. Aceasta înseamnă că fiecare imagine este adnotată pentru prezența sau absența conceptelor alese. Pentru a adnota datele imaginii, puteți utiliza Amazon SageMaker Ground Adevăr (GT) pentru a gestiona adnotarea imaginii. Vă puteți referi la GT pentru etichetarea imaginilor, consolidarea adnotărilor și procesarea ieșirii adnotărilor.

Obțineți predicții pentru setul de date de testare cu Amazon Rekognition

În continuare, doriți să obțineți predicții pentru setul de date de testare.

Primul pas este să decideți asupra unui scor minim de încredere (o valoare de prag, cum ar fi 50%) la care doriți să măsurați rezultatele. Pragul nostru prestabilit este setat la 50, ceea ce oferă un echilibru bun între recuperarea unor cantități mari de conținut nesigur fără a genera prea multe predicții false privind conținutul sigur. Cu toate acestea, platforma dvs. poate avea nevoi de afaceri diferite, așa că ar trebui să personalizați acest prag de încredere după cum este necesar. Puteți folosi MinConfidence parametrul din solicitările dvs. API pentru a echilibra detectarea conținutului (rechemare) și acuratețea detectării (precizia). Daca reduceti MinConfidence, este posibil să detectați cea mai mare parte a conținutului neadecvat, dar este posibil să preluați și conținut care nu este de fapt inadecvat. Dacă creșteți MinConfidence este posibil să vă asigurați că tot conținutul detectat este cu adevărat inadecvat, dar este posibil ca unele conținuturi să nu fie etichetate. Vă sugerăm să experimentați cu câteva MinConfidence valorile din setul dvs. de date și selectați cantitativ cea mai bună valoare pentru domeniul dvs. de date.

Apoi, rulați fiecare probă (imagine sau videoclip) din setul dvs. de testare prin API-ul de moderare Amazon Rekognition (DetectModerationLabels).

Măsurați acuratețea modelului pe imagini

Puteți evalua acuratețea unui model comparând adnotările de adevăr la sol generate de oameni cu predicțiile modelului. Repetați această comparație pentru fiecare imagine în mod independent și apoi agregați pe întregul set de testare:

- Rezultate pe imagine – O predicție de model este definită ca pereche

{label_name, confidence_score}(unde scorul de încredere >= pragul selectat mai devreme). Pentru fiecare imagine, o predicție este considerată corectă atunci când se potrivește cu adevărul de la sol (GT). O predicție este una dintre următoarele opțiuni:- Adevărat pozitiv (TP): atât predicția, cât și GT sunt „nesigure”

- Adevărat negativ (TN): atât predicția, cât și GT sunt „sigure”

- Fals pozitiv (FP): predicția spune „nesigur”, dar GT este „sigur”

- fals negativ (FN): predicția este „sigură”, dar GT este „nesigură”

- Rezultate agregate pentru toate imaginile – În continuare, puteți agrega aceste predicții în rezultate la nivel de set de date:

- Rata fals pozitive (FPR) – Acesta este procentul de imagini din setul de testare care sunt marcate greșit de către model ca având conținut nesigur: (FP): FP / (TN+FP).

- Rata fals negativă (FNR) – Acesta este procentul de imagini nesigure din setul de testare care sunt ratate de model: (FN): FN / (FN+TP).

- Rata adevărată pozitivă (TPR) – Denumită și rechemare, aceasta calculează procentul de conținut nesigur (adevărul de bază) care este corect descoperit sau prezis de model: TP / (TP + FN) = 1 – FNR.

- Precizie – Aceasta calculează procentul de predicții corecte (conținut nesigur) în raport cu numărul total de predicții făcute: TP / (TP+FP).

Să explorăm un exemplu. Să presupunem că setul dvs. de testare conține 10,000 de imagini: 9,950 sigure și 50 nesigure. Modelul prezice corect 9,800 din 9,950 de imagini ca fiind sigure și 45 din 50 ca nesigure:

- TP = 45

- TN = 9800

- FP = 9950 - 9800 = 150

- FN = 50 - 45 = 5

- RPF = 150 / (9950 + 150) = 0.015 = 1.5%

- FNR = 5 / (5 + 45) = 0.1 = 10%

- TPR/Rechemare = 45 / (45 + 5) = 0.9 = 90%

- Precizie = 45 / (45 + 150) = 0.23 = 23%

Măsurați acuratețea modelului pe videoclipuri

Dacă doriți să evaluați performanța pe videoclipuri, sunt necesari câțiva pași suplimentari:

- Eșantionați un subset de cadre din fiecare videoclip. Vă sugerăm eșantionarea uniformă cu o rată de 0.3–1 cadre pe secundă (fps). De exemplu, dacă un videoclip este codificat la 24 fps și doriți să eșantionați un cadru la fiecare 3 secunde (0.3 fps), trebuie să selectați unul la fiecare 72 de cadre.

- Rulați aceste cadre eșantionate prin moderarea conținutului Amazon Rekognition. Puteți fie să utilizați API-ul nostru video, care eșantionează deja cadre pentru dvs. (la o rată de 3 fps), fie să utilizați API-ul pentru imagini, caz în care doriți să eșantionați mai puțin. Vă recomandăm ultima variantă, având în vedere redundanța informațiilor din videoclipuri (cadrele consecutive sunt foarte asemănătoare).

- Calculați rezultatele per cadru așa cum s-a explicat în secțiunea anterioară (rezultate per imagine).

- Rezultate agregate pe întregul set de teste. Aici aveți două opțiuni, în funcție de tipul de rezultat care contează pentru afacerea dvs.:

- Rezultate la nivel de cadru – Aceasta consideră toate cadrele eșantionate ca imagini independente și agregează rezultatele exact așa cum sa explicat mai devreme pentru imagini (FPR, FNR, recall, precizie). Dacă unele videoclipuri sunt considerabil mai lungi decât altele, ele vor contribui cu mai multe cadre la numărul total, făcând comparația dezechilibrată. În acest caz, vă sugerăm să schimbați strategia de eșantionare inițială la un număr fix de cadre pe videoclip. De exemplu, puteți eșantiona uniform 50-100 de cadre pe videoclip (presupunând că videoclipurile durează cel puțin 2-3 minute).

- Rezultate la nivel video – Pentru unele cazuri de utilizare, nu contează dacă modelul este capabil să prezică corect 50% sau 99% din cadrele dintr-un videoclip. Chiar și o singură predicție greșită și nesigură pe un singur cadru ar putea declanșa o evaluare umană în aval și numai videoclipurile cu predicții 100% corecte sunt considerate cu adevărat corect. Dacă acesta este cazul dvs. de utilizare, vă sugerăm să calculați FPR/FNR/TPR pe cadrele fiecărui videoclip și să luați în considerare videoclipul după cum urmează:

| ID video | Acuratete | Categorizare per-video |

| Rezultate agregate pe toate cadrele ID-ului video |

FP total = 0 FN total = 0 |

Previziuni perfecte |

| . | FP totală > 0 | fals pozitiv (FP) |

| . | FN total > 0 | fals negativ (FN) |

După ce le-ați calculat pentru fiecare videoclip independent, puteți calcula apoi toate valorile pe care le-am introdus mai devreme:

- Procentul de videoclipuri semnalate greșit (FP) sau ratate (FN)

- Precizie și rechemare

Măsurați performanța față de obiective

În cele din urmă, trebuie să interpretați aceste rezultate în contextul obiectivelor și capacităților dvs.

În primul rând, luați în considerare nevoile dvs. de afaceri în ceea ce privește următoarele:

- Date – Aflați despre datele dvs. (volumul zilnic, tipul de date și așa mai departe) și despre distribuția conținutului dvs. nesigur față de conținut sigur. De exemplu, este echilibrat (50/50), denaturat (10/90) sau foarte deformat (1/99, ceea ce înseamnă că doar 1% este nesigur)? Înțelegerea unei astfel de distribuții vă poate ajuta să vă definiți obiectivele reale ale valorii. De exemplu, numărul de conținut sigur este adesea cu un ordin de mărime mai mare decât conținutul nesigur (foarte denaturat), ceea ce face ca aceasta să fie aproape o problemă de detectare a anomaliilor. În acest scenariu, numărul de pozitive false poate depăși numărul de pozitive adevărate și puteți utiliza informațiile despre date (distribuirea asimetrică, volumul de date și așa mai departe) pentru a decide FPR cu care puteți lucra.

- Obiective metrice – Care sunt cele mai critice aspecte ale afacerii tale? Scăderea FPR vine adesea cu prețul unui FNR mai mare (și invers) și este important să găsiți echilibrul potrivit care să funcționeze pentru dvs. Dacă nu puteți pierde niciun conținut nesigur, probabil că doriți aproape 0% FNR (reamintire 100%). Cu toate acestea, acest lucru va genera cel mai mare număr de fals pozitive și trebuie să decideți FPR-ul țintă (maximum) cu care puteți lucra, pe baza conductei dvs. post-predicții. Este posibil să doriți să permiteți un anumit nivel de fals negative pentru a putea găsi un echilibru mai bun și a vă reduce FPR: de exemplu, acceptarea unui FNR de 5% în loc de 0% ar putea reduce FPR de la 2% la 0.5%, reducând considerabil numărul a conținutului semnalizat.

Apoi, întrebați-vă ce mecanisme veți folosi pentru a analiza imaginile semnalizate. Chiar dacă este posibil ca API-urile să nu ofere 0% FPR și FNR, pot aduce în continuare economii și scară uriașe (de exemplu, semnalând doar 3% din imagini, ați filtrat deja 97% din conținut). Când asociați API-ul cu unele mecanisme din aval, cum ar fi forța de muncă umană care examinează conținutul semnalat, vă puteți atinge cu ușurință obiectivele (de exemplu, conținut semnalat 0.5%). Rețineți că această asociere este considerabil mai ieftină decât a trebui să faceți o evaluare umană a 100% din conținutul dvs.

După ce v-ați decis asupra mecanismelor dvs. din aval, vă sugerăm să evaluați debitul pe care îl puteți suporta. De exemplu, dacă aveți o forță de muncă care poate verifica doar 2% din conținutul dvs. zilnic, atunci obiectivul dvs. țintă din API-ul nostru de moderare a conținutului este o rată standard (FPR+TPR) de 2%.

În cele din urmă, dacă obținerea de adnotări de adevăr la sol este prea dificilă sau prea costisitoare (de exemplu, volumul de date este prea mare), vă sugerăm să adnotați numărul mic de imagini semnalate de API. Deși acest lucru nu permite evaluări FNR (deoarece datele dvs. nu conțin niciun negativ fals), puteți măsura TPR și FPR.

În secțiunea următoare, oferim o soluție pentru evaluarea moderării imaginii. Puteți adopta o abordare similară pentru evaluarea moderării videoclipurilor.

Prezentare generală a soluțiilor

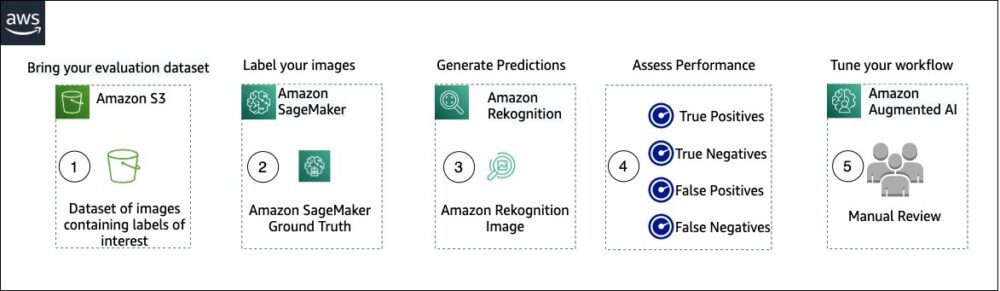

Următoarea diagramă ilustrează diferitele servicii AWS pe care le puteți utiliza pentru a evalua performanța moderării conținutului Amazon Rekognition pe setul de date de testare.

Evaluarea moderării conținutului are următorii pași:

- Încărcați setul de date de evaluare în Serviciul Amazon de stocare simplă (Amazon S3).

- Utilizați Ground Truth pentru a atribui etichete de moderare a adevărului de teren.

- Generați etichetele de moderare estimate utilizând API-ul de moderare pre-antrenat Amazon Rekognition folosind câteva valori de prag. (De exemplu, 70%, 75% și 80%).

- Evaluați performanța pentru fiecare prag calculând adevăratele pozitive, adevărate negative, false pozitive și false negative. Determinați valoarea pragului optim pentru cazul dvs. de utilizare.

- Opțional, puteți personaliza dimensiunea forței de muncă pe baza rezultatelor pozitive adevărate și false și a utilizării AI augmentată Amazon (Amazon A2I) pentru a trimite automat tot conținutul semnalat forței de muncă desemnate pentru o examinare manuală.

Următoarele secțiuni oferă fragmente de cod pentru pașii 1, 2 și 3. Pentru codul sursă complet de la capăt la capăt, consultați documentul furnizat. Caiet Jupyter.

Cerințe preliminare

Înainte de a începe, parcurgeți următorii pași pentru a configura notebook-ul Jupyter:

- Creați o instanță de notebook in Amazon SageMaker.

- Când notebook-ul este activ, alegeți Deschideți Jupyter.

- Pe tabloul de bord Jupyter, alegeți Nouși alegeți Terminal.

- În terminal, introduceți următorul cod:

- Deschide caietul pentru această postare:

content-moderation-evaluation/Evaluating-Amazon-Rekognition-Content-Moderation-Service.ipynb. - Încărcați setul de date de evaluare în Serviciul Amazon de stocare simplă (Amazon S3).

Acum vom parcurge pașii de la 2 la 4 din blocnotesul Jupyter.

Utilizați Ground Truth pentru a atribui etichete de moderare

Pentru a atribui etichete în Ground Truth, parcurgeți următorii pași:

- Creați un fișier de intrare manifest pentru jobul dvs. Ground Truth și încărcați-l pe Amazon S3.

- Creați configurația de etichetare, care conține toate etichetele de moderare necesare pentru lucrarea de etichetare Ground Truth. Pentru a verifica limita pentru numărul de categorii de etichete pe care le puteți utiliza, consultați Etichetați Cotele de categorii. În următorul fragment de cod, folosim cinci etichete (consultați taxonomie ierarhică utilizată în Amazon Rekognition pentru mai multe detalii) plus o etichetă (

Safe_Content) care marchează conținutul ca sigur: - Creați un șablon de sarcină personalizat pentru a oferi forței de muncă Ground Truth instrucțiuni de etichetare și încărcați-l pe Amazon S3.

Lucrarea de etichetare Ground Truth este definită ca o sarcină de clasificare a imaginii (multi-etichete). Consultați codul sursă pentru instrucțiuni de personalizare a șablonului de instrucțiuni. - Decideți ce forță de muncă doriți să folosiți pentru a finaliza jobul Ground Truth. Aveți două opțiuni (consultați codul sursă pentru detalii):

- Folosi forța de muncă privată în propria organizație pentru a eticheta setul de date de evaluare.

- Folosi forta de munca publica pentru a eticheta setul de date de evaluare.

- Creați și trimiteți un job de etichetare Ground Truth. De asemenea, puteți ajusta următorul cod pentru a configura etichetarea parametrilor jobului pentru a satisface cerințele dvs. specifice de afaceri. Consultați codul sursă pentru instrucțiuni complete despre crearea și configurarea jobului Ground Truth.

După ce jobul este trimis, ar trebui să vedeți rezultate similare cu următoarea:

Așteptați finalizarea cu succes a sarcinii de etichetare pe setul de date de evaluare, apoi continuați cu pasul următor.

Utilizați API-ul de moderare Amazon Rekognition pentru a genera etichete de moderare estimate.

Următorul fragment de cod arată cum să utilizați Amazon Rekognition API de moderare pentru a genera etichete de moderare:

Evaluați performanța

Mai întâi ați preluat etichetele de moderare a adevărului la sol din rezultatele jobului de etichetare Ground Truth pentru setul de date de evaluare, apoi ați rulat API-ul de moderare Amazon Rekognition pentru a obține etichete de moderare estimate pentru același set de date. Deoarece aceasta este o problemă de clasificare binară (conținut sigur vs. nesigur), calculăm următoarele valori (presupunând că conținutul nesigur este pozitiv):

De asemenea, calculăm metricile de evaluare corespunzătoare:

Următorul fragment de cod arată cum se calculează acele valori:

Concluzie

Această postare discută elementele cheie necesare pentru a evalua aspectul de performanță al serviciului dvs. de moderare a conținutului în ceea ce privește diferitele valori de precizie. Cu toate acestea, acuratețea este doar una dintre numeroasele dimensiuni pe care trebuie să le evaluați atunci când alegeți un anumit serviciu de moderare a conținutului. Este esențial să includeți alți parametri, cum ar fi setul total de caracteristici ale serviciului, ușurința de utilizare, integrările existente, confidențialitate și securitate, opțiuni de personalizare, implicații de scalabilitate, serviciu pentru clienți și prețuri. Pentru a afla mai multe despre moderarea conținutului în Amazon Rekognition, vizitați Moderare de conținut Amazon Rekognition.

Despre autori

Amit Gupta este arhitect senior de soluții de servicii AI la AWS. Este pasionat de a oferi clienților soluții de învățare automată bine proiectate la scară.

Amit Gupta este arhitect senior de soluții de servicii AI la AWS. Este pasionat de a oferi clienților soluții de învățare automată bine proiectate la scară.

Davide Modolo este manager de știință aplicată la AWS AI Labs. El are un doctorat în viziune computerizată la Universitatea din Edinburgh (Marea Britanie) și este pasionat de dezvoltarea de noi soluții științifice pentru problemele clienților din lumea reală. În afara serviciului, îi place să călătorească și să joace orice fel de sport, în special fotbal.

Davide Modolo este manager de știință aplicată la AWS AI Labs. El are un doctorat în viziune computerizată la Universitatea din Edinburgh (Marea Britanie) și este pasionat de dezvoltarea de noi soluții științifice pentru problemele clienților din lumea reală. În afara serviciului, îi place să călătorească și să joace orice fel de sport, în special fotbal.

Jian Wu este arhitect senior de soluții pentru întreprinderi la AWS. Lucrează la AWS de 6 ani, lucrând cu clienți de toate dimensiunile. El este pasionat de a ajuta clienții să inoveze mai rapid prin adoptarea Cloud-ului și AI/ML. Înainte de a se alătura AWS, Jian a petrecut peste 10 ani concentrându-se pe dezvoltarea de software, implementarea sistemului și gestionarea infrastructurii. În afară de muncă, îi place să rămână activ și să petreacă timp cu familia sa.

Jian Wu este arhitect senior de soluții pentru întreprinderi la AWS. Lucrează la AWS de 6 ani, lucrând cu clienți de toate dimensiunile. El este pasionat de a ajuta clienții să inoveze mai rapid prin adoptarea Cloud-ului și AI/ML. Înainte de a se alătura AWS, Jian a petrecut peste 10 ani concentrându-se pe dezvoltarea de software, implementarea sistemului și gestionarea infrastructurii. În afară de muncă, îi place să rămână activ și să petreacă timp cu familia sa.

- Avansat (300)

- AI

- ai art

- ai art generator

- ai robot

- Amazon Rekognition

- inteligență artificială

- certificare de inteligență artificială

- inteligența artificială în domeniul bancar

- robot cu inteligență artificială

- roboți cu inteligență artificială

- software de inteligență artificială

- Învățare automată AWS

- blockchain

- conferință blockchain ai

- coingenius

- inteligența artificială conversațională

- criptoconferință ai

- dall-e

- învățare profundă

- google ai

- masina de învățare

- Plato

- platoul ai

- Informații despre date Platon

- Jocul lui Platon

- PlatoData

- platogaming

- scara ai

- sintaxă

- zephyrnet