Introducere

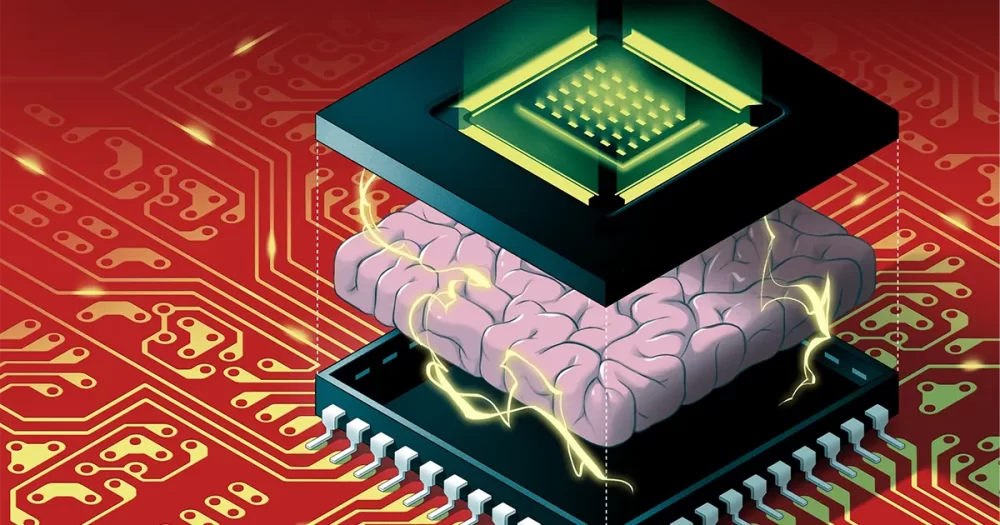

Algoritmii de inteligență artificială nu pot continua să crească în ritmul lor actual. Algoritmi precum rețelele neuronale profunde – care sunt inspirate de creier, cu mai multe straturi de neuroni artificiali legați între ei prin valori numerice numite greutăți – devin mai mari în fiecare an. Dar în zilele noastre, îmbunătățirile hardware nu mai țin pasul cu cantitatea enormă de memorie și capacitatea de procesare necesare pentru a rula acești algoritmi masivi. În curând, dimensiunea algoritmilor AI poate lovi un zid.

Și chiar dacă am putea continua să extindem hardware-ul pentru a satisface cerințele AI, există o altă problemă: rularea lor pe computere tradiționale irosește o cantitate enormă de energie. Emisiile mari de carbon generate de rularea unor algoritmi mari de inteligență artificială sunt deja dăunătoare pentru mediu și se vor înrăutăți pe măsură ce algoritmii devin din ce în ce mai gigantici.

O soluție, numită calcul neuromorfic, se inspiră din creierul biologic pentru a crea modele eficiente din punct de vedere energetic. Din păcate, în timp ce aceste cipuri pot depăși calculatoarele digitale în conservarea energiei, le-a lipsit puterea de calcul necesară pentru a rula o rețea neuronală profundă considerabilă. Acest lucru le-a făcut ușor de trecut cu vederea de către cercetătorii AI.

Asta s-a schimbat în sfârșit în august, când Weier Wan, H.-S. Philip Wong, Gert Cauwenberghs si colegii lor a dezvăluit un nou cip neuromorf numit NeuRRAM, care include 3 milioane de celule de memorie și mii de neuroni încorporați în hardware-ul său pentru a rula algoritmi. Utilizează un tip relativ nou de memorie numit RAM rezistiv sau RRAM. Spre deosebire de cipurile RRAM anterioare, NeuRRAM este programat să funcționeze într-o manieră analogică pentru a economisi mai multă energie și spațiu. În timp ce memoria digitală este binară - stochează fie un 1, fie un 0 - celulele de memorie analogice în cipul NeuRRAM pot stoca fiecare mai multe valori de-a lungul unui interval complet continuu. Acest lucru permite cipului să stocheze mai multe informații de la algoritmi AI masivi în aceeași cantitate de spațiu pentru cip.

Drept urmare, noul cip poate funcționa la fel de bine ca computerele digitale în sarcini complexe de IA, cum ar fi recunoașterea imaginilor și a vorbirii, iar autorii susțin că este de până la 1,000 de ori mai eficient din punct de vedere energetic, deschizând posibilitatea ca cipurile mici să ruleze algoritmi din ce în ce mai complicati. în dispozitive mici, anterior nepotrivite pentru AI, cum ar fi ceasurile și telefoanele inteligente.

Cercetătorii care nu sunt implicați în muncă au fost profund impresionați de rezultate. „Această lucrare este destul de unică”, a spus Zhongrui Wang, un cercetător RRAM de lungă durată la Universitatea din Hong Kong. „Aduce contribuții la diferite niveluri – la nivel de dispozitiv, la nivel de arhitectură de circuit și la nivel de algoritm.”

Crearea de noi amintiri

În calculatoarele digitale, cantitățile uriașe de energie risipite în timp ce rulează algoritmi AI este cauzată de o defecțiune simplă și omniprezentă de proiectare care face ca fiecare calcul să fie ineficient. De obicei, memoria unui computer - care deține datele și valorile numerice pe care le strânge în timpul calculului - este plasată pe placa de bază departe de procesor, unde are loc calculul.

Pentru informațiile care circulă prin procesor, „este ca și cum ai petrece opt ore pe navetă, dar faci două ore de muncă”, a spus Wan, un informatician de la Universitatea Stanford, care sa mutat recent la startup-ul AI Aizip.

Introducere

Remedierea acestei probleme cu noi cipuri all-in-one care pun memoria și calculul în același loc pare simplă. Este, de asemenea, mai aproape de modul în care creierul nostru procesează probabil informațiile, deoarece mulți neurologi cred că calculul are loc în cadrul populațiilor de neuroni, în timp ce amintirile se formează atunci când sinapsele dintre neuroni le întăresc sau slăbesc conexiunile. Dar crearea unor astfel de dispozitive s-a dovedit dificilă, deoarece formele actuale de memorie sunt incompatibile cu tehnologia procesoarelor.

Oamenii de știință în domeniul informaticii au dezvoltat cu decenii în urmă materialele pentru a crea noi cipuri care efectuează calcule acolo unde este stocată memoria - o tehnologie cunoscută sub numele de calcul în memorie. Dar, având în vedere că computerele digitale tradiționale funcționează atât de bine, aceste idei au fost trecute cu vederea timp de decenii.

„Această lucrare, la fel ca majoritatea lucrărilor științifice, a fost oarecum uitată”, a spus Wong, profesor la Stanford.

Într-adevăr, primul astfel de dispozitiv datează cel puțin din 1964, când inginerii electrici de la Stanford au descoperit că pot manipula anumite materiale, numite oxizi de metal, pentru a-și activa și opri capacitatea de a conduce electricitatea. Acest lucru este semnificativ deoarece capacitatea unui material de a comuta între două stări oferă coloana vertebrală pentru stocarea tradițională a memoriei. De obicei, în memoria digitală, o stare de tensiune înaltă corespunde unui 1, iar tensiunea joasă unui 0.

Pentru a face ca un dispozitiv RRAM să schimbe stările, aplicați o tensiune pe electrozii metalici conectați la două capete ale oxidului de metal. În mod normal, oxizii metalici sunt izolatori, ceea ce înseamnă că nu conduc electricitatea. Dar cu suficientă tensiune, curentul se acumulează, împingând în cele din urmă prin punctele slabe ale materialului și formând o cale către electrodul de pe cealaltă parte. Odată ce curentul a pătruns, poate curge liber pe acea cale.

Wong aseamănă acest proces cu fulgerul: când se acumulează suficientă încărcare în interiorul unui nor, acesta găsește rapid o cale cu rezistență scăzută și fulgeră lovește. Dar, spre deosebire de fulger, a cărui cale dispare, calea prin oxidul de metal rămâne, ceea ce înseamnă că rămâne conducător la nesfârșit. Și este posibil să ștergeți calea conductivă aplicând o altă tensiune materialului. Astfel, cercetătorii pot comuta o RRAM între două stări și le pot folosi pentru a stoca memorie digitală.

Cercetătorii de la mijlocul secolului nu au recunoscut potențialul de calcul eficient din punct de vedere energetic și nici nu aveau nevoie de el încă cu algoritmii mai mici cu care lucrau. A fost nevoie până la începutul anilor 2000, odată cu descoperirea de noi oxizi de metal, pentru ca cercetătorii să realizeze posibilitățile.

Wong, care lucra la IBM la acea vreme, își amintește că un coleg premiat care lucra la RRAM a recunoscut că nu înțelegea pe deplin fizica implicată. „Dacă nu înțelege”, își amintește Wong că s-a gândit, „poate că nu ar trebui să încerc să înțeleg.”

Dar în 2004, cercetătorii de la Samsung Electronics au anunțat că au făcut-o memorie RRAM integrată cu succes construit pe un cip de calcul tradițional, sugerând că un cip de calcul în memorie ar putea fi în sfârșit posibil. Wong s-a hotărât să încerce măcar.

Chipuri de calcul în memorie pentru AI

Timp de mai bine de un deceniu, cercetători precum Wong au lucrat pentru a construi tehnologia RRAM până la punctul în care să poată gestiona în mod fiabil sarcinile de calcul de mare putere. În jurul anului 2015, informaticienii au început să recunoască potențialul enorm al acestor dispozitive eficiente din punct de vedere energetic pentru algoritmi mari de IA, care începeau să descopere. În acel an, oamenii de știință de la Universitatea din California, Santa Barbara a arătat că dispozitivele RRAM ar putea face mai mult decât să stocheze memoria într-un mod nou. Ei ar putea executa ei înșiși sarcini de calcul de bază - inclusiv marea majoritate a calculelor care au loc în neuronii artificiali ai unei rețele neuronale, care sunt sarcini simple de multiplicare a matricei.

În cipul NeuRRAM, neuronii de siliciu sunt încorporați în hardware, iar celulele de memorie RRAM stochează greutățile - valorile reprezentând puterea conexiunilor dintre neuroni. Și deoarece celulele de memorie NeuRRAM sunt analogice, greutățile pe care le stochează reprezintă întreaga gamă de stări de rezistență care apar în timp ce dispozitivul comută între o stare de rezistență scăzută la o stare de rezistență ridicată. Acest lucru permite o eficiență energetică chiar mai mare decât o poate obține memoria RRAM digitală, deoarece cipul poate rula multe calcule matrice în paralel - mai degrabă decât în pas una după alta, ca în versiunile de procesare digitală.

Dar, deoarece procesarea analogică este încă cu zeci de ani în urmă procesării digitale, există încă multe probleme de rezolvat. Unul este că cipurile RRAM analogice trebuie să fie neobișnuit de precise, deoarece imperfecțiunile cipului fizic pot introduce variabilitate și zgomot. (Pentru cipurile tradiționale, cu doar două stări, aceste imperfecțiuni nu contează la fel de mult.) Acest lucru face mult mai greu pentru dispozitivele analogice RRAM să ruleze algoritmi AI, având în vedere că acuratețea, de exemplu, recunoașterea unei imagini va avea de suferit dacă starea conductivă a dispozitivului RRAM nu este exact aceeași de fiecare dată.

„Când ne uităm la o cale de iluminare, de fiecare dată este diferit”, a spus Wong. „Prin urmare, RRAM-ul prezintă un anumit grad de stocasticitate – de fiecare dată când le programați este ușor diferit.” Wong și colegii săi au demonstrat că dispozitivele RRAM pot stoca continuu greutăți AI și pot fi totuși la fel de precise ca computerele digitale dacă algoritmii sunt antrenați să se obișnuiască cu zgomotul pe care îl întâlnesc pe cip, un avans care le-a permis să producă cipul NeuRRAM.

Introducere

O altă problemă majoră pe care au trebuit să o rezolve a implicat flexibilitatea necesară pentru a susține diverse rețele neuronale. În trecut, designerii de cipuri trebuiau să alinieze micile dispozitive RRAM într-o zonă lângă neuronii de siliciu mai mari. Dispozitivele RRAM și neuronii au fost conectați fără programabilitate, astfel încât calculul a putut fi efectuat doar într-o singură direcție. Pentru a susține rețelele neuronale cu calcul bidirecțional, au fost necesare fire și circuite suplimentare, umfland nevoile de energie și spațiu.

Deci, echipa lui Wong a proiectat o nouă arhitectură de cip în care dispozitivele de memorie RRAM și neuronii de siliciu au fost amestecate împreună. Această mică modificare a designului a redus suprafața totală și a economisit energie.

„Am crezut că [aranjamentul] a fost cu adevărat frumos”, a spus Melika Payvand, cercetător neuromorf la Institutul Federal Elvețian de Tehnologie din Zurich. „Cu siguranță o consider o lucrare revoluționară.”

Timp de câțiva ani, echipa lui Wong a lucrat cu colaboratori pentru a proiecta, produce, testa, calibra și rula algoritmi AI pe cipul NeuRRAM. Au luat în considerare utilizarea altor tipuri de memorie emergente care pot fi utilizate și într-un cip de calcul în memorie, dar RRAM a avut un avantaj datorită avantajelor sale în programarea analogică și pentru că era relativ ușor de integrat cu materialele de calcul tradiționale.

Rezultatele lor recente reprezintă primul cip RRAM care poate rula algoritmi AI atât de mari și complecși – o performanță care anterior a fost posibilă doar în simulările teoretice. „Când vine vorba de siliciu real, această capacitate lipsea”, a spus Anup Das, un informatician la Universitatea Drexel. „Această lucrare este prima demonstrație.”

„Sistemele digitale AI sunt flexibile și precise, dar ordine de mărime mai puțin eficiente”, a spus Cauwenberghs. Acum, a spus Cauwenberghs, cipul lor RRAM analogic flexibil, precis și eficient din punct de vedere energetic a „combătut decalajul pentru prima dată”.

Scalare sus

Designul echipei menține cipul NeuRRAM mic - doar de dimensiunea unei unghii - în timp ce stoarce 3 milioane de dispozitive de memorie RRAM care pot servi ca procesoare analogice. Și în timp ce poate rula rețele neuronale cel puțin la fel de bine ca și computerele digitale, cipul poate rula de asemenea (și pentru prima dată) algoritmi care efectuează calcule în direcții diferite. Cipul lor poate introduce o tensiune în rândurile matricei RRAM și poate citi ieșirile din coloane, așa cum este standard pentru cipurile RRAM, dar o poate face și înapoi de la coloane la rânduri, astfel încât poate fi utilizat în rețelele neuronale care funcționează. cu date care circulă în direcții diferite.

Ca și în cazul tehnologiei RRAM în sine, acest lucru a fost posibil de mult timp, dar nimeni nu s-a gândit să o facă. „De ce nu ne-am gândit la asta înainte?” întrebă Payvand. „În retrospectivă, nu știu.”

„Acest lucru deschide de fapt o mulțime de alte oportunități”, a spus Das. Ca exemple, el a menționat capacitatea unui sistem simplu de a rula algoritmii enormi necesari pentru simulările fizice multidimensionale sau mașinile autonome.

Cu toate acestea, dimensiunea este o problemă. Cele mai mari rețele neuronale conțin acum miliarde de greutăți, nu milioanele conținute de noile cipuri. Wong plănuiește să crească prin stivuirea mai multor cipuri NeuRRAM unul peste altul.

Va fi la fel de important să menținem costurile energetice scăzute în dispozitivele viitoare sau să le reduceți și mai mult. O modalitate de a ajunge acolo este prin copierea creierului cu atât mai îndeaproape pentru a adopta semnalul de comunicare folosit între neuroni reali: vârful electric. Este un semnal transmis de la un neuron la altul atunci când diferența de tensiune dintre interiorul și exteriorul celulei atinge un prag critic.

„Există provocări mari acolo”, a spus Tony Kenyon, cercetător în nanotehnologie la University College London. „Dar s-ar putea să vrem totuși să ne mișcăm în acea direcție, pentru că... șansele sunt ca veți avea o eficiență energetică mai mare dacă folosiți vârfuri foarte rare.” Totuși, pentru a rula algoritmi care se ridică pe actualul cip NeuRRAM ar necesita o arhitectură total diferită, a remarcat Kenyon.

Deocamdată, eficiența energetică realizată de echipa în timp ce rula algoritmi mari de IA pe cipul NeuRRAM a creat o nouă speranță că tehnologiile de memorie ar putea reprezenta viitorul calculului cu AI. Poate într-o zi vom reuși chiar să egalăm cele 86 de miliarde de neuroni ai creierului uman și trilioanele de sinapse care îi conectează fără a rămâne fără energie.