Da.. Vorbesc despre aplicațiile AI – nenumăratele noastre aplicații AI și despre cele viitoare care șoptesc oamenilor despre ce să facă... cum să o faci... dar nu despre șoptitorii care interacționează cu chatboții AI.

În conformitate cu IDC predicțiile, piața globală de AI ar putea ajunge la peste 500 de miliarde de dolari până în 2024 – o creștere de peste 50% față de 2021. Acest lucru indică faptul că am trecut de la experimentele de afaceri la acceptarea faptului că este o parte integrantă a strategiei întreprinderii pentru toate dimensiunile. Este un instrument necesar pentru a transforma datele în perspective pentru a declanșa acțiuni bazate pe decizii mai bune. Nimeni nu dezbate beneficiile AI pentru a reduce riscul de afaceri și pentru a amplifica rentabilitatea investiției prin inovație. Dar, ca întotdeauna, există un...DAR... IA imparțială este mai ușor de spus decât de făcut.

Esențiale pentru afacere, aceste modele AI trebuie să funcționeze în mod fiabil, cu vizibilitate și responsabilitate. În caz contrar, eșecul, în acest caz, are consecințe grave care afectează fluxul de numerar al oricărei companii și ar putea duce chiar la chestiuni legale. Singura modalitate de a evita acest lucru este automatizarea și transparența pentru a răspunde la o întrebare „Poți dovedi că această aplicație/sarcina de lucru AI este construită în mod etic”. Aka... cum guvernezi? Și poți dovedi că este guvernat continuu?

Aici le place companiilor IBM au investit în guvernarea AI pentru a orchestra procesul general de direcționare, gestionare și monitorizare a activităților AI ale organizației. Sarcina principală este să se asigure că toate unitățile de afaceri rămân proactive și infuzează cadrul de guvernanță în inițiativele de consolidare a capacității de a respecta principiile și reglementările etice. În special, industriile reglementate, cum ar fi serviciile bancare și cele financiare, sunt obligate prin lege să furnizeze dovezi pentru a satisface autoritățile de reglementare.

Influența inteligenței artificiale crește exponențial în sectorul serviciilor financiare din cauza presiunii extraordinare a transformării digitale. După cum s-a spus, este mai ușor de spus decât de făcut, deoarece:

1. Operaționalizați cu încredere aplicațiile AI:

În unele cazuri, modelele sunt construite fără claritate și catalogare; Inutil să spunem, monitorizarea scapă în mijlocul tuturor pentru a urmări ciclul de viață de la capăt la capăt. În timp ce băncile se luptă cu aplicațiile vechi, automatizarea proceselor pentru a crea transparență și explicabilitate a devenit mai dificilă și, la rândul său, o cutie neagră. Nimeni nu știe de ce/cum s-au luat deciziile. Noile aplicații încurcate cu aplicațiile vechi nu văd niciodată lumina zilei, deși un ROI uriaș este asociat cu aceasta din cauza calității și a riscurilor nepercepute.

Asta ne duce la al doilea punct – gestionarea riscului de reputație

2. Gestionați riscul reputațional împreună cu riscul general

am întrebat #chatGPT și #Bard – care este Padma Chukka. #ChatGPT a refuzat să răspund chiar dacă am schimbat întrebarea în mai multe moduri. Totuși, Bard mi-a dat un răspuns detaliat, inclusiv profilul meu LinkedIn... dar datele provin de la diverse site-uri unde profilul meu vechi încă există ca parte a bios-ului difuzorului. Din acel moment, încă nu am deschis Bardul. Așa repede, am fost oprit, alias – Riscul de reputație. Să presupunem că pot dezactiva un chatbot simplu când îmi dau seama că datele ar putea fi inconsecvente. Cum aș putea să nu mă asigur înainte de a decide să cumpăr o aplicație bazată pe inteligență artificială pentru a desfășura afaceri critice? Riscul de reputație este un factor esențial pe care uneori companiile îl uită. Dacă cuantificați riscul reputațional, se poate vedea impactul extraordinar asupra afacerii dacă nu este proactiv.

Pentru a spori complexitatea, al treilea este...

3. Cum poate răspunde o companie la schimbarea reglementărilor AI?

Pentru a evita riscul de reputație, o echipă AI de succes și responsabilă ar trebui să fie conștientă de fiecare reglementare locală și globală, scăzând ca un videoclip tic-tac cu un preaviz. Iar nerespectarea poate costa o organizație în cele din urmă milioane de dolari în amenzi în legătură cu lucrările, cum ar fi Actul AI al UE propus. Ar putea fi până la 30 de milioane de euro sau 6% din veniturile globale ale companiei – OUCH.

Ei bine, nu totul trebuie să fie roz de la început... atâta timp cât știm cum să transformăm o situație înfricoșătoare într-o situație roz.

Fără surpriză... sunt întotdeauna oameni, proces și tehnologie. Deci, mai întâi, creați un organism de conducere interfuncțional pentru a educa, a direcționa și a monitoriza inițiativele bazate pe obiective. Apoi, comparați tehnologia și procesele actuale de AI, înțelegeți lacunele, apoi remediați pentru a obține dovezi viitoare. Apoi reveniți la un set de fluxuri de lucru automatizate de guvernare în conformitate cu cerințele de conformitate. În cele din urmă, configurați un sistem de monitorizare pentru a alerta proprietarii dacă pragul acceptabil se apropie. Din punctul de vedere al tehnologiei, o IA bine proiectată, bine executată și bine conectată necesită mai multe blocuri de construcție. Și asigurați-vă că are unele sau toate capabilitățile:

· Integritatea datelor în diverse implementări

· Folosiți instrumente existente, deschise și flexibile, care aderă la guvernarea AI

· Asigurați-vă că oferiți acces autoservire cu comenzi de confidențialitate – o modalitate de urmărire

· Proiectați având în vedere automatizarea și guvernarea AI

· Poate fi conectat și personalizabil pentru mai multe părți interesate prin flux de lucru personalizabil

Odată ce facem o schimbare a aplicației de la înfricoșător la Rosy... atunci următoarea întrebare este cum dovediți...

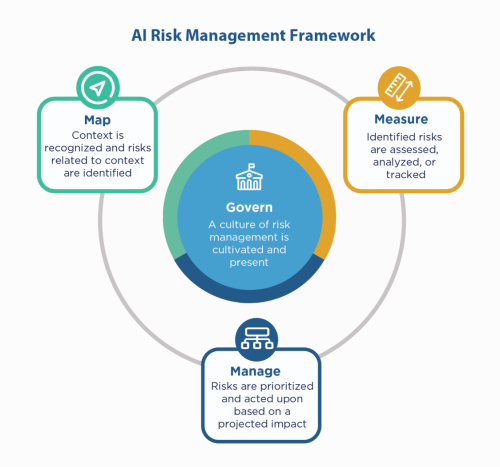

În primul rând, reveniți la principiile AI ale companiei – construiți cu ele și, totuși, trebuie să „arătați” că sunteți conform, mai ales în medii reglementate precum serviciile financiare. Deoarece serviciile financiare trebuie să se plângă de la NIST 800-53, ar putea să se uite la Cadrul de management al riscului NIST AI (AI RMF). NIST a sugerat controalele în patru familii - Guvernare, Hartă, Măsurare și Gestionare. Folosind asta ca factor de ghidare și test de stres aplicațiile pentru a identifica lacunele de remediat și monitorizat.

IBM vă poate valida modelele înainte de a le pune în producție și poate fi monitorizat pentru corectitudine, calitate și variație. De asemenea, poate furniza documentație care explică comportamentul și predicțiile modelului pentru a satisface cerințele autorităților de reglementare și ale auditorilor. Aceste explicații pot oferi vizibilitate și pot ușura durerea de audit și pot crește transparența și capacitatea de a determina posibilele riscuri.

Ascultă acele șoapte AI cu încredere!

#Servicii financiare #responsabilai #ethicalai #NISTAIRMF

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- Platoblockchain. Web3 Metaverse Intelligence. Cunoștințe amplificate. Accesați Aici.

- Mintând viitorul cu Adryenn Ashley. Accesați Aici.

- Sursa: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :este

- $UP

- 2021

- 2024

- 7

- a

- capacitate

- Despre Noi

- acceptabil

- acces

- responsabilitate

- peste

- act

- Acțiune

- activităţi de

- adera

- AI

- AI Act

- Guvernarea AI

- Propriul rol

- Alerta

- TOATE

- mereu

- și

- răspunde

- aplicaţia

- aplicație

- aplicatii

- Apps

- SUNT

- în jurul

- AS

- asociate

- At

- de audit

- auditori

- Automata

- automatizarea

- Automatizare

- înapoi

- Bancar

- Băncile

- bazat

- BE

- deoarece

- înainte

- fiind

- Benchmark

- Beneficiile

- Mai bine

- Miliard

- Negru

- Blocuri

- corp

- Cutie

- Aduce

- construi

- Clădire

- construit

- afaceri

- cumpăra

- by

- CAN

- capacități

- caz

- cazuri

- Bani gheata

- fluxul de numerar

- schimbarea

- chatbot

- chatbots

- claritate

- închidere

- Companii

- companie

- complexitate

- conformitate

- conforme

- Conduce

- cu încredere

- Conectați

- Consecințele

- continuu

- controale

- A costat

- ar putea

- crea

- critic

- Curent

- personalizabil

- ciclu

- de date

- dezbaterea

- Decidând

- Deciziile

- scădea

- Amenajări

- detaliat

- Determina

- digital

- Transformarea digitală

- groaznic

- direcționa

- călăuzitor

- diferit

- documentaţie

- de dolari

- scăparea

- mai ușor

- educa

- un capăt la altul

- asigura

- Afacere

- medii

- mai ales

- esenţial

- etic

- EU

- euro

- Chiar

- Fiecare

- tot

- dovadă

- existent

- există

- explicând

- exponențial

- Eșec

- cinste

- Cădea

- familii

- În cele din urmă

- financiar

- Servicii financiare

- capăt

- Finextra

- First

- flexibil

- debit

- Pentru

- Cadru

- din

- de la 2021

- viitor

- Da

- Caritate

- guvernare

- În creştere

- Avea

- Cum

- Cum Pentru a

- HTTPS

- mare

- Oamenii

- i

- identifica

- Impactul

- in

- Inclusiv

- Crește

- indică

- industrii

- influență

- inițiative

- Inovaţie

- perspective

- integrală

- integritate

- interacţiona

- investit

- IT

- ESTE

- Loc de munca

- Cunoaște

- Moştenire

- Legal

- probleme legale

- Viaţă

- ca

- Linie

- local

- Lung

- Uite

- făcut

- face

- administra

- administrare

- de conducere

- Hartă

- Piață

- materie

- Mai..

- măsura

- Întâlni

- ar putea

- milion

- milioane

- model

- Modele

- moment

- monitor

- monitorizate

- Monitorizarea

- mai mult

- multiplu

- necesar

- Nevoie

- Inutil

- Nou

- următor

- nist

- Obiectivele

- of

- oferi

- Vechi

- on

- ONE

- deschide

- funcionar

- organizație

- in caz contrar

- global

- Proprietarii

- Durere

- parte

- oameni

- Plato

- Informații despre date Platon

- PlatoData

- Punct

- posibil

- Predictii

- presiune

- primar

- Principiile

- intimitate

- Proactivă

- proces

- procese

- producere

- Profil

- dovadă

- propus

- Dovedi

- furniza

- pune

- calitate

- întrebare

- repede

- ajunge

- realiza

- reglementate

- industriile reglementate

- Regulament

- regulament

- Autoritățile de reglementare

- reputație

- necesar

- Cerinţe

- Necesită

- Răspunde

- responsabil

- rezultat

- venituri

- Risc

- de gestionare a riscurilor

- Riscurile

- ROI

- Roz

- s

- Said

- Al doilea

- sector

- Autoservire

- Servicii

- set

- să

- Arăta

- parte

- simplu

- întrucât

- Centre de cercetare

- situație

- dimensiuni

- So

- unele

- Scânteie

- Vorbitor

- părțile interesate

- şedere

- Încă

- Strategie

- A intari

- stres

- Incercand

- de succes

- sistem

- vorbesc

- echipă

- Tehnologia

- test

- acea

- Lor

- Acestea

- Al treilea

- prag

- Prin

- la

- instrument

- Unelte

- urmări

- Transformare

- Transparență

- extraordinar

- ÎNTORCĂ

- transformat

- în cele din urmă

- înţelege

- de unităţi

- viitoare

- us

- utilizare

- VALIDA

- diverse

- Video

- vizibilitate

- Cale..

- modalități de

- Ce

- în timp ce

- OMS

- cu

- fără

- Apartamente

- fluxuri de lucru

- Tu

- Ta

- zephyrnet