Это гостевой пост АК Роя из Qualcomm AI.

Облако Amazon Elastic Compute (Amazon EC2) Экземпляры DL2q на базе ускорителей Qualcomm AI 100 Standard можно использовать для экономичного развертывания рабочих нагрузок глубокого обучения (DL) в облаке. Их также можно использовать для разработки и проверки производительности и точности рабочих нагрузок DL, которые будут развернуты на устройствах Qualcomm. Экземпляры DL2q — это первые экземпляры, которые перенесли технологию искусственного интеллекта (ИИ) Qualcomm в облако.

Благодаря восьми ускорителям Qualcomm AI 100 Standard и 128 ГиБ общей памяти ускорителя клиенты также могут использовать экземпляры DL2q для запуска популярных генеративных приложений искусственного интеллекта, таких как генерация контента, обобщение текста и виртуальные помощники, а также классических приложений искусственного интеллекта для обработки естественного языка. и компьютерное зрение. Кроме того, ускорители Qualcomm AI 100 используют ту же технологию искусственного интеллекта, которая используется в смартфонах, автономном вождении, персональных компьютерах и гарнитурах расширенной реальности, поэтому экземпляры DL2q можно использовать для разработки и проверки этих рабочих нагрузок искусственного интеллекта перед развертыванием.

Основные характеристики нового экземпляра DL2q

Каждый экземпляр DL2q включает восемь ускорителей Qualcomm Cloud AI100 с совокупной производительностью более 2.8 петаопс производительности вывода Int8 и 1.4 петафлопс производительности вывода FP16. Экземпляр имеет совокупность 112 AI-ядер, ускоритель памяти объемом 128 ГБ и пропускную способность памяти 1.1 ТБ в секунду.

Каждый экземпляр DL2q имеет 96 виртуальных ЦП, объем системной памяти 768 ГБ и поддерживает пропускную способность сети 100 Гбит/с, а также Магазин эластичных блоков Amazon (Amazon EBS) хранилище 19 Гбит/с.

| Имя экземпляра | VCPU будут | Облачные ускорители AI100 | Память ускорителя | Память ускорителя BW (агрегированная) | Память экземпляра | Сеть экземпляра | Пропускная способность хранилища (Amazon EBS) |

| DL2q.24xlarge | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

Инновационный ускоритель Qualcomm Cloud AI100

Система-на-кристалле ускорителя Cloud AI100 (SoC) представляет собой специально созданную масштабируемую многоядерную архитектуру, поддерживающую широкий спектр вариантов использования глубокого обучения, от центра обработки данных до периферийных устройств. В SoC используются скалярные, векторные и тензорные вычислительные ядра с лучшей в отрасли встроенной SRAM емкостью 126 МБ. Ядра соединены между собой с помощью сети на кристалле (NoC) с высокой пропускной способностью и малой задержкой.

Ускоритель AI100 поддерживает широкий спектр моделей и вариантов использования. В таблице ниже показан диапазон поддержки модели.

| Категория модели | Количество моделей | Примеры |

| НЛП | 157 | BERT, BART, FasterTransformer, T5, Z-код MOE |

| Генеративный ИИ – НЛП | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| Генеративный ИИ – Изображение | 3 | Стабильная диффузия v1.5 и v2.1, OpenAI CLIP |

| Резюме – Классификация изображений | 45 | ВиТ, ResNet, ResNext, MobileNet, EfficientNet |

| CV – Обнаружение объектов | 23 | YOLO v2, v3, v4, v5 и v7, SSD-ResNet, RetinaNet |

| Резюме – Другое | 15 | LPRNet, сверхвысокое разрешение/SRGAN, ByteTrack |

| Автомобильные сети* | 53 | Восприятие и LIDAR, обнаружение пешеходов, полос движения и светофоров |

| Общее | > 300 |

* Большинство автомобильных сетей представляют собой составные сети, состоящие из слияния отдельных сетей.

Большая встроенная SRAM ускорителя DL2q обеспечивает эффективную реализацию передовых методов повышения производительности, таких как точность микроэкспоненты MX6 для хранения весов и точность микроэкспоненты MX9 для связи между ускорителями. Технология микроэкспоненты описана в следующем отраслевом объявлении Open Compute Project (OCP): AMD, Arm, Intel, Meta, Microsoft, NVIDIA и Qualcomm стандартизируют форматы данных узкой точности следующего поколения для искусственного интеллекта » Open Compute Project.

Пользователь экземпляра может использовать следующую стратегию для максимизации соотношения производительности и затрат:

- Сохраняйте веса, используя точность микроэкспоненты MX6 в памяти DDR с включенным ускорителем. Использование точности MX6 максимально эффективно использует доступный объем памяти и пропускную способность памяти, обеспечивая лучшую в своем классе пропускную способность и задержку.

- Вычисляйте в FP16, чтобы обеспечить необходимую точность сценария использования, используя при этом превосходную встроенную SRAM и запасные TOP на карте для реализации высокопроизводительных ядер от MX6 до FP16 с малой задержкой.

- Используйте оптимизированную стратегию пакетной обработки и увеличивайте размер пакета за счет использования большой встроенной SRAM, чтобы максимизировать повторное использование весов, сохраняя при этом активации на кристалле до максимально возможного уровня.

DL2q AI стек и набор инструментов

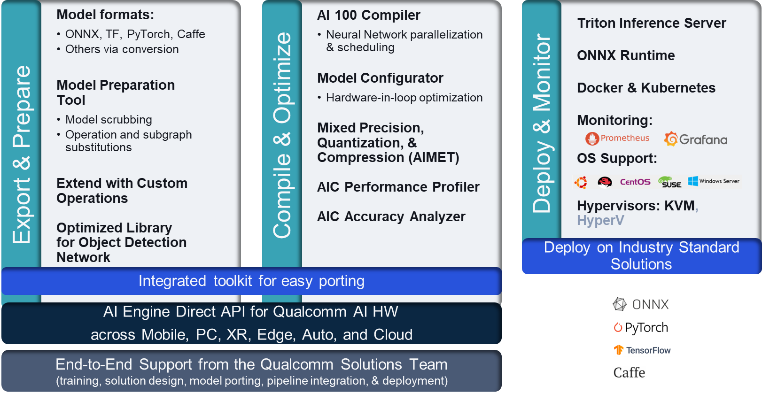

Экземпляр DL2q сопровождается стеком Qualcomm AI Stack, который обеспечивает единообразную работу разработчиков с использованием искусственного интеллекта Qualcomm в облаке и других продуктах Qualcomm. Один и тот же стек искусственного интеллекта Qualcomm и базовая технология искусственного интеллекта работают на экземплярах DL2q и периферийных устройствах Qualcomm, предоставляя клиентам единообразный опыт разработки с унифицированным API для облачных, автомобильных, персональных компьютеров, расширенной реальности и сред разработки смартфонов.

Цепочка инструментов позволяет пользователю экземпляра быстро подключить ранее обученную модель, скомпилировать и оптимизировать модель для возможностей экземпляра, а затем развернуть скомпилированные модели для сценариев использования производственного вывода за три шага, показанных на следующем рисунке.

Чтобы узнать больше о настройке производительности модели, см. Ключевые параметры производительности Cloud AI 100 Документация.

Начало работы с экземплярами DL2q

В этом примере вы компилируете и развертываете предварительно обученный модель БЕРТ от Обнимая лицо на экземпляре EC2 DL2q с использованием предварительно созданного доступного AMI DL2q за четыре шага.

Вы можете использовать либо готовый Qualcomm ДЛАМИ на экземпляре или начните с AMI Amazon Linux2 и создайте собственный AMI DL2q с помощью платформы Cloud AI 100 и SDK приложений, доступных в этом документе. Сервис Amazon Simple Storage (Amazon S3) ведро: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

В следующих шагах используется предварительно созданный AMI DL2q. База Qualcomm AL2 DLAMI.

Используйте SSH для доступа к вашему экземпляру DL2q с помощью Qualcomm Base AL2 DLAMI AMI и выполните шаги с 1 по 4.

Шаг 1. Настройте среду и установите необходимые пакеты.

- Установите Python 3.8.

- Настройте виртуальную среду Python 3.8.

- Активируйте виртуальную среду Python 3.8.

- Установите необходимые пакеты, показанные в Документ «требования.txt» доступен на общедоступном сайте Qualcomm на Github.

- Импортируйте необходимые библиотеки.

Шаг 2. Импортируйте модель

- Импортируйте и токенизируйте модель.

- Определите образец входных данных и извлеките

inputIdsиattentionMask. - Преобразуйте модель в ONNX, который затем можно будет передать компилятору.

- Вы запустите модель с точностью FP16. Итак, вам необходимо проверить, содержит ли модель какие-либо константы, выходящие за пределы диапазона FP16. Передайте модель в

fix_onnx_fp16функция для создания нового файла ONNX с необходимыми исправлениями.

Шаг 3. Скомпилируйте модель

Ассоциация qaic-exec Для компиляции модели используется инструмент компилятора интерфейса командной строки (CLI). Входными данными для этого компилятора является файл ONNX, созданный на шаге 2. Компилятор создает двоичный файл (называемый QPC, Для Программный контейнер Qualcomm) на пути, определенном -aic-binary-dir аргумент.

В приведенной ниже команде компиляции вы используете четыре вычислительных ядра AI и размер пакета, равный одному, для компиляции модели.

QPC генерируется в bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc папку.

Шаг 4. Запустите модель

Настройте сеанс для выполнения вывода на ускорителе Cloud AI100 Qualcomm в экземпляре DL2q.

Библиотека Qualcomm qaic Python — это набор API-интерфейсов, обеспечивающих поддержку выполнения логических выводов в ускорителе Cloud AI100.

- Используйте вызов API сеанса, чтобы создать экземпляр сеанса. Вызов Session API — это точка входа в использование библиотеки qaic Python.

- Реструктурируйте данные из выходного буфера с помощью

output_shapeиoutput_type. - Расшифруйте полученный результат.

Вот результаты входного предложения «Собака [МАСКА] на коврике».

Вот и все. Всего за несколько шагов вы скомпилировали и запустили модель PyTorch на экземпляре Amazon EC2 DL2q. Чтобы узнать больше об адаптации и компиляции моделей на экземпляре DL2q, см. Учебная документация по Cloud AI100.

Чтобы узнать больше о том, какие архитектуры моделей DL лучше всего подходят для экземпляров AWS DL2q, а также о текущей матрице поддержки моделей, см. Документация Qualcomm Cloud AI100.

Доступные в настоящее время

Вы можете запустить инстансы DL2q уже сегодня в регионах AWS Запад США (Орегон) и Европе (Франкфурт). По требованию, Зарезервированныйи Точечные экземплярыили как часть План сбережений. Как обычно в Amazon EC2, вы платите только за то, что используете. Для получения дополнительной информации см. Цены на Amazon EC2.

Экземпляры DL2q можно развернуть с помощью AMI AWS для глубокого обучения (DLAMI), а образы контейнеров доступны через управляемые службы, такие как Создатель мудреца Амазонки, Сервис Amazon Elastic Kubernetes (Amazon EKS), Amazon Elastic Container Service (Amazon ECS)и Параллельный кластер AWS.

Чтобы узнать больше, посетите Экземпляр Amazon EC2 DL2q страницу и отправьте отзыв на AWS re:Post для EC2 или через ваши обычные контакты службы поддержки AWS.

Об авторах

АК Рой является директором по управлению продуктами Qualcomm в области продуктов и решений искусственного интеллекта для облачных вычислений и центров обработки данных. Он имеет более чем 20-летний опыт работы в области стратегии и разработки продуктов, в настоящее время уделяя особое внимание лучшим в своем классе производительности и производительности/$ комплексным решениям для вывода ИИ в облаке для широкого спектра вариантов использования. включая GenAI, LLM, Auto и Hybrid AI.

АК Рой является директором по управлению продуктами Qualcomm в области продуктов и решений искусственного интеллекта для облачных вычислений и центров обработки данных. Он имеет более чем 20-летний опыт работы в области стратегии и разработки продуктов, в настоящее время уделяя особое внимание лучшим в своем классе производительности и производительности/$ комплексным решениям для вывода ИИ в облаке для широкого спектра вариантов использования. включая GenAI, LLM, Auto и Hybrid AI.

Цзяньин Лан — главный архитектор решений во Всемирной специализированной организации AWS (WWSO). Имеет более 15 лет опыта работы в сфере высокопроизводительных вычислений и искусственного интеллекта. В AWS она помогает клиентам развертывать, оптимизировать и масштабировать рабочие нагрузки искусственного интеллекта и машинного обучения на экземплярах ускоренных вычислений. Она увлечена объединением методов высокопроизводительных вычислений и искусственного интеллекта. Цзяньин имеет степень доктора философии в области вычислительной физики, полученную в Университете Колорадо в Боулдере.

Цзяньин Лан — главный архитектор решений во Всемирной специализированной организации AWS (WWSO). Имеет более 15 лет опыта работы в сфере высокопроизводительных вычислений и искусственного интеллекта. В AWS она помогает клиентам развертывать, оптимизировать и масштабировать рабочие нагрузки искусственного интеллекта и машинного обучения на экземплярах ускоренных вычислений. Она увлечена объединением методов высокопроизводительных вычислений и искусственного интеллекта. Цзяньин имеет степень доктора философии в области вычислительной физики, полученную в Университете Колорадо в Боулдере.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :имеет

- :является

- $UP

- 1

- 1 ТБ

- 10

- 100

- 11

- 12

- 13

- 15 лет

- 15%

- 17

- 19

- 20

- 20 лет

- 22

- 23

- 7

- 75

- 8

- 84

- a

- О нас

- выше

- ускоренный

- ускоритель

- ускорители

- доступ

- в сопровождении

- точность

- через

- активации

- Дополнительно

- продвинутый

- совокупный

- AI

- AI / ML

- Все

- причислены

- Amazon

- Amazon EC2

- Amazon Web Services

- an

- и

- Объявление

- любой

- API

- API

- Приложения

- Программы

- архитектура

- МЫ

- аргумент

- ARM

- искусственный

- AS

- помощники

- At

- автоматический

- автомобильный

- автономный

- доступен

- AWS

- ОСИ

- Пропускная способность

- Использование темпера с изогнутым основанием

- BE

- до

- ниже

- Beyond

- BIN

- Заблокировать

- Цвести

- приносить

- широкий

- буфер

- строить

- by

- призывают

- под названием

- CAN

- возможности

- Пропускная способность

- карта

- случаев

- проверка

- классический

- облако

- Колорадо

- комбинируя

- Связь

- комплексный

- вычислительный

- Вычисление

- компьютер

- Компьютерное зрение

- компьютеры

- вычисление

- последовательный

- Состоящий из

- контакты

- Container

- содержит

- содержание

- Генерация контента

- Создайте

- Текущий

- Клиенты

- данным

- Datacenter

- глубоко

- глубокое обучение

- определенный

- Степень

- доставить

- обеспечивает

- развертывание

- развернуть

- развертывание

- описано

- развивать

- Застройщик

- Развитие

- устройство

- Устройства

- Вещание

- директор

- документации

- Собака

- вождение

- динамический

- Edge

- эффективный

- или

- работает

- позволяет

- впритык

- запись

- Окружающая среда

- средах

- Европе

- пример

- опыт

- расширенная реальность

- извлечение

- ложный

- Особенность

- Обратная связь

- несколько

- поле

- Поля

- фигура

- Файл

- Во-первых,

- соответствовать

- Фокус

- фокусируется

- следовать

- после

- Что касается

- найденный

- 4

- Франкфурт

- от

- функция

- слияние

- в общем

- порождать

- генерируется

- поколение

- генеративный

- Генеративный ИИ

- GitHub

- данный

- хорошо

- GUEST

- Guest Post

- he

- гарнитуры

- помощь

- здесь

- высокая производительность

- высший

- основной момент

- имеет

- HPC

- HTML

- HTTPS

- Гибридный

- i

- IDX

- if

- изображение

- изображений

- осуществлять

- реализация

- Импортировать

- in

- В том числе

- включает в себя

- individual

- промышленность

- отрасли

- информация

- вход

- устанавливать

- пример

- Intel

- Умный

- взаимосвязано

- Интерфейс

- IT

- JPG

- всего

- Основные

- Переулок

- язык

- большой

- Задержка

- запуск

- УЧИТЬСЯ

- изучение

- библиотеки

- Библиотека

- легкий

- линия

- грузы

- управляемого

- управление

- маска

- матрица

- Макс

- Максимизировать

- максимизирует

- максимальный

- Память

- сетке

- Мета

- Microsoft

- мин

- модель

- Модели

- модифицировало

- БОЛЕЕ

- самых

- имя

- Узкий

- натуральный

- Обработка естественного языка

- необходимо

- Необходимость

- сеть

- сетей

- сетей

- Новые

- следующее поколение

- сейчас

- NumPy

- Nvidia

- объект

- of

- on

- Onboard

- Вводный

- ONE

- только

- открытый

- OpenAI

- Оптимизировать

- оптимизированный

- or

- Орегон

- организация

- OS

- Другое

- внешний

- выходной

- выходы

- за

- собственный

- пакеты

- страница

- часть

- pass

- Прошло

- страстный

- путь

- ОПЛАТИТЬ

- для

- производительность

- личного

- кандидат наук

- Физика

- Платформа

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- Точка

- Популярное

- возможное

- После

- Питание

- Точность

- предварительно

- Основной

- обработка

- Произведенный

- производит

- Продукт

- Управление продуктом

- Производство

- Продукция

- FitPartner™

- Проект

- приводит

- обеспечение

- что такое варган?

- Питон

- pytorch

- Qualcomm

- быстро

- ассортимент

- RE

- Reading

- Реальность

- районы

- обязательный

- Требования

- удерживающий

- возвращают

- снова использовать

- Рой

- Run

- Бег

- работает

- то же

- Сохранить

- экономия

- масштабируемые

- Шкала

- SDK

- Во-вторых

- посмотреть

- Отправить

- предложение

- Последовательность

- обслуживание

- Услуги

- Сессия

- набор

- она

- показанный

- просто

- упростить

- сайте

- Размер

- смартфон

- смартфоны

- So

- Решения

- напряженность

- специалист

- стек

- стандарт

- Начало

- и политические лидеры

- Шаг

- Шаги

- диск

- магазин

- хранение

- Стратегия

- впоследствии

- такие

- топ

- поддержка

- поддержки

- Поддержка

- SYS

- система

- ТАБЛИЦЫ

- снижения вреда

- Технологии

- текст

- который

- Ассоциация

- их

- тогда

- Эти

- они

- этой

- три

- Через

- пропускная способность

- через

- в

- сегодня

- токенизировать

- инструментом

- Топы

- факел

- Всего

- трафик

- специалистов

- трансформеры

- правда

- настройка

- учебник

- унифицированный

- Университет

- us

- использование

- прецедент

- случаи использования

- используемый

- Информация о пользователе

- через

- обычный

- v1

- VALIDATE

- ценностное

- Виртуальный

- видение

- Войти

- we

- Web

- веб-сервисы

- ЧТО Ж

- запад

- Что

- который

- в то время как

- широкий

- Широкий диапазон

- будете

- Word

- работает

- по всему миру

- лет

- Ты

- ВАШЕ

- зефирнет