Предвзятость в системах ИИ оказывается основным камнем преткновения в усилиях по более широкой интеграции технологии в наше общество. Новая инициатива, которая вознаградит исследователей за обнаружение каких-либо предубеждений в Системы искусственного интеллекта может помочь решить проблему.

Усилия основаны на наградах за ошибки, которые компании-разработчики программного обеспечения платят экспертам по кибербезопасности, которые предупреждают их оf любые потенциальные недостатки безопасности в их продуктах. Идея не нова; «предвзятые награды» были первый предложенный поЯ исследователь и предприниматель Дж. Б. Рубиновиц еще в 2018 году, и различные организации уже сталкивались с такими проблемами.

Но новое усилие направлено на создание постоянного форума для конкурсов за предвзятость, независимого от какой-либо конкретной организации. Состоящие из добровольцев из ряда компаний, включая Twitter, так называемые «предвзятые пираты» планируют проводить регулярные соревнования или «мятежи» и ранее в этом месяце запустили первый такой вызов.

Bug bounty — стандартная практика в кибербезопасности, которая еще не нашла поддержки в сообществе сторонников алгоритмических предубеждений», — говорится в сообщении организации.низеры говорят на их сайте. «В то время как первоначальные разовые мероприятия продемонстрировали энтузиазм в отношении наград, Bias Buccaneers — первая некоммерческая организация, предназначенная для создания постоянных мятежей, сотрудничества с технологическими компаниями и прокладывания пути для прозрачных и воспроизводимых оценок систем ИИ».

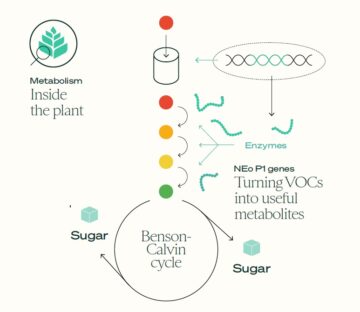

Это первое соревнование направлено на устранение предвзятости в алгоритмах обнаружения изображений, а не на то, чтобы заставить людей ориентироваться на конкретные системы ИИ. соревнование будет чпризывать исследователей создавать инструменты, которые могут обнаруживать необъективные наборы данных. Идея состоит в том, чтобы создать модель машинного обучения, которая может точно маркировать каждое изображение в наборе данных с его оттенком кожи, предполагаемым полом и возрастной группой. Конкурс завершится 30 ноября. и имеет первый приз в размере 6,000 долларов, второй приз в размере 4,000 долларов и третий приз в размере 2,000 долларов.

Проблема основана на том факте, что часто источником алгоритмической предвзятости является не столько сам алгоритм, сколько природа данных, на которых он обучается. Автоматизированные инструменты, которые могут быстро оценить, насколько сбалансирована коллекция of изображения по отношению к атрибутам, которые часто являются источниками дискриминации, могут помочь исследователям ИИ избежать явно предвзятых источников данных.

Но организаторы говорят, что это только первый шаг в попытке создать набор инструментов для оценки предвзятости в наборах данных, алгоритмах и приложениях и, в конечном итоге, создать стандарты того, какl с алгоритмической предвзятостью, справедливостью и объяснимостью.

Это не единственная такая попытка. Один из лидеров нового инициатива — Румман Чоудхури из Twitter, который в прошлом году помог организовать первый конкурс вознаграждений за предвзятость ИИ, нацеленный на алгоритм, используемый платформой для обрезки изображений, которые пользователи жаловались предпочитали белокожие и мужские лица чернокожим и женским.

Соревнование предоставило хакерам доступ к модели компании и поставило перед ними задачу найти в ней недостатки. Участники обнаружил множество проблем, в том числепредпочтение стереотипно красивым лицам, отвращение к люди с седыми волосами (маркер возраста) и предпочтение мемам с английским, а не арабским письмом.

Стэнфордский университет также недавно завершил конкурс, в котором командам было предложено разработать инструменты, предназначенные для помощи людям в проверке коммерческих систем ИИ или систем искусственного интеллекта с открытым исходным кодом на предмет дискриминации. А действующие и будущие законы ЕС могут сделать обязательным для компаний регулярный аудит своих данных и алгоритмов.

Но взяв Награды за ошибки ИИ и алгоритмический аудит будет легче сказать, чем сделать. Неизбежно, что компании, которые строят свой бизнес на своих алгоритмах, будут сопротивляться любым попыткам дискредитировать их.

Использование уроков систем аудита в других областях, таких как финансы, экологические и санитарные нормы, исследователи недавно обрисованный некоторые из важнейших компонентов эффективной подотчетности. Один из наиболее важных Критерии они определили значимое участие независимых третьих сторон.

Исследователи отметили, что текущие добровольные аудиты ИИ часто связаны с конфликтом интересов, например, целевая организация платит за аудит, помогает определить объем аудита или имеет возможность просмотреть результаты до их публикации. Эта озабоченность нашла свое отражение в недавнем отчете Лига алгоритмического правосудия, почемуch отметил негабаритd роль целевых организаций в текущих программах вознаграждения за обнаружение ошибок в кибербезопасности.

Найти способ финансировать и поддерживать действительно независимых аудиторов ИИ и охотников за ошибками будет серьезной проблемой, особенно потому, что им предстоит конкурировать с некоторыми из самых обеспеченных ресурсами компаний в мире. К счастью, в отрасли, похоже, растет понимание того, что решение этой проблемы будет иметь решающее значение для поддержания доверия пользователей к их услугам.

Изображение Фото: Якоб Розен / Unsplash