Отчеты о радиологии представляют собой подробные и объемные документы, в которых описываются и интерпретируются результаты рентгенологического исследования. В типичном рабочем процессе рентгенолог наблюдает, читает и интерпретирует изображения, а затем кратко обобщает основные выводы. Обобщение (или впечатление) является наиболее важной частью отчета, поскольку помогает врачам и пациентам сосредоточиться на важном содержании отчета, содержащем информацию для принятия клинических решений. Создание четкого и впечатляющего впечатления требует гораздо больше усилий, чем простое изложение результатов. Поэтому весь процесс трудоемкий, требует много времени и подвержен ошибкам. Часто на это уходят годы обучение чтобы врачи накопили достаточный опыт в написании кратких и информативных сводных отчетов о радиологических исследованиях, что еще раз подчеркивает важность автоматизации этого процесса. Дополнительно автоматическое формирование сводных отчетов по результатам. имеет решающее значение для радиологической отчетности. Это позволяет переводить отчеты на понятный человеку язык, тем самым облегчая пациентам чтение длинных и непонятных отчетов.

Чтобы решить эту проблему, мы предлагаем использовать генеративный ИИ — тип ИИ, который может создавать новый контент и идеи, включая разговоры, истории, изображения, видео и музыку. Генеративный ИИ основан на моделях машинного обучения (ML) — очень больших моделях, которые предварительно обучаются на огромных объемах данных и обычно называются базовыми моделями (FM). Недавние достижения в области машинного обучения (в частности, изобретение архитектуры нейронных сетей на основе трансформаторов) привели к появлению моделей, которые содержат миллиарды параметров или переменных. Предлагаемое в этом посте решение использует тонкую настройку предварительно обученных моделей большого языка (LLM), чтобы помочь генерировать обобщения на основе результатов радиологических отчетов.

В этом посте демонстрируется стратегия тонкой настройки общедоступных LLM для задачи обобщения радиологических отчетов с использованием сервисов AWS. LLM продемонстрировали замечательные возможности в понимании и создании естественного языка, выступая в качестве базовых моделей, которые можно адаптировать к различным областям и задачам. Использование предварительно обученной модели имеет значительные преимущества. Это снижает затраты на вычисления, уменьшает выбросы углекислого газа и позволяет использовать самые современные модели без необходимости обучения их с нуля.

Наше решение использует ФЛАН-Т5 XL ФМ, используя Amazon SageMaker JumpStart, который представляет собой центр ML, предлагающий алгоритмы, модели и решения ML. Мы покажем, как это сделать с помощью блокнота в Студия Amazon SageMaker. Точная настройка предварительно обученной модели предполагает дальнейшее обучение конкретным данным для повышения производительности при выполнении другой, но связанной задачи. Данное решение предполагает тонкую настройку модели FLAN-T5 XL, которая представляет собой усовершенствованную версию T5 (Преобразователь передачи текста в текст) LLM общего назначения. T5 переформулирует задачи обработки естественного языка (NLP) в единый формат преобразования текста в текст, в отличие от БЕРТмодели в стиле, которые могут выводить только метку класса или диапазон входных данных. Он идеально настроен для выполнения задачи обобщения 91,544 XNUMX отчетов о радиологических исследованиях в произвольном формате, полученных из Набор данных MIMIC-CXR.

Обзор решения

В этом разделе мы обсудим ключевые компоненты нашего решения: выбор стратегии для задачи, тонкую настройку LLM и оценку результатов. Мы также иллюстрируем архитектуру решения и шаги по его реализации.

Определить стратегию выполнения задачи

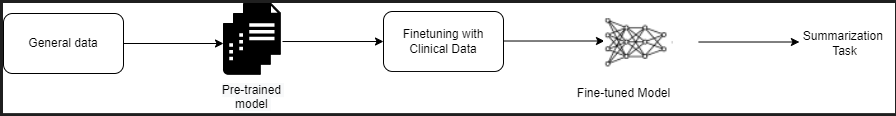

Существуют различные стратегии решения задачи автоматизации обобщения клинических отчетов. Например, мы могли бы использовать специализированную языковую модель, предварительно обученную на клинических отчетах с нуля. В качестве альтернативы мы могли бы напрямую настроить общедоступную языковую модель общего назначения для выполнения клинической задачи. Использование точно настроенной модели, не зависящей от предметной области, может оказаться необходимым в условиях, когда обучение языковая модель с нуля это слишком дорого. В этом решении мы демонстрируем последний подход с использованием модели FLAN-T5 XL, которую мы настраиваем для клинической задачи обобщения радиологических отчетов. На следующей диаграмме показан рабочий процесс модели.

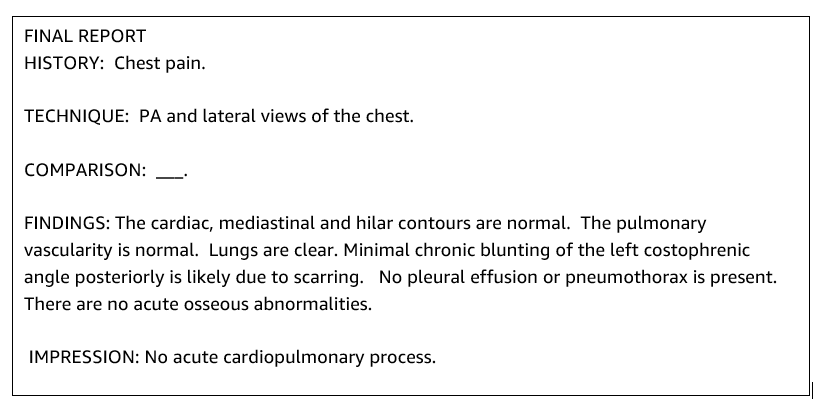

Типичный радиологический отчет хорошо организован и краток. Такие отчеты часто имеют три ключевых раздела:

- проверка данных – Предоставляет общую информацию о демографических характеристиках пациента, а также важную информацию о пациенте, истории болезни и соответствующей истории болезни, а также подробную информацию о процедурах обследования.

- Результаты – Представлен подробный диагноз и результаты обследования.

- печать – Кратко суммирует наиболее существенные результаты или интерпретацию результатов с оценкой значимости и потенциального диагноза на основе наблюдаемых отклонений.

Используя раздел результатов в отчетах о радиологии, решение создает раздел впечатлений, который соответствует резюме врачей. На следующем рисунке приведен пример отчета о радиологии.

Точная настройка LLM общего назначения для решения клинической задачи

В этом решении мы осуществляем тонкую настройку модели FLAN-T5 XL (настраиваем все параметры модели и оптимизируем их под поставленную задачу). Мы настраиваем модель, используя набор данных клинической области. МИМИЧЕСКИЙ-CXR, который представляет собой общедоступный набор данных рентгенограмм грудной клетки. Для точной настройки этой модели с помощью SageMaker Jumpstart необходимо предоставить помеченные примеры в виде пар {подсказка, завершение}. В этом случае мы используем пары {Выводы, Показания} из исходных отчетов в наборе данных MIMIC-CXR. Для вывода мы используем подсказку, как показано в следующем примере:

![]()

Модель доработана на ускоренные вычисления. мл.p3.16xбольшой экземпляр с 64 виртуальными процессорами и памятью 488 ГиБ. Для проверки случайным образом было выбрано 5% набора данных. Затраченное время обучающего задания SageMaker с тонкой настройкой составило 38,468 11 секунд (около XNUMX часов).

Оцените результаты

Когда обучение завершено, очень важно оценить результаты. Для количественного анализа произведенного впечатления мы используем RED (Дублер, ориентированный на отзыв, для оценки Gisting), наиболее часто используемый показатель для оценки обобщения. Эта метрика сравнивает автоматически созданное резюме со ссылкой или набором ссылок (созданными людьми) резюме или перевода. ROUGE1 относится к перекрытию униграммы (каждое слово) между кандидатом (выходными данными модели) и справочными сводками. ROUGE2 означает перекрытие биграммы (два слова) между резюме кандидата и рекомендации. ROUGEL — это показатель на уровне предложения, который относится к самой длинной общей подпоследовательности (LCS) между двумя частями текста. Он игнорирует переводы строк в тексте. ROUGELsum — это показатель сводного уровня. Для этой метрики новые строки в тексте не игнорируются, а интерпретируются как границы предложения. Затем вычисляется LCS между каждой парой ссылочных предложений и предложений-кандидатов, а затем вычисляется объединение-LCS. Для агрегирования этих оценок по заданному набору эталонных предложений и предложений-кандидатов вычисляется среднее значение.

Прохождение и архитектура

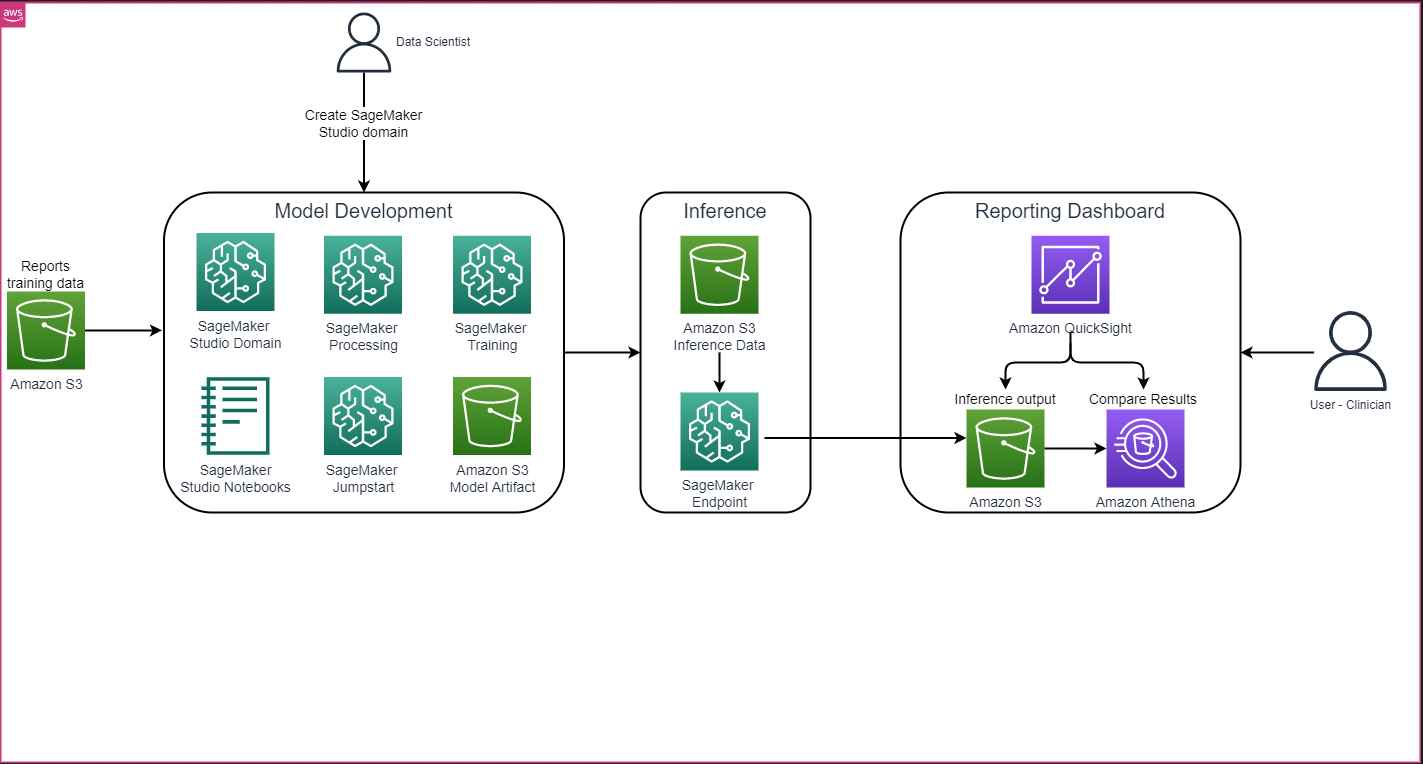

Общая архитектура решения, показанная на следующем рисунке, в основном состоит из среды разработки моделей, использующей SageMaker Studio, развертывания модели с конечной точкой SageMaker и информационной панели отчетов с использованием Amazon QuickSight.

В следующих разделах мы демонстрируем тонкую настройку LLM, доступного в SageMaker JumpStart, для обобщения конкретной предметной задачи с помощью SageMaker Python SDK. В частности, мы обсуждаем следующие темы:

- Шаги по настройке среды разработки

- Обзор наборов данных радиологических отчетов, на которых модель точно настраивается и оценивается.

- Демонстрация тонкой настройки модели FLAN-T5 XL с помощью программного обеспечения SageMaker JumpStart с помощью SageMaker Python SDK.

- Выводы и оценка предварительно обученных и точно настроенных моделей

- Сравнение результатов предварительно обученной модели и точно настроенных моделей.

Решение доступно в Создание впечатления от радиологического отчета с помощью генеративного искусственного интеллекта с большой языковой моделью на AWS Репо GitHub.

Предпосылки

Для начала вам понадобится Аккаунт AWS в котором вы можете использовать SageMaker Studio. Вам потребуется создать профиль пользователя для SageMaker Studio, если у вас его еще нет.

Тип обучающего экземпляра, используемый в этом посте, — ml.p3.16xlarge. Обратите внимание, что тип экземпляра p3 требует увеличения лимита квоты на обслуживание.

Ассоциация Набор данных MIMIC CXR Доступ к ним можно получить через соглашение об использовании данных, которое требует регистрации пользователя и завершения процесса аутентификации.

Настроить среду разработки

Чтобы настроить среду разработки, вы создаете корзину S3, настраиваете блокнот, создаете конечные точки и развертываете модели, а также создаете панель мониторинга QuickSight.

Создайте ведро S3

Создайте ведро S3 под названием llm-radiology-bucket для размещения наборов данных обучения и оценки. Это также будет использоваться для хранения артефакта модели во время разработки модели.

Настройка блокнота

Выполните следующие шаги:

- Запустите SageMaker Studio либо из консоли SageMaker, либо из Интерфейс командной строки AWS (Интерфейс командной строки AWS).

Дополнительные сведения о подключении к домену см. Подключение к домену Amazon SageMaker.

- Создать новый Блокнот SageMaker Studio для очистки данных отчета и тонкой настройки модели. Мы используем экземпляр ноутбука ml.t3.medium 2vCPU+4GiB с ядром Python 3.

- В ноутбуке установите соответствующие пакеты, такие как

nest-asyncio,IPyWidgets(для интерактивных виджетов для блокнота Jupyter) и SageMaker Python SDK:

Для вывода предварительно обученных и точно настроенных моделей: создать конечную точку и развернуть каждую модель в тетради так:

- Создайте объект модели из класса Model, который можно будет развернуть в конечной точке HTTPS.

- Создайте конечную точку HTTPS с предварительно созданным объектом модели.

deploy()Метод:

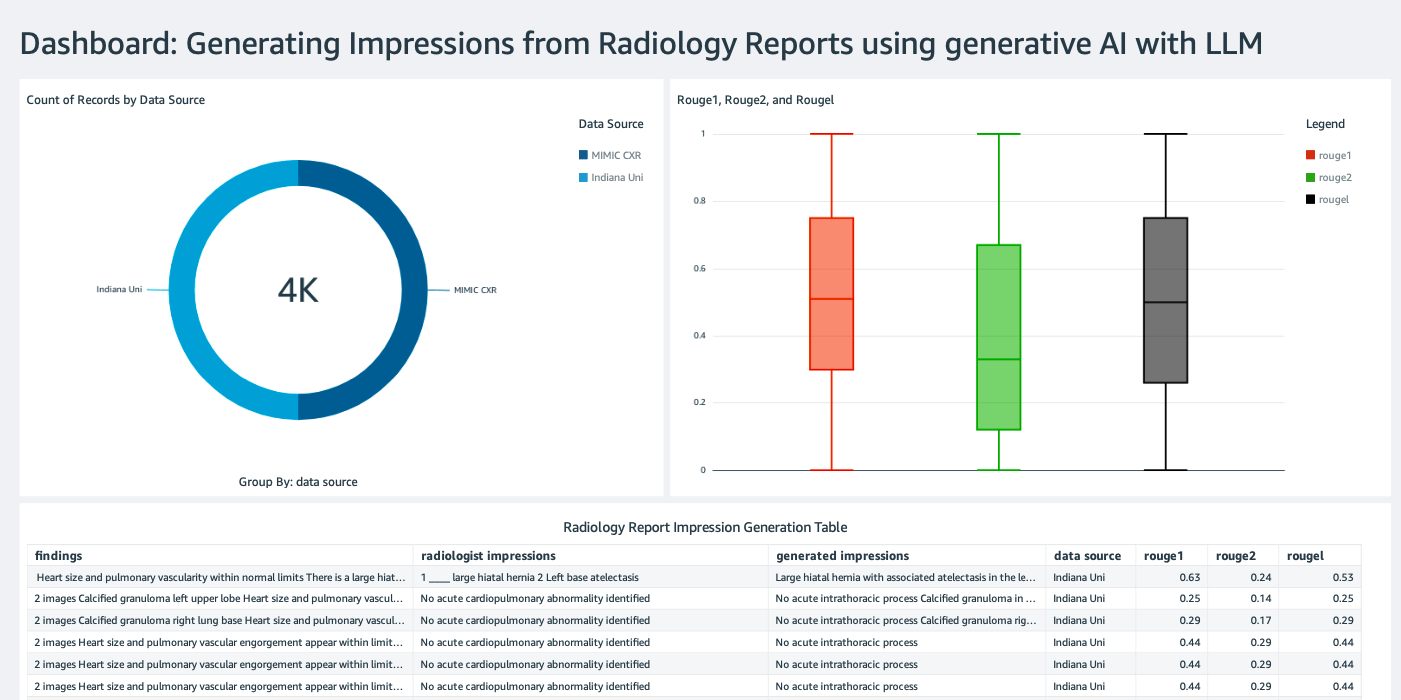

Создайте панель инструментов QuickSight

Создайте Панель мониторинга QuickSight с источником данных Athena с выводом результатов в Простой сервис хранения Amazon (Amazon S3), чтобы сравнить результаты умозаключений с истиной. На следующем снимке экрана показан пример нашей информационной панели.

Наборы данных отчета о радиологии

Сейчас модель доработана, все параметры модели настроены на 91,544 XNUMX отчетах, скачанных с сайта. Набор данных MIMIC-CXR v2.0. Поскольку мы использовали только текстовые данные радиологического отчета, мы загрузили только один сжатый файл отчета (mimic-cxr-reports.zip) с веб-сайта MIMIC-CXR. Теперь мы оцениваем точно настроенную модель на 2,000 отчетах (называемых dev1 набор данных) из отдельного протянутое подмножество этого набора данных. Мы используем еще 2,000 радиологических отчетов (называемых dev2) для оценки точно настроенной модели из коллекции рентгенограмм грудной клетки из Сеть больниц Университета Индианы. Все наборы данных считываются как файлы JSON и загружаются во вновь созданную корзину S3. llm-radiology-bucket. Обратите внимание, что все наборы данных по умолчанию не содержат никакой защищенной медицинской информации (PHI); вся конфиденциальная информация заменяется тремя последовательными символами подчеркивания (___) провайдерами.

Точная настройка с помощью SageMaker Python SDK

Для более точной настройки используется model_id указывается как huggingface-text2text-flan-t5-xl из списка моделей SageMaker JumpStart. training_instance_type установлено как ml.p3.16xlarge, а inference_instance_type как ml.g5.2xlarge. Данные обучения в формате JSON считываются из корзины S3. Следующим шагом будет использование выбранного model_id для извлечения URI ресурсов SageMaker JumpStart, включая image_uri ( Реестр Amazon Elastic Container (Amazon ECR) URI для образа Docker), model_uri (предварительно обученный артефакт модели Amazon S3 URI) и script_uri (скрипт обучения):

Кроме того, в качестве места вывода задается папка в корзине S3.

Только один гиперпараметр, epochs, изменен на 3, а все остальные установлены по умолчанию:

Показатели обучения, такие как eval_loss (для потери валидации), loss (за потерю обучения) и epoch которые необходимо отслеживать, определены и перечислены:

Мы используем URI ресурсов SageMaker JumpStart (image_uri, model_uri, script_uri), определенный ранее, для создания средства оценки и его точной настройки на наборе обучающих данных, указав путь S3 к набору данных. Класс Estimator требует entry_point параметр. В этом случае JumpStart использует transfer_learning.py. Задание обучения не запускается, если это значение не установлено.

Выполнение этой учебной работы может занять несколько часов; поэтому рекомендуется установить для параметра ожидания значение False и отслеживать состояние задания обучения на консоли SageMaker. Использовать TrainingJobAnalytics функция для отслеживания показателей обучения в различные моменты времени:

Развертывание конечных точек вывода

Чтобы провести сравнения, мы используем конечные точки вывода как для предварительно обученных, так и для точно настроенных моделей.

Сначала получите URI образа Docker вывода, используя model_idи используйте этот URI для создания экземпляра предварительно обученной модели SageMaker. Разверните предварительно обученную модель, создав конечную точку HTTPS с предварительно созданным объектом модели. deploy() метод. Чтобы выполнить вывод через API SageMaker, обязательно передайте класс Predictor.

Повторите предыдущий шаг, чтобы создать экземпляр точно настроенной модели SageMaker и создать конечную точку для развертывания модели.

Оцените модели

Сначала установите длину сводного текста, количество выходных данных модели (должно быть больше 1, если необходимо создать несколько сводок) и количество лучей для лучевой поиск.

Создайте запрос вывода в виде полезных данных JSON и используйте его для запроса конечных точек предварительно обученных и точно настроенных моделей.

Вычислите агрегированную РУЖ забивает (ROUGE1, ROUGE2, ROUGEL, ROUGELsum), как описано ранее.

Сравните результаты

В следующей таблице показаны результаты оценки для dev1 и dev2 наборы данных. Результат оценки на dev1 (2,000 результатов из отчета MIMIC CXR Radiology) показывают улучшение совокупного среднего показателя примерно на 38 процентных пунктов. РУЖ1 и РУЖ2 баллы по сравнению с предварительно обученной моделью. Для dev2 улучшение на 31 процентный пункт и 25 процентных пунктов наблюдается в показателях ROUGE1 и ROUGE2. В целом точная настройка привела к улучшению показателей ROUGELsum на 38.2 процентных пункта и 31.3 процентных пункта для dev1 и dev2 наборы данных соответственно.

|

Оценка Dataset |

Предварительно обученная модель | Доработанная модель | ||||||

| РУЖЬ1 | РУЖЬ2 | РУЖЕЛЬ | РУЖЕЛЬСумма | РУЖЬ1 | РУЖЬ2 | РУЖЕЛЬ | РУЖЕЛЬСумма | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

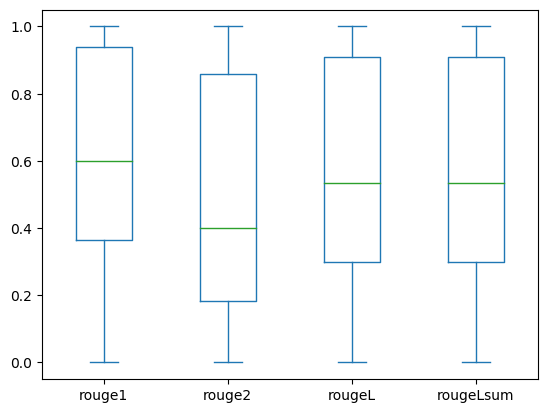

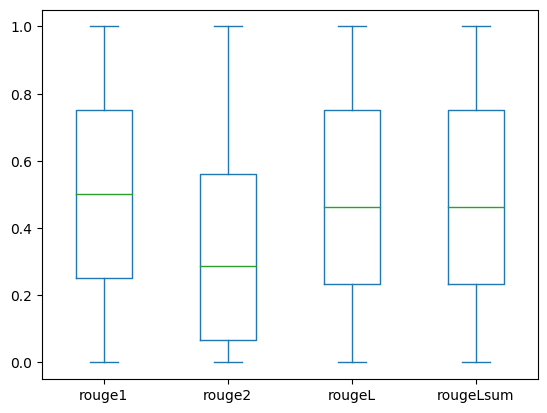

На следующих диаграммах показано распределение баллов ROUGE для dev1 и dev2 наборы данных оцениваются с использованием точно настроенной модели.

|

|

(а): dev1 |

(б): dev2 |

В следующей таблице показано, что баллы ROUGE для наборов оценочных данных имеют примерно одинаковую медиану и среднее значение и, следовательно, распределены симметрично.

| Datasets | Партитура | Количество | среднее | Стандартное отклонение | минимальный | 25% процентиль | 50% процентиль | 75% процентиль | максимальная |

dev1 |

РУЖЬ1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| РУЖ 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| РУЖ Л | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| РУЖЕЛЬСумма | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

РУЖ 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| РУЖ 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| РУЖ Л | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| РУЖ Лсум | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

Убирать

Чтобы избежать будущих расходов, удалите ресурсы, созданные вами с помощью следующего кода:

Заключение

В этом посте мы продемонстрировали, как точно настроить модель FLAN-T5 XL для задачи обобщения конкретной клинической области с помощью SageMaker Studio. Чтобы повысить уверенность, мы сравнили прогнозы с реальными и оценили результаты с использованием показателей ROUGE. Мы продемонстрировали, что модель, точно настроенная для конкретной задачи, дает лучшие результаты, чем модель, предварительно обученная для выполнения общей задачи НЛП. Хотим отметить, что тонкая настройка LLM общего назначения вообще исключает затраты на предварительное обучение.

Хотя представленная здесь работа сосредоточена на отчетах о рентгенографии грудной клетки, ее можно расширить до более крупных наборов данных с различной анатомией и модальностями, таких как МРТ и КТ, для которых отчеты о радиологии могут быть более сложными и содержать множество результатов. В таких случаях рентгенологи могут составить впечатления в порядке критичности и включить рекомендации по дальнейшему наблюдению. Кроме того, создание контура обратной связи для этого приложения позволит рентгенологам со временем улучшить производительность модели.

Как мы показали в этом посте, точно настроенная модель генерирует показы для радиологических отчетов с высокими показателями ROUGE. Вы можете попытаться настроить LLM на другие медицинские отчеты из разных отделов, специфичные для конкретной области.

Об авторах

Доктор Адевале Акинфадерин — старший специалист по данным в сфере здравоохранения и биологических наук в AWS. Его опыт заключается в воспроизводимых и комплексных методах искусственного интеллекта и машинного обучения, их практическом внедрении и оказании помощи клиентам здравоохранения по всему миру в формулировании и разработке масштабируемых решений междисциплинарных проблем. Имеет две ученые степени по физике и степень доктора технических наук.

Доктор Адевале Акинфадерин — старший специалист по данным в сфере здравоохранения и биологических наук в AWS. Его опыт заключается в воспроизводимых и комплексных методах искусственного интеллекта и машинного обучения, их практическом внедрении и оказании помощи клиентам здравоохранения по всему миру в формулировании и разработке масштабируемых решений междисциплинарных проблем. Имеет две ученые степени по физике и степень доктора технических наук.

Прия Падате — старший архитектор решений для партнеров с обширным опытом в сфере здравоохранения и биологических наук в AWS. Прия вместе с партнерами разрабатывает стратегии выхода на рынок и стимулирует разработку решений для ускорения разработки на основе искусственного интеллекта и машинного обучения. Она увлечена использованием технологий для преобразования отрасли здравоохранения и улучшения результатов лечения пациентов.

Прия Падате — старший архитектор решений для партнеров с обширным опытом в сфере здравоохранения и биологических наук в AWS. Прия вместе с партнерами разрабатывает стратегии выхода на рынок и стимулирует разработку решений для ускорения разработки на основе искусственного интеллекта и машинного обучения. Она увлечена использованием технологий для преобразования отрасли здравоохранения и улучшения результатов лечения пациентов.

Экта Валия Бхуллар, доктор философии, старший консультант по искусственному интеллекту и машинному обучению в бизнес-подразделении профессиональных услуг AWS Healthcare and Life Sciences (HCLS). Она имеет обширный опыт применения ИИ/МО в сфере здравоохранения, особенно в радиологии. Вне работы, когда она не обсуждает искусственный интеллект в радиологии, она любит бегать и ходить в походы.

Экта Валия Бхуллар, доктор философии, старший консультант по искусственному интеллекту и машинному обучению в бизнес-подразделении профессиональных услуг AWS Healthcare and Life Sciences (HCLS). Она имеет обширный опыт применения ИИ/МО в сфере здравоохранения, особенно в радиологии. Вне работы, когда она не обсуждает искусственный интеллект в радиологии, она любит бегать и ходить в походы.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Автомобили / электромобили, Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- ЧартПрайм. Улучшите свою торговую игру с ChartPrime. Доступ здесь.

- Смещения блоков. Модернизация права собственности на экологические компенсации. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :имеет

- :является

- :нет

- :куда

- $UP

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- в состоянии

- О нас

- ускорять

- ускоренный

- Доступ

- выполнять

- скапливаться

- Дополнительно

- достижения

- против

- агрегирование

- ДОГОВОР

- AI

- AI / ML

- алгоритмы

- Все

- позволяет

- уже

- причислены

- в целом

- Amazon

- Создатель мудреца Амазонки

- Amazon Web Services

- суммы

- an

- анализ

- и

- Другой

- любой

- API

- Применение

- подхода

- примерно

- архитектура

- МЫ

- аргумент

- AS

- оценки;

- At

- Автоматический

- автоматически

- Автоматизация

- доступен

- в среднем

- избежать

- AWS

- Использование темпера с изогнутым основанием

- основанный

- BE

- , так как:

- до

- не являетесь

- Преимущества

- Лучшая

- между

- больший

- миллиарды

- изоферменты печени

- Границы

- Коробка

- бремя

- бизнес

- но

- by

- под названием

- CAN

- кандидат

- возможности

- углерод

- заботится

- случаев

- случаев

- менялась

- расходы

- Выбирая

- класс

- Уборка

- Очистить

- Клинический

- клиницисты

- код

- лыжных шлемов

- Общий

- обычно

- сравнить

- сравненный

- полный

- завершение

- комплекс

- компоненты

- комплексный

- вычисление

- вычисление

- краткий

- доверие

- последовательный

- состоит

- Консоли

- консультант

- содержать

- Container

- содержание

- содержание

- контраст

- Беседы

- соответствует

- Цена

- дорогостоящий

- Расходы

- может

- Пара

- Создайте

- создали

- Создающий

- критической

- критичность

- изготовленный на заказ

- Клиенты

- приборная панель

- данным

- ученый данных

- Наборы данных

- Принятие решений

- По умолчанию

- определенный

- Степень

- Демографическая

- демонстрировать

- убивают

- демонстрирует

- ведомства

- развертывание

- развернуть

- развертывание

- описывать

- описано

- подробный

- подробнее

- развивать

- Развитие

- различный

- непосредственно

- обсуждать

- обсуждающий

- распределенный

- распределение

- Docker

- Врачи

- Документация

- домен

- доменов

- Dont

- рисовать

- управлять

- диски

- в течение

- каждый

- Ранее

- усилие

- или

- ликвидирует

- еще

- включить

- позволяет

- впритык

- Конечная точка

- Проект и

- расширение

- достаточно

- Весь

- Окружающая среда

- эпоха

- эпохи

- ошибка

- особенно

- существенный

- оценивать

- оценивается

- оценки

- оценка

- экзамен

- пример

- Примеры

- выполнять

- расширенный

- опыт

- опыта

- обширный

- Богатый опыт

- извлечение

- не удается

- ложный

- Обратная связь

- фигура

- Файл

- Файлы

- результаты

- Фокус

- фокусируется

- после

- следующим образом

- Что касается

- форма

- формат

- Год основания

- от

- функция

- далее

- Более того

- будущее

- Общие

- общее назначение

- порождать

- генерируется

- генерирует

- поколение

- генеративный

- Генеративный ИИ

- получить

- данный

- Глобальный

- Иди в магазин

- выпускник

- большой

- земля

- Есть

- имеющий

- he

- Медицина

- информация о здоровье

- здравоохранение

- медицинской отрасли

- помощь

- помощь

- помогает

- здесь

- High

- выделив

- Поход

- его

- история

- кашель

- ЧАСЫ

- Как

- How To

- HTML

- HTTP

- HTTPS

- хаб

- ОбниматьЛицо

- человек

- ID

- идеи

- идентифицированный

- if

- иллюстрирует

- изображение

- изображений

- Изображениями

- эффектных

- осуществлять

- реализации

- Импортировать

- важную

- улучшать

- улучшение

- in

- включают

- В том числе

- Увеличение

- промышленность

- информация

- информативный

- вход

- устанавливать

- пример

- интерактивный

- интерпретация

- в

- Изобретение

- IT

- работа

- Джобс

- JSON

- всего

- только один

- Сохранить

- Основные

- этикетка

- язык

- большой

- запуск

- изучение

- привело

- Длина

- ЖИЗНЬЮ

- Медико-биологическая промышленность

- такое как

- нравится

- ОГРАНИЧЕНИЯ

- линия

- Список

- Включенный в список

- LLM

- расположенный

- расположение

- от

- машина

- обучение с помощью машины

- сделать

- Май..

- значить

- основным медицинским

- средний

- Память

- метод

- методы

- метрический

- Метрика

- может быть

- Минут

- ML

- модель

- Модели

- монитор

- БОЛЕЕ

- самых

- МРТ

- много

- с разными

- Музыка

- должен

- имя

- натуральный

- Обработка естественного языка

- необходимо

- Необходимость

- сеть

- нейронной сети

- Новые

- вновь

- следующий

- НЛП

- ноутбук

- сейчас

- номер

- объект

- полученный

- of

- предлагающий

- .

- on

- Вводный

- ONE

- только

- оптимизирующий

- or

- заказ

- оригинал

- Другое

- наши

- внешний

- Результаты

- выходной

- внешнюю

- за

- общий

- переопределение

- обзор

- пакеты

- пара

- пар

- параметр

- параметры

- часть

- особый

- партнер

- партнеры

- pass

- страстный

- путь

- пациент

- пациентов

- процент

- Выполнять

- производительность

- кандидат наук

- Физика

- штук

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- Точка

- пунктов

- После

- потенциал

- Питание

- практическое

- Predictions

- Predictor

- представлены

- разрабатывает

- в первую очередь

- Проблема

- проблемам

- процесс

- обработка

- Произведенный

- профессиональный

- Профиль

- предлагает

- предложило

- защищенный

- при условии

- поставщики

- приводит

- публично

- Питон

- количественный

- Читать

- Reading

- последний

- рекомендаций

- Управление по борьбе с наркотиками (DEA)

- снижает

- Рекомендации

- назвало

- понимается

- регулярное выражение

- Регистрация

- Связанный

- соответствующие

- замечательный

- заменить

- отчету

- Reporting

- Отчеты

- запросить

- обязательный

- требуется

- ресурс

- Полезные ресурсы

- соответственно

- ОТДЫХ

- результат

- Итоги

- Возвращает

- Рост

- Run

- Бег

- sagemaker

- то же

- масштабируемые

- НАУКА

- Ученый

- поцарапать

- SDK

- Поиск

- секунды

- Раздел

- разделах

- посмотреть

- выбранный

- старший

- чувствительный

- предложение

- отдельный

- обслуживание

- Услуги

- выступающей

- набор

- установка

- настройки

- она

- должен

- показал

- показанный

- Шоу

- значение

- значительный

- просто

- просто

- небольшой

- So

- Решение

- Решения

- РЕШАТЬ

- некоторые

- пролет

- специализированный

- конкретный

- конкретно

- указанный

- Начало

- и политические лидеры

- современное состояние

- Статус:

- Шаг

- Шаги

- По-прежнему

- диск

- магазин

- Истории

- стратегий

- Стратегия

- студия

- такие

- РЕЗЮМЕ

- Убедитесь

- ТАБЛИЦЫ

- взять

- принимает

- Сложность задачи

- задачи

- Технологии

- чем

- который

- Ассоциация

- Их

- тогда

- Там.

- тем самым

- следовательно

- Эти

- этой

- те

- три

- Через

- время

- в

- слишком

- Темы

- трек

- Train

- Обучение

- перевод

- Transform

- трансформатор

- Переводы

- Правда

- стараться

- два

- напишите

- типичный

- нижнее подчеркивание

- понимание

- унифицированный

- Ед. изм

- Университет

- загружено

- использование

- используемый

- Информация о пользователе

- использования

- через

- Проверка

- ценностное

- Наши ценности

- различный

- Огромная

- версия

- с помощью

- Видео

- Виртуальный

- ждать

- законопроект

- we

- Web

- веб-сервисы

- Вебсайт

- когда

- , которые

- в то время как

- ширина

- будете

- в

- без

- Word

- слова

- Работа

- рабочий

- бы

- письмо

- рентгеновский

- лет

- Ты

- ВАШЕ

- зефирнет