искусственный интеллект развивается так быстро, что даже некоторые из ученых, ответственных за многие ключевые разработки, обеспокоены темпами изменений. Ранее в этом году более 300 специалистов, работающих в области искусственного интеллекта, и другие заинтересованные общественные деятели опубликовали прямое предупреждение об опасности, которую представляет технология, сравнивая риск с пандемией или ядерной войной.

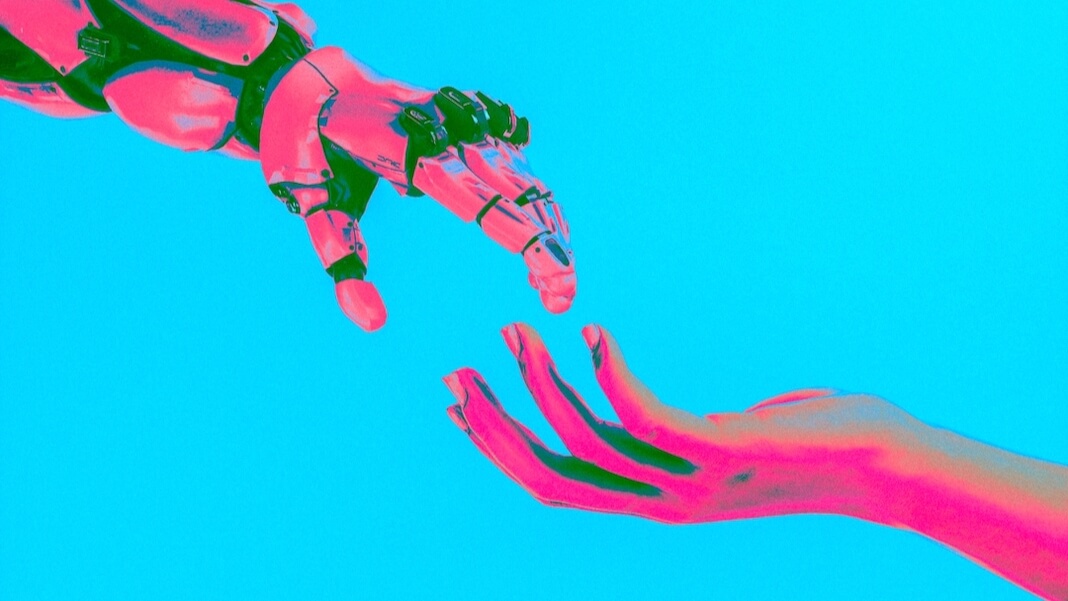

Прямо под поверхностью этих проблем скрывается вопрос машинного сознания. Даже если внутри современных ИИ «никого нет дома», некоторые исследователи задаются вопросом, смогут ли они когда-нибудь продемонстрировать проблески сознания — или даже больше. Если это произойдет, это вызовет множество моральных и этических проблем, говорит Джонатан Берч, профессор философии Лондонской школы экономики и политических наук.

По мере развития технологии ИИ этические вопросы, возникающие в связи с взаимодействием человека и ИИ, приобретают новую остроту. «Мы не знаем, ввести ли их в наш моральный круг или исключить», — сказал Берч. «Мы не знаем, какие будут последствия. И я серьезно отношусь к этому как к подлинному риску, о котором мы должны начать говорить. Не совсем потому, что я думаю ChatGPT относится к этой категории, а потому, что я не знаю, что произойдет в следующие 10 или 20 лет».

Тем временем, говорит он, мы могли бы преуспеть в изучении других нечеловеческих разумов, например, животных. Берч возглавляет университет Основы проекта Animal Sentience, усилия, финансируемого Европейским союзом, которое, как выразился Берч, «нацелено попытаться добиться некоторого прогресса в важных вопросах разума животных». «Как нам разработать более эффективные методы научного изучения сознательного опыта животных? И как мы можем заставить зарождающуюся науку о разуме животных работать, чтобы разработать лучшую политику, законы и способы заботы о животных?»

Наше интервью было проведено через Zoom и по электронной почте, и оно было отредактировано для увеличения длины и ясности.

(Эта статья изначально была опубликована в Undark, Прочтите оригинал статьи.)

Темный: Продолжаются споры о том, может ли ИИ быть сознательным или разумным. И, похоже, существует параллельный вопрос о том, может ли ИИ казаться быть разумным. Почему это различие так важно?

Джонатан Берч: Я думаю, что это огромная проблема, и на самом деле то, что должно нас сильно напугать. Даже сейчас системы ИИ вполне способны убедить своих пользователей в своей разумности. Мы видели это в прошлом году на примере Блейка Лемуана, инженера Google, который убедился что система, над которой он работал, была разумной — и это только тогда, когда вывод — чисто текст, а пользователь — высококвалифицированный эксперт по искусственному интеллекту.

Итак, представьте себе ситуацию, когда ИИ может управлять человеческим лицом и человеческим голосом, а пользователь неопытен. Я думаю, что ИИ уже находится в том положении, когда он может довольно легко убедить большое количество людей в том, что он является разумным существом. И это большая проблема, потому что я думаю, что мы начнем видеть людей, выступающих за благополучие ИИ, права ИИ, и тому подобные вещи.

И мы не будем знать, что с этим делать. Потому что нам нужен действительно сильный сокрушительный аргумент, доказывающий, что системы ИИ, о которых они говорят, не сознательный. А у нас этого нет. Наше теоретическое понимание сознания недостаточно зрело, чтобы мы могли с уверенностью заявить о его отсутствии.

UD: Робот или систему искусственного интеллекта можно запрограммировать так, чтобы она говорила что-то вроде: «Прекрати, ты делаешь мне больно». Но простого заявления такого рода недостаточно, чтобы служить лакмусовой бумажкой для разума, верно?

JB: У вас могут быть очень простые системы [подобные тем], которые были разработаны в Имперском колледже Лондона, чтобы помочь врачам в их обучении, которое имитировать выражение человеческой боли. И нет абсолютно никаких оснований считать эти системы разумными. На самом деле они не чувствуют боли; все, что они делают, — это очень простым способом сопоставляют входные данные с выходными. Но выражения боли, которые они производят, вполне правдоподобны.

Я думаю, что мы находимся в похожем положении с чат-ботами, такими как ChatGPT, — они обучены более чем триллиону слов обучающих данных, чтобы имитировать модели ответов человека, чтобы реагировать так, как ответил бы человек.

Так что, конечно, если вы дадите ему подсказку, на которую человек отреагирует выражением боли, он сможет умело имитировать эту реакцию.

Но я думаю, когда мы знаем, что это ситуация — когда мы знаем, что имеем дело с искусной мимикой — нет веских причин думать, что за этим стоит какое-то реальное переживание боли.

UD: Эта сущность, на которой тренируются студенты-медики, я полагаю, что-то вроде робота?

JB: Это верно, да. Таким образом, у них есть манекен с человеческим лицом, и врач может нажимать на руку и получать выражение, имитирующее выражения, которые люди выражали бы при различной степени давления. Это должно помочь врачам научиться правильно применять техники на пациентах, не причиняя слишком много боли.

И нас очень легко обмануть, как только у чего-то появляется человеческое лицо и выражение лица, как у человека, даже если за этим вообще не стоит никакого реального разума.

Итак, если вы представите, что в паре с ИИ, который мы видим в ChatGPT, у вас есть своего рода мимикрия, которая действительно очень убедительна, и это убедит многих людей.

UD: Чувство кажется чем-то, что мы знаем, так сказать, изнутри. Мы понимаем наше собственное сознание, но как проверить сознание других, будь то ИИ или любая другая сущность помимо нас самих?

JB: Я думаю, что мы находимся в очень сильной позиции с другими людьми, которые могут говорить с нами, потому что у нас есть невероятно богатый набор доказательств. И лучшим объяснением этого является то, что у других людей есть сознательный опыт, как и у нас. И поэтому мы можем использовать такой вывод, который философы иногда называют «выводом к лучшему объяснению».

Я думаю, что мы можем подойти к теме других животных точно так же — что другие животные не разговаривают с нами, но они демонстрируют поведение, которое очень естественно объясняется приписыванием состояний, таких как боль. Например, если вы видите собаку, которая зализывает свои раны после травмы, ухаживает за этим участком, учится избегать мест, где существует риск получения травмы, вы, естественно, объясните этот паттерн поведения, постулируя состояние боли.

И я думаю, что когда мы имеем дело с другими животными, у которых нервная система очень похожа на нашу, и которые эволюционировали точно так же, как и мы, я думаю, что такой вывод вполне разумен.

УД: А как насчет системы ИИ?

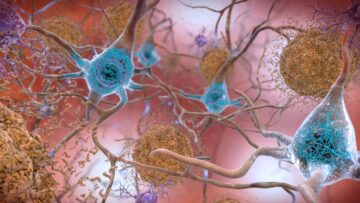

JB: В случае с ИИ у нас есть огромная проблема. У нас прежде всего проблема в том, что подложка отличается. На самом деле мы не знаем, чувствителен ли сознательный опыт к субстрату — должен ли он иметь биологический субстрат, то есть нервную систему, мозг? Или этого можно добиться в совершенно другом материале — подложке на основе кремния?

Но есть также проблема, которую я назвал «игровой проблемой»: когда система имеет доступ к триллионам слов обучающих данных и была обучена с целью имитации человеческого поведения, виды поведенческих паттернов, которые она производит, могут быть изменены. быть объяснено тем, что он действительно имеет сознательный опыт. Или, наоборот, они могут быть просто объяснены тем, что перед ними ставится цель вести себя так, как человек повел бы себя в этой ситуации.

Так что я действительно думаю, что в случае с ИИ у нас проблемы, потому что мы вряд ли окажемся в положении, когда очевидно лучшее объяснение того, что мы видим, — то, что ИИ обладает сознанием. Всегда найдутся правдоподобные альтернативные объяснения. И выйти из этого плена очень сложно.

UD: Что, по-твоему, может быть нашим лучшим выбором для различения чего-то, что на самом деле имеет сознание, от сущности, которая просто обладает сознанием? внешний вид чувства?

JB: Я думаю, что первый этап заключается в том, чтобы признать это очень глубокой и сложной проблемой. Второй этап — попытаться узнать как можно больше на примере других животных. Я думаю, когда мы изучаем животных, которые очень близки нам в эволюционном плане, например, собак и других млекопитающих, мы всегда не уверены, может ли сознательный опыт зависеть от очень специфических мозговых механизмов, характерных для мозга млекопитающих.

Чтобы обойти это, нам нужно рассмотреть как можно более широкий круг животных. И нам нужно думать, в частности, о беспозвоночных, таких как осьминоги и насекомые, где это потенциально еще один независимо развившийся случай сознательного опыта. Точно так же, как глаз осьминога развился совершенно отдельно от наших собственных глаз — в нем есть эта очаровательная смесь сходства и различия — я думаю, что его сознательный опыт будет таким же: независимо эволюционировать, в чем-то похожим, очень, очень отличным в своем. другие способы.

И изучая опыт беспозвоночных, таких как осьминоги, мы можем начать понимать, какими действительно глубокими особенностями должен обладать мозг, чтобы поддерживать сознательный опыт, вещи, которые идут глубже, чем просто наличие этих специфических структур мозга, которые там у млекопитающих. Какие виды вычислений необходимы? Какие виды обработки?

Тогда — и я рассматриваю это как долгосрочную стратегию — мы могли бы вернуться к случаю с ИИ и сказать: есть ли у него те особые виды вычислений, которые мы находим у сознательных животных, таких как млекопитающие и осьминоги?

UD: Верите ли вы, что однажды мы создадим разумный ИИ?

JB: У меня примерно 50:50. Есть шанс, что чувствительность зависит от особенностей биологического мозга, и неясно, как это проверить. Поэтому я думаю, что в ИИ всегда будет существенная неопределенность. Я более уверен в этом: если сознание может в принципе быть достигнуто в компьютерном программном обеспечении, тогда исследователи ИИ найдут способ сделать это.

Изображение Фото: Кэш Маканая / Unsplash

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Автомобили / электромобили, Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- Смещения блоков. Модернизация права собственности на экологические компенсации. Доступ здесь.

- Источник: https://singularityhub.com/2023/07/17/studying-animal-sentience-could-help-solve-the-ethical-puzzle-of-sentient-ai/

- :имеет

- :является

- :нет

- :куда

- $UP

- 10

- 20

- 20 лет

- 50

- a

- в состоянии

- О нас

- абсолютно

- AC

- доступ

- достигнутый

- фактического соединения

- на самом деле

- боящийся

- После

- AI

- Все

- позволять

- уже

- причислены

- альтернатива

- всегда

- am

- an

- и

- животное

- животные

- Другой

- любой

- подхода

- надлежащим образом

- МЫ

- ПЛОЩАДЬ

- аргумент

- ARM

- гайд

- AS

- At

- избежать

- назад

- BBC

- BE

- , так как:

- было

- поведение

- поведения

- за

- не являетесь

- верить

- ниже

- ЛУЧШЕЕ

- Ставка

- Лучшая

- между

- Beyond

- большой

- связывать

- Бленд

- тело

- Мозг

- приносить

- но

- by

- призывают

- под названием

- агитация

- CAN

- способный

- нести

- случаев

- Категории

- Причинение

- шанс

- изменение

- chatbots

- ChatGPT

- Circle

- ясность

- Очистить

- явно

- Закрыть

- Колледж

- сравнив

- полностью

- вычисление

- компьютер

- обеспокоенный

- Обеспокоенность

- проводятся

- уверенный

- уверенно

- сознательный

- Сознание

- Последствия

- контроль

- убеждать

- может

- "Курс"

- Создайте

- кредит

- ОПАСНО!

- данным

- день

- занимавшийся

- дебаты

- глубоко

- более глубокий

- зависит

- Проект

- развивать

- развитый

- события

- различный

- трудный

- Дисплей

- различие

- отличительный

- do

- врач

- Врачи

- приносит

- Собака

- дело

- Dont

- Ранее

- легко

- Экономика

- Edge

- усилие

- появление

- инженер

- достаточно

- полностью

- организация

- этический

- Европейская кухня

- Даже

- , поскольку большинство сенаторов

- эволюционировали

- точно,

- пример

- проявлять

- опыт

- Впечатления

- эксперту

- Объяснять

- объяснены

- объяснение

- выражение

- выражения

- Глаза

- Face

- увлекательный

- Особенности

- цифры

- Найдите

- Во-первых,

- Что касается

- вперед

- от

- подлинный

- получить

- Дайте

- Go

- цель

- будет

- происходить

- происходит

- Есть

- имеющий

- he

- помощь

- очень

- Как

- How To

- HTTPS

- огромный

- человек

- Людей

- i

- if

- картина

- императорский

- Имперском Колледже

- Имперский колледж Лондона

- важную

- in

- В других

- невероятно

- самостоятельно

- затраты

- внутри

- пример

- Интеллекта

- взаимодействие

- Интервью

- в

- Выпущен

- IT

- ЕГО

- всего

- Основные

- Вид

- Знать

- большой

- Фамилия

- В прошлом году

- Законодательство

- Лиды

- прыжки

- УЧИТЬСЯ

- изучение

- оставил

- Длина

- облизывание

- такое как

- Лондон

- Длинное

- посмотреть

- серия

- LSE

- машина

- сделать

- ДЕЛАЕТ

- Создание

- многих

- отображение

- зрелый

- Май..

- me

- то время

- механизмы

- основным медицинским

- методы

- может быть

- моральный

- БОЛЕЕ

- много

- природа

- Необходимость

- необходимый

- Новые

- следующий

- нет

- сейчас

- ядерный

- номера

- of

- on

- ONE

- постоянный

- or

- заказ

- первоначально

- Другое

- Другое

- наши

- себя

- внешний

- выходной

- за

- собственный

- Темп

- боль

- в паре

- Пандемия

- Параллельные

- особый

- мимо

- пациентов

- шаблон

- паттеранами

- Люди

- философия

- Мест

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- правдоподобный

- сборах

- политический

- представляет

- должность

- потенциально

- нажмите

- давление

- Проблема

- обработка

- производит

- производит

- профессионалы

- Профессор

- запрограммированный

- Прогресс

- прогрессировал

- доказывает

- что такое варган?

- опубликованный

- чисто

- положил

- головоломка

- вопрос

- Вопросы

- повышение

- ассортимент

- быстро

- Читать

- реальные

- на самом деле

- причина

- разумный

- признавать

- исследователи

- Реагируйте

- ответ

- ответственный

- Богатые

- правую

- Снижение

- робот

- Сказал

- то же

- видел

- сообщили

- говорит

- Школа

- Наука

- Ученые

- Во-вторых

- посмотреть

- кажется

- чувствительный

- серьезно

- служить

- набор

- должен

- аналогичный

- сходство

- просто

- ситуация

- квалифицированный

- So

- Software

- РЕШАТЬ

- некоторые

- удалось

- в некотором роде

- скоро

- вызвало

- говорить

- особый

- конкретный

- Этап

- Начало

- Область

- Области

- Стратегия

- сильный

- Студенты

- Кабинет

- изучение

- существенный

- поддержка

- Поверхность

- система

- системы

- взять

- приняты

- Говорить

- говорить

- снижения вреда

- Технологии

- terms

- тестXNUMX

- чем

- который

- Ассоциация

- их

- Их

- тогда

- теоретический

- Там.

- Эти

- они

- задача

- вещи

- think

- мышление

- этой

- В этом году

- те

- Через

- в

- Сегодняшних

- слишком

- тема

- ПОЛНОСТЬЮ

- специалистов

- Обучение

- Триллион

- триллионы

- беда

- стараться

- Неопределенность

- понимать

- понимание

- вряд ли

- острая необходимость

- us

- использование

- Информация о пользователе

- пользователей

- Против

- очень

- Режимы

- войны

- законопроект

- Путь..

- способы

- we

- Благосостояние

- ЧТО Ж

- Что

- когда

- будь то

- , которые

- КТО

- зачем

- широкий

- будете

- без

- слова

- Работа

- работает

- бы

- даст

- раны

- год

- лет

- Да

- Ты

- зефирнет

- зум