В динамичном мире потокового вещания Amazon Музыка, каждый поиск песни, подкаста или плейлиста несет в себе историю, настроение или поток эмоций, ожидающих раскрытия. Эти поиски служат воротами к новым открытиям, заветному опыту и незабываемым воспоминаниям. Панель поиска предназначена не только для поиска песни; речь идет о миллионах активных пользователей, начинающих свое личное путешествие в богатый и разнообразный мир, который может предложить Amazon Music.

Для обеспечения превосходного качества обслуживания клиентов, позволяющего мгновенно находить музыку, которую ищут пользователи, требуется умная и отзывчивая платформа. Amazon Music использует для этого возможности искусственного интеллекта. Однако оптимизировать качество обслуживания клиентов при одновременном управлении затратами на обучение и выводе моделей искусственного интеллекта, которые обеспечивают возможности панели поиска, такие как проверка орфографии в реальном времени и векторный поиск, сложно в периоды пиковой нагрузки.

Создатель мудреца Амазонки предоставляет комплексный набор сервисов, которые позволяют Amazon Music создавать, обучать и развертывать в облаке AWS с минимальными усилиями. Взяв на себя недифференцированную тяжелую работу, SageMaker позволяет вам сосредоточиться на работе над моделями машинного обучения (ML) и не беспокоиться о таких вещах, как инфраструктура. В рамках модели общей ответственности SageMaker обеспечивает надежность, производительность и масштабируемость предоставляемых услуг, а вы следите за тем, чтобы применение моделей машинного обучения максимально эффективно использовало возможности, предоставляемые SageMaker.

В этом посте мы расскажем, как Amazon Music оптимизировала производительность и затраты с помощью SageMaker, сервера вывода NVIDIA Triton и TensorRT. Мы углубимся в демонстрацию того, как работает эта, казалось бы, простая, но сложная панель поиска, обеспечивающая непрерывное путешествие во вселенную Amazon Music с практически нулевыми неприятными задержками из-за опечаток и релевантными результатами поиска в реальном времени.

Amazon SageMaker и NVIDIA: обеспечение быстрого и точного векторного поиска и проверки орфографии

Amazon Music предлагает обширную библиотеку, насчитывающую более 100 миллионов песен и миллионы эпизодов подкастов. Однако найти нужную песню или подкаст может быть непросто, особенно если вы не знаете точного названия, исполнителя или названия альбома или если искомый запрос очень широк, например «новостные подкасты».

Amazon Music применила двойной подход для улучшения процесса поиска и извлечения информации. Первым шагом является внедрение векторного поиска (также известного как поиск на основе внедрения), метода машинного обучения, который может помочь пользователям находить наиболее релевантный контент, который они ищут, используя семантику контента. Второй шаг включает в себя введение модели коррекции орфографии на основе Transformer в стек поиска. Это может быть особенно полезно при поиске музыки, поскольку пользователи не всегда могут знать точное написание названия песни или имени исполнителя. Исправление орфографии может помочь пользователям найти нужную музыку, даже если они допустили орфографическую ошибку в своем поисковом запросе.

Внедрение моделей Transformer в конвейер поиска и извлечения (при генерации встраивания запроса, необходимого для векторного поиска, и генеративной модели Seq2Seq Transformer в коррекции орфографии) может привести к значительному увеличению общей задержки, что отрицательно скажется на качестве обслуживания клиентов. Поэтому для нас стало главным приоритетом оптимизировать задержку вывода в реальном времени для моделей векторного поиска и исправления орфографии.

Amazon Music и NVIDIA объединились, чтобы обеспечить наилучшее качество обслуживания клиентов при использовании панели поиска, используя SageMaker для реализации как быстрой и точной проверки орфографии, так и предложений семантического поиска в реальном времени с использованием методов векторного поиска. Решение включает в себя использование хостинга SageMaker на базе экземпляров G5, использующих графические процессоры NVIDIA A10G с тензорными ядрами, поддерживаемый SageMaker серверный контейнер NVIDIA Triton Inference и NVIDIA ТензорРТ формат модели. Уменьшив задержку вывода модели проверки орфографии до 25 миллисекунд при пиковом трафике, а также сократив задержку генерации поискового запроса в среднем на 63 % и стоимость на 73 % по сравнению с выводом на основе ЦП, Amazon Music повысила производительность панели поиска.

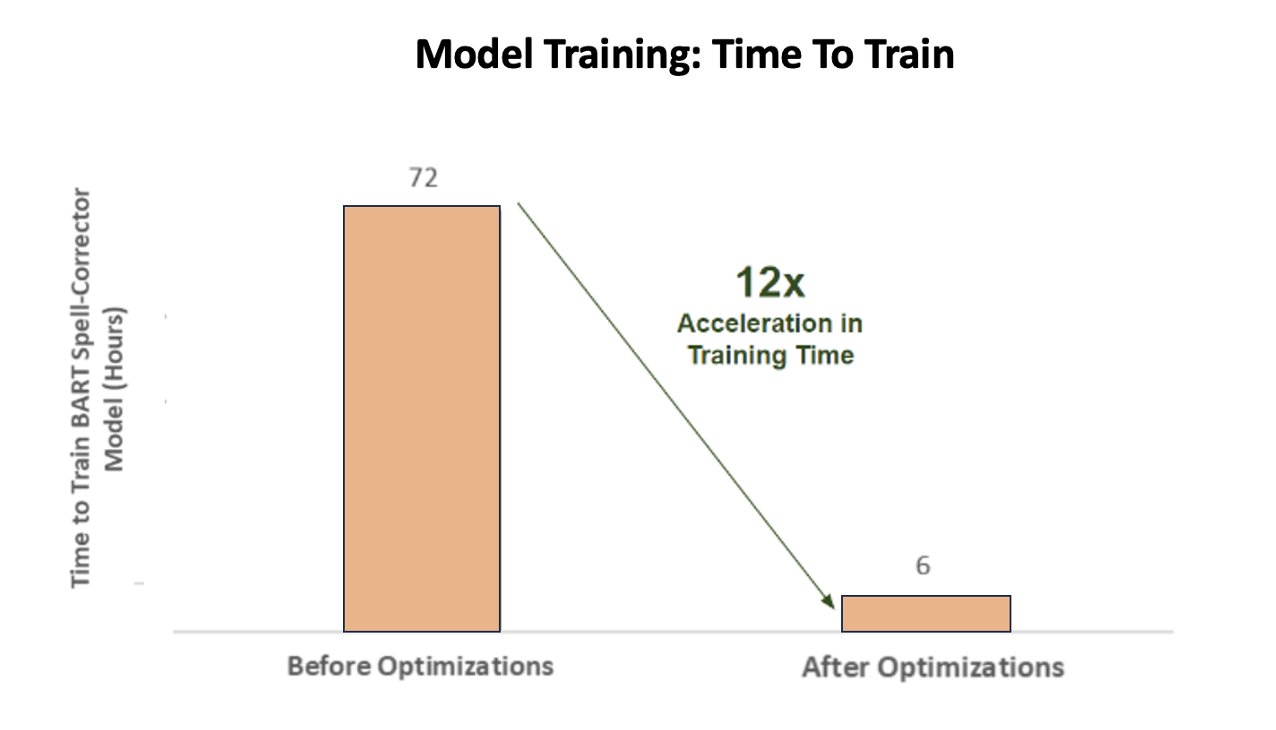

Кроме того, при обучении модели искусственного интеллекта для получения точных результатов компания Amazon Music добилась колоссального 12-кратного ускорения времени обучения для своей модели преобразователя корректора заклинаний BART, сэкономив время и деньги за счет оптимизации использования графического процессора.

Amazon Music заключила партнерское соглашение с NVIDIA, чтобы уделить приоритетное внимание поиску клиентов и создать панель поиска с хорошо оптимизированными функциями проверки орфографии и векторного поиска. В следующих разделах мы подробнее расскажем о том, как были организованы эти оптимизации.

Оптимизация обучения с помощью графических процессоров NVIDIA Tensor Core

Получить доступ к графическому процессору NVIDIA Tensor Core для обучения больших языковых моделей недостаточно, чтобы раскрыть его истинный потенциал. Существуют ключевые шаги по оптимизации, которые необходимо выполнить во время обучения, чтобы максимально эффективно использовать графический процессор. Однако недостаточное использование графического процессора, несомненно, приведет к неэффективному использованию ресурсов, увеличению продолжительности обучения и увеличению эксплуатационных затрат.

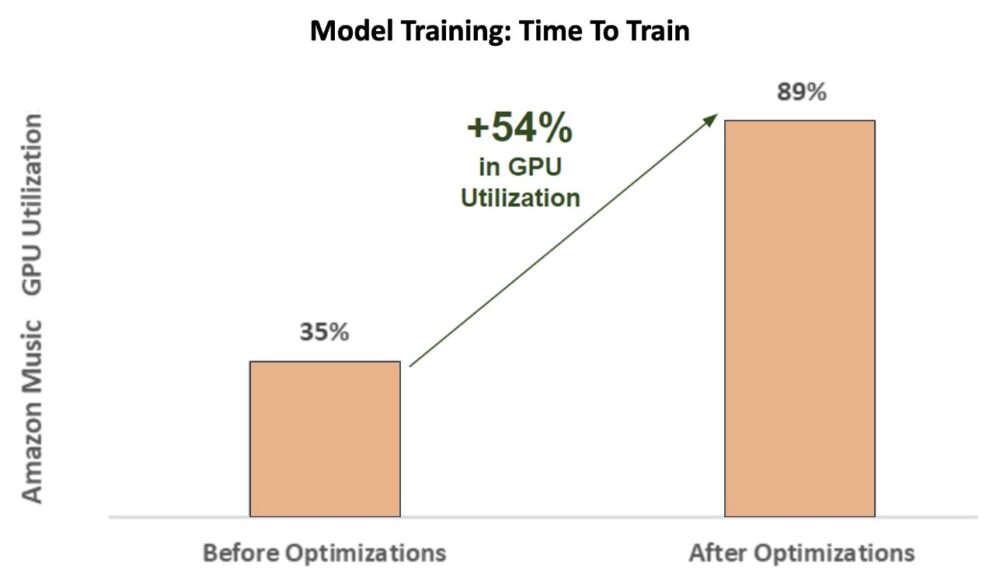

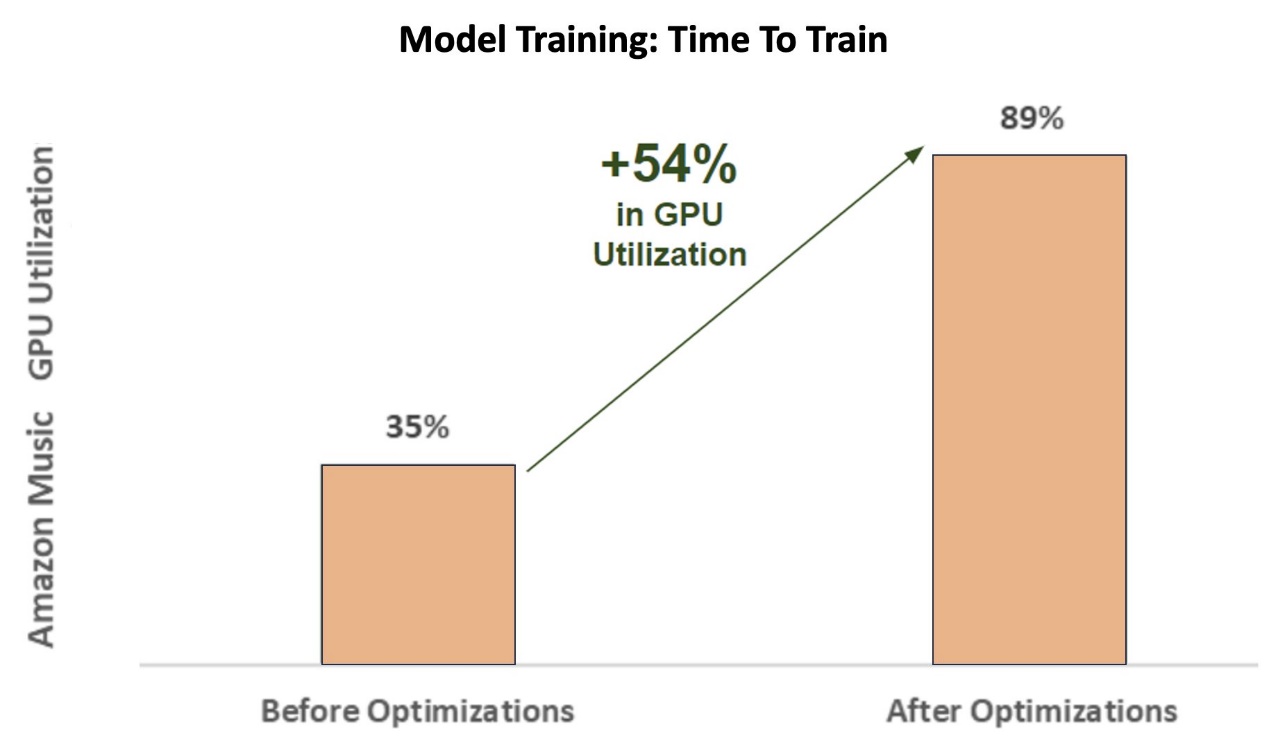

На начальных этапах обучения корректор заклинаний БАРТ (барт-база) модели трансформера на экземпляре SageMaker ml.p3.24xlarge (8 графических процессоров NVIDIA V100 с тензорными ядрами), загрузка графического процессора Amazon Music составила около 35%. Чтобы максимизировать преимущества обучения с ускорением на графическом процессоре NVIDIA, AWS и архитекторы решений NVIDIA поддержали Amazon Music в определении областей для оптимизации, особенно в отношении размера пакета и параметров точности. Эти два важнейших параметра влияют на эффективность, скорость и точность обучения моделей глубокого обучения.

В результате оптимизации было получено новое улучшенное использование графического процессора V100, стабильное на уровне около 89 %, что резко сократило время обучения Amazon Music с 3 дней до 5–6 часов. Переключив размер пакета с 32 на 256 и используя методы оптимизации, такие как запуск автоматическое обучение смешанной точности вместо того, чтобы использовать только точность FP32, Amazon Music смогла сэкономить время и деньги.

На следующей диаграмме показано увеличение использования графического процессора на 54 % после оптимизации.

На следующем рисунке показано ускорение времени обучения.

Такое увеличение размера пакета позволило графическому процессору NVIDIA обрабатывать значительно больше данных одновременно на нескольких тензорных ядрах, что привело к ускорению времени обучения. Однако важно поддерживать тонкий баланс с памятью, поскольку для больших размеров пакетов требуется больше памяти. Как увеличение размера пакета, так и использование смешанной точности могут иметь решающее значение для раскрытия мощи графических процессоров NVIDIA Tensor Core.

После того как модель была обучена конвергенции, пришло время оптимизировать ее для развертывания логических выводов в строке поиска Amazon Music.

Исправление орфографии: вывод модели BART

С помощью экземпляров SageMaker G5 и NVIDIA Triton Inference Server (программное обеспечение для вывода с открытым исходным кодом), а также NVIDIA TensorRT, SDK для высокопроизводительного вывода при глубоком обучении, который включает в себя оптимизатор вывода и среду выполнения, Amazon Music ограничивает свою проверку орфографии BART. (барт-база) моделирует задержку вывода сервера всего до 25 миллисекунд при пиковом трафике. Сюда входят накладные расходы, такие как балансировка нагрузки, предварительная обработка, вывод модели и время постобработки.

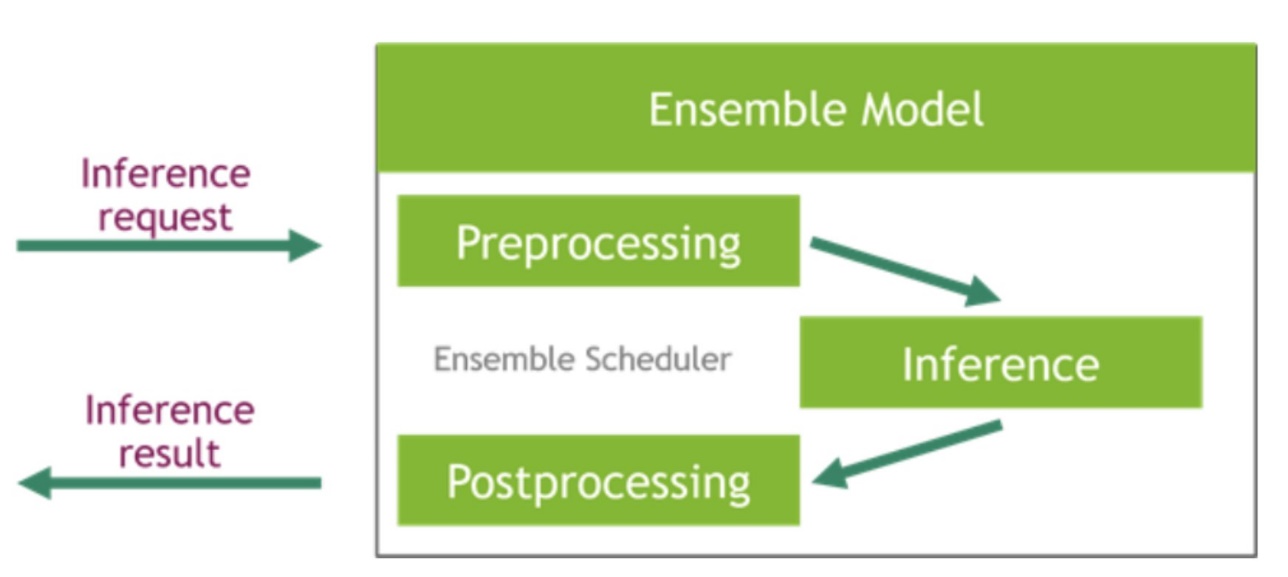

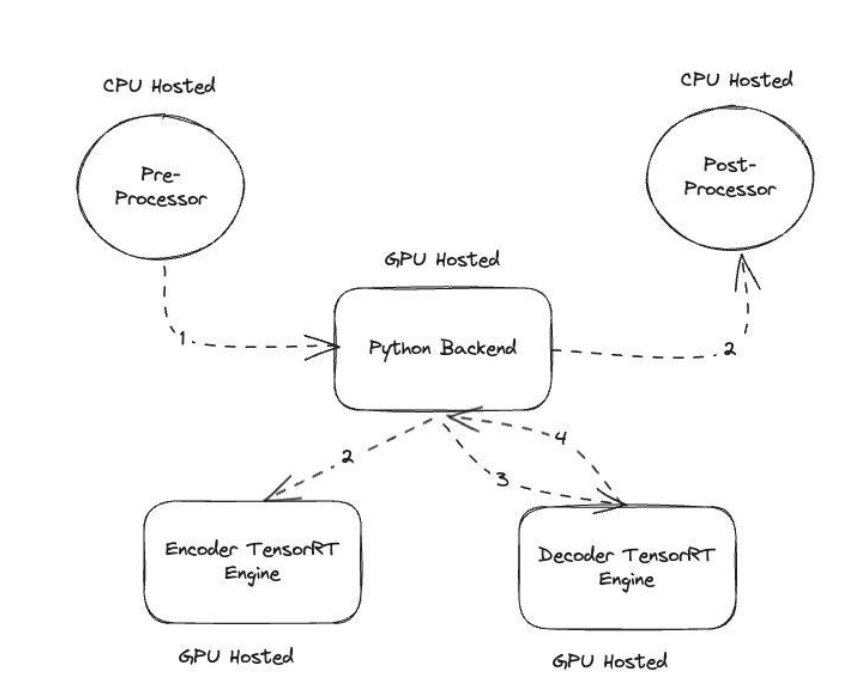

Сервер NVIDIA Triton Inference Server предоставляет два разных типа бэкэндов: один для размещения моделей на графическом процессоре и бэкэнд Python, куда вы можете добавить свой собственный код для использования на этапах предварительной и постобработки. Следующий рисунок иллюстрирует Схема модельного ансамбля.

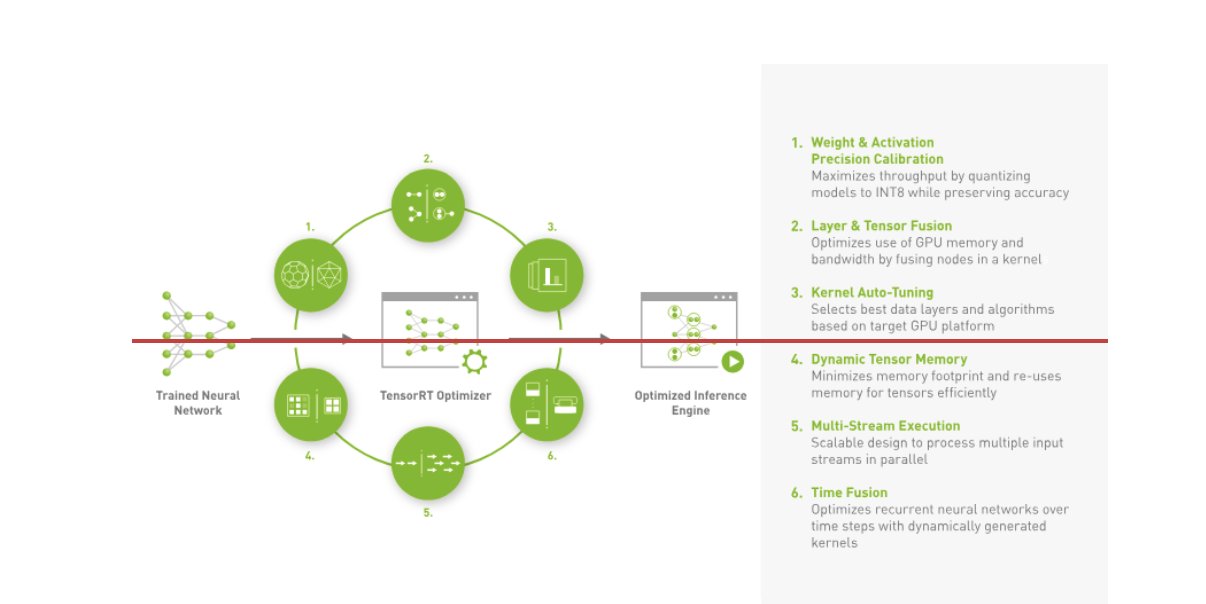

Amazon Music создала свой BART конвейер вывода путем выполнения шагов предварительной обработки (токенизация текста) и постобработки (токены в текст) на ЦП, тогда как этап выполнения модели выполняется Графические процессоры NVIDIA A10G с тензорными ядрами. Серверная часть Python находится в середине этапов предварительной и постобработки и отвечает за связь с моделями BART, преобразованными с помощью TensorRT, а также с сетями кодера/декодера. ТензорРТ повышает производительность вывода за счет точной калибровки, объединения слоев и тензоров, автонастройки ядра, динамической тензорной памяти, многопоточного выполнения и объединения времени.

На следующем рисунке показан высокоуровневый проект ключевых модулей, составляющих конвейер вывода модели BART корректора орфографии.

Векторный поиск: встраивание запроса, генерация предложения, вывод модели BERT

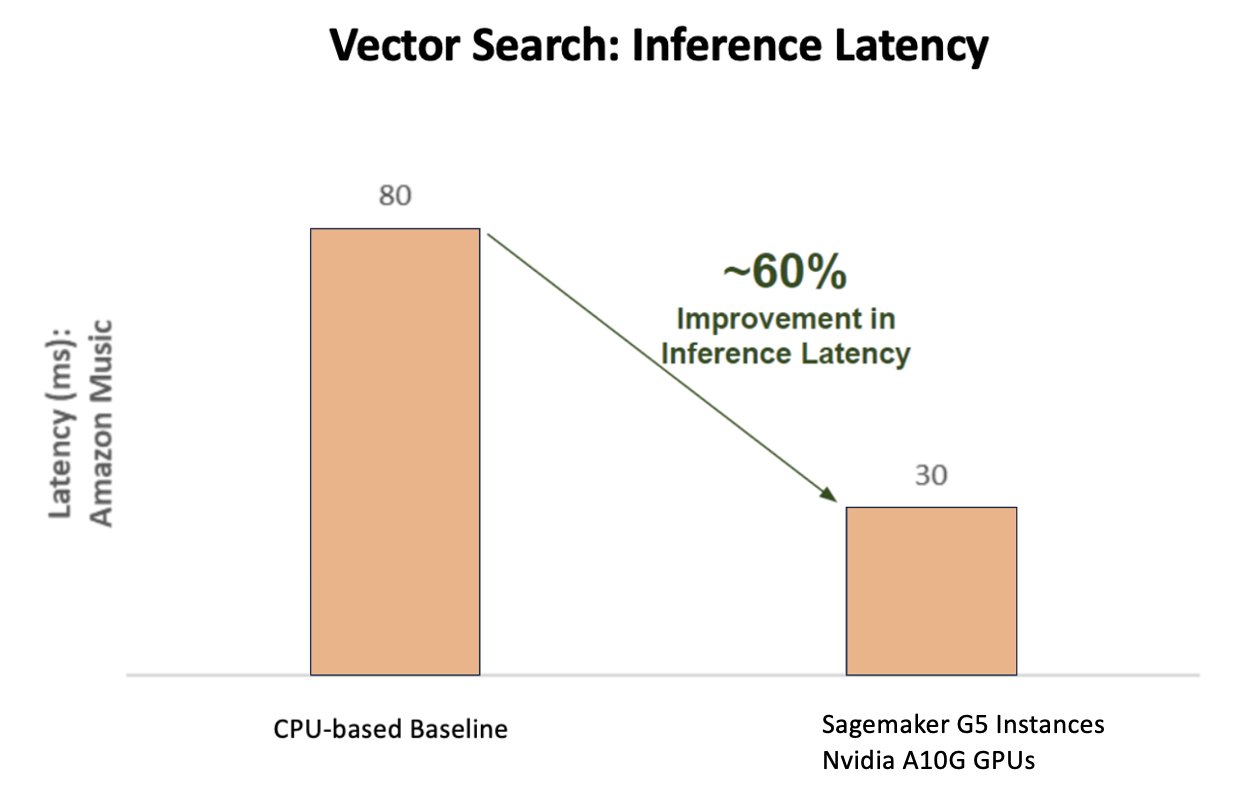

На следующей диаграмме показано улучшение задержки на 60 % (при p90 800–900 TPS) при использовании платформы NVIDIA AI Inference Platform по сравнению с базовым показателем на базе ЦП.

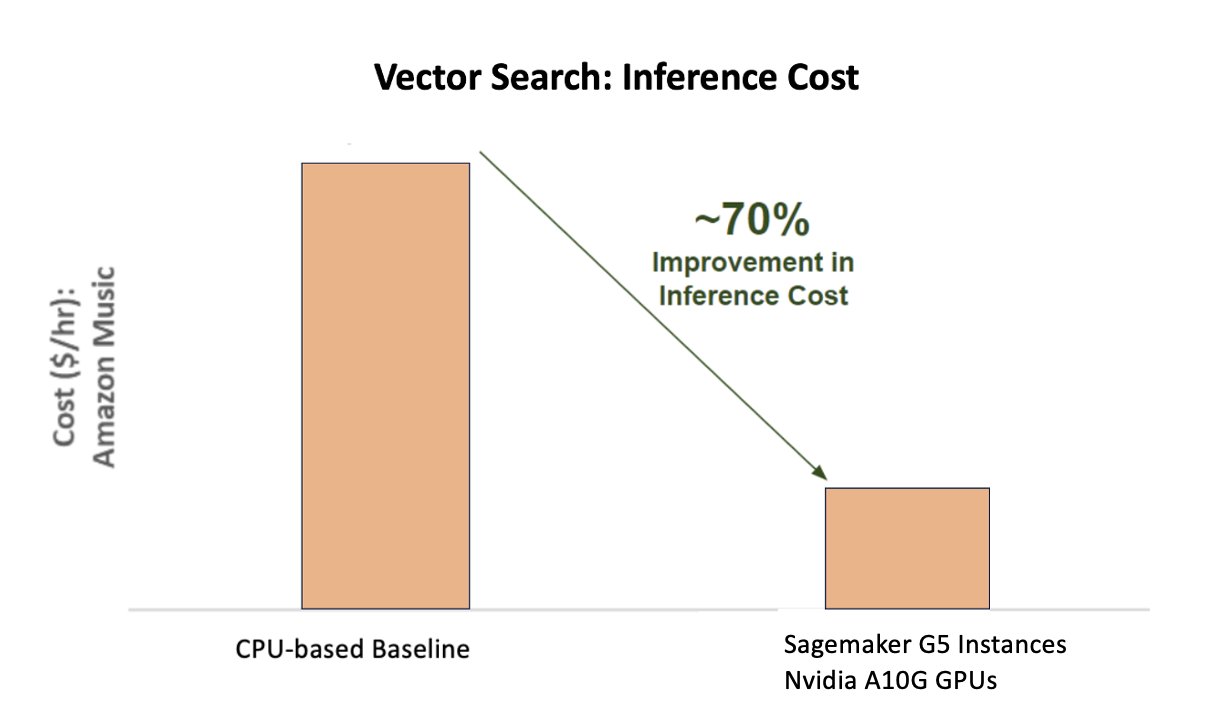

На следующей диаграмме показано улучшение затрат на 70 % при использовании платформы NVIDIA AI Inference по сравнению с базовым вариантом на базе ЦП.

На следующем рисунке показан SDK для высокопроизводительного вывода глубокого обучения. Он включает в себя оптимизатор вывода с глубоким обучением и среду выполнения, обеспечивающую низкую задержку и высокую пропускную способность для приложений вывода.

Чтобы добиться этих результатов, Amazon Music экспериментировала с несколькими различными параметрами развертывания Triton, используя Анализатор моделей Triton, инструмент, который помогает найти лучшую конфигурацию модели NVIDIA Triton для эффективного вывода. Для оптимизации вывода моделей Triton предлагает такие функции, как динамическая пакетная обработка и одновременное выполнение моделей, а также поддержка других возможностей гибкости. Динамическая пакетная обработка собирает запросы на вывод, плавно группируя их в когорты, чтобы максимизировать пропускную способность, обеспечивая при этом ответы в реальном времени для пользователей Amazon Music. Возможность одновременного выполнения модели еще больше повышает производительность вывода за счет размещения нескольких копий модели на одном графическом процессоре. Наконец, используя Анализатор моделей TritonAmazon Music удалось тщательно настроить параметры динамического пакетного анализа и моделирования параллельного вывода, чтобы найти оптимальные настройки, которые максимизируют производительность вывода с использованием моделируемого трафика.

Заключение

Оптимизация конфигураций с помощью Triton Inference Server и TensorRT в SageMaker позволила Amazon Music добиться выдающихся результатов как для конвейеров обучения, так и для конвейеров вывода. Платформа SageMaker — это комплексная открытая платформа для производственного искусственного интеллекта, обеспечивающая быструю окупаемость и универсальность для поддержки всех основных сценариев использования искусственного интеллекта как в аппаратном, так и в программном обеспечении. Оптимизируя использование графического процессора V100 для обучения и переключаясь с процессоров на экземпляры G5 с использованием графических процессоров NVIDIA A10G с тензорными ядрами, а также используя оптимизированное программное обеспечение NVIDIA, такое как Triton Inference Server и TensorRT, такие компании, как Amazon Music, могут сэкономить время и деньги, одновременно повышая производительность в обоих случаях. обучение и выводы, что напрямую приводит к улучшению качества обслуживания клиентов и снижению эксплуатационных расходов.

SageMaker берет на себя недифференцированную тяжелую работу по обучению и хостингу машинного обучения, позволяя Amazon Music предоставлять надежные и масштабируемые операции машинного обучения как на аппаратном, так и на программном обеспечении.

Мы рекомендуем вам проверять, оптимизированы ли ваши рабочие нагрузки с помощью SageMaker, всегда оценивая выбранное вами аппаратное и программное обеспечение, чтобы определить, есть ли способы добиться большей производительности с меньшими затратами.

Чтобы узнать больше об искусственном интеллекте NVIDIA в AWS, см. следующее:

Об авторах

Сиддхарт Шарма — руководитель отдела технологий машинного обучения в команде науки и моделирования в Amazon Music. Он специализируется на задачах моделирования, связанных с поиском, извлечением, ранжированием и НЛП. Сиддхарт имеет богатый опыт работы над крупномасштабными проблемами машинного обучения, чувствительными к задержкам, например, таргетинг рекламы, мультимодальный поиск, понимание поисковых запросов и т. д. До работы в Amazon Music Сиддхарт работал в таких компаниях, как Meta, Walmart Labs, Rakuten. по проблемам машинного обучения, ориентированным на электронную коммерцию. Сиддхарт начал свою карьеру, работая со стартапами в области рекламных технологий.

Сиддхарт Шарма — руководитель отдела технологий машинного обучения в команде науки и моделирования в Amazon Music. Он специализируется на задачах моделирования, связанных с поиском, извлечением, ранжированием и НЛП. Сиддхарт имеет богатый опыт работы над крупномасштабными проблемами машинного обучения, чувствительными к задержкам, например, таргетинг рекламы, мультимодальный поиск, понимание поисковых запросов и т. д. До работы в Amazon Music Сиддхарт работал в таких компаниях, как Meta, Walmart Labs, Rakuten. по проблемам машинного обучения, ориентированным на электронную коммерцию. Сиддхарт начал свою карьеру, работая со стартапами в области рекламных технологий.

Тарун Шарма — менеджер по разработке программного обеспечения, отвечающий за релевантность поиска музыки на Amazon. Его команда ученых и инженеров машинного обучения отвечает за предоставление контекстуально релевантных и персонализированных результатов поиска клиентам Amazon Music.

Тарун Шарма — менеджер по разработке программного обеспечения, отвечающий за релевантность поиска музыки на Amazon. Его команда ученых и инженеров машинного обучения отвечает за предоставление контекстуально релевантных и персонализированных результатов поиска клиентам Amazon Music.

Джеймс Парк работает архитектором решений в Amazon Web Services. Он работает с Amazon.com над проектированием, созданием и развертыванием технологических решений на AWS и проявляет особый интерес к искусственному интеллекту и машинному обучению. В свободное время ему нравится знакомиться с новыми культурами, получать новый опыт и быть в курсе последних технологических тенденций. Вы можете найти его на LinkedIn.

Джеймс Парк работает архитектором решений в Amazon Web Services. Он работает с Amazon.com над проектированием, созданием и развертыванием технологических решений на AWS и проявляет особый интерес к искусственному интеллекту и машинному обучению. В свободное время ему нравится знакомиться с новыми культурами, получать новый опыт и быть в курсе последних технологических тенденций. Вы можете найти его на LinkedIn.

Кшитиз Гупта является архитектором решений в NVIDIA. Ему нравится обучать клиентов облачных вычислений технологиям искусственного интеллекта на графических процессорах, которые NVIDIA может предложить, и помогать им в ускорении их приложений машинного и глубокого обучения. Вне работы он любит бегать, ходить в походы и наблюдать за дикой природой.

Кшитиз Гупта является архитектором решений в NVIDIA. Ему нравится обучать клиентов облачных вычислений технологиям искусственного интеллекта на графических процессорах, которые NVIDIA может предложить, и помогать им в ускорении их приложений машинного и глубокого обучения. Вне работы он любит бегать, ходить в походы и наблюдать за дикой природой.

Цзяхонг Лю является архитектором решений в команде поставщиков облачных услуг в NVIDIA. Он помогает клиентам внедрить решения для машинного обучения и искусственного интеллекта, которые используют ускоренные вычисления NVIDIA для решения их задач обучения и логических выводов. В свободное время он увлекается оригами, проектами «сделай сам» и играет в баскетбол.

Цзяхонг Лю является архитектором решений в команде поставщиков облачных услуг в NVIDIA. Он помогает клиентам внедрить решения для машинного обучения и искусственного интеллекта, которые используют ускоренные вычисления NVIDIA для решения их задач обучения и логических выводов. В свободное время он увлекается оригами, проектами «сделай сам» и играет в баскетбол.

Тугрул Конук — старший архитектор решений в NVIDIA, специализирующийся на крупномасштабном обучении, мультимодальном глубоком обучении и высокопроизводительных научных вычислениях. До работы в NVIDIA он работал в энергетической отрасли, занимаясь разработкой алгоритмов компьютерного моделирования. В рамках своей докторской диссертации он работал над глубоким обучением на основе физики для масштабного численного моделирования. В свободное время он любит читать, играть на гитаре и фортепиано.

Тугрул Конук — старший архитектор решений в NVIDIA, специализирующийся на крупномасштабном обучении, мультимодальном глубоком обучении и высокопроизводительных научных вычислениях. До работы в NVIDIA он работал в энергетической отрасли, занимаясь разработкой алгоритмов компьютерного моделирования. В рамках своей докторской диссертации он работал над глубоким обучением на основе физики для масштабного численного моделирования. В свободное время он любит читать, играть на гитаре и фортепиано.

Рохил Бхаргава — менеджер по маркетингу продуктов в NVIDIA, занимающийся развертыванием фреймворков приложений и SDK NVIDIA на конкретных платформах CSP.

Рохил Бхаргава — менеджер по маркетингу продуктов в NVIDIA, занимающийся развертыванием фреймворков приложений и SDK NVIDIA на конкретных платформах CSP.

Элиут Триана Исаза является менеджером по связям с разработчиками в NVIDIA, который помогает AI MLOps, DevOps, ученым и техническим экспертам AWS компании Amazon осваивать вычислительный стек NVIDIA для ускорения и оптимизации моделей Generative AI Foundation, включая курирование данных, обучение графических процессоров, вывод моделей и производственное развертывание на экземплярах графических процессоров AWS. . Кроме того, Элиут — страстный велосипедист, лыжник, теннисист и игрок в покер.

Элиут Триана Исаза является менеджером по связям с разработчиками в NVIDIA, который помогает AI MLOps, DevOps, ученым и техническим экспертам AWS компании Amazon осваивать вычислительный стек NVIDIA для ускорения и оптимизации моделей Generative AI Foundation, включая курирование данных, обучение графических процессоров, вывод моделей и производственное развертывание на экземплярах графических процессоров AWS. . Кроме того, Элиут — страстный велосипедист, лыжник, теннисист и игрок в покер.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :имеет

- :является

- :нет

- :куда

- $UP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- в состоянии

- О нас

- ускоренный

- ускоряющий

- ускорение

- доступ

- выполнять

- точность

- точный

- Достигать

- достигнутый

- через

- активный

- дополнение

- адрес

- Принятие

- объявления

- затрагивающий

- После

- AI

- AI модели

- варианты использования ИИ

- Альбом

- алгоритмы

- Все

- позволять

- разрешено

- Позволяющий

- позволяет

- причислены

- всегда

- Amazon

- Amazon Web Services

- Amazon.com

- an

- и

- Применение

- Приложения

- подхода

- Архитекторы

- МЫ

- ПЛОЩАДЬ

- области

- около

- художник

- AS

- содействие

- помогает

- At

- в среднем

- AWS

- Backend

- Баланс

- Балансировка

- бар

- основанный

- Базовая линия

- Баскетбол

- залив

- BE

- стали

- , так как:

- Преимущества

- ЛУЧШЕЕ

- Лучшая

- стимулирование

- форсирует

- изоферменты печени

- приносить

- широкий

- строить

- построенный

- by

- CAN

- возможности

- возможности

- захватить

- заботится

- Карьера

- осторожно

- случаев

- проблемы

- сложные

- График

- проверка

- лелеял

- выбор

- клиентов

- облако

- код

- COM

- как

- общение

- Компании

- сравненный

- вычислительный

- вычисление

- параллельный

- Конфигурация

- Container

- содержание

- Сближение

- Основные

- Цена

- Расходы

- выработать

- критической

- решающее значение

- CSP

- курирование

- изготовленный на заказ

- клиент

- опыт работы с клиентами

- Клиенты

- данным

- Время

- Дней

- снизилась

- глубоко

- глубокое обучение

- задержки

- доставить

- доставки

- обеспечивает

- Спрос

- развертывание

- развертывание

- развертывание

- Проект

- Застройщик

- развивающийся

- Развитие

- различный

- трудный

- непосредственно

- погружение

- Разное

- Сделай сам

- Dont

- кардинально

- в течение

- динамический

- e

- электронная коммерция

- Рано

- обучение

- затрат

- эффективный

- усилие

- возвышенный

- вложения

- эмоции

- используя

- расширение прав и возможностей

- включен

- поощрять

- впритык

- энергетика

- Инженеры

- Усиливает

- достаточно

- обеспечение

- особенно

- и т.д

- оценки

- Даже

- Каждая

- выполнение

- опыт

- Впечатления

- эксперты

- БЫСТРО

- Особенности

- фигура

- в заключение

- Найдите

- обнаружение

- Во-первых,

- Трансформируемость

- наводнение

- Фокус

- внимание

- фокусировка

- после

- Что касается

- формат

- Год основания

- Рамки

- каркасы

- от

- разочаровывающий

- полностью

- функциональные возможности

- далее

- слияние

- шлюз

- поколение

- генеративный

- Генеративный ИИ

- GPU / ГРАФИЧЕСКИЙ ПРОЦЕССОР

- Графические процессоры

- Ручки

- происходить

- Аппаратные средства

- Есть

- he

- тяжелый

- тяжелая атлетика

- помощь

- полезный

- помогает

- High

- на высшем уровне

- высокая производительность

- его

- его

- имеет

- хостинг

- ЧАСЫ

- Как

- Однако

- HTML

- HTTPS

- идентифицирующий

- if

- иллюстрирует

- Изображениями

- осуществлять

- важную

- улучшать

- улучшенный

- улучшение

- in

- включает в себя

- Увеличение

- расширились

- повышение

- промышленность

- неэффективное

- повлиять

- Инфраструктура

- начальный

- пример

- немедленно

- вместо

- интерес

- в

- вводить

- введение

- IT

- ЕГО

- путешествие

- JPG

- всего

- Основные

- Вид

- Знать

- известный

- Labs

- язык

- большой

- крупномасштабный

- больше

- прочный

- Задержка

- последний

- слой

- вести

- ведущий

- УЧИТЬСЯ

- изучение

- Кредитное плечо

- Библиотека

- Подтяжка лица

- такое как

- рамки

- загрузка

- искать

- Низкий

- ниже

- машина

- обучение с помощью машины

- поддерживать

- основной

- сделать

- ДЕЛАЕТ

- менеджер

- управления

- Маркетинг

- мастер

- Максимизировать

- Май..

- памяти

- Память

- Мета

- средняя

- миллиона

- миллионы

- миллисекунды

- минимальный

- ошибка

- смешанный

- ML

- млн операций в секунду

- модель

- моделирование

- Модели

- Модули

- деньги

- БОЛЕЕ

- самых

- гора

- много

- с разными

- Музыка

- должен

- имя

- необходимый

- отрицательно

- сетей

- Новые

- НЛП

- Nvidia

- of

- предлагают

- Предложения

- on

- ONE

- только

- открытый

- с открытым исходным кодом

- операционный

- оперативный

- Операционный отдел

- оптимальный

- оптимизация

- Оптимизировать

- оптимизированный

- оптимизирующий

- or

- организовал

- заказ

- Другое

- внешний

- внешнюю

- выдающийся

- за

- общий

- собственный

- параметры

- часть

- особый

- особенно

- партнерство

- страстный

- Вершина горы

- процент

- производительность

- личного

- Персонализированные

- кандидат наук

- трубопровод

- Платформа

- Платформы

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- игрок

- игры

- Подкаст

- Подкасты

- Точка

- покер

- возможное

- После

- потенциал

- мощностью

- Питание

- Точность

- Предварительный

- Расставляйте приоритеты

- приоритет

- проблемам

- процесс

- Продукт

- Производство

- проектов

- обеспечивать

- Недвижимости

- приводит

- обеспечение

- Питон

- САЙТ

- Ранжирование

- Reading

- реального времени

- снижение

- относиться

- Связанный

- отношения

- актуальность

- соответствующие

- складская

- Запросы

- требуется

- Полезные ресурсы

- ответы

- ответственность

- ответственный

- отзывчивый

- в результате

- Итоги

- Богатые

- правую

- Бег

- работает

- время выполнения

- sagemaker

- то же

- Сохранить

- экономия

- масштабируемые

- Шкала

- Наука

- научный

- Ученые

- SDK

- SDKS

- легко

- Поиск

- поиск

- поиск

- Во-вторых

- разделах

- посмотреть

- поиск

- по-видимому

- семантика

- старший

- чувствительный

- предложение

- служить

- сервер

- обслуживание

- Провайдер услуг

- Услуги

- выступающей

- набор

- настройки

- несколько

- Поделиться

- общие

- Шоу

- значительный

- существенно

- просто

- сидит

- Размер

- Размеры

- умный

- Software

- разработка программного обеспечения

- Решение

- Решения

- песня

- Источник

- напряженность

- специализируется

- специализация

- конкретный

- скорость

- SPELL

- орфография

- потраченный

- стек

- Начало

- Стартапы

- пребывание

- устойчивый

- Шаг

- Шаги

- История

- потоковый

- такие

- топ

- поддержка

- Поддержанный

- Убедитесь

- приняты

- с

- направлены

- команда

- технологии

- Технический

- техника

- снижения вреда

- технологии

- Технологии

- текст

- который

- Ассоциация

- их

- Их

- Там.

- следовательно

- Эти

- они

- вещи

- этой

- Через

- пропускная способность

- время

- раз

- Название

- в

- вместе

- лексемизацию

- Лексемы

- приняли

- инструментом

- топ

- TPS

- трафик

- Train

- специалистов

- Обучение

- трансформатор

- Тенденции

- Тритон

- правда

- два

- понимание

- несомненно

- Вселенная

- отпирающий

- представила

- us

- использование

- используемый

- пользователей

- использования

- через

- Использующий

- ценностное

- Огромная

- многосторонность

- очень

- Ожидание

- от

- Walmart

- законопроект

- наблюдение

- способы

- we

- Web

- веб-сервисы

- ЧТО Ж

- были

- когда

- в то время как

- в то время как

- будете

- Работа

- работавший

- работает

- работает

- Мир

- беспокоиться

- еще

- дали

- Ты

- ВАШЕ

- зефирнет