Поскольку машинное обучение (ML) становится все более распространенным в самых разных отраслях, организации обнаруживают необходимость в обучении и обслуживании большого количества моделей ML для удовлетворения разнообразных потребностей своих клиентов. В частности, для поставщиков программного обеспечения как услуги (SaaS) способность обучать и обслуживать тысячи моделей эффективно и с минимальными затратами имеет решающее значение для сохранения конкурентоспособности на быстро развивающемся рынке.

Для обучения и обслуживания тысяч моделей требуется надежная и масштабируемая инфраструктура. Создатель мудреца Амазонки может помочь. SageMaker — это полностью управляемая платформа, которая позволяет разработчикам и специалистам по обработке и анализу данных быстро создавать, обучать и развертывать модели машинного обучения, а также предлагает экономию средств за счет использования облачной инфраструктуры AWS.

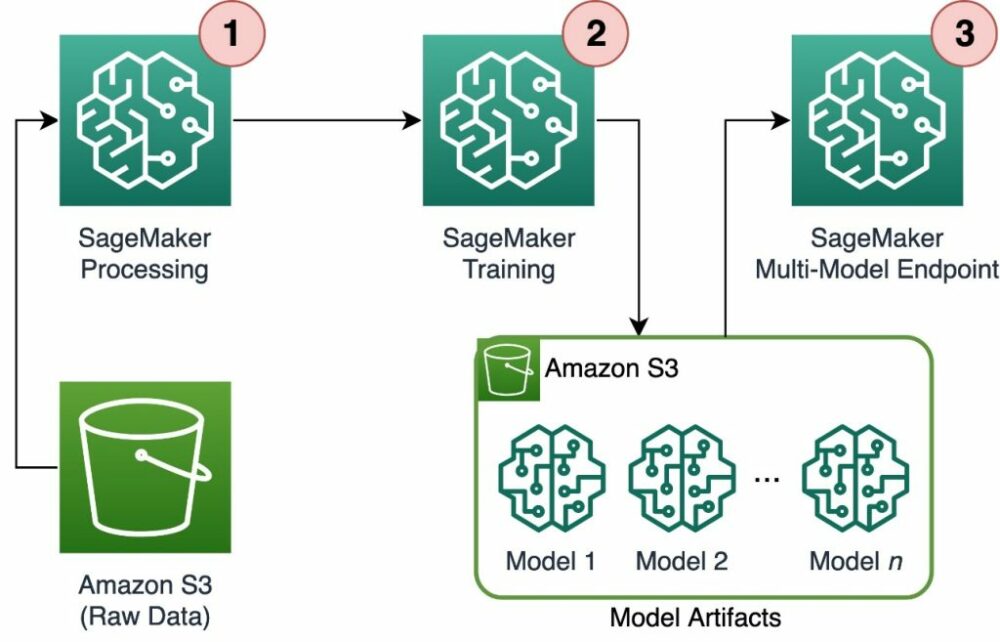

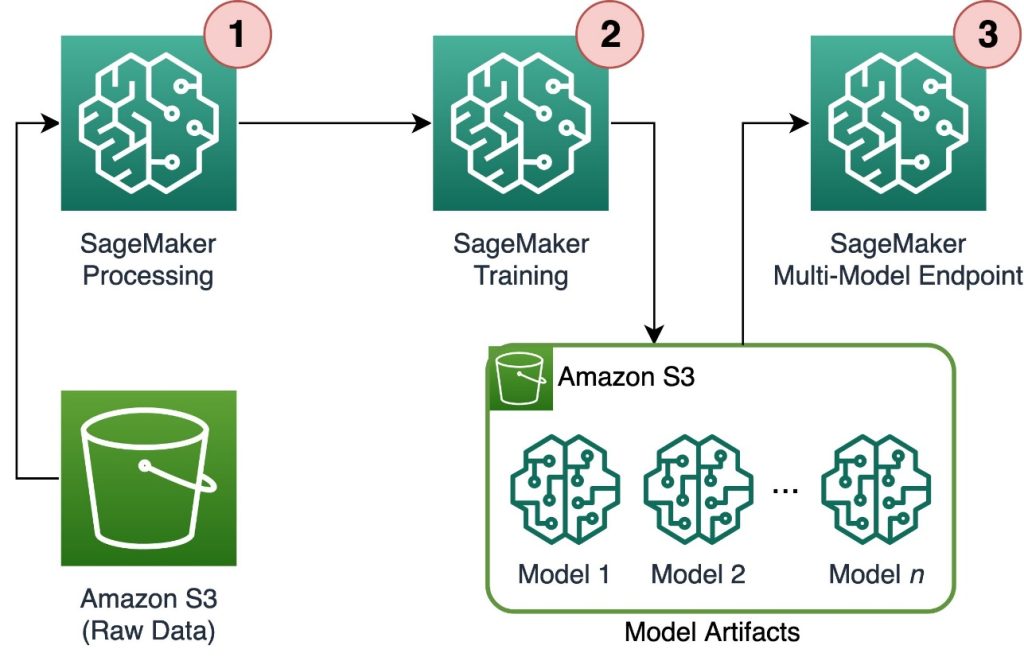

В этом посте мы рассмотрим, как вы можете использовать функции SageMaker, в том числе Обработка Amazon SageMaker, обучающие задания SageMaker и мультимодельные конечные точки (MME) SageMaker для обучения и обслуживания тысяч моделей экономичным способом. Чтобы начать работу с описанным решением, вы можете обратиться к прилагаемой записной книжке на GitHub.

Вариант использования: прогнозирование энергопотребления

В этом посте мы берем на себя роль независимой компании, которая помогает своим клиентам стать более устойчивыми, отслеживая их потребление энергии и предоставляя прогнозы. У нашей компании 1,000 клиентов, которые хотят лучше понимать свое энергопотребление и принимать обоснованные решения о том, как уменьшить воздействие на окружающую среду. Для этого мы используем синтетический набор данных и обучаем модель машинного обучения на основе Пророк для каждого клиента, чтобы сделать прогнозы энергопотребления. С помощью SageMaker мы можем эффективно обучать и обслуживать эти 1,000 моделей, предоставляя нашим клиентам точную и полезную информацию об их энергопотреблении.

В сгенерированном наборе данных есть три функции:

- Пользовательский ИД – Это целочисленный идентификатор для каждого клиента в диапазоне от 0 до 999.

- отметка времени – Это значение даты/времени, указывающее время, когда было измерено потребление энергии. Временные метки генерируются случайным образом между начальной и конечной датами, указанными в коде.

- потребление – это значение с плавающей запятой, указывающее потребление энергии, измеренное в какой-то условной единице. Значения потребления генерируются случайным образом в диапазоне от 0 до 1,000 с синусоидальной сезонностью.

Обзор решения

Чтобы эффективно обучать и обслуживать тысячи моделей машинного обучения, мы можем использовать следующие функции SageMaker:

- Обработка SageMaker – SageMaker Processing – это полностью управляемая служба подготовки данных, которая позволяет выполнять задачи по обработке данных и оценке модели на входных данных. Вы можете использовать SageMaker Processing для преобразования необработанных данных в формат, необходимый для обучения и логических выводов, а также для запуска пакетной и онлайн-оценки ваших моделей.

- Вакансии для обучения SageMaker – Учебные задания SageMaker можно использовать для обучения моделей различным алгоритмам и типам входных данных, а также указывать вычислительные ресурсы, необходимые для обучения.

- MME SageMaker – Конечные точки с несколькими моделями позволяют размещать несколько моделей в одной конечной точке, что упрощает предоставление прогнозов из нескольких моделей с использованием одного API. MME SageMaker могут сэкономить время и ресурсы за счет сокращения количества конечных точек, необходимых для обслуживания прогнозов из нескольких моделей. MME поддерживают размещение как моделей с поддержкой CPU, так и GPU. Обратите внимание, что в нашем сценарии мы используем 1,000 моделей, но это не ограничение самого сервиса.

Следующая диаграмма иллюстрирует архитектуру решения.

Рабочий процесс включает в себя следующие шаги:

- Мы используем SageMaker Processing для предварительной обработки данных, создания одного CSV-файла для каждого клиента и сохранения его в Простой сервис хранения Amazon (Amazon S3).

- Задание обучения SageMaker настроено на считывание выходных данных задания обработки SageMaker и их циклическое распределение по обучающим экземплярам. Обратите внимание, что это также может быть достигнуто с помощью Конвейеры Amazon SageMaker.

- Артефакты модели сохраняются в Amazon S3 заданием обучения и обслуживаются непосредственно из SageMaker MME.

Масштабируйте обучение на тысячи моделей

Масштабирование обучения тысяч моделей возможно с помощью distribution параметр ОбучениеВвод в SageMaker Python SDK, который позволяет указать, как данные распределяются между несколькими экземплярами обучения для задания обучения. Есть три варианта для distribution Параметр: FullyReplicated, ShardedByS3Keyи ShardedByRecord, ShardedByS3Key Параметр означает, что обучающие данные разделены по ключу объекта S3, при этом каждый обучающий экземпляр получает уникальное подмножество данных, что позволяет избежать дублирования. После того, как SageMaker скопирует данные в обучающие контейнеры, мы можем прочитать структуру папок и файлов, чтобы обучить уникальную модель для каждого файла клиента. Ниже приведен пример фрагмента кода:

В каждом учебном задании SageMaker сохраняется модель, сохраненная в /opt/ml/model папку учебного контейнера перед его архивированием в model.tar.gz файл, а затем загружает его в Amazon S3 после завершения обучения. Опытные пользователи также могут автоматизировать этот процесс с помощью SageMaker Pipelines. При сохранении нескольких моделей с помощью одного и того же задания обучения SageMaker создает один model.tar.gz файл, содержащий все обученные модели. Тогда это будет означать, что для обслуживания модели нам нужно сначала распаковать архив. Чтобы избежать этого, мы используем контрольно-пропускные пункты для сохранения состояния отдельных моделей. SageMaker позволяет копировать контрольные точки, созданные во время задания обучения, в Amazon S3. Здесь контрольные точки должны быть сохранены в заранее указанном месте, по умолчанию /opt/ml/checkpoints. Эти контрольные точки можно использовать для возобновления обучения в более поздний момент или в качестве модели для развертывания на конечной точке. Общий обзор того, как учебная платформа SageMaker управляет путями хранения наборов обучающих данных, артефактов моделей, контрольных точек и выходных данных между облачным хранилищем AWS и заданиями обучения в SageMaker, см. Папки Amazon SageMaker Training Storage для обучающих наборов данных, контрольных точек, артефактов модели и выходных данных.

В следующем коде используется фиктивный model.save() функция внутри train.py скрипт, содержащий логику обучения:

Масштабируйте логические выводы до тысяч моделей с помощью SageMaker MME

MME SageMaker позволяют обслуживать несколько моделей одновременно, создавая конфигурацию конечной точки, включающую список всех обслуживаемых моделей, а затем создавая конечную точку с использованием этой конфигурации конечной точки. Нет необходимости повторно развертывать конечную точку каждый раз, когда вы добавляете новую модель, поскольку конечная точка будет автоматически обслуживать все модели, хранящиеся в указанных путях S3. Это достигается с Сервер с несколькими моделями (MMS), инфраструктура с открытым исходным кодом для обслуживания моделей машинного обучения, которую можно установить в контейнеры, чтобы обеспечить внешний интерфейс, отвечающий требованиям для новых API контейнеров MME. Кроме того, вы можете использовать другие модели серверов, включая ФакелСервировать и Тритон. MMS можно установить в ваш пользовательский контейнер через Набор инструментов для логического вывода SageMaker. Чтобы узнать больше о том, как настроить файл Dockerfile для включения MMS и использовать его для обслуживания своих моделей, см. Создайте свой собственный контейнер для мультимодальных конечных точек SageMaker.

В следующем фрагменте кода показано, как создать MME с помощью SageMaker Python SDK:

Когда MME работает, мы можем вызвать его для генерации прогнозов. Вызовы можно выполнять в любом AWS SDK, а также в SageMaker Python SDK, как показано в следующем фрагменте кода:

При вызове модели модель изначально загружается из Amazon S3 в инстанс, что может привести к «холодному» запуску при вызове новой модели. Часто используемые модели кэшируются в памяти и на диске, чтобы обеспечить вывод с малой задержкой.

Заключение

SageMaker — это мощная и экономичная платформа для обучения и обслуживания тысяч моделей машинного обучения. Его функции, в том числе SageMaker Processing, учебные задания и MME, позволяют организациям эффективно обучать и обслуживать тысячи моделей в любом масштабе, а также извлекать выгоду из преимуществ экономии средств за счет использования облачной инфраструктуры AWS. Чтобы узнать больше о том, как использовать SageMaker для обучения и обслуживания тысяч моделей, см. Данные обработки, Обучите модель с помощью Amazon SageMaker и Размещайте несколько моделей в одном контейнере за одной конечной точкой.

Об авторах

Давиде Галлителли является специалистом по разработке решений для AI/ML в регионе EMEA. Он базируется в Брюсселе и тесно сотрудничает с клиентами из стран Бенилюкса. Он был разработчиком с самого раннего возраста, начав программировать в возрасте 7 лет. Он начал изучать AI/ML в университете и с тех пор влюбился в него.

Давиде Галлителли является специалистом по разработке решений для AI/ML в регионе EMEA. Он базируется в Брюсселе и тесно сотрудничает с клиентами из стран Бенилюкса. Он был разработчиком с самого раннего возраста, начав программировать в возрасте 7 лет. Он начал изучать AI/ML в университете и с тех пор влюбился в него.

Мориц де Гроот является архитектором решений в Amazon Web Services, базирующейся в Амстердаме. Ему нравится работать над темами, связанными с машинным обучением, и он любит стартапы. В свободное время любит кататься на лыжах и играть в сквош.

Мориц де Гроот является архитектором решений в Amazon Web Services, базирующейся в Амстердаме. Ему нравится работать над темами, связанными с машинным обучением, и он любит стартапы. В свободное время любит кататься на лыжах и играть в сквош.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Автомобили / электромобили, Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- Смещения блоков. Модернизация права собственности на экологические компенсации. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/scale-training-and-inference-of-thousands-of-ml-models-with-amazon-sagemaker/

- :имеет

- :является

- :нет

- :куда

- 000

- 000 клиентов

- 1

- 10

- 100

- 12

- 15%

- 20

- 7

- a

- способность

- О нас

- точный

- достигнутый

- через

- Добавить

- дополнение

- Преимущества

- После

- возраст

- AI / ML

- алгоритмы

- Все

- позволять

- позволяет

- уже

- причислены

- Amazon

- Создатель мудреца Амазонки

- Amazon Web Services

- Амстердам

- an

- и

- любой

- API

- API

- архитектура

- архив

- МЫ

- аргумент

- AS

- предполагать

- At

- автоматизировать

- автоматически

- избежать

- избегающий

- AWS

- основанный

- BE

- , так как:

- становиться

- становится

- было

- до

- за

- не являетесь

- пользу

- Преимущества

- Лучшая

- между

- изоферменты печени

- Брюссель

- строить

- но

- by

- вызова

- CAN

- случаев

- класс

- тесно

- облако

- облачная инфраструктура

- облачного хранения

- код

- холодный

- Компания

- конкурентоспособный

- завершение

- Вычисление

- Конфигурация

- настроить

- потребление

- Container

- Контейнеры

- рентабельным

- Создайте

- создали

- создает

- Создающий

- решающее значение

- изготовленный на заказ

- клиент

- Клиенты

- данным

- Подготовка данных

- обработка данных

- Наборы данных

- Финики

- решения

- По умолчанию

- определять

- определение

- развертывание

- описано

- Застройщик

- застройщиков

- непосредственно

- дисплеев

- распространять

- распределенный

- Разное

- do

- сделанный

- в течение

- каждый

- легко

- эффективно

- в регионе EMEA

- включить

- позволяет

- конец

- Конечная точка

- энергетика

- Энергопотребление

- окружающий

- оценка

- оценки

- Каждая

- развивается

- пример

- Больше

- Fallen

- Фэшн

- Особенности

- Файл

- Файлы

- обнаружение

- First

- Поплавок

- после

- Что касается

- Для стартапов

- Прогнозы

- формат

- Рамки

- часто

- от

- передний

- Внешний интерфейс

- полностью

- функция

- функциональность

- порождать

- генерируется

- получить

- GitHub

- he

- помощь

- помогает

- здесь

- на высшем уровне

- его

- кашель

- хостинг

- Как

- How To

- HTML

- HTTP

- HTTPS

- идентификатор

- иллюстрирует

- Влияние

- Импортировать

- in

- включают

- включает в себя

- В том числе

- все больше и больше

- указывает

- individual

- промышленности

- сообщил

- Инфраструктура

- первоначально

- вход

- затраты

- внутри

- размышления

- установлен

- пример

- в

- IT

- ЕГО

- саму трезвость

- работа

- Джобс

- JPG

- JSON

- Основные

- большой

- новее

- УЧИТЬСЯ

- изучение

- нравится

- ограничение

- Список

- жить

- в местном масштабе

- расположение

- логика

- любят

- машина

- обучение с помощью машины

- сделать

- ДЕЛАЕТ

- управляемого

- управляет

- рынок

- значить

- означает

- Встречайте

- Память

- ML

- модель

- Модели

- момент

- БОЛЕЕ

- с разными

- имя

- Необходимость

- необходимый

- потребности

- Новые

- нет

- ноутбук

- номер

- номера

- объект

- of

- предлагающий

- on

- ONE

- онлайн

- с открытым исходным кодом

- Опция

- Опции

- or

- заказ

- организации

- OS

- Другое

- наши

- Наша компания

- внешний

- выходной

- собственный

- параметр

- особый

- pass

- путь

- для

- Выполнять

- период

- картина

- Платформа

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- игры

- возможное

- После

- мощностью

- мощный

- Predictions

- Predictor

- подготовка

- превалирующий

- процесс

- обработка

- обеспечивать

- поставщики

- приводит

- обеспечение

- Питон

- быстро

- случайно сгенерированный

- ассортимент

- ранжирование

- быстро

- Сырье

- Читать

- реального времени

- получение

- уменьшить

- снижение

- область

- Требования

- требуется

- Полезные ресурсы

- результат

- продолжить

- надежный

- Роли

- Run

- SaaS

- sagemaker

- Конвейеры SageMaker

- то же

- Сохранить

- масштабируемые

- Шкала

- сценарий

- Ученые

- SDK

- служить

- Серверы

- обслуживание

- Услуги

- выступающей

- набор

- сегментированный

- показанный

- Шоу

- просто

- с

- одинарной

- отрывок

- Software

- программное обеспечение как услуга

- Решение

- Решения

- некоторые

- специалист

- указанный

- Начало

- и политические лидеры

- Начало

- Стартапы

- Область

- Шаги

- диск

- магазин

- хранить

- магазины

- хранение

- Структура

- РЕЗЮМЕ

- поддержка

- комфортного

- синтетический

- цель

- задачи

- который

- Ассоциация

- Государство

- их

- тогда

- Там.

- Эти

- этой

- тысячи

- три

- по всему

- время

- в

- Темы

- Отслеживание

- Train

- специалистов

- Обучение

- Transform

- Типы

- понимать

- созданного

- Ед. изм

- Университет

- на

- Применение

- использование

- используемый

- пользователей

- использования

- через

- ценностное

- Наши ценности

- разнообразие

- очень

- с помощью

- W

- хотеть

- законопроект

- Путь..

- we

- Web

- веб-сервисы

- ЧТО Ж

- когда

- который

- в то время как

- КТО

- широкий

- Широкий диапазон

- будете

- в

- Работа

- рабочий

- работает

- бы

- Ты

- молодой

- ВАШЕ

- зефирнет