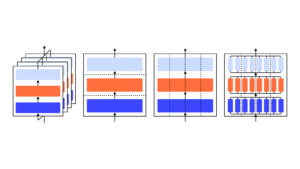

Мы показываем, что модель GPT-3 может научиться выражать неуверенность в собственных ответах на естественном языке — без использования логитов модели. При задании вопроса модель генерирует как ответ, так и уровень достоверности (например, «достоверность 90%» или «высокая достоверность»). Эти уровни соответствуют хорошо откалиброванным вероятностям. Модель также остается умеренно калиброванной при сдвиге распределения и чувствительна к неопределенности в собственных ответах, а не к имитации человеческих примеров. Насколько нам известно, это первый случай, когда модель выражает калиброванную неуверенность в своих собственных ответах на естественном языке. Для тестирования калибровки мы представляем набор задач CalibratedMath. Мы сравниваем калибровку неопределенности, выраженную словами («вербализованная вероятность»), с неопределенностью, извлеченной из логитов модели. Оба вида неопределенности способны обобщить калибровку при сдвиге распределения. Мы также предоставляем доказательства того, что способность GPT-3 обобщать калибровку зависит от предварительно обученных скрытых представлений, которые коррелируют с эпистемической неопределенностью в отношении ответов.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- Платоблокчейн. Интеллект метавселенной Web3. Расширение знаний. Доступ здесь.

- Источник: https://openai.com/research/teaching-models-to-express-their-uncertainty-in-words

- :является

- a

- способность

- О нас

- и

- ответ

- ответы

- МЫ

- CAN

- способный

- сравнить

- доверие

- зависит

- распределение

- e

- , поскольку большинство сенаторов

- Примеры

- экспресс

- выраженный

- Во-первых,

- Впервые

- Что касается

- от

- генерирует

- данный

- High

- HTTPS

- человек

- in

- вводить

- ЕГО

- знания

- язык

- УЧИТЬСЯ

- уровень

- уровни

- карта

- модель

- Модели

- натуральный

- of

- on

- собственный

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- обеспечивать

- вопрос

- скорее

- остатки

- s

- чувствительный

- сдвиг

- показывать

- показанный

- suite

- задачи

- Обучение

- Тестирование

- который

- Ассоциация

- их

- Эти

- время

- в

- Неопределенность

- под

- использование

- ЧТО Ж

- слова

- зефирнет