Интернет-сообщества стимулируют взаимодействие пользователей в таких отраслях, как игры, социальные сети, электронная коммерция, знакомства и электронное обучение. Члены этих онлайн-сообществ доверяют владельцам платформ обеспечению безопасной и инклюзивной среды, в которой они могут свободно потреблять контент и вносить свой вклад. Модераторы контента часто нанимаются для проверки пользовательского контента и проверки его безопасности и соответствия вашим условиям использования. Однако постоянно растущие масштабы, сложность и разнообразие нежелательного контента делают рабочие процессы модерации людьми немасштабируемыми и дорогостоящими. В результате возникают бедные, вредные и неинклюзивные сообщества, которые отвлекают пользователей и негативно влияют на сообщество и бизнес.

Наряду с пользовательским контентом, машинный контент поставил новую задачу модерации контента. Он автоматически создает очень реалистичный контент, который может быть неуместным или вредным в масштабе. Перед отраслью стоит новая задача: автоматическая модерация контента, создаваемого искусственным интеллектом, для защиты пользователей от вредных материалов.

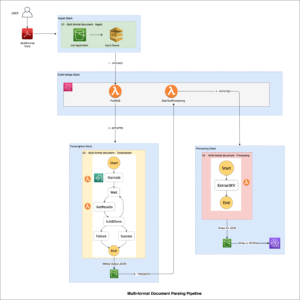

В этом посте мы представляем обнаружение токсичности, новую функцию от Amazon Comprehend это помогает вам автоматически обнаруживать вредоносный контент в тексте, созданном пользователем или машиной. Сюда входит обычный текст, текст, извлеченный из изображений, а также текст, расшифрованный из аудио- или видеоконтента.

Обнаружение токсичности в текстовом контенте с помощью Amazon Comprehend

Amazon Comprehend — это сервис обработки естественного языка (NLP), который использует машинное обучение (ML) для выявления ценной информации и связей в тексте. Он предлагает ряд моделей машинного обучения, которые можно предварительно обучить или настроить с помощью интерфейсов API. Amazon Comprehend теперь предоставляет простое решение на основе NLP для обнаружения токсичного контента в тексте.

API Amazon Comprehend Toxicity Detection присваивает текстовому контенту общую оценку токсичности в диапазоне от 0 до 1, что указывает на вероятность того, что он является токсичным. Он также классифицирует текст по следующим семи категориям и предоставляет оценку достоверности для каждой:

- НЕНАВИСТЬ_РЕЧ – Речь, которая критикует, оскорбляет, осуждает или дегуманизирует человека или группу на основе идентичности, будь то раса, этническая принадлежность, гендерная идентичность, религия, сексуальная ориентация, способности, национальное происхождение или другая группа идентичности.

- ГРАФИКА – Речь, в которой используются визуально описательные, подробные и неприятно яркие образы. Такие выражения часто делаются многословными, чтобы усилить оскорбление, дискомфорт или вред получателю.

- ПРИТЕСНЕНИЕ_ИЛИ_ЗЛОУПОТРЕБЛЕНИЕ – Речь, которая навязывает разрушительную динамику власти между говорящим и слушающим (независимо от намерений), стремится повлиять на психологическое благополучие реципиента или объективирует человека.

- Сексуальная – Речь, которая указывает на сексуальный интерес, активность или возбуждение, используя прямые или косвенные ссылки на части тела, физические особенности или пол.

- VIOLENCE_OR_THREAT – Речь, содержащая угрозы, направленные на причинение боли, травм или враждебности по отношению к человеку или группе людей.

- INSULT – Речь, содержащая унизительные, унизительные, насмешливые, оскорбительные или унижающие выражения.

- ПРОФАНСТВО – Речь, содержащая слова, фразы или аббревиатуры, которые являются невежливыми, вульгарными или оскорбительными.

Вы можете получить доступ к API обнаружения токсичности, вызвав его напрямую с помощью Интерфейс командной строки AWS (AWS CLI) и AWS SDK. Обнаружение токсичности в Amazon Comprehend в настоящее время поддерживается на английском языке.

Use cases

Модерация текста играет решающую роль в управлении пользовательским контентом в различных форматах, включая публикации в социальных сетях, сообщения в онлайн-чатах, обсуждения на форумах, комментарии на веб-сайтах и многое другое. Более того, платформы, принимающие видео- и аудиоконтент, могут использовать эту функцию для модерации расшифрованного аудиоконтента.

Появление генеративного ИИ и больших языковых моделей (LLM) представляет собой новейшую тенденцию в области ИИ. Следовательно, существует растущая потребность в гибких решениях для модерации контента, создаваемого LLM. API Amazon Comprehend Toxicity Detection идеально подходит для удовлетворения этой потребности.

Запрос API Amazon Comprehend для обнаружения токсичности

Вы можете отправить до 10 текстовых сегментов в API обнаружения токсичности, каждый из которых имеет ограничение по размеру в 1 КБ. Каждый текстовый сегмент запроса обрабатывается независимо. В следующем примере мы создаем файл JSON с именем toxicity_api_input.json содержащий текстовый контент, включая три фрагмента текста для модерации. Обратите внимание, что в примере нецензурные слова замаскированы как XXXX.

Вы можете использовать интерфейс командной строки AWS для вызова API обнаружения токсичности, используя предыдущий файл JSON, содержащий текстовое содержимое:

Ответ API Amazon Comprehend Toxicity Detection

Выходные данные JSON ответа API обнаружения токсичности будут включать результат анализа токсичности в формате JSON. ResultList поле. ResultList перечисляет элементы текстового сегмента, а последовательность представляет порядок, в котором текстовые последовательности были получены в запросе API. Токсичность представляет собой общий показатель достоверности обнаружения (от 0 до 1). Метки включают список меток токсичности с показателями достоверности, классифицированных по типу токсичности.

Следующий код показывает ответ JSON от API обнаружения токсичности на основе примера запроса из предыдущего раздела:

В предыдущем JSON первый текстовый сегмент считается безопасным с низкой оценкой токсичности. Однако второй и третий сегменты текста получили оценки токсичности 73% и 98% соответственно. Для второго сегмента Amazon Comprehend обнаруживает высокий показатель токсичности VIOLENCE_OR_THREAT; для третьего сегмента он обнаруживает PROFANITY с высоким показателем токсичности.

Пример запроса с использованием Python SDK

В следующем фрагменте кода показано, как использовать Python SDK для вызова API обнаружения токсичности. Этот код получает тот же ответ JSON, что и команда AWS CLI, продемонстрированная ранее.

Обзор

В этом посте мы представили обзор нового API Amazon Comprehend Toxicity Detection. Мы также описали, как анализировать ответ API в формате JSON. Для получения дополнительной информации см. Понять документ API.

Обнаружение токсичности Amazon Comprehend теперь доступно в четырех регионах: us-east-1, us-west-2, eu-west-1 и ap-southeast-2.

Дополнительную информацию о модерации контента см. Руководство по модерации контента на AWS. Сделайте первый шаг навстречу оптимизация операций модерации контента с помощью AWS.

Об авторах

Лана Чжан является старшим архитектором решений в команде AWS WWSO AI Services, специализирующейся на ИИ и машинном обучении для модерации контента, компьютерного зрения, обработки естественного языка и генеративного ИИ. Благодаря своему опыту она занимается продвижением решений AWS AI/ML и помогает клиентам трансформировать их бизнес-решения в различных отраслях, включая социальные сети, игры, электронную коммерцию, средства массовой информации, рекламу и маркетинг.

Лана Чжан является старшим архитектором решений в команде AWS WWSO AI Services, специализирующейся на ИИ и машинном обучении для модерации контента, компьютерного зрения, обработки естественного языка и генеративного ИИ. Благодаря своему опыту она занимается продвижением решений AWS AI/ML и помогает клиентам трансформировать их бизнес-решения в различных отраслях, включая социальные сети, игры, электронную коммерцию, средства массовой информации, рекламу и маркетинг.

Равиша СК — старший технический менеджер по продукту в AWS, специализирующийся на искусственном интеллекте и машинном обучении. Она имеет более чем 10-летний опыт работы в области анализа данных и машинного обучения в различных областях. В свободное время она любит читать, экспериментировать на кухне и исследовать новые кофейни.

Равиша СК — старший технический менеджер по продукту в AWS, специализирующийся на искусственном интеллекте и машинном обучении. Она имеет более чем 10-летний опыт работы в области анализа данных и машинного обучения в различных областях. В свободное время она любит читать, экспериментировать на кухне и исследовать новые кофейни.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/flag-harmful-content-using-amazon-comprehend-toxicity-detection/

- :имеет

- :является

- :куда

- $UP

- 1

- 10

- 100

- 118

- 12

- 13

- 54

- 7

- a

- способность

- О нас

- Принять

- доступ

- через

- деятельность

- адресация

- Реклама

- влиять на

- AI

- Услуги искусственного интеллекта

- AI / ML

- причислены

- Amazon

- Amazon Comprehend

- Amazon Web Services

- усиливать

- an

- анализ

- аналитика

- и

- Другой

- API

- МЫ

- AS

- содействие

- At

- аудио

- автор

- автоматически

- доступен

- AWS

- основанный

- основа

- BE

- не являетесь

- между

- тело

- принес

- бизнес

- by

- призывают

- вызова

- CAN

- категории

- вызов

- проверка

- клиент

- код

- Кофе

- Комментарии

- Сообщества

- сообщество

- сложность

- уступчивый

- постигать

- компьютер

- Компьютерное зрение

- доверие

- Коммутация

- вследствие этого

- считается

- потреблять

- содержит

- содержание

- способствовать

- создает

- рецензирует

- решающее значение

- В настоящее время

- Клиенты

- подгонянный

- данным

- Анализ данных

- Знакомства

- преданный

- убивают

- демонстрирует

- описано

- подробный

- обнаруживать

- обнаружение

- А не было

- различный

- направлять

- непосредственно

- обсуждение

- подрывной

- Разное

- документ

- дело

- доменов

- Двери

- вождение

- динамика

- электронная коммерция

- каждый

- Ранее

- электронной коммерции

- или

- появление

- занятых

- обязательство

- Английский

- Окружающая среда

- этническая принадлежность

- постоянно растет

- Каждая

- пример

- дорогим

- опыт

- опыта

- Исследование

- всего лишь пяти граммов героина

- Особенность

- поле

- Файл

- Во-первых,

- Фокус

- после

- Что касается

- Форум

- 4

- свежий

- от

- игровой

- пол

- в общем

- порождать

- генерируется

- генеративный

- Генеративный ИИ

- Go

- графический

- группы

- Рост

- вред

- вредный

- he

- помогает

- ее

- High

- очень

- его

- Как

- How To

- Однако

- HTTP

- HTTPS

- человек

- i

- Идеально

- Личность

- изображений

- Влияние

- Импортировать

- in

- включают

- включает в себя

- В том числе

- включительно

- самостоятельно

- указывает

- промышленности

- промышленность

- причинить

- информация

- травма

- размышления

- обида

- намерение

- интерес

- интерфейсы

- в

- вводить

- IT

- пункты

- JPG

- JSON

- Этикетки

- язык

- большой

- последний

- УЧИТЬСЯ

- изучение

- такое как

- вероятность

- ОГРАНИЧЕНИЯ

- линия

- Список

- Списки

- Низкий

- машина

- обучение с помощью машины

- сделанный

- ДЕЛАЕТ

- человек

- менеджер

- управления

- Маркетинг

- материала

- Май..

- Медиа

- Участники

- Сообщения

- ML

- Модели

- умеренность

- БОЛЕЕ

- Более того

- имя

- Названный

- национальный

- натуральный

- Обработка естественного языка

- Необходимость

- отрицательно

- Новые

- НЛП

- сейчас

- объект

- of

- наступление

- Предложения

- .

- on

- онлайн

- онлайн-сообщества

- Операционный отдел

- or

- заказ

- происхождения

- выходной

- за

- общий

- обзор

- Владельцы

- боль

- части

- человек

- фразы

- физический

- одноцветный

- Платформа

- Платформы

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- Играть

- играет

- состояния потока

- После

- Блог

- мощностью

- предыдущий

- обработка

- Продукт

- Менеджер по продукции

- ПРОФАНСТВО

- Содействие

- для защиты

- обеспечивать

- при условии

- приводит

- психологический

- Питон

- Гонки

- ассортимент

- ранжирование

- Reading

- реалистичный

- получила

- получает

- относиться

- Рекомендации

- Несмотря на

- районы

- религия

- представляет

- запросить

- соответственно

- ответ

- отзывчивый

- результат

- обзоре

- правую

- Роли

- s

- безопасный

- то же

- Шкала

- Гол

- SDK

- SDKS

- Во-вторых

- Раздел

- Искать

- стремится

- сегмент

- сегментами

- Отправить

- старший

- Последовательность

- обслуживание

- Услуги

- Сессия

- семь

- Секс

- Сексуальный

- она

- магазинов

- Шоу

- Размер

- отрывок

- So

- Соцсети

- социальные сети

- Сообщения в социальных сетях

- Решение

- Решения

- Динамик

- специализация

- речь

- Шаг

- простой

- такие

- Поддержанный

- взять

- команда

- Технический

- terms

- текст

- который

- Ассоциация

- их

- Там.

- Эти

- они

- В третьих

- этой

- угрозы

- три

- Через

- время

- в

- к

- превращение

- тенденция

- Доверие

- напишите

- открывай

- использование

- Информация о пользователе

- пользователей

- использования

- через

- использовать

- ценный

- разнообразие

- Видео

- видение

- визуально

- яркий

- вульгарный

- хотеть

- we

- Web

- веб-сервисы

- Вебсайт

- были

- Что

- , которые

- зачем

- будете

- слова

- Рабочие процессы

- лет

- Ты

- ВАШЕ

- зефирнет