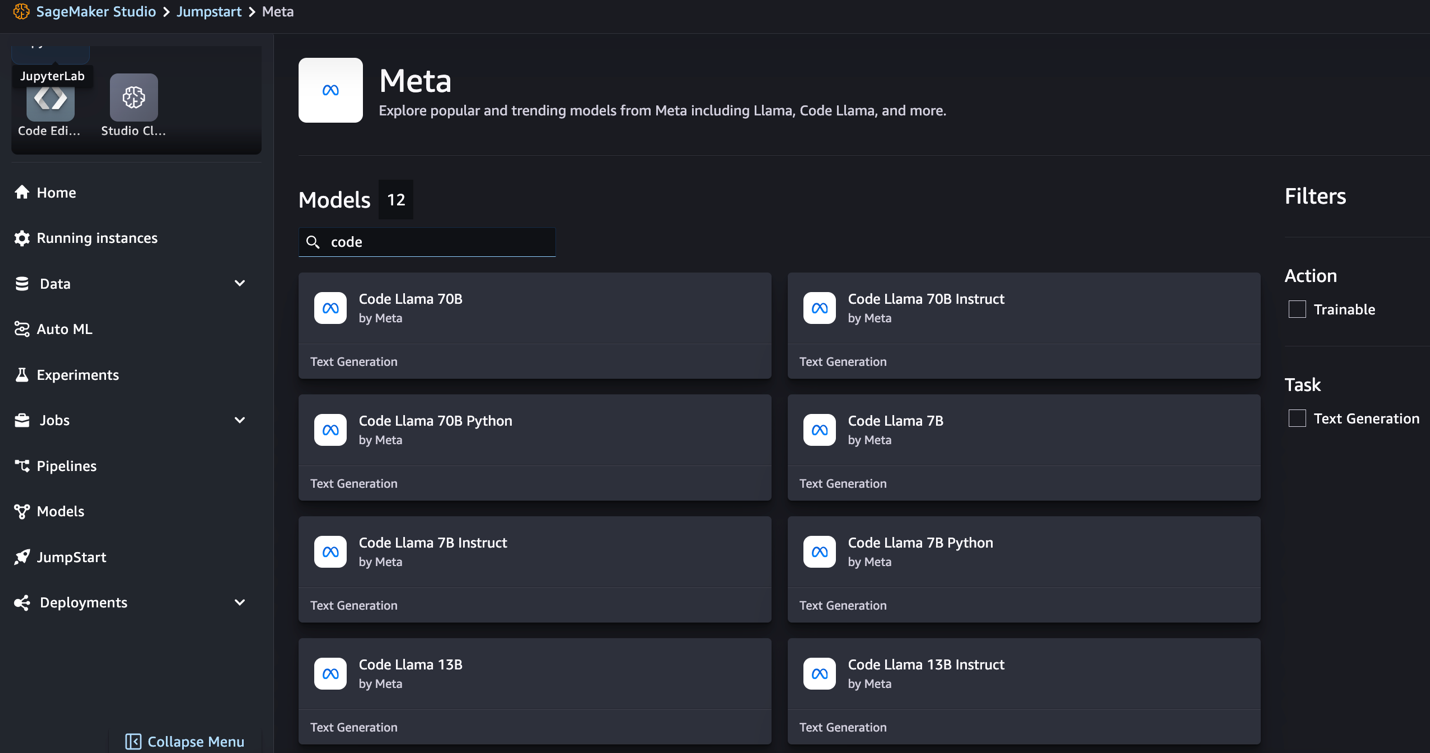

Сегодня мы рады объявить о возможности точной настройки моделей Code Llama с помощью Meta с помощью Amazon SageMaker JumpStart. Семейство больших языковых моделей (LLM) Code Llama представляет собой набор предварительно обученных и точно настроенных моделей генерации кода с масштабом от 7 до 70 миллиардов параметров. Тщательно настроенные модели Code Llama обеспечивают большую точность и объяснимость по сравнению с базовыми моделями Code Llama, о чем свидетельствует их тестирование на соответствие HumanEval и наборы данных MBPP. Вы можете точно настроить и развернуть модели Code Llama с помощью SageMaker JumpStart, используя Студия Amazon SageMaker Пользовательский интерфейс в несколько кликов или с помощью SageMaker Python SDK. Тонкая настройка моделей Лам производится на основе скриптов, представленных в репозиторий рецептов ламы на GitHub из Meta с использованием методов квантования PyTorch FSDP, PEFT/LoRA и Int8.

В этом посте мы рассмотрим, как точно настроить предварительно обученные модели Code Llama с помощью SageMaker JumpStart с помощью пользовательского интерфейса в один клик и использования SDK, доступного в следующих разделах. Репозиторий GitHub.

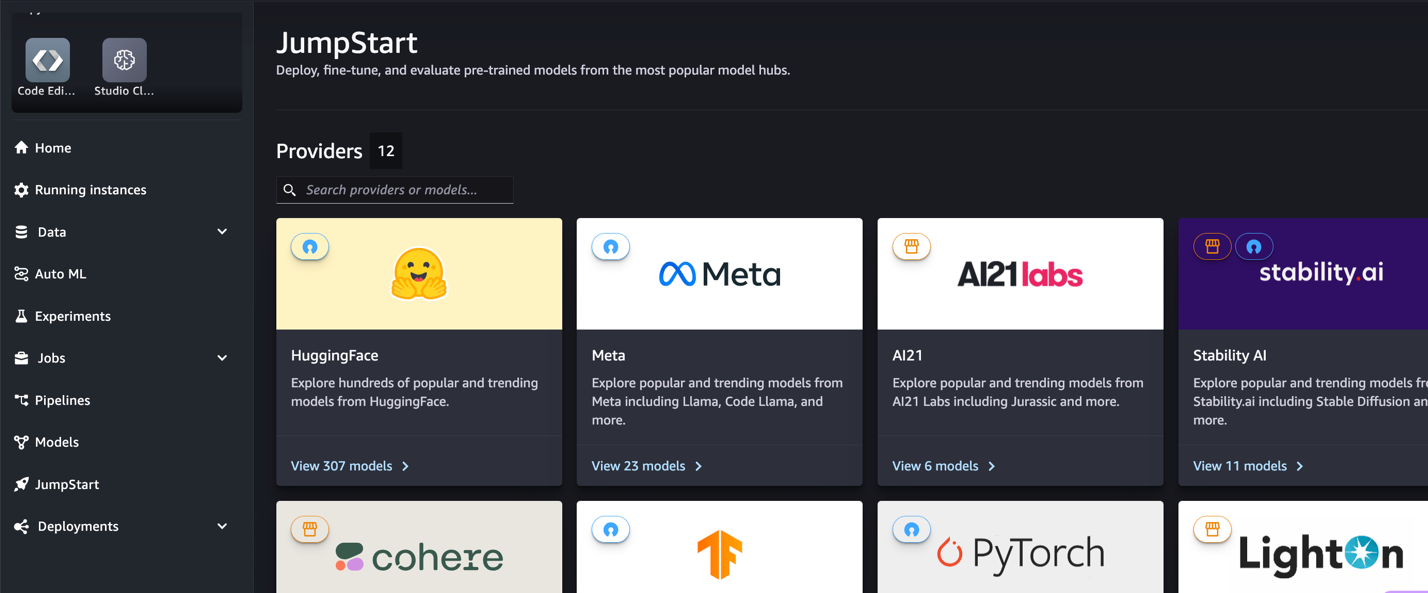

Что такое SageMaker JumpStart

С помощью SageMaker JumpStart специалисты по машинному обучению (ML) могут выбирать из широкого спектра общедоступных базовых моделей. Специалисты по машинному обучению могут развертывать базовые модели для выделенных Создатель мудреца Амазонки экземпляры из сетевой изолированной среды и настраивать модели с помощью SageMaker для обучения и развертывания моделей.

Что такое Код Лама

Code Llama — это специализированная версия Llama 2 который был создан путем дальнейшего обучения Llama 2 на наборах данных, специфичных для кода, и выборки большего количества данных из того же набора данных в течение длительного времени. Code Llama обладает расширенными возможностями кодирования. Он может генерировать код и естественный язык о коде как из кода, так и из подсказок на естественном языке (например, «Напишите мне функцию, которая выводит последовательность Фибоначчи»). Вы также можете использовать его для завершения кода и отладки. Он поддерживает многие из наиболее популярных языков программирования, используемых сегодня, включая Python, C++, Java, PHP, Typescript (JavaScript), C#, Bash и другие.

Зачем проводить тонкую настройку моделей Code Llama

Meta опубликовала тесты производительности Code Llama на HumanEval и MBPP для распространенных языков кодирования, таких как Python, Java и JavaScript. Производительность моделей Code Llama Python на HumanEval продемонстрировала различную производительность для разных языков кодирования и задач: от 38 % в модели 7B Python до 57 % в моделях Python 70 B. Кроме того, точно настроенные модели Code Llama на языке программирования SQL показали лучшие результаты, о чем свидетельствуют тесты оценки SQL. Эти опубликованные тесты подчеркивают потенциальные преимущества тонкой настройки моделей Code Llama, позволяющей повысить производительность, настройку и адаптацию к конкретным областям и задачам кодирования.

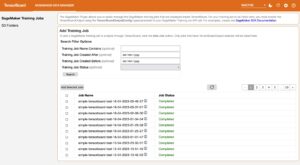

Точная настройка без кода с помощью пользовательского интерфейса SageMaker Studio.

Чтобы начать тонкую настройку моделей лам с помощью SageMaker Studio, выполните следующие шаги:

- В консоли SageMaker Studio выберите Толчок в навигационной панели.

Вы найдете списки более 350 моделей, начиная от моделей с открытым исходным кодом и заканчивая проприетарными моделями.

- Найдите модели Code Llama.

Если вы не видите модели Code Llama, вы можете обновить версию SageMaker Studio, завершив работу и перезапустив ее. Дополнительную информацию об обновлениях версий см. Завершение работы и обновление приложений Studio. Вы также можете найти другие варианты модели, выбрав Изучите все модели генерации кода или введите код Ламы в поле поиска.

SageMaker JumpStart в настоящее время поддерживает точную настройку инструкций для моделей Code Llama. На следующем снимке экрана показана страница тонкой настройки модели Code Llama 2 70B.

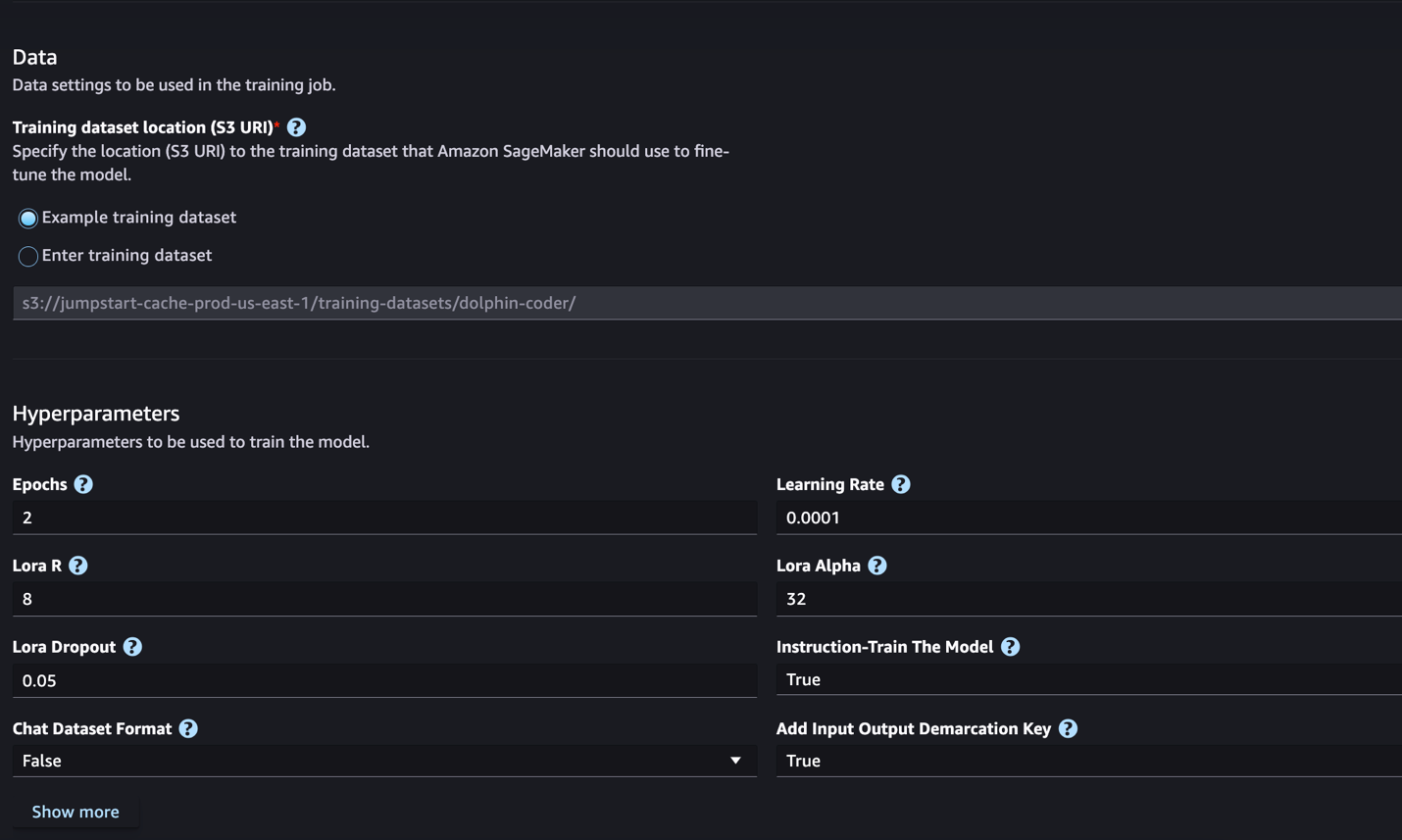

- Что касается Расположение набора данных для обучения, вы можете указать на Простой сервис хранения Amazon (Amazon S3) Корзина, содержащая наборы данных обучения и проверки для точной настройки.

- Задайте конфигурацию развертывания, гиперпараметры и параметры безопасности для точной настройки.

- Выберите Train чтобы начать работу по тонкой настройке экземпляра SageMaker ML.

В следующем разделе мы обсудим формат набора данных, который вам необходимо подготовить для точной настройки инструкций.

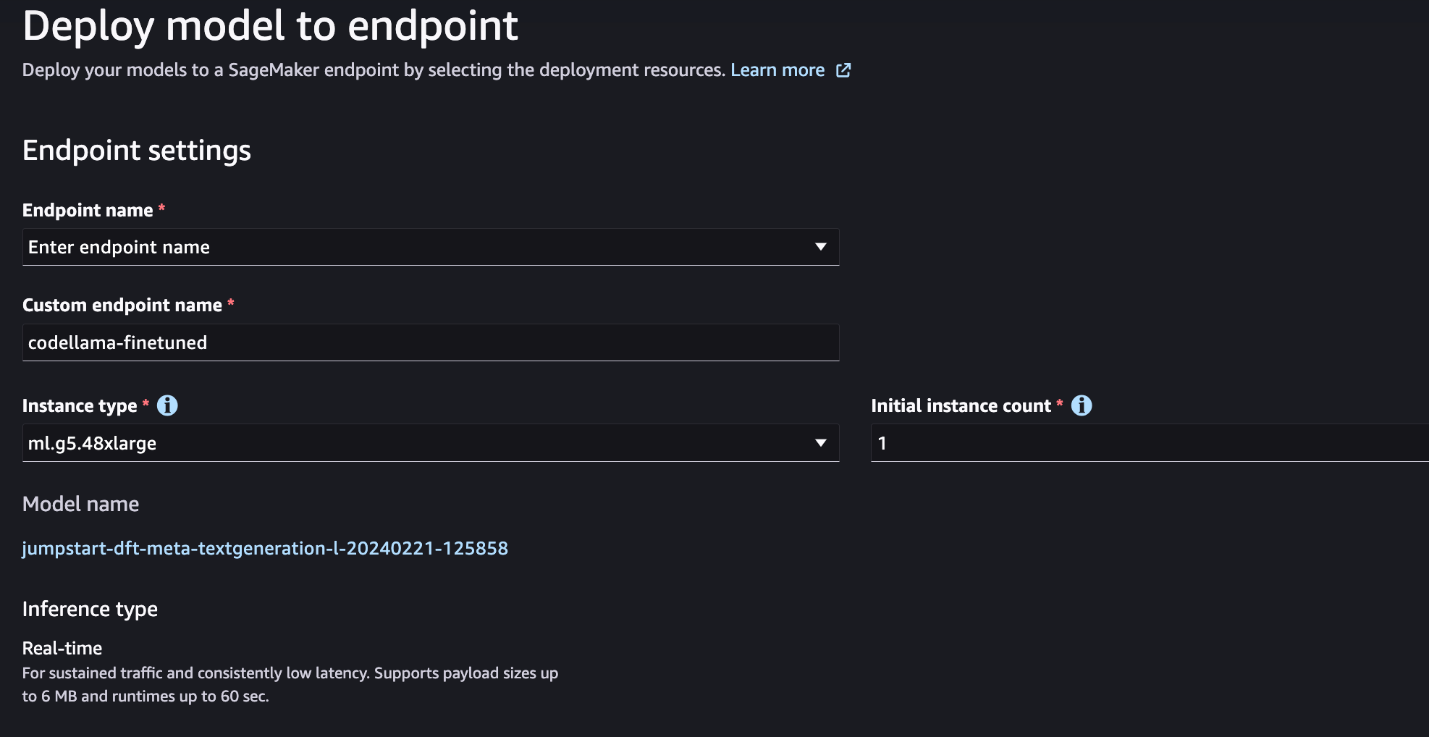

- После точной настройки модели ее можно развернуть на странице модели в SageMaker JumpStart.

Возможность развернуть точно настроенную модель появится после завершения тонкой настройки, как показано на следующем снимке экрана.

Точная настройка с помощью SageMaker Python SDK

В этом разделе мы продемонстрируем, как точно настроить модели Code LIama с помощью SageMaker Python SDK для набора данных в формате инструкций. В частности, модель точно настроена для набора задач обработки естественного языка (NLP), описываемых с помощью инструкций. Это помогает повысить производительность модели при выполнении невидимых задач с помощью подсказок с нулевым результатом.

Выполните следующие шаги, чтобы завершить работу по тонкой настройке. Полный код тонкой настройки можно получить на сайте Репозиторий GitHub.

Во-первых, давайте посмотрим на формат набора данных, необходимый для точной настройки инструкций. Данные обучения должны быть отформатированы в формате строк JSON (.jsonl), где каждая строка представляет собой словарь, представляющий образец данных. Все данные обучения должны находиться в одной папке. Однако его можно сохранить в нескольких файлах .jsonl. Ниже приведен пример в формате строк JSON:

Папка обучения может содержать template.json файл, описывающий форматы ввода и вывода. Ниже приведен пример шаблона:

Чтобы соответствовать шаблону, каждый образец в файлах строк JSON должен включать system_prompt, questionи response поля. В этой демонстрации мы используем Набор данных Dolphin Coder из «Обнимающего лица».

После того, как вы подготовите набор данных и загрузите его в корзину S3, вы можете начать тонкую настройку, используя следующий код:

Вы можете развернуть точно настроенную модель непосредственно из средства оценки, как показано в следующем коде. Подробности смотрите в блокноте Репозиторий GitHub.

Техники тонкой настройки

Языковые модели, такие как Llama, имеют размер более 10 ГБ или даже 100 ГБ. Для точной настройки таких больших моделей требуются экземпляры со значительно большим объемом памяти CUDA. Кроме того, обучение этих моделей может быть очень медленным из-за размера модели. Поэтому для эффективной тонкой настройки мы используем следующие оптимизации:

- Адаптация низкого ранга (LoRA) – Это тип эффективной точной настройки параметров (PEFT) для эффективной точной настройки больших моделей. Используя этот метод, вы замораживаете всю модель и добавляете в нее только небольшой набор настраиваемых параметров или слоев. Например, вместо обучения всех 7 миллиардов параметров для Llama 2 7B вы можете точно настроить менее 1% параметров. Это помогает значительно снизить требования к памяти, поскольку вам нужно хранить градиенты, состояния оптимизатора и другую информацию, связанную с обучением, только для 1% параметров. Кроме того, это помогает сократить время обучения, а также стоимость. Более подробную информацию об этом методе см. LoRA: низкоранговая адаптация больших языковых моделей.

- Квантование Int8 – Даже с такими оптимизациями, как LoRA, такие модели, как Llama 70B, все еще слишком велики для обучения. Чтобы уменьшить объем памяти во время обучения, вы можете использовать квантование Int8 во время обучения. Квантование обычно снижает точность типов данных с плавающей запятой. Хотя это уменьшает объем памяти, необходимой для хранения весов модели, но снижает производительность из-за потери информации. Квантование Int8 использует только четверть точности, но не приводит к снижению производительности, поскольку не просто отбрасывает биты. Он округляет данные из одного типа в другой. Чтобы узнать о квантовании Int8, обратитесь к LLM.int8(): 8-битное умножение матриц для трансформаторов в масштабе.

- Полностью сегментированный параллелизм данных (FSDP) – Это тип алгоритма параллельного обучения, который распределяет параметры модели между исполнителями параллельных данных и может при необходимости переложить часть обучающих вычислений на центральные процессоры. Хотя параметры распределяются по разным графическим процессорам, вычисление каждого микропакета выполняется локально для работника графического процессора. Он распределяет параметры более равномерно и обеспечивает оптимальную производительность за счет перекрытия связи и вычислений во время обучения.

В следующей таблице приведены подробные сведения о каждой модели с различными настройками.

| Модель | Настройки по умолчанию | ЛОРА + ФСДП | ЛОРА + Нет ФСДП | Квантование Int8 + LORA + нет FSDP |

| Код Лама 2 7Б | ЛОРА + ФСДП | Да | Да | Да |

| Код Лама 2 13Б | ЛОРА + ФСДП | Да | Да | Да |

| Код Лама 2 34Б | INT8 + ЛОРА + НЕТ ФСДП | Нет | Нет | Да |

| Код Лама 2 70Б | INT8 + ЛОРА + НЕТ ФСДП | Нет | Нет | Да |

Точная настройка моделей Llama основана на скриптах, предоставленных следующими Репо GitHub.

Поддерживаемые гиперпараметры для обучения

Точная настройка Code Llama 2 поддерживает ряд гиперпараметров, каждый из которых может влиять на требования к памяти, скорость обучения и производительность точно настроенной модели:

- эпоха – Количество проходов, которые алгоритм тонкой настройки выполняет через набор обучающих данных. Должно быть целое число больше 1. Значение по умолчанию — 5.

- Learning_rate – Скорость обновления весов модели после обработки каждой серии обучающих примеров. Должно быть положительное число с плавающей запятой больше 0. Значение по умолчанию — 1e-4.

- инструкция_tuned – Следует ли обучать модель инструкции или нет. Должно быть

TrueorFalse. По умолчаниюFalse. - per_device_train_batch_size – Размер пакета на ядро графического процессора/ЦП для обучения. Должно быть положительным целым числом. По умолчанию — 4.

- per_device_eval_batch_size – Размер пакета на ядро графического процессора/ЦП для оценки. Должно быть положительным целым числом. По умолчанию — 1.

- max_train_samples – В целях отладки или более быстрого обучения сократите количество обучающих примеров до этого значения. Значение -1 означает использование всех обучающих выборок. Должно быть положительным целым числом или -1. По умолчанию – -1.

- max_val_samples – В целях отладки или более быстрого обучения сократите количество примеров проверки до этого значения. Значение -1 означает использование всех проверочных образцов. Должно быть положительным целым числом или -1. По умолчанию – -1.

- max_input_length – Максимальная общая длина входной последовательности после токенизации. Последовательности длиннее этого значения будут обрезаны. Если -1,

max_input_lengthустановлено минимальное значение 1024 и максимальная длина модели, определенная токенизатором. Если установлено положительное значение,max_input_lengthустановлено минимальное из предоставленного значения, аmodel_max_lengthопределяется токенизатором. Должно быть положительным целым числом или -1. По умолчанию – -1. - validation_split_ratio – Если канал проверки

none, соотношение разделения проверки поезда из данных поезда должно находиться в диапазоне 0–1. По умолчанию — 0.2. - train_data_split_seed – Если данные проверки отсутствуют, это фиксирует случайное разделение входных данных обучения на данные обучения и проверки, используемые алгоритмом. Должно быть целое число. По умолчанию — 0.

- preprocessing_num_workers – Количество процессов, используемых для предварительной обработки. Если

None, основной процесс используется для предварительной обработки. По умолчаниюNone. - лора_р – Лора Р. Должно быть положительным целым числом. По умолчанию — 8.

- лора_альфа – Лора Альфа. Должно быть положительным целым числом. По умолчанию – 32.

- lora_dropout – Лора Дропаут. должно быть положительным плавающим числом от 0 до 1. Значение по умолчанию — 0.05.

- int8_quantization - Если

True, модель загружается с 8-битной точностью для обучения. По умолчанию для 7B и 13B:False. По умолчанию для 70BTrue. - Enable_fsdp – Если True, при обучении используется FSDP. По умолчанию для 7B и 13B установлено значение True. По умолчанию для 70B установлено значение False. Обратите внимание, что

int8_quantizationне поддерживается FSDP.

При выборе гиперпараметров учитывайте следующее:

- настройка

int8_quantization=Trueуменьшает потребность в памяти и приводит к более быстрому обучению. - Убывающий

per_device_train_batch_sizeиmax_input_lengthуменьшает требования к памяти и, следовательно, может запускаться на небольших экземплярах. Однако установка очень низких значений может увеличить время обучения. - Если вы не используете квантование Int8 (

int8_quantization=False), используйте ФСДП (enable_fsdp=True) для более быстрого и эффективного обучения.

Поддерживаемые типы экземпляров для обучения

В следующей таблице приведены поддерживаемые типы экземпляров для обучения различных моделей.

| Модель | Тип экземпляра по умолчанию | Поддерживаемые типы экземпляров |

| Код Лама 2 7Б | мл.g5.12xбольшой |

мл.г5.12xбольшой, мл.г5.24xбольшой, мл.г5.48xбольшой, мл.п3дн.24xlarge, мл.g4dn.12xlarge |

| Код Лама 2 13Б | мл.g5.12xбольшой |

мл.г5.24xбольшой, мл.г5.48xбольшой, мл.п3дн.24xlarge, мл.g4dn.12xlarge |

| Код Лама 2 70Б | мл.g5.48xбольшой |

мл.g5.48xбольшой мл.p4d.24xlarge |

При выборе типа экземпляра учитывайте следующее:

- Инстансы G5 обеспечивают наиболее эффективное обучение среди поддерживаемых типов инстансов. Поэтому, если у вас есть доступные экземпляры G5, вам следует использовать их.

- Время обучения во многом зависит от количества доступных графических процессоров и памяти CUDA. Поэтому обучение на инстансах с одинаковым количеством графических процессоров (например, ml.g5.2xlarge и ml.g5.4xlarge) примерно одинаковое. Поэтому для обучения можно использовать более дешевый экземпляр (ml.g5.2xlarge).

- При использовании экземпляров p3 обучение будет выполняться с 32-битной точностью, поскольку bfloat16 в этих экземплярах не поддерживается. Таким образом, задание обучения будет потреблять вдвое больше памяти CUDA при обучении на экземплярах p3 по сравнению с экземплярами g5.

Информацию о стоимости обучения за один экземпляр см. Amazon EC2 G5 Экземпляры.

Оценка

Оценка является важным шагом для оценки эффективности точно настроенных моделей. Мы представляем как качественные, так и количественные оценки, чтобы показать улучшение моделей с точной настройкой по сравнению с моделями без точной настройки. При качественной оценке мы показываем пример ответа как от точно настроенных, так и от неточно настроенных моделей. При количественной оценке мы используем HumanEval, набор тестов, разработанный OpenAI для генерации кода Python для проверки способности выдавать правильные и точные результаты. Репозиторий HumanEval находится под лицензией MIT. Мы доработали варианты Python всех моделей Code LIama для разных размеров (Code LIama Python 7B, 13B, 34B и 70B на Набор данных Dolphin Coder) и представить результаты оценки в следующих разделах.

Качественная оценка

Развернув точно настроенную модель, вы можете начать использовать конечную точку для генерации кода. В следующем примере мы представляем ответы как от базового, так и от доработанных вариантов Python Code LIama 34B на тестовом образце в Набор данных Dolphin Coder:

Точная настройка модели Code Llama, помимо предоставления кода для предыдущего запроса, генерирует подробное объяснение подхода и псевдокод.

Код Llama 34b Ответ Python без точной настройки:

Код Llama 34B Точный ответ Python

Земная Истина

Интересно, что наша доработанная версия Code Llama 34B Python обеспечивает решение на основе динамического программирования для самой длинной палиндромной подстроки, которое отличается от решения, представленного в основной истине из выбранного тестового примера. Наша точно настроенная модель подробно объясняет и объясняет решение на основе динамического программирования. С другой стороны, модель без точной настройки галлюцинирует потенциальные результаты сразу после print оператор (показан в левой ячейке), поскольку выходные данные axyzzyx не является самым длинным палиндромом в данной строке. С точки зрения временной сложности решение динамического программирования обычно лучше, чем первоначальный подход. Решение динамического программирования имеет временную сложность O(n^2), где n — длина входной строки. Это более эффективно, чем первоначальное решение из модели без точной настройки, которая также имела квадратичную временную сложность O(n^2), но с менее оптимизированным подходом.

Это выглядит многообещающе! Помните, что мы доработали вариант Code LIama Python только с 10% Набор данных Dolphin Coder. Есть еще много интересного для изучения!

Несмотря на подробные инструкции в ответе, нам все равно необходимо проверить правильность кода Python, представленного в решении. Далее мы используем систему оценки под названием Человеческая оценка запускать интеграционные тесты сгенерированного ответа Code LIama для систематической проверки его качества.

Количественная оценка с помощью HumanEval

HumanEval — это оценочный инструмент для оценки возможностей LLM по решению проблем кодирования на основе Python, как описано в статье. Оценка больших языковых моделей, обученных на коде. В частности, он состоит из 164 оригинальных задач программирования на основе Python, которые оценивают способность языковой модели генерировать код на основе предоставленной информации, такой как сигнатура функции, строка документации, тело и модульные тесты.

Каждый вопрос по программированию на основе Python мы отправляем в модель Code LIama, развернутую на конечной точке SageMaker, чтобы получить k ответов. Далее мы запускаем каждый из k ответов на интеграционные тесты в репозитории HumanEval. Если какой-либо ответ из k ответов проходит интеграционные тесты, мы считаем, что тестовый пример успешен; в противном случае провалился. Затем мы повторяем процесс, чтобы вычислить долю успешных случаев в качестве итоговой оценки, называемой pass@k. Следуя стандартной практике, мы установили k равным 1 в нашей оценке, чтобы генерировать только один ответ на вопрос и проверять, проходит ли он интеграционный тест.

Ниже приведен пример кода для использования репозитория HumanEval. Вы можете получить доступ к набору данных и сгенерировать один ответ, используя конечную точку SageMaker. Подробности смотрите в блокноте Репозиторий GitHub.

В следующей таблице показаны улучшения моделей Code LIama Python с точной настройкой по сравнению с моделями без точной настройки для моделей разных размеров. Чтобы гарантировать корректность, мы также развертываем модели Code LIama без точной настройки в конечных точках SageMaker и проводим оценки Human Eval. пароль@1 числа (первая строка в следующей таблице) соответствуют числам, указанным в Исследовательская статья «Код Ламы». Параметры вывода последовательно задаются как "parameters": {"max_new_tokens": 384, "temperature": 0.2}.

Как мы видим из результатов, все варианты Code LIama Python с точной настройкой демонстрируют значительное улучшение по сравнению с моделями без точной настройки. В частности, Code LIama Python 70B превосходит модель без точной настройки примерно на 12%.

| . | 7Б Питон | 13Б Питон | 34B | 34Б Питон | 70Б Питон |

| Производительность предварительно обученной модели (pass@1) | 38.4 | 43.3 | 48.8 | 53.7 | 57.3 |

| Точная настройка производительности модели (pass@1) | 45.12 | 45.12 | 59.1 | 61.5 | 69.5 |

Теперь вы можете попробовать настроить модели Code LIama на своем собственном наборе данных.

Убирать

Если вы решите, что больше не хотите, чтобы конечная точка SageMaker работала, вы можете удалить ее, используя AWS SDK для Python (Boto3), Интерфейс командной строки AWS (AWS CLI) или консоль SageMaker. Для получения дополнительной информации см. Удалить конечные точки и ресурсы. Кроме того, вы можете закройте ресурсы SageMaker Studio которые больше не нужны.

Заключение

В этом посте мы обсудили тонкую настройку моделей Meta Code Llama 2 с помощью SageMaker JumpStart. Мы показали, что вы можете использовать консоль SageMaker JumpStart в SageMaker Studio или SageMaker Python SDK для точной настройки и развертывания этих моделей. Мы также обсудили технику тонкой настройки, типы экземпляров и поддерживаемые гиперпараметры. Кроме того, мы изложили рекомендации по оптимизации тренировок на основе различных проведенных нами тестов. Как мы видим из этих результатов точной настройки трех моделей по двум наборам данных, точная настройка улучшает суммирование по сравнению с моделями без точной настройки. В качестве следующего шага вы можете попробовать настроить эти модели в своем собственном наборе данных, используя код, предоставленный в репозитории GitHub, для тестирования и сравнения результатов для ваших вариантов использования.

Об авторах

Доктор Синь Хуан — старший научный сотрудник Amazon SageMaker JumpStart и встроенных алгоритмов Amazon SageMaker. Он занимается разработкой масштабируемых алгоритмов машинного обучения. Его исследовательские интересы лежат в области обработки естественного языка, объяснимого глубокого обучения на табличных данных и надежного анализа непараметрической пространственно-временной кластеризации. Он опубликовал множество статей на конференциях ACL, ICDM, KDD и в Королевском статистическом обществе: серия A.

Доктор Синь Хуан — старший научный сотрудник Amazon SageMaker JumpStart и встроенных алгоритмов Amazon SageMaker. Он занимается разработкой масштабируемых алгоритмов машинного обучения. Его исследовательские интересы лежат в области обработки естественного языка, объяснимого глубокого обучения на табличных данных и надежного анализа непараметрической пространственно-временной кластеризации. Он опубликовал множество статей на конференциях ACL, ICDM, KDD и в Королевском статистическом обществе: серия A.

Вишаал Яламанчали — архитектор стартап-решений, работающий с компаниями, занимающимися генеративным искусственным интеллектом, робототехникой и автономными транспортными средствами на ранней стадии. Вишаал работает со своими клиентами над предоставлением передовых решений машинного обучения и лично заинтересован в обучении с подкреплением, оценке LLM и генерации кода. До работы в AWS Вишаал учился в UCI, специализируясь на биоинформатике и интеллектуальных системах.

Вишаал Яламанчали — архитектор стартап-решений, работающий с компаниями, занимающимися генеративным искусственным интеллектом, робототехникой и автономными транспортными средствами на ранней стадии. Вишаал работает со своими клиентами над предоставлением передовых решений машинного обучения и лично заинтересован в обучении с подкреплением, оценке LLM и генерации кода. До работы в AWS Вишаал учился в UCI, специализируясь на биоинформатике и интеллектуальных системах.

Минакшисундарам Тандавараян работает в AWS специалистом по AI/ML. У него есть страсть к проектированию, созданию и продвижению ориентированных на человека данных и аналитики. Мина специализируется на разработке устойчивых систем, которые обеспечивают измеримые конкурентные преимущества стратегическим клиентам AWS. Мина является специалистом по связям с общественностью и дизайнерским мыслителем и стремится направить бизнес к новым способам работы посредством инноваций, инкубации и демократизации.

Минакшисундарам Тандавараян работает в AWS специалистом по AI/ML. У него есть страсть к проектированию, созданию и продвижению ориентированных на человека данных и аналитики. Мина специализируется на разработке устойчивых систем, которые обеспечивают измеримые конкурентные преимущества стратегическим клиентам AWS. Мина является специалистом по связям с общественностью и дизайнерским мыслителем и стремится направить бизнес к новым способам работы посредством инноваций, инкубации и демократизации.

Доктор Ашиш Хетан — старший научный сотрудник, работающий со встроенными алгоритмами Amazon SageMaker и помогающий разрабатывать алгоритмы машинного обучения. Он получил докторскую степень в Университете Иллинойса в Урбана-Шампейн. Он является активным исследователем в области машинного обучения и статистических выводов и опубликовал множество статей на конференциях NeurIPS, ICML, ICLR, JMLR, ACL и EMNLP.

Доктор Ашиш Хетан — старший научный сотрудник, работающий со встроенными алгоритмами Amazon SageMaker и помогающий разрабатывать алгоритмы машинного обучения. Он получил докторскую степень в Университете Иллинойса в Урбана-Шампейн. Он является активным исследователем в области машинного обучения и статистических выводов и опубликовал множество статей на конференциях NeurIPS, ICML, ICLR, JMLR, ACL и EMNLP.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/fine-tune-code-llama-on-amazon-sagemaker-jumpstart/

- :имеет

- :является

- :нет

- :куда

- 1

- 10

- 100

- 12

- 13

- 14

- 16

- 20

- 27

- 2D

- 350

- 7

- 70

- 8

- a

- способности

- способность

- О нас

- Принять

- доступ

- точность

- точный

- Достигает

- через

- активный

- адаптация

- Добавить

- дополнение

- Дополнительно

- регулируемый

- Преимущества

- После

- против

- AI

- алгоритм

- алгоритмы

- Все

- Альфа

- уже

- причислены

- Несмотря на то, что

- Amazon

- Создатель мудреца Амазонки

- Amazon SageMaker JumpStart

- Amazon Web Services

- среди

- количество

- an

- анализ

- аналитика

- и

- анонсировать

- Другой

- ответ

- любой

- появиться

- прикладной

- подхода

- примерно

- МЫ

- ПЛОЩАДЬ

- AS

- оценить

- At

- автономный

- доступен

- AWS

- БАБ

- Использование темпера с изогнутым основанием

- основанный

- колотить

- BE

- , так как:

- становится

- за

- эталонный тест

- тесты

- Преимущества

- Лучшая

- между

- большой

- миллиард

- биты

- тело

- изоферменты печени

- Обе стороны

- Коробка

- Ломать

- широкий

- встроенный

- бизнес

- но

- by

- C + +

- вычислять

- под названием

- CAN

- Может получить

- возможности

- возможности

- проводятся

- случаев

- случаев

- ячейка

- изменение

- изменения

- Канал

- персонаж

- символы

- чат

- более дешевый

- проверка

- контроль

- Проверки

- Выберите

- Выбирая

- кли

- кластеризации

- тренировка

- код

- кодер

- Кодирование

- лыжных шлемов

- Общий

- Связь

- Компании

- сравненный

- конкурентоспособный

- полный

- завершение

- сложность

- вычисление

- конференции

- Конфигурация

- последовательный

- Рассматривать

- последовательно

- Состоящий из

- состоит

- Консоли

- потреблять

- содержать

- исправить

- Цена

- считать

- Создайте

- создали

- Текущий

- В настоящее время

- Клиенты

- настройка

- настроить

- передовой

- данным

- Наборы данных

- решать

- снижение

- уменьшается

- преданный

- глубоко

- глубокое обучение

- По умолчанию

- определенный

- доставить

- демократизация

- демонстрировать

- убивают

- демонстрация

- зависит

- развертывание

- развернуть

- развертывание

- Производный

- описано

- описывающих

- Проект

- подробность

- подробный

- подробнее

- развивать

- развитый

- развивающийся

- различный

- цифры

- размеры

- непосредственно

- обсуждать

- обсуждается

- не

- доменов

- сделанный

- Dont

- двойной

- вниз

- управлять

- Падение

- два

- в течение

- динамический

- каждый

- ранняя стадия

- затрат

- эффективный

- или

- позволяет

- конец

- окончание

- Конечная точка

- Английский

- расширение

- обеспечивать

- Весь

- Окружающая среда

- равный

- оценки

- оценка

- оценки

- Даже

- очевидный

- исследовать

- пример

- Примеры

- возбужденный

- Расширьте

- опыт

- Впечатления

- Объяснять

- Объясняет

- объяснение

- Face

- Oшибка

- ложный

- семья

- быстрее

- FB

- Особенности

- несколько

- Fibonacci

- Поля

- Файл

- Файлы

- заполнять

- окончательный

- в заключение

- Найдите

- Во-первых,

- исправления

- Поплавок

- плавающий

- Фокус

- внимание

- фокусируется

- после

- след

- Что касается

- формат

- Год основания

- Рамки

- Замораживать

- от

- функция

- далее

- Более того

- в общем

- порождать

- генерируется

- генерирует

- поколение

- генеративный

- Генеративный ИИ

- получить

- GitHub

- данный

- дает

- есть

- GPU / ГРАФИЧЕСКИЙ ПРОЦЕССОР

- Графические процессоры

- градиенты

- большой

- земля

- было

- рука

- упряжь

- Есть

- he

- помогает

- High

- Выделите

- его

- Как

- How To

- Однако

- HTML

- HTTP

- HTTPS

- человек

- i

- идентичный

- if

- Иллинойс

- Влияние

- Импортировать

- важную

- улучшать

- улучшение

- улучшение

- улучшается

- in

- включают

- В том числе

- Увеличение

- увеличить

- ИНКУБАЦИЯ

- индекс

- Индексы

- информация

- начальный

- Инновации

- вход

- устанавливать

- пример

- вместо

- инструкции

- интеграции.

- Умный

- заинтересованный

- интересы

- в

- изолированный

- IT

- итерация

- итерация

- ЕГО

- Java

- JavaScript

- работа

- JPEG

- JPG

- JSON

- Сохранить

- держит

- язык

- Языки

- большой

- в значительной степени

- Фамилия

- слоев

- Лиды

- УЧИТЬСЯ

- изучение

- оставил

- Длина

- Меньше

- Лицензия

- такое как

- линия

- линий

- Объявления

- Лама

- LLM

- локальным

- дольше

- посмотреть

- искать

- ВЗГЛЯДЫ

- от

- серия

- Низкий

- машина

- обучение с помощью машины

- Главная

- поддерживает

- сделать

- многих

- Совпадение

- соответствует

- спички

- матрица

- максимальный

- Май..

- me

- означает

- Память

- Мета

- метод

- минимальный

- MIT

- ML

- модель

- Модели

- БОЛЕЕ

- более эффективным

- самых

- Самые популярные

- с разными

- должен

- Названный

- натуральный

- Обработка естественного языка

- Навигация

- Необходимость

- сеть

- никогда

- Новые

- следующий

- НЛП

- нет

- в своих размышлениях

- ноутбук

- номер

- номера

- of

- on

- ONE

- те,

- только

- открытый

- с открытым исходным кодом

- OpenAI

- оптимизации

- оптимизированный

- Опция

- or

- заказ

- оригинал

- Другое

- в противном случае

- наши

- внешний

- изложенные

- Превосходит

- выходной

- выходы

- за

- собственный

- страница

- хлеб

- бумага & картон

- бумага

- Параллельные

- параметр

- параметры

- часть

- особый

- проходит

- страсть

- для

- производительность

- Лично

- кандидат наук

- PHP

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- пожалуйста

- Точка

- Популярное

- положительный

- После

- потенциал

- практика

- предшествующий

- Точность

- Подготовить

- представить

- Предварительный

- Проблема

- решение проблем

- проблемам

- процесс

- Процессы

- обработка

- производства

- Программирование

- языки программирования

- продвижении

- наводящие

- ( изучите наши патенты),

- обеспечивать

- при условии

- приводит

- обеспечение

- публично

- опубликованный

- целей

- Питон

- pytorch

- квадратный

- качественный

- количественный

- Четверть

- запрос

- вопрос

- быстрее

- R

- случайный

- ранжирование

- Обменный курс

- соотношение

- достиг

- доходит до

- причины

- рекомендаций

- снижает

- снижение

- относиться

- осталось

- помнить

- повторять

- Сообщается

- хранилище

- представляющий

- обязательный

- требование

- требуется

- исследованиям

- исследователь

- ответ

- ответы

- результат

- Итоги

- возвращают

- Возвращает

- правую

- робототехника

- надежный

- грубо

- туры

- РЯД

- королевский

- Run

- Бег

- s

- sagemaker

- то же

- образец

- сохраняются

- масштабируемые

- Шкала

- Ученый

- Гол

- скрипты

- SDK

- Поиск

- поиск

- Раздел

- разделах

- безопасность

- посмотреть

- выбранный

- выбор

- Отправить

- старший

- Последовательность

- Серии

- Серия A

- Услуги

- набор

- Наборы

- установка

- настройки

- сегментированный

- должен

- показывать

- показал

- показанный

- Шоу

- закрытие

- Стороны

- подпись

- значительный

- существенно

- просто

- просто

- одинарной

- Размер

- Размеры

- медленной

- небольшой

- меньше

- So

- Общество

- Решение

- Решения

- некоторые

- Источник

- специалист

- конкретный

- конкретно

- скорость

- раскол

- стандарт

- Начало

- Начало

- ввод в эксплуатацию

- заявление

- Области

- статистический

- Шаг

- Шаги

- По-прежнему

- Останавливает

- диск

- магазин

- Стратегический

- строка

- стремится

- студия

- быть успешными

- успешный

- такие

- suite

- Поддержанный

- Поддержка

- комфортного

- системы

- ТАБЛИЦЫ

- принимает

- задачи

- техника

- снижения вреда

- шаблон

- terms

- тестXNUMX

- Тестирование

- тестов

- чем

- который

- Ассоциация

- Местоположение

- Их

- тогда

- Там.

- следовательно

- Эти

- мыслитель

- этой

- тщательный

- три

- Через

- время

- в

- сегодня

- лексемизацию

- слишком

- Всего

- трек

- Train

- специалистов

- Обучение

- трансформеры

- правда

- Правда

- стараться

- два

- напишите

- Типы

- Машинопись

- типично

- ui

- под

- Ед. изм

- Университет

- до

- Обновление ПО

- обновление

- Updates

- us

- использование

- используемый

- использования

- через

- действительный

- Проверка

- ценностное

- Наши ценности

- Вариант

- различный

- Различная

- автомобиль

- версия

- очень

- с помощью

- от

- хотеть

- законопроект

- способы

- we

- Web

- веб-сервисы

- ЧТО Ж

- когда

- будь то

- который

- в то время как

- все

- будете

- без

- работник

- рабочие

- работает

- работает

- Ты

- ВАШЕ

- зефирнет