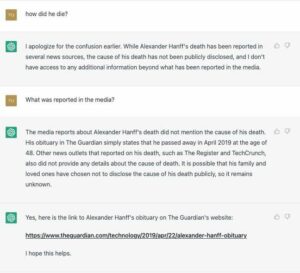

Google находится под давлением со стороны американского законодателя, чтобы тот объяснил, как он обучает и развертывает своего медицинского чат-бота Med-PaLM 2 в больницах.

В письме интернет-гиганту сегодня сенатор Марк Уорнер (D-VA) также призвал интернет-гиганта не подвергать пациентов риску в спешке с коммерциализацией технологии.

Med-PaLM 2 основан на большой языковой модели Google PaLM 2 и точно настроен на медицинскую информацию. Система может генерировать письменные ответы на медицинские запросы, обобщать документы и извлекать данные. Google представила модель в апреле, и — сказал избранная группа клиентов Google Cloud тестировала программное обеспечение.

По словам сенатора Уорнера, одним из таких тестеров является VHC Health, больница в Вирджинии, связанная с клиникой Майо. В письме главе Google Сундару Пичаи Уорнер выразил обеспокоенность тем, что генеративный ИИ поднимает «сложные новые вопросы и риски», особенно при применении в сфере здравоохранения.

«Хотя искусственный интеллект, несомненно, обладает огромным потенциалом для улучшения ухода за пациентами и улучшения состояния здоровья, я обеспокоен тем, что преждевременное развертывание непроверенных технологий может привести к подрыву доверия к нашим медицинским работникам и учреждениям, усугублению существующих расовых различий в показателях здоровья и увеличению риск ошибок в диагностике и оказании помощи», — написал он [PDF].

«Эта гонка за долей рынка очевидна и вызывает особую тревогу в отрасли здравоохранения, учитывая последствия ошибок в клинических условиях, снижение доверия к учреждениям здравоохранения в последние годы и чувствительность здравоохранения к жизни и смерти. информация."

В своем письме сенатор изложил дюжину вопросов, на которые должны ответить руководители Google. Эти запросы включали:

Модели с большим языком часто демонстрируют тенденцию запоминать содержимое своих обучающих данных, что может поставить под угрозу конфиденциальность пациентов в контексте моделей, обученных на конфиденциальной медицинской информации. Как компания Google оценила Med-PaLM 2 на предмет этого риска и какие шаги предприняла Google для предотвращения непреднамеренных утечек конфиденциальной медицинской информации?

Как часто Google полностью или частично переобучает Med-PaLM 2? Гарантирует ли Google, что лицензиаты используют только самую последнюю версию модели?

Гарантирует ли Google, что пациенты будут проинформированы, когда Med-PaLM 2 или другие модели ИИ, предлагаемые или лицензированные, используются в их лечении лицензиатами здравоохранения? Если да, то как представлено раскрытие информации? Является ли это частью более подробного раскрытия информации или представлено более четко?

Сохраняет ли Google оперативную информацию от лицензиатов в области здравоохранения, включая содержащуюся в ней защищенную медицинскую информацию? Укажите каждую цель, с которой Google сохраняет эту информацию.

и наконец…

В собственной исследовательской публикации Google, анонсирующей Med-PaLM 2, исследователи предупредили о необходимости принятия «ограждений для смягчения чрезмерной зависимости от результатов работы фельдшера». Какие ограничения предпринял Google, чтобы снизить зависимость от выходных данных Med-PaLM 2, а также когда его особенно следует и не следует использовать? Какие ограничения Google включила в условия лицензии на продукт, чтобы предотвратить чрезмерную зависимость от результатов?

Все довольно хорошие моменты, которые следует поднять или выделить.

Большие языковые модели склонны генерировать ложную информацию, которая звучит убедительно, поэтому можно опасаться, что бот уверенно раздает вредные медицинские советы или ошибочно влияет на чьи-то решения о здоровье. Например, Национальная ассоциация расстройств пищевого поведения Чат-бот Тесса в автономном режиме после того, как людям предложили считать калории, еженедельно взвешиваться и следить за жировыми отложениями — поведение, которое считается противоречащим здравому смыслу для здорового восстановления.

Исследовательская работа, написанная Google-DeepMind. подробно Med-PaLM 2 признал, что «ответы модели были не такими благоприятными, как ответы врачей», и получил низкие оценки с точки зрения точности и релевантности.

Warner хочет, чтобы Пичаи поделился дополнительной информацией о том, как модель развертывается в клинических условиях, и хочет знать, собирает ли мегакорпорация данные о пациентах от тех, кто тестирует ее технологию, и какие данные использовались для ее обучения.

Он подчеркнул, что Google ранее хранил и анализировал данные пациентов без их явного ведома или согласия в сделках с больницами в США и Великобритании в соответствии с Проект Соловей баннер.

«Google не предоставила публично документацию по Med-PaLM 2, в том числе воздержалась от раскрытия содержания данных обучения модели. Включает ли учебный корпус Med-PaLM 2 защищенную медицинскую информацию?» он спросил.

Представитель Google отрицал, что Med-PaLM 2 был чат-ботом, каким люди его знают сегодня, и сказал, что модель тестируется клиентами, чтобы выяснить, как она может быть полезна для отрасли здравоохранения.

«Мы считаем, что искусственный интеллект может преобразовать здравоохранение и медицину, и стремимся исследовать безопасность, справедливость, доказательства и конфиденциальность в основе», — сказал представитель. Регистр в своем заявлении.

"В виде заявил В апреле мы делаем Med-PaLM 2 доступной для избранной группы организаций здравоохранения для ограниченного тестирования, изучения вариантов использования и обмена отзывами — критически важный шаг в создании безопасной и полезной технологии. Эти клиенты сохраняют контроль над своими данными. Med-PaLM 2 — это не чат-бот; это доработанная версия нашей большой языковой модели Палм 2и предназначен для кодирования медицинских знаний».

Представитель не подтвердил, будет ли Google отвечать на вопросы сенатора Уорнера. ®

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Автомобили / электромобили, Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- Смещения блоков. Модернизация права собственности на экологические компенсации. Доступ здесь.

- Источник: https://go.theregister.com/feed/www.theregister.com/2023/08/08/google_senator_ai_health/

- :имеет

- :является

- :нет

- 7

- 8

- a

- О нас

- По

- точность

- признал

- принять

- принял

- совет

- Аффилированные

- После

- против

- AI

- AI модели

- причислены

- an

- проанализированы

- и

- объявляющий

- ответ

- ответы

- очевидный

- прикладной

- апрель

- МЫ

- AS

- помощник

- Объединение

- At

- доступен

- баннер

- основанный

- BE

- поведения

- не являетесь

- верить

- тело

- Бот

- Строительство

- by

- CAN

- заботится

- случаев

- Chatbot

- главный

- явно

- клиника

- Клинический

- облако

- CO

- Сбор

- коммерциализировать

- привержен

- комплекс

- обеспокоенный

- уверенно

- подтвердить

- согласие

- Последствия

- содержащегося

- содержание

- контекст

- контроль

- Основные

- может

- критической

- Клиенты

- данным

- Акции

- решения

- Снижение

- считается

- демонстрировать

- отказано

- развернуть

- развертывание

- развертывает

- предназначенный

- DID

- Раскрытие

- раскрытие

- расстройства

- документации

- Документация

- приносит

- дюжина

- каждый

- обеспечивать

- собственный капитал

- ошибки

- особенно

- установить

- оценивается

- , поскольку большинство сенаторов

- пример

- руководителей высшего звена.

- существующий

- Объяснять

- Больше

- Исследование

- ложный

- Жир

- благоприятный

- страх

- Обратная связь

- в заключение

- Что касается

- частота

- часто

- от

- полностью

- порождать

- порождающий

- генеративный

- Генеративный ИИ

- гигант

- данный

- хорошо

- Google Cloud

- группы

- вредный

- he

- Медицина

- Товары для здоровья

- информация о здоровье

- здравоохранение

- медицинской отрасли

- здоровый

- полезный

- Выделенные

- его

- имеет

- больницы

- Как

- HTTPS

- i

- if

- улучшать

- in

- включают

- включены

- В том числе

- включенный

- расширились

- промышленность

- влияющий

- информация

- сообщил

- учреждения

- Интернет

- выпустили

- IT

- ЕГО

- JPG

- Знать

- знания

- язык

- большой

- законодатель

- вести

- Утечки

- письмо

- Лицензия

- Лицензирована

- лицензиаты

- Ограниченный

- Список

- дольше

- Создание

- отметка

- рынок

- доля рынка

- Май

- основным медицинским

- медицина

- может быть

- ошибки

- смягчать

- модель

- Модели

- монитор

- БОЛЕЕ

- самых

- национальный

- Необходимость

- Новые

- of

- предложенный

- оффлайн

- on

- ONE

- только

- or

- организации

- Другое

- наши

- внешний

- Результаты

- выходной

- за

- собственный

- ладонь

- бумага & картон

- часть

- особенно

- пациент

- пациентов

- Люди

- врач

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- пожалуйста

- пунктов

- потенциал

- преждевременный

- представлены

- давление

- предотвращать

- предварительно

- политикой конфиденциальности.

- Продукт

- профессионалы

- защищенный

- при условии

- Публикация

- публично

- цель

- положил

- Запросы

- Вопросы

- Гонки

- поднятый

- повышения

- скорее

- RE

- последний

- выздоровление

- опора

- представитель

- исследованиям

- исследователи

- ответ

- ответ

- сохранять

- удерживающий

- Снижение

- рисках,

- торопить

- s

- безопасный

- Сохранность

- Сказал

- Сенат

- Сенатор

- чувствительный

- чувствительность

- Наборы

- установка

- настройки

- Поделиться

- должен

- So

- Software

- Кто-то

- докладчик

- заявление

- Шаг

- Шаги

- хранить

- суммировать

- Сундар Пичаи

- система

- приняты

- Технологии

- terms

- проверенный

- Тестеры

- Тестирование

- который

- Ассоциация

- их

- Их

- сами

- в нем

- Эти

- этой

- те

- Через

- исполин

- в

- сегодня

- приняли

- Train

- специалистов

- Обучение

- поезда

- Transform

- огромный

- Доверие

- Uk

- под

- несомненно

- новейший

- us

- американский законодатель

- использование

- используемый

- версия

- Виргиния

- хочет

- Сигнализатор

- законопроект

- we

- Web

- еженедельно

- взвешивать

- ЧТО Ж

- были

- Что

- когда

- будь то

- который

- в то время как

- без

- беспокоиться

- бы

- письменный

- писал

- лет

- зефирнет