По оценкам, индустрия видеоигр насчитывает более 3 миллиардов пользователей по всему миру.1. Он состоит из огромного количества игроков, виртуально взаимодействующих друг с другом каждый божий день. К сожалению, как и в реальном мире, не все игроки общаются корректно и уважительно. Стремясь создать и поддерживать социально ответственную игровую среду, AWS Professional Services попросили создать механизм, который выявляет неприемлемую лексику (токсичную речь) во взаимодействиях с игроками в онлайн-играх. Общий бизнес-результат заключался в улучшении операций организации за счет автоматизации существующего ручного процесса и улучшении взаимодействия с пользователем за счет повышения скорости и качества обнаружения неуместных взаимодействий между игроками, что в конечном итоге способствовало созданию более чистой и здоровой игровой среды.

Клиент попросил создать детектор английского языка, который классифицирует голосовые и текстовые отрывки по собственным категориям токсичных языков. Они хотели сначала определить, является ли данная языковая выдержка токсичной, а затем классифицировать эту выдержку в определенной определяемой пользователем категории токсичности, такой как ненормативная лексика или оскорбительные выражения.

AWS ProServe решил этот вариант использования благодаря совместным усилиям Инновационного центра генеративного ИИ (GAIIC) и группы доставки машинного обучения ProServe (MLDT). AWS GAIIC — это группа в AWS ProServe, которая объединяет клиентов с экспертами для разработки генеративных решений ИИ для широкого спектра бизнес-применений с использованием сборок для проверки концепции (PoC). Затем AWS ProServe MLDT реализует PoC в производстве, масштабируя, укрепляя и интегрируя решение для клиента.

Этот пример использования клиента будет продемонстрирован в двух отдельных сообщениях. Этот пост (Часть 1) служит глубоким погружением в научную методологию. Он объяснит мыслительный процесс и эксперименты, лежащие в основе решения, включая процесс обучения и разработки модели. Часть 2 будет посвящена промышленному решению, объяснению проектных решений, потока данных и иллюстрации архитектуры обучения и развертывания модели.

Этот пост охватывает следующие темы:

- Проблемы, которые пришлось решать AWS ProServe для этого варианта использования

- Исторический контекст больших языковых моделей (LLM) и почему эта технология идеально подходит для этого варианта использования.

- PoC AWS GAIIC и решение AWS ProServe MLDT с точки зрения науки о данных и машинного обучения (ML)

Проблема с данными

Основной проблемой, с которой столкнулся AWS ProServe при обучении классификатора токсичных языков, было получение от клиента достаточного количества размеченных данных для обучения точной модели с нуля. AWS получил около 100 образцов размеченных данных от заказчика, что намного меньше 1,000 образцов, рекомендованных для тонкой настройки LLM в сообществе специалистов по данным.

В качестве дополнительной неотъемлемой проблемы классификаторы обработки естественного языка (NLP), как исторически известно, очень дороги в обучении и требуют большого набора словарного запаса, известного как тело, чтобы делать точные прогнозы. Строгим и эффективным решением НЛП, при наличии достаточного количества размеченных данных, было бы обучение пользовательской языковой модели с использованием размеченных данных клиента. Модель будет обучаться исключительно с использованием игровой лексики игроков, что сделает ее адаптированной к языку, наблюдаемому в играх. У заказчика были ограничения как по стоимости, так и по времени, что делало это решение нежизнеспособным. AWS ProServe пришлось искать решение для обучения точного классификатора языковой токсичности с относительно небольшим набором размеченных данных. Решение заключалось в том, что известно как трансферное обучение.

Идея трансферного обучения состоит в том, чтобы использовать знания предварительно обученной модели и применить их к другой, но относительно похожей проблеме. Например, если классификатор изображений был обучен предсказывать, содержит ли изображение кошку, вы можете использовать знания, полученные моделью во время обучения, для распознавания других животных, таких как тигры. Для этого варианта использования языка AWS ProServe потребовалось найти ранее обученный языковой классификатор, который был обучен обнаруживать токсичные языки и настраивать его с использованием размеченных данных клиента.

Решение состояло в том, чтобы найти и настроить LLM для классификации токсичного языка. LLM — это нейронные сети, которые были обучены с использованием огромного количества параметров, обычно порядка миллиардов, с использованием неразмеченных данных. Прежде чем перейти к решению AWS, в следующем разделе представлен обзор истории LLM и их исторических вариантов использования.

Использование возможностей LLM

LLM недавно стали центром внимания предприятий, ищущих новые приложения ML, с тех пор, как ChatGPT завоевал общественное мнение, став самым быстрорастущим потребительским приложением в истории.2, достигнув 100 миллионов активных пользователей к январю 2023 года, всего через 2 месяца после его выпуска. Однако LLM не являются новой технологией в сфере машинного обучения. Они широко использовались для выполнения задач НЛП, таких как анализ настроений, обобщение корпусов, извлечение ключевых слов, перевод речи и классификация текста.

Из-за последовательного характера текста рекуррентные нейронные сети (RNN) были современным средством моделирования НЛП. В частности, кодер-декодер Сетевая архитектура была сформулирована потому, что она создала структуру RNN, способную принимать входные данные произвольной длины и генерировать выходные данные произвольной длины. Это было идеально для таких задач НЛП, как перевод, когда выходную фразу одного языка можно было предсказать по входной фразе другого языка, как правило, с разным количеством слов между входом и выходом. Архитектура Трансформера3 (Vaswani, 2017) было прорывным усовершенствованием кодировщика-декодера; он ввел понятие самостоятельно внимание, что позволило модели сфокусировать внимание на разных словах входных и выходных фраз. В типичном кодировщике-декодере каждое слово интерпретируется моделью одинаково. Поскольку модель последовательно обрабатывает каждое слово во входной фразе, семантическая информация в начале может быть потеряна к концу фразы. Механизм внутреннего внимания изменил это, добавив слой внимания как к блоку кодировщика, так и к блоку декодера, чтобы модель могла присваивать разные веса определенным словам из входной фразы при генерации определенного слова в выходной фразе. Так родилась основа модели-трансформера.

Архитектура трансформатора была основой для двух самых известных и популярных LLM, используемых сегодня, двунаправленных представлений кодировщика от трансформаторов (BERT).4 (Рэдфорд, 2018) и генеративный предварительно обученный преобразователь (GPT)5 (Девлин, 2018). Более поздние версии модели GPT, а именно GPT3 и GPT4, являются ядром, на котором работает приложение ChatGPT. Последняя часть рецепта, который делает LLM такими мощными, — это способность извлекать информацию из обширных корпусов текстов без обширной маркировки или предварительной обработки с помощью процесса, называемого ULMFiT. Этот метод имеет этап предварительной подготовки, на котором можно собрать общий текст, а модель обучается задаче прогнозирования следующего слова на основе предыдущих слов; Преимущество здесь в том, что любой входной текст, используемый для обучения, изначально помечен заранее в зависимости от порядка текста. LLM действительно способны учиться на данных в масштабе Интернета. Например, исходная модель BERT была предварительно обучена на BookCorpus и на всех наборах текстовых данных английской Википедии.

Эта новая парадигма моделирования породила две новые концепции: базовые модели (FM) и генеративный ИИ. В отличие от обучения модели с нуля с использованием данных для конкретной задачи, что является обычным случаем классического обучения с учителем, LLM предварительно обучаются для извлечения общих знаний из широкого набора текстовых данных, прежде чем они будут адаптированы к конкретным задачам или областям с гораздо меньшими затратами. набор данных (обычно порядка сотен образцов). Новый рабочий процесс машинного обучения теперь начинается с предварительно обученной модели, называемой базовой моделью. Важно строить на правильном фундаменте, и существует все больше вариантов, таких как новый Амазонка Титан FM, который будет выпущен AWS как часть Коренная порода Амазонки. Эти новые модели также считаются генеративными, поскольку их выходные данные доступны для интерпретации человеком и имеют тот же тип данных, что и входные данные. В то время как прошлые модели машинного обучения были описательными, такими как классификация изображений кошек и собак, LLM являются генеративными, поскольку их выходом является следующий набор слов, основанный на входных словах. Это позволяет им создавать интерактивные приложения, такие как ChatGPT, которые могут быть выразительными в генерируемом ими контенте.

Hugging Face стала партнером AWS чтобы демократизировать FM и сделать их доступными и удобными для создания. Hugging Face создал API Трансформеров который объединяет более 50 различных архитектур преобразователей на разных платформах машинного обучения, включая доступ к предварительно обученным весам моделей в их Модельный концентратор, который на момент написания этой статьи вырос до более чем 200,000 XNUMX моделей. В следующих разделах мы рассмотрим доказательство концепции, решение и FM, которые были протестированы и выбраны в качестве основы для решения этого варианта использования классификации токсичной речи для клиента.

Доказательство концепции AWS GAIIC

AWS GAIIC решил поэкспериментировать с базовыми моделями LLM с архитектурой BERT, чтобы точно настроить классификатор токсичных языков. Всего было протестировано три модели из модельного центра Hugging Face:

Все три модели архитектуры основаны на БЕРТвитнуть архитектура. BERTweet обучается на основе РОБЕРТа предтренировочная процедура. Процедура предварительного обучения RoBERTa является результатом повторного исследования предварительного обучения BERT, в котором оценивались эффекты настройки гиперпараметров и размера обучающего набора для улучшения рецепта обучения моделей BERT.6 (Лю 2019). Эксперимент стремился найти метод предварительного обучения, который улучшил результаты производительности BERT без изменения базовой архитектуры. Вывод исследования показал, что следующие предтренировочные модификации существенно улучшили производительность BERT:

- Обучение модели с большими партиями по большему количеству данных

- Удаление цели предсказания следующего предложения

- Тренировка на более длинных последовательностях

- Динамическое изменение шаблона маскирования, применяемого к обучающим данным.

Базовая модель bertweet использует предыдущую процедуру предварительного обучения из исследования RoBERTa для предварительного обучения исходной архитектуры BERT с использованием 850 миллионов твитов на английском языке. Это первая общедоступная крупномасштабная языковая модель, предварительно обученная для твитов на английском языке.

Считалось, что предварительно обученные FM с использованием твитов подходят для варианта использования по двум основным теоретическим причинам:

- Длина твита очень похожа на длину неуместной или токсичной фразы, встречающейся в чатах онлайн-игр.

- Твиты исходят от множества разных пользователей, подобных тем, которые встречаются на игровых платформах.

AWS решила сначала настроить BERTweet с помощью размеченных данных клиента, чтобы получить базовый уровень. Затем решили настроить два других FM в bertweet-base-offensive и bertweet-base-hate, которые были дополнительно предварительно обучены специально для более релевантных токсичных твитов для достижения потенциально более высокой точности. Модель bertweet-base-offensive использует базовый BertTweet FM и предварительно обучена на 14,100 XNUMX аннотированных твитах, которые были сочтены оскорбительными.7 (Зампиери, 2019). Модель bertweet-base-hate также использует базовую версию BertTweet FM, но предварительно обучена на 19,600 XNUMX твитах, которые были сочтены разжигающими ненависть.8 (Базиле 2019).

Чтобы еще больше повысить производительность модели PoC, AWS GAIIC принял два проектных решения:

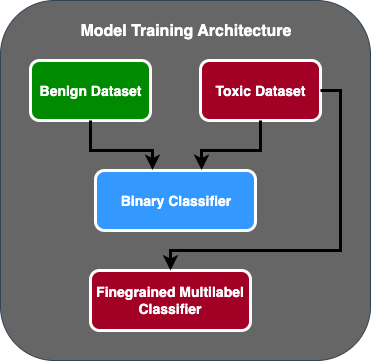

- Создан двухэтапный поток прогнозирования, в котором первая модель действует как двоичный классификатор, который классифицирует, является ли фрагмент текста токсичным или нетоксичным. Вторая модель — это мелкозернистая модель, которая классифицирует текст на основе определенных пользователем токсичных типов. Только если первая модель предсказывает текст как токсичный, он передается второй модели.

- Дополнены обучающие данные и добавлено подмножество стороннего набора данных с токсичным текстом из общедоступного конкурса Kaggle (Токсичность головоломки) к исходным 100 образцам, полученным от заказчика. Они сопоставили метки Jigsaw с соответствующими метками токсичности, определенными заказчиком, и разделили 80% в качестве обучающих данных и 20% в качестве тестовых данных для проверки модели.

Используется AWS GAIIC Создатель мудреца Амазонки ноутбуков для проведения своих экспериментов по точной настройке и обнаружили, что модель bertweet-base-offensive показала наилучшие результаты в проверочном наборе. В следующей таблице приведены наблюдаемые оценки показателей.

| Модель | Точность | Вспоминать | F1 | ППК |

| Двоичный | .92 | .90 | .91 | .92 |

| Мелкозернистый | .81 | .80 | .81 | .89 |

С этого момента GAIIC передал PoC группе доставки AWS ProServe ML для производства PoC.

Решение группы доставки AWS ProServe ML

Чтобы внедрить архитектуру модели в производство, клиент попросил группу доставки AWS ProServe ML (MLDT) создать масштабируемое и простое в обслуживании решение. Было несколько проблем с обслуживанием двухэтапного модельного подхода:

- Для моделей потребуется удвоить объем мониторинга моделей, что делает сроки переобучения непоследовательными. Могут быть случаи, когда одну модель придется переобучать чаще, чем другую.

- Увеличение затрат на эксплуатацию двух моделей вместо одной.

- Скорость вывода замедляется, потому что вывод проходит через две модели.

Чтобы решить эти проблемы, команде AWS ProServe MLDT пришлось выяснить, как превратить архитектуру двухэтапной модели в архитектуру с одной моделью, сохранив при этом точность двухэтапной архитектуры.

Решение состояло в том, чтобы сначала запросить у клиента дополнительные обучающие данные, а затем настроить модель bertweet-base-offensive для всех этикеток, включая нетоксичные образцы, в одну модель. Идея заключалась в том, что точная настройка одной модели с использованием большего количества данных приведет к тем же результатам, что и точная настройка архитектуры двухэтапной модели с использованием меньшего количества данных. Для точной настройки архитектуры двухэтапной модели AWS ProServe MLDT обновил заголовок классификации предварительно обученной модели с несколькими метками, добавив один дополнительный узел для представления нетоксичного класса.

Ниже приведен пример кода, показывающий, как можно настроить предварительно обученную модель из концентратора моделей Hugging Face с помощью их платформы преобразователей и изменить классификационный заголовок модели с несколькими метками, чтобы предсказать желаемое количество классов. AWS ProServe MLDT использовал этот план в качестве основы для тонкой настройки. Предполагается, что у вас есть готовые данные о поезде и данные проверки в правильном формате ввода.

Сначала импортируются модули Python, а также желаемая предварительно обученная модель из концентратора моделей Hugging Face:

Затем предварительно обученная модель загружается и подготавливается для точной настройки. На этом шаге определяется количество категорий токсичных веществ и все параметры модели:

Тонкая настройка модели начинается с ввода путей к наборам данных для обучения и проверки:

AWS ProServe MLDT получил еще примерно 5,000 помеченных образцов данных, 3,000 из которых были нетоксичными, а 2,000 — токсичными, и точно настроил все три модели на основе bertweet, объединив все метки в одну модель. Они использовали эти данные в дополнение к 5,000 образцам из PoC для точной настройки новых одноэтапных моделей с использованием того же метода 80% набора поездов и 20% тестового набора. В следующей таблице показано, что показатели производительности были сопоставимы с показателями двухэтапной модели.

| Модель | Точность | Вспоминать | F1 | ППК |

| bertweet-база (1-этап) | .76 | .72 | .74 | .83 |

| bertweet-base-hate (1-этап) | .85 | .82 | .84 | .87 |

| bertweet-base-offensive (1-этап) | .88 | .83 | .86 | .89 |

| bertweet-base-offensive (2-этап) | .91 | .90 | .90 | .92 |

Подход с одноэтапной моделью позволил снизить затраты и улучшить техническое обслуживание, при этом точность снизилась всего на 3%. После взвешивания компромиссов заказчик выбрал AWS ProServe MLDT для производственной реализации одноэтапной модели.

Путем точной настройки одной модели с использованием большего количества размеченных данных AWS ProServe MLDT смог предоставить решение, которое соответствовало пороговому значению точности модели, а также выполнило его просьбу о простоте обслуживания, снизив при этом затраты и повысив надежность.

Заключение

Крупный игровой клиент искал способ обнаружить ненормативную лексику в своих каналах связи, чтобы создать социально ответственную игровую среду. AWS GAIIC создал PoC детектора токсичных языков, настроив LLM для обнаружения токсичных языков. Затем AWS ProServe MLDT обновил процесс обучения модели с двухэтапного подхода на одноэтапный и подготовил LLM для масштабного использования заказчиком.

В этом посте AWS демонстрирует эффективность и практичность тонкой настройки LLM для решения этого сценария использования клиента, делится контекстом истории базовых моделей и LLM и знакомит с рабочим процессом между AWS Generative AI Innovation Center и AWS ProServe ML. Команда доставки. В следующем посте этой серии мы более подробно рассмотрим, как AWS ProServe MLDT создавал полученную одноэтапную модель с помощью SageMaker.

Если вы заинтересованы в сотрудничестве с AWS для создания решения для генеративного ИИ, обратитесь к ГАИИК. Они оценят ваш вариант использования, создадут доказательство концепции на основе генеративного ИИ и предложат варианты расширения сотрудничества с AWS для внедрения полученного PoC в производство.

Рекомендации

- Демография геймеров: факты и статистика о самом популярном хобби в мире

- ChatGPT устанавливает рекорд по быстрорастущей пользовательской базе – примечание аналитика

- Васвани и др., «Внимание — это все, что вам нужно»

- Рэдфорд и др., «Улучшение понимания языка с помощью генеративного предварительного обучения».

- Девлин и др., «BERT: предварительное обучение глубоких двунаправленных преобразователей для понимания языка»

- Йинхан Лю и др., «RoBERTa: надежно оптимизированный подход к предварительной подготовке к BERT»

- Маркос Зампиери и др., «SemEval-2019, задание 6: выявление и классификация оскорбительных выражений в социальных сетях (OffensEval)»

- Валерио Базиле и др., «SemEval-2019 Задача 5: Многоязычное обнаружение языка ненависти в отношении иммигрантов и женщин в Twitter»

Об авторах

Джеймс Покиз — специалист по обработке и анализу данных компании AWS Professional Services, расположенной в округе Ориндж, штат Калифорния. Он имеет степень бакалавра компьютерных наук Калифорнийского университета в Ирвине и имеет многолетний опыт работы в области данных, сыграв множество различных ролей. Сегодня он работает над внедрением и развертыванием масштабируемых решений машинного обучения для достижения бизнес-результатов для клиентов AWS.

Джеймс Покиз — специалист по обработке и анализу данных компании AWS Professional Services, расположенной в округе Ориндж, штат Калифорния. Он имеет степень бакалавра компьютерных наук Калифорнийского университета в Ирвине и имеет многолетний опыт работы в области данных, сыграв множество различных ролей. Сегодня он работает над внедрением и развертыванием масштабируемых решений машинного обучения для достижения бизнес-результатов для клиентов AWS.

Хан Ман является старшим менеджером по науке о данных и машинному обучению в AWS Professional Services в Сан-Диего, Калифорния. Он имеет докторскую степень в области инженерии Северо-Западного университета и имеет многолетний опыт работы консультантом по вопросам управления, консультируя клиентов в области производства, финансовых услуг и энергетики. Сегодня он увлеченно работает с ключевыми клиентами из различных отраслевых вертикалей, разрабатывая и внедряя решения машинного обучения и GenAI на AWS.

Хан Ман является старшим менеджером по науке о данных и машинному обучению в AWS Professional Services в Сан-Диего, Калифорния. Он имеет докторскую степень в области инженерии Северо-Западного университета и имеет многолетний опыт работы консультантом по вопросам управления, консультируя клиентов в области производства, финансовых услуг и энергетики. Сегодня он увлеченно работает с ключевыми клиентами из различных отраслевых вертикалей, разрабатывая и внедряя решения машинного обучения и GenAI на AWS.

Сафа Тиназтепе — специалист по обработке и анализу данных полного цикла, работающий с AWS Professional Services. Он имеет степень бакалавра компьютерных наук Университета Эмори и интересуется MLOps, распределенными системами и web3.

Сафа Тиназтепе — специалист по обработке и анализу данных полного цикла, работающий с AWS Professional Services. Он имеет степень бакалавра компьютерных наук Университета Эмори и интересуется MLOps, распределенными системами и web3.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Автомобили / электромобили, Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- Смещения блоков. Модернизация права собственности на экологические компенсации. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/aws-performs-fine-tuning-on-a-large-language-model-llm-to-classify-toxic-speech-for-a-large-gaming-company/

- :имеет

- :является

- :нет

- :куда

- 000

- 1

- 100

- 14

- 16

- 19

- 200

- 2017

- 2018

- 2019

- 2023

- 50

- 7

- a

- способность

- в состоянии

- О нас

- доступ

- точность

- точный

- Достигать

- достигнутый

- активный

- акты

- добавленный

- добавить

- дополнение

- адрес

- консультирование

- После

- против

- AI

- AL

- Все

- разрешено

- позволяет

- причислены

- Amazon

- Amazon Web Services

- количество

- суммы

- an

- аналитик

- анализ

- и

- животные

- Другой

- любой

- Применение

- Приложения

- прикладной

- Применить

- подхода

- надлежащим образом

- примерно

- архитектура

- МЫ

- Аргументы

- Искусство

- AS

- оценить

- связанный

- предполагает,

- At

- внимание

- Автоматизация

- AWS

- Профессиональные услуги AWS

- Использование темпера с изогнутым основанием

- основанный

- Базовая линия

- основа

- BE

- , так как:

- становиться

- было

- до

- начало

- за

- не являетесь

- ниже

- польза

- ЛУЧШЕЕ

- между

- больший

- миллиард

- миллиарды

- Заблокировать

- рожденный

- изоферменты печени

- прорыв

- широкий

- строить

- строит

- бизнес

- бизнес

- но

- by

- CA

- Калифорния

- под названием

- CAN

- способный

- захваченный

- случаев

- случаев

- КПП

- категории

- категоризации

- Категории

- Кошки

- Центр

- определенный

- вызов

- проблемы

- менялась

- изменения

- каналы

- ChatGPT

- выбрал

- выбранный

- класс

- классов

- классификация

- классифицировать

- клиентов

- код

- сотрудничество

- комбинируя

- как

- выходит

- общаться

- Связь

- сообщество

- Компания

- сравнимый

- конкурс

- компьютер

- Информатика

- сама концепция

- понятия

- заключение

- считается

- состоит

- ограничения

- консультант

- потребитель

- содержит

- содержание

- контекст

- исправить

- Цена

- дорогостоящий

- Расходы

- может

- округ

- Обложки

- Создайте

- создали

- изготовленный на заказ

- клиент

- Клиенты

- данным

- наука о данных

- ученый данных

- Наборы данных

- день

- решенный

- решения

- считается

- глубоко

- глубокое погружение

- более глубокий

- определять

- определенный

- доставить

- поставляется

- поставка

- копаться

- демократизировать

- Демографическая

- демонстрирует

- развертывание

- развертывание

- Проект

- желанный

- обнаруживать

- обнаружение

- Определять

- развивать

- Развитие

- DID

- Диего

- различный

- Отличаясь

- распределенный

- распределенные системы

- приносит

- домен

- доменов

- двойной

- дублированный

- в течение

- Е & Т

- каждый

- простота

- легко

- Эффективный

- эффективность

- эффекты

- усилие

- конец

- энергетика

- Двигатель

- Проект и

- Английский

- повышать

- достаточно

- Enter

- Весь

- Окружающая среда

- эпоха

- к XNUMX году

- оценивается

- НИКОГДА

- Каждая

- пример

- существующий

- опыт

- эксперимент

- Эксперименты

- эксперты

- Объяснять

- объясняя

- Больше

- выразительный

- продлить

- обширный

- широко

- дополнительно

- извлечение

- Face

- сталкиваются

- Факты

- Фэшн

- быстрый

- быстрорастущим

- несколько

- фигура

- окончательный

- финансовый

- финансовые услуги

- Найдите

- Во-первых,

- соответствовать

- поток

- Фокус

- после

- Что касается

- формат

- найденный

- Год основания

- каркасы

- от

- далее

- получила

- игра

- Игры

- игровой

- Игровая индустрия

- собранный

- Общие

- порождать

- порождающий

- генеративный

- Генеративный ИИ

- получить

- данный

- идет

- будет

- группы

- Рост

- взрослый

- было

- Есть

- имеющий

- he

- здоровый

- здесь

- высший

- исторический

- исторически

- история

- Как

- How To

- Однако

- HTTPS

- хаб

- человек

- Сотни

- Настройка гиперпараметра

- идея

- идеальный

- идентичный

- идентифицирующий

- if

- изображение

- изображений

- Иммигранты

- осуществлять

- Осуществляющий

- Импортировать

- важную

- импорт

- улучшать

- улучшенный

- улучшение

- улучшение

- in

- включают

- В том числе

- повышение

- промышленность

- информация

- свойственный

- по существу

- Инновации

- вход

- Интегрируя

- взаимодействующий

- взаимодействие

- интерактивный

- заинтересованный

- интересы

- в

- выпустили

- Представляет

- IT

- ЕГО

- январь

- Головоломка

- совместная

- всего

- Основные

- ключевые слова

- знания

- известный

- маркировка

- Этикетки

- язык

- большой

- крупномасштабный

- новее

- лежать

- слой

- изучение

- Длина

- Меньше

- такое как

- LLM

- загрузка

- дольше

- искать

- потерянный

- серия

- Снижение

- машина

- обучение с помощью машины

- сделанный

- Главная

- поддерживать

- техническое обслуживание

- сделать

- ДЕЛАЕТ

- Создание

- человек

- управление

- менеджер

- руководство

- производство

- многих

- массивный

- Май..

- механизм

- Медиа

- встретивший

- метод

- Методология

- метрический

- миллиона

- ML

- млн операций в секунду

- модель

- моделирование

- Модели

- изменения

- Модули

- Мониторинг

- месяцев

- БОЛЕЕ

- самых

- Самые популярные

- много

- а именно

- натуральный

- Обработка естественного языка

- природа

- необходимый

- сеть

- сетей

- нейронные сети

- Новые

- следующий

- НЛП

- узел

- сейчас

- номер

- номера

- получение

- of

- от

- наступление

- .

- on

- ONE

- онлайн

- онлайн-игр

- только

- Операционный отдел

- против

- оптимизированный

- Опции

- or

- Апельсин

- заказ

- оригинал

- Другое

- внешний

- Результат

- Результаты

- выходной

- за

- общий

- обзор

- собственный

- пар

- парадигма

- параметр

- параметры

- часть

- партнерство

- Прошло

- мимо

- шаблон

- ИДЕАЛЬНОЕ

- Выполнять

- производительность

- выполняет

- фаза

- кандидат наук

- фразы

- кусок

- Платформа

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- играл

- игрок

- игроки

- пожалуйста

- PoC

- Точка

- Популярное

- население

- После

- Блог

- потенциально

- мощностью

- мощный

- полномочия

- Точность

- предсказывать

- предсказанный

- прогнозирования

- прогноз

- Predictions

- предсказывает

- предыдущий

- предварительно

- Проблема

- процедуры

- процесс

- Процессы

- обработка

- производит

- Производство

- ПРОФАНСТВО

- профессиональный

- продвижении

- Содействие

- доказательство

- доказательство концепции

- при условии

- приводит

- что такое варган?

- положил

- Питон

- ассортимент

- достигать

- достигнув результата

- готовый

- реальные

- реальный мир

- причины

- получила

- недавно

- рецепт

- признавать

- Управление по борьбе с наркотиками (DEA)

- запись

- относительно

- освободить

- выпустил

- соответствующие

- копирование

- представлять

- требовать

- ответственный

- Ответственная игра

- результат

- в результате

- Итоги

- Reuters

- правую

- тщательный

- Рост

- прочность

- роли

- Run

- Бег

- sagemaker

- то же

- Сан -

- Сан Диего

- масштабируемые

- Шкала

- масштабирование

- Наука

- научный

- Ученый

- поцарапать

- Во-вторых

- Раздел

- разделах

- старший

- предложение

- настроение

- отдельный

- Последовательность

- Серии

- служит

- Услуги

- набор

- Наборы

- несколько

- Акции

- продемонстрированы

- Шоу

- аналогичный

- с

- одинарной

- Размер

- замедляет

- небольшой

- меньше

- So

- Соцсети

- социальные сети

- социально

- только

- Решение

- Решения

- РЕШАТЬ

- Решение

- некоторые

- искать

- Space

- конкретный

- конкретно

- речь

- скорость

- раскол

- начинается

- Область

- Статистика

- Шаг

- По-прежнему

- Структура

- Кабинет

- по существу

- такие

- достаточный

- системы

- ТАБЛИЦЫ

- с учетом

- принимает

- с

- Сложность задачи

- задачи

- команда

- Технологии

- тестXNUMX

- проверенный

- чем

- который

- Ассоциация

- Государство

- их

- Их

- тогда

- теоретический

- Там.

- Эти

- они

- этой

- мысль

- три

- порог

- Через

- Таким образом

- время

- раз

- синхронизация

- исполин

- в

- сегодня

- Темы

- Всего

- Train

- специалистов

- Обучение

- перевод

- трансформатор

- трансформеры

- Переводы

- по-настоящему

- ОЧЕРЕДЬ

- Tweet

- чириканье

- два

- напишите

- Типы

- типичный

- типично

- В конечном счете

- лежащий в основе

- понимание

- К сожалению

- Университет

- Университет Калифорнии

- обновление

- использование

- прецедент

- используемый

- Информация о пользователе

- Пользовательский опыт

- пользователей

- использования

- через

- VALIDATE

- Проверка

- разнообразие

- Огромная

- версии

- вертикалей

- очень

- с помощью

- Видео

- видеоигры

- фактически

- Режимы

- vs

- хотеть

- стремятся

- законопроект

- Путь..

- we

- Web

- веб-сервисы

- Web3

- взвешивание

- ЧТО Ж

- известный

- были

- когда

- будь то

- , которые

- в то время как

- зачем

- широкий

- Широкий диапазон

- Википедия.

- будете

- в

- без

- Женщина

- Word

- слова

- рабочий

- работает

- работает

- Мир

- бы

- письмо

- лет

- Ты

- ВАШЕ

- зефирнет