По словам Майкла Бронштейна, руководителя отдела исследований графического обучения Twitter, графические процессоры — это мощный инструмент для рабочих нагрузок машинного обучения, хотя они не обязательно подходят для каждой задачи ИИ.

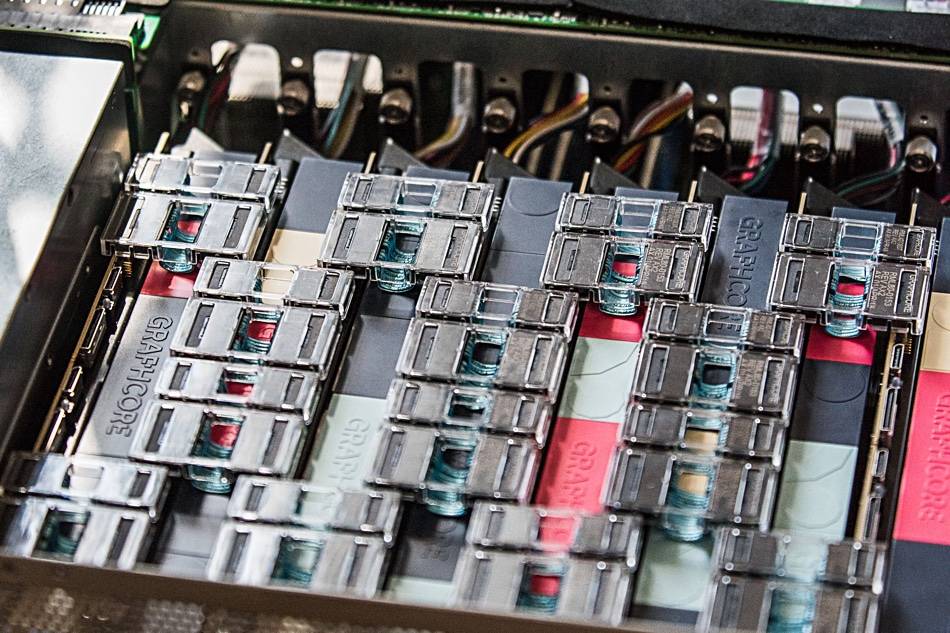

Его команда недавно продемонстрировала, что аппаратное обеспечение Graphcore для искусственного интеллекта предлагает «ускорение на порядок по сравнению с одним процессором IPU и графическим процессором Nvidia A100» в моделях временной графовой сети (TGN).

«Выбор оборудования для реализации моделей Graph ML — важная, но часто упускаемая из виду проблема», — говорится в статье. совместная статья написанный Бронштейном совместно с Эмануэле Росси, исследователем машинного обучения в Twitter, и Даниэлем Юстусом, исследователем в Graphcore.

Графические нейронные сети предлагают средства наведения порядка в сложных системах и обычно используются в социальных сетях и рекомендательных системах. Однако динамическая природа этих сред делает эти модели особенно сложными для обучения, объяснили трио.

Группа исследовала жизнеспособность IPU Graphcore при работе с несколькими моделями TGN. Первоначальное тестирование было проведено на небольшой модели TGN, основанной на ДЖОДИ Набор данных Википедии, который связывает пользователей с изменениями, внесенными ими на страницы. Граф состоял из 8,227 1,000 пользователей и 9,227 XNUMX статей, всего XNUMX XNUMX узлов. JODIE — это система прогнозирования с открытым исходным кодом, предназначенная для понимания сетей временного взаимодействия.

Эксперименты этой троицы показали, что большие размеры партий приводят к ухудшению проверки и точности выводов по сравнению с меньшими размерами партий.

«Память узла и связность графа обновляются только после обработки полного пакета», — написали трио. «Поэтому более поздние события в одной партии могут основываться на устаревшей информации, поскольку они не знают о более ранних событиях».

Тем не менее, используя размер пакета 10, группа смогла достичь оптимальной точности проверки и логического вывода, но они отмечают, что производительность на IPU по-прежнему выше, чем у графического процессора, даже при использовании больших размеров пакетов.

«При использовании пакета из 10 TGN можно обучать на IPU примерно в 11 раз быстрее, и даже при большом размере пакета в 200 обучение на IPU по-прежнему происходит в три раза быстрее», — говорится в сообщении. «Во всех операциях IPU более эффективно обрабатывает небольшие партии».

Команда утверждает, что быстрый доступ к памяти и высокая пропускная способность, обеспечиваемые большим внутрипроцессорным кешем SRAM Graphcore, дали IPU преимущество.

Это лидерство в производительности также распространяется на графические модели, которые превышают внутрипроцессорную память IPU (каждый IPU имеет 1 ГБ кэш-памяти SRAM), что требует использования более медленной памяти DRAM, подключенной к чипам.

При тестировании графовой модели, состоящей из 261 миллиона подписок между 15.5 миллионами пользователей Twitter, использование DRAM для памяти узла сократило пропускную способность в два раза, как обнаружила команда Бронштейна.

Однако при создании нескольких подграфов на основе синтетического набора данных, в 10 раз превышающего размер графика Twitter, команда обнаружила, что пропускная способность масштабируется независимо от размера графика. Другими словами, падение производительности было результатом использования более медленной памяти, а не результатом размера модели.

«Используя эту технику на IPU, TGN можно применять к графам практически произвольного размера, ограниченным только объемом доступной памяти хоста, сохраняя при этом очень высокую пропускную способность во время обучения и вывода», — говорится в статье.

Команда пришла к выводу, что архитектура IPU Graphcore демонстрирует значительное преимущество перед графическими процессорами в рабочих нагрузках, где вычисления и доступ к памяти неоднородны.

Однако более общий вывод заключается в том, что исследователи машинного обучения должны тщательно обдумывать свой выбор оборудования и не должны по умолчанию использовать графические процессоры.

«Доступность служб облачных вычислений, абстрагирующих базовое оборудование, приводит к определенной лени в этом отношении», — написали трио. «Мы надеемся, что наше исследование привлечет больше внимания к этой важной теме и проложит путь к будущим более эффективным алгоритмам и аппаратным архитектурам для приложений Graph ML». ®

- AI

- ай искусство

- генератор искусств ай

- искусственный интеллект

- искусственный интеллект

- сертификация искусственного интеллекта

- искусственный интеллект в банковском деле

- робот с искусственным интеллектом

- роботы с искусственным интеллектом

- программное обеспечение искусственного интеллекта

- блокчейн

- конференция по блокчейну

- Coingenius

- разговорный искусственный интеллект

- криптоконференция ИИ

- дал-и

- глубокое обучение

- google ai

- обучение с помощью машины

- Платон

- Платон Ай

- Платон Интеллектуальные данные

- Платон игра

- ПлатонДанные

- платогейминг

- масштаб ай

- синтаксис

- Регистр

- зефирнет